英偉達(dá)推出的StyleGAN在前不久大火了一把。今日,Reddit一位網(wǎng)友便利用StyleGAN耗時(shí)5天創(chuàng)作出了999幅抽象派畫作!不僅如此,他還將創(chuàng)作過(guò)程無(wú)私的分享給了大家,引來(lái)眾網(wǎng)友的一致好評(píng)。

人人都能當(dāng)抽象派畫作大師了!

去年,佳士得拍賣會(huì)上拍賣了一副由AI創(chuàng)作的肖像畫——《愛(ài)德蒙·貝拉米的肖像》,該畫最終售價(jià)43.25萬(wàn)美元(301萬(wàn)元人民幣),遠(yuǎn)遠(yuǎn)超過(guò)了7000到1萬(wàn)美元的預(yù)計(jì)售價(jià),同時(shí)也引發(fā)了人們對(duì)人工智能作畫的熱烈探討。

愛(ài)德蒙·貝拉米的肖像

今天,Reddit上一位網(wǎng)友利用StyleGAN訓(xùn)練生成了999幅抽象派畫作!

生成的其中一幅畫作

這項(xiàng)工作使得其他網(wǎng)友們羨慕不已:

那么,這999幅AI生成的畫作中,是否又會(huì)出現(xiàn)天價(jià)作品呢?值得拭目以待。

利用StyleGAN訓(xùn)練生成抽象派畫作

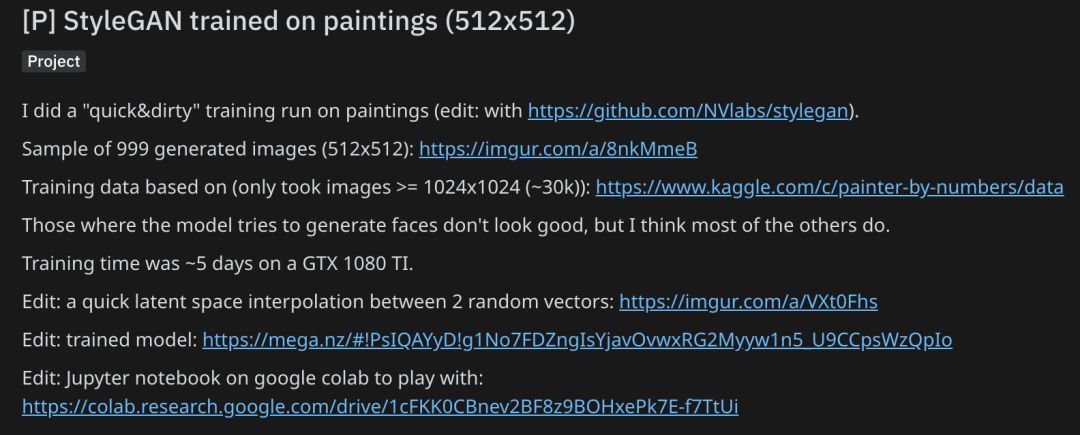

這位名為“_COD32_”的網(wǎng)友在Reddit上毫無(wú)保留的分享了這項(xiàng)工作的創(chuàng)作過(guò)程。

Reddit地址:

https://www.reddit.com/r/MachineLearning/comments/bagnq6/p_stylegan_trained_on_paintings_512x512/

在模型方面,采用的依舊是去年英偉達(dá)爆款StyleGAN,這是一種新的生成器架構(gòu),基于風(fēng)格遷移,將面部細(xì)節(jié)分離出來(lái),由模型進(jìn)行單獨(dú)調(diào)整,從而大幅度超越傳統(tǒng)GAN等模型。

英偉達(dá)StyleGAN GitHub官方地址:

https://github.com/NVlabs/stylegan

在數(shù)據(jù)方面,采用的是Kaggle上名為”Painter by Numbers“項(xiàng)目中的數(shù)據(jù)集,其中大部分的圖像數(shù)據(jù)來(lái)源于WikiArt.org網(wǎng)站。

Kaggle地址:

https://www.kaggle.com/c/painter-by-numbers/data

其中,只采用了≥1024X2014的圖像。在GTX 1080 TI上的訓(xùn)練時(shí)間大約是5天。

不過(guò)作者表示,該模型試圖生成人臉的部分并不是很完美,但其它部分還算可以。

例如下面兩個(gè)隨機(jī)向量之間的快速隱空間差值(latent space interpolation):

同時(shí),作者也給出了訓(xùn)練好的模型和Jupyter Notebook地址:

https://mega.nz/#!PsIQAYyD!g1No7FDZngIsYjavOvwxRG2Myyw1n5_U9CCpsWzQpIo

https://colab.research.google.com/drive/1cFKK0CBnev2BF8z9BOHxePk7E-f7TtUi

英偉達(dá)“造假”黑科技:StyleGAN簡(jiǎn)介

StyleGAN是英偉達(dá)提出的一種用于生成對(duì)抗網(wǎng)絡(luò)的替代生成器體系結(jié)構(gòu),該結(jié)構(gòu)借鑒了樣式遷移學(xué)習(xí)的成果。新結(jié)構(gòu)能夠?qū)崿F(xiàn)自動(dòng)學(xué)習(xí),以及無(wú)監(jiān)督的高級(jí)屬性分離(比如在使用人臉圖像訓(xùn)練時(shí)區(qū)分姿勢(shì)和身份屬性)和生成的圖像(如雀斑,頭發(fā))的隨機(jī)變化,并能在圖像合成和控制上實(shí)現(xiàn)直觀化和規(guī)模化。

新模型在傳統(tǒng)的分布質(zhì)量指標(biāo)方面實(shí)現(xiàn)了提升,并且更好地解決了潛在的變量因素。為了對(duì)插值質(zhì)量和分解進(jìn)行量化,本模型提出了兩種適用于任何生成架構(gòu)的自動(dòng)化新方法。以及一個(gè)新的、高度多樣化、高質(zhì)量的人臉數(shù)據(jù)集。

英偉達(dá)研究人員在論文中寫道,他們提出的新架構(gòu)可以完成自動(dòng)學(xué)習(xí),無(wú)監(jiān)督地分離高級(jí)屬性(例如在人臉上訓(xùn)練時(shí)的姿勢(shì)和身份)以及生成圖像中的隨機(jī)變化,并且可以對(duì)合成進(jìn)行更直觀且特定于比例的控制。

換句話說(shuō),這種新的GAN在生成和混合圖像,特別是人臉圖像時(shí),可以更好地感知圖像之間有意義的變化,并且在各種尺度上針對(duì)這些變化做出引導(dǎo)。

例如,研究人員使用的舊系統(tǒng)可能產(chǎn)生兩個(gè)“不同”的面部,這兩個(gè)面部其實(shí)大致相同,只是一個(gè)人的耳朵被抹去了,兩人的襯衫是不同的顏色。而這些并不是真正的面部特異性特征,不過(guò)系統(tǒng)并不知道這些是無(wú)需重點(diǎn)關(guān)注的變化,而當(dāng)成了兩個(gè)人來(lái)處理。

在上面的動(dòng)圖中,其實(shí)面部已經(jīng)完全變了,但“源”和“樣式”的明顯標(biāo)記顯然都得到了保留,例如最底下一排圖片的藍(lán)色襯衫。為什么會(huì)這樣?請(qǐng)注意,所有這些都是完全可變的,這里說(shuō)的變量不僅僅是A + B = C,而且A和B的所有方面都可以存在/不存在,具體取決于設(shè)置的調(diào)整方式。

下面這些由計(jì)算機(jī)生成的圖像都不是真人。但如果我告訴你這些圖像是真人的照片,你可能也不會(huì)懷疑:

效果如此出眾的StyleGAN一經(jīng)開(kāi)源就成了“網(wǎng)紅”,由該模型生成的假臉幾乎完全可以亂真,即使是放大了仔細(xì)看,大多數(shù)情況下依然難以分清,其難度堪比“大家來(lái)找茬”。

為此,有人甚至專門寫了一篇指南,專門指點(diǎn)那些有興趣“鑒臉”的人,該文總結(jié)出了StyleGAN生成假臉的幾處常見(jiàn)的破綻。不過(guò),這些破綻大部分是在圖片背景、配飾、衣物等附加元素上找到的,面部本身的破綻雖然也有,但顯著性和易見(jiàn)性都要下降一個(gè)檔次。

上圖的StyleGAN生成圖像在面部上幾乎無(wú)破綻,但左右耳的首飾不對(duì)稱

被玩壞的StyleGAN:從“假人臉”到“假房子”,生成世間萬(wàn)物

StyleGAN生成假臉圖像的逼真程度令人驚艷,但這么厲害的模型只能用來(lái)生成假人臉嗎?顯然不是。很快,越來(lái)越多的吃瓜群眾發(fā)現(xiàn)了StyleGAN的更多潛力。比如生成假的出租房。

前不久,就有好事者利用StyleGAN生成了一個(gè)假的Airbnb租房網(wǎng)站,上面從房源圖片、地址、再到租客的評(píng)論和打分沒(méi)有一個(gè)是真實(shí)的,全是StyleGAN的杰作。

假房生成網(wǎng)站 thisairbnbdoesnotexist.com,每次刷新都會(huì)出現(xiàn)一個(gè)虛假的房源,網(wǎng)頁(yè)上的照片、文字描述、發(fā)布人頭像均由計(jì)算機(jī)自動(dòng)生成。由于使用的模型非常簡(jiǎn)單,文字描述多有不合邏輯之處,但乍看上去還是能以假亂真。來(lái)源:假房生成網(wǎng)站 thisairbnbdoesnotexist.com

AirBNB網(wǎng)站截圖,避免廣告嫌疑做了虛化處理

根據(jù)Christopher Schmidt在Twitter的介紹,生成每個(gè)網(wǎng)頁(yè)用一塊GPU只需0.5秒,相關(guān)代碼開(kāi)源,你可以在這里找到:

https://colab.research.google.com/github/tensorflow/tpu/blob/master/tools/colab/shakespeare_with_tpu_and_keras.ipynb

這個(gè)“假房源”網(wǎng)站是怎么做的?

網(wǎng)站上的圖像當(dāng)然由著名的圖像生成模型StyleGAN生成,文本則來(lái)自在一個(gè)AirBNB列表(文末鏈接[1])上訓(xùn)練的語(yǔ)言模型,主要基于Tensorflow的“Predict Shakespeare with Cloud TPU”(https://t.co/sJoUbwZ2UL)。

這個(gè)文本生成模型似乎是個(gè)兩層的前饋LSTM(文末鏈接[2]),主要是用它來(lái)獨(dú)立訓(xùn)練生成房屋列表中的標(biāo)題、描述、房主姓名、地理位置等,然后組合生成綜合列表。

每個(gè)模型的輸出都是預(yù)先生成的,每5秒創(chuàng)建一個(gè)新的列表(網(wǎng)頁(yè))。唯一的修改是根據(jù)文本稍微調(diào)整序列大小。

下面是Christopher Schmidt在Twitter上對(duì)這個(gè)“假房子”網(wǎng)站的簡(jiǎn)要介紹,包括靈感來(lái)源、大致結(jié)構(gòu)、構(gòu)建頁(yè)面使用的框架和訓(xùn)練方式等。

本頁(yè)面在開(kāi)發(fā)時(shí)主要使用以下幾種模型:在構(gòu)建圖片和臥室照片時(shí)使用StyleGAN,一些文本網(wǎng)絡(luò)的訓(xùn)練使用了tf.keras來(lái)生成地點(diǎn)名稱、房主姓名、標(biāo)題和描述。此外還使用了Tensorflow的實(shí)例代碼)

所有的數(shù)據(jù)訓(xùn)練過(guò)程都在谷歌的Colab上完成,該平臺(tái)上可以免費(fèi)使用GPU和TPU來(lái)訓(xùn)練和生成數(shù)據(jù)。

每個(gè)模型都可以做出獨(dú)立的預(yù)測(cè),所以會(huì)經(jīng)常出現(xiàn)各部分信息不相配的情況,比如描述信息中說(shuō)某套房子有一間臥室,但列表信息中顯示有四件臥室,或者外觀和名字排列不齊等。

但總的來(lái)看,這個(gè)過(guò)程是比較理想的,我在這個(gè)學(xué)習(xí)過(guò)程中也獲得了不少樂(lè)趣,進(jìn)一步掌握了一些模型的使用技巧。這里要感謝Colab平臺(tái),更感謝StyleGAN社群的出色研究成果。

有了這個(gè)思路,應(yīng)用方向什么的就不用愁了,基于StyleGAN模型的假簡(jiǎn)歷、假食物、假貓咪等等如雨后春筍一樣不斷涌現(xiàn)。甚至有人把這些“造假成果”匯總到了一個(gè)網(wǎng)站,叫“這些東西都不存在”。

這樣看來(lái),StyleGAN已經(jīng)火到了幾乎要被“玩壞”的程度。未來(lái)再出現(xiàn)什么樣的假貨,可能已經(jīng)不取決于模型本身,而是程序員們的腦洞了。

介紹了這么多,大家是不是也想玩一玩StyleGAN呢?打開(kāi)下方鏈接,快去嘗鮮吧!

-

人工智能

+關(guān)注

關(guān)注

1806文章

49014瀏覽量

249405 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1224瀏覽量

25446 -

英偉達(dá)

+關(guān)注

關(guān)注

22文章

3952瀏覽量

93741

原文標(biāo)題:StyleGAN玩出新高度!生成999幅抽象畫,人人都是畢加索(附代碼)

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

一個(gè)套件就能讓多路高清攝像頭接入樹(shù)莓派5?

搭載樹(shù)莓派CM5:Sfera Labs 工業(yè)控制器!

VIVADO自帶Turbo譯碼器IP核怎么用?

關(guān)于 樹(shù)莓派5 超頻:你需要知道的一切!

樹(shù)莓派也能實(shí)現(xiàn)海上自動(dòng)化駕駛?

原來(lái)樹(shù)莓派也可以用來(lái)逗貓......

騰訊混元3D AI創(chuàng)作引擎正式發(fā)布

ADS1194調(diào)試串口輸出,在一定時(shí)間的轉(zhuǎn)換后數(shù)據(jù)會(huì)少一位輸出,為什么?

LabVIEW抽象消息使用教程(上)

鍵盤就是電腦,樹(shù)莓派500來(lái)了!

如何使用 ChatGPT 進(jìn)行內(nèi)容創(chuàng)作

OrangePi 5 Max:樹(shù)莓派5的勁敵,小巧的?RK3588開(kāi)發(fā)板

一位網(wǎng)友便利用StyleGAN耗時(shí)5天創(chuàng)作出了999幅抽象派畫作!

一位網(wǎng)友便利用StyleGAN耗時(shí)5天創(chuàng)作出了999幅抽象派畫作!

評(píng)論