今天,DeepMind爆出一篇重磅論文,引發(fā)學(xué)術(shù)圈熱烈反響:基于最強圖像生成器BigGAN,打造了BigBiGAN,在無監(jiān)督表示學(xué)習(xí)和圖像生成方面均實現(xiàn)了最先進的性能!Ian Goodfellow也稱贊“太酷了!”

GAN在圖像合成方面一次次讓人們驚嘆不已!

例如,被稱為史上最強圖像生成器的BigGAN——許多人看到BigGAN生成的圖像都要感嘆“太逼真了!DeepMind太秀了吧!”

BigGAN生成的逼真圖像

這不是最秀的。今天,DeepMind的一篇新論文再次引發(fā)學(xué)術(shù)圈熱烈反響,論文題為《大規(guī)模對抗性表示學(xué)習(xí)》。

論文鏈接:

https://arxiv.org/pdf/1907.02544.pdf

在這篇論文中,DeepMind基于最先進的BigGAN模型構(gòu)建了BigBiGAN模型,通過添加編碼器和修改鑒別器將其擴展到表示學(xué)習(xí)。

BigBiGAN表明,“圖像生成質(zhì)量的進步轉(zhuǎn)化為了表示學(xué)習(xí)性能的顯著提高”。

研究人員廣泛評估了BigBiGAN模型的表示學(xué)習(xí)和生成性能,證明這些基于生成的模型在ImageNet上的無監(jiān)督表示學(xué)習(xí)和無條件圖像生成方面都達到了state of the art的水平。

這篇論文在Twitter上引發(fā)很大反響。GAN發(fā)明人Ian Goodfellow說:“很有趣,又回到了表示學(xué)習(xí)。我讀PhD期間,我和大多數(shù)合作者都對作為樣本生成的副產(chǎn)品的表示學(xué)習(xí)很感興趣,而不是樣本生成本身。”

Goodfellow說:“當(dāng)年我們在寫最初的GAN論文時,我的合著者@dwf(David Warde-Farley)試圖得到一些類似于BiGAN的東西,用于表示學(xué)習(xí)。5年后看到這一成果,我覺得太酷了。”

Andrej Karpathy也說:“無監(jiān)督/自監(jiān)督學(xué)習(xí)是一個非常豐富的領(lǐng)域,它將消除目前對大規(guī)模數(shù)據(jù)集的必要性.”

總結(jié)而言,這篇論文展示了GAN可以用于無監(jiān)督表示學(xué)習(xí),并在ImageNet上獲得了最先進的結(jié)果。

下面是BigBiGAN生成的一些重建樣本,可以看到,重建是傾向于強調(diào)高級語義,而不是像素級的細節(jié)。

下面,新智元帶來對這篇論文的詳細解讀。

基于BigGAN打造BigBiGAN:學(xué)習(xí)高級語義,而非細節(jié)

近年來,我們已經(jīng)看到視覺數(shù)據(jù)生成模型的快速發(fā)展。雖然這些模型以前局限于模式單一或少模式、結(jié)構(gòu)簡單、分辨率低的領(lǐng)域,但隨著建模和硬件的進步,它們已經(jīng)獲得了令人信服地生成復(fù)雜、多模態(tài)、高分辨率圖像分布的能力。

直觀地說,在特定域中生成數(shù)據(jù)的能力需要高度理解所述域的語義。這一想法長期以來頗具吸引力,因為原始數(shù)據(jù)既便宜——可以從互聯(lián)網(wǎng)等來源獲得幾乎無限的供應(yīng)——又豐富,圖像包含的信息遠遠超過典型的機器學(xué)習(xí)模型訓(xùn)練用來預(yù)測的類別標(biāo)簽。

然而,盡管生成模型取得的進展不可否認,但仍然存在一些令人困擾的問題:這些模型學(xué)到了什么語義,以及如何利用它們進行表示學(xué)習(xí)?

僅憑原始數(shù)據(jù)就能真正理解生成這個夢想幾乎不可能實現(xiàn)。相反,最成功的無監(jiān)督學(xué)習(xí)方法利用了監(jiān)督學(xué)習(xí)領(lǐng)域的技術(shù),這是一種被稱為自監(jiān)督學(xué)習(xí)(self-supervised learnin)的方法。

這些方法通常涉及以某種方式更改或保留數(shù)據(jù)的某些方面,并訓(xùn)練模型來預(yù)測或生成缺失信息的某些方面。

例如,Richard Zhang等人的研究(CVPR 2016)提出了一種非監(jiān)督學(xué)習(xí)的圖像著色方法,在這種方法中,模型被給予輸入圖像中顏色通道的子集,并經(jīng)過訓(xùn)練來預(yù)測缺失的通道。

作為無監(jiān)督學(xué)習(xí)手段的生成模型為self-supervised的任務(wù)提供了一個很有吸引力的替代方案,因為它們經(jīng)過訓(xùn)練,可以對整個數(shù)據(jù)分布建模,而不需要修改原始數(shù)據(jù)。

GAN是一類應(yīng)用于表示學(xué)習(xí)的生成模型。GAN框架中的生成器是一個從隨機采樣的潛在變量(也稱為“噪聲”)到生成數(shù)據(jù)的前饋映射,其中學(xué)習(xí)信號由經(jīng)過訓(xùn)練的鑒別器提供,用來區(qū)分真實數(shù)據(jù)和生成的數(shù)據(jù)樣本,引導(dǎo)生成器的輸出跟隨數(shù)據(jù)分布。

作為GAN框架的擴展,Vincent Dumoulin等人(ICLR 2017)提出adversarially learned inference(ALI)[7],或Jeff Donahue等人(ICLR 2017)提出bidirectional GAN (BiGAN)[4]方法,這些方法通過編碼器模塊將實際數(shù)據(jù)映射到潛在數(shù)據(jù)(與生成器學(xué)習(xí)的映射相反)來增強標(biāo)準(zhǔn)GAN。

在最優(yōu)判別器的極限下,[4]論文表明確定性BiGAN的行為類似于自編碼器,最大限度地降低了重建成本l?;然而,重建誤差曲面的形狀是由參數(shù)鑒別器決定的,而不是像誤差l?這樣的簡單像素級度量。

由于鑒別器通常是一個功能強大的神經(jīng)網(wǎng)絡(luò),我們希望它能產(chǎn)生一個誤差曲面,在重建時強調(diào)“語義”誤差,而不是強調(diào)低層次的細節(jié)。

BigBiGAN重建的更多圖像

論文證明了通過BiGAN或ALI框架學(xué)習(xí)的編碼器是在ImageNet上學(xué)習(xí)下游任務(wù)的一種有效的視覺表示方法。然而,它使用了DCGAN風(fēng)格的生成器,無法在這個數(shù)據(jù)集上生成高質(zhì)量的圖像,因此編碼器能夠建模的語義也相當(dāng)有限。

在這項工作中,我們再次使用BigGAN作為生成器,這是一個能夠捕獲ImageNet圖像中的許多模式和結(jié)構(gòu)的先進模型。我們的貢獻如下:

我們證明了BigBiGAN (BiGAN with BigGAN generator)與ImageNet上無監(jiān)督表示學(xué)習(xí)的最先進技術(shù)相匹敵。

我們?yōu)锽igBiGAN提出了一個更穩(wěn)定的聯(lián)合鑒別器。

我們對模型設(shè)計選擇進行了全面的實證分析和消融研究。

我們證明,表示學(xué)習(xí)目標(biāo)還有助于無條件生成圖像,并展示了無條件生成ImageNet的最先進結(jié)果。

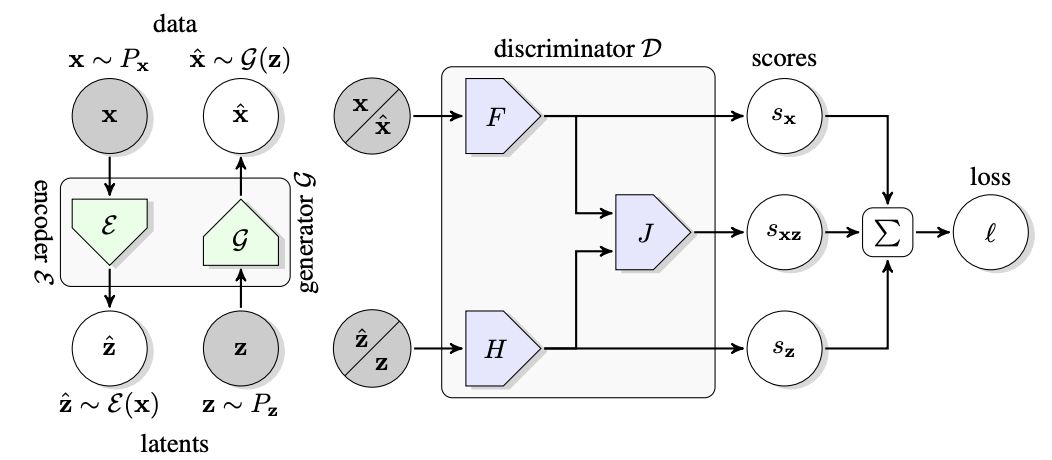

BigBiGAN框架的結(jié)構(gòu)

BigBiGAN框架的結(jié)構(gòu)

BigBiGAN框架的結(jié)構(gòu)如上圖所示。

聯(lián)合判別器D用于計算損失l。其輸入是data-latent pairs,可以是從數(shù)據(jù)分布 和編碼器

和編碼器 輸出采樣的

輸出采樣的 ,或從生成器G輸入和潛在分布

,或從生成器G輸入和潛在分布 采樣的?

采樣的? 。損失l包括一元數(shù)據(jù)項

。損失l包括一元數(shù)據(jù)項 和一元潛在項,以及將數(shù)據(jù)和潛在分布聯(lián)系起來的共同項。

和一元潛在項,以及將數(shù)據(jù)和潛在分布聯(lián)系起來的共同項。

評估和結(jié)果:表示學(xué)習(xí)、圖像生成實現(xiàn)最優(yōu)性能

表示學(xué)習(xí)

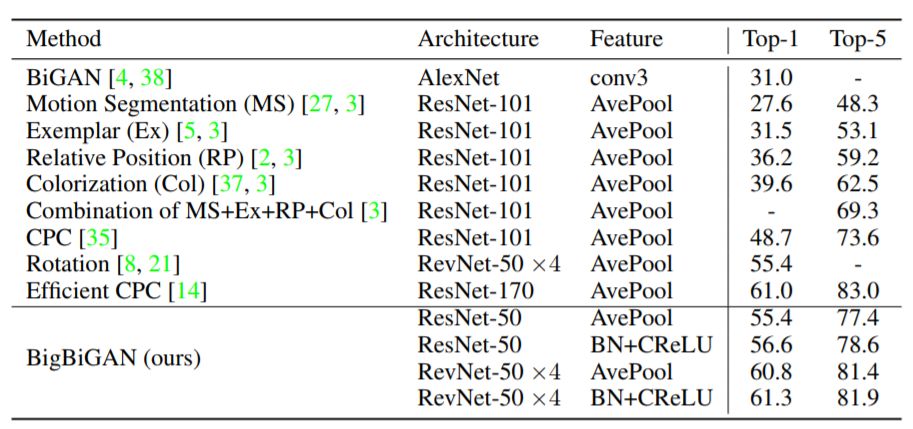

我們現(xiàn)在從上述簡化學(xué)習(xí)結(jié)果中獲取基于train-val分類精度的最優(yōu)模型,在官方ImageNet驗證集上得出結(jié)果,并與最近的無監(jiān)督學(xué)習(xí)研究文獻中的現(xiàn)有技術(shù)水平進行比較。

為了進行這些比較,我們還提供了基于規(guī)模較小的ResNet-50的最佳性能GAN變種的分類結(jié)果。詳細比較結(jié)果在表2中給出。

與當(dāng)前許多自監(jiān)督學(xué)習(xí)方法相比,本文中采用的純基于生成模型的BigBiGAN方法在表示學(xué)習(xí)方面表現(xiàn)良好,在最近的無監(jiān)督學(xué)習(xí)任務(wù)上的表現(xiàn)達到了SOTA 水平,最近公布的結(jié)果顯示,本文中的方法在使用表2的AvePool相同的表示學(xué)習(xí)架構(gòu)和特征的旋轉(zhuǎn)預(yù)測預(yù)訓(xùn)練任務(wù)中,將top-1精度由55.4%提高到60.8%。

表1:多個BigBiGAN變體的性能結(jié)果,在生成圖像的初始分?jǐn)?shù)(IS)和Fréchet初始距離(FID),監(jiān)督式邏輯回歸分類器ImageNet top-1精度百分比(Cls。)由編碼器特征訓(xùn)練,并基于從訓(xùn)練集中隨機抽樣的10K圖像進行分割計算,我們將其稱為“train-val”分割。

表2:在官方ImageNet驗證集上對BigBiGAN模型與最近的基于監(jiān)督式邏輯回歸分類器的其他方法的對比。

表3:我們的BigBiGAN與無監(jiān)督(無條件)生成方法、以及之前報告的無監(jiān)督BigGAN的性能結(jié)果對比。

無監(jiān)督式圖像生成

表3所示為BigBiGAN進行無監(jiān)督生成的結(jié)果,與基于BigGAN的無監(jiān)督生成結(jié)果做比較。請注意,這些結(jié)果與表1中的結(jié)果不同,因為使用的是數(shù)據(jù)增強方法(而非表1中的用于所有結(jié)果的ResNet樣式預(yù)處理方法)。

這些結(jié)果表明,BigBiGAN顯著提升了以IS和FID為量度的基線無條件BigGAN生成結(jié)果的性能。

圖2:從無監(jiān)督的BigBiGAN模型中選擇的圖像重建結(jié)果。上面一行的圖像是真實圖像(x~Px),下面一行圖像是由G(E(x))計算出的這些圖像的重建結(jié)果。與大多數(shù)顯式重建成本(例如像素數(shù)量)不同,由(Big)BiGAN 實現(xiàn)隱式最小化的重建成本更多傾向于強調(diào)圖像的語義及其他更高級的細節(jié)。

圖像重建:更偏重高級語義,而非像素細節(jié)

圖2中所示的圖像重建在像素上遠達不到完美,可能部分原因是目標(biāo)沒有明確強制執(zhí)行重建成本,在訓(xùn)練時甚至對重建模型進行計算。然而,它們可以為編碼器ε學(xué)習(xí)建模的特征提供一些幫助。

比如,當(dāng)輸入圖像中包含狗、人或食物時,重建結(jié)果通常是姿勢、位置和紋理等相同特征“類別”的不同實例。例如,臉朝同一方向的另一只類似的狗。重建結(jié)果傾向于保留輸入的高級語義,而不是低級細節(jié),這表明BigBiGAN的訓(xùn)練在鼓勵編碼器對前者進行建模,而不是后者。

-

編碼器

+關(guān)注

關(guān)注

45文章

3780瀏覽量

137308 -

圖像

+關(guān)注

關(guān)注

2文章

1094瀏覽量

41059 -

DeepMind

+關(guān)注

關(guān)注

0文章

131瀏覽量

11413

原文標(biāo)題:DeepMind爆出無監(jiān)督表示學(xué)習(xí)模型BigBiGAN,GAN之父點贊!

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

大語言模型:原理與工程時間+小白初識大語言模型

使用海爾曼太通/HellermannTyton 3D CAD 模型進行快速高效的設(shè)計

未來的AI 深挖谷歌 DeepMind 和它背后的技術(shù)

機器學(xué)習(xí)如何賦能風(fēng)力發(fā)電?DeepMind 做了以下嘗試 精選資料推薦

太秀了!小學(xué)生都開始學(xué)習(xí)華為鴻蒙了?

基于邊采樣的網(wǎng)絡(luò)表示學(xué)習(xí)模型

DeepMind攜手Unity,加速機器學(xué)習(xí)和人工智能研究

谷歌、DeepMind重磅推出PlaNet 強化學(xué)習(xí)新突破

BigBiGAN問世,“GAN父”都說酷的無監(jiān)督表示學(xué)習(xí)模型有多優(yōu)秀?

基于LSTM的表示學(xué)習(xí)-文本分類模型

語言模型做先驗,統(tǒng)一強化學(xué)習(xí)智能體,DeepMind選擇走這條通用AI之路

谷歌DeepMind發(fā)布機器人大模型RT-2,提高泛化與涌現(xiàn)能力

再登Nature!DeepMind大模型突破60年數(shù)學(xué)難題,解法超出人類已有認知

太秀了!DeepMind推出最強表示學(xué)習(xí)模型BigBiGAN

太秀了!DeepMind推出最強表示學(xué)習(xí)模型BigBiGAN

評論