隨著云計算、大數據、人工智能等技術的發展和應用,“東數西算”政策的落地以及數據中心規模不斷擴大,數據中心總體耗能不斷增加。傳統的散熱方式已不能滿足當前高密度數據中心的發展需求。液冷技術的出現,改善了傳統的散熱形式,并憑借高可靠、低能耗等優勢,逐步被應用于數據中心。

1 數據中心的發展階段

自20世紀60年代以來,數據中心發展分為三個階段:

一、早期階段

1996年,美國 Exodus 公司(專門從事機房設施建設和帶寬服務)首次提出 “IDC”。

二、第二階段

隨著時間的推移,數據中心托管服務開始精細化,從完全的服務器托管到網站托管,出現虛擬托管服務。

三、云計算階段

通過虛擬化技術和容器技術,徹底實現數據中心服務器計算能力資源的池化。所有的CPU、內存、硬盤等資源都由更強大的虛擬化軟件管理,然后分發給用戶。

2 數據中心的組成結構

從硬件類型上來說,數據中心和我們以前看到的內部機房差不多,只是規格、檔次、管理水平更高一點。

如今,隨著國家政策變化,國產 CPU 崛起占據越來越多的份額。國產 CPU 采用 ARM 架構,性價比更高,成本更低。

總體來說,數據中心的硬件分為兩類,即主設備和支撐設備。

一、主設備

數據中心最基本的主要設備是服務器。和臺式電腦一樣,包含CPU、內存、主板、硬盤、顯卡(GPU)、電源等。

藍海大腦服務器

服務器機架

一個常見標準機架,高度尺寸通常是 42U。1U等于4.445cm,機架寬度有600mm或800mm。機架深度有很多種,如有600mm、800mm、900mm、1000mm、1200mm等。一般來說,IT設備(服務器)機架較深(1100mm或1200mm),通信設備較淺(600mm)。

IT設備和通信設備的機架深度對比

機架中的IT設備除服務器之外,還有磁盤陣列等專業存儲設備。隨著大數據的發展,人類產生的數據量每年都在快速增加,增加了對存儲設備數量和性能的要求。

眾所周知,主流的電腦存儲硬盤分為HDD和SSD。HDD是傳統的機械硬盤,而SSD是逐漸普及的固態硬盤。SSD屬于半導體內存,由于存儲速度快體積小,所以很受歡迎。但價格較為昂貴。對于數據中心來說,HDD仍是性價比的主流選擇。目前SSD主要用于高端客戶和高性能業務。

說到交換機,我們不得不提到一個名詞 —— 架頂式。TOR 交換機是數據中心領域常用術語。顧名思義,就是機架頂部的交換機。這種交換機是數據中心最底層的網絡交換設備,負責連接這個機架中的服務器和上層的交換機。

TOR 交換機的位置

實際上,機架交換機并非一定放在機架頂部。可以位于機架的頂部,也可以位于機架的中部或底部(一般放在最上面,因為有利于內部布線)。

機架再往上是一排機架和 n 排機架。將這些機架與服務器連接起來需要數據中心的網絡技術(最流行的數據中心組網架構是葉脊網絡(Spine-Leaf))。

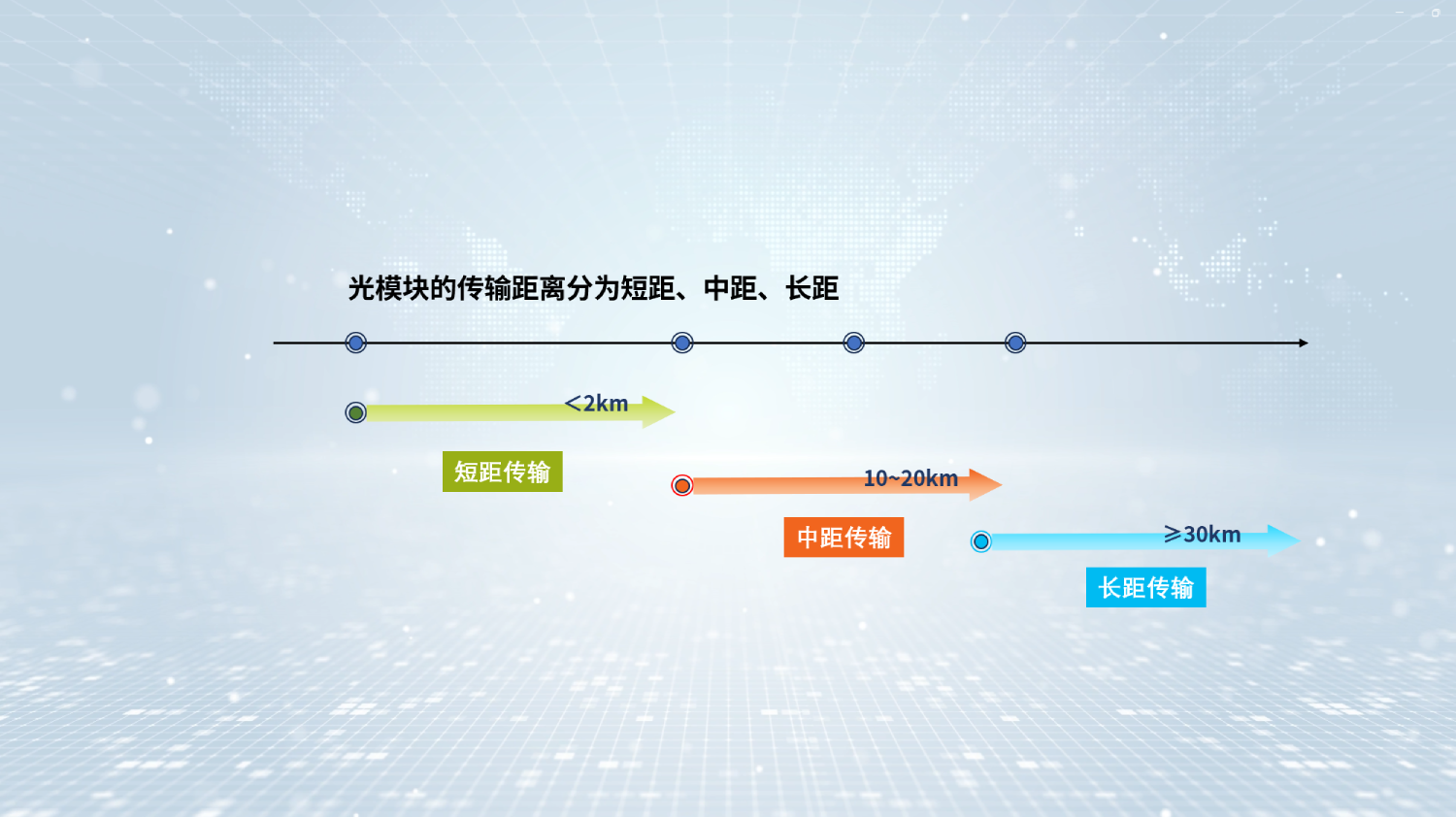

如今,為了高帶寬傳輸數據,數據中心廣泛使用光纖替代網線。所以光纖、光模塊和光通信設備 (OTN等) 成為數據中心的重要組成部分。

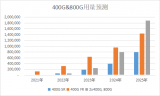

現在流行分布式部署,數據中心之間的數據流量很大,對帶寬要求很高。

光通信骨干網設備

二、配套設備

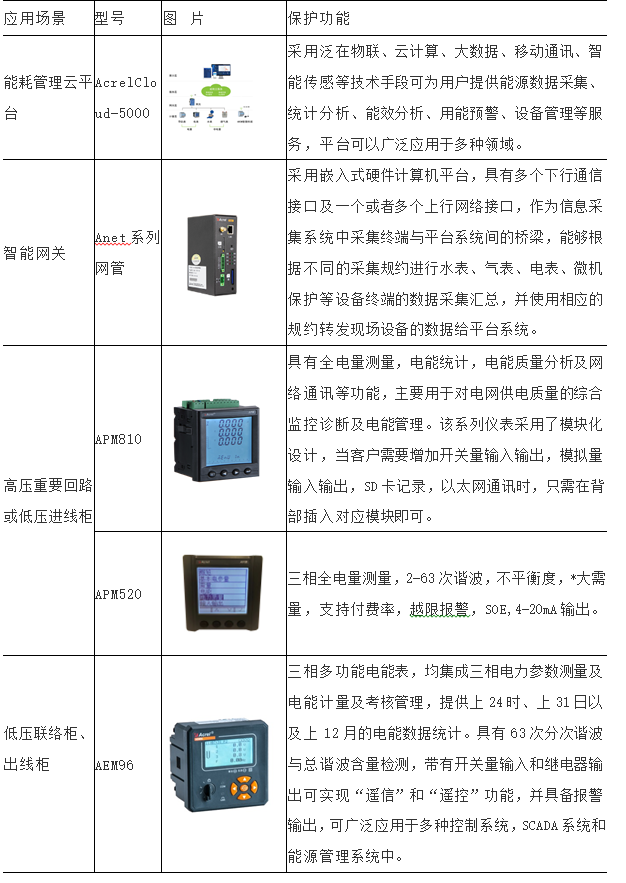

底層配套設備設施分為多種類型,主要包括供配電系統和冷卻系統,消防系統、監控系統和建筑管理系統。

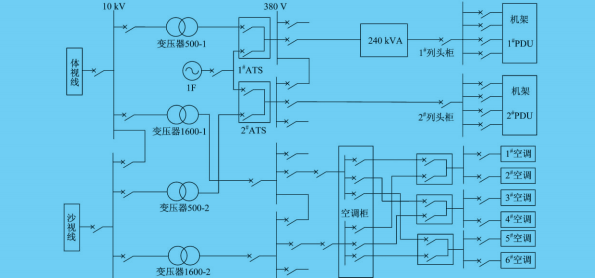

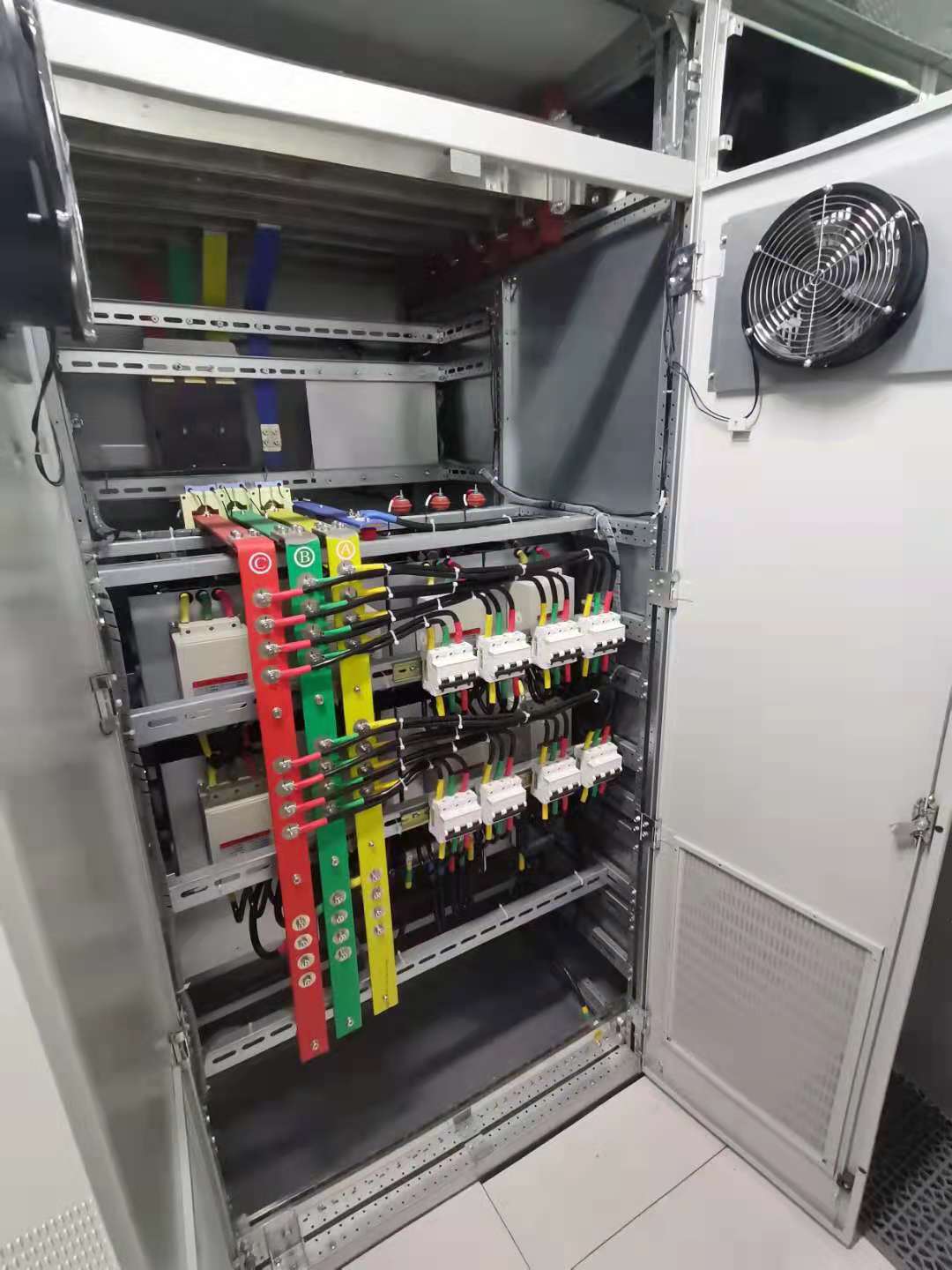

供配電系統

電源是數據中心正常運行的基礎。數據中心配電設備的主要功能是電能的開/關、控制和保護。主要配電設備是配電柜。數據中心配電柜分為中壓配電柜和低壓配電柜。

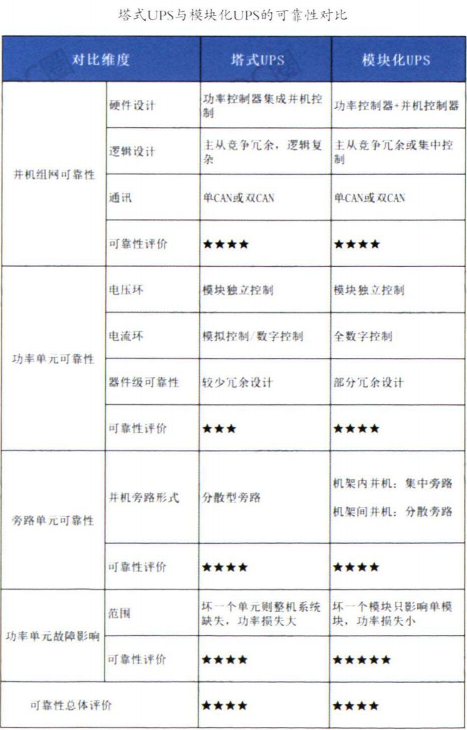

除配電柜,為保證緊急情況下的正常供電,數據中心還會配備大量的UPS(不間斷電源)甚至柴油發電機組。數據中心一般會提供 48V 直流電和 220V 交流電(通過 AC-DC 轉換和 DC-AC 逆變轉換)。直流現在正成為更多數據中心(如Google)的選擇,因為直流損耗更小,電能利用率更高,符合高計算能力數據中心高能耗的發展趨勢。

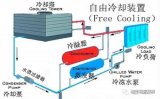

冷卻系統

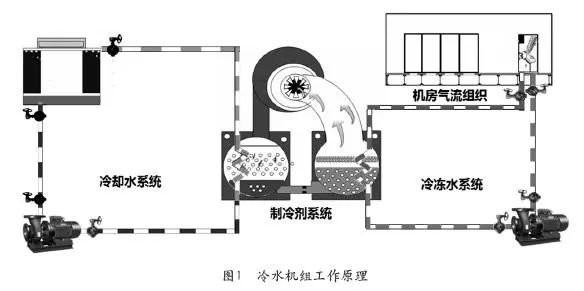

目前數據中心制冷主要包括兩種方式:風冷和液冷。

風冷

風冷一般采用風冷空調系統。和家用空調一樣,數據中心風冷空調也分為室內機和室外機。相對來說,技術成熟,結構簡單,容易維護。

液冷

液冷,利用液體作為制冷劑降溫散熱。液體的導熱系數是空氣的25倍。相同體積下,液體帶走的熱量是空氣的近3000倍。從噪音上來看,在相同的散熱水平下,液冷的噪音比風冷低 20-35 分貝。從能耗來看,液冷比風冷省30%-50%。目前液冷技術被業界普遍看好,但仍處于探索階段。總的來說,液冷的市場前景非常廣闊,據統計市場規模超過千億。

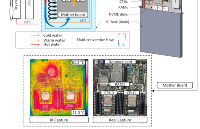

藍海大腦液冷散熱技術

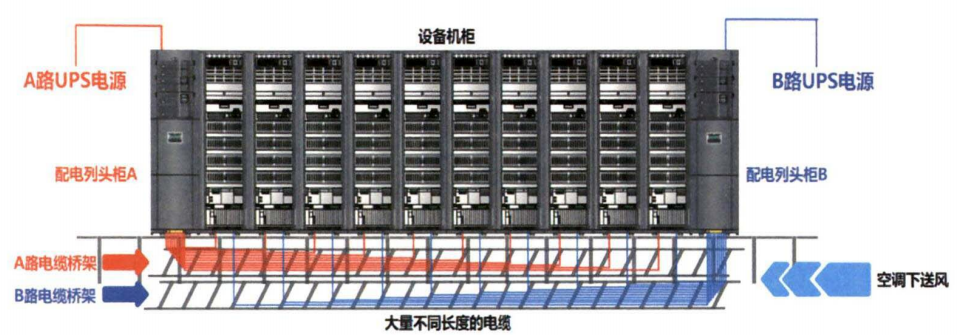

關于制冷散熱值得一提的是,機柜池級、排級、機柜級等近端制冷方式正在興起,成為新建數據中心的主流選擇。傳統制冷是房間級,整個機房都是空調制冷。這種方式冷卻路徑太長,效率太低,無法滿足大功率設備的散熱要求,能耗也很高。機柜池級、排級、機柜級是以一個機柜池、一排柜或單個機柜為中心進行散熱設計。

機柜排級散熱,以一排機柜為對象進行風道設計。氣流路徑明顯縮短,散熱效率高。除配電和散熱制冷之外,數據中心還有一些和管理運維有關的設備設施,例如動環監控系統、樓宇自動控制系統、消防系統等。

3 數據中心液冷技術發展分析

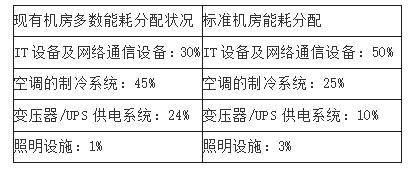

數據中心在信息社會和數字經濟發展中扮演著重要角色,提供計算、存儲、網絡能力、支撐社交、視頻、網購等應用的正常進行。如圖所示,數據中心能耗結構中冷卻系統能耗占據高達40%,成為數據中心進行能效優化的重要因素。

隨著國家對新基建的重視,數據中心迎來新的發展浪潮,伴隨著數字化社會的發展,數據中心也將會承擔越來越重要的角色,推動數據處理、存儲、傳輸等相關設備的建設與發展。

在發展方面,液冷技術在航天等領域內具有很長的應用歷史,而在數據中心行業中發展較為緩慢。有專家提出液冷結合風冷技術的雙通道系統,且測試實驗 PUE 結果達1.1 到1.2 之間;基于多個城市的液冷散熱樣本數據進行分析,構建不同城市數據中心制冷散熱系統的能耗計算模型,有效降低數據中心系統的能耗值。結合數據中心節能分析基礎上,采用熱回收技術,在降低數據中心能耗的同時,提升熱回收效益。在國外,也有大量的研究人員對降低數據中心的損耗進行大量的研究,產生了較多的應用案例,如IBM 公司的 SuperMUC 充分應用液冷技術的制冷優勢,大幅度降低了數據中心的損耗率。

針對數據中心液冷技術在不同行業的技術應用發展,下面主要從浸沒式、冷板式、噴淋式三種液冷技術的發展進行分析,并將三種液冷技術的特點進行系統的對比,總結出液冷技術的不同特點以及適用應用場景類型,為數據中心液冷技術的場景應用及技術發展提供參考。

液冷技術分析

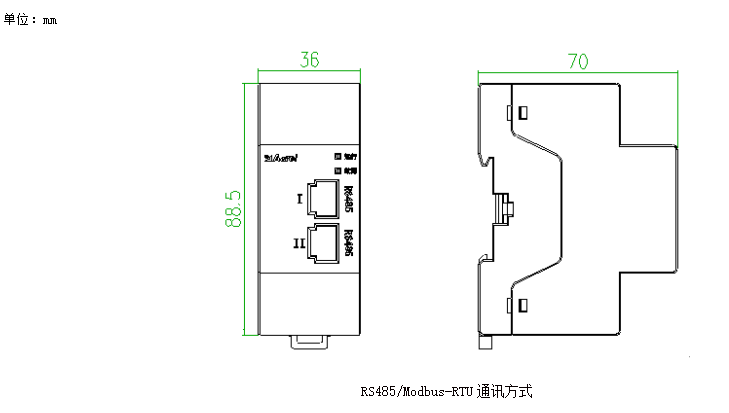

液冷技術是電子設備進行散熱的技術,主要區別于目前常用的風冷技術。當前液冷技術包括浸沒式、冷板式、噴淋式等類型。

一、浸沒式液冷技術

浸沒式液冷技術通過浸沒發熱器件,使得器件與液體直接接觸,進而進行熱交換。根據介質是否存在相變化分為單相浸沒和相變浸沒兩種類型。

浸沒式液冷技術主要由冷卻液、腔體結構、換熱模塊及相關的連接管道等設施構成。其中,冷卻液為數據中心的換熱介質,具有高絕緣、低黏度以及超強兼容特性,是浸沒式液冷技術的主要媒介。主板芯片等發熱器件表面散熱性能在很大程度上影響介質沸騰的換熱強度,若芯片表面光滑,則液體在換熱面上傳熱系數較高,從而提高熱量的散發速率。市場上常采用安裝散熱罩的方式,增大芯片的散熱面積,從而提高數據中心的散熱性能,降低損耗率。冷卻模塊是浸沒式液冷技術的主要散熱模塊,包含液氣換熱器、循環泵等多個配件設施。冷卻模塊的部署方式可以影響冷卻液的冷凝換熱效率,改變浸沒式系統的冷卻極限,從而降低數據中心的散熱效率,其模塊大多適用于高性能、高熱流的計算場景,如中科曙光 E 級超算設備,完全擺脫風冷散熱的制約,去除風冷式散熱器,配置 512 個計算節點,系統峰值功耗為 249 kW,PUE 達 1.04,有效解決高密度計算產生的制冷散熱問題。

二、冷板式液冷分析

冷板式液冷系統主要由換熱冷板、熱交換單元和循環管路、冷源等部件構成。冷板式液冷將熱量傳遞給循環管道中的冷卻液體,通過液體本身的制冷特性將服務器產生的熱量帶走,提高冷板的冷卻效率,大幅度降低數據中心的能耗。

換熱冷板通過空氣、水或其他冷卻介質在通道中的強迫對流,帶走服務器中的耗熱能量,可有效降低數據中心的 PUE 值。冷板材質一般由高導熱系數的材料構成,使得冷板表面接近等溫,帶走大量的集中熱量。并且冷板的應用減少冷卻介質對電子元器件的污染,提高數據中心設施的使用壽命。冷量分配單元主要為豎直和水平兩種形式,通過豎直和水平分液單元將低溫冷卻液均勻的分配給每一個分液單元,防止芯片熱量無法有效散出,減少因節點溫度升高而發生的隱患,提高系統的計算能力。循環管路是連接換熱冷板、熱交換單元以及其他相關器件的重要部件,一般分為直連式和環路式兩種類型,大多根據數據中心建設的不同需求,選擇合適的管路進行連接。冷源作為帶走數據中心產生熱量的最終出口,是冷卻系統的主要組成部分。大多采用室外冷卻設備提供的低溫冷卻水在熱交換單元中充當冷源。冷源與升溫后的冷卻液進行間接接觸,通過帶走冷卻液的熱量進行降溫,使冷卻液以低溫狀態進入芯片模塊,進而進入散熱循環。因此,冷源的選擇合理與否,將會直接影響整個系統的使用效率及運行的經濟性問題,如阿里巴巴千島湖數據中心利用周邊環境的自然資源,采用湖水自然冷卻系統等技術,使PUE 達1.28,有效節省數據中心的建設成本。

三、噴淋式液冷分析

噴淋式液冷一般不需要對數據中心的基礎設施進行大幅度地改動,只需在噴淋模塊調整噴淋頭,實現噴淋設備與服務器的精準對應。與傳統風冷服務器相比,其可以有效降低器件所產生的熱量,從而控制數據中心運行的溫度。噴淋式液冷服務器是整個噴淋系統的主要內部器件,憑借其高性能、低能耗、高可靠運行的特點,可以有效降低數據中心能耗。當前,先進的噴淋式液冷服務器大多采用芯片級噴淋液冷技術,通過冷卻液帶走部件產生的熱量,冷卻液的溫度提升后,隨即進入冷卻系統的換熱裝置進行換熱。

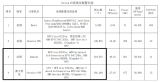

四、液冷技術對比

對冷板式、浸沒式、噴淋式液冷技術進行比對,具體情況如表所示。由表可以看出,冷板式液冷技術在可維護性、空間利用率、兼容性方面具有較強的應用優勢;但在成本方面,由于其單獨定制冷板裝置的原因,導致技術應用的成本相對較高。而噴淋式液冷技術則通過改造舊式的服務器和機柜的形式,大幅度減少了數據中心基礎設施的建設成本。浸沒式技術與其他兩種技術相比,雖然器件的可維護性和兼容性較差,但空間利用率與可循環方面具有較好的表現,降低數據中心的能耗。

液冷產業發展分析

一、行業應用問題分析

液冷技術在數據中心行業的散熱方面具有顯著的優勢,但在數據中心行業大規模應用,仍需提高技術的創新性和適用性,需要解決以下行業發展問題。

1、液冷適用性

每一種新興技術的應用,都需要廠商進行長期的實驗,才能保證技術穩定性。并且在大批量應用之前需進行小規模的定點實驗,提高液冷的實用性。當前,液冷技術應當進一步加強小規模的定點實驗,并努力批量應用于數據中心行業中。

2、液冷架構重構性

液冷方式的部署環境與傳統的機房有較大的差異,而且部署架構也需要重新構建。因此,采用液冷技術不但面臨高額的部署費用,而且也增加運維人員的時間成本,大幅度升高了數據中心的運維成本,因此,需要進一步在架構、運維等方面進行優化。

3、液冷設計規范性

液冷在數據中心的建設和測試過程中缺乏成熟的行業規范,大部分企業均根據自身的需求特點進行研發,未達成業界的統一標準。若未進行標準化統一管理,會導致液冷技術不規范發展,一旦產生破壞性故障,會徹底打擊液冷技術的發展。同時,非標產品也不利于成本和應用,因此必須加快標準化進程。

二、行業發展建議

液冷技術在數據中心行業的應用中,需要逐步成熟的發展過程,必須依托廠商、用戶及行業組織的推進,才能在未來的發展中獲得大幅度提升,具體建議如下。

1、完善液冷技術材料的通用性,降低建設成本。

如冷板式液冷技術中,冷板的要求規格較多,導致冷板式技術的成本較高。若對液冷應用的原材料和配件進行深入研究,降低制造液冷原材料和配件的成本,將會大幅度提升液冷數據中心的發展速度。

2、提高液冷技術的運維效率。

液冷技術的運維與傳統風冷技術的運維方式相差較大,從而加劇運維人員的工作成本。因此,需要生產配件的各個廠商及設備商提供安裝、調試和運維的規范說明。通過標準化的流程,不但保障其應用的穩定性,而且大幅度提升運維人員的工作效率。

3、加強液冷技術驗證力度,確保技術可靠運行。

液冷技術的可靠性實施,需要依托于設備商、服務商、用戶等企業。從節能性、可靠性和適用性等方面,推進液冷技術示范試點的運行,并在加強驗證的基礎上,在數據中心行業進行大批量的推廣。

4 藍海大腦液冷解決方案

藍海大腦液冷技術通過液體作為熱量傳輸媒介,達到降低設備溫度的目的。液體直接導向熱源帶走熱量,不需要像風冷一樣間接通過空氣制冷。對于密度高、規模大、散熱需求高的數據中心優勢明顯。

液冷數據中心解決方案

對于需要最大性能、密度和效率的大型系統的客戶,超級計算機提供液冷機柜,支持緊湊刀片配置中所有組件的直接液冷。

架構包含許多支持高瓦數 CPU 和 GPU(超過500W)的創新功能,極大地減少互連布線需求,降低操作成本。液冷式基礎設施還帶來更緊湊的系統結構,減少使用昂貴的光互連電纜。

此外,其基礎設施經過精心設計,支持多處理器體系結構和加速器選項,至少在未來十年內與下一代CPU、GPU和互連技術保持向前兼容。

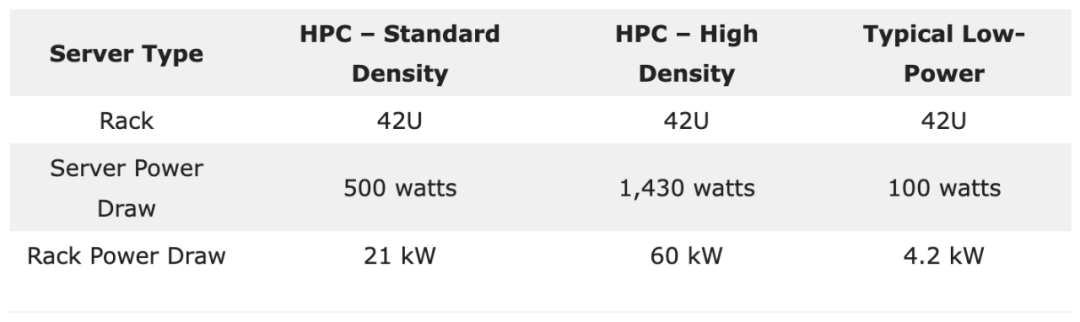

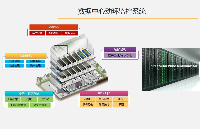

機柜架構

液冷機柜的計算和交換機基本構件包括:

服務器機柜:一臺機柜可容納8臺機箱,最多支持64個計算刀片和512個處理器。

計算刀片:刀片是機箱中的模塊,包括CPU、結構連接、印刷電路板,以及冷卻和電源組件。預裝四個雙插座節點。從機柜前部插入機箱。

交換機機箱:可容納8臺交換機箱,最多支持64個交換機。從機柜后部插入機箱。

交換機刀片:包含光纖交換機,電路板,用于連接計算刀片和冷卻所需的所有組件和電源。

每個機柜包含8個服務器機箱和8個交換機機箱,直接從交換機連到刀片上,無需布線。交換機和交換機端口都是直接液冷冷卻。刀片垂直放置,交換機水平放置,交換機可以直接與刀片相連接。

預裝的液冷計算刀片配備四臺雙處理器服務器。所有組件均采用直接液體冷卻方式。機柜未配置風扇。

網路

64 口交換機,提供 12.8 Tb/s 帶寬

每個交換機機箱最多支持8個交換機刀片,每個計算刀片最多支持8個光纖連接

每個機箱2個交換機,用于向32個計算節點(8個計算刀片)單點連接 (每個節點一個網絡連接)

每個機柜有16個交換機,用于向256個計算節點(64個計算刀片)單點連接 (每個節點一個網絡連接)

任何端點間,最多3次連接

電源

液冷機柜可支持高達300千瓦的功率。

冷卻

機柜和所有組件冷卻由貫穿整個計算設施的循環液體完成。冷卻分配單元(CDU)通過數據中心的熱交換器冷卻液體將熱水排出。

整個冷卻回路是一個源自CDU的閉環。一個CDU最多可以支持四個液冷機柜。CDU將冷卻液保持在一定溫度,并通過熱傳遞機制將熱量轉移到數據中心的水里。

液體冷卻通過一系列流管到達液冷柜中的各個刀片和部件,這些流管將冷卻液從主管道分配到各個刀片和交換機,然后將熱的液體回流管道。機柜前面配備計算刀片的冷卻管,后面配備交換機的冷卻管。計算刀片和交換機刀片之間的連接快速且無滴漏,可在不關閉整個系統的情況下卸下刀片服務器進行維護。冷板直接去除CPU中的熱量。當NIC夾層卡位于CPU上方時,由CPU冷板冷卻。液冷超級計算機的功率和冷卻預算大大小于風冷裝置。

5 如何構建數據中心?

在介紹建設過程之前,我們先了解一下數據中心的服務提供商。

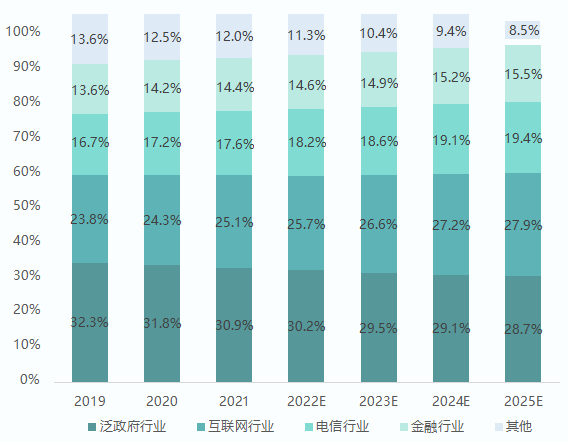

數據中心服務提供商

雖說數據中心是基礎設施,但不是完全屬于國有。也可以是民營,由私企建設和運營。但根據國家法律法規,必須持有互聯網數據中心經營許可證,才能提供數據中心服務。一般來說,數據中心服務商分為三類公司。

一、電信運營商,如中國移動、中國電信、中國聯通。

大型國企,資金雄厚,人才雄厚,資源豐富,基建經驗豐富,是國內數據中心市場的主導力量。以中國電信為例,作為國內最大的IDC服務商,他們擁有794個數據中心,50多萬個機架,數量最多,分布最廣。

二、云計算服務商,如阿里、騰訊、華為等。

提供商本身就開展云計算業務,所以自建或合建大量的數據中心。在數據中心的建設和運營方面非常專業,技術實力較強。以阿里為例,在全球25個地區部署上百個云數據中心,在張北、河源、南通、烏蘭察布、杭州等地擁有多個超級數據中心,投資數千億。

三、專業從事數據中心的第三方服務商,如萬國數據、世紀互聯、光環新網、寶信軟件、中金數據、奧飛數據、數據港等。

通過建設數據中心或者租用運營商的數據中心,為客戶提供服務,不受單一電信運營商的網絡和地域限制,可以提供相對均衡的網絡出口。同時,服務更加靈活,善于根據客戶的需求提供定制服務。

根據銷售方式不同,第三方數據中心又分為零售型數據中心和批發型數據中心。零售型數據中心面向中小型互聯網公司、一般企業等客戶,提供相對標準化的服務器托管服務和網絡帶寬服務。批發數據中心,面向大型互聯網公司、云計算廠商或電信運營商,提供定制服務,一般以模塊為最小出租單位。

數據中心的建設

數據中心的建設是一個專業性較強的項目,需要較強的資源整合能力。按照時間順序,數據中心建設不可避免地包括以下一系列專業項目:

選址

土地、電力、水、能源評估、環境評估等

可行性研究

項目立項

方案設計和施工圖設計

工程施工總包招標采購、以及監理招標采購

專業分包的包界劃分、工程分包商采購、主要設備采購

土建

機電安裝

設備調試

驗收交付

在數據中心選址階段,每個數據中心服務商都會根據自身需求和外部條件 (溫度、地質、自然災害、電力資源、能耗指標) 對數據中心選址進行規劃。

數據中心的設計非常復雜,需要考慮的因素很多,也會使用到大量的專業設計工具。

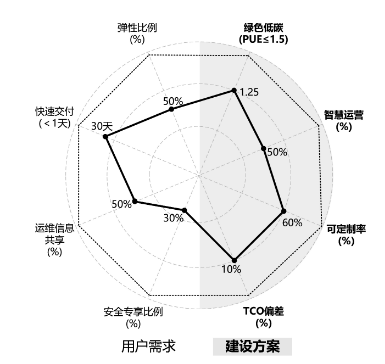

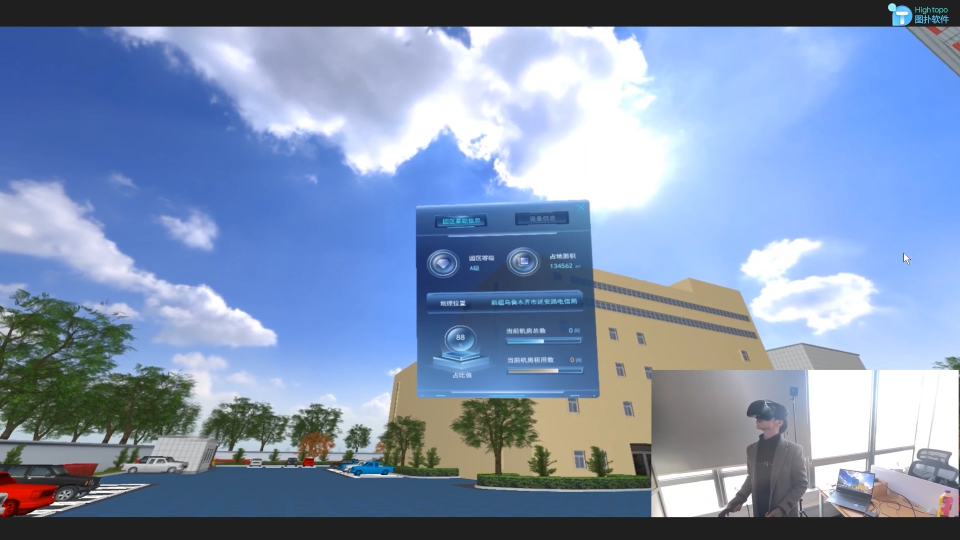

數據中心的規劃思路

該設計不僅包括樓宇和園區的總體概念設計,還包括數據中心各子系統的詳細設計。需要輸出每個細節的設計方案和施工圖,方便后續施工。設計完成后,進入真正的施工階段。施工流程就不一一介紹了。無非是土建施工、配套設備設施安裝、主體設備設施安裝調試等。

建設過程中的每一個細節,國家都有相應的標準來規范和約束。正規施工單位基本都能滿足要求。

幾項常見施工的步驟

6 總結

數據中心是數字時代重要的信息化實施是算力重要載體,直接決定國家的數字競爭力。在“東數西算”戰略的推動下,國內數據中心將迎來又一波發展熱潮。據統計,2022年中國數據中心業務市場規模將達到3200.5億元,年復合增長率為27.0%。2025年,國內數據中心IT投資規模預計將達到7070.9億元。除了數量的快速增加,數據中心正在向綠色和智能方向發展,積極引入AI人工智能,提高能效,降低運營復雜度。未來數據中心是否會有新的形態變化,我們拭目以待。

藍海大腦液冷服務器是面向數字中心建設的一站式服務器,具有超強算力密度、高能效比、高網絡帶寬、易擴展、易管理等優點,滿足企業機房部署、大規模數據中心集群部署和人工智能計算集群部署。

審核編輯:湯梓紅

電子發燒友App

電子發燒友App

評論