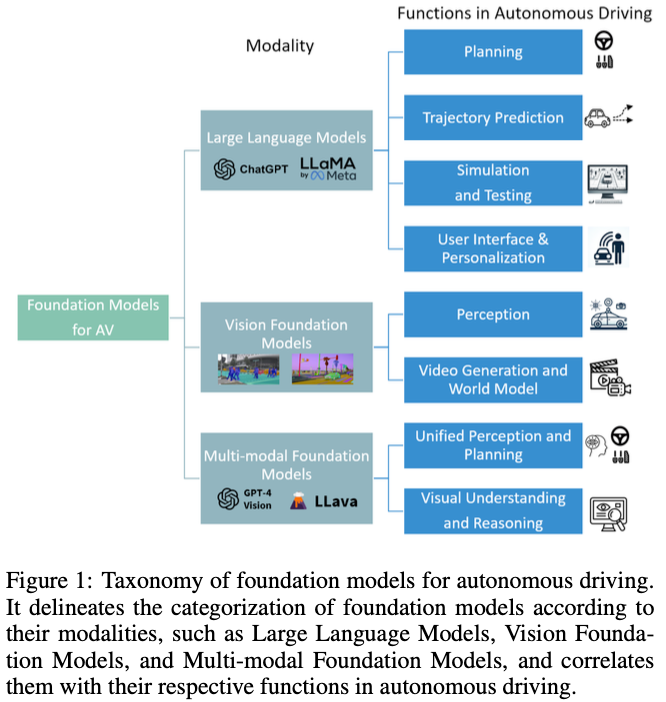

基礎模型的出現徹底改變了自然語言處理和計算機視覺領域,為其在自動駕駛(AD)中的應用鋪平了道路。這項調查對40多篇研究論文進行了全面回顧,展示了基礎模型在增強AD中的作用。大型語言模型有助于AD的規劃和模擬,特別是通過其在推理、代碼生成和翻譯方面的熟練程度。與此同時,視覺基礎模型越來越適用于關鍵任務,如3D目標檢測和跟蹤,以及為仿真和測試創建逼真的駕駛場景。多模態基礎模型,集成了不同的輸入,顯示了非凡的視覺理解和空間推理,對端到端AD至關重要。這項調查不僅提供了一個結構化的分類法,根據基礎模型在AD領域的模式和功能對其進行分類,還深入研究了當前研究中使用的方法。它確定了現有基礎模型和尖端AD方法之間的差距,從而規劃了未來的研究方向,并提出了彌合這些差距的路線圖。

簡介

深度學習(DL)與自動駕駛(AD)的融合標志著該領域的重大飛躍,吸引了學術界和工業界的關注。配備了攝像頭和激光雷達的AD系統模擬了類似人類的決策過程。這些系統基本上由三個關鍵組成部分組成:感知、預測和規劃。Perception利用DL和計算機視覺算法,專注于物體檢測和跟蹤。預測預測交通代理的行為及其與自動駕駛汽車的相互作用。規劃通常是分層結構的,包括做出戰略性駕駛決策、計算最佳軌跡和執行車輛控制命令。基礎模型的出現,特別是在自然語言處理和計算機視覺領域,為AD研究引入了新的維度。這些模型是不同的,因為它們在廣泛的網絡規模數據集上進行訓練,并且參數大小巨大。考慮到自動駕駛汽車服務產生的大量數據和人工智能的進步,包括NLP和人工智能生成內容(AIGC),人們對基礎模型在AD中的潛力越來越好奇。這些模型可能有助于執行一系列AD任務,如物體檢測、場景理解和決策,具有與人類駕駛員相似的智力水平。

基礎模型解決了AD中的幾個挑戰。傳統上,AD模型是以監督的方式訓練的,依賴于手動注釋的數據,這些數據往往缺乏多樣性,限制了它們的適應性。然而,基礎模型由于在不同的網絡規模數據上進行訓練,顯示出卓越的泛化能力。它們可以用從廣泛的預訓練中獲得的推理能力和知識,潛在地取代規劃中復雜的啟發式基于規則的系統。例如,LLM具有從預訓練數據集中獲得的推理能力和常識性駕駛知識,這可能會取代啟發式基于規則的規劃系統,后者需要在軟件代碼中手工制定規則并在角落案例中進行調試的復雜工程工作。該領域中的生成模型可以為模擬創建真實的交通場景,這對于在罕見或具有挑戰性的情況下測試安全性和可靠性至關重要。此外,基礎模型有助于使AD技術更加以用戶為中心,語言模型可以用自然語言理解和執行用戶命令。

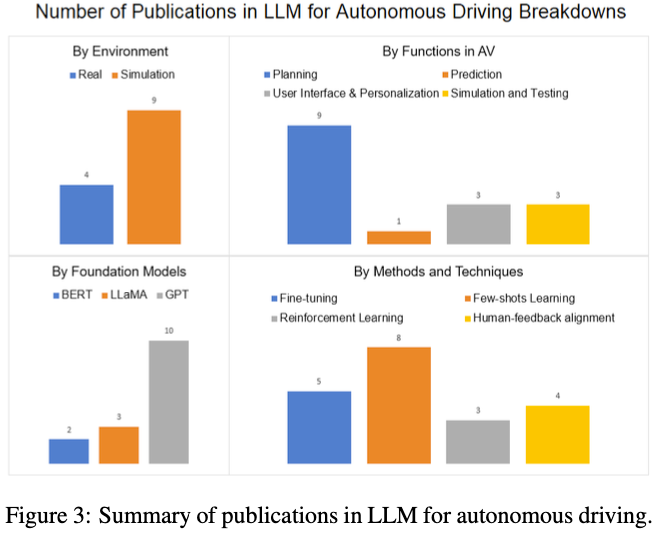

盡管在將基礎模型應用于AD方面進行了大量研究,但在實際應用中仍存在顯著的局限性和差距。我們的調查旨在提供一個系統的重新審視,并提出未來的研究方向。LLM4Drive更側重于大型語言模型。我們在現有調查的基礎上,涵蓋了視覺基礎模型和多模態基礎模型,分析了它們在預測和感知任務中的應用。這種綜合方法包括對技術方面的詳細檢查,如預先訓練的模型和方法,并確定未來的研究機會。創新性地,我們提出了一種基于模式和功能對AD中的基礎模型進行分類的分類法,如圖1所示。以下部分將探討各種基礎模型在AD環境中的應用,包括大型語言模型、視覺基礎模型和多模態基礎模型。

Large Language Models in AD

概述

LLM最初在NLP中具有變革性,現在正在推動AD的創新。BERT開創了NLP中的基礎模型,利用轉換器架構來理解語言語義。這種預先訓練的模型可以在特定的數據集上進行微調,并在廣泛的任務中實現最先進的結果。在此之后,OpenAI的生成預訓練轉換器(GPT)系列,包括GPT-4,由于在廣泛的數據集上進行了訓練,展示了非凡的NLP能力。后來的GPT模型,包括ChatGPT、GPT-4,使用數十億個參數和數萬億個單詞的爬行網絡數據進行訓練,并在許多NLP任務上取得了強大的性能,包括翻譯、文本摘要、問題回答。它還展示了從上下文中學習新技能的一次性和少量推理能力。越來越3多的研究人員已經開始應用這些推理、理解和上下文學習能力來應對AD中的挑戰。

AD中的應用

推理與規劃

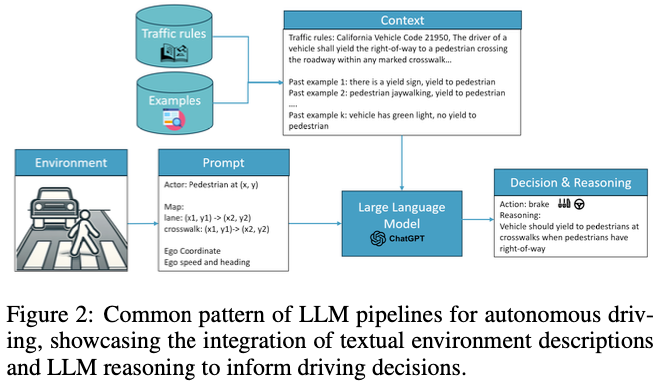

AD的決策過程與人類推理密切相似,因此必須對環境線索進行解釋,才能做出安全舒適的駕駛決策。LLM通過對各種網絡數據的培訓,吸收了與駕駛相關的常識性知識,這些知識來自包括網絡論壇和政府官方網站在內的眾多來源。這些豐富的信息使LLM能夠參與AD所需的細微決策。在AD中利用LLM的一種方法是向他們提供駕駛環境的詳細文本描述,促使他們提出駕駛決策或控制命令。如圖2所示,這個過程通常包括全面的提示,詳細說明代理狀態,如坐標、速度和過去的軌跡,車輛的狀態,即速度和加速度,以及地圖細節,包括紅綠燈、車道信息和預定路線)。為了增強對交互的理解,LLM還可以被引導在其響應的同時提供推理。例如,GPT駕駛員不僅建議車輛行動,還闡明了這些建議背后的理由,大大提高了自動駕駛決策的透明度和可解釋性。這種方法,以LLM駕駛為例,增強了自動駕駛決策的可解釋性。同樣,“接收、推理和反應”方法指示LLM代理人評估車道占用情況并評估潛在行動的安全性,從而促進對動態駕駛場景的更深入理解。這些方法不僅利用LLM理解復雜場景的固有能力,還利用它們的推理能力來模擬類似人類的決策過程。通過整合詳細的環境描述和戰略提示,LLM對AD的規劃和推理方面做出了重大貢獻,提供了反映人類判斷和專業知識的見解和決策。

預測

Prediction預測交通參與者未來的軌跡、意圖以及可能與自車交通工具的互動。常見的基于深度學習的模型基于交通場景的光柵化或矢量圖像,對空間信息進行編碼。然而,準確預測高度互動的場景仍然具有挑戰性,這需要推理和語義信息,例如路權、車輛的轉向信號和行人的手勢。場景的文本表示可以提供更多的語義信息,并更好地利用LLM的推理能力和預訓練數據集中的公共知識。將LLM應用于軌跡預測的研究還不多。與僅使用圖像編碼或文本編碼的基線相比,他們的評估顯示出顯著的改進。

用戶界面和個性化

自動駕駛汽車應便于用戶使用,并能夠遵循乘客或遠程操作員的指示。當前的Robotaxi遠程輔助界面僅用于執行一組有限的預定義命令。然而,LLM的理解和交互能力使自動駕駛汽車能夠理解人類的自由形式指令,從而更好地控制自動駕駛汽車,滿足用戶的個性化需求。LLM代理還能夠基于預定義的業務規則和系統要求來接受或拒絕用戶命令。

仿真和測試

LLM可以從現有的文本數據中總結和提取知識,并生成新的內容,這有助于仿真和測試。ADEPT系統使用GPT使用QA方法從NHTSA事故報告中提取關鍵信息,并能夠生成用于模擬和測試的各種場景代碼。TARGET系統能夠使用GPT將流量規則從自然語言轉換為特定領域的語言,用于生成測試場景。LCTGen使用LLM作為強大的解釋器,將用戶的文本查詢轉換為交通模擬場景中地圖車道和車輛位置的結構化規范。

方法和技巧

研究人員在自然語言處理中使用類似的技術,將LLM用于自動駕駛任務,如即時工程、上下文和少鏡頭學習,以及來自人類反饋的強化學習。

Prompt Engineering

Prompt engineering采用復雜的輸入提示和問題設計來指導大型語言模型生成我們想要的答案。

一些論文增加了交通規則作為前置提示,以使LLM代理符合法律。Driving with LLMs有交通規則,涵蓋紅綠燈過渡和左側或右側駕駛等方面。

LanguageMPC采用自上而下的決策系統:給定不同的情況,車輛有不同的可能動作。LLM代理還被指示識別場景中的重要代理,并輸出注意力、權重和偏差矩陣,以從預先定義的動作中進行選擇。

Fine-tuning v.s. In-context Learning

微調和上下文學習都用于使預先訓練的模型適應自動駕駛。微調在較小的特定領域數據集上重新訓練模型參數,而上下文學習或少鏡頭學習利用LLM的知識和推理能力,在輸入提示中從給定的例子中學習。大多數論文都專注于上下文學習,但只有少數論文使用微調。研究人員對哪一個更好的結果喜憂參半:GPT-Driver有一個不同的結論,即使用OpenAI微調比少鏡頭學習表現得更好。

強化學習和人類反饋

DILU提出了反射模塊,通過人工校正來存儲好的駕駛示例和壞的駕駛示例,以進一步增強其推理能力。通過這種方式,LLM可以學會思考什么行動是安全的和不安全的,并不斷反思過去的大量駕駛經驗。Surreal Driver采訪了24名駕駛員,并將他們對駕駛行為的描述作為思維鏈提示,開發了一個“教練-代理”模塊,該模塊可以指導LLM模型具有類似人類的駕駛風格。

限制和未來方向

幻覺與危害

幻覺是LLM中的一大挑戰,最先進的大型語言模型仍然會產生誤導和虛假信息。現有論文中提出的大多數方法仍然需要從LLM的響應中解析驅動動作。當給定一個看不見的場景時,LLM模型仍然可能產生無益或錯誤的駕駛決策。自動駕駛是一種安全關鍵應用程序,其可靠性和安全性要求遠高于聊天機器人。根據評估結果,用于自動駕駛的LLM模型的碰撞率為0.44%,高于其他方法。經過預先培訓的LLM也可能包括有害內容,例如,激烈駕駛和超速行駛。更多的人在環訓練和調整可以減少幻覺和有害的駕駛決策。

耗時和效率

大型語言模型通常存在高延遲,生成詳細的駕駛決策可能會耗盡車內有限計算資源的延遲預算。推理需要幾秒鐘的時間。具有數十億個參數的LLM可能會消耗超過100GB的內存,這可能會干擾自動駕駛汽車中的其他關鍵模塊。在這一領域還需要做更多的研究,如模型壓縮和知識提取,以使LLM更高效、更容易部署。

對感知系統的依賴

盡管LLM具有最高的推理能力,但環境描述仍然依賴于上游感知模塊。駕駛決策可能會出錯,并在環境輸入中出現輕微錯誤,從而導致重大事故。LLM還需要更好地適應感知模型,并在出現錯誤和不確定性時做出更好的決策。

Sim to Real Gap

大多數研究都是在仿真環境中進行的,駕駛場景比真實世界的環境簡單得多。為了覆蓋現實世界中的所有場景,需要進行大量的工程和人類詳細的注釋工作,例如,該模型知道如何向人類屈服,但可能不擅長處理與小動物的互動。

視覺基礎模型

視覺基礎模型在多個計算機視覺任務中取得了巨大成功,如物體檢測和分割。DINO使用ViT架構,并以自監督的方式進行訓練,在給定局部圖像塊的情況下預測全局圖像特征。DINOV2利用10億個參數和12億幅圖像的多樣化數據集對訓練進行了擴展,并在多任務中取得了最先進的結果。Segment-anything模型是圖像分割的基礎模型。該模型使用不同類型的提示(點、框或文本)進行訓練,以生成分割掩碼。在數據集中使用數十億分割掩碼進行訓練后,該模型顯示了零樣本傳遞能力,可以在適當的提示下分割新目標。

擴散模型是一種廣泛應用于圖像生成的生成基礎模型。擴散模型迭代地將噪聲添加到圖像,并應用反向擴散過程來恢復圖像。為了生成圖像,我們可以從學習的分布中進行采樣,并從隨機噪聲中恢復高度逼真的圖像。穩定擴散模型使用VAE將圖像編碼為潛在表示,并使用UNet將潛在變量解碼為逐像素圖像。它還有一個可選的文本編碼器,并應用交叉注意力機制生成基于提示的圖像(文本描述或其他圖像)。DALL-E模型使用數十億對圖像和文本進行訓練,并使用穩定的擴散來生成高保真圖像和遵循人類指令的創造性藝術。

人們對視覺基礎模型在自動駕駛中的應用越來越感興趣,主要用于3D感知和視頻生成任務。

感知

SAM3D將SAM應用于自動駕駛中的3D物體檢測。激光雷達點云被投影到BEV(鳥瞰圖)圖像中,它使用32x32網格生成點提示,以檢測前景目標的遮罩。它利用SAM模型的零樣本傳輸能力來生成分割掩模和2D盒。然后,它使用2D box內的激光雷達點的垂直屬性來生成3D box。然而,Waymo開放數據集評估顯示,平均精度指標與現有最先進的3D目標檢測模型仍有很大差距。他們觀察到,SAM訓練的基礎模型不能很好地處理那些稀疏和有噪聲的點,并且經常導致對遠處物體的假陰性。

SAM應用于3D分割任務的領域自適應,利用SAM模型的特征空間,該特征空間包含更多的語義信息和泛化能力。

SAM和Grounding DINO用于創建一個統一的分割和跟蹤框架,利用視頻幀之間的時間一致性。Grounding DINO是一個開放集目標檢測器,它從目標的文本描述中獲取輸入并輸出相應的邊界框。給定與自動駕駛相關的目標類的文本提示,它可以檢測視頻幀中的目標,并生成車輛和行人的邊界框。SAM模型進一步將這些框作為提示,并為檢測到的目標生成分割掩碼。然后將生成的目標掩碼傳遞給下游跟蹤器,后者比較連續幀中的掩碼,以確定是否存在新目標。

視頻生成和世界模型

基礎模型,特別是生成模型和世界模型可以生成逼真的虛擬駕駛場景,用于自動駕駛仿真。許多研究人員已經開始將擴散模型應用于真實場景生成的自動駕駛。視頻生成問題通常被公式化為一個世界模型:給定當前世界狀態,以環境輸入為條件,該模型預測下一個世界狀態,并使用擴散來解碼高度逼真的駕駛場景。

GAIA-1由Wayve開發,用于生成逼真的駕駛視頻。世界模型使用相機圖像、文本描述和車輛控制信號作為輸入標記,并預測下一幀。本文利用預訓練的DINO模型的嵌入和余弦相似性損失提取更多的語義知識用于圖像標記嵌入。他們使用視頻擴散模型從預測的圖像標記中解碼高保真駕駛場景。有兩個單獨的任務來訓練擴散模型:圖像生成和視頻生成。圖像生成任務幫助解碼器生成高質量的圖像,而視頻生成任務使用時間注意力來生成時間一致的視頻幀。生成的視頻遵循高級真實世界約束,并具有逼真的場景動力學,例如目標的位置、交互、交通規則和道路結構。視頻還展示了多樣性和創造力,這些都有現實的可能結果,取決于不同的文本描述和自我載體的行動。

DriveDreamer還使用世界模型和擴散模型為自動駕駛生成視頻。除了圖像、文本描述和車輛動作,該模型還使用了更多的結構性交通信息作為輸入,如HDMap和目標3D框,使模型能夠更好地理解交通場景的更高層結構約束。模型訓練分為兩個階段:第一階段是使用基于結構化交通信息的擴散模型生成視頻。

限制和未來方向

目前最先進的基礎模型(如SAM)對于3D自動駕駛感知任務(如物體檢測和分割)沒有足夠好的零樣本泛化能力。自動駕駛感知依賴于多個攝像頭、激光雷達和傳感器融合來獲得最高精度的物體檢測結果,這與從網絡上隨機收集的圖像數據集大不相同。當前用于自動駕駛感知任務的公共數據集的規模仍然不足以訓練基礎模型并覆蓋所有可能的長尾場景。盡管存在局限性,現有的2D視覺基礎模型可以作為有用的特征提取器進行知識提取,這有助于模型更好地結合語義信息。在視頻生成和預測任務領域,我們已經看到了利用現有擴散模型進行視頻生成和點云預測的有希望的進展,這可以進一步應用于創建自動駕駛模擬和測試的高保真場景。

多模態基礎模型

多模態基礎模型通過從多種模態(如聲音、圖像和視頻)獲取輸入數據來執行更復雜的任務,例如從圖像生成文本、使用視覺輸入進行分析和推理,從而受益更多。

最著名的多模態基礎模型之一是CLIP。使用對比預訓練方法對模型進行預訓練。輸入是有噪聲的圖像和文本對,并且訓練模型來預測給定的圖像和文字是否是正確的對。訓練該模型以最大化來自圖像編碼器和文本編碼器的嵌入的余弦相似性。CLIP模型顯示了其他計算機視覺任務的零樣本轉移能力,如圖像分類,以及在沒有監督訓練的情況下預測類的正確文本描述。

LLaVA、LISA和CogVLM等多模態基礎模型可用于通用視覺人工智能代理,它在視覺任務中表現出優異的性能,如目標分割、檢測、定位和空間推理。

將通用知識從大規模預訓練數據集轉移到自動駕駛中,多模態基礎模型可用于目標檢測、視覺理解和空間推理,從而在自動駕駛中實現更強大的應用。

視覺理解和推理

傳統的物體檢測或分類模型對于自動駕駛來說是不夠的,因為我們需要更好地理解場景的語義和視覺推理,例如識別危險物體,了解交通參與者的意圖。現有的基于深度學習的預測和規劃模型大多是暗箱模型,當事故或不適事件發生時,這些模型的可解釋性和可調試性較差。在多模態基礎模型的幫助下,我們可以生成模型的解釋和推理過程,以更好地研究問題。

Talk2BEV提出了一種融合視覺和語義信息的場景創新鳥瞰圖(BEV)表示。該管道首先從圖像和激光雷達數據中生成BEV地圖,并使用通用視覺語言基礎模型添加對物體裁剪圖像的更詳細的文本描述。然后,BEV映射的JSON文本表示被傳遞給通用LLM,以執行Visual QA,其中包括空間和視覺推理任務。結果表明,它很好地理解了詳細的實例屬性和目標的更高層次意圖,并能夠就自我載體的行為提供自由形成的建議。

統一感知和規劃

Wen對GPT-4Vision在感知和規劃任務中的應用進行了早期探索,并評估了其在幾個場景中的能力。它表明GPT-4Vision可以了解天氣、交通標志和紅綠燈,并識別場景中的交通參與者。它還可以提供這些目標的更詳細的語義描述,如車輛尾燈、U型轉彎等意圖和詳細的車輛類型(如水泥攪拌車、拖車和SUV)。它還顯示了基礎模型理解點云數據的潛力,GPT-4V可以從BEV圖像中投影的點云輪廓識別車輛。他們還評估了模型在規劃任務中的性能。考慮到交通場景,GPT4-V被要求描述其對車輛行動的觀察和決定。結果顯示,與其他交通參與者的互動良好,遵守了交通規則和常識,例如在安全距離內跟車,在人行橫道上向騎自行車的人讓行,在綠燈變綠之前保持停車。它甚至可以很好地處理一些長尾場景,比如門控停車場。

限制和未來方向

多模態基礎模型顯示了自動駕駛任務所需的空間和視覺推理能力。與傳統的目標檢測相比,在閉集數據集上訓練的分類模型、視覺推理能力和自由形式的文本描述可以提供更豐富的語義信息,可以解決許多長尾檢測問題,如特種車輛的分類、警察和交通管制員對手勢的理解。多模態基礎模型具有良好的泛化能力,可以很好地利用常識處理一些具有挑戰性的長尾場景,例如在受控訪問的門口停車。進一步利用其規劃任務的推理能力,視覺語言模型可用于統一感知規劃和端到端自動駕駛。

多基礎模型在自動駕駛中仍然存在局限性。GPT-4V模型仍然存在幻覺,并在幾個例子中產生不清楚的反應或錯誤的答案。該模型還顯示出在利用多視圖相機和激光雷達數據進行精確的3D物體檢測和定位方面的無能,因為預訓練數據集只包含來自網絡的2D圖像。需要更多特定領域的微調或預訓練來訓練多模態基礎模型,以更好地理解點云數據和傳感器融合,從而實現最先進的感知系統的可比性能。

結論和未來方向

我們對最近將基礎模型應用于自動駕駛的論文進行了總結和分類。我們基于自動駕駛中的模態和功能建立了一個新的分類法。我們詳細討論了使基礎模型適應自動駕駛的方法和技術,例如上下文學習、微調、強化學習和視覺教學調整。我們還分析了自動駕駛基礎模型的局限性,如幻覺、延遲和效率,以及數據集中的領域差距,從而提出了以下研究方向:

在自動駕駛數據集上進行特定領域的預訓練或微調;

強化學習和人在環對齊,以提高安全性并減少幻覺;

2D基礎模型對3D的適應,例如語言引導的傳感器融合、微調或3D數據集上的few-shot學習;

用于將基礎模型部署到車輛的延遲和內存優化、模型壓縮和知識提取。

我們還注意到,數據集是自動駕駛基礎模型未來發展的最大障礙之一。現有的1000小時規模的自動駕駛開源數據集遠遠少于最先進的LLM所使用的預訓練數據集。用于現有基礎模型的網絡數據集并沒有利用自動駕駛所需的所有模式,如激光雷達和環視攝像頭。網絡數據域也與真實的駕駛場景大不相同。

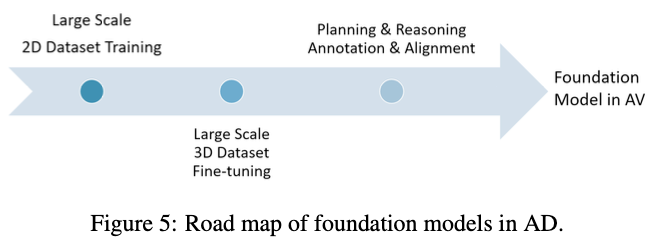

我們在圖5中提出了長期的未來路線圖。在第一階段,我們可以收集一個大規模的2D數據集,該數據集可以覆蓋真實世界環境中駕駛場景的所有數據分布、多樣性和復雜性,用于預訓練或微調。大多數車輛都可以配備前置攝像頭,在一天中的不同時間收集不同城市的數據。在第二階段,我們可以使用激光雷達使用更小但質量更高的3D數據集來改善基礎模型的3D感知和推理,例如,我們可以作為教師使用現有最先進的3D目標檢測模型來微調基礎模型。最后,我們可以在規劃和推理中利用人類駕駛示例或注釋來進行對齊,從而達到自動駕駛的最大安全目標。

審核編輯:黃飛

?

電子發燒友App

電子發燒友App

評論