為了解釋周圍的世界,AI系統(tǒng)必須理解三維視覺場景。這種需求不僅只局限于機器人技術(shù),同時包括導(dǎo)航,甚至是增強現(xiàn)實應(yīng)用。即便是2D照片與視頻,所描繪的場景和對象本身都屬于三維。真正智能的內(nèi)容理解系統(tǒng)必須能夠視頻中識別出杯子旋轉(zhuǎn)時的把手幾何形狀,或者識別出對象是位于照片的前景還是背景。

日前,F(xiàn)acebook公布了多項能夠推進3D圖像理解的AI研究項目。雖然不盡相同,但互為補充。正在國際計算機視覺大會(International Conference on Computer Vision)進行演示的項目涉及一系列的用例和情形,包含不同種類的訓(xùn)練數(shù)據(jù)和輸入。

Mesh R-CNN是一種新穎的,先進的解決方案,可以通過各種現(xiàn)實世界2D圖像預(yù)計最精確的3D形狀。這個方法利用了Facebook的Mask R-CNN框架進行對象實例分割,其甚至可以檢測諸如凳腳或重疊家具等復(fù)雜對象。

Facebook指出,通過利用Mesh R-CNN的替代和補充方法C3DPO,他們是第一個通過解釋3D幾何形狀而在三個基準(zhǔn)上成功實現(xiàn)非剛性形狀的大規(guī)模3D重建,對象類別涉及14種以上。需要注意的是,團隊僅使用2D關(guān)鍵點來實現(xiàn)這一目標(biāo),零3D注釋。

Facebook提出了一種新穎的方法來學(xué)習(xí)圖像與3D形狀之間的關(guān)聯(lián),同時大大減少了對含注釋訓(xùn)練示例的需求。這使得團隊更接近于開發(fā)出能夠為更多種類對象創(chuàng)建3D表示的自我監(jiān)督系統(tǒng)。

Facebook團隊同時開發(fā)了一種稱為VoteNet的新穎技術(shù),其可以利用LIDAR或其他傳感器的3D輸入執(zhí)行對象檢測。盡管大多數(shù)傳統(tǒng)系統(tǒng)都依靠2D圖像信號,但這個系統(tǒng)完全基于3D點云。與以前的研究相比,它可以實現(xiàn)更高的精度。

這項研究的基礎(chǔ)包括:利用深度學(xué)習(xí)來預(yù)測和定位圖像中對象的最新進步,以及用于3D形狀理解的全新工具和架構(gòu)(如體素,點云和網(wǎng)格)。計算機視覺領(lǐng)域已經(jīng)擴展到各種各樣的任務(wù),但3D理解將在支持AI系統(tǒng)進一步理解現(xiàn)實世界和執(zhí)行相關(guān)任務(wù)方面發(fā)揮核心作用。

1. 以高精度預(yù)測非約束遮擋對象的3D形狀

諸如Mask R-CNN這樣的感知系統(tǒng)是理解圖像的強大通用工具。但由于它們是根據(jù)2D數(shù)據(jù)進行預(yù)測,所以其忽略了世界的3D結(jié)構(gòu)。利用2D感知技術(shù)的進步,F(xiàn)acebook設(shè)計了一種3D對象重建模型,可以根據(jù)非約束的真實世界圖像預(yù)測3D對象形狀,包含具有一系列光學(xué)挑戰(zhàn)的圖像(如具有遮擋,雜波和各種拓?fù)涞膶ο螅⒌谌S帶到對象檢測系統(tǒng),同時實現(xiàn)對復(fù)雜情況的穩(wěn)定增加工作,這要求更為強大的工程能力,而當(dāng)下的工程架構(gòu)阻礙了所述領(lǐng)域的發(fā)展。

Mesh R-CNN根據(jù)輸入圖像預(yù)測里面的對象實例,并推斷其3D形狀。為了捕獲幾何形狀和拓?fù)涞亩鄻有裕紫阮A(yù)測粗略體素,將其精化并進行精確的網(wǎng)格預(yù)測。

為了應(yīng)對挑戰(zhàn),F(xiàn)aceboook團隊通過網(wǎng)格預(yù)測分支增強了Mask R-CNN的2D對象分割系統(tǒng),并構(gòu)建了Torch3d(Pytorch庫,其中包含高度優(yōu)化的3D運算符)以實現(xiàn)所述系統(tǒng)。Mesh R-CNN利用Mask R-CNN來檢測和分類圖像中的各種對象。然后,它使用新穎的網(wǎng)格預(yù)測器來推斷3D形狀(所述預(yù)測器由體素預(yù)測和網(wǎng)格細(xì)化的混合方法組成)。在預(yù)測精細(xì)3D結(jié)構(gòu)方面,這個兩步過程實現(xiàn)了比以前更高的精度。通過支持復(fù)雜操作的高效,靈活和模塊化實現(xiàn),Torch3d能夠幫助實現(xiàn)這一點。

他們利用Detectron2來實現(xiàn)最終的系統(tǒng),其使用RGB圖像作為輸入并同時檢測物體和預(yù)測3D形狀。與Mask R-CNN使用監(jiān)督學(xué)習(xí)來實現(xiàn)強大的2D感知類似,F(xiàn)acebook的新穎方法使用完全監(jiān)督學(xué)習(xí)(成對的圖像和網(wǎng)格)來學(xué)習(xí)3D預(yù)測。為了進行訓(xùn)練,團隊使用了由10000對圖像和網(wǎng)格組成的Pix3D數(shù)據(jù)集,而這比通常包含數(shù)十萬個圖像與對象注釋的2D基準(zhǔn)要小得多。

Facebook用兩組數(shù)據(jù)集評估了Mesh R-CNN,而他們均取得了亮眼的結(jié)果。對于Pix3D數(shù)據(jù)集,Mesh R-CNN是第一個能夠同時檢測所有類別對象,并在各種雜亂無章的家具場景中預(yù)計完整3D形狀的系統(tǒng)。先前的工作重點是在完美裁剪的,無遮擋的圖像中評估模型。對于ShapeNet數(shù)據(jù)集,體素預(yù)測和網(wǎng)格細(xì)化的混合方法的表現(xiàn)要比先前的研究提升7%。

Mesh R-CNN的系統(tǒng)綜述,F(xiàn)acebook用3D形狀推斷強化了Mask R-CNN

精確預(yù)測和重建非約束場景形狀是邁向增強虛擬現(xiàn)實和其他新型體驗的重要一步。盡管如此,與為2D圖像收集注釋數(shù)據(jù)相比,為3D圖像收集注釋數(shù)據(jù)要更加復(fù)雜和耗時,所以3D形狀預(yù)測的數(shù)據(jù)集發(fā)展相對滯后。所以,F(xiàn)acebook正在探索不同的方法來利用監(jiān)督學(xué)習(xí)和自我監(jiān)督學(xué)習(xí)來重建3D對象。

相關(guān)論文:Mesh R-CNN完整論文

2. 用2D關(guān)鍵點重建3D對象類別

對于無法利用網(wǎng)格對象和相應(yīng)圖像進行訓(xùn)練,而且無需完全重建靜態(tài)對象或場景的情況,F(xiàn)acebook開發(fā)了一種替代方法。全新的C3DPO(Canonical 3D Pose Networks)系統(tǒng)可以對3的D關(guān)鍵點模型進行重建,并通過更廣泛的2D關(guān)鍵點監(jiān)督來實現(xiàn)先進的重建結(jié)果。C3DPO能夠以適合大規(guī)模部署的方式來幫助你理解對象的3D幾何形狀。

C3DPO根據(jù)檢測到的2D關(guān)鍵點來為一系列對象類別生成3D關(guān)鍵點,能夠精確區(qū)分視點變化和形狀變形。

追蹤對象類別特定部分(如人體關(guān)節(jié)或小鳥翅膀)的2D關(guān)鍵點提供了有關(guān)對象幾何形狀及其形狀變形或視點變化的完整線索。生成的3D關(guān)鍵點十分有用,如用于3D面容和全身網(wǎng)格的建模,從而為VR構(gòu)建更逼真的虛擬化身圖形。與Mesh R-CNN相似,C3DPO使用非約束圖像來重建3D對象。

C3DPO是第一種能夠用數(shù)千個2D關(guān)鍵點來重建包含數(shù)十萬個圖像的數(shù)據(jù)集的方法。Facebook針對三種不同的數(shù)據(jù)集,14種以上不同的非剛性對象類別實現(xiàn)了先進的重建精度。相關(guān)代碼已經(jīng)托管至GitHub 。

Facebook的模型包含兩個重要的創(chuàng)新。首先,給定一組單目2D關(guān)鍵點,這個全新的3D重建網(wǎng)絡(luò)將預(yù)測相應(yīng)camera視點的參數(shù)以及3D關(guān)鍵點位置。其次,F(xiàn)acebook提出了一種名為Canonicalization的新穎正準(zhǔn)化技術(shù)(其包括一個第二輔助深度網(wǎng)絡(luò))。所述技術(shù)解決了因分解3D視點和形狀而帶來的歧義。這兩項創(chuàng)新使得Facebook團隊能夠?qū)崿F(xiàn)比傳統(tǒng)方法更優(yōu)秀的統(tǒng)計模型。

原來無法實現(xiàn)這種重建,這主要是因為以前基于矩陣分解的方法的存儲限制。與Facebook的深度網(wǎng)絡(luò)不同,所述方法不能在“小批量”狀態(tài)下運行。以前的方法通過利用多個同時出現(xiàn)的圖像,并建立瞬時3D重建之間的對應(yīng)關(guān)系來解決變形建模問題,而這需要特殊實驗室中專門研發(fā)的硬件。C3DPO帶來的高效率使得在不使用硬件進行3D捕捉的情況下實現(xiàn)3D重建成為可能。

相關(guān)論文:C3DPO的完整論文。

3. 從圖像采集中學(xué)習(xí)像素到表面映射

Facebook的系統(tǒng)學(xué)習(xí)了一個參數(shù)化卷積神經(jīng)網(wǎng)絡(luò)(CNN),它將圖像作為輸入并預(yù)測每個像素的正準(zhǔn)表面映射,其可以說明模板形狀的相應(yīng)位置點。2D圖像和3D形狀之間的正準(zhǔn)表面映射的相似著色暗示了對應(yīng)關(guān)系。

Facebook進一步減少了開發(fā)通用對象類別3D理解所需的監(jiān)督程度。他們介紹了一種可以通過近似自動實例分割來利用未注釋圖像集合的方法。Facebook沒有明確預(yù)測圖像的基礎(chǔ)3D結(jié)構(gòu),而是解決了將圖像像素映射到3D形狀類別模板表面的補充任務(wù)。

這種映射不僅允許團隊能夠在3D形狀類別的背景下理解圖像,而且可以歸納相同類別對象之間的對應(yīng)關(guān)系。例如,對于你在左側(cè)圖像中看到的高亮鳥喙,F(xiàn)acebook可以輕松地在右側(cè)圖像定位相應(yīng)的點。

這可以實現(xiàn)的原因是,F(xiàn)acebook能夠直觀地理解實例之間的共同3D結(jié)構(gòu)。將圖像像素映射到正準(zhǔn)3D表面的新穎方法同時為Facebook的學(xué)習(xí)系統(tǒng)帶來了這項功能。當(dāng)評估所述方法在各個實例之間傳輸對應(yīng)關(guān)系的準(zhǔn)確性時,其結(jié)果比原來的自我監(jiān)督方法(不利用任務(wù)的底層3D結(jié)構(gòu))高出兩倍。

Facebook的關(guān)鍵見解是,像素到3D表面的映射可以與逆操作(從3D到像素)配對,從而完成一個循環(huán)。Facebook團隊的新穎方法可實現(xiàn)這個目的,并且可以利用檢測方法的近似分割和無注釋的,免費的,公開可用的圖像集進行學(xué)習(xí)。Facebook的系統(tǒng)可以直接使用,并與其他自上而下的3D預(yù)測方法結(jié)合,從而提供對像素級3D的補充理解。相關(guān)代碼已經(jīng)托管至GitHub 。

如視頻中汽車顏色一致性所表明,F(xiàn)acebook的系統(tǒng)為運動和旋轉(zhuǎn)對象產(chǎn)生了不變的像素嵌入。這種一致性超出了特定的實例,并且在需要理解對象之間共性的情況下十分有用。

Facebook不是直接學(xué)習(xí)兩個圖像之間的2D到2D對應(yīng)關(guān)系,而是學(xué)習(xí)2D到3D對應(yīng)關(guān)系,并確保與3D到2D重投影的一致性。這種一致循環(huán)可用作學(xué)習(xí)2D到3D對應(yīng)關(guān)系的監(jiān)督信號。

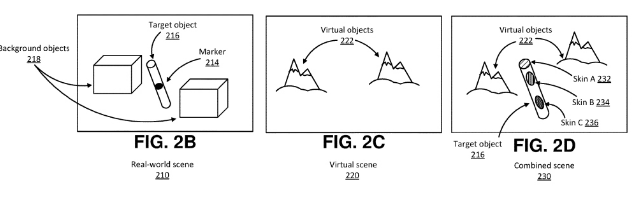

例如,如果要訓(xùn)練系統(tǒng)學(xué)習(xí)椅子就座的正確位置或茶杯握持的正確位置,當(dāng)系統(tǒng)下次需要理解如何就座另一張椅子或如何握持另一個茶杯時,這種表示就十分有用。這種任務(wù)不僅可以幫助你加深對傳統(tǒng)2D圖像與視頻內(nèi)容的理解,同時可以通過轉(zhuǎn)移對象表示來增強AR/VR體驗。

相關(guān)論文:正準(zhǔn)表面映射論文

4. 提升當(dāng)前3D系統(tǒng)的對象檢測基礎(chǔ)

隨著自動代理和3D空間掃描系統(tǒng)等尖端技術(shù)的不斷發(fā)展,我們需要推動對象檢測機制的進步。在這些情況下,3D場景理解系統(tǒng)需要知道場景中存在什么對象以及它們的位置,從而支持諸如導(dǎo)航之類的高級任務(wù)。Facebook通過VoteNet改進了現(xiàn)有系統(tǒng)。VoteNet是為點云量身定制的高精確端到端3D對象檢測網(wǎng)絡(luò),而它同時獲得了ICCV 2019大會的最佳論文提名。與傳統(tǒng)系統(tǒng)不同,VoteNet依賴于2D圖像信號,而這是首批完全基于3D點云的系統(tǒng)之一。與以前的研究相比,這種方法效率更高,識別精度更高。

Facebook的模型已經(jīng)開源。據(jù)介紹,NoteNet實現(xiàn)了最先進的3D檢測,其性能比原來所有的3D對象檢測方法都要優(yōu)秀,比SUN RGB-D和ScanNet中至少增加了3.7和18.4 mAP(平均精度)。VoteNet僅使用幾何信息,不依賴標(biāo)準(zhǔn)的彩色圖像,其性能優(yōu)于以前的方法。

VoteNet具有簡單的設(shè)計,緊湊的模型尺寸,能夠?qū)崿F(xiàn)高效率,全場景的速度約為100毫秒,而且內(nèi)存占用空間較小。Facebook的算法從深度攝像頭獲取3D點云,并返回對象的3D邊界框,包含語義類。

VoteNet架構(gòu)的示例圖

Facebook提出了受經(jīng)典Hough投票算法啟發(fā)的投票機制。使用這種方法,F(xiàn)acebook的系統(tǒng)能夠生成位于對象中心附近的新點,然后可以將它們進行分組和匯總。利用投票(由深度神經(jīng)網(wǎng)絡(luò)進行學(xué)習(xí))的基本概念,可以將一組3D種子點投票給對象中心,從而恢復(fù)它們的位置和狀態(tài)。

從自動駕駛汽車到生物醫(yī)學(xué),隨著3D掃描儀的使用情況正在日益增多,通過對3D場景的對象進行定位和分類來實現(xiàn)對3D內(nèi)容的語義理解非常重要。通過為2D攝像頭補充更先進的深度攝像頭傳感器以進行3D識別,F(xiàn)acebook團隊能夠捕獲任何給定場景的強大視圖。借助VoteNet,系統(tǒng)可以更好地識別場景中的主要對象,并支持諸如放置虛擬對象,導(dǎo)航或LiveMap構(gòu)建等任務(wù)。

5. 開發(fā)對真實世界有著進一步理解的系統(tǒng)

3D計算機視覺存在大量的開放性研究問題,而Facebook正在嘗試通過多種問題假設(shè),技術(shù)和監(jiān)督方法來推動所述領(lǐng)域的進步。隨著數(shù)字世界的不斷發(fā)展,3D照片和AR和VR體驗等新型產(chǎn)品的興起,我們需要不斷開發(fā)出更為智能的系統(tǒng)來更準(zhǔn)確理解視覺場景中的對象,并支持與其交互。

這是Facebook AI團隊的長期愿景,亦即開發(fā)出一個能如同人類般理解世界并與之交互的AI系統(tǒng)。他們表示:“我們一直在致力于縮小物理空間與虛擬空間之間的差距,并實現(xiàn)各個方面的科學(xué)突破。我們以3D為重點的最新研究同時可以幫助改善和更好地補充Facebook AI仿真平臺中的3D對象推動我們應(yīng)對在現(xiàn)實世界中進行實驗所面臨的復(fù)雜挑戰(zhàn)一樣,3D研究對于訓(xùn)練系統(tǒng)如何理解對象的所有視點(即使被遮擋或其他光學(xué)挑戰(zhàn))同樣很重要。”

Facebook團隊最后指出:“當(dāng)結(jié)合諸如觸覺感知和自然語言理解等技術(shù)時,諸如虛擬助手這樣的AI系統(tǒng)可以以更加無縫和有用的方式運行。總而言之,對于我們要構(gòu)建出能夠如同人類般理解三個維度的AI系統(tǒng),這種前沿研究正在幫助我們朝目標(biāo)不斷邁進。”

電子發(fā)燒友App

電子發(fā)燒友App

評論