英特爾(Intel)、英偉達(NVIDIA)、高通(Qualcomm)等半導體企業亦已低調地將觸角延伸至營收表現較為穩定的汽車電子市場,欲利用最新的處理器產品線切入聯網汽車領域。

2014-07-16 10:07:08 413

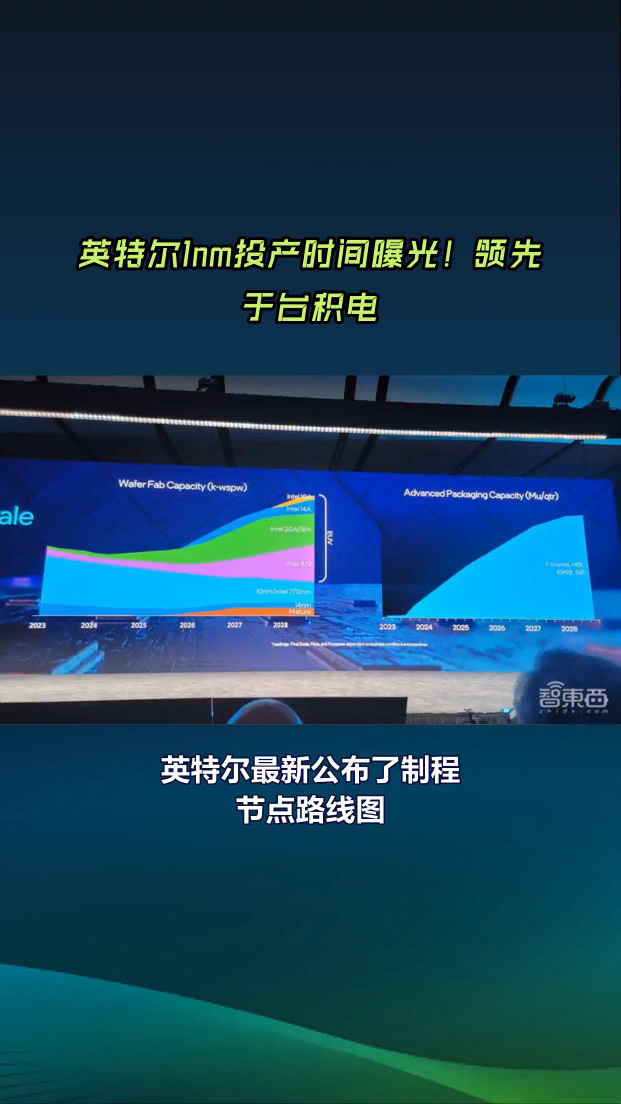

413 展示了在網絡、邊緣和企業的新硬件、軟件和服務方面的突破性創新。 此次在MWC2024上,英特爾帶來三大旗艦產品線:一、用于網絡工作負載的未來Granite Rapids-D和Sierra Forest處理器;二、幫助運營商變現其邊緣部署的英特爾邊緣平臺;三、用于商用AI PC的英特爾酷睿Ultra處理器

2024-03-04 07:57:00 2610

2610

C3000產品系列、英特爾? 至強? 處理器D-1500產品系列 - 網絡系列、25 GbE英特爾以太網適配器XXV710和下一代英特爾QuickAssist技術適配器,這些技術從數據中心到網絡邊緣

2017-03-01 17:23:20

。據表示,這些新晶片都采用英特爾的新電晶體技術與45奈米制程生產,可提升個人電腦速度、降低耗電需求、延長電池續航力、有益于環保,并催生更時尚精巧的電腦外觀設計。 此次發布的16款新產品中,有12款

2018-12-03 10:17:40

大家好,所以3天前我遇到了這個問題,當我更新我的英特爾驅動程序時,我的屏幕就像這樣我無法通過登錄屏幕,我已經嘗試了一切我可以重置我的筆記本電腦,重新安裝Windows,刪除我的nvidia驅動程序

2018-10-22 11:24:44

英特爾對外公開提出Optane DC Persistent Memory Module已經快一年的時間了,這個介于SSD和DRAM之間的新層級對于數據中心有很大的好處。持久內存的目標始終是將更多

2021-11-17 06:21:13

嗨,我最近從惠普購買了一臺新筆記本電腦。它采用Intel i5 8250U芯片組和Intel UHD 620 Graphics。我不明白為什么英特爾會更新所有其他處理器上的UHD 620,除了

2018-10-30 11:29:02

英特爾optane軟件崩潰了幾天?在此之前它工作正常。內存本身正在工作,那里沒有發生錯誤。以上來自于谷歌翻譯以下為原文Since a couple of days the intel optane

2018-11-14 11:44:35

英特爾和微軟正在漫長的道路上一步步地走向他們所構想的藍圖,即為未來多核處理器設計新型并行編程模型。兩個公司在英特爾發展論壇上發表了各自所取得的進展。

2019-07-31 06:39:24

你好,我來自德國,我的英語不是最好的...但我試著問我的問題。有一個來自英特爾的競爭,他們贈送了1.000英特爾i7-8086k盒裝處理器。這些處理器的保修情況如何,因為使用這些處理器你不會得

2018-10-22 11:38:21

你好,我有一個三星np-n150-haz1it我發現英特爾凌動N450受到幽靈的影響。怎么解決?最好的祝福以上來自于谷歌翻譯以下為原文Hello,I have a samsung

2018-10-26 14:49:01

英特爾今天發布了英特爾?凌動?處理器CE4100,這是英特爾媒體處理器系列中最新的SoC產品,將用于為數字電視、DVD播放器和高級機頂盒提供互聯網內容與服務。

2019-09-03 06:24:30

系統事業部產品線經理Mr. Sam Cravatta這樣表示。 “此次ROHM成功開發出用于新一代英特爾凌動處理器E3800產品系列的最佳PMIC.這是繼2010年9月推出英特爾凌動處理器E600系列

2018-09-29 17:07:20

,為那些要將來自不同供貨商之MEMS組件整合到產品中的設計工程師帶來不少麻煩。為此,英特爾、高通以及MEMS產業組織 (MIG)公布了一套“標準化傳感器性能參數規格(Standardized

2018-11-13 16:11:08

將亮相。 據了解,英特爾的Z3735D系列是專為入門級Android平板設計的Bay Trail處理器。這款處理器將于2014年第一季度發布,覆蓋的產品線包括8英寸至10英寸的平板電腦,這些平板

2013-12-19 16:48:30

英特爾媒體加速器參考軟件是用于數字標志、交互式白板(IWBs)和亭位使用模型的參考媒體播放器應用軟件,它利用固定功能硬件加速來提高媒體流速、改進工作量平衡和資源利用,以及定制的圖形處理股(GPU)管道解決方案。該用戶指南將介紹和解釋如何為Linux* 使用英特爾媒體加速器參考軟件。

2023-08-04 06:34:54

“嗨,很久以前我安裝了我的英特爾實感SDK以便使用D435相機。我看了一下”英特爾實感SDK 2.0的示例“。我非常關注”捕獲“和”保存技術“兩個例子,通過Visual Studio分析代碼。我

2018-10-18 14:13:50

`英特爾最近披露稱,它終于首次使用14納米加工技術制造成功試驗的芯片電路。英特爾計劃在2013年使用14納米加工技術生產代號為“Broadwell”的處理器。英特爾北歐及比利時、荷蘭、盧森堡經濟聯盟

2011-12-05 10:49:55

市場的競爭力。而這款產品,已經得到Facebook高管的認可。新節能芯片獲Facebook高管肯定英特爾在當地時間本周二推出的這款Atom芯片,采用了低能耗技術,相比傳統的英特爾服務器芯片,耗電量更少

2012-12-12 10:09:45

北京時間11月8日早間消息,盡管惠普與甲骨文有關安騰服務器的爭端尚未完全平息,但英特爾和惠普周四還是共同展示了基于高端安騰處理器的新一代服MAX3232EUE+T務器技術。 由于惠普和甲骨文

2012-11-09 15:48:19

)和M2M(機器對機器)市場。 英特爾架構事業部副總裁斯特凡·沃爾夫(Stefan Wolf)表示,這種系統芯片比類似的系統芯片體積小,將簡化產品開發和減少制作產品所需要的組件數量,為開發商減少

2012-08-07 17:14:52

你好我有一個問題英特爾高清顯卡控制面板保持“初始化”但不會打開我該怎么辦?以上來自于谷歌翻譯以下為原文Hello i have a problem intel HD graphic card

2018-10-29 14:37:07

:2017年9月1日15:13:00英特爾SoC設備檢測失敗:嘗試#0英特爾SoC設備檢測失敗:嘗試#1英特爾SoC設備檢測失敗:嘗試#2英特爾SoC設備檢測失敗:嘗試#3英特爾SoC設備檢測失敗:嘗試

2018-11-02 10:57:32

我們正在嘗試在Caffe開發的網絡的DevCloud中進行培訓。我們嘗試了LeNet,AlexNet和自定義網絡。沒有顯示有關培訓的狀態。英特爾的Caffe優化是否支持這些網絡?如果是這樣,您可

2018-12-05 10:43:25

英特爾公司今日宣布,英特爾將面向嵌入式市場為全新2010英特爾? 酷睿? 處理器系列中的十款處理器和三款芯片組提供7年以上生命周期支持。全新2010英特爾酷睿處理器系列能夠提供智能性能和高能效表現

2019-07-29 06:13:57

30億美元,同比下滑14%。同時,英特爾MAX3232EUE+T看淡四季度PC銷量,下調了營收預期目標,隨后該公司股票應聲下跌3%。 作為PC產業鏈上游的芯片廠商,英特爾的業績下滑顯然是受累于移動互聯

2012-11-07 16:33:48

你好,幾天前買了一個英特爾產品并收到了下載游戲包的鑰匙,但是列表上的一些游戲沒有任何鑰匙。試圖通過網站表單聯系支持位我收到一些錯誤。誰經歷過這個?祝你今天愉快 !以上來自于谷歌翻譯以下為原文

2018-11-19 14:09:51

`英特爾與AMD之間的相愛相殺,已經延續了30多年。兩位歡喜冤家一直唇槍舌劍、你來我往,斗得不亦樂乎。這場曠日持久的死亡競賽為全球科技圈增添了不少話題,也讓全球消費者用到更優質、更先進的技術和產品

2018-09-29 17:42:03

緩解供應鏈短缺。2021年1月,英特爾在越南投資了4.75億美元在本文中,我們將討論 ABF 基板,它對供應鏈的影響,以及英特爾的越南計劃是如何解決市場挑戰。什么是 ABF 基質?其中一個最不迷人

2022-06-20 09:50:00

。oneAPI是什么?oneAPI是一個統一的、簡化的編程模型,旨在簡化跨多架構的開發過程(如CPU、GPU、FPGA、加速器)。oneAPI包含兩個組成部分:一項產業計劃和一款英特爾? bete產品

2020-10-26 13:51:43

你好,我有一臺聯想瑜伽(Win10 1803)運行英特爾驅動程序&支持助手v3.5.1.7和系統有一個英特爾雙頻無線-N 7260.問題是英特爾驅動程序&當有更新的WiFi驅動程序

2018-10-23 10:48:52

和NVIDIA GTX 960M。顯示器的色溫配置為R-75,G-75,B-75(每個的最大設置為100)。英特爾高清顯卡4600可以選擇“默認RGB”,“限制RGB”或“全RGB”。此外,還有一個啟用或禁用

2018-10-26 14:53:25

10月31日,移動芯片領域的幕后巨頭ARM公司在北京正式發布了兩款64位處理器產品Cortex A50系列。這是ARM公布的首批64位處理器,意圖在移動領域進一步擴大自己相對于英特爾的領先地位,同時

2012-11-01 16:49:34

)“Windows”和提供核心硬件MPU的Intel,這是一個象征著兩公司“親密無間”和在IT市場上寡頭壟斷的詞匯。但在2011年1月,微軟宣布其新一代OS“Windows8”除英特爾的產品外,還可

2011-12-24 17:00:32

的x86架構超小型計算機“Edison”,銷售價格約為五十美元。在日本預定10月上市,主要以零售方式提供。 Edison是英特爾在2014年1月的“2014 International CES”上發表主題

2014-09-12 14:04:26

在這個高度依賴圖像的時代,英特爾? FPGA 可利用 OpenCL? 平臺滿足巨大的圖像處 理和分類需求簡介從 2015 年到 2020 年,互聯網視頻流量將增長四倍。[1] 鑒于可視數據的爆炸性

2019-07-17 06:34:16

方案之一角。 產業界一直在期待英特爾的機器學習計劃,這也是近幾年半導體產業界最熱門的技術領域之一;對此專長人工智能(AI)處理器設計的新創公司Graphcore共同創辦人暨執行長Nigel Toon

2016-12-23 16:50:37

2016年對半導體產業來說是艱難的一年,最后的統計數字也顯示整體產業成長表現平平;不過在FPGA領域卻看到不少變化,最引人矚目的就是英特爾(Intel)在2015年完成收購Altera。另一家

2017-03-11 17:29:16

iphone高通基帶和英特爾基帶,聲明:針對蘋果與高通基帶芯片專利糾紛,來了興致,收集一波信息.以下信息對百度百科的基帶芯片進行整理;維基百科沒有基帶芯片介紹;1 簡介基帶芯片是用來合成即將發射

2021-07-28 06:42:24

NAND產品已實現商用并出貨。“英特爾遵循摩爾定律,持續向前推進制程工藝,每一代都會帶來更強的功能和性能、更高的能效、更低的晶體管成本,”英特爾公司執行副總裁兼制造、運營與銷售集團總裁Stacy

2017-09-22 11:08:53

`【大賽介紹】英特爾智能硬件大賽·第二季,由英特爾硬享公社(CCE)發起,聯合華強聚豐等50家合作伙伴,集合全國各地硬創資源,尋找中國最具代表性的硬件創業項目;通過技術支持、資源對接、產品推廣等方式

2016-01-19 10:56:48

因此抑制了作為英特爾主要產品的x86處理器的需求。相比之下,移動處理器的需求將大幅度增長,并且預計在未來幾年肯定會增長。因此,像英特爾這樣的品牌廠商在這個時候進入移動領域是一個很理想的時機。至于蘋果

2013-03-12 11:40:10

任何人都可以告訴我為什么聯想不必更新英特爾圖形驅動程序?我一直看到英特爾圖形芯片的所有這些更新,這是我的筆記本電腦的一部分,但聯想從未更新它。出于某種原因,他們對Nvidia沒有同樣的權力,因為我

2018-11-08 11:21:27

近日,加入英特爾已有3個月的明星芯片架構師Jim Keller接受了外媒VentureBeat的采訪,在采訪中談及了自己加入英特爾的始末和讓其為之興奮的新角色——英特爾公司技術、系統架構和客戶端事業部高級副總裁兼芯片工程事業部總經理。

2019-07-25 07:31:03

`誰將會憑借更具優勢的策略在移動處理器領域獲得成功?未來手機的架構是由Intel還是ARM主導?英特爾的策略是主打X86處理器。在英特爾集團,負責歐洲UMPC市場的Jon Jadersten說:“在

2016-09-26 11:26:37

介紹英特爾?分布式OpenVINO?工具包可快速部署模擬人類視覺的應用程序和解決方案。 該工具包基于卷積神經網絡(CNN),可擴展英特爾?硬件的計算機視覺(CV)工作負載,從而最大限度地提高

2021-07-26 06:45:21

Coordinated Computing(英特爾? TCC)和時間敏感網絡(TSN),非常適合需要硬實時計算工作負載處理的應用領域,如工業自動化、自動駕駛、AI機器人以及航空等領域全球領先的邊緣計算解決方案提供商—凌

2023-02-15 10:30:48

你好。當我在英特爾RST中啟用英特爾Optane,然后重新啟動我的計算機時,Defraggler將加速驅動器看作只是一個硬盤驅動器,在任務管理器中,它將其視為“1.8TB硬盤+英特爾Optane”我

2018-10-31 10:12:53

現在移動領域絕大多數用的 ARM 提供的芯片授權,就連 iPhone 先是直接從三星(三星的也經過 ARM 授權)那里買,后來直接用經過 ARM 授權,自己設計的 A4 處理器。另外最近 ARM CEO 表示未來英特爾只會扮演小角色。在移動領域,ARM 在哪些方面領先英特爾?

2020-07-17 06:32:14

——面向嵌入式應用的英特爾凌動處理器平臺文/英特爾(中國)有限公司基于英特爾凌動處理器系列構建的相關平臺優勢明顯,可以用在車載信息娛樂系統、工業控制、醫療、零售等方面。車載信息娛樂系統:該平臺集

2019-07-18 07:05:50

奇怪的事正在圣克拉拉——英特爾的總部所在地發生。出于眾所周知的原因,英特爾前不久被傳出準備以10-20億美元收購以色列AI創業公司Habana Labs的消息,這是其既3.5億美元拿下N...

2021-07-26 07:31:53

絕非AMD“目前未有產品銷售”的市場。而且AMD作為唯一同時具備自有高端中央處理芯片和高端顯卡芯片產品線的大型芯片廠商,與英特爾簽訂技術授權協議無疑會削弱其獨一無二的市場競爭優勢。 與英特爾簽訂多年

2017-05-27 16:12:29

2008年10月20日:英特爾嵌入式與通信產品事業部總經理兼數字企業事業部副總裁Douglas L. Davis先生在中國臺北英特爾信息技術峰會上發表了題為“互聯網發展第四階段:嵌入式計算的崛起”主題演講,以下為其演講摘錄以及英特爾嵌入式產品相關新聞:

2019-07-16 07:30:18

怎么安裝適用于Linux *的OpenVINO?工具包的英特爾?發布版?

2021-09-23 08:33:34

本帖最后由 gk320830 于 2015-3-9 20:12 編輯

有高手破解了英特爾倍頻嗎,現在幾乎每個CPU都鎖定了倍頻,有高手破解了嗎,或者誰有英特爾倍頻對應的圖紙資料呢

2010-12-22 11:33:49

我安裝了英特爾optane內存,出現了安裝錯誤沒有兼容的磁盤用于英特爾操作系統內存。optane.txt.zip 5.9 K.以上來自于谷歌翻譯以下為原文I have the Intel

2018-10-12 11:50:39

全新的基于英特爾Bay Trail-T四核低功耗Windows平板——原道W11C和W11 Pro。此次發布會上,原道常務副總裁文和軍、英特爾中國區CTE銷售及市場總經理楊彬、微軟大中華區OEM事業部

2014-05-29 15:36:41

你好。我在處理器Intel atom C3538上開發了一塊主板。我需要為我的主板構建自定義BIOS(bootloader,硅初始化等)。因此,有一些問題:1.告訴我下載鏈接到英特爾凌動?處理器

2018-11-07 11:10:36

英特爾的未來樂觀嗎?看一看英特爾的盲點在哪里?英特爾有哪些死角?

2021-06-18 08:08:01

,而且可以減少散熱設備,設計更薄的產品。 與基于英特爾的Mac相比,基于ARM的芯片將具有多項優勢,例如更快的性能和更低的功耗。而且基于ARM的處理器還將利用人工智能顯著提高圖形性能和應用程序速度

2020-06-23 09:30:39

提升,性能相比英特爾處理器會大幅降低。而且,未來蘋果A系列芯片將橫跨其移動辦公產品,iPhone和iPad早早地使用了蘋果自研的ARM架構芯片,自研的ARM版芯片順利用于Mac電腦后,那蘋果移動端

2020-06-23 08:53:12

? AMD拋棄了英特爾 早在10月30日,AMD就宣布了,除原有的x86處理器外,公司還將設計面向多ST22I個市場的64位ARM架構處理器,新產品將首先供應云服務器和數據中心服務器市場。據悉,首

2012-11-06 16:41:09

騰訊科技訊,7 月 5 日據國外媒體報道,英特爾未來不會再向蘋果的 iPhone 智能手機提供基帶芯片了。英特爾剛剛確認,公司已經停止開發部分原本計劃使用在蘋果 iPhone 上的 5G 通信基帶

2021-07-23 06:20:50

是否有任何將EEPROM IIC文件轉換為英特爾十六進制的UTIONE?

2019-10-25 14:02:39

在被英特爾收購兩年之后,深度學習芯片公司 Nervana 終于準備將代號為「Lake Crest」的架構轉化為實際的產品了。對于英特爾來說,現在入局或許有些遲到,英偉達已經占據深度學習芯片市場很長一段時間了,后者有充分的時間通過新...

2021-07-26 07:04:35

適用于英特爾性能設備平臺的RMC

2019-08-20 07:53:05

我擁有一臺采用ICH10芯片組的英特爾DP45SG主板。我一直在使用Raid 1卷,并且自從幾年前升級到Windows 10以來,我一直在努力獲得英特爾快速存儲技術應用程序的工作版本。我可以在

2018-11-29 15:10:02

采用MMX技術的英特爾奔騰和奔騰

2019-02-26 08:05:26

` 馬宏升先生,現任英特爾中國區董事長。他于1982年加盟英特爾。 馬宏升在英特爾的工作生涯始于英特爾歐洲總部。在那MAX3232EUE+T里他工作了9年,先后擔任英特爾英國公司的應用工程經理

2012-09-26 17:12:24

?汽車電子、物聯網、網絡、移動芯片統統稱霸?這也太狠了。如此霸氣的公司你想到了誰?對!那就是英特爾。高通此舉自然讓英特爾襠下一緊,那英特爾最近的頻頻動作也讓高通略感胸悶。未來化趨勢,物聯網、自動駕駛等都是

2016-11-18 14:32:41

人才是技術能否蓬勃發展的基礎,而英特爾對于AI的策略,也考慮到知識與能力培養,他們將設立在線課程,并鼓勵學員參與資料科學競賽

2017-01-03 11:05:42 779

779

電子發燒友App

電子發燒友App

評論