需要注意哪些知識。首先一定遠離負能量的人,我曾記得有這樣的一句話“近墨者黑 近朱者赤”。這些影響還是很大的。如果一個人整天在你耳邊說學這沒用、學那很難。立馬讓滾~。我相信這都是坑友的,當然讓你別吃喝嫖賭

2021-07-18 17:52:29

遇到的問題是:只將AO直接連到其中一個AI,則8個AI采集到的數據相同。所用數據采集卡為:DAQ2501

2017-08-30 11:22:19

51學完了直接學stm32嗎?還是學一下其他的?

2016-09-15 17:00:34

1 個 AI 模型 = 5 輛汽車終身碳排量,AI 為何如此耗能?

2021-01-22 06:35:03

,可以組合出、、與阿拉伯數字,如下: 人們很容易就能辨識出來,那么我們如何去訓練AI機器,讓它具有智慧,也能迅速辨別出來呢? 本章就透過這范例,讓您來觀摩一下啰。 其中,最后一個看起來很像數字,在本范例里

2020-11-25 11:21:51

海量資料是怎么來的,光把這些資料瀏覽一遍就夠花上數月乃至上年的時間了。看完之后還只是懂個大概,該不會的還是不會,時間長了還都忘光了。倒不如踏踏實實靜下心來,吃透每一個知識點,理解每一個細節。本人學習C

2016-08-19 09:42:46

,且不說這些海量資料是怎么來的,光把這些資料瀏覽一遍就夠花上數月乃至上年的時間了。看完之后還只是懂個大概,該不會的還是不會,時間長了還都忘光了。倒不如踏踏實實靜下心來,吃透每一個知識點,理解每一個細節

2014-05-07 10:17:06

大家好,學51單片機先學C語言還是先學匯編?匯編要學到什么程度才開始學C語言?

2013-08-17 20:43:37

1. 學AI的出發點:如何提取特徵(Feature)說明: AI機器學習(Machine Learning)的基礎活動之一就是:提取特徵(Feature extraction)。在本文裡,藉由舉例

2020-11-30 17:11:56

剛到公司,boss給我們分方向,本科畢業 ,以后是學FPGA數字信號處理,還是學射頻比較好,我們公司是做測試儀器儀表的。

2015-06-26 14:57:44

01話 題經常有大學生同學糾結:我到底是學STM32還是學嵌入式linux。這個問題很多人都會有自己的看法,今天我試著從多個角度,把我了解到的事實講一下,希望對大家有所啟發。02STM3...

2021-12-16 07:54:35

學stm32之前有沒有必要學51,之前無際在網上看了一些老工程師給初學者的一些建議。其中一個就是新手可不可以直接跳過51單片機學習stm32。很多老鳥教唆初學者說51已經過時了,建議直接學stm32

2021-07-15 07:40:24

本人是南昌航空大學大二的學生一枚,專業是電子科學與技術.....但是老師告訴我,我們學院主要是做光學方面的,搞得我好糾結,不知道該往哪方面走,而且據說現在點已經發展的很成熟沒有什么前景...接下來我是應該學光方面多一點,還是繼續學電..........

2012-06-07 15:29:59

01 問題很多同學一直在糾結:我是學單片機呢還是學嵌入式呢?還有人說單片機也是嵌入式,到底對不對?嵌入式是不是就是linux?今天咱們說說這個問題。02 什么是單片機單片機的本質是...

2021-11-09 06:24:14

的幾個問題,然后我們一起由問題切入進行一些討論。問題1:我是學單片機好還是直接學STM32好???問題2:STM32如何才能快速入門?問題3:為什么是STM32呢?為什么不是ARM9,ARM11呢?下面我將逐個答復首先問題1:我是單片機好還是直接學STM32好呢?答:首先我們談下目的,你學習的最終目的是

2021-12-07 06:48:32

著名嵌入式工程師吳堅鴻曾經發過一貼“學單片機有前途還是嵌入式系統有前途?”原貼如下:http://www.makeru.com.cn/live/3523_1772.html?s=69821我在深圳

2021-07-13 06:22:07

求求求求求,學完51下一步學AVR還是430呢?

2015-06-01 19:37:34

其他院校畢業生,主要集中在制造業領域,比如:汽車行業、電網公司、醫療制造、工控化學、儀器設備加工等制造業廠。學自動化=學得多但是不精?曾經看到一個回答,說的是一流的人員搞AI人工智能,二流的搞嵌入式開發

2020-05-25 16:11:43

學軟件好還是硬件好

2016-06-04 07:47:32

首先我是一個大二電子信息工程專業的本科生,想在arm這方面發展,現在團隊因為項目需要所以要分驅動和Qt組,之前我是照著國嵌的視頻學的,學了裸機和一點點的系統移植,現在不知道選哪個組,希望大家給些建議,謝謝{:3:}

2013-12-07 15:02:38

的設計者,我們必須掌握其最基本的以下四個組成部分:(1)晶體管元件的設計它是指半導體工程學方面的知識,任何設計的IC芯片都將最終回歸于它,一般都是從薛定諤波動方程式開始引出的(比較復雜),但與實際具體

2018-08-22 09:29:21

從使用感受還是品質,都有了長足的進步,而這之中無線技術要算得上是一個革命性的改變。【關鍵詞】:無線耳機,無線技術,長期延續,人體工程學,折疊,電腦,革命性,線材,量調節,感受【DOI】:CNKI

2010-05-13 09:02:34

STM32CubeMX AI嘗嘗鮮X-Cube-AI介紹&&開發前提創建模型創建工程??我是在學習Tensorflow 2.0的時候,當然,最終還是為了跑在嵌入式設備上,因為這次疫情

2021-08-09 08:06:53

步。STM32的局限性不能說STM32不好,只能說有局限性。STM32最大的局限性就是:它只是個單片機。也就是說,你學習STM32,其實學的都是單片機相關的技術。譬如GUI方面,你學STM32可能會學

2020-06-26 14:25:21

步。STM32的局限性不能說STM32不好,只能說有局限性。STM32最大的局限性就是:它只是個單片機。也就是說,你學習STM32,其實學的都是單片機相關的技術。譬如GUI方面,你學STM32可能會學

2021-07-11 10:46:38

我想知道 X-CUBE-AI 和 NanoEdge AI Studio 在 ML 和 AI 開發環境中的區別。我可以在任何一個開發環境中做同樣的事情嗎?使用的設備有什么限制嗎?

2022-12-05 06:03:15

學習,能夠基于人們所給予的特征值而進行分類了。其中,是由人們去觀察而萃取特征的,然后才遞交給AI去分類,這通稱為:人工提取特征。在本任務(No.9)里,將向前邁進一大步:人們做示范,傳授更多智慧,讓

2020-11-05 17:55:48

積累經驗,方案費用不能低,一天的人工至少1000元,而且還是熟人的,打了折之后。不要把我們這行搞砸了。 學單片機可以單干嗎—— 可以。我就是這樣的。搞單片機的有點像作家,有的作家就是一次賣斷產權,有的

2014-03-27 17:17:42

有理論知識體系支撐,與AI企業研發活動協同發展,需要技術架構來引導AI未來生態體系。而他的AI創作是薈聚了其從事軟件代碼40年的專業經驗和在中西方企業工作經驗,以及教育領域的從事經驗,其從一個專業的頂級

2019-04-18 15:51:32

創造新模版,也支持不熟悉編程者,善用模版來創造形形色色的 AI 模型。所以,不一定需要寫程序,不一定需要高深數學,大家都可以利用模板來創作 AI 智能模型。那么如何使用 AI 模板?AI 模板的使用可以分為三個層級。如下圖所示: `

2020-11-02 10:38:57

-卡耐基梅隆大學聯合工程學院博士,研究方向為面向人工智能的集成電路與系統設計。為人工智能芯片領域重要科學家,在AI硬件技術領域作為第一作者發表了4篇頂級SCI學術論文(其中2篇trans期刊,分別為電路

2019-11-07 14:18:45

書本上的每一個知識點學透。卓越班在實驗實踐能力方面對學生要求高,學生們遇到問題,先主動嘗試解決問題,多思考為什么,在實踐過程中持續深入學習理解理論知識,做到融會貫通。見面會在熱烈的氣氛中圓滿結束,本次

2022-12-08 10:16:24

、工具鏈等幫助我們縮短了芯片的校驗時間。另一個很關鍵的因素就是我們有經驗豐富的工程師,我們的工程師對RISC-V更深的理解以及知道設計芯片的關鍵對縮短芯片研發的時間也非常關鍵。”到底是架構更重要還是

2020-08-02 11:59:27

` 先學單片機還是plc 簡單點說,兩者的原理都是一樣的,所以無論你先學哪樣,學好一樣后再學另一樣就比較容易, 因為PLC已經把I/O電路,存儲器,等都集成在內部,學的時候硬件方面不需要下太大

2020-06-28 09:46:36

本人學過51,現在糾結于學avr還是stm32,學哥說學avr才能更好的學stm32。可是我感覺avr也是8位的,還不如學stm32.望,大俠給建議,小弟誠心求助

2012-09-13 21:37:10

01話 題經常有大學生同學糾結:我到底是學STM32還是學嵌入式linux。這個問題很多人都會有自己的看法,今天我試著從多個角度,把我了解到的事實講一下,希望對大家有所啟發。STM3202STM32

2022-02-07 07:06:50

單片機新手學STM32還是學51?先說我的答案第一點第二點第三點先說我的答案如果你之前只是接觸計算機方面的東西,對單片機的內部結構,以及供電,外設,傳感器,相關控制硬件,驅動硬件,保護電路等還沒

2021-07-14 06:36:13

南京工程學院,電子CAD課程設計,dxp2004

2014-12-26 20:26:54

本帖最后由 eehome 于 2013-1-5 09:52 編輯

請學arm的大神解答,學arm先學單片機好,還是直接學arm好,哪種方式更好?!!先學單片機的話要學到哪種程度?

2012-11-15 19:15:45

嗨社區,在選擇 MCU 或電路板時,我們可以使用MCU/MPU Selector代替Board Selector來選擇嗎?因為我使用的是STM32F769AI,它沒有任何板包來創建觸摸 GFX 項目。那么,如何使用STM32CubeIDE創建一個Touch GFX工程呢?哪個不在板選擇器下?

2022-12-12 06:31:27

時,就需要用FPGA來快速的定義一個能用的芯片。前面說了,FPGA里面無法就是一些“真值表”、觸發器、各種連線以及一些硬件資源,電子系統工程師使用FPGA進行設計時無非就是考慮如何將這些以后資源組合

2018-08-23 09:17:41

我對DSP剛入手,學習6000系列的,想求教一下一個DSP嵌入式工程師所必須具備的基礎,比如說,因為我要學習6000系列,所以算法處理必須要具備,我目前已經學了的僅僅局限于算法,但是其他的一些方面

2014-07-27 23:14:19

使用單片機它是可以做什么?如果想學習單片機,需要哪些條件?學習單片機中該學匯編還是學C語言?

2021-10-14 08:41:50

嵌入式LINUX應該學什么?做驅動還是做應用不少人問我,到底是學驅動還是學應用?我只能說憑興趣,并且驅動和應用并不是截然分開的1. 我們說的驅動,其實并不局限于硬件的操作,還有操作系統的原理、進程

2021-11-05 07:35:53

不少人問我,到底是學驅動還是學應用? 我只能說憑興趣,并且驅動和應用并不是截然分開的1. 我們說的驅動,其實并不局限于硬件的操作,還有操作系統的原理、進程的休眠喚醒調度等概念。 想寫出一個好

2017-04-03 11:31:06

入式LINUX應該學什么?做驅動還是做應用不少人問我,到底是學驅動還是學應用? 我只能說憑興趣,并且驅動和應用并不是截然分開的 1. 我們說的驅動,其實并不局限于硬件的操作,還有操作系統的原理、進程

2014-08-07 00:04:32

嵌入式新手該先學C語言還是先學匯編?這是一個非常有爭議的問題。而目前C語言已漸漸深入了,有意向學習嵌入式的不少,但是疑問是,學嵌入式能不能只用C 寫程序?觀點1:匯編,只是一個語言工具。你要學習

2021-11-09 06:31:21

` 誰來闡述一下成為SMT工程師需要學什么?`

2020-02-28 16:55:36

如題。本人目前大學畢業也有1年了,學的微電子專業。但是算是一個混日子party吧,很多專業知識都學的不好,沒有系統化。目前完全算的上是一個技術門外漢。現在想走FPGA開發方向,也有自己好好復習以前

2013-09-06 15:03:08

大家好,我想考個通訊工程的本科證書。想向大家請教一下該怎么學,從哪學?

2012-03-29 16:40:25

` 人體工程學設計以用戶作為產品設計出發點,要求產品的外形、色彩、性能等都要圍繞用戶的生理、心理特點來設計,使產品和環境的設計盡量適合人體的自然形態,是手持機設計的重點。 人體工程學在手

2016-01-26 17:29:06

工程學導論工程、技術與工程師工程與技術工程依賴技術的發展,技術是實現工程的手段。技術比工程更依賴科學的發展。也可以認為技術是建立在科學與工程間的橋梁,這也是人們總是將科學與技術統稱為“科技”的原因

2021-07-12 06:33:54

AI的采用。使用AI技術還是創建智能企業?就算AI還不具備這種能力,企業也必須預先向好一個問題:他們是只想部分使用AI技術,還是最終創建一個全智能企業?目前圍繞機器人工序自動化(RPA)以及它們是否

2019-05-06 16:46:05

有幾個問題1)電路是自己設計,還是按照下載的資料上畫,還是參考資料上的畫可以改動。2)輸入電壓時多少,有誰提供,是電池還是穩壓模塊3)輸出電壓要求是穩到多少4)整體的意思就是設計一個充電器嗎?

2012-06-01 09:02:47

新人想學FPGA,學ALTERA還是Xilinx,請大俠指點啊

2013-06-27 13:13:45

我是這個月開始學的 STM32,現在還不知道怎么在 keil4 里去配置一個新建的工程,就是怎么配置是下載到 Flash里和RAM面的;我每次新建一個工程,自己配置都下載不了,不知道是怎么回事?求助?{:soso_e154:}{:soso_e154:}{:soso_e154:}

2012-10-30 18:16:03

什么建議分享給職場菜鳥?朱有鵬老師:說幾個重要的吧。 第一必備技能就是編程語言。對于嵌入式工程師來說,C/C++絕對是核心中的核心,是你吃飯的家伙。我的所有課程之中,迄今為止好評最多的還是《C語言高級專題

2019-12-10 15:55:07

機器人學代表了當今集成度高、具有代表性的高技術領域,它綜合了多門學科。其中包括機械工程學、計算機技術、控制工程學、電子學、生物學等多學科的交叉與融合,體現了當今實用科學技術的先進水平。

2020-05-12 08:24:18

我們乘坐的航班剛剛開始下降高度,這時坐在我旁邊的一位先生轉過頭來和我聊起工程學——他看到我在閱讀一本工程學期刊。這位鄰座的先生說,他是電氣與電子工程師協會 (IEEE) 會員,而他原來的志向就是

2019-08-12 07:59:39

本文從測試系統的工程學實際出發,完成了對中頻電源系統的電壓、電流、頻率、功率因數、有功功率等參數的測量和實時監控,較好的實現了中頻電源測試系統的功能和工程要求。

2021-04-14 06:33:51

sql功能雖然強大,但是還是有很多的要求無法達到例如:突破sql局限的方案:1、利用高級語言的表達能力:嵌入式sql2、擴展sql語言3、ODBC編程:把數據庫當作是數據源嵌入式sql:為了區分

2021-12-22 06:13:04

,真·中年養生·boy小智轉身對朵妹說:“傻死了,這些人畫的傻死了…”,話剛說一半就看見朵妹在手機上按照提示畫著花瓶。——“這不就是你畫我猜嗎?”——“才不是,這個比那個好玩多了,這里面有AI。”觀望

2018-07-23 09:11:45

使用的產品的認知印象和回應。由此物聯網手持機人體工程學設計原則有:1、手持機能有效地實現預定的功能,每一個結構或設計點都是必須的。2、手持機與用戶身體成適當比例,使用戶能發揮最大效率。3、按照用戶的力度

2016-03-07 17:43:30

新手,我想請教一下最基礎的問題,對于一些差分測量,例如電壓測量,將正極接在AI0,負極接在AI8,請問我用daq助手進行輸入通道選擇的時候,是選擇AI0,還是AI8,或者兩個都選,

2014-05-20 10:33:20

作為一個電子工程師,你要回會的軟件,你要看的資料,你要了解的知識都是非常非常多的,所以說你是萬能的...你要從51開始學起;你要從流水燈入門;你要會DXP電路設計軟件;你要長我KEIL調試;你要會用

2012-10-03 23:50:49

的時間能學90%,但是后面的10%可能需要你花一輩子的時間去學,所以,從這個角度來講,你必須要跟你水平低的人進行一個交流。你跟他交流,他總有一點東西是你沒有想到的。這個就是團隊的力量。在這個團隊中,你

2015-06-24 16:51:14

`之前一直使用的都是比較傳統的車子自帶的后視鏡,后來看見同事的坐騎換了一個凱迪拉克后視鏡才真的關注到流媒體后視鏡。隨著時代的變化,當下最被頻繁提及的就是人工智能(AI)。原來現在行車記錄儀也實現了云

2018-08-03 16:41:59

_scan vi 的輸入channel選擇的是ai0:6,輸出信號竟然是一個28行的數組,也就是一個ai通道同時能輸出4行數據,讓我實在捉摸不透。我的猜測:這些daq自帶的vi調用的.dll文件 是不是被修改過了?希望各位大牛能指點我一二!

2015-08-12 11:47:53

FP_AI_VISION1工程是否可以適用于stm32f746discovery開發板?使用STM32CUBEIDE打開FP_AI_VISION1工程為什么沒有stm32可運行文件,不能編譯?

2023-08-07 08:37:02

迷茫啊,學嵌入式還是學EDA呢?請高手指教一二

2012-09-23 13:14:11

•0.1瓦軟關機模式人體工程學設計•70毫米高度調節,坐姿更理想•傾角和轉角調整功能讓您可獲得理想的視角出眾的顯示性能•

2011-03-12 02:23:29

`這是一本非常基礎的 AI 入門書籍。AI 的<教>與<學>會比傳統IT(信息)有趣的地方是,當今 AI 的基礎是:機器學習

2020-11-06 17:25:10

煥堂老師:數十年來,一直從事工程師的工作。后來想往設計師方向發展,就取去學習設計思維(Design Thinking),這是一個很大的挑戰。然而,卻發現了這是邁向商業創新的很棒途徑,創新的過程就是利用工程

2019-11-26 13:52:25

人體工程學商用超大顯示屏,提升工作效率憑借SmartImage、前置立體聲音響、USB端口和人體工程學底座等功能,高效節能的240B1商務顯示屏必將提升您的工作效率。

2010-07-01 21:25:43 15

15 95華梵大學機電工程學系專題研究成果報告

2010-07-17 17:41:40 20

20 人體工程學鍵盤 人體工程學又叫人類工學或人類工程學,是第二次世界大戰后發展起來的一門新學科

2009-12-28 11:19:43 814

814 人體工程學鼠標

&nbs

2009-12-28 11:43:03 725

725 便攜式電源的工程學解決方案

便攜式超聲設備市場就是一個很好的例子。至今,超聲波圖像檢查還是需要到診所才可以完成。在大多數發達國家,

2010-05-25 08:52:29 675

675

交通信息顯示屏是樞紐信息發布的一個重要設備,應用較為廣泛。論文將人因工程學理念應用到信息顯示屏的外形和內容設計中,在外形設計上對交通信息顯示屏的靜態標識字體、屏幕

2011-04-17 15:54:33 37

37 目錄 上海交通大學機械與動力工程學院概況 . 1 上海交通大學機械與動力工程學院科研概況 . 7 Research Overview of School of Mechanical Engineering, Shanghai Jiao Tong University .. 8 學院科研代表性項目

2011-04-28 09:55:21 0

0 “搬磚”的附屬物件相信是大部分小伙伴生活中不可或缺的一部分。簡單粗暴的,兩部分合在一起就是今天的主角,我自認為最襯的上“型”的微軟Surface人體工程學鍵盤。

2019-02-28 09:49:06 5986

5986 近日,ThinkPad 推出了新款的人體工程學鼠標,采用了側握設計,售價139元。

2019-12-30 14:52:28 4781

4781 在公開信中雷軍表示:5G技術在未來不只是局限于手機網絡上面。物聯網和AI技術也不會局限于自己本身的領域。未來的發展方向,5G和物聯網+AI將會形成一個全場景的服務,脫離其中任何一個,另外兩個發展都會受到阻礙。

2020-01-03 11:29:57 2475

2475 要利用工程學工藝制作高級時裝,就需要專業的增材制造人士組成專家團隊,因此Protolabs與GE Additive(GE 增材)建立了合作關系。

2020-05-22 17:57:13 2242

2242 人機工程學是按照人的特性來設計和優化人、機、環境系統的科學。其主要目的是使人能安全、健康、舒適和有效地進行工作。其中,系統的安全可靠,尤其是人的安全與健康,應列為首位考慮的問題。

2020-12-25 04:26:13 1724

1724 數據驅動的建模:在水資源和環境工程學中使用MATLAB說明。

2021-05-27 09:53:42 0

0 2021中國汽車工程學會年會暨展覽會將于2021年10月19日-21日在上海汽車會展中心盛大召開,虹科在D14-15展位誠邀您前來觀展。 中國汽車工程學會年會暨展覽會(SAECCE)由中國汽車工程學

2021-10-13 09:25:37 1202

1202 2021中國汽車工程學會年會暨展覽會于2021年10月19日-21日在上海汽車會展中心盛大召。 中國汽車工程學會年會暨展覽會(SAECCE)由中國汽車工程學會(China SAE)主辦,迄今為止已成

2021-10-22 10:46:13 3496

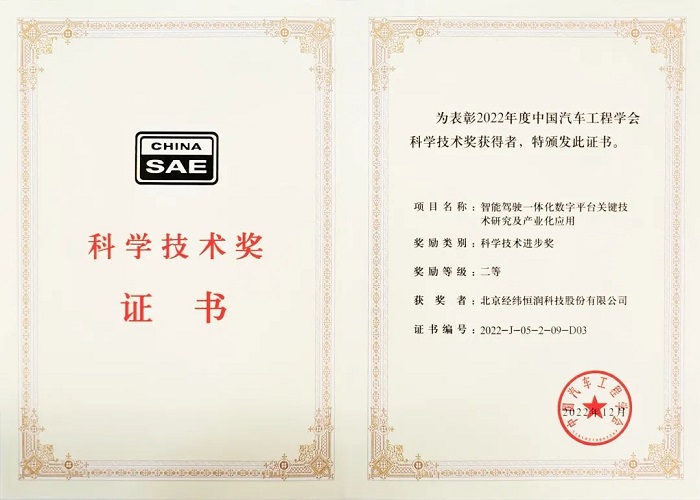

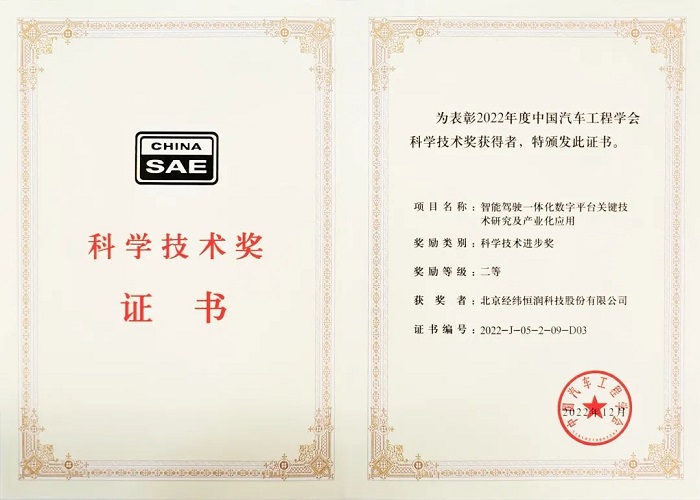

3496 日前,中國汽車工程學會公布了《關于2022年度中國汽車工程學會科學技術獎的獎勵決定》。經緯恒潤參與完成的《乘用車電子電氣架構開發與應用》項目,榮獲中國汽車工程學會科學技術進步獎二等獎。中國汽車工程學

2023-07-31 22:04:17 853

853

日前,中國汽車工程學會公布了“關于2022年度中國汽車工程學會科學技術獎的獎勵決定”。經緯恒潤參與完成的《智能駕駛一體化數字平臺關鍵技術研究及產業化應用》項目,榮獲中國汽車工程學會科學技術進步獎二等獎。

2023-08-18 10:34:06 1185

1185

本文轉自:中國汽車工程學會學術交流 六十載櫛風沐雨風雪載途,甲子間踔厲奮發篤行不怠。在中國汽車工程學會喜迎60華誕之際, 中國汽車工程學會年會暨展覽會(SAECCE 2023) 于 10月25

2023-10-26 09:15:02 301

301

電子發燒友App

電子發燒友App

評論