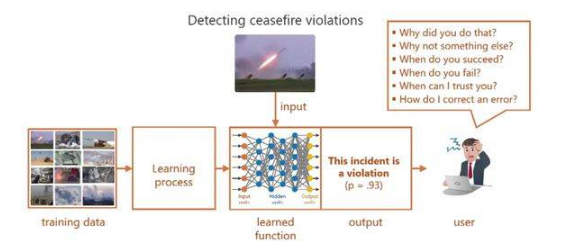

XAI 主要解決以下問題:對于使用者而言某些機器學習模型如同黑盒一般,給它一個輸入,決策出一個結果。比如大部分深度學習的模型,沒人能確切知道它決策的依據以及決策是否可靠。如圖 1 的 output 所示,為一般網絡給出的決策,缺乏可解釋性的結果讓使用者感到困惑,嚴重限制了其在現實任務中的廣泛應用。

圖 1 如今的深度學習 [1]

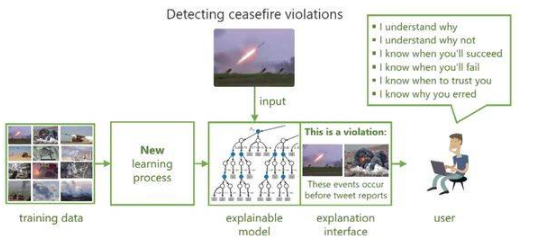

所以為了提高機器學習模型的可解釋性和透明性,使用戶和決策模型之間建立信任關系,近年來學術界進行了廣泛和深入的研究并提出了可解釋的機器學習模型。如圖 2,模型在決策的同時給出相應的解釋,以獲得用戶的信任和理解。

圖 2 可解釋的機器學習 [1]

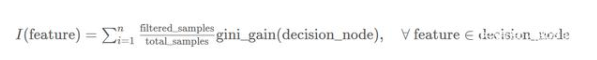

對于機器學習模型來說,我們常常會提到2個概念:模型準確性(accuracy)和模型復雜度(complexity)。模型的復雜度與準確性相關,又與模型的可解釋性相對立。因此我們希望找到一種模型如圖 3 所示,具有可解釋性的同時盡可能保證模型的準確性和復雜度。

編輯:hfy

-

機器學習

+關注

關注

66文章

8503瀏覽量

134613 -

深度學習

+關注

關注

73文章

5561瀏覽量

122794

發布評論請先 登錄

機器學習模型可解釋性的結果分析

什么是“可解釋的”? 可解釋性AI不能解釋什么

機器學習模型的“可解釋性”的概念及其重要意義

Explainable AI旨在提高機器學習模型的可解釋性

機器學習模型可解釋性的介紹

人工智能可解釋性規制面臨的問題分析

小白學解釋性AI:從機器學習到大模型

淺談機器學習模型的可解釋性和透明性

淺談機器學習模型的可解釋性和透明性

評論