首發:AIWalker

標題&作者團隊

paper: http://www.cad.zju.edu.cn/hom...

該文是浙江大學&微軟提出的一種實時視頻增強方案(ACM Multimedia 2020),它不僅可以達到SOTA的視頻增強效果,同時對于1080P的視頻可以達到驚人的77fps@Tesla P40GPU或者45fps@CPU端。

Abstract

實時視頻增強具有巨大的潛在應用場景,但是現有的方案遠遠不足以滿足視頻增強的實時性與穩定性需求。

該文提出一種新穎的AI視頻增強方法,它能夠單CPU以45fps處理1080P視頻,極具產品化應用價值。所提方法基于輕量型MobileNetV2設計,并在此基礎上引入了時序特征集(Temporal Feature Aggregation, TFA)成模塊以確保視頻的時序一致性。不同于已有多數圖像增強方法采用encoder-decoder架構生成通分辨率的輸出,該文所提方法消除了decoder模塊,而僅僅采用了encoder部分與一個小的head模塊。所提方法直接預測顏色映射函數,而非像素值,這就使得所提方法可以更好的處理任意分辨率的視頻。除此之外,該文還引入了TFA以確保生成視頻的時序一致性。

最后,作者通過實驗證實:所提方法可以適用于不同類型的增強任務,比如relighting, retouching 以及dehazing等。相比已有方法(比如HDRNet、UPE),所提方法不僅可以取得SOTA性能,同時處理速度快10倍(HD視頻哦)。

image-20201121193610283

該文的主要貢獻包含以下三點:

- 提出一種新穎的實時圖像/視頻增強方法,所提方法比現有實時方法(HDRNet,UPE)快10倍(處理的對象是1080P視頻哦);

- 提出一種廣義的圖像增強表達方式,它可以有效的集成全局上下文信息與局部信息進行像素映射。實驗證實:所提方法可以處理欠曝光、過曝光、retouching、dehazing等場景圖像;

- 提出一種TFA用于確保視頻的時序一致性,甚至可以進一步改善訓練的穩定性。

Method

該文提出了一種end-to-end輕量CNN用于實時視頻增強,接下來,我們將從問題定義、視頻增強網絡、損失函數三個方面展開本文所提方法的介紹。

Problem Formulation

現有稠密像素預測任務大多采用encoder-decoder方案,而decoder部分的高計算量問題是難以忽視的。估計顏色映射函數是一種極具吸引力的方向,然而它有這樣兩個挑戰:(1) 單一映射函數難以反映復雜的局部圖像處理計算問題;(2) 現有的顏色映射函數往往基于用戶評價或參考圖像,而無參考自動校正則會“模棱兩可”。

受啟發于“Bilateral Guided Upsampling”與“Fast Guided Filter”(兩種非常經典的傳統圖像處理方法),該文構建了一種網格狀態的映射函數,它不僅可以獲得局部區域的更細粒度的細節,同時可以更好的切合encoder部分的CNN結構。輸入圖像I經過CNN處理后,可以得到一個大小為的特征。網格中每個特征點信息與網格中的映射函數參數相關,并用于預測映射函數,并反過來作用于局部區域。下圖給出了該過程的示意圖,也就是說圖像將被進行分塊處理,每個塊采用不同的映射函數。

image-20201121195843151

映射函數在這里定義為分片線性函數,定義如下:

其中,L表示映射函數的分片數量,表示每個線性函數的斜率。因此,網絡的目標在于預測映射函數的系數。

看到這里,也許會有不少同學不知道這里的系數與映射函數該怎么去應用。其實這個地方沒想象的那么復雜。先來個最簡單的情形:,即恒等映射,也就是圖像不做任何操作,此時有。如果我們希望調整圖像的亮區呢,其實就需要將亮區對應的斜率調大,而其他區域對應的斜率調小;類似的,如果我們希望調整圖像的暗區,就需要調整其對應的斜率。也就是說,通過每一段線性函數的斜率,它可以輕松的構建不同形狀的映射函數,而這個映射函數則對應于傳統圖像處理中的累積直方圖。

對此該興趣的同學,非常建議去了解一下直方圖均衡相關的一些基礎知識,可以參考剛薩雷斯的《圖像處理》第三章的直方圖均衡。其實這個地方的映射函數理解還可以參考PhotoShop中的直方圖類增強方案,通過調節直方圖的形狀達到不同的編輯目的,Photoshop中的直方圖調整方法其實與這里的調整機制是相通的。

Video Enhancement Network

image-20201121195529411

上圖給出了該文所提出的視頻增強網絡架構示意圖,它包含一個輕量型基礎網路與一個時序特征集成模塊。

Baseline Image Network 上圖的下半部分給出了基礎網絡部分,注:下角標t表示視頻的時序標簽。輸入圖像I首先下采樣到低分辨率,然后送入到基礎網絡中回歸映射系數集。這里的基礎網絡是在MobileNetV2的基礎上改進而來,它用于將圖像映射到高維空間并得到隱狀態特征。在上述網絡的后端接一個head,它包含三個卷積用于將隱狀態特征變換為顏色映射系數。最終輸出的形狀為。最后,目標圖像則是由輸入圖像經由映射函數變換得到。

Temporal feature aggregation 視頻增強網絡是在上述圖像增強網絡的基礎上插入TFA得到,TFA用于促使時序一致性。為緩解閃爍偽影問題,作者認為:靜態區域應當有相鄰兩幀賦予相似的注意力,運動區域則主要由當前幀決定,而區域的運動/靜態特性則由相鄰幀的相關性決定。基于該假設,作者設計了如下的特征集成方式:

其中,分別表示融合特征,前一幀的影響因子,以及像素級特征相似性。特征的相似性計算方式則是采用的cosine相似性(上圖也給出了相鄰幀的相似性圖示),公式如下:

$$M/_g = cos/= //frac{f/_{t-1} //cdot f/_t}{//|f/_{t-1} //| //cdot //|f/_t //|} $$

Loss Function

給定預測的映射系數與高分辨率圖像,我們可以通過相應的變換得到目標圖像(假設表示GT)。為更好的訓練上述模型,作者提出了一個同時考慮圖像距離關系和映射函數約束的損失函數,定義如下:

損失函數的四部分分別對應重建損失(損失)、感知損失、平滑損失以及時序一致性損失。更具體的函數定義建議查看原文,這里不再贅述。

Experiments

在實現方面,輸入圖像首先被下采樣到大小,映射函數的分片數,對應的輸出通道數為48。正如前述,骨干網絡包含5個階段,前四個階段與MobileNetV2相同,最后一個階段包含三個卷積,其參數為:。head部分由三個卷積構成,其輸出通道數分別為。最終的輸出經tanh激活,其對應了映射系數的對數值。假設表示每個通道的輸出,那么映射函數可以表示為 其中用于控制映射函數的范圍。基于上述表達,曲線的范圍將被限制在.

在超參方面,。作者選用Adam+L2正則進行訓練,batch=32,學習率為0.005,經40k迭代后衰減到0.001.

我們先來看一下所提方法在圖像增強方面的效果,見下圖&下表。從中可以看到:(1) 相比HDRNet,所提方法具有更快的推理速度,更高的PSNR、SSIM等指標;(2) 相比HDRNet、UPE等方法,所提方法生成結果具有更好的對比度和顏色分布。

接下來,我們再來看一下所提方法在視頻增強方面的效果,見下圖&下表。可以看到:所提方法具有更高的PSNR指標;更快的推理速度;更好的時序一致性。

image-20201122132832313

image-20201122132857742

最后,我們再來看一下所提方法在去霧任務上的表現,見下圖。從中可以看到:所提方法在圖像去霧任務上同樣取得了SOTA指標與視覺效果。

image-20201122133254136

Conclusion

該文從AI+直方圖的角度提出了一種實時圖像/視頻增強方法,它采用encoder網絡預測映射函數系數,然后將得到的映射函數作用于輸入圖像得到期望的輸出圖像。這種處理方式將輸入分辨率與方法進行了解耦,進而使得Image-to-Image類方法的的產品化應用提供了一個非常有參考價值的方向。盡管所提方法在圖像/視頻增強方面取得了非常好的效果和推理速度,但該方法對于低光/帶噪圖像的效果并不太好,甚至會進一步造成噪聲放大,當然,這也是直方圖增強類方案的缺陷所在。

image-20201122134143102

推薦閱讀

本文章著作權歸作者所有,任何形式的轉載都請注明出處。更多動態濾波,圖像質量,超分辨相關請關注我的專欄深度學習從入門到精通。

審核編輯:符乾江

-

視頻

+關注

關注

6文章

1971瀏覽量

73803 -

AI

+關注

關注

88文章

34765瀏覽量

276923 -

深度學習

+關注

關注

73文章

5557瀏覽量

122645

發布評論請先 登錄

新思科技攜手微軟借助AI技術加速芯片設計

Arm攜手微軟共筑云計算和PC未來

2025 RT-Thread全球技術大會議程正式發布!

【直播預告】《實時操作系統應用技術—基于RT-Thread與ARM的編程實踐》教學脈絡及資源簡介

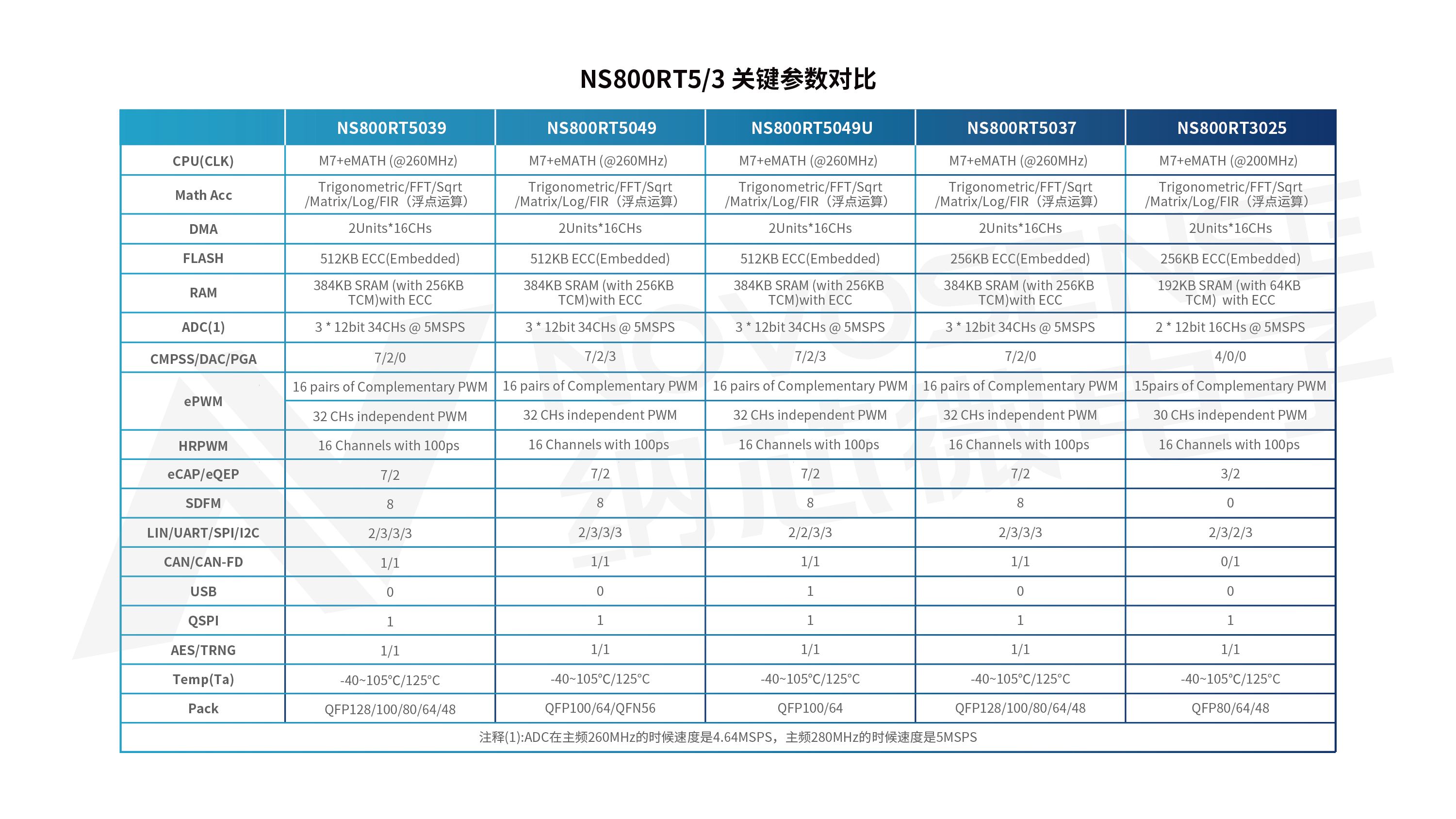

納芯微NS800RT系列MCU:實時控制領域的全新標桿

微軟攜手長虹佳華開啟AI視頻廣告行業新篇章

納芯微聯合芯弦推出NS800RT系列實時控制MCU

MCU新玩家:納芯微推出NS800RT系列實時控制MCU

納芯微攜手芯弦發布NS800RT系列實時控制MCU

國產實時操作系統:和RT-Linux,Zephyr的實時性對比

浙大與海康威視合作再添新成果

RT-Thread攜手進迭時空:共建RISC-V實時計算生態

微軟正全力研發Windows增強現實(AR)眼鏡

工業實時操作系統對比:鴻道Intewell跟rt-linux有啥區別

浙大攜手微軟聯合提出實時視頻增強|RT-VENet

浙大攜手微軟聯合提出實時視頻增強|RT-VENet

評論