大家在很多地方都可以看到嵌入式AI的概念,但是到實(shí)際的上手和開發(fā)過程中,不完善的工具鏈和復(fù)雜的開發(fā)流程都是嵌入式工程師或者AI算法工程師很大的阻礙。

而基于STM32H7的OpenMV機(jī)器視覺模組和云端AI平臺(tái)Edge Impulse合作,就很好的打通了從數(shù)據(jù)收集、打標(biāo),NN模型訓(xùn)練、優(yōu)化到部署的整個(gè)流程。

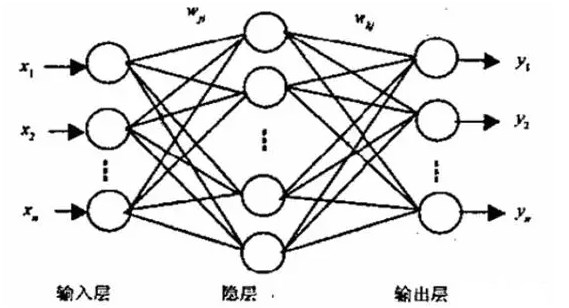

去年4月份我們的新品OpenMV4 H7 Plus上市啦,今天我來給大家介紹一下OpenMV4 H7 Plus的新功能——利用EdgeImpulse在線網(wǎng)站自行訓(xùn)練神經(jīng)網(wǎng)絡(luò)進(jìn)行分類識(shí)別。

在本教程中,你將使用機(jī)器學(xué)習(xí)來構(gòu)建一個(gè)識(shí)別系統(tǒng),該系統(tǒng)可通過OpenMV4 H7 Plus智能攝像頭識(shí)別人臉是否佩戴口罩,即實(shí)現(xiàn)影像分類。

EdgeImpulse是一個(gè)為嵌入式設(shè)備提供在線訓(xùn)練神經(jīng)網(wǎng)絡(luò)模型服務(wù)的網(wǎng)站,它是我們OpenMV的合作伙伴,同時(shí)也均為ST意法半導(dǎo)體的官方合作伙伴。目前EdgeImpulse對(duì)我們OpenMV用戶是免費(fèi)開放的,OpenMV用戶可以免費(fèi)的使用EdgeImpulse在線訓(xùn)練適用于OpenMV的神經(jīng)網(wǎng)絡(luò)模型。

為嵌入式設(shè)備OpenMV增加神經(jīng)網(wǎng)絡(luò),可實(shí)現(xiàn)區(qū)分盜獵者和大象、對(duì)工廠生產(chǎn)線進(jìn)行質(zhì)量控制、讓遙控模型車自行駕駛等功能。

在本教程中,你將學(xué)習(xí)如何收集圖像建立一個(gè)高質(zhì)量的數(shù)據(jù)集,如何應(yīng)用遷移學(xué)習(xí)訓(xùn)練神經(jīng)網(wǎng)絡(luò),以及如何將系統(tǒng)部署到OpenMV。

你可以在以下地址查看整個(gè)項(xiàng)目內(nèi)容,所有代碼和模型都包括在內(nèi):https://book.openmv.cc/project/mask.html

使用EdgeImpulse在線訓(xùn)練適用于OpenMV的神經(jīng)網(wǎng)絡(luò)模型主要分為以下四個(gè)步驟:數(shù)據(jù)集采集、上傳、訓(xùn)練以及部署。

01 采集數(shù)據(jù)集

在本教程中,我們會(huì)構(gòu)建一個(gè)可以區(qū)分人臉是否佩戴口罩的模型。當(dāng)然你也可以選擇分類其他物品。為實(shí)現(xiàn)機(jī)器學(xué)習(xí)模型的運(yùn)作,你需要收集戴口罩和不帶口罩兩種人臉的大量示例圖像。在訓(xùn)練時(shí),這些示例圖像就用來做模型的區(qū)分練習(xí)。

我們需要利用OpenMV IDE來采集我們的數(shù)據(jù)集,采集圖像的步驟如下:

* 創(chuàng)建兩個(gè)分類:

打開OpenMV IDE菜單欄的“工具”,選擇“數(shù)據(jù)集編輯器”,單擊“新建數(shù)據(jù)集”,然后新建一個(gè)文件夾并打開,在數(shù)據(jù)集里面再新建兩個(gè)文件夾分別命名為mask(用來保存戴口罩的人臉的照片)和face(用來保存不戴口罩的人臉的照片)。

新建數(shù)據(jù)集

創(chuàng)建分類文件夾

* 用OpenMV采集圖像

首先我們連接OpenMV,點(diǎn)擊IDE里面的“連接”,點(diǎn)擊“運(yùn)行”,F(xiàn)ramebuffer幀緩沖區(qū)中可以看到OpenMV實(shí)時(shí)的圖像,點(diǎn)擊左側(cè)菜單欄中的照片的按鈕,OpenMV就會(huì)自動(dòng)的保存這張圖片,這就是數(shù)據(jù)集里面的一個(gè)數(shù)據(jù)。

首先我們要保存的是戴了口罩的人臉,點(diǎn)一下照片的按鈕,IDE下側(cè)就會(huì)拍攝一張照片,它會(huì)自動(dòng)命名為00000,然后下一張是00001,以此類推。

用OpenMV分別采集200張戴口罩(男女各100張)和200張不戴口罩(男女各占100張)的人臉的照片。

用OopenMV采集男生戴口罩的圖像

用OopenMV采集女生戴口罩的圖像

* 注意:要確保采集到各種角度的照片,保證我們訓(xùn)練學(xué)習(xí)的多樣化。

* 如果采集的過程中發(fā)現(xiàn)某張圖片采集得不夠完美的話,可以右鍵此圖片點(diǎn)擊刪除。

02 上傳

使用OpenMV采集完圖像以后,你需要注冊(cè)賬號(hào)登錄EdgeImpulse官網(wǎng)(https://edgeimpulse.com/)開始上傳圖像,上傳圖像的步驟:

* 在EdgeImpulse上新建一個(gè)項(xiàng)目,點(diǎn)擊“keys”,選擇“API Key”并復(fù)制“API Key”。通過API Key實(shí)現(xiàn)OpenMV IDE和Edge Impulse的連通。

* 選擇OpenMV IDE上方菜單欄的“工具”——“數(shù)據(jù)編輯器”——“Export”——“上傳”——“通過API Key上傳”,復(fù)制“API Key”上傳即可。

上傳時(shí)數(shù)據(jù)將自動(dòng)劃分為訓(xùn)練集和測試集,我們默認(rèn)選擇比例為“80%和20%”即可。我們一共采集了400多張人臉圖片,其中80%的Training Date就是默認(rèn)你80%的數(shù)據(jù)用來訓(xùn)練,剩余的20%用作測試集。

用OpenMV上傳數(shù)據(jù)集

將數(shù)據(jù)集上傳到EdgeImpulse上

03 訓(xùn)練數(shù)據(jù)集

數(shù)據(jù)集準(zhǔn)備就緒,你就可以在EdgeImpulse網(wǎng)站界面中訓(xùn)練數(shù)據(jù)集了。

* 配置處理模塊:

首先選擇“Impulse Design”,配置處理模塊:

* 設(shè)置默認(rèn)的圖像長寬為“96 x 96”;

* 選擇“圖像Images”模塊,表示我們是對(duì)圖像進(jìn)行分類訓(xùn)練(你也可以用EdgeImpulse分類聲音、視頻等);

* 選擇“遷移學(xué)習(xí)(圖像)Transfer Learning (Images)”,設(shè)置學(xué)習(xí)的模型;

選擇“保存Save impulse”,顯示Successfully就是配置成功了。

配置處理模塊

* 圖像預(yù)處理:

單擊左側(cè)菜單中的“圖像Image”,將顏色格式設(shè)置為“RGB”,然后點(diǎn)擊“Save”。

* 接下來選擇“生成特征Generate features”來啟動(dòng)流程,將對(duì)400多張數(shù)據(jù)進(jìn)行圖像預(yù)處理,右側(cè)會(huì)顯示完整數(shù)據(jù)集的3D可視化。

特征資源管理器將數(shù)據(jù)集中的數(shù)據(jù)進(jìn)行可視化處理。

在特征資源管理器中分離良好的集群更便于機(jī)器學(xué)習(xí)模型學(xué)習(xí)。

* 配置遷移學(xué)習(xí)模型

單擊左側(cè)菜單中的“遷移學(xué)習(xí)Transfer learning”,設(shè)置的參數(shù)全部選擇默認(rèn)的就可以,也可以根據(jù)需求來更改參數(shù):

1.將訓(xùn)練周期數(shù)Number of training cycles設(shè)置默認(rèn)為10

2.將學(xué)習(xí)率Learning rate設(shè)置為0.0005

3.可以勾選也可以不勾選“數(shù)據(jù)增強(qiáng)Data augmentation”

4.將最低置信度Minimum confidence rating默認(rèn)設(shè)置為0.8。

點(diǎn)擊“開始訓(xùn)練Start training”,訓(xùn)練的過程大概4到5分鐘左右。

模型訓(xùn)練完成后,你可以查看準(zhǔn)確度、混淆矩陣confusion matrix和預(yù)期設(shè)備性能。

訓(xùn)練完成后的表現(xiàn)

* 測試模型:

訓(xùn)練完成后,我們將使用測試數(shù)據(jù)來檢驗(yàn)?zāi)P汀?/p>

選擇“模型測試Model testing”,勾選“樣本名稱Sample name”旁的復(fù)選框,點(diǎn)擊“分類選擇Classify selected”。這里顯示的準(zhǔn)確度達(dá)到了97%,就一個(gè)數(shù)據(jù)甚少的模型而言實(shí)屬難得。

發(fā)現(xiàn)顯示紅色的這一張圖片是不確定的,點(diǎn)擊這張圖片右側(cè)的三個(gè)點(diǎn),選擇“顯示分類 Show classification”,你就會(huì)進(jìn)入“實(shí)時(shí)分類”的界面,里面包含文件的更多細(xì)節(jié)。這個(gè)界面將幫助你確定圖片分類錯(cuò)誤的原因。

一個(gè)無法分類的圖片(因?yàn)槠渥罡邤?shù)值仍低于0.8的閾值)

如果數(shù)據(jù)在所有已知的集群(戴口罩/不戴口罩)之外,這可能是與以前看到的任何分類都不匹配的數(shù)據(jù)——可能是由于頭發(fā)遮住了大半的人臉。

04 在OpenMV上運(yùn)行模型

完成了訓(xùn)練設(shè)計(jì)、模型訓(xùn)練和模型驗(yàn)證的步驟,你就可以將這個(gè)模型導(dǎo)出到你的OpenMV,選擇“OpenMV”,選擇“Build”進(jìn)行生成,它自動(dòng)生成了3個(gè)文件:

* trained.tflite 訓(xùn)練好的神經(jīng)網(wǎng)絡(luò)模型

* labels.txt 兩個(gè)分類標(biāo)簽(face和mask)

* ei_image_classification.py 是OpenMV上面要運(yùn)行的代碼

連接OpenMV IDE,把這3個(gè)文件保存到OpenMV內(nèi)置的Flash里面。將ei_image_classification.py文件在OpenMV IDE中打開,可以看到我們剛剛在EdgeImpulse里面生成的代碼。點(diǎn)擊運(yùn)行,在串行終端里面會(huì)顯示運(yùn)行的結(jié)果。

識(shí)別戴口罩的人臉

識(shí)別不戴口罩的人臉

好啦,你已經(jīng)成功地為OpenMV增加自行訓(xùn)練神經(jīng)網(wǎng)絡(luò)的功能了。

期待你的成果!

責(zé)任編輯:lq

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4810瀏覽量

102985 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25309 -

智能攝像頭

+關(guān)注

關(guān)注

0文章

84瀏覽量

15212

原文標(biāo)題:OpenMV4 Plus使用Edge Impulse自行訓(xùn)練神經(jīng)網(wǎng)絡(luò)進(jìn)行口罩識(shí)別

文章出處:【微信號(hào):STM32_STM8_MCU,微信公眾號(hào):STM32單片機(jī)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

BP神經(jīng)網(wǎng)絡(luò)的優(yōu)缺點(diǎn)分析

脈沖神經(jīng)網(wǎng)絡(luò)怎么訓(xùn)練

怎么對(duì)神經(jīng)網(wǎng)絡(luò)重新訓(xùn)練

BP神經(jīng)網(wǎng)絡(luò)在語言特征信號(hào)分類中的應(yīng)用

BP神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)和訓(xùn)練過程

利用EdgeImpulse在線網(wǎng)站自行訓(xùn)練神經(jīng)網(wǎng)絡(luò)進(jìn)行分類識(shí)別

利用EdgeImpulse在線網(wǎng)站自行訓(xùn)練神經(jīng)網(wǎng)絡(luò)進(jìn)行分類識(shí)別

評(píng)論