命名實體識別是NLP領域中的一項基礎任務,在文本搜索、文本推薦、知識圖譜構建等領域都起著至關重要的作用,一直是熱點研究方向之一。多模態命名實體識別在傳統的命名實體識別基礎上額外引入了圖像,可以為文本補充語義信息來進行消岐,近些年來受到人們廣泛的關注。

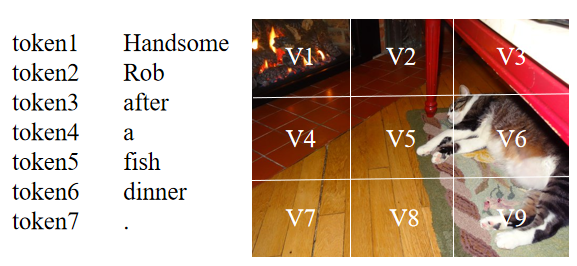

盡管當前的多模態命名實體識別方法取得了成功,但仍然存在著兩個問題:(1)當前大部分方法基于注意力機制來進行文本和圖像間的交互,但由于不同模態的表示來自于不同的編碼器,想要捕捉文本中token和圖像中區域之間的關系是困難的。如下圖所示,句子中的‘Rob’應該和圖像中存在貓的區域(V5,V6,V9等)有著較高的相似度,但由于文本和圖像的表示并不一致,在通過點積等形式計算相似度時,‘Rob’可能會和其它區域有著較高的相似度得分。因此,表示的不一致會導致模態之間難以建立起較好的關系。

(2)當前的方法認為文本與其隨附的圖像是匹配的,并且可以幫助識別文本中的命名實體。然而,并不是所有的文本和圖像都是匹配的,模型考慮這種不匹配的圖像將會做出錯誤的預測。如下圖所示,圖片中沒有任何與命名實體“Siri”相關的信息,如果模型考慮這張不匹配的圖像,便會受圖中“人物”的影響將“Siri”預測為PER(人)。而在只有文本的情況下,預訓練模型(BERT等)通過預訓練任務中學到的知識可以將“Siri”的類型預測為MISC(雜項)。

Text: Ask [Siri MISC] what 0 divided by 0 is and watch her put you in your place.

為了解決上述存在的問題,本文提出了MAF,一種通用匹配對齊框架(General Matching and Alignment Framework),將文本和圖像的表示進行對齊并通過圖文匹配的概率過濾圖像信息 。由于該框架中的模塊是插件式的,其可以很容易地被拓展到其它多模態任務上。

本文研究成果已被WSDM2022接收,文章和代碼鏈接如下:

論文鏈接:https://dl.acm.org/doi/pdf/10.1145/3488560.3498475

代碼:https://github.com/xubodhu/MAF

整體框架

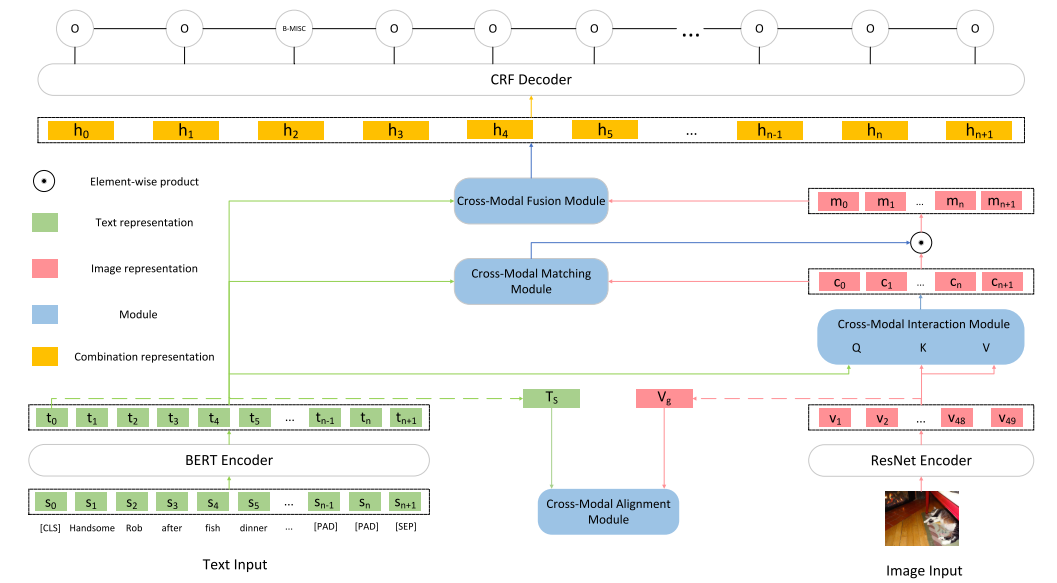

本文框架如下圖所示,由5個主要部分組成:

Input Representations

將原始的文本輸入轉為token序列的表示以及文本整體的表示,將原始的圖像輸入轉為圖像區域的表示以及圖像整體的表示。

Cross-Modal Alignment Module

接收文本整體的表示和圖像整體的表示作為輸入,通過對比學習將文本和圖像的表示變得更為一致。

Cross-Modal Interaction Module

接收token序列的表示以及圖像區域的表示作為輸入,使用注意力機制建立起文本token和圖像區域之間的聯系得到文本增強后的圖像的表示。

Cross-Modal Matching Module

接收文本序列的表示和文本增強后的圖像的表示作為輸入,用于判斷文本和圖像匹配的概率,并用輸出的概率對圖像信息進行過濾。

Cross-Modal Fusion Module

將文本token序列的表示和最終圖像的表示結合在一起輸入到CRF層進行預測。

主要部分

Input Representations

本文使用BERT作為文本編碼器,當文本輸入到BERT后,便可以得到token序列的表示,其中n為token的數量,為[CLS],為[SEP],,本文使用[CLS]的表示作為整個文本的表示。

本文使用ResNet作為圖像編碼器,當圖像輸入到ResNet后,其最后一層卷積層的輸出被作為圖像區域的表示,其中為圖像區域的數量,即將整張圖像均分為49個區域。接著,使用大小為的平均池化層對進行平均池化得到整個圖像的表示。由于后續和需要進行交互,所以將通過一個全連接層將其投影到與相同的維度,其中。

Cross-Modal Alignment Module (CA)

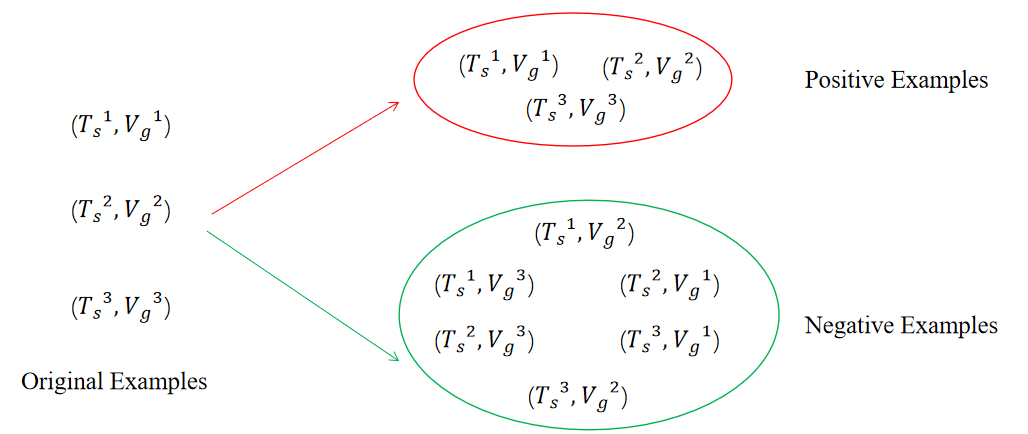

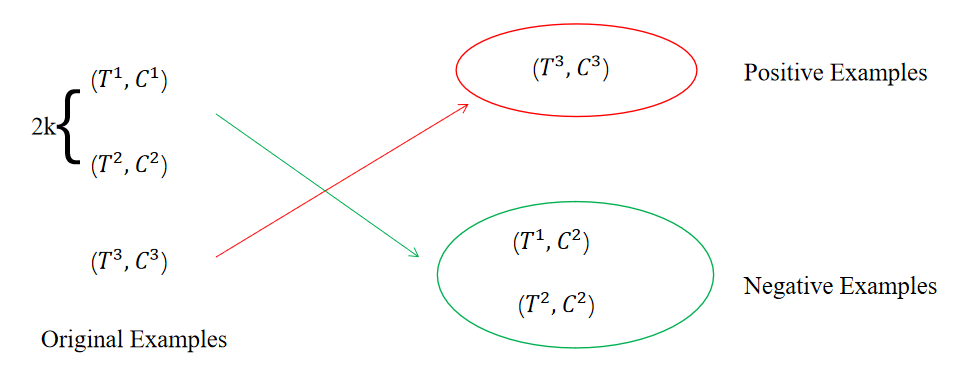

該模塊遵循SimCLR[1]進行對比學習的訓練過程使得文本的表示和圖像的表示更趨于一致,接收以及作為輸入,通過對比學習來調整編碼器的參數。本文在構造正負樣例階段中認為原始的文本-圖像對為正樣例,除此之外的文本-圖像對均為負樣例,因此在大小為N的batch中,只有N個原始的文本-圖像對為正樣例,對于batch中的每個文本來說,除了其原始的image外,其余任意image與其都構成負樣例,對于batch中的每個圖像來說也是如此。如下圖所示,當N為3時,可以得到3個正樣例以及個負樣例。

接著,本文使用兩個不同的MLP作為投影層分別對和進行投影得到以及。然后,通過最小化對比學習損失來最大化正樣例之間的相似度并且最小化負樣例之間的相似度來使得文本的表示和圖像的表示更加一致,image-to-text對比學習損失如下所示:

其中為余弦相似度,為溫度參數。text-to-image對比學習損失如下所示:

我們將上述兩個對比學習損失函數合并,得到最終的對比學習損失函數:

其中為超參數。

補充:

Q:在“背景”部分提到的第(2)個問題是圖文可能是不匹配的,為什么在CA中還是認為來自同一文本-圖像對的數據為正樣例?

A:在EBR[2]中,作者通過類似于對比學習的方式來訓練一個向量召回模型(通過搜索文本來召回淘寶商品),并且認為點擊和購買的商品為正樣例,但這種點擊和購買的信號除了和搜索內容有關之外還受到商品價格、銷量、是否包郵等因素影響,類似于本文中將原始的文本-圖像對看作正例,都是存在噪聲的。由于本身可以調節分布的特性,EBR作者通過增加的大小來減少數據噪聲的影響,并且通過實驗證明將增大到一定數值(設置為3時達到最好)可以提高模型的表現。本文最終的也是一個相對較大的數字為0.1。而在其它數據噪聲相對較少的對比學習的工作中,如SimCSE[3],被設置為0.05,MoCo[4]中的被設置為0.07。

總的來說,CA中會存在一定數量的噪聲數據,但可以通過提高的方式來顯著地降低其帶來的影響。

Cross-Modal Interaction Module (CI)

該模塊通過注意力機制建立起文本和圖像之間的關系,使用文本token序列表示作為Query,使用圖像的區域表示作為Key和Value,最終得到文本增強后的圖像表示。

Cross-Modal Matching Module (CM)

該模塊用于判斷圖文匹配的概率,并用概率調整圖像應保留的信息。該模塊接受和作為輸入,輸出為和匹配的概率。由于缺少用于標記圖文是否匹配的監督數據,本文使用一種自監督的學習方式來訓練該模塊。

首先,本文在大小為N的batch中構造正負樣例,其中原始的文本-圖像對為正樣例,其余的為負樣例。本文通過隨機交換batch中前2k個樣例的來構造負樣例,如下圖所示,在大小為3的batch中,交換前2*1個樣例的得到2個負樣例,而剩余的3-2=1個沒有被交換的樣例則為正樣例。

接著,將構造好的每個樣例中的和拼接起來作為輸入到一個激活函數為sigmoid的全連接層中用于預測圖文匹配的概率。

判斷圖文是否匹配可以被看做是一個二分類任務,因此在獲取的正負樣例后,可以自然地獲得每個樣例的真實標簽(正樣例為1,負樣例為0),再通過上述公式得到預測概率后,便可以使用二元交叉熵來訓練該模塊。

最后,使用該模塊輸出的概率與進行逐元素相乘來獲得圖像應保留的信息(該模塊輸出的概率越大說明圖文匹配的概率越高,則逐元素相乘圖像保留的信息越多)。

Cross-Modal Fusion Module (CF)

該模塊用于將文本token序列以及最終圖像的表示融合在一起。首先,本文使用門機制動態地調整應與文本結合的圖像表示:

最后將和拼接在一起得到,其中。將輸入到CRF層中,便可以得到每個token對應的類別。

訓練時,CA和CM中的損失會和命名實體識別的損失同步訓練。

實驗

主要結果

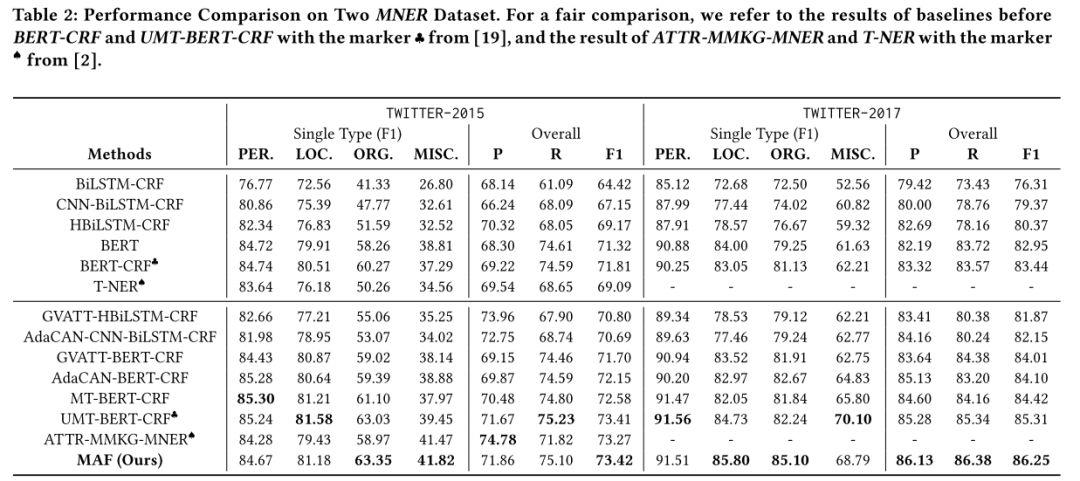

本文的方法在Twitter-2015和Twitter-2017數據集上效果均優于之前的方法。

運行時間

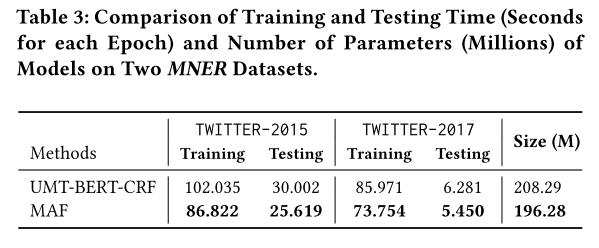

本文的方法相比于之前的方法除了有著模態之間交互的模塊(本文中為CI),還添加了對齊模態表示的CA以及判斷圖文是否匹配的CM,這可能會導致訓練成本以及預測成本增加。但本文簡化了模態之間交互的過程,因此整體訓練和預測時間以及模型大小均由于之前的SOTA方法。

消融實驗

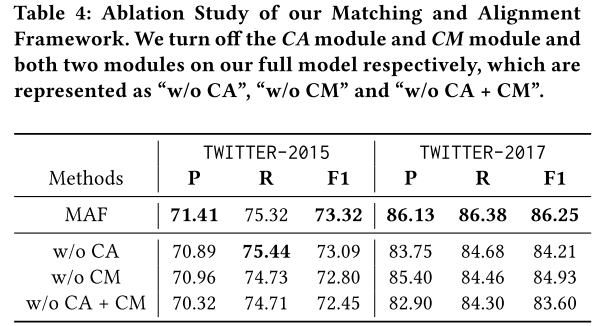

本文進行了消融實驗,驗證了CA和CM的有效性。

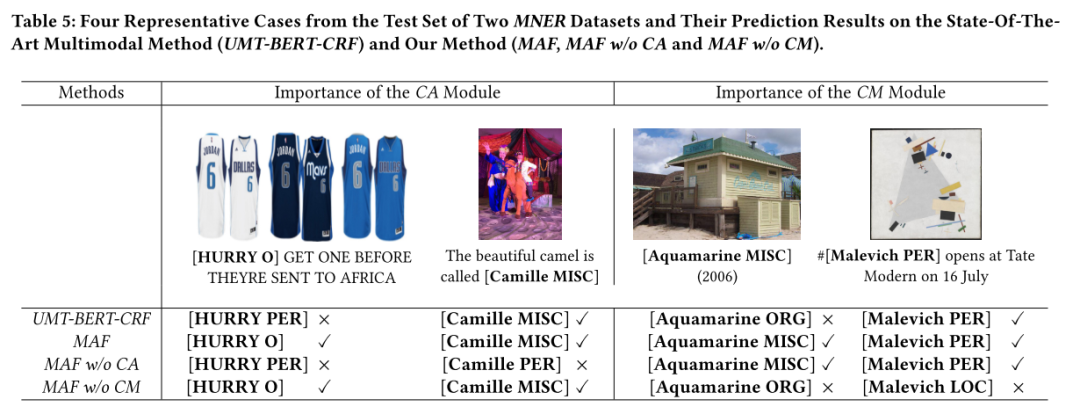

樣例分析

本文還進行了樣例分析來更加直觀地展示CA和CM的有效性。

參考資料

[1] A Simple Framework for Contrastive Learning of Visual Representations:http://proceedings.mlr.press/v119/chen20j/chen20j.pdf

[2] Embedding-based Product Retrieval in Taobao Search:https://arxiv.org/pdf/2106.09297.pdf?ref=https://githubhelp.com

[3] SimCSE: Simple Contrastive Learning of Sentence Embeddings:https://arxiv.org/pdf/2104.08821.pdf?ref=https://githubhelp.com

[4] Momentum Contrast for Unsupervised Visual Representation Learning:https://openaccess.thecvf.com/content_CVPR_2020/papers/He_Momentum_Contrast_for_Unsupervised_Visual_Representation_Learning_CVPR_2020_paper.pdf

審核編輯 :李倩

-

圖像

+關注

關注

2文章

1094瀏覽量

41059 -

框架

+關注

關注

0文章

404瀏覽量

17812 -

nlp

+關注

關注

1文章

490瀏覽量

22516

發布評論請先 登錄

基于LockAI視覺識別模塊:C++多模板匹配

基于LockAI視覺識別模塊:C++多模板匹配

愛芯通元NPU適配Qwen2.5-VL-3B視覺多模態大模型

?多模態交互技術解析

海康威視發布多模態大模型文搜存儲系列產品

字節跳動發布OmniHuman 多模態框架

商湯日日新多模態大模型權威評測第一

利用OpenVINO部署Qwen2多模態模型

云知聲山海多模態大模型UniGPT-mMed登頂MMMU測評榜首

使用 TMP1826 嵌入式 EEPROM 替換用于模塊識別的外部存儲器

用于多模態命名實體識別的通用匹配對齊框架

用于多模態命名實體識別的通用匹配對齊框架

評論