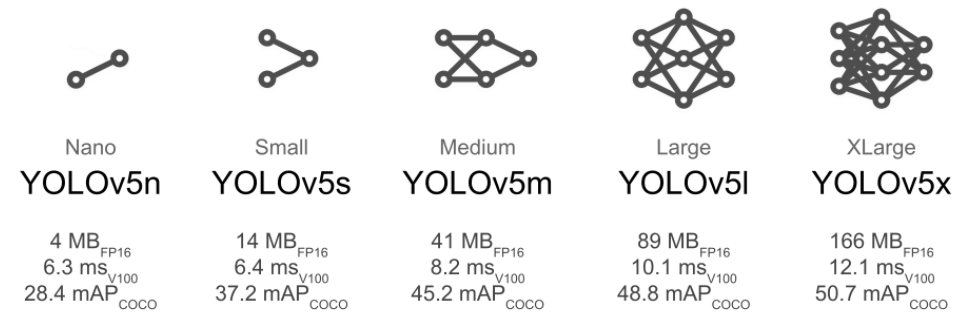

emmm,我老師寫的代碼,Intel D435抓到畫面,經過YOLOV5以后,輸出結果控制小車來運動,很具體的代碼就不能分享了,不過我就是想研究下這個CV算法的結果是如何和硬件世界產生聯系的。

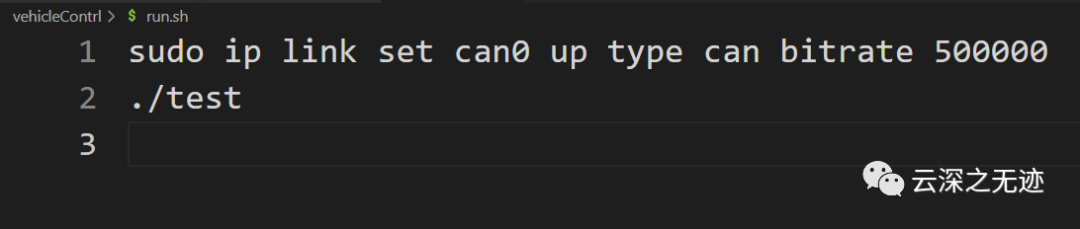

代碼在運行的時候都是需要設置CAN的一些參數

一開始就是一個大無語的事件,在源碼里面有一個代碼的注釋,套娃無止境~

合著這一篇文就是無限Copy唄,吐了

由于系統將 CAN 設備作為網絡設備進行管理,因此在 CAN 總線應用開發方面, Linux 提供了SocketCAN 接口,使得 CAN 總線通信近似于和以太網的通信,應用程序開發接口 更加通用, 也更加靈活。

SocketCAN 中大部分的數據結構和函數在頭文件 linux/can.h 中進行了定義。CAN 總線套接字的創建采用標準的網絡套接字操作來完成。網絡套接字在頭文件 sys/socket.h 中定義。

截至現在,edge瀏覽器已經被我不小心關了兩次了,吐了,

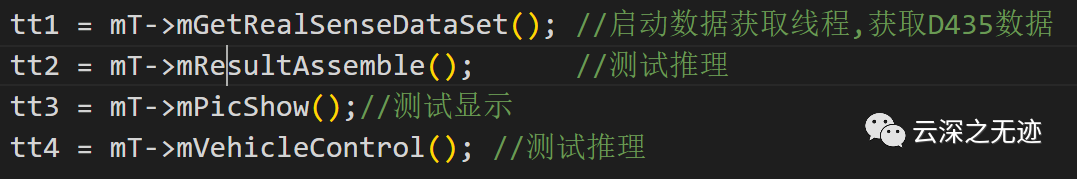

主要會開3個線程,有一個是測試的,在運行的時候是不需要打開的

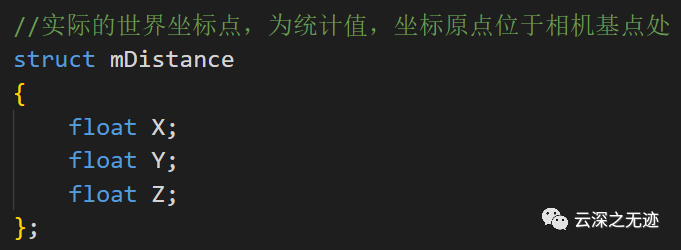

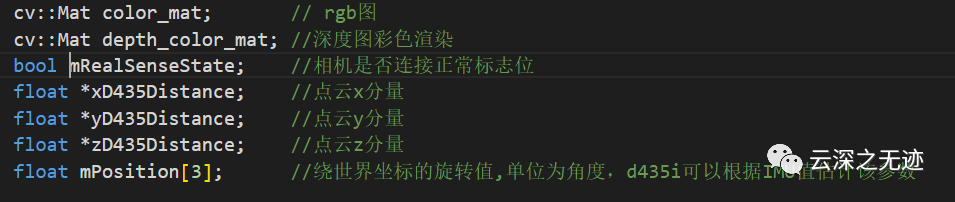

這個就看一個定義就行

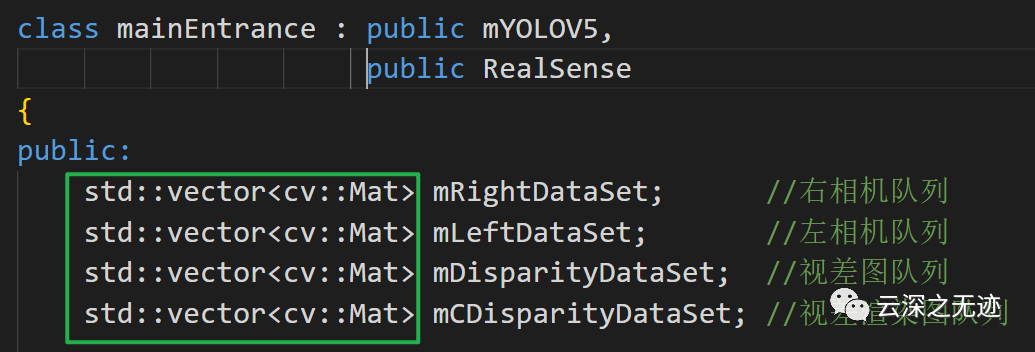

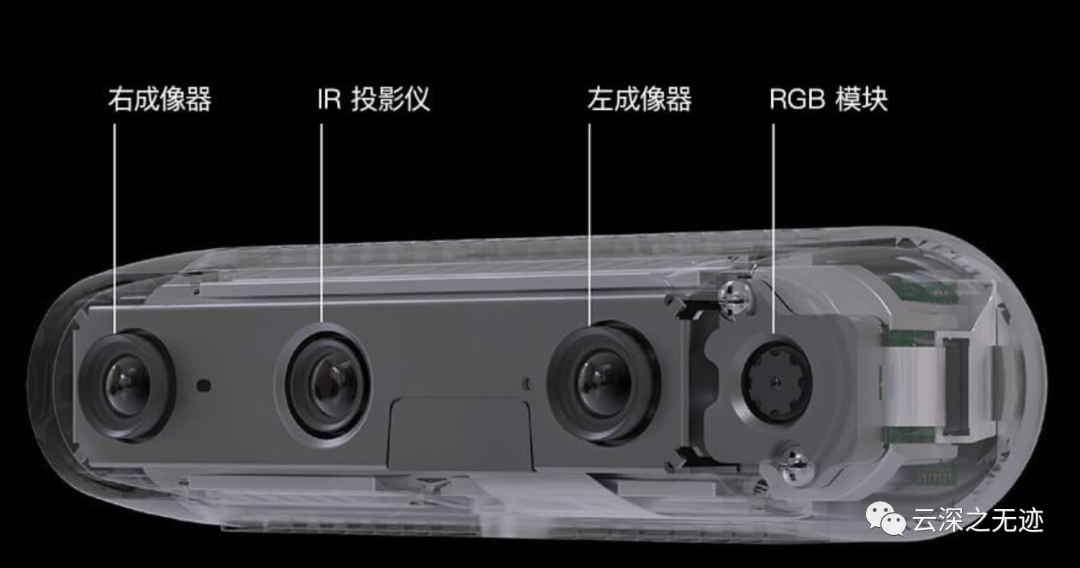

這里使用雙目的相機做出來的,使用了隊列的結構來緩沖

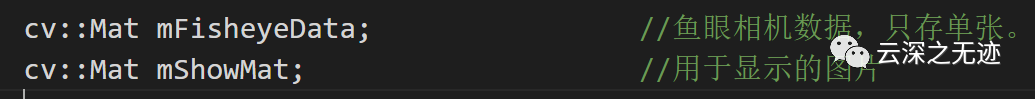

這個魚眼我覺沒有用到

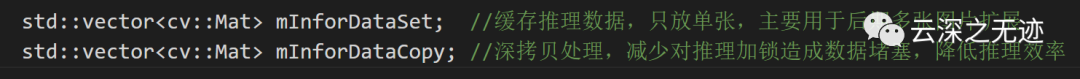

以及圖像中間的一些緩存結果

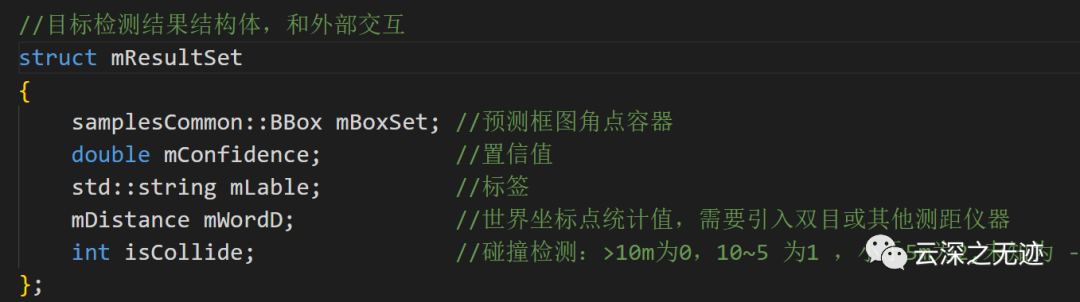

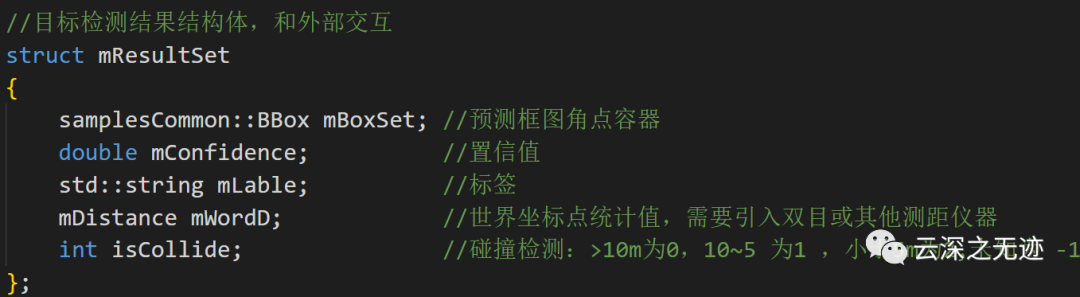

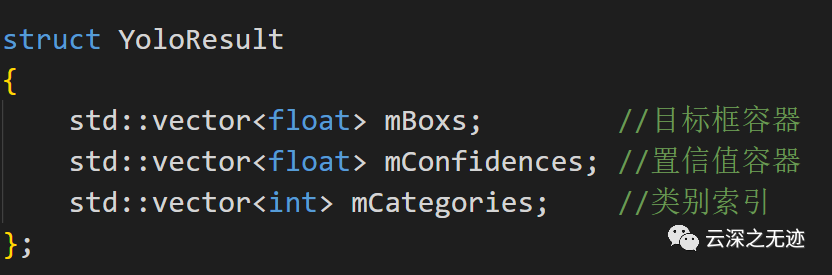

這個就是我在意的東西,推理的結果就這樣就輸出來

這里是把相機和tensor(英偉達的加速器),通用功能寫一起

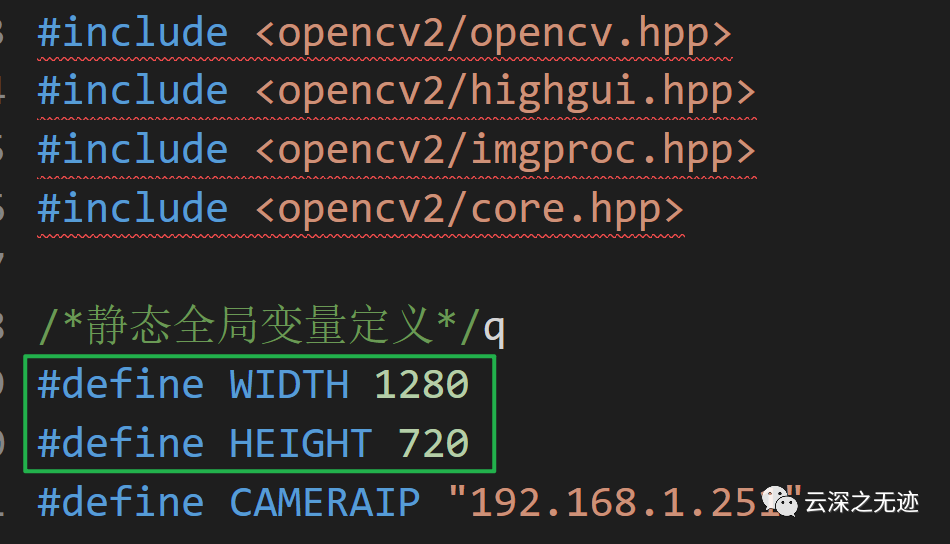

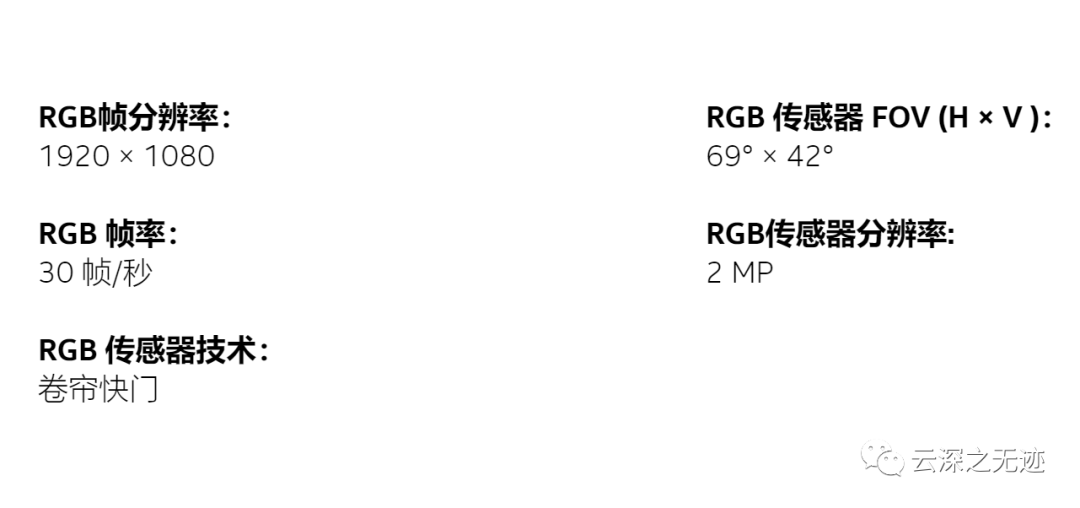

這里是相機的分辨率,直接就最高了

因為是英偉達的東西,所以CUDA必須出現

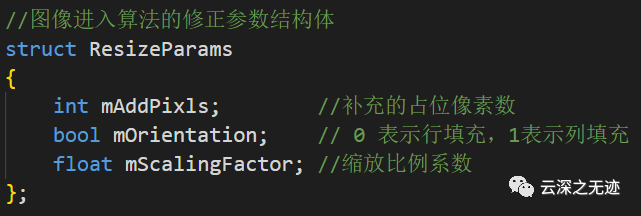

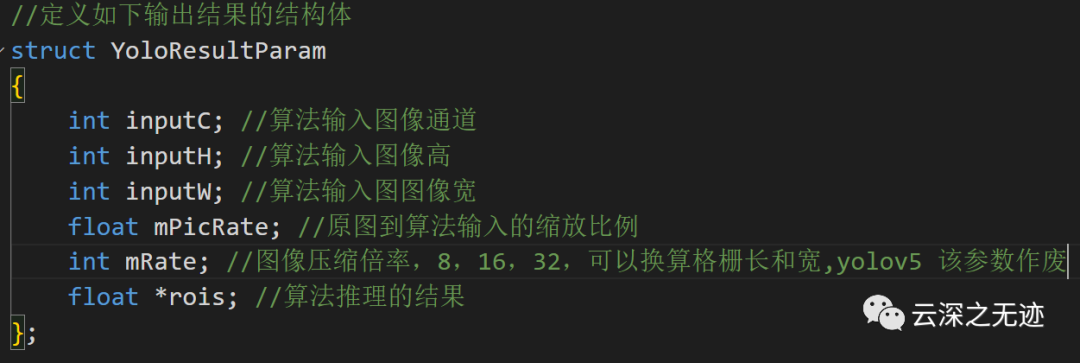

這個是算法的修正參數

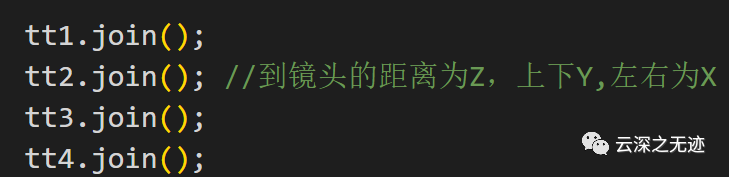

這里有個疑惑的地方就是Z,可能是使用了深度相機,所以這個就可以讀取到,上面說了,Z是相機到景物的距離,我土狗了。

這個就是我最感興趣的,從圖像中計算出來的一個結果怎么樣才可以傳到外部進行下一步的計算和使用呢?結構體里面第一個就是預測框的點容器,我覺得CV里面最好玩,最有成就感的事情無非就是這些事情了,下面是的你計算的物體的置信值,下面是標簽,具體的這個距離還是需要使用雙目相機來估計位置。

應該是可以使用的雙目相機

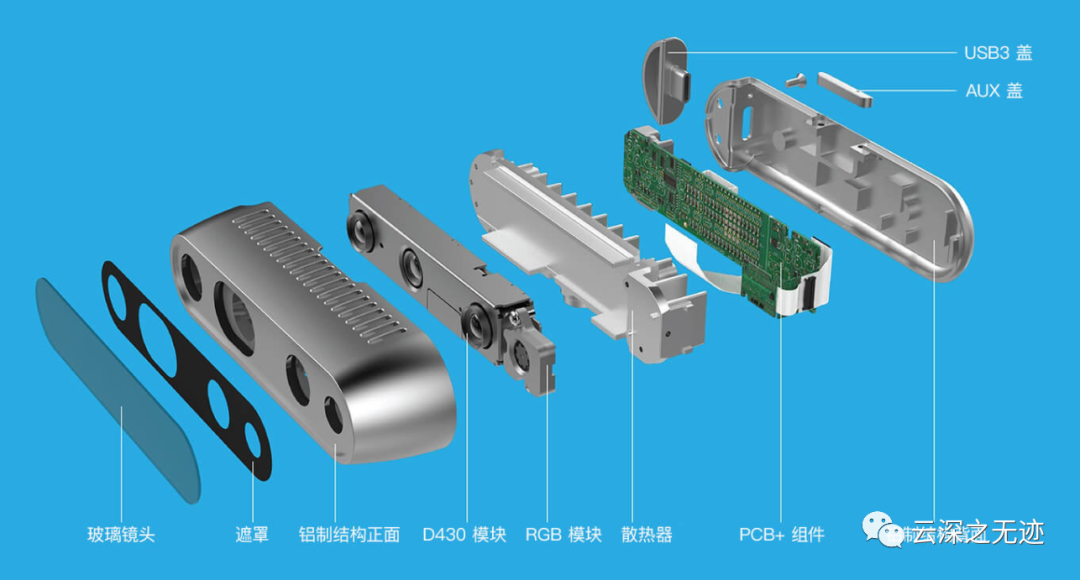

具體的結構圖

最大支持就是1080P的結果

這個就是當時的一張照片,我這里就截圖了

這個是結果的參數結構體

YOLO的輸出結構體

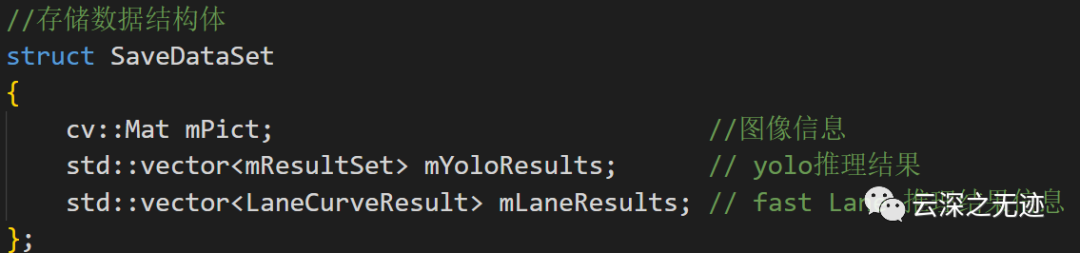

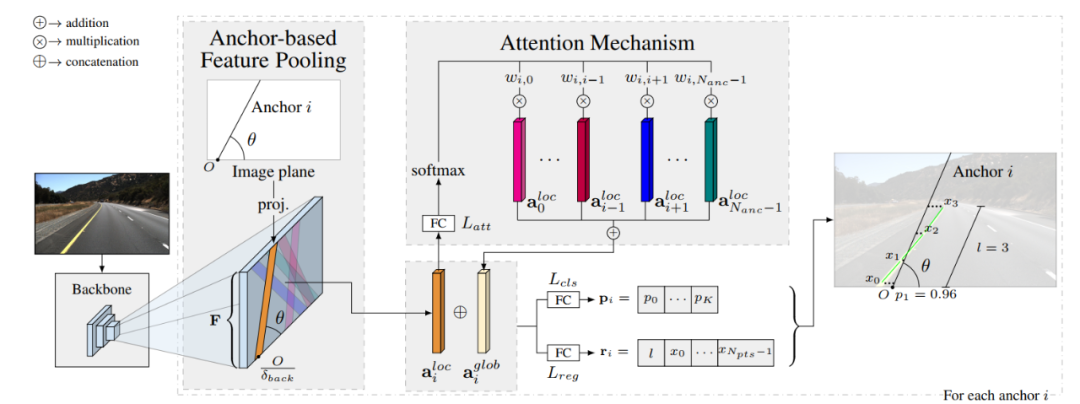

這個看注釋吧,不過應該是有一個高性能車道線檢測算法LaneATT,下面也有輸出的結果,不過在室內是沒有檢測到。

算法的流程圖

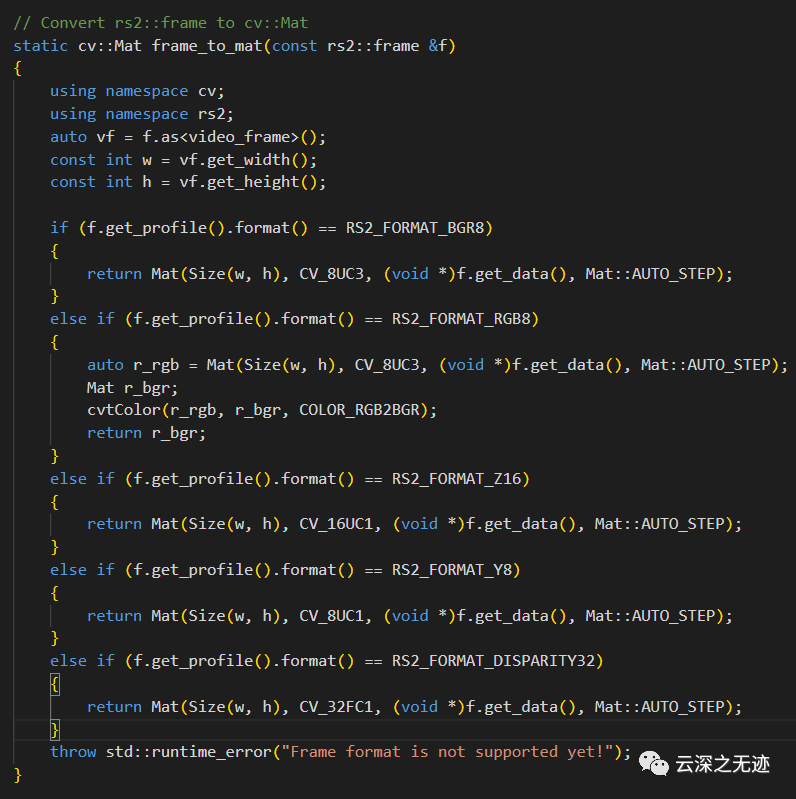

太詳細的代碼不貼了,不過這里可以放一個工具函數:

realsense到CV

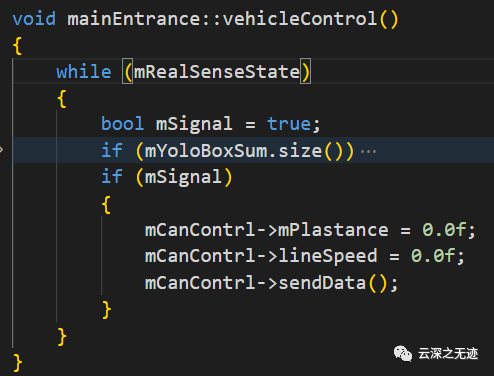

這個就是控制車子和相機的代碼

相機正常輸出幀以后,開始處理

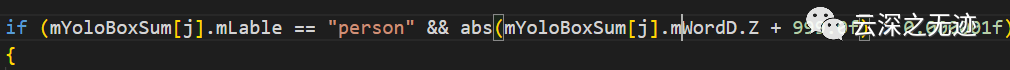

這句是來判斷,是不是人和深度無限遠

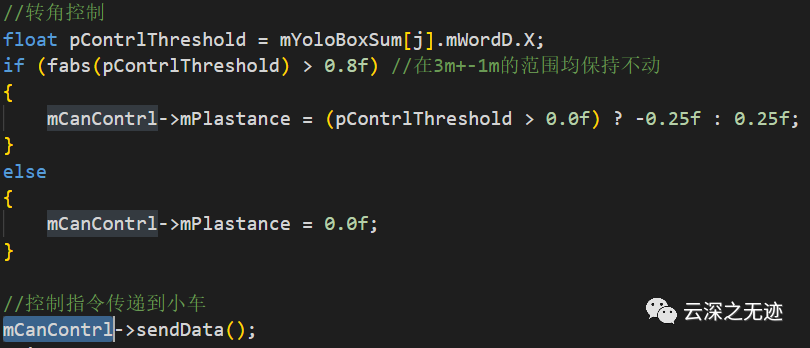

這里就是在上面條件成立的前提下開始控制車

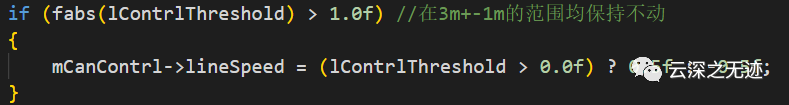

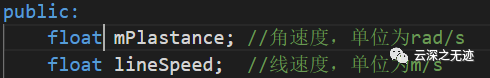

只有兩個

把要控制的指令打包好一發送就差不多可以啦。

審核編輯:劉清

-

以太網通信

+關注

關注

2文章

54瀏覽量

11264 -

Linux系統

+關注

關注

4文章

604瀏覽量

28406 -

CAN接口

+關注

關注

3文章

80瀏覽量

26323

原文標題:YoloV5如何輸出檢測結果給外界使用?

文章出處:【微信號:TT1827652464,微信公眾號:云深之無跡】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【YOLOv5】LabVIEW+YOLOv5快速實現實時物體識別(Object Detection)含源碼

在RK3568教學實驗箱上實現基于YOLOV5的算法物體識別案例詳解

怎樣使用PyTorch Hub去加載YOLOv5模型

使用Yolov5 - i.MX8MP進行NPU錯誤檢測是什么原因?

如何YOLOv5測試代碼?

yolov5模型onnx轉bmodel無法識別出結果如何解決?

基于YOLOv5的目標檢測文檔進行的時候出錯如何解決?

yolov5和YOLOX正負樣本分配策略

在樹莓派上部署YOLOv5進行動物目標檢測的完整流程

YoloV5輸出檢測結果給外界使用的操作流程

YoloV5輸出檢測結果給外界使用的操作流程

評論