導(dǎo)讀

本文作者從稀疏性的角度提出了一個(gè)應(yīng)用超大 Kernel 的方法,它可以平滑地將 Kernel 擴(kuò)展到 61×61,并具有更好的性能。因此作者將模型命名為稀疏大 Kernel 網(wǎng)絡(luò) (SLaK),一種配備 51×51 卷積核的純 CNN 架構(gòu)。

1 SLaK:從稀疏性的角度將卷積核擴(kuò)展到 51×51

論文名稱(chēng):More ConvNets in the 2020s: Scaling up Kernels Beyond 51 × 51 using Sparsity

論文:https://arxiv.org/abs/2207.03620

代碼:https://github.com/VITA-Group/SLaK

1.1 SLaK 原理分析

本文的背景是超大 Kernel 的卷積神經(jīng)網(wǎng)絡(luò)的出現(xiàn),大核卷積的思路來(lái)自 ViT 模型建模全局信息的性質(zhì)。其中代表性的工作就是 RepLKNet,將卷積核的大小增加到了 31×31,同時(shí)獲得了和 Swin Transformer 相當(dāng)?shù)姆诸?lèi)性能和更好的下游任務(wù)性能。本文作者探索了訓(xùn)練大于 31×31 的極端卷積的可能性,本文發(fā)現(xiàn)持續(xù)地增加卷積核會(huì)帶來(lái)性能飽和,所以本文意在探索是否可以通過(guò)策略性地?cái)U(kuò)大卷積來(lái)消除性能差距。經(jīng)過(guò)不斷探索,本文作者從稀疏性的角度提出了一個(gè)應(yīng)用超大 Kernel 的方法,它可以平滑地將 Kernel 擴(kuò)展到 61×61,并具有更好的性能。因此作者將模型命名為稀疏大 Kernel 網(wǎng)絡(luò) (SLaK),一種配備 51×51 卷積核的純 CNN 架構(gòu)。

1.1.1 背景和動(dòng)機(jī)

在現(xiàn)代計(jì)算機(jī)視覺(jué)任務(wù)中,通用視覺(jué)模型最早以深而 Kernel 小的 CNN 為主。自從 ViTs 出現(xiàn)之后,人們漸漸發(fā)現(xiàn)建模全局信息的重要性:人們開(kāi)始覺(jué)得 ViTs 的幾本構(gòu)件:類(lèi) Self-attention 模塊具有建模全局信息的能力[1]。很多工作也證明了,即使 Token-Mixer 不設(shè)計(jì)成 Query-Key-Value 的形式,模型也能夠訓(xùn)練出很出色的性能。所以大家覺(jué)得,Self-attention 的這種在全局尺度或較大的窗口內(nèi)進(jìn)行運(yùn)算的模式,才是模型性能提升的關(guān)鍵。來(lái)自單個(gè) Self-attention 層的每個(gè)輸出能夠從相對(duì)大的區(qū)域收集信息。與 CNN 共享權(quán)重的小滑動(dòng)窗口 (3×3 或 5×5) 相比,ViTs 中具有較大窗口大小的全局注意或局部注意直接使每一層能夠捕獲大的感受野。

受這種趨勢(shì)的啟發(fā),最近一些關(guān)于 CNN 的工作 (RepLKNet[2],ConvNeXt[3]) 通過(guò)設(shè)計(jì)較大的 Kernel 獲得了與Swin Transformer 相當(dāng)?shù)慕Y(jié)果。但即使是使用了重參數(shù)化技術(shù),使用平行的小 Kernel 分支來(lái)輔助訓(xùn)練,大 Kernel 仍然存在難以訓(xùn)練的問(wèn)題。本文發(fā)現(xiàn),隨著 Kernel 大小的不斷增加,RepLKNet 的性能逐漸趨于飽和。我們是否可以通過(guò)進(jìn)一步將 Kernel 的大小從 31×31 再向上擴(kuò)展,以超越基于 Transformer 的模型,這仍然是一個(gè)謎,所以本文意在探索是否可以通過(guò)策略性地?cái)U(kuò)大卷積來(lái)消除性能差距。

具體而言,本文作者從稀疏性的角度來(lái)探索這個(gè)問(wèn)題。稀疏性是人類(lèi)視覺(jué)系統(tǒng)中視覺(jué)皮層 (V1) 的重要特點(diǎn),視覺(jué)皮層中傳入的刺激可以假設(shè)為稀疏編碼 (sparsely coded) 并被選擇。作者廣泛研究了大 Kernel 的可訓(xùn)練性,并在本文章給出了3個(gè)主要觀(guān)察結(jié)果:

直接訓(xùn)練大 Kernel 模型,或者輔助結(jié)構(gòu)重新參數(shù)化技術(shù)都不能將核的大小縮放到 31×31 以上。

用兩個(gè)矩形的并行內(nèi)核 (M×N 和 N×M,其中 N < M) 代替一個(gè)大的 M×M Kernel,可以平滑地將內(nèi)核大小縮放到 61×61,并改進(jìn)性能。

使用稀疏方法,同時(shí)加大模型的寬度,可以再顯著提升性能。

基于這些觀(guān)察,本文提出的稀疏大 Kernel 網(wǎng)絡(luò) (SLaK),一種新的純 CNN 架構(gòu),配備了前所未有的 51×51 的超大 Kernel。在包括 ImageNet 圖像分類(lèi)、ADE20K 語(yǔ)義分割和 PASCAL VOC 2007 上的物體檢測(cè)在內(nèi)的各種任務(wù)中進(jìn)行評(píng)估,SLaK 實(shí)現(xiàn)了比 SOTA CNN (如 ConvNeXt 等) 以及 SOTA Transformer (如 Swin 等) 更高的準(zhǔn)確性。有效感受野 (ERF) 的分析也證明了 SLaK 能夠覆蓋比現(xiàn)有更大的 ERF 區(qū)域,同時(shí)引入更多的 human-like peripheral shape bias。

1.1.2 動(dòng)態(tài)稀疏化技術(shù)

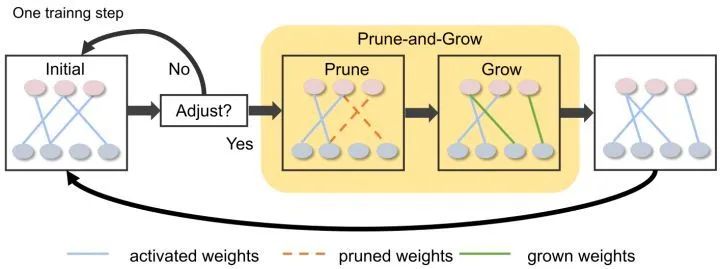

動(dòng)態(tài)稀疏化技術(shù)是一種從頭開(kāi)始訓(xùn)練稀疏神經(jīng)網(wǎng)絡(luò)的技術(shù)。后訓(xùn)練剪枝 (post-training pruning) 一般是指先訓(xùn)練好一個(gè)密集的大模型,再對(duì)其參數(shù)進(jìn)行剪枝。但在動(dòng)態(tài)稀疏化中,模型從一開(kāi)始就是稀疏的,訓(xùn)練和推理的 FLOPs 以及內(nèi)存的需求只是密集模型的一小部分。不涉及任何預(yù)訓(xùn)練。

如下圖1所示,動(dòng)態(tài)稀疏化技術(shù)來(lái)自 Sparse Evolutionary Training (SET) 方法,該方法首先隨機(jī)初始化層之間的稀疏連接,并在訓(xùn)練過(guò)程中通過(guò)參數(shù)修剪-增長(zhǎng)方案動(dòng)態(tài)調(diào)整模型的稀疏連接。這個(gè)方案允許模型的稀疏結(jié)構(gòu)逐漸進(jìn)化,比單純訓(xùn)練靜態(tài)稀疏網(wǎng)絡(luò)獲得更好的性能。

圖1:動(dòng)態(tài)稀疏化技術(shù)

1.1.3 縮放卷積核的大小使之超過(guò) 31×31 的三個(gè)觀(guān)察

作者首先研究大于 31×31 的極限 Kernel 的性能,并分享3個(gè)主要的觀(guān)察結(jié)果。以最近的 SOTA CNN 架構(gòu)ConvNeXt 和 ImageNet-1K 數(shù)據(jù)集作為基準(zhǔn)。

作者遵循骨干模型的一般訓(xùn)練策略,即數(shù)據(jù)增強(qiáng)方式為 Mixup,Cutmix,RandAugment,Random Erasing 。正則化方法是:Stochastic Depth 和 Label Smoothing。AdamW 作為優(yōu)化器,分析性試驗(yàn)都是訓(xùn)練 120 Epochs 目的是快速觀(guān)察方法的效果,正式實(shí)驗(yàn)訓(xùn)練 300 Epochs,以便能夠與最先進(jìn)的模型進(jìn)行公平的比較。

觀(guān)察1:已有方法 (結(jié)構(gòu)重參數(shù)化技術(shù)) 無(wú)法進(jìn)一步將 Kernel 的大小從 31×31 再向上擴(kuò)展

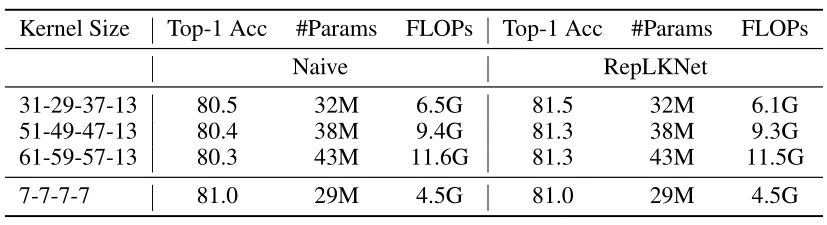

RepLKNet 通過(guò)結(jié)構(gòu)重新參數(shù)化技術(shù)成功地將卷積擴(kuò)展到 31×31,同時(shí)使得模型獲得了和 Swin Transformer 相當(dāng)?shù)男阅堋1疚淖髡哌M(jìn)一步將內(nèi)核大小增加到 51×51 和 61×61,看看更大的 Kernel 是否能夠帶來(lái)更多的性能增益。按照 RepLKNet 中的設(shè)計(jì),作者相繼將每一個(gè) Stage 的 Kernel 大小設(shè)置為 [51, 49, 47, 13] 和 [61, 59, 57, 13],結(jié)果如下圖2所示。結(jié)果顯示,僅僅將 Kernel 的大小從 7×7 增加到 31×31 會(huì)顯著降低性能,而 RepLKNet可以克服這個(gè)問(wèn)題,將精度提高 0.5%。然而,這種趨勢(shì)不適用于較大的內(nèi)核,因?yàn)閷?Kernel 的大小增加到51×51 會(huì)開(kāi)始損害性能。

圖2:在 ImageNet-1K 上用各種大 Kernel 訓(xùn)練的 ConvNeXt-T 的測(cè)試精度,naive 是指直接增加 Kernel 的大小,RepLKNet 是指使用了結(jié)構(gòu)重參數(shù)化技術(shù)

對(duì)于這種現(xiàn)象,一種合理的解釋是:我們把卷積核擴(kuò)大到 51×51 或者 61×61 之后,雖然模型的感受野增加了,但是它可能無(wú)法保持某些期望的特性,比如局部性。由于標(biāo)準(zhǔn) ResNet 和 ConvNeXt 的 Stem 模塊已經(jīng)把輸入降采樣了4倍,所以 51×51 這種超大的 Kernel 其實(shí)就基本相當(dāng)于是 global convolution (對(duì)于 224×224 的 ImageNet 而言)。因此,這種觀(guān)察是有意義的,因?yàn)樵?ViTs 的類(lèi)似機(jī)制中,局部注意力 (如 Swin) 通常優(yōu)于整體注意力 (如 DeiT) 。借此啟發(fā),作者希望借助局部性來(lái)解決這個(gè)問(wèn)題,同時(shí)要使模型保留捕捉全局關(guān)系的能力。

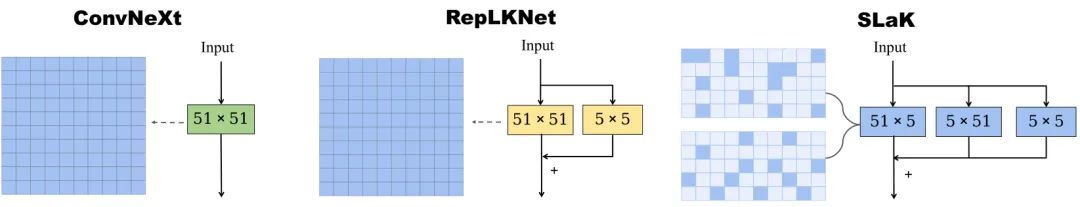

觀(guān)察2:把一個(gè)正方形的大 Kernel 分解成兩個(gè)矩形的、平行的不規(guī)則 Kernel 可以平滑地將 Kernel 的大小擴(kuò)展到61

作者的方法是用兩個(gè)平行的矩形卷積來(lái)逼近超大 M×M 的 Kernel,這兩個(gè)卷積的 Kernel 大小分別是 M×N 和N×M (其中 N < M),如下圖2所示。這種等于是改進(jìn)得 RepLKNet,只是并行的分支變?yōu)榱藘芍АM瑫r(shí)再多一支 5×5 的分支,并且在 BN 層的輸出合并這3個(gè)分支。

圖2:用兩個(gè)平行的矩形卷積來(lái)逼近超大 M×M 的 Kernel,這兩個(gè)卷積的 Kernel 大小分別是 M×N 和N×M (其中 N < M)

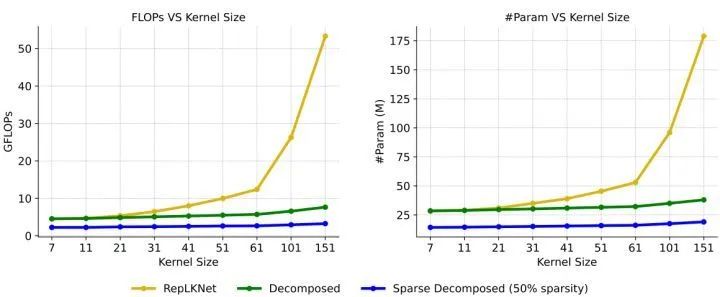

這種分解不僅繼承了超大 Kernel 捕捉長(zhǎng)距離關(guān)系的能力,而且可以提取具有較短邊緣的局部上下文特征。此外,如下圖3所示,現(xiàn)有的大 Kernel 訓(xùn)練技術(shù) (RepLKNet) 隨著 Kernel Size 的增加,計(jì)算和存儲(chǔ)開(kāi)銷(xiāo)也呈平方增長(zhǎng)。N=5 被記為 Decomposed,由于不再有 31×31 的大 Kernel,所以 Decomposed 相比于結(jié)構(gòu)重參數(shù)化的 31×31 會(huì)犧牲一定的精度。但是,隨著卷積大小增加到全局卷積,它可以令人驚訝地將內(nèi)核大小擴(kuò)展到61,同時(shí)提高性能。

圖3:應(yīng)用于 ConvNeXt-T 時(shí)各種大 Kernel 訓(xùn)練方法的縮放效率

觀(guān)察3:使用更多稀疏的 Group,可以提高模型的容量

ConvNeXt 的卷積操作設(shè)計(jì)原則是使用 Depth-wise Convolution,同時(shí)加大寬度,因此這個(gè)設(shè)計(jì)思路可以概括成 "use more groups, expand width"。本文的設(shè)計(jì)思路可以概括成 "use sparse groups, expand more"。具體來(lái)講,作者首先用稀疏卷積替換密集卷積,其中稀疏核基于 SNIP 構(gòu)建。在構(gòu)建之后,作者用動(dòng)態(tài)稀疏化技術(shù)來(lái)訓(xùn)練稀疏模型。其中稀疏化的權(quán)重在訓(xùn)練期間動(dòng)態(tài)調(diào)整:先隨機(jī)剪掉一部分,再隨機(jī)增加相同數(shù)量的權(quán)重。這樣做允許稀疏權(quán)重的動(dòng)態(tài)適應(yīng),從而產(chǎn)生更好的局部特征。由于核在整個(gè)訓(xùn)練過(guò)程中是稀疏的,相應(yīng)的 Params 和訓(xùn)練/推理的 FLOPs 都不大。作者用 40% 的稀疏度,結(jié)果被記為 Sparse Decomposed。

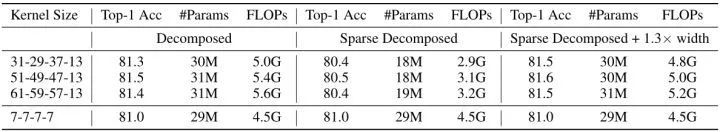

圖4:ConvNeXt 在不同實(shí)驗(yàn)設(shè)置下的測(cè)試精度

如上圖4所示為 ConvNeXt 在不同實(shí)驗(yàn)設(shè)置下的測(cè)試精度。從第2列可以看到,用 40% 的稀疏度之后,模型的參數(shù)量和計(jì)算量出現(xiàn)了明顯下降,但是性能出現(xiàn)了暫時(shí)的下降。但是動(dòng)態(tài)稀疏可以提高模型的可擴(kuò)展性 (scalability)。具體而言就是,動(dòng)態(tài)稀疏性允許我們擴(kuò)大模型的規(guī)模。例如,使用相同的稀疏度 (40%),可以將模型寬度 (width) 擴(kuò)展1.3倍,同時(shí)保持參數(shù)計(jì)數(shù)和 FLOPs 與密集模型大致相同。這帶來(lái)了顯著的性能提升,使用 51×51Kernel 時(shí),性能從 81.3% 提高到 81.6%。

1.1.4 稀疏大 Kernel 網(wǎng)絡(luò):SLaK

到目前為止,已經(jīng)可以成功地將 Kernel 的大小擴(kuò)展到 61,同時(shí)不會(huì)犧牲模型的性能。擴(kuò)展的方法包括2個(gè)稀疏啟發(fā)的設(shè)計(jì)。在宏觀(guān)層面上,構(gòu)建了一個(gè)系數(shù)模型,通過(guò)動(dòng)態(tài)稀疏化技術(shù)提高模型的容量。在微觀(guān)層面上,作者將一個(gè)超大 Kernel 分解為兩個(gè)互補(bǔ)的動(dòng)態(tài)稀疏核,以提高超大 Kernel 的可擴(kuò)展性。作者直接從頭開(kāi)始訓(xùn)練 SLaK,不涉及任何預(yù)訓(xùn)練或微調(diào)。

SLaK 是基于 ConvNeXt 的架構(gòu)構(gòu)建的,Stem 的設(shè)計(jì)繼承了 ConvNeXt。SLaK-T 的每個(gè) Stage 的塊數(shù)為 [3, 3, 9, 3],SLaK-S/B 的每一階段的塊數(shù)為 [3, 3, 27, 3],Stem 層是一個(gè) K=S=4 的卷積層。作者將 ConvNeXt 各個(gè) Stage 的 Kernel 的大小分別增加到 [51, 49, 47, 13],并將每個(gè) M×M 的 Kernel 替換為 M×5 和 5×M 的組合。作者發(fā)現(xiàn)在 M×5 和 5×M 之后加一個(gè) BN 層之后再求和非常有必要,同時(shí)按照使用更多稀疏的 Group 的原則,作者進(jìn)一步稀疏化整個(gè)網(wǎng)絡(luò),并將各個(gè) Stage 的寬度擴(kuò)展1.3倍,最終得到 SLaK-T/S/B 模型。

1.1.5 SLaK 實(shí)驗(yàn)結(jié)果

圖像分類(lèi)實(shí)驗(yàn)設(shè)置:ImageNet 數(shù)據(jù)集,300 Epochs,AdamW 優(yōu)化器,Batch size:4096,weight decay:0.05,lr:4e-3,20-epoch linear warmup rate,cosine lr decay schedule,數(shù)據(jù)增強(qiáng):RandAugment (rand-m9-mstd0.5-inc1), Label Smoothing (coefficient of 0.1), Mixup (α = 0.8), Cutmix (α = 1.0), Random Erasing (p = 0.25), Stochastic Depth with drop rate (0.1 SLaK-T, 0.4 SLaK-S, 0.5 SLaK-B),EMA (decay factor=0.9999)。

語(yǔ)義分割實(shí)驗(yàn)設(shè)置:ADE20K 數(shù)據(jù)集,ImageNet pre-trained 的預(yù)訓(xùn)練模型,UperNet 語(yǔ)義分割模型,訓(xùn)練 80K-iteration,測(cè)試 single-scale mIoU。

目標(biāo)檢測(cè)實(shí)驗(yàn)設(shè)置:PASCAL VOC 數(shù)據(jù)集,ImageNet pre-trained 的預(yù)訓(xùn)練模型,F(xiàn)aster-RCNN 目標(biāo)檢測(cè)模型,訓(xùn)練 36 Epochs,遵循 Swin。

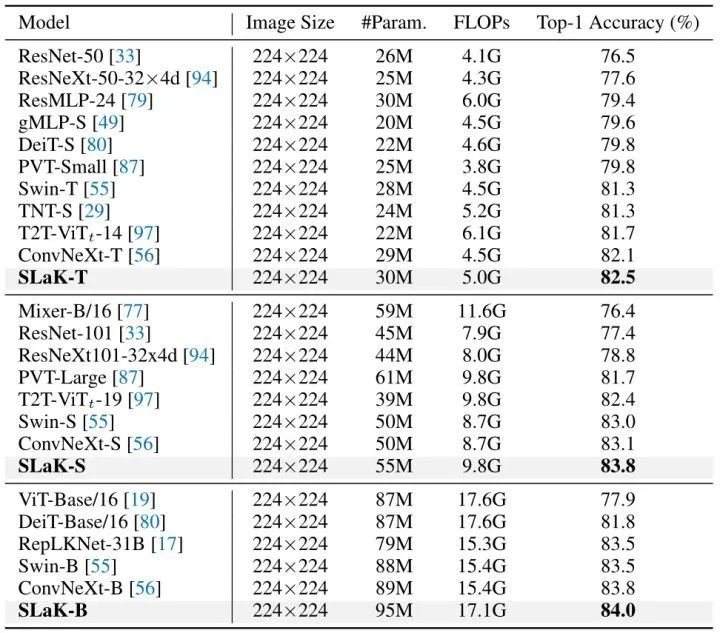

ImageNet 實(shí)驗(yàn)結(jié)果

如下圖4所示,在模型 Params 和 FLOPs 相似的情況下,SLaK 優(yōu)于現(xiàn)有的卷積模型,如 ResNe(X)t 、RepLKNet 和 ConvNeXt。在不使用任何復(fù)雜的 Self-attention 模塊和 Patch embedding 的情況下,SLaK 能夠?qū)崿F(xiàn)比最先進(jìn)的視覺(jué) Transformer (Swin,PVT 等)更高的精確度。更有趣的是,直接將 ConvNeXt-S 的 7×7 替換為 51×51能夠提高 0.7% 的精度。

圖4:ImageNet 實(shí)驗(yàn)結(jié)果

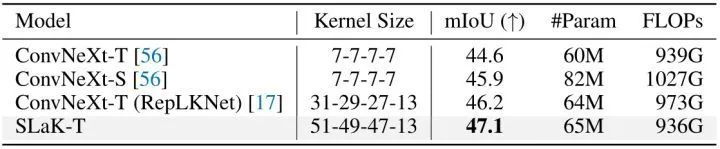

語(yǔ)義分割實(shí)驗(yàn)結(jié)果

ADE20K 數(shù)據(jù)集使用了 180K-iteration training schedule。結(jié)果如下圖5所示,可以看到一個(gè)非常明顯的趨勢(shì),性能隨著 Kernel 大小的增加而增加:RepLKNet 將 ConvNeXt-T 的 Kernel 大小從 7×7 擴(kuò)展到 31×31,mIoU 提高了 1.6%。值得注意的是,具有更大 Kernel (51×51) 的 SLaK-T 比具有 31×31 內(nèi)核的 ConvNeXt-T (RepLKNet) 進(jìn)一步提高了 0.9% mIoU,而所需的 FLOPs 更少。

圖5:語(yǔ)義分割實(shí)驗(yàn)結(jié)果

目標(biāo)檢測(cè)實(shí)驗(yàn)結(jié)果

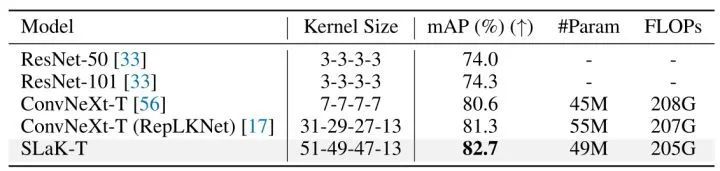

如下圖6所示顯示了 SLaK-T、ConvNeXt-T、RepLKNet 和傳統(tǒng)卷積網(wǎng)絡(luò) (ResNet) 的比較結(jié)果。同樣,大 Kernel 會(huì)帶來(lái)更好的性能。具體來(lái)說(shuō),具有 31×31 Kernel 的 ConvNeXt-T 比 7×7 Kernel 的平均精度 (mAP) 高 0.7%,具有 51×51 Kernel 大小的 SLaK-T 進(jìn)一步帶來(lái)了 1.4% 的 mAP 提升,突出了超大 Kernel 在下游視覺(jué)任務(wù)中的關(guān)鍵作用。

圖6:目標(biāo)檢測(cè)實(shí)驗(yàn)結(jié)果

1.1.6 SLaK 的其他討論

淺而大 Kernel 的 CNN 比深而小 Kernel 的 CNN 具有更大的有效感受野

RepLKNet 的作者在原論文中討論了幾種網(wǎng)絡(luò)模型的有效感受野:RepLKNet 作者認(rèn)為, 就獲得大的有效感受野而言, 單個(gè)大 Kernel 比許多小 Kernel 有效得多。根據(jù)有效感受野 (ERF) 理論 , ERF的大小與 成正比, 其中 是卷積核大小, 是深度, 即層數(shù)。換句話(huà)說(shuō), ERF 隨 Kernel 的大小線(xiàn)性增長(zhǎng), 而隨深度亞線(xiàn)性增長(zhǎng)。

因此,SLaK 中的 Kernel 分解操作背后的假設(shè)是,兩個(gè)獨(dú)立的 M×N 和 N×M 的 Kernel 可以很好地保持大 Kernel 在捕獲很大的有效感受野方面的能力,同時(shí)卷積核的短邊 (N) 也有利于捕捉細(xì)粒度的局部特征。為了評(píng)估這一假設(shè),作者對(duì) SLaK 和 RepLKNet 捕獲的 ERF 進(jìn)行了比較。

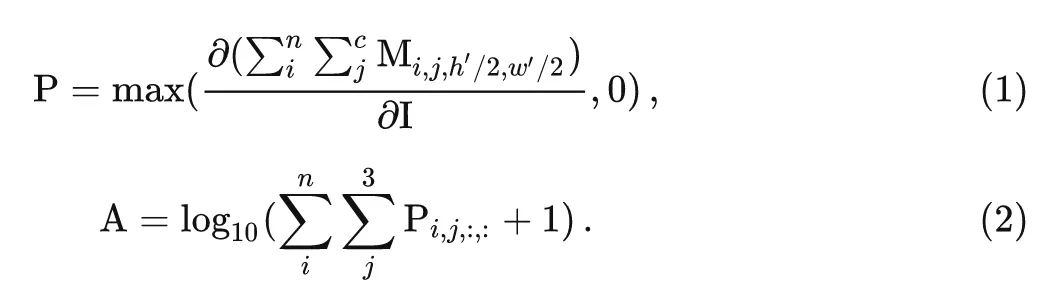

作者從驗(yàn)證集中選擇50張圖像并將其大小調(diào)整為 1024×1024,測(cè)量輸入圖像上的像素對(duì)最后一層中生成的特征圖的中心點(diǎn)的貢獻(xiàn),并將它們相加得到 1024×1024 矩陣。如下圖7所示作者分析了 ResNet 和 RepLKNet 的有效感受野。可視化有效感受野的方法是:

令 表示輸入圖片, 表示最終的輸出特征, 我們希望測(cè)量一下輸入圖片的每一個(gè)像素對(duì)于最終輸出特征中心位置 的貢獻(xiàn)。這可以通過(guò) autograd 機(jī)制通過(guò)計(jì)算 對(duì)輸入的導(dǎo)數(shù)來(lái)得到。形式上, 得分矩陣 由下式給出:

最后, 把得分矩陣 rescale 到 0-1。簡(jiǎn)而言之, 得分矩陣 測(cè)量輸入圖像上的對(duì)應(yīng)像素對(duì)由最后一層產(chǎn)生的特征圖的中心點(diǎn)的貢獻(xiàn)。如上圖1所示, 暗色區(qū)域分布得越離散, 代表有效感受野 (ERF) 越大。結(jié)果發(fā)現(xiàn), 更多的層 (例如從 ResNet-101 到 ResNet-152) 對(duì)擴(kuò)大 ERF 幾乎沒(méi)有幫助。相反, 較淺的大 Kernel 模型的有效感受野非常大。

圖7:ConvNeXt,RepLKNet 和 SLaK 的有效感受野,以及所使用的的卷積核大小

從圖7中可以看到,盡管原始的 ConvNeXt 已經(jīng)將 Kernel 大小提高到 7×7,但是對(duì)輸出的某個(gè)像素具有高貢獻(xiàn)度的輸入圖片的像素僅出現(xiàn)在中心部分。對(duì)于 RepLKNet,即使它使用了 31×31 的 Kernel,也不足以讓 ConvNeXt 的有效感受野覆蓋整個(gè)輸入。相比之下,SLaK 的高貢獻(xiàn)像素分布在更大的輸入范圍內(nèi),表明 ERF 更大。另外,SLaK 的感受野呈現(xiàn)出了明暗交替的現(xiàn)象,中心區(qū)域更加明亮,外圍區(qū)域更暗淡一點(diǎn)。這一發(fā)現(xiàn)與假設(shè)完全一致,即 SLaK 不僅能夠捕獲長(zhǎng)程距離的依賴(lài)性,還能夠捕獲局部特征。

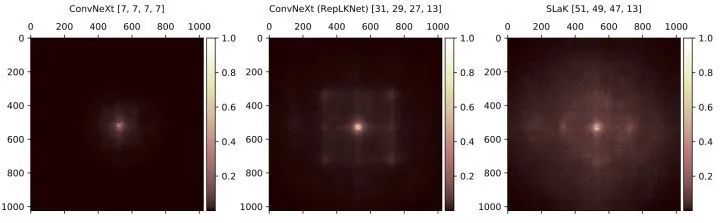

作者還做了定量分析:給定一個(gè)閾值 , 作者報(bào)告了覆蓋面積的貢獻(xiàn)分?jǐn)?shù)達(dá)到了閾值 的最小矩形的面積比 ,如下圖8所示。比如對(duì)于 ResNet-101 模型, 中間 102×102 的區(qū)域的貢獻(xiàn)分?jǐn)?shù)達(dá)到了閾值 20%, 所占面積為 。較大的值代表模型考慮更大范圍的像素來(lái)做決策。可以看到, 有了全局內(nèi)核, SLaK 自然會(huì)比 ConvNeXt 和 RepLKNet 的最小矩形的面積比 值高。

圖8:ERF 的定量分析結(jié)果

使用更多稀疏的 Group,可以提高模型的容量

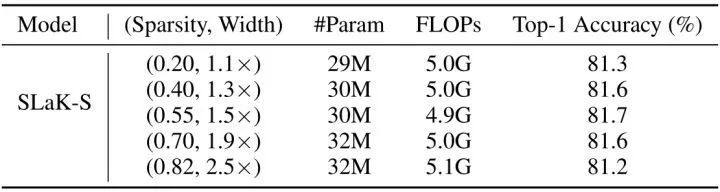

除此之外,本文的第3點(diǎn)觀(guān)察 "使用更多稀疏的 Group,可以提高模型的容量"。為了維持模型的參數(shù)量和計(jì)算量盡量接近,當(dāng)模型的稀疏度足夠低時(shí),寬度就得小一些;當(dāng)模型的稀疏度很高時(shí),寬度就可以大一些。因此,存在一個(gè) Sparsity-Width 的權(quán)衡。為了更好地理解這種權(quán)衡,作者選擇了 Sparsity-Width 的5種組合,所有設(shè)置都有大約 5.0M 的 FLOPs,但網(wǎng)絡(luò)寬度不同。實(shí)驗(yàn)在 SLaK-T 上進(jìn)行。正如作者預(yù)期的那樣,隨著模型寬度的增加,模型的性能不斷提高,直到寬度因子達(dá)到1.5倍。

之后,隨著稀疏度的進(jìn)一步增大,模型開(kāi)始變得高度稀疏,使得訓(xùn)練變得很困難,所以此時(shí)再增加寬度,就會(huì)開(kāi)始損害性能。

圖9:Sparsity-Width 的權(quán)衡

總結(jié)

本文發(fā)現(xiàn)持續(xù)地增加卷積核會(huì)帶來(lái)性能飽和,所以本文意在探索是否可以通過(guò)策略性地?cái)U(kuò)大卷積來(lái)消除性能差距。經(jīng)過(guò)不斷探索,本文作者從稀疏性的角度提出了一個(gè)應(yīng)用超大 Kernel 的方法,它可以平滑地將 Kernel 擴(kuò)展到 61×61,并具有更好的性能。因此作者將模型命名為稀疏大 Kernel 網(wǎng)絡(luò) (SLaK),一種配備 51×51 卷積核的純 CNN 架構(gòu)。主要的策略是把一個(gè)正方形的大 Kernel 分解成兩個(gè)矩形的、平行的不規(guī)則 Kernel,以及使用更多稀疏的 Group,同時(shí)提高模型的寬度。

審核編輯 :李倩

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4810瀏覽量

102909 -

卷積

+關(guān)注

關(guān)注

0文章

95瀏覽量

18709 -

cnn

+關(guān)注

關(guān)注

3文章

354瀏覽量

22653

原文標(biāo)題:ICLR 2023 | 卷積核大到51x51!SLaK:一種純CNN新主干

文章出處:【微信號(hào):CVer,微信公眾號(hào):CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

如何將范圍從萬(wàn)到FFFF擴(kuò)展到FRQQUPWM=44100

可以將ESP Basic擴(kuò)展到ESP32嗎?

用兩個(gè)條形信號(hào)驅(qū)動(dòng)器將10個(gè)單元擴(kuò)展到100個(gè)單元

C51核_MCU_原理圖庫(kù)

ADI公司如何從硬件擴(kuò)展到軟件和API以及集成收發(fā)器的功能

蘋(píng)果將iPhone 的保修范圍擴(kuò)展到全球

如何對(duì)51單片機(jī)進(jìn)行外部擴(kuò)展

如何使用稀疏卷積特征和相關(guān)濾波進(jìn)行實(shí)時(shí)視覺(jué)跟蹤算法

如何使用51單片機(jī)擴(kuò)展64K的RAM詳細(xì)資料免費(fèi)下載

蘋(píng)果可能正在尋求將蘋(píng)果地圖的范圍擴(kuò)展到其iDevices之外

AN-1529:使用AD9215高頻VGA將10位65 MSPS ADC的動(dòng)態(tài)范圍擴(kuò)展到100 dB以上

高斯濾波的卷積核怎么確定

通過(guò)應(yīng)用頻率將TPS92210的調(diào)光范圍擴(kuò)展到通用AC范圍

使用外部基準(zhǔn)電壓源將VOUT擴(kuò)展到1.2 V以下

SLaK:從稀疏性的角度將卷積核擴(kuò)展到51×51

SLaK:從稀疏性的角度將卷積核擴(kuò)展到51×51

評(píng)論