在利用 OpenAI 的 GPT-4 為 Bing Chat、 Bing Image Creator、Microsoft 365 Copilot、Azure OpenAI Service 和 GitHub Copilot X 引入了類似 ChatGPT 的功能后。微軟現(xiàn)又宣布推出 DeepSpeed-Chat,一種用于 RLHF 訓(xùn)練的低成本開源解決方案,基于微軟開源的深度學(xué)習(xí)優(yōu)化庫 DeepSpeed;聲稱即使是使用單個(gè) GPU,任何人也都可以創(chuàng)建高質(zhì)量的 ChatGPT 式模型。

該公司表示,盡管開源社區(qū)付出了巨大的努力,但目前仍缺乏一個(gè)支持端到端的基于人工反饋機(jī)制的強(qiáng)化學(xué)習(xí)(RLHF)的規(guī)模化系統(tǒng),這使得訓(xùn)練強(qiáng)大的類 ChatGPT 模型十分困難。ChatGPT 模型的訓(xùn)練是基于 InstructGPT 論文中的 RLHF 方式,與常見的大語言模型的預(yù)訓(xùn)練和微調(diào)截然不同,使得現(xiàn)有深度學(xué)習(xí)系統(tǒng)在訓(xùn)練類 ChatGPT 模型時(shí)存在種種局限。因此,為了讓 ChatGPT 類型的模型更容易被普通數(shù)據(jù)科學(xué)家和研究者使用,并使 RLHF 訓(xùn)練真正普及到 AI 社區(qū),他們發(fā)布了 DeepSpeed-Chat。

DeepSpeed-Chat 具有以下三大核心功能:

簡化 ChatGPT 類型模型的訓(xùn)練和強(qiáng)化推理體驗(yàn):只需一個(gè)腳本即可實(shí)現(xiàn)多個(gè)訓(xùn)練步驟,包括使用 Huggingface 預(yù)訓(xùn)練的模型、使用 DeepSpeed-RLHF 系統(tǒng)運(yùn)行 InstructGPT 訓(xùn)練的所有三個(gè)步驟、甚至生成你自己的類 ChatGPT 模型。此外,還提供了一個(gè)易于使用的推理 API,用于用戶在模型訓(xùn)練后測試對(duì)話式交互。

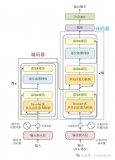

DeepSpeed-RLHF 模塊:DeepSpeed-RLHF 復(fù)刻了 InstructGPT 論文中的訓(xùn)練模式,并確保包括 a) 監(jiān)督微調(diào)(SFT),b) 獎(jiǎng)勵(lì)模型微調(diào)和 c) 基于人類反饋的強(qiáng)化學(xué)習(xí)(RLHF)在內(nèi)的三個(gè)步驟與其一一對(duì)應(yīng)。此外,還提供了數(shù)據(jù)抽象和混合功能,以支持用戶使用多個(gè)不同來源的數(shù)據(jù)源進(jìn)行訓(xùn)練。

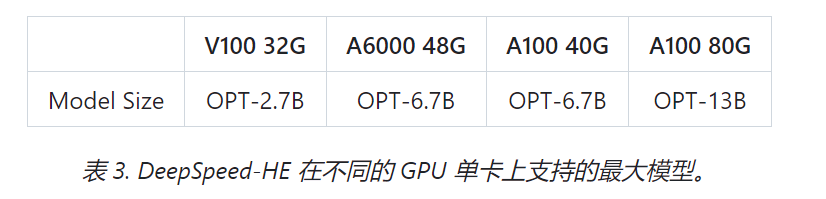

DeepSpeed-RLHF 系統(tǒng):其將 DeepSpeed 的訓(xùn)練(training engine)和推理能力(inference engine) 整合到一個(gè)統(tǒng)一的混合引擎(DeepSpeed Hybrid Engine or DeepSpeed-HE)中用于 RLHF 訓(xùn)練。DeepSpeed-HE 能夠在 RLHF 中無縫地在推理和訓(xùn)練模式之間切換,使其能夠利用來自 DeepSpeed-Inference 的各種優(yōu)化,如張量并行計(jì)算和高性能 CUDA 算子進(jìn)行語言生成,同時(shí)對(duì)訓(xùn)練部分還能從 ZeRO- 和 LoRA-based 內(nèi)存優(yōu)化策略中受益。DeepSpeed-HE 還能夠自動(dòng)在 RLHF 的不同階段進(jìn)行智能的內(nèi)存管理和數(shù)據(jù)緩存。

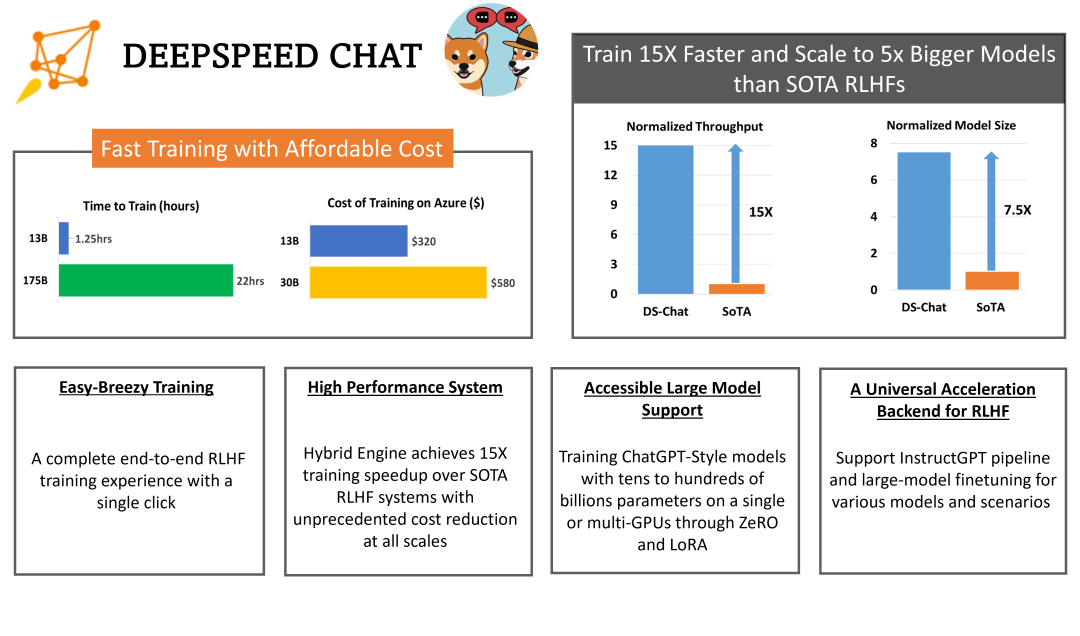

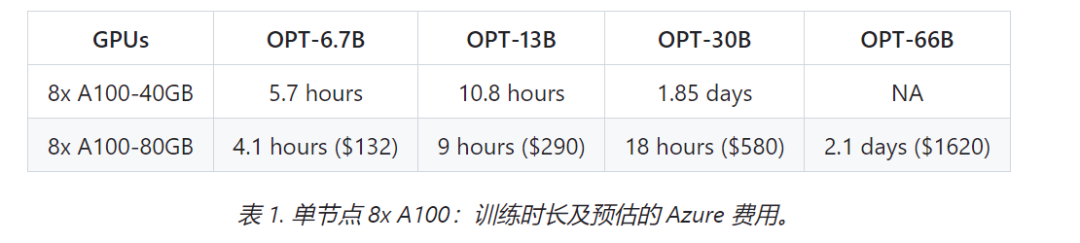

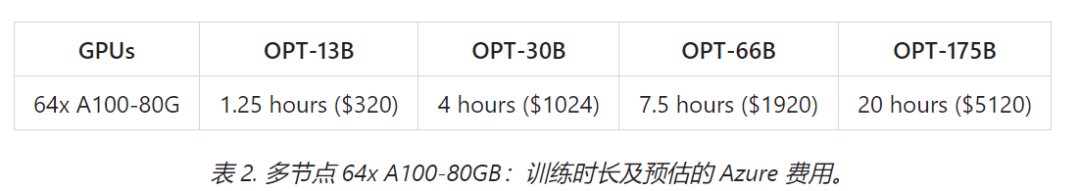

文檔內(nèi)容指出,DeepSpeed Chat 與其他先進(jìn)方案相比的優(yōu)勢在于:效率和經(jīng)濟(jì)性方面比現(xiàn)有系統(tǒng)快 15 倍以上,在 Azure 云上只需 9 小時(shí)即可訓(xùn)練一個(gè) OPT-13B 模型,只需 18 小時(shí)既可訓(xùn)練 OPT-30B 模型,分別花費(fèi)不到 300 美元和 600 美元。

在速度和可擴(kuò)展性方面,即使是 13B 的模型也可以在 1.25 小時(shí)內(nèi)訓(xùn)練,龐大的 175B 模型可以在不到一天的時(shí)間內(nèi)使用 64 個(gè) GPU 集群進(jìn)行訓(xùn)練。在 RLHF 的可訪問性和普及化方面,則可以在單個(gè) GPU 上訓(xùn)練超過 130 億參數(shù)的模型。此外還支持在相同的硬件上分別運(yùn)行 6.5B 和 50B 的模型,實(shí)現(xiàn)高達(dá) 7.5 倍的提升。

盡管近期關(guān)于對(duì) ChatGPT 類大語言模型發(fā)展的反對(duì)和擔(dān)憂之聲不斷,但微軟似乎仍在全力推進(jìn)其 AI 開發(fā)。對(duì)于微軟的此次發(fā)布,前 Meta AI 專家 Elvis 也激動(dòng)地表示,DeepSpeed Chat 提供了 Alpaca 和 Vicuna 等所缺少的、一個(gè)端到端的 RLHF 管道來訓(xùn)練類似 ChatGPT 的模型,解決的是成本和效率方面的挑戰(zhàn)。這是 “微軟令人印象深刻的開源努力。..。.. 是一件大事”。

審核編輯 :李倩

-

微軟

+關(guān)注

關(guān)注

4文章

6630瀏覽量

104469 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5515瀏覽量

121552 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1568瀏覽量

8061

原文標(biāo)題:微軟開源“傻瓜式”類ChatGPT模型訓(xùn)練工具,提速省錢15倍

文章出處:【微信號(hào):OSC開源社區(qū),微信公眾號(hào):OSC開源社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

【「大模型啟示錄」閱讀體驗(yàn)】+開啟智能時(shí)代的新鑰匙

微軟否認(rèn)使用用戶數(shù)據(jù)訓(xùn)練AI模型

什么是大模型、大模型是怎么訓(xùn)練出來的及大模型作用

ChatGPT:怎樣打造智能客服體驗(yàn)的重要工具?

llm模型和chatGPT的區(qū)別

名單公布!【書籍評(píng)測活動(dòng)NO.34】大語言模型應(yīng)用指南:以ChatGPT為起點(diǎn),從入門到精通的AI實(shí)踐教程

微軟將推出自研AI大模型

【大語言模型:原理與工程實(shí)踐】大語言模型的預(yù)訓(xùn)練

微軟自研AI大模型即將問世

NVIDIA加速微軟最新的Phi-3 Mini開源語言模型

探索ChatGPT模型的人工智能語言模型

微軟開源“傻瓜式”類ChatGPT模型訓(xùn)練工具

微軟開源“傻瓜式”類ChatGPT模型訓(xùn)練工具

評(píng)論