內(nèi)容簡介:ChatGPT的火爆出圈使得AI生成(AIGC)技術(shù)受到了全社會前所未有的廣泛關(guān)注。此消彼長之下,傳統(tǒng)的知識工程遭受了諸多質(zhì)疑。在多模態(tài)智能領(lǐng)域,AIGC的能力不斷提升,多模態(tài)知識工程工作應(yīng)該何去何從?是否仍有價值?在本次分享中,講者將探討當(dāng)前AIGC技術(shù)耀眼“光芒”背后的“暗面”,思考與展望AIGC時代的多模態(tài)知識工程研究。

關(guān)于AIGC時代的多模態(tài)知識工程思考與展望,我們將從以下六個方面展開介紹:

第一部分,我們回顧一下AIGC技術(shù)的發(fā)展歷程和它帶來的劃時代影響力;

第二部分,我們對AIGC技術(shù)的不足(阿克琉斯之踵)之處進(jìn)行分析與總結(jié);

第三部分,我們將介紹多模態(tài)認(rèn)知智能的框架和兩種實(shí)現(xiàn)路徑,并進(jìn)行對比分析;

第四~六部分,我們會展望當(dāng)前AIGC大模型和MMKG多模態(tài)圖譜間如何競與合。

01

AIGC時代:未來已來

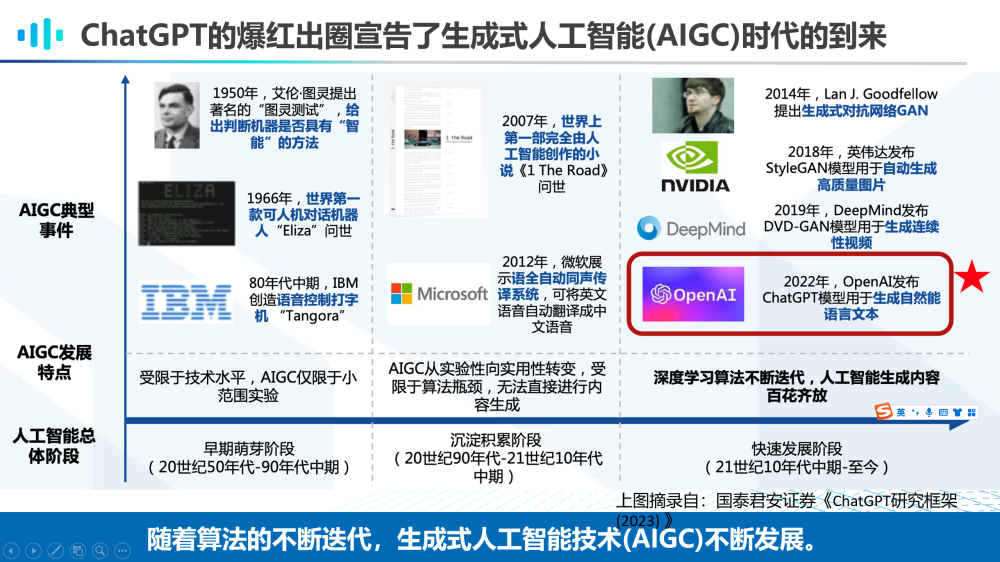

隨著人工智能總體階段的發(fā)展,生成式人工智能技術(shù)(AIGC)也在不斷迭代。從20世紀(jì)50年代到90年代中期,是AIGC的早期萌芽階段,這一時期受限于技術(shù)水平,AIGC僅限于小范圍實(shí)驗(yàn)。這一時期的AIGC典型事件包括:1950年,艾倫·圖靈提出的著名的“圖靈測試”,給出判斷機(jī)器是否具有“智能”的方法;1966年,世界上第一款可人機(jī)對話機(jī)器人“Eliza”的問世;以及在80年代中期IBM公司創(chuàng)造的語音控制打字機(jī)“Tangora”的出現(xiàn)。

而從20世紀(jì)90年代到21世紀(jì)10年代中期,AIGC處于沉淀積累階段,這一階段的AIGC技術(shù)從實(shí)驗(yàn)性向?qū)嵱眯赞D(zhuǎn)變,但仍因受限于算法瓶頸,無法直接進(jìn)行內(nèi)容生成。這一階段的AIGC典型事件則包括2007年世界上第一部完全由人工智能創(chuàng)作的小說《1 the road》的問世;以及2012年微軟開發(fā)的全自動同聲傳譯系統(tǒng)的出現(xiàn),它能夠?qū)⒂⑽恼Z音自動翻譯成中文語音。

自21世紀(jì)10年代中期至今,是AIGC快速發(fā)展的階段,得益于深度學(xué)習(xí)算法不斷迭代,人工智能生成內(nèi)容百花齊放。2014年,Goodfellow提出的生成對抗網(wǎng)絡(luò)GAN用于生成圖像;2019年,英偉達(dá)發(fā)布StyleGAN模型可以自動生成高質(zhì)量圖片;2019年DeepMind發(fā)布DVD-GAN用于生成連續(xù)性視頻,直到2022年,OpenAI發(fā)布ChatGPT模型生成流暢的自然語言文本。

可以說,ChatGPT的爆紅出圈宣告了AIGC時代的到來。

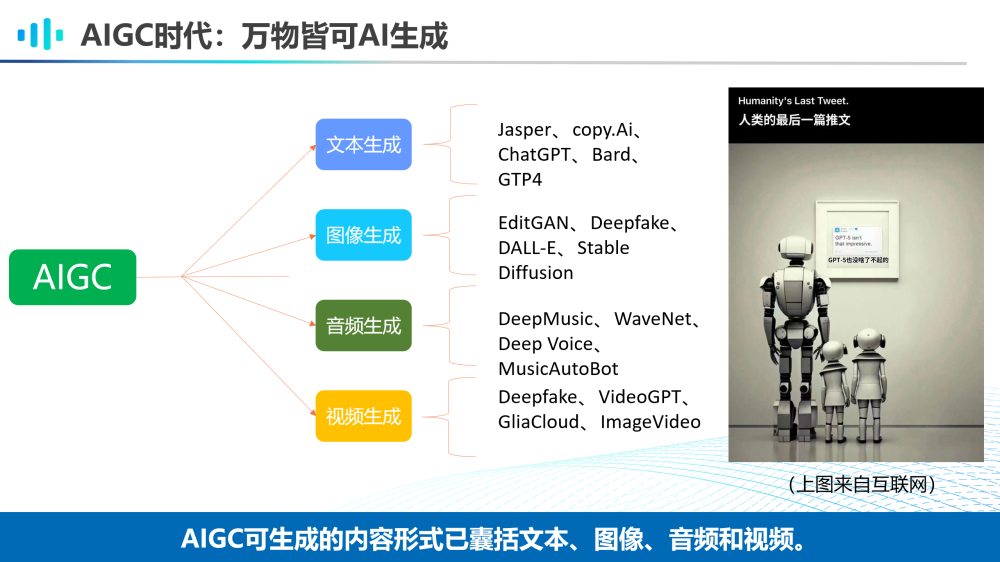

現(xiàn)在的AIGC技術(shù)可以生成的內(nèi)容包括文本、圖像、音頻和視頻等。如今,已經(jīng)有很多強(qiáng)大的算法被發(fā)明出來,如用于圖像生成的Stable Diffusion算法。此外,還有很多走在技術(shù)前沿的創(chuàng)業(yè)公司不斷推動AIGC技術(shù)的應(yīng)用落地,如Jasper AI的AI寫作軟件和midjourney的AI繪畫工具的發(fā)明都在解放著人類的內(nèi)容創(chuàng)作生產(chǎn)力。這些共同促進(jìn)了一個萬物皆可AI生成的AIGC時代。

右圖是一張來自互聯(lián)網(wǎng)的趣味圖片——機(jī)器人一家三口在人類博物館中觀賞人類的最后一篇推文“GPT-5也沒啥了不起的”——表達(dá)了創(chuàng)作者對當(dāng)今AIGC技術(shù)飛速發(fā)展的隱隱擔(dān)憂。

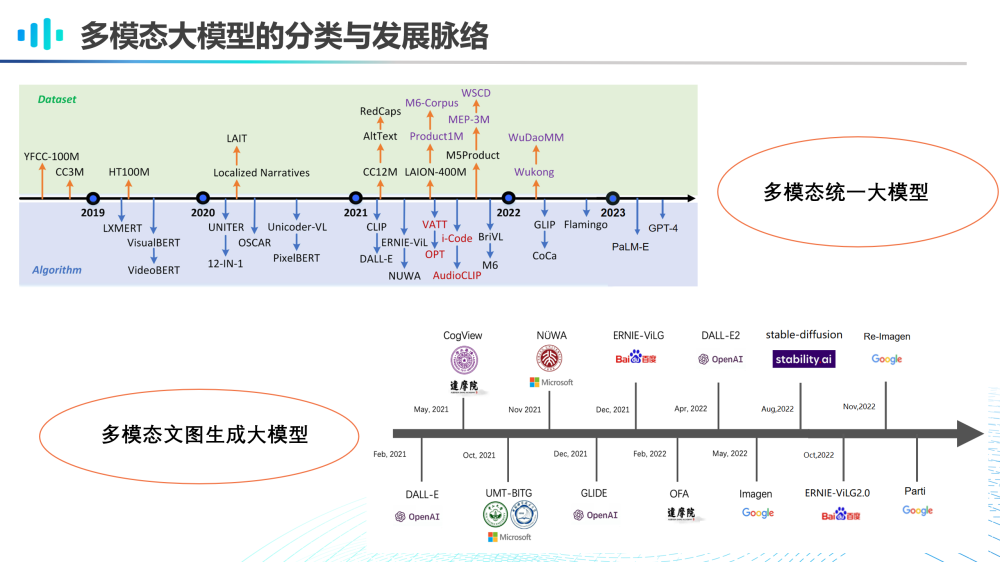

那么,我們首先看一下多模態(tài)大模型的分類與發(fā)展脈絡(luò)。如上圖所示,多模態(tài)大模型發(fā)展非常迅速,我們可以將多模態(tài)大模型簡單分為多模態(tài)統(tǒng)一大模型和多模態(tài)文圖生成大模型,前者用于統(tǒng)一的多模態(tài)生成和理解,后者特指具備強(qiáng)大的多模態(tài)文到圖生成能力的大模型。

當(dāng)前,文圖生成大模型已經(jīng)可以生成逼真、高清以及風(fēng)格化的意境圖像。

還有一些文圖生成大模型,如斯坦福大學(xué)提出的ControlNet,其生成能力更加精致、可控。它不僅可以生成各類質(zhì)地細(xì)膩、細(xì)節(jié)精致的圖片,也可以通過簡筆畫來對圖像生成進(jìn)行操控。

AIGC大模型生成的視頻在某種程度上也可謂自然流暢、栩栩如生。

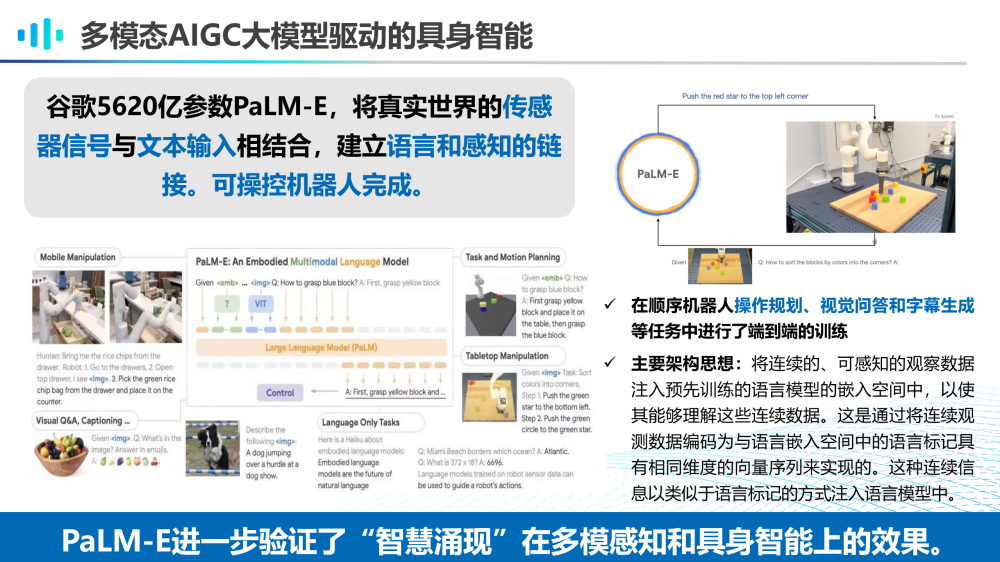

我們還看到Google發(fā)布的PaLM-E模型,展現(xiàn)了多模態(tài)AIGC大模型驅(qū)動的具身智能的情景。這個具備5620億參數(shù)的具身多模態(tài)大模型,可以將真實(shí)世界的傳感器信號與文本輸入相結(jié)合,建立語言和感知的鏈接,可以用自然語言操控機(jī)器人完成操作規(guī)劃、視覺問答等任務(wù)。

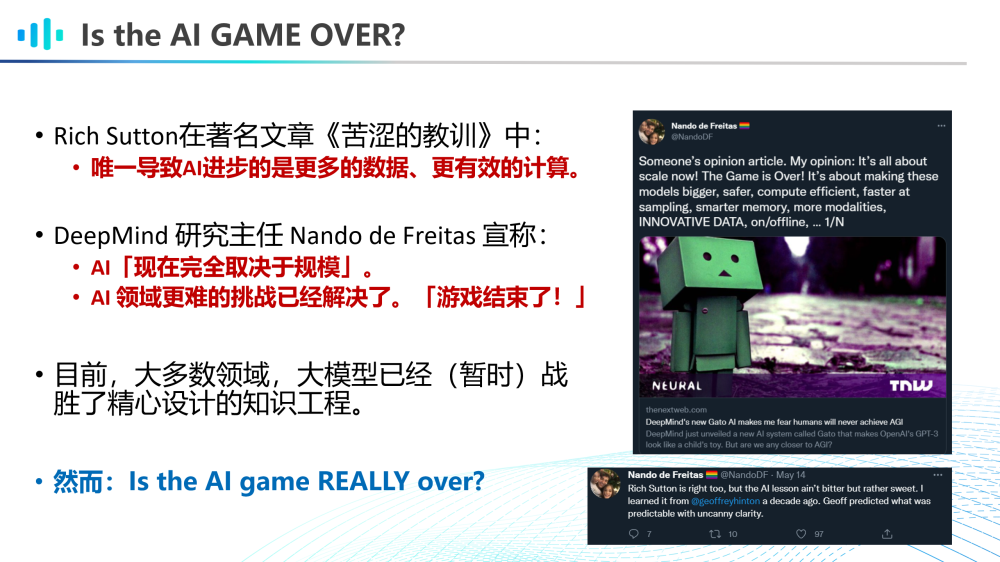

AIGC的驚艷效果不禁讓很多人對符號主義(知識工程)的研究產(chǎn)生了疑問。Rich Sutton在著名文章《苦澀的教訓(xùn)》中提出,唯一導(dǎo)致AI進(jìn)步的因素是更多的數(shù)據(jù)和更有效的計(jì)算。而DeepMind的研究主任Nando de Freitas也宣稱,“AI現(xiàn)在完全取決于規(guī)模,AI領(lǐng)域更難的挑戰(zhàn)已經(jīng)解決了,游戲結(jié)束了!”。我們也看到,在大多數(shù)領(lǐng)域,大模型已經(jīng)(暫時)戰(zhàn)勝了精心設(shè)計(jì)的知識工程。然而,AI的流派之爭真的結(jié)束了嗎?

02

AIGC的阿克琉斯之踵

第二部分,讓我們來看一下當(dāng)前AIGC大模型實(shí)際存在的一些問題。

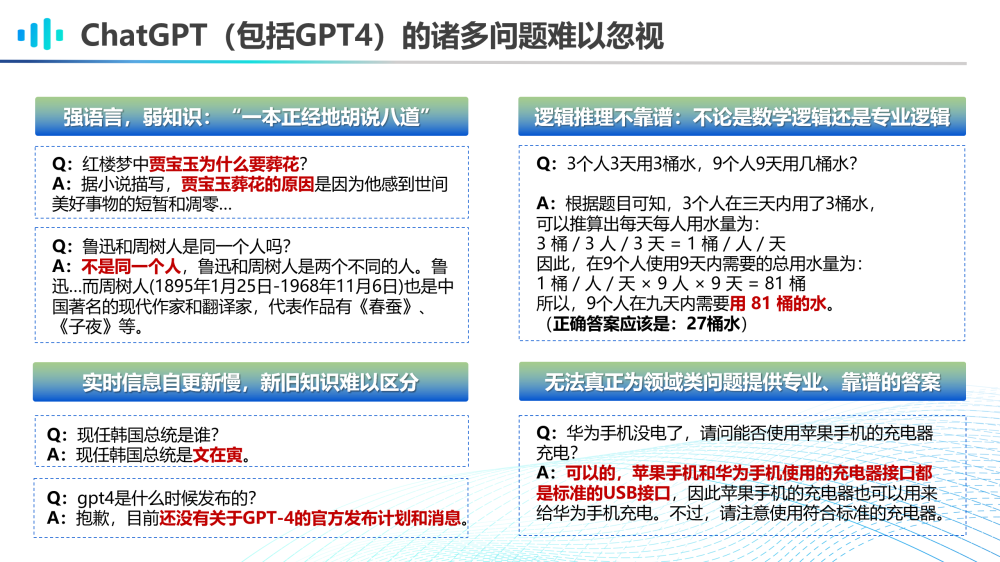

盡管今天的ChatGPT(包括GPT-4)很強(qiáng)大,它的諸多問題仍舊難以忽視:

第一、強(qiáng)語言弱知識的問題,ChatGPT無法理解用戶查詢中的知識性錯誤,它具備強(qiáng)大的語言能力,但知識能力仍舊較弱;

第二、實(shí)時信息自更新慢,新舊知識難以區(qū)分,目前ChatGPT的知識還停留在2021年,而每一次信息更新都需要成本高昂的重新訓(xùn)練;

第三、其邏輯推理能力并不可靠,應(yīng)該說尚不具備復(fù)雜數(shù)學(xué)邏輯推理與專業(yè)邏輯推理能力;

第四、由于缺乏領(lǐng)域知識,它也無法真正為領(lǐng)域類問題提供專業(yè)靠譜的答案。

當(dāng)前的多模態(tài)大模型的跨模態(tài)生成能力也尚不完善。上圖是我們用文圖生成大模型Stable Diffusion生成的一些案例。具體來說,當(dāng)前的文圖生成存在組合泛化、屬性泄露、方位理解混亂、語義理解錯誤等問題。因此,盡管我們看到AIGC跨模態(tài)生成的視覺效果驚艷,但往往存在較大的模態(tài)間信息不對稱問題。

此外,當(dāng)前多模態(tài)大模型的多模態(tài)理解能力也存在問題。上圖是來自BLIP2進(jìn)行視覺問答任務(wù)的錯誤樣例。我們看到:

1)模型由于缺乏事實(shí)知識,無法知曉球拍上的“w”圖案是品牌“Wilson”的logo,因而錯誤回答成“nike”;

2)模型由于欠缺邏輯推理能力,不理解圖像場景和問題的邏輯關(guān)系,因而回答錯誤;

3)模型由于常識儲備不足,對某個具體場景(沖浪)下的意圖理解犯了常識性錯誤。

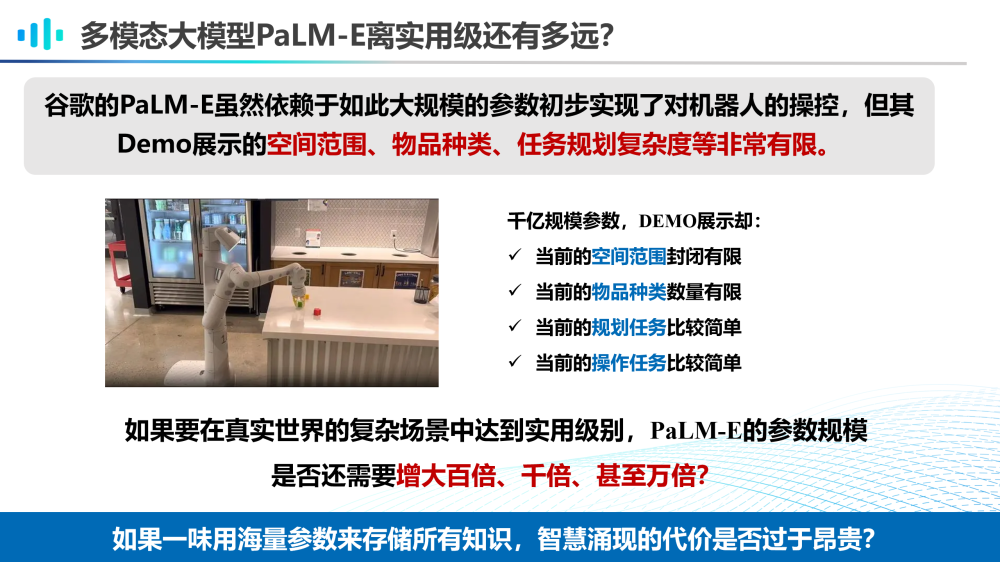

讓我們再來看一下Google的具身多模態(tài)大模型PaLM-E,雖然依賴如此大規(guī)模的參數(shù)實(shí)現(xiàn)了初步的機(jī)器人操控,但其demo視頻中所展示的空間范圍、物品種類、規(guī)劃和操作任務(wù)的復(fù)雜度等都非常有限。我們可以想象,如果要在真實(shí)世界的復(fù)雜場景中達(dá)到實(shí)用級別,PaLM-E的參數(shù)規(guī)模是否還需要增大百倍、千倍甚至萬倍?如果一味用海量參數(shù)存儲所有知識,那么智慧涌現(xiàn)的代價是否過于昂貴?

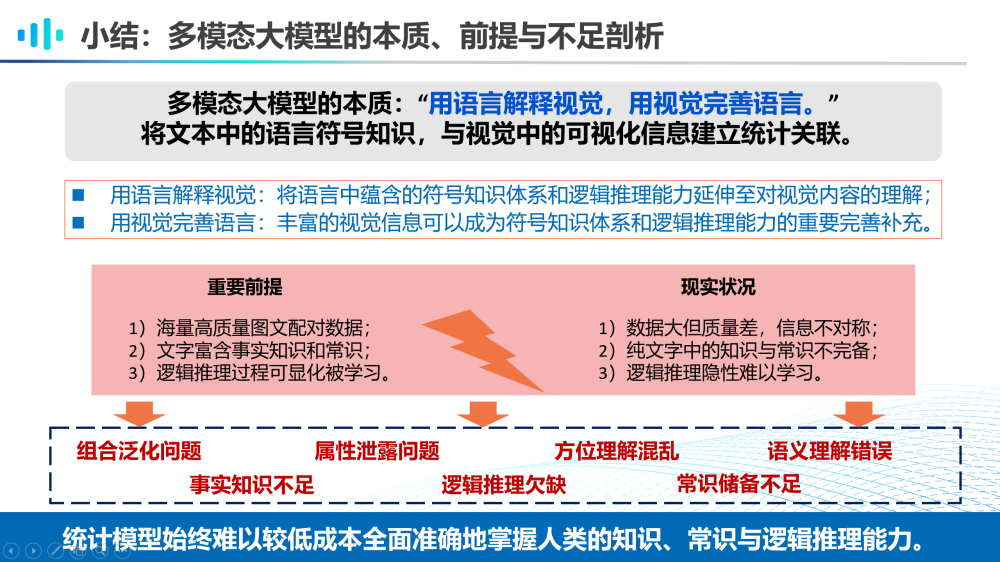

至此,我們對多模態(tài)大模型做個簡單的小結(jié)。首先,多模態(tài)大模型的本質(zhì)是“用語言解釋視覺,用視覺完善語言”。換句話說,我們要將文本中的語言符號知識,與視覺中的可視化信息建立統(tǒng)計(jì)關(guān)聯(lián)。所謂“用語言解釋視覺”,就是將語言中蘊(yùn)含的符號知識體系和邏輯推理能力延伸至對視覺內(nèi)容的理解;而所謂“用視覺完善語言”,是指豐富的視覺信息可以成為符號知識體系和邏輯推理能力的重要完善和補(bǔ)充。

我們知道,多模態(tài)大模型能發(fā)揮重大作用的重要前提是:

1)具有海量高質(zhì)量圖文配對數(shù)據(jù);

2)文字富含事實(shí)知識和常識;

3)其邏輯推理過程可顯式化被學(xué)習(xí)。

而我們所面臨的現(xiàn)實(shí)情況卻是:

1)數(shù)據(jù)量大但質(zhì)量差,信息不對稱;

2)純文字中的知識與常識也不完備;

3)其邏輯推理是隱性難以學(xué)習(xí)的。

正因?yàn)檫@些理想與現(xiàn)實(shí)間的差距,導(dǎo)致了前面提到的多模態(tài)大模型的種種問題與不足。綜上,我們認(rèn)為,統(tǒng)計(jì)大模型始終難以較低成本,全面、準(zhǔn)確地掌握人類知識、常識和邏輯推理能力。

03

多模態(tài)認(rèn)知智能

第三部分,我們引出多模態(tài)認(rèn)知智能,其研究旨在解決前一部分提到的問題。

上圖是我們提出的一個多模態(tài)認(rèn)知智能的研究框架。總的來說,多模態(tài)認(rèn)知智能主要研究基于多模態(tài)數(shù)據(jù)的知識獲取、表示、推理與應(yīng)用。在多模態(tài)知識獲取層面,我們從語料中通過抽取、生成、群智等方法獲取知識或者從語言模型中萃取知識。在多模態(tài)知識表示層面,可以使用多模態(tài)圖譜、常識圖譜、語言模型、大規(guī)模知識網(wǎng)絡(luò)等方法進(jìn)行知識表示。基于多模態(tài)知識表示,可以進(jìn)一步支撐多模態(tài)理解、推理和元認(rèn)知等能力,從而賦能諸如跨模態(tài)搜索、推薦、問答、生成等多模態(tài)知識的應(yīng)用。

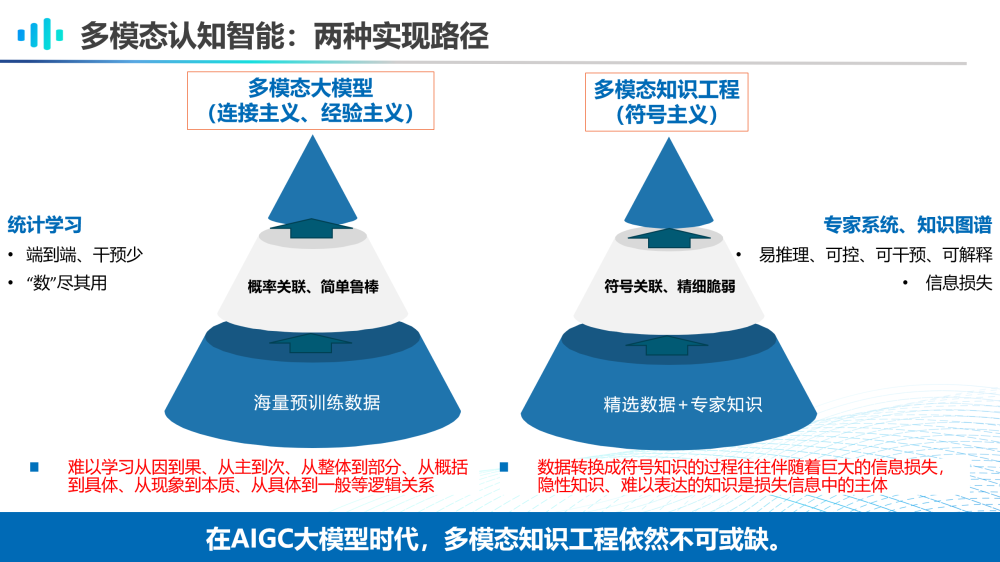

多模態(tài)認(rèn)知智能目前有兩種實(shí)現(xiàn)路徑。一種是多模態(tài)大模型,其代表了聯(lián)結(jié)主義和經(jīng)驗(yàn)主義的思想,從海量預(yù)訓(xùn)練數(shù)據(jù)中學(xué)習(xí)概率關(guān)聯(lián),是簡單而魯棒的,它屬于統(tǒng)計(jì)學(xué)習(xí)范疇,具備端到端、干預(yù)少和“數(shù)”盡其用的優(yōu)勢,其劣勢在于難以學(xué)習(xí)到從因到果、從主到次、從整體到部分、從概括到具體、從現(xiàn)象到本質(zhì)、從具體到一般等邏輯關(guān)系。

另一種實(shí)現(xiàn)路徑是多模態(tài)知識工程,其代表了符號主義的思想,從精選數(shù)據(jù)和專家知識中學(xué)習(xí)符號關(guān)聯(lián),是精細(xì)而脆弱的,它往往通過專家系統(tǒng)和知識圖譜實(shí)現(xiàn),具備易推理、可控、可干預(yù)、可解釋的優(yōu)點(diǎn),但是它的劣勢主要在于將數(shù)據(jù)轉(zhuǎn)換成符號知識的過程往往伴隨著巨大的信息損失,而其中隱性知識等難以表達(dá)的知識往往是信息損失的主體。

結(jié)合多模態(tài)大模型和多模態(tài)知識工程的優(yōu)劣勢分析,我們認(rèn)為:在AIGC大模型時代,多模態(tài)知識工程依然不可或缺。

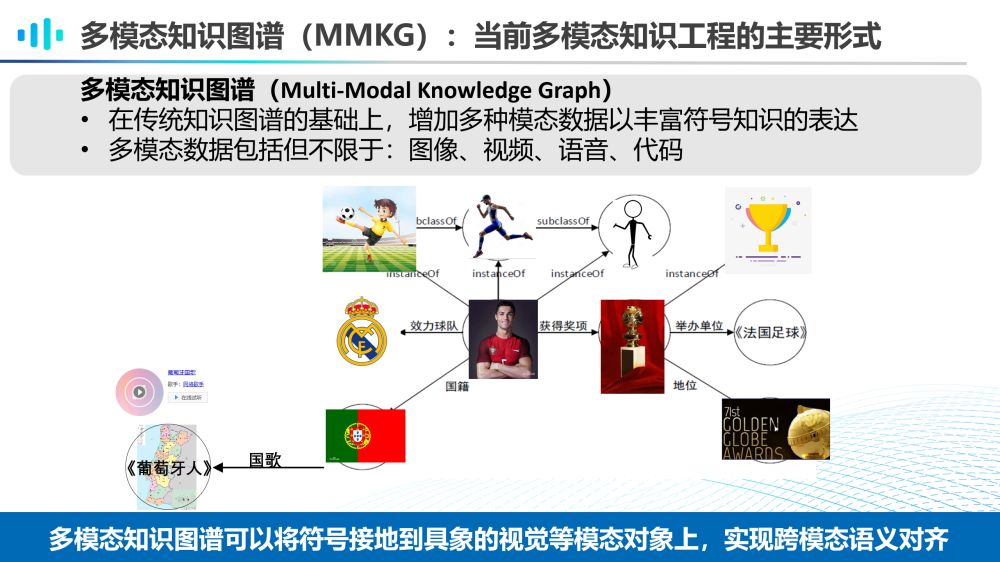

當(dāng)前,多模態(tài)知識工程的主要形式之一是多模態(tài)知識圖譜(MMKG)。多模態(tài)知識圖譜是在傳統(tǒng)知識圖譜的基礎(chǔ)上,增加多種模態(tài)數(shù)據(jù)以豐富符號知識表達(dá)的方法,其多模態(tài)數(shù)據(jù)包括但不限于圖像、視頻、語言、代碼等。多模態(tài)知識圖譜可以將符號接地到具象的視覺等模態(tài)對象上,實(shí)現(xiàn)跨模態(tài)語義對齊。

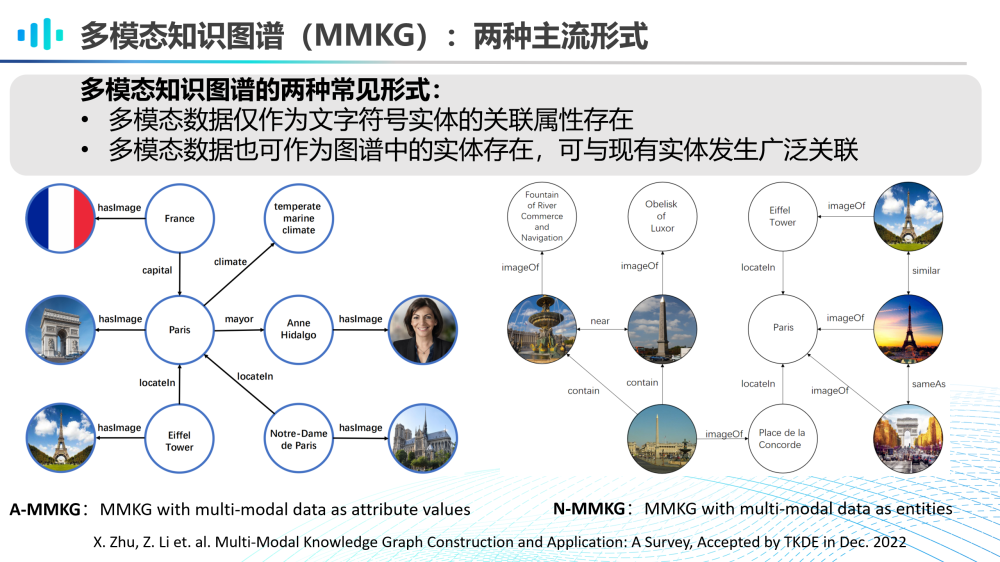

目前多模知識圖譜的主流形式有兩種。

一種是A-MMKG,其中多模態(tài)數(shù)據(jù)僅作為文字符號實(shí)體的關(guān)聯(lián)屬性存在;

另一種是N-MMKG,其中多模態(tài)數(shù)據(jù)也可作為圖譜中的實(shí)體存在,可與現(xiàn)有實(shí)體發(fā)生廣泛關(guān)聯(lián)。

至此,我們進(jìn)一步分析AIGC多模態(tài)大模型和大規(guī)模多模態(tài)知識圖譜各自的優(yōu)缺點(diǎn)。

多模態(tài)大模型的優(yōu)點(diǎn)是:

1)關(guān)聯(lián)推理能力強(qiáng):可以學(xué)習(xí)掌握大量跨模態(tài)知識模式,隱空間的關(guān)聯(lián)推理能力強(qiáng),具有很強(qiáng)的泛化能力;

2)多任務(wù)通吃:一套大模型處理各類跨模態(tài)任務(wù);

3)人工成本低:不依賴人工schema設(shè)計(jì)與數(shù)據(jù)標(biāo)注;

4)適配能力強(qiáng):可通過調(diào)優(yōu)訓(xùn)練或prompt對話等方式來適配新的領(lǐng)域和任務(wù)。

而其不足之處在于:

1)可靠程度低:所生成的內(nèi)容可靠性堪憂,存在誤差累積、隱私泄露等問題,無法勝任高精度嚴(yán)肅場景需求;

2)知識推理弱:沒有真正掌握數(shù)據(jù)背后的知識,缺乏知識推理能力,更無因果推理能力;

3)可解釋性弱:雖有CoT加持,但可解釋性仍然不足;

4)訓(xùn)練成本高:需要消耗大量計(jì)算資源和時間來進(jìn)行訓(xùn)練,需要強(qiáng)大的計(jì)算設(shè)備和高效的算法。

而與之對應(yīng)的,多模態(tài)知識圖譜的優(yōu)點(diǎn)是:

1)專業(yè)可信度高:其結(jié)構(gòu)和關(guān)系清晰,易于理解和解釋,可為人類決策提供參考,通常為某個具體應(yīng)用場景構(gòu)建,可提供更精準(zhǔn)和針對性的知識支持;

2)可解釋性好:以結(jié)構(gòu)化形式表示知識 ,知識的可訪問性、可重用性、可解釋性好,對人類友好;

3)可擴(kuò)展性強(qiáng):知識圖譜的內(nèi)容可以隨著應(yīng)用場景的需要進(jìn)行不斷擴(kuò)展和更新,可以不斷完善和改進(jìn)。

而多模態(tài)知識圖譜的缺點(diǎn)在于:

1)推理能力弱:只能表示已有的知識和關(guān)系,對于未知或不確定的領(lǐng)域難以進(jìn)行有效的知識建模和推理;

2)人工成本高:其構(gòu)建需要依賴于人工或半自動的方式進(jìn)行知識抽取和建模,難以實(shí)現(xiàn)完全自動化;

3)架構(gòu)調(diào)整難:其基本schema架構(gòu)通常是靜態(tài)的,不易根據(jù)新的數(shù)據(jù)或場景進(jìn)行修改和調(diào)整。

由上分析可見:多模態(tài)大模型的優(yōu)點(diǎn)常常是多模態(tài)知識圖譜的不足,而多模態(tài)大模型的不足又往往是多模態(tài)知識圖譜的優(yōu)勢。因此,我們認(rèn)為:當(dāng)前階段,大模型與知識圖譜仍應(yīng)繼續(xù)保持競合關(guān)系,互相幫助,互為補(bǔ)充。

04

AIGC for MMKG

第四部分,我們思考與展望一下AIGC大模型如何輔助MMKG的構(gòu)建與應(yīng)用。

第一,AIGC大模型為知識獲取降本增效。

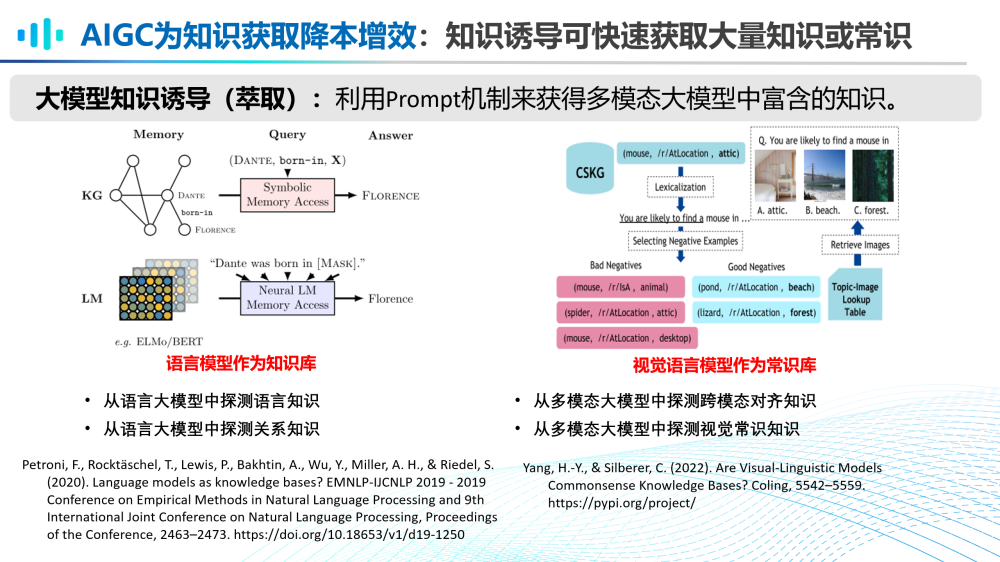

(1)通過知識誘導(dǎo)(萃取),可以快速獲取大量知識或常識。例如,我們可以從語言大模型中誘導(dǎo)語言知識和關(guān)系知識;我們也可以從多模態(tài)大模型中誘導(dǎo)跨模態(tài)對齊知識和視覺常識知識。

(2)AIGC大模型的出現(xiàn)使得零樣本、少樣本、開放知識抽取成為可能。例如,我們可以利用ChatGPT對話大模型的理解和生成能力,從給定文本中抽取三元組知識;我們也可以利用多模態(tài)AIGC大模型的跨模態(tài)生成和理解能力,從給定圖文數(shù)據(jù)中抽取多模態(tài)知識。

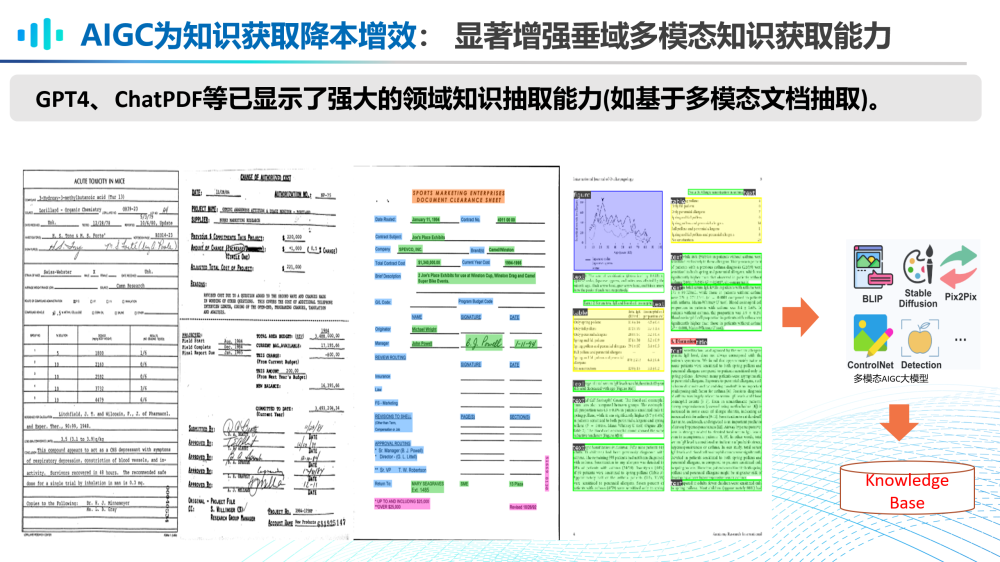

(3)AIGC大模型可以顯著增強(qiáng)垂域多模態(tài)知識獲取能力。GPT-4、ChatPDF模型等已經(jīng)顯示了強(qiáng)大的領(lǐng)域知識抽取能力,如基于多模態(tài)文檔的知識抽取。

第二,AIGC大模型助圖譜設(shè)計(jì)一臂之力。

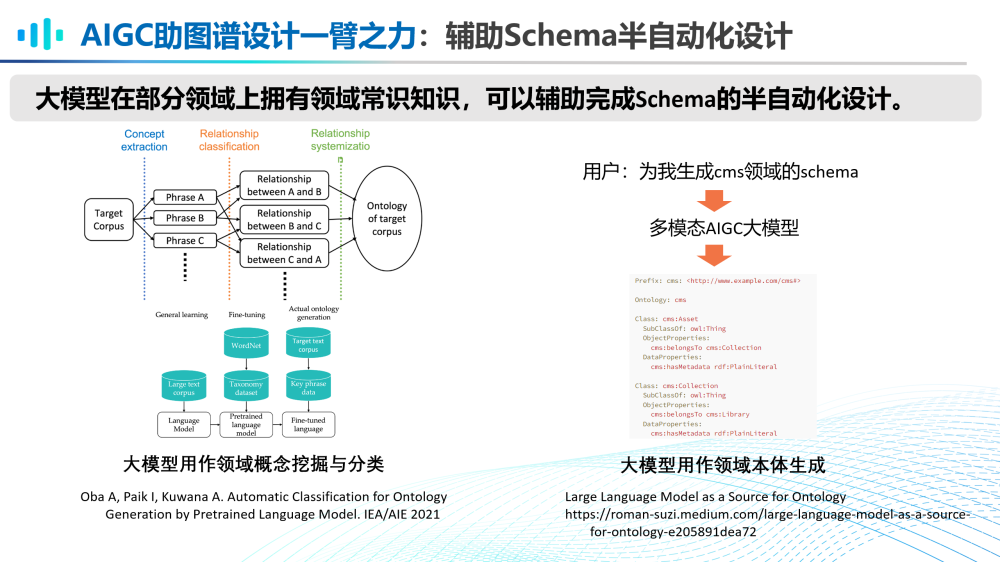

大模型在部分領(lǐng)域上擁有領(lǐng)域常識知識,可以輔助完成schema的半自動化設(shè)計(jì)。在多模態(tài)場景中,也有一些嘗試,例如可以用多模態(tài)AIGC大模型生成cms領(lǐng)域的schema。

第三,AIGC大模型為知識推理保駕護(hù)航。

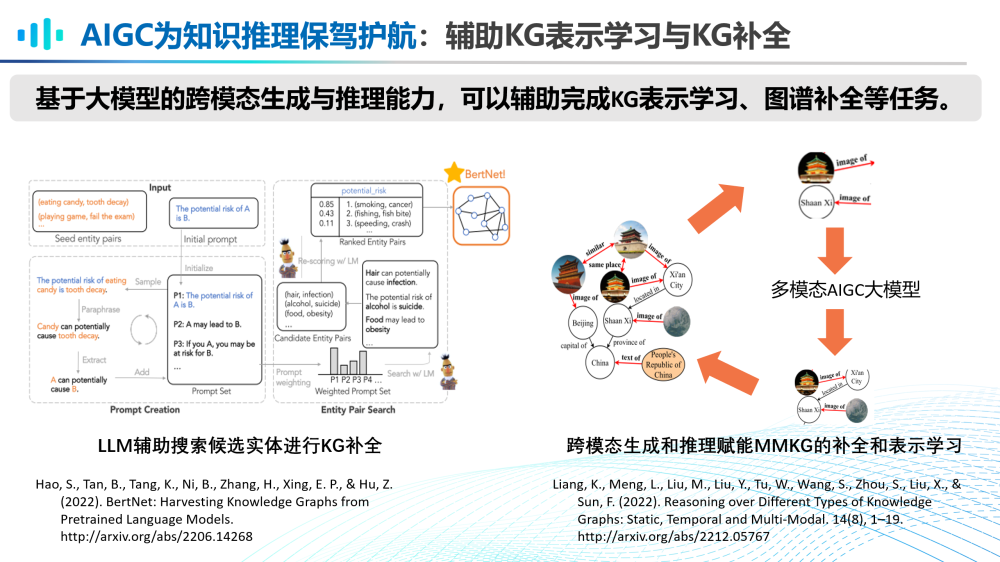

基于大模型的跨模態(tài)生成與推理能力,可以輔助完成KG表示學(xué)習(xí)、圖譜補(bǔ)全等任務(wù)。

第四,AIGC大模型為知識融合掃清障礙。

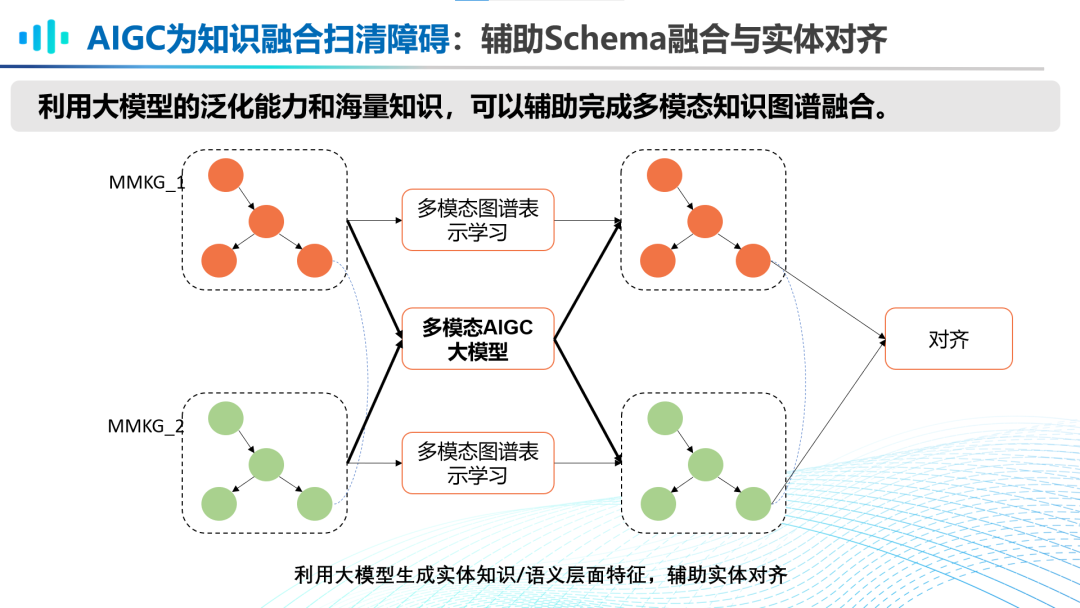

利用大模型的泛化能力和海量知識,可以輔助完成多模態(tài)知識圖譜融合。利于對于兩個MMKG的對齊,多模態(tài)AIGC大模型在兩者之間可以生成實(shí)體知識或語義層面的特征,輔助完成實(shí)體對齊。

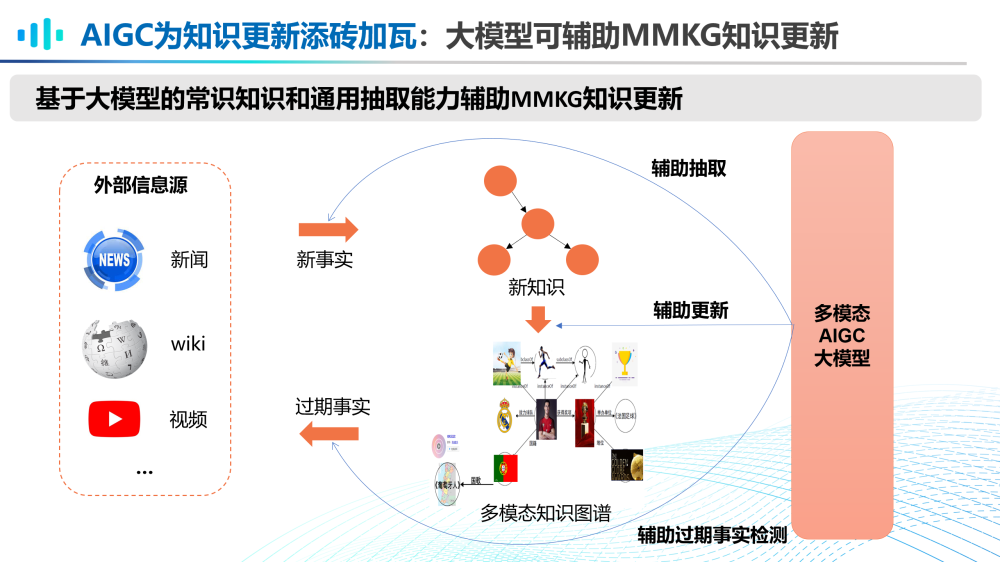

第五,AIGC大模型為知識更新舔磚加瓦。

基于大模型的常識知識和通用抽取能力可以輔助MMKG進(jìn)行知識更新。可以利用多模態(tài)AIGC大模型從新事實(shí)中輔助抽取新知識;當(dāng)新知識抽取完成后,可以借助多模態(tài)AIGC大模型輔助更新多模態(tài)知識圖譜。此外,還可以借助多模態(tài)AIGC大模型輔助過期事實(shí)檢測,從而將過期知識從知識圖譜中刪除。

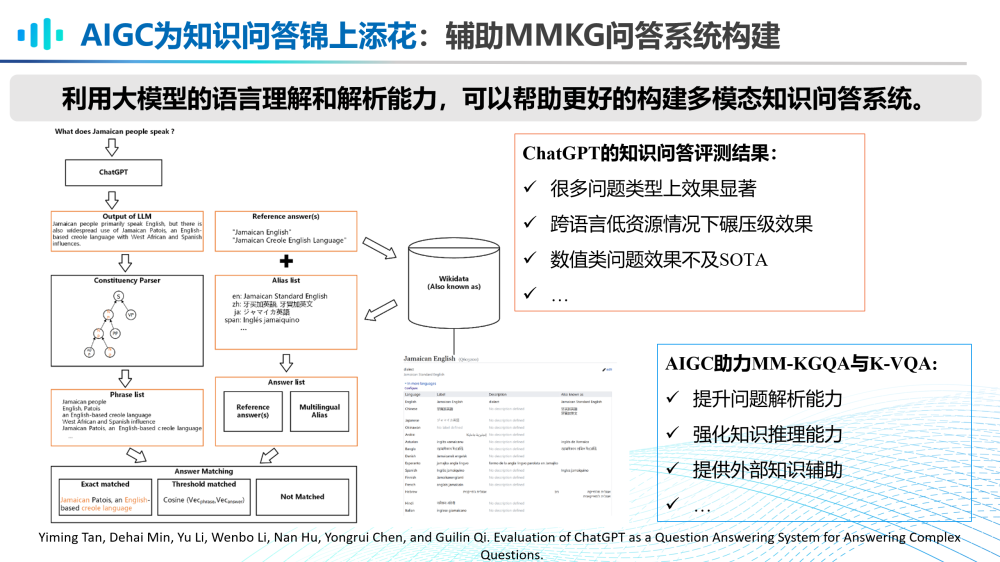

第六,AIGC大模型為知識問答錦上添花。

利用大模型的語言理解能力和解析能力,可以幫助更好的構(gòu)建多模態(tài)知識問答系統(tǒng)。在ChatGPT的知識問答評測結(jié)果顯示其在很多問題類型上效果顯著,且跨語言低資源情況下具有碾壓級效果,但是其數(shù)值類問題效果不及SOTA。因此,使用AIGC大模型助力MM-KGQA和K-VQA等任務(wù),可以提升問題解析能力,強(qiáng)化知識推理能力,提供外部知識輔助等。

05

MMKG for AIGC

第五部分,我們總結(jié)與展望一下MMKG如何助力AIGC大模型的提升與完善。

第一,MMKG參與AIGC大模型的生成能力評估。

基于多模態(tài)知識圖譜中的知識構(gòu)建測試集,可對大模型的生成能力進(jìn)行各方面評估。例如利用各類百科知識圖譜進(jìn)行事實(shí)性檢驗(yàn)評估,也可以利用各類MMKG構(gòu)建測試集進(jìn)行符號推理能力評估、視覺常識推理能力評估、非語言推理能力評估等。

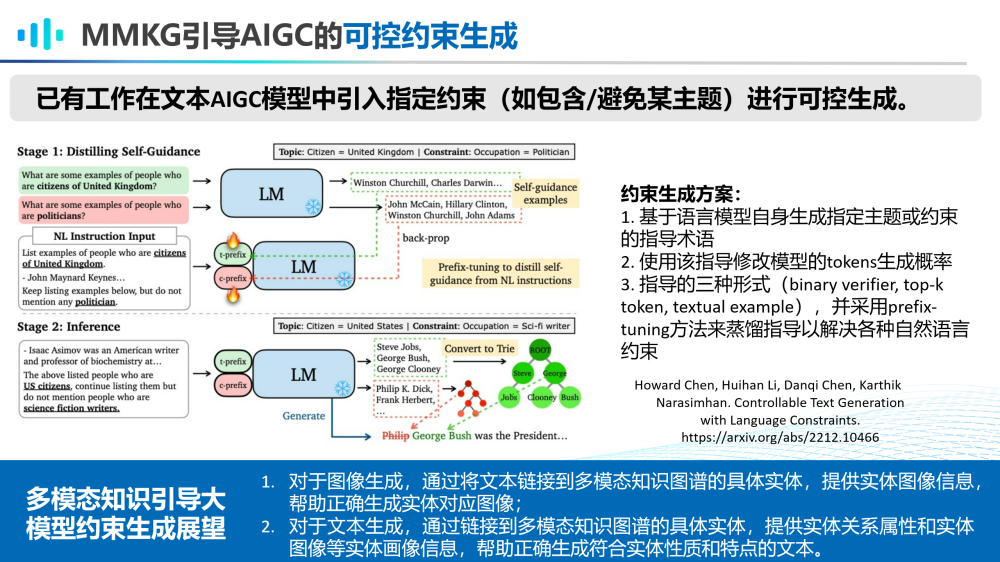

第二,MMKG引導(dǎo)AIGC大模型的可控約束生成。

已有工作在文本AIGC模型中引入指定約束(如包含/避免某主題)進(jìn)行可控生成。可以展望未來會出現(xiàn)多模態(tài)知識引導(dǎo)大模型約束生成的工作。比如對于圖像生成,可通過將文本鏈接到多模態(tài)知識圖譜的具體實(shí)體,提供實(shí)體圖像信息,幫助正確生成實(shí)體對應(yīng)圖像;對于文本生成,通過鏈接到多模態(tài)知識圖譜的具體實(shí)體,提供實(shí)體關(guān)系屬性和實(shí)體圖像等實(shí)體畫像信息,幫助正確生成符合實(shí)體性質(zhì)和特點(diǎn)的文本。

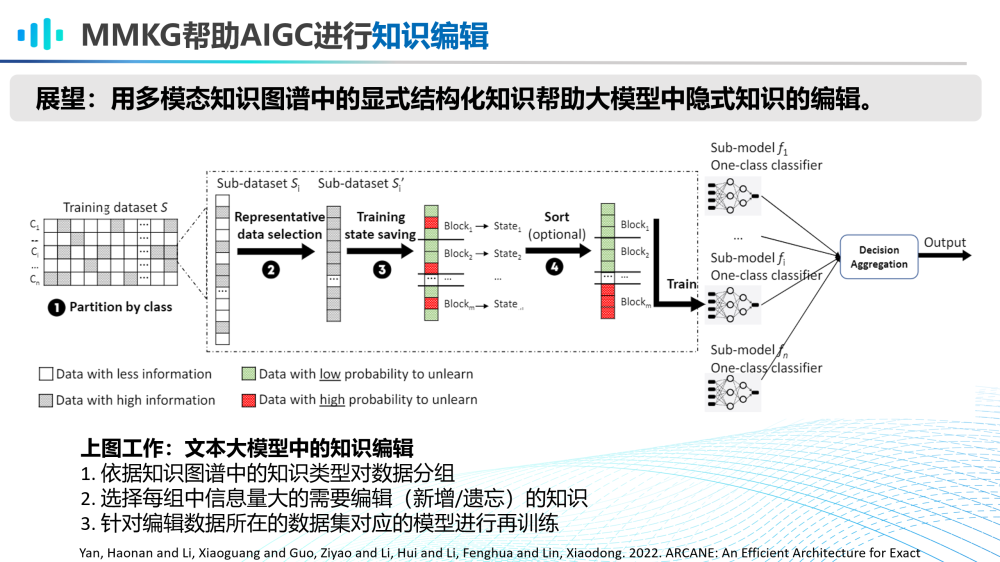

第三,MMKG幫助AIGC大模型進(jìn)行知識編輯。

目前已有在文本大模型上的知識編輯的相關(guān)工作。可以預(yù)見,未來也會出現(xiàn)利用多模態(tài)知識圖譜來對多模態(tài)大模型進(jìn)行知識編輯的研究工作。

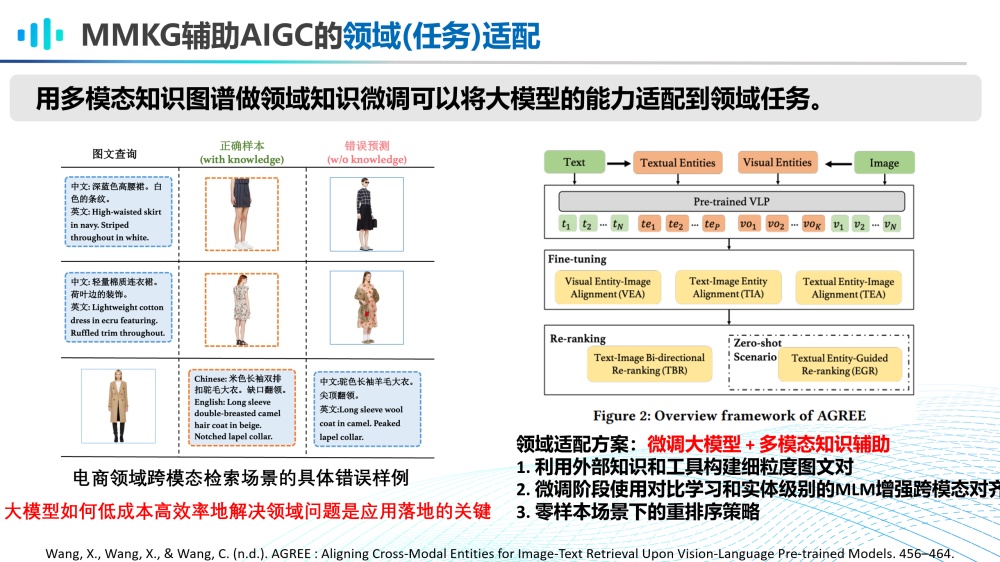

第四,MMKG輔助AIGC大模型的領(lǐng)域(任務(wù))適配。

用多模態(tài)知識圖譜做領(lǐng)域知識微調(diào)可以將大模型的能力適配到領(lǐng)域任務(wù)。例如,在電商領(lǐng)域跨模態(tài)檢索場景,常常存在語義不匹配的問題。這種情況下,大模型如何低成本、高效率地解決該領(lǐng)域的具體問題是其應(yīng)用落地的關(guān)鍵。我們與阿里合作的這篇工作提出了通過微調(diào)大模型,加上多模態(tài)知識輔助的方式,實(shí)現(xiàn)了大模型的輕量級領(lǐng)域適配。

06

AIGC+MMKG

第六部分,我們展望一下AIGC大模型和MMKG如何進(jìn)一步合作。

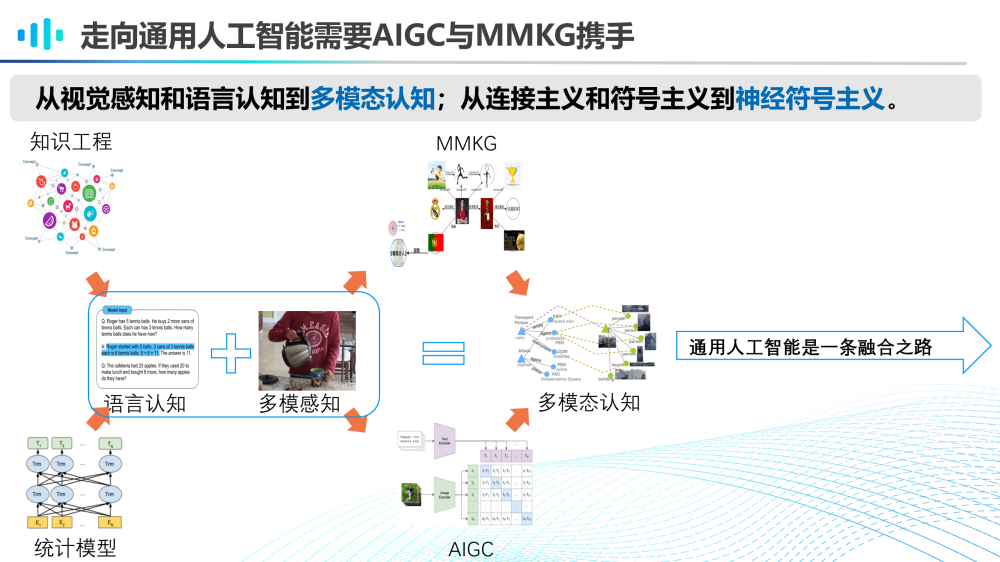

我們認(rèn)為,走向通用人工智能需要AIGC大模型和MMKG攜手并進(jìn)。在未來,基于知識工程和統(tǒng)計(jì)模型的語言認(rèn)知和多模態(tài)感知將會相互結(jié)合,并且借助MMKG和AIGC大模型,共同走向多模態(tài)認(rèn)知的發(fā)展道路上。從視覺感知和語言認(rèn)知到多模態(tài)認(rèn)知,從連接主義和符號主義到神經(jīng)符號主義,通用人工智能必將是一條融合之路。

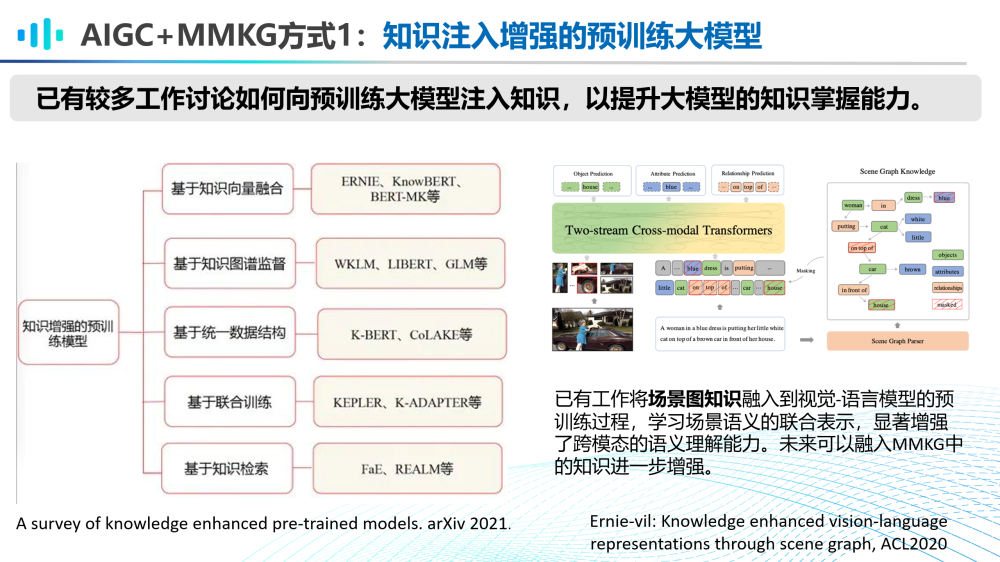

AIGC和MMKG的第一種融合方式是注入知識以增強(qiáng)預(yù)訓(xùn)練大模型。目前知識增強(qiáng)的預(yù)訓(xùn)練語言模型已有多種路徑實(shí)現(xiàn)。在多模態(tài)知識增強(qiáng)預(yù)訓(xùn)練的方向上,也有工作將場景圖知識融入視覺語言預(yù)訓(xùn)練模型的預(yù)訓(xùn)練過程中以增強(qiáng)跨模態(tài)語言理解能力。未來還有很多方式方法來將MMKG中的知識以更多方式融入到大模型當(dāng)中。

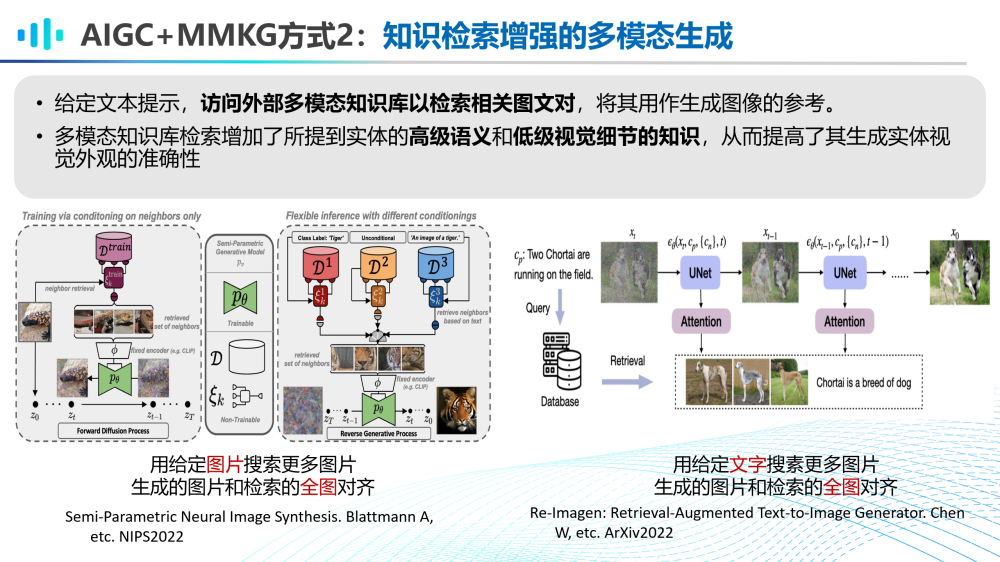

AIGC和MMKG的第二種融合方式是基于知識檢索增強(qiáng)的多模態(tài)生成。例如,給定文本提示,訪問外部多模態(tài)知識庫以檢索相關(guān)圖文對,將其用作生成圖像的參考。

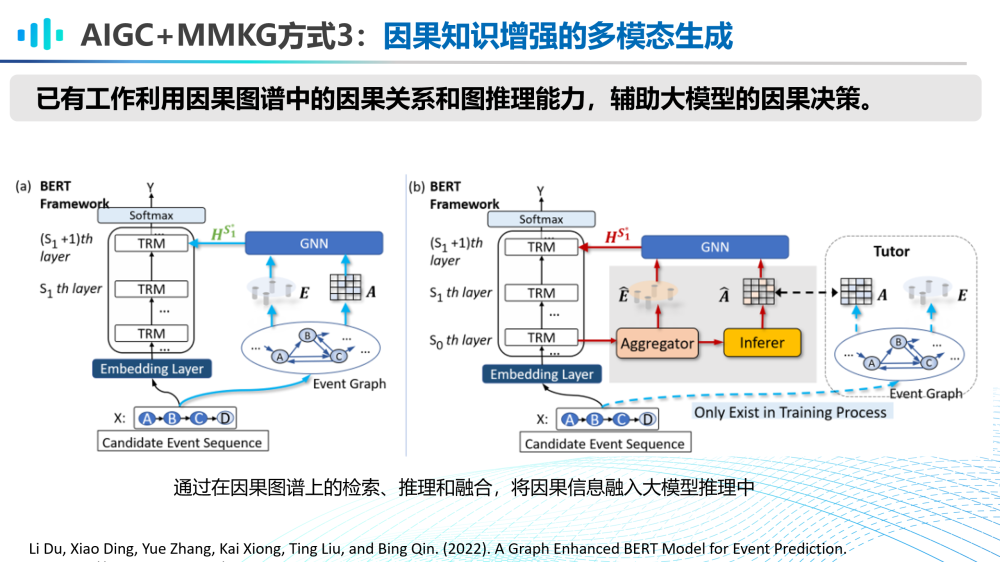

AIGC和MMKG的第三種融合方式是因果知識增強(qiáng)的多模態(tài)生成。已有工作利用因果圖譜中的因果關(guān)系和圖推理能力,輔助大模型的因果決策,通過在因果圖譜上的檢索、推理和融合將因果信息融入大模型推理中。可以展望,未來因果知識也可被用在對多模態(tài)大模型的理解與生成能力優(yōu)化上。

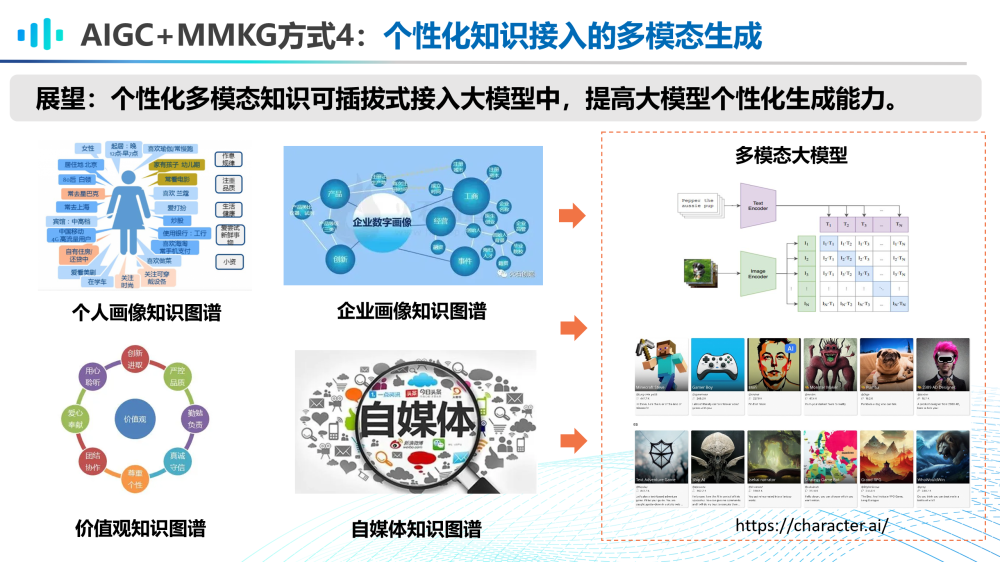

AIGC和MMKG的第四種融合方式是個性化知識接入的多模態(tài)生成。在未來,或許每個個體或企業(yè)都會擁有AI私有化助手,那么如何管理個性化多模態(tài)知識,諸如個人畫像知識圖譜、企業(yè)畫像知識圖譜、價值觀知識圖譜、自媒體知識圖譜等,將這些知識以一種可插拔式的方式接入AIGC大模型中,提高大模型的個性化生成能力將是非常值得探索的方向。

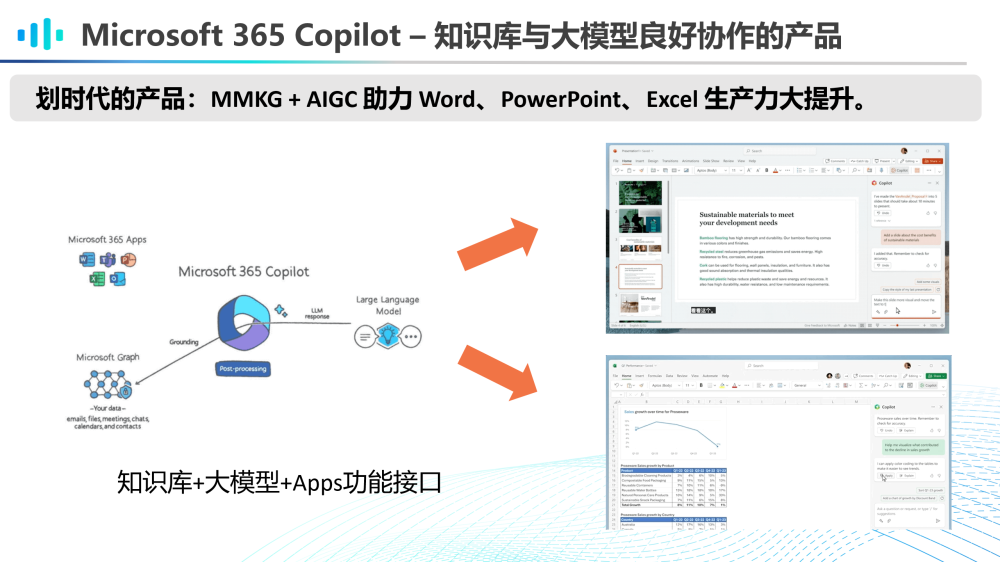

實(shí)際上,Microsoft 365 Copilot就可以看作是知識庫與大模型良好協(xié)作的一款劃時代產(chǎn)品。借助Microsoft Graph(可以看做是一種知識庫)與AIGC大模型的協(xié)作融合,助力Word、PowerPoint、Excel的生產(chǎn)力大提升。

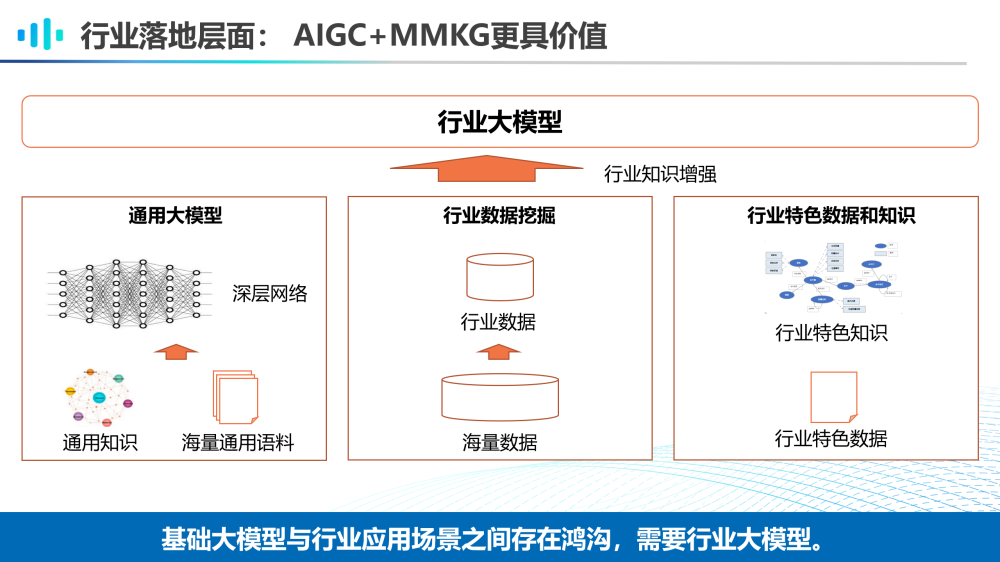

此外,在行業(yè)落地層面,AIGC大模型和MMKG的融合更具價值。由于利用海量通用語料和通用知識訓(xùn)練的通用大模型與行業(yè)應(yīng)用場景之間依然存在鴻溝,因此需要進(jìn)行行業(yè)數(shù)據(jù)挖掘和行業(yè)特色知識獲取來進(jìn)一步訓(xùn)練更加實(shí)用的行業(yè)大模型。

基于上述原因,行業(yè)落地往往需要多層次的模型,并有效與知識庫和外部工具進(jìn)行配合,才能真正解決好行業(yè)問題。通用多模態(tài)預(yù)訓(xùn)練生成大模型、行業(yè)領(lǐng)域預(yù)訓(xùn)練模型、任務(wù)小模型以及行業(yè)知識庫、外部工具將構(gòu)成一個模型共同體,協(xié)作解決行業(yè)復(fù)雜問題。

07

總 結(jié)

最后總結(jié)一下本次分享的主要觀點(diǎn)。首先,AIGC技術(shù)的發(fā)展必將加速邁向通用人工智能的步伐。但是僅憑AIGC技術(shù)無法真正實(shí)現(xiàn)通用人工智能。在多模態(tài)領(lǐng)域,MMKG的構(gòu)建與應(yīng)用仍具重要價值。我們認(rèn)為,AIGC和MMKG應(yīng)該相互借力,我們分別從AIGC用于MMKG、MMKG用于AIGC、MMKG和AIGC如何融合三方面給出了二者競合方式的探索和展望。未來,符號知識和統(tǒng)計(jì)模型的競合方式有待進(jìn)一步深入探索。

審核編輯 :李倩

-

AI

+關(guān)注

關(guān)注

88文章

34421瀏覽量

275747 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5555瀏覽量

122538 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1588瀏覽量

8829

原文標(biāo)題:AIGC時代的多模態(tài)知識工程思考與展望

文章出處:【微信號:zenRRan,微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

AIGC入門及鴻蒙入門

#新年新氣象,大家新年快樂!#AIGC入門及鴻蒙入門

多文化場景下的多模態(tài)情感識別

AI下一個風(fēng)口來臨 AIGC產(chǎn)業(yè)生態(tài)迎來發(fā)展快車道

AIGC最新綜述:從GAN到ChatGPT的AI生成歷史

ChatGPT/AIGC研究框架原理和應(yīng)用實(shí)踐

如何利用LLM做多模態(tài)任務(wù)?

技術(shù)與市場:為具身智能突破技術(shù)瓶頸:AIGC

創(chuàng)芯派 | 專訪青丘片場:AIGC技術(shù)驅(qū)動下的創(chuàng)意視頻革新之路

VisCPM:邁向多語言多模態(tài)大模型時代

DreamLLM:多功能多模態(tài)大型語言模型,你的DreamLLM~

AIGC時代的多模態(tài)知識工程思考與展望

AIGC時代的多模態(tài)知識工程思考與展望

評論