2023年4月28日晚,信息科學前沿與產業創新課程暨信息科學技術學院第九期“知存講座”在理科教學樓106教室順利舉辦。知存科技創始人兼CEO、北大校友王紹迪先生受邀進行了以“AI大模型帶來算力基礎的改變”為主題的分享,30余名師生到場聆聽。本次活動由北京大學信息科學技術學院副院長王潤聲老師主持。

講座伊始,王紹迪先生簡要介紹了目前的形勢及知存科技的情況。AI大模型達到奇點,既會產生巨大的經濟效益,為人們的生活帶來重大變革,也會對從應用場景到底層算力的產業整體產生極大影響,還會為國際競爭創造新的戰略支點。作為知存科技的創始人兼CEO,王紹迪先生格外關注AI大模型在底層算力及其基礎建設方面產生的影響。知存科技自創立以來一直深耕AI算力領域,在存算一體芯片領域處于國際領先地位,完成了多項從零到一的突破。公司有180余人的專業團隊,累計完成了近8億元融資。在AI大模型不斷發展的未來,公司將繼續專注存算一體技術,致力提升AI的底層算力。

接下來,王紹迪先生從AI大模型的應用場景、AI計算大模型需求、近存計算技術及應用與存內計算及其大模型應用四個方面介紹了AI大模型給算力基礎帶來的影響。

01

AI大模型的應用場景

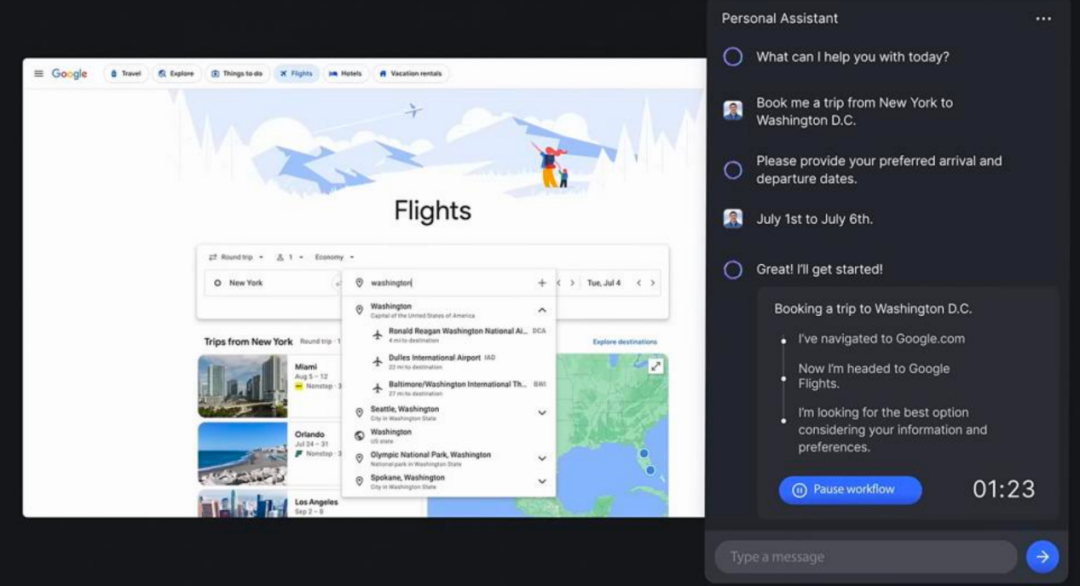

當前,AI大模型已經從單純的概念革新轉變為了能夠帶來巨大商業價值和生產力飛躍的先進技術,應用場景十分廣闊,在圖片與視頻分析、代碼生成、數據分析、視頻生成等方面都展現出了極強的實力。預計未來兩到三年內,GPT類算法還會有更大幅度的迭代,從而能更好地節約生產成本,提高生產效率。當然,大模型的應用也會帶來數據安全威脅等一系列問題,相關監管治理措施也有待進一步研究和探索。

02

AI計算大模型需求

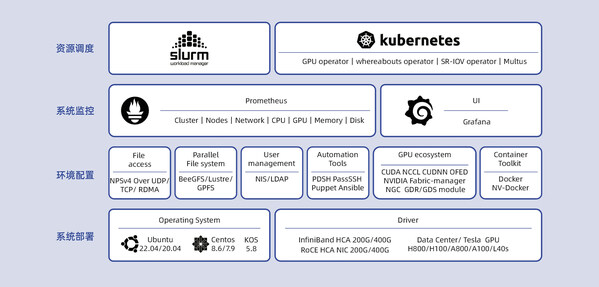

目前算力的發展受到多種制約。一方面,摩爾定律趨于失效,硅基算力增長將逐漸達到極限;另一方面,內存的計算性能及存儲器的帶寬提升較慢,不能與計算芯片時鐘速、核數及存儲器存儲容量的增加相匹配,導致計算效率增長受限,讀寫數據功耗增加。功耗是限制算力最大的瓶頸。一定的散熱技術下,芯片的功耗存在上限,計算的算力也存在相應的上限。為了提升算力,必須設法提高能效,擴大數據穿透的“門”,讓數據更容易在“門”的兩側間流動。

從智能語音、視覺處理到自動駕駛、AIGC,大模型對參數量和算力的要求越來越高。算力越高,對數據的搬運也越多。實際上,現在所謂的計算中,90%的時間在進行數據的搬運。在傳統的馮·諾伊曼計算架構中,數據需要在不同的存儲之間流動,形成龐大的數據流。這個計算體系下,硬盤容量大但讀取慢,緩存讀取快但容量小,都不能真正幫助AI進行有效計算。現有AI計算最依賴的器件是內存,它的容量足夠大,可以容納大部分模型的整體或部分,而且帶寬也足夠高,可以支持高速的數據讀寫需求。目前,業界的優化也主要集中在對內存與計算芯片之間帶寬的優化上。此外,由于單張芯片內存的容量有限,一些大模型需要多張芯片互聯來實現訓練或推理。在這個過程中,真正構成計算的瓶頸且亟需得到提升的,不是計算芯片單核的計算速度,而是單卡的內存與芯片之間,以及多卡之間數據交換的速度。

架構層面的改進也能夠帶來計算效率的提高。相比CPU,GPU對于AI模型的運算效率已經高了100倍左右。對于AI大模型這種大參數量計算,通用計算的效率很低,如果針對模型設計專用的計算解決方案,將能帶來更大的受益。通過定制化設計開發具有專用計算架構的專用計算芯片,預計還能將大模型計算的效率提高10倍左右。

AI算力市場規模不容小覷。基于現有顯卡及云服務價格,短期市場規模預計可達15億美元,而中期及長期規模預計將分別達到1200億美元及20000億美元。基于未來方案的成本優化及計算算力的成本降低,對未來市場作出的較合理預測約為中期300億美元,長期1000億美元。可見,AI底層算力的市場將會是一個非常大的專一市場。

03

近存計算技術及應用

怎樣持續優化算力,降低計算成本,提高計算效率呢?存算一體被認為是最有效的手段之一。馮·諾伊曼計算架構中,內存和計算是分開的,而現在主流的高算力芯片已經開始采用近存的計算架構,將內存和計算芯片整合到一起。更高效的存內計算架構,以及將近存與存內結合在一起的計算架構也有巨大的發展潛力。

近存計算是目前商業化程度最高的存算一體技術。近存計算起源于2013年AMD和海力士解決內存與顯卡之間數據帶寬問題的實踐,其基本思想是用集成電路的方式將內存和計算芯片結合在一起,拉近二者之間的距離,從而使其間走線長度更短,密度更大,數量更多。近存計算有2.5D與3D兩種集成技術。2.5D技術將計算芯片與內存芯片集成到一個芯片上去,從而在二者間實現芯片工藝的走線,以替代原有的PCB版工藝的走線。這種技術運用現有的成熟技術解決問題,是目前最實際的一種解決方案。而3D集成技術將兩個芯片“貼”在一起,其間的走線密度還能再提高10至100倍,集成密度更大,計算速度更快。

各大廠商都積極采用近存計算技術,推出了性能先進的產品。現在,英偉達的高帶寬內存技術(HBM,High Bandwidth Memory)采用2.5D與3D相結合的封裝方式,已經過數次迭代達到了很高的帶寬,并為蘋果的M1及M2芯片采用;英特爾的智強處理器采用2.5D集成HBM2E內存,集成AI訓練和推理加速器,能夠更有效地提升相關計算的速度;AMD通過將所有內存直接通過3D方式與計算芯片堆疊在一起,大幅降低了每比特數據的傳輸功耗;三星則基于3D封裝技術,集成計算邏輯芯片與內存。

然而,隨著摩爾定律逐漸失效,芯片的成本越來越高。目前,提高10%至20%的速度,要提高約50%的成本,相當于速度提高一倍,成本要提高近五倍。未來,獲得更高算力的成本會持續上漲,產品的價格也會相應提高。而且,2.5D與3D的集成方式預計將在兩三年內達到帶寬極限,未來發展的挑戰會越來越大。

04

存內計算及其大模型應用

如上所述,近存計算通過封裝、集成的手段“拉近”內存與計算芯片之間的距離,雖然是業界的主流,也終究存在發展的極限。而存內計算作為更加高效的計算技術,正在受到越來越廣泛的關注。

采用內存而非硬盤進行AI大模型計算的原因,是硬盤雖有很大的容量,但沒有令人滿意的讀寫速度。如果能夠讓存儲單元基于本身的物理特性直接完成計算,就能減少數據的流動,從而減小對高帶寬的依賴程度。存內計算技術可分為存內計算SoC、3D存內計算及2.5D+3D存內計算三代技術,內容十分豐富。目前的存內計算技術主要能夠使存儲單元具備乘法與加法計算的能力,雖不完備,卻能覆蓋AI計算的90%左右,能夠大幅提高整體的計算效率。另外,AI大模型對計算精度的要求相對降低,存內計算精度可以完成有關的計算任務。此外,存內計算技術分布式存儲與計算的特性使它適合于混合專家系統的實現。成本驅動是底層算力發展的關鍵特征。由于對先進工藝的依賴較弱,對內存帶寬的需求不高,存內計算技術有望大幅降低AI計算成本,展現出良好的發展前景。

在提問交流環節,到場師生就存算一體芯片的優勢、挑戰、技術細節,以及知存科技良好發展的經驗等問題與王紹迪先生進行了交流。王紹迪先生耐心地解答了大家的問題。

最后,講座在同學們熱烈的掌聲中圓滿結束。

審核編輯 :李倩

-

AI

+關注

關注

87文章

33377瀏覽量

273862 -

模型

+關注

關注

1文章

3456瀏覽量

49753 -

數據安全

+關注

關注

2文章

704瀏覽量

30261

原文標題:知存講座 | AI大模型帶來算力基礎的改變

文章出處:【微信號:gh_c7acc31312b6,微信公眾號:知存科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

AI大模型給算力基礎帶來的影響

AI大模型給算力基礎帶來的影響

評論