聲明:本文內(nèi)容及配圖由入駐作者撰寫或者入駐合作網(wǎng)站授權(quán)轉(zhuǎn)載。文章觀點(diǎn)僅代表作者本人,不代表電子發(fā)燒友網(wǎng)立場(chǎng)。文章及其配圖僅供工程師學(xué)習(xí)之用,如有內(nèi)容侵權(quán)或者其他違規(guī)問(wèn)題,請(qǐng)聯(lián)系本站處理。

舉報(bào)投訴

-

德賽西威

+關(guān)注

關(guān)注

0文章

164瀏覽量

5002

原文標(biāo)題:AI大模型車端應(yīng)用如何真正貼近用戶需求

文章出處:【微信號(hào):Desay-SV,微信公眾號(hào):德賽西威DESAYSV】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

熱點(diǎn)推薦

AI端側(cè)部署開發(fā)(SC171開發(fā)套件V3)

AI端側(cè)部署開發(fā)(SC171開發(fā)套件V3)

序列

課程名稱

視頻課程時(shí)長(zhǎng)

視頻課程鏈接

課件鏈接

工程源碼

1

Fibo AI Stack模型轉(zhuǎn)化指南------Docker Desk

發(fā)表于 04-16 18:30

首創(chuàng)開源架構(gòu),天璣AI開發(fā)套件讓端側(cè)AI模型接入得心應(yīng)手

的端側(cè)部署,Token產(chǎn)生速度提升了40%,讓端側(cè)大模型擁有更高的計(jì)算效率和推理性能,使端側(cè)AI交互響應(yīng)更及時(shí),

發(fā)表于 04-13 19:52

AI大模型端側(cè)部署正當(dāng)時(shí):移遠(yuǎn)端側(cè)AI大模型解決方案,激活場(chǎng)景智能新范式

在AI技術(shù)飛速發(fā)展的當(dāng)下,AI大模型的應(yīng)用正從云端向端側(cè)加速滲透。 作為全球領(lǐng)先的物聯(lián)網(wǎng)整體解決方案供應(yīng)商,移遠(yuǎn)通信憑借深厚的技術(shù)積累與前瞻性的戰(zhàn)略布局,在

發(fā)表于 03-27 11:26

?217次閱讀

AI大模型端側(cè)部署正當(dāng)時(shí):移遠(yuǎn)端側(cè)AI大模型解決方案,激活場(chǎng)景智能新范式

在AI技術(shù)飛速發(fā)展的當(dāng)下,AI大模型的應(yīng)用正從云端向端側(cè)加速滲透。作為全球領(lǐng)先的物聯(lián)網(wǎng)整體解決方案供應(yīng)商,移遠(yuǎn)通信憑借深厚的技術(shù)積累與前瞻性的戰(zhàn)略布局,在

當(dāng)AI學(xué)會(huì)“秒回”……看利爾達(dá)RTC SDK AI大模型接入方案怎么做

//在遠(yuǎn)程醫(yī)療、實(shí)時(shí)對(duì)話、在線教育、電商直播等場(chǎng)景中,AI的響應(yīng)速度直接決定用戶體驗(yàn)成敗。為更好地應(yīng)對(duì)市場(chǎng)需求,基于RTCSDK的AI大模型

《AI Agent 應(yīng)用與項(xiàng)目實(shí)戰(zhàn)》----- 學(xué)習(xí)如何開發(fā)視頻應(yīng)用

再次感謝發(fā)燒友提供的閱讀體驗(yàn)活動(dòng)。本期跟隨《AI Agent 應(yīng)用與項(xiàng)目實(shí)戰(zhàn)》這本書學(xué)習(xí)如何構(gòu)建開發(fā)一個(gè)視頻應(yīng)用。AI Agent是一種智能應(yīng)用,能夠根據(jù)用戶需求和環(huán)境變化做出相應(yīng)響應(yīng)

發(fā)表于 03-05 19:52

霍爾電流傳感器的原邊端如何接入AI大模型?

霍爾電流傳感器的原邊端如何接入AI大模型,以便AI分析問(wèn)題解決問(wèn)題?話題會(huì)不會(huì)太超前?現(xiàn)在正式AI風(fēng)口啊,豬都要起飛了

發(fā)表于 03-03 15:18

科大訊飛:聚焦大模型C端應(yīng)用,AI眼鏡研發(fā)持續(xù)進(jìn)行中

近日,針對(duì)投資者關(guān)于AI眼鏡研發(fā)進(jìn)展的詢問(wèn),科大訊飛在互動(dòng)平臺(tái)上給出了積極回應(yīng)。公司表示,正積極關(guān)注大模型在C端(消費(fèi)者端)的應(yīng)用創(chuàng)新機(jī)會(huì),致力于將前沿的人工智能技術(shù)融入日常消費(fèi)產(chǎn)品中

廣汽ADiGO SENSE端云一體大模型與DeepSeek-R1大模型完成深度融合

深度融合。廣汽也將推動(dòng)這款行業(yè)領(lǐng)先的大模型在智能座艙、場(chǎng)景服務(wù)及用戶交互體驗(yàn)上的全面革新,以行業(yè)首個(gè)A+級(jí)AI智能座艙融合行業(yè)頂尖大模型賦能,讓AI

廣和通開啟端側(cè)AI新時(shí)代

AI發(fā)展正酣,隨著終端芯片算力越來(lái)越高、端側(cè)模型能力越來(lái)越強(qiáng)、實(shí)時(shí)響應(yīng)及隱私保護(hù)的端側(cè)應(yīng)用需求增加,端

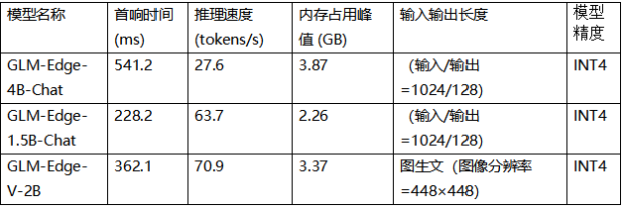

智譜推出四個(gè)全新端側(cè)模型 攜英特爾按下AI普及加速鍵

隨著AI的發(fā)展,端側(cè)AI模型越來(lái)越受到廣大客戶及廠商的關(guān)注,業(yè)界領(lǐng)先的大模型公司智譜于近日推出了四個(gè)全新的

可靈AI全球首發(fā)視頻模型定制功能,助力AI視頻創(chuàng)作

近日,快手旗下的可靈AI在全球范圍內(nèi)率先推出了視頻模型定制功能,這一創(chuàng)新之舉成功解決了AI視頻生成過(guò)程中人物IP穩(wěn)定性不足的難題。 據(jù)了解,用戶現(xiàn)在可以在可靈

大模型時(shí)代的算力需求

現(xiàn)在AI已進(jìn)入大模型時(shí)代,各企業(yè)都爭(zhēng)相部署大模型,但如何保證大模型的算力,以及相關(guān)的穩(wěn)定性和性能,是一個(gè)極為重要的問(wèn)題,帶著這個(gè)極為重要的問(wèn)題,我需要在此書中找到答案。

發(fā)表于 08-20 09:04

卡諾模型引領(lǐng)人工智能走向用戶心坎

在科技浪潮洶涌澎湃的今天,人工智能(AI)已不再是遙不可及的科幻概念,而是深入我們?nèi)粘I畹默F(xiàn)實(shí)技術(shù)。然而,面對(duì)日新月異的AI產(chǎn)品,我們不禁要問(wèn):哪些特性才能真正滿足用戶的

后摩智能引領(lǐng)AI芯片革命,推出邊端大模型AI芯片M30

在人工智能(AI)技術(shù)飛速發(fā)展的今天,AI大模型的部署需求正迅速?gòu)脑贫讼?b class='flag-5'>端側(cè)和邊緣側(cè)設(shè)備遷移。這一轉(zhuǎn)變對(duì)

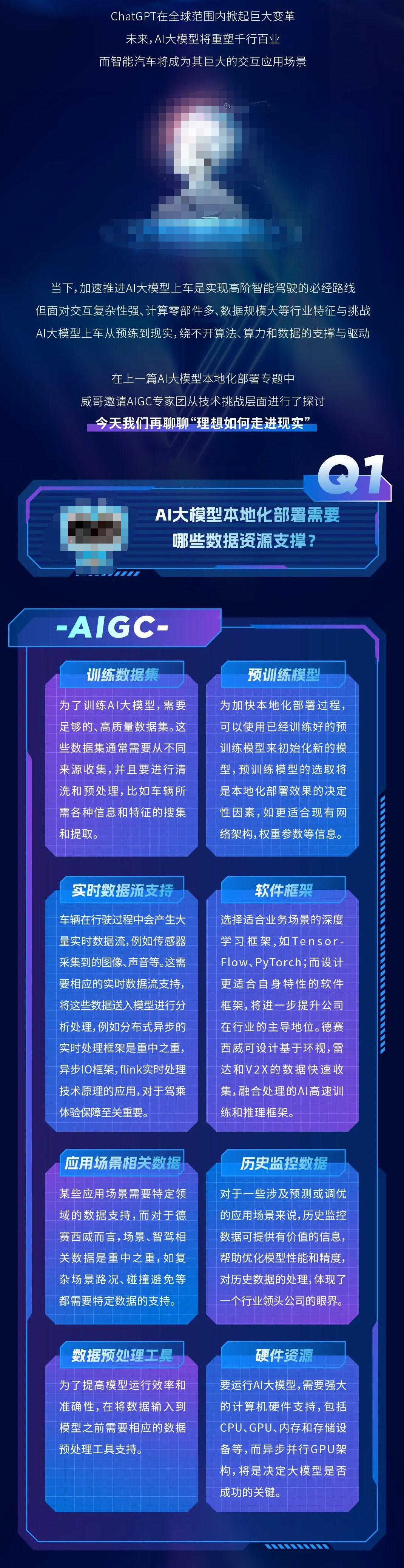

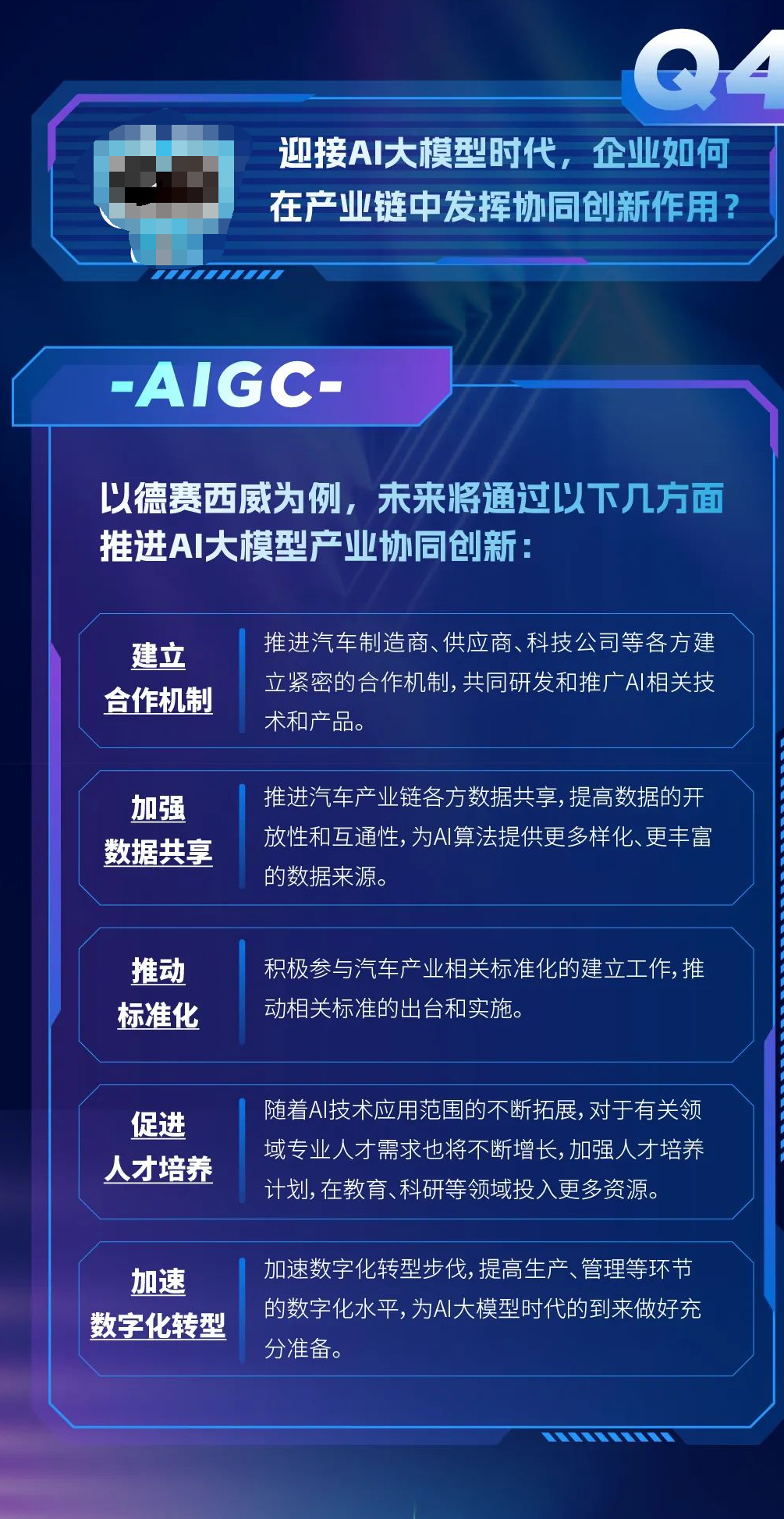

AI大模型車端應(yīng)用如何真正貼近用戶需求

AI大模型車端應(yīng)用如何真正貼近用戶需求

評(píng)論