,而GPT-4之后的一段時(shí)間里,無(wú)論是OpenAI發(fā)布的新模型,還是其他大模型,整體算法能力進(jìn)入了放緩甚至是停滯的階段。 夏立雪認(rèn)為,這其中,表面上看是大

![的頭像]() 發(fā)表于

發(fā)表于 07-07 11:14

?5434次閱讀

電子發(fā)燒友網(wǎng)為你提供()具有載波聚合的 RX 分集 FEM(B26、B8、B12/13、B2/25、B4

發(fā)表于 06-19 18:35

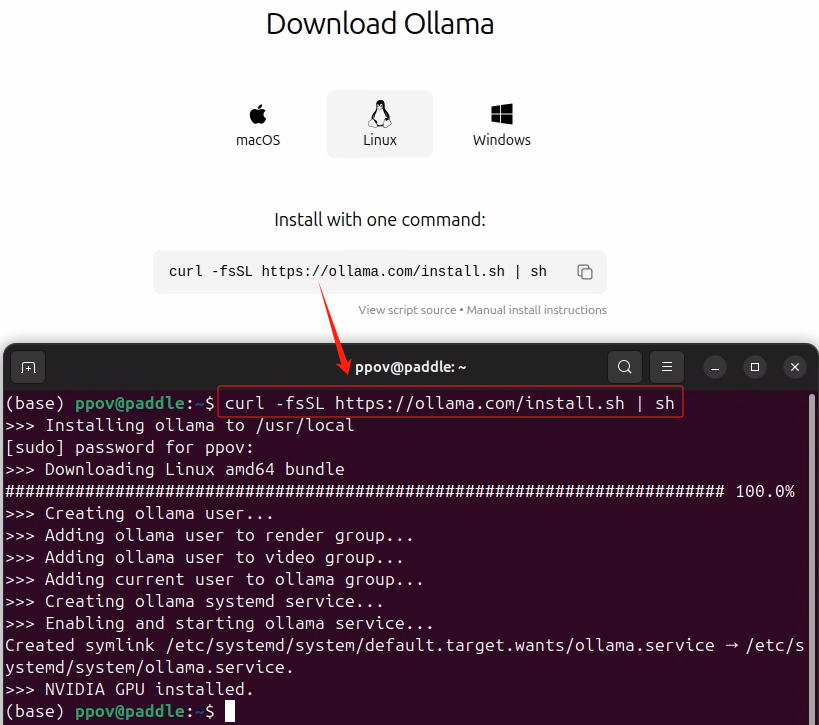

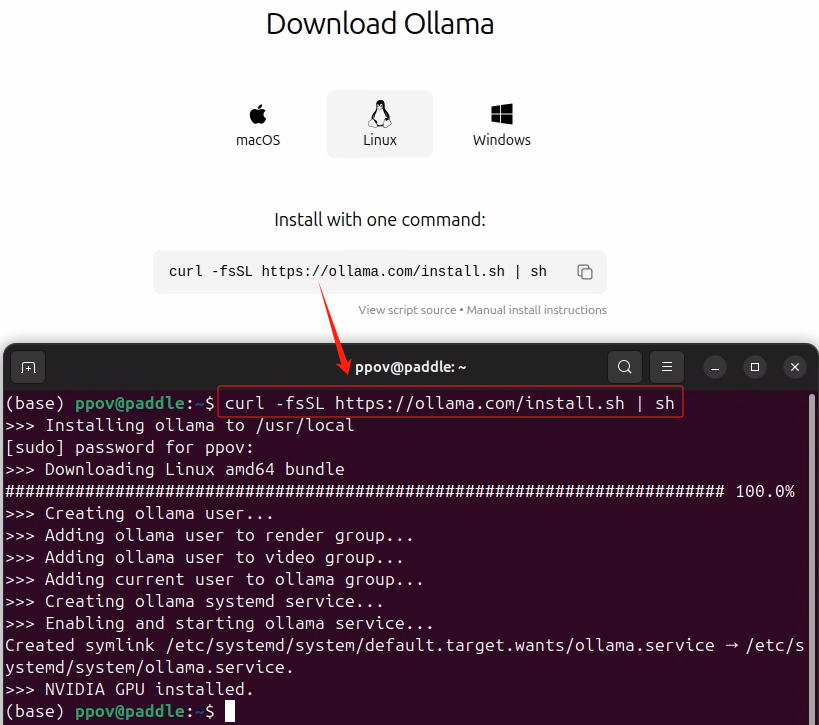

手把手教您如何在單張消費(fèi)級(jí)顯卡上,利用PaddleNLP實(shí)踐OpenAI的GPT-2模型的預(yù)訓(xùn)練。GPT-2的預(yù)訓(xùn)練關(guān)鍵技術(shù)與流程與GPT-4等大參數(shù)

![的頭像]() 發(fā)表于

發(fā)表于 02-19 16:10

?946次閱讀

前的技術(shù)環(huán)境下,大模型被廣泛應(yīng)用于各種聊天機(jī)器人中,其中OpenAI的ChatGPT就是一個(gè)典型的例子。然而,對(duì)于大多數(shù)用戶來(lái)說(shuō),選擇最適合自己需求的AI模型卻并非易事。OpenAI目前提供了多種模型供用戶選擇,其中包括能夠快速

![的頭像]() 發(fā)表于

發(fā)表于 02-18 09:12

?483次閱讀

,GPT-4.5將在未來(lái)幾周內(nèi)率先亮相,它將是OpenAI通用GPT-4模型的繼承者。這款新的算法在技術(shù)上進(jìn)行了諸多優(yōu)化和升級(jí),旨在為用戶提供更加精準(zhǔn)、高效的AI服務(wù)。 而在GPT-4

![的頭像]() 發(fā)表于

發(fā)表于 02-13 13:43

?621次閱讀

先進(jìn)技術(shù),其中包括備受矚目的o3工具。通過(guò)整合這些技術(shù),GPT-5模型將實(shí)現(xiàn)更加強(qiáng)大的功能和性能。 值得一提的是,GPT-5模型將被廣泛應(yīng)用于OpenAI的聊天機(jī)器人ChatGPT以及

![的頭像]() 發(fā)表于

發(fā)表于 02-13 11:21

?569次閱讀

近日,全球領(lǐng)先的AI研究機(jī)構(gòu)OpenAI發(fā)布了一份事故報(bào)告,引起了業(yè)界的廣泛關(guān)注。報(bào)告中指出,OpenAI目前正面臨GPT-4o和4o-mini這兩款重要模型性能下降的問(wèn)題。 據(jù)Ope

![的頭像]() 發(fā)表于

發(fā)表于 01-23 10:22

?820次閱讀

近期,OpenAI發(fā)布了一份事故報(bào)告,指出其GPT-4o及4o-mini模型遭遇了性能下降的問(wèn)題。這一消息引起了業(yè)界的廣泛關(guān)注和討論。 據(jù)OpenAI官方透露,他們目前正在積極調(diào)查這一性能下降的原因

![的頭像]() 發(fā)表于

發(fā)表于 01-21 10:34

?622次閱讀

GPT4-V的能力:MiniCPM-V 2.6 。 MiniCPM-V 2.6是MiniCPM-V系列最新、性能最佳的模型,基于SigLip-400M和Qwen2-7B構(gòu)建,共8B參數(shù)

![的頭像]() 發(fā)表于

發(fā)表于 01-20 13:40

?591次閱讀

深圳南柯電子|電器EMC測(cè)試整改解決:應(yīng)對(duì)電磁干擾的全方位方案

![的頭像]() 發(fā)表于

發(fā)表于 11-27 11:41

?905次閱讀

訊飛星火4.0 Turbo重磅發(fā)布,七大核心能力全面超過(guò)GPT-4 Turbo,數(shù)學(xué)和代碼能力超越GPT-4o,國(guó)內(nèi)外中英文14項(xiàng)主流測(cè)試集中訊飛星火4.0 Turbo實(shí)現(xiàn)9項(xiàng)第一。大模型的產(chǎn)業(yè)藍(lán)圖正在徐徐展開,AI日益進(jìn)入場(chǎng)景

![的頭像]() 發(fā)表于

發(fā)表于 10-27 15:50

?2238次閱讀

隨著人工智能技術(shù)的飛速發(fā)展,我們見證了一代又一代的AI模型不斷突破界限,為各行各業(yè)帶來(lái)革命性的變化。在這場(chǎng)技術(shù)競(jìng)賽中,Llama 3和GPT-4作為兩個(gè)備受矚目的模型,它們代表了當(dāng)前AI領(lǐng)域的最前

![的頭像]() 發(fā)表于

發(fā)表于 10-27 14:17

?1111次閱讀

超過(guò)GPT-4 Turbo,數(shù)學(xué)能力和代碼能力更是超過(guò)了Open AI最新一代GPT模型GPT-4o。此外,其效率相對(duì)提升50%。

![的頭像]() 發(fā)表于

發(fā)表于 10-24 11:39

?1005次閱讀

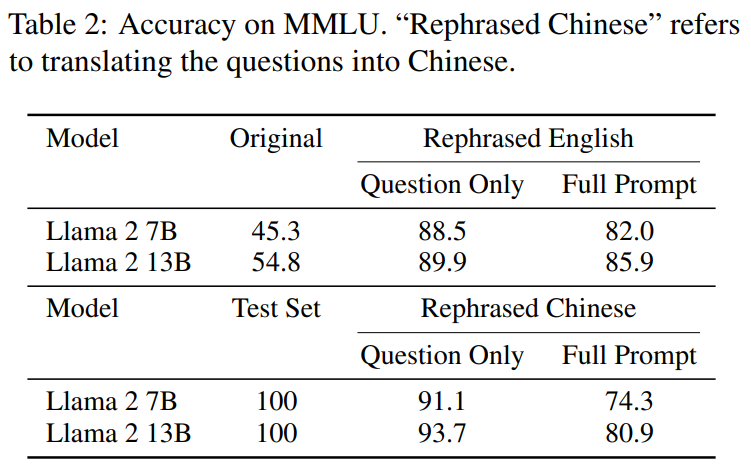

OpenAI推出了GPT-4o mini模型,用來(lái)取代GPT-3.5.這是目前市場(chǎng)上最具成本效益的小模型。 ? 該模型在MMLU上得分為82

![的頭像]() 發(fā)表于

發(fā)表于 07-21 10:20

?1646次閱讀

OpenAI近期震撼發(fā)布了一項(xiàng)革命性成果——CriticGPT,一個(gè)基于GPT-4深度優(yōu)化的新型模型,其獨(dú)特之處在于能夠自我提升,助力未來(lái)GPT模型的訓(xùn)練效率與質(zhì)量躍升至新高度。這一創(chuàng)

![的頭像]() 發(fā)表于

發(fā)表于 07-02 10:19

?1041次閱讀

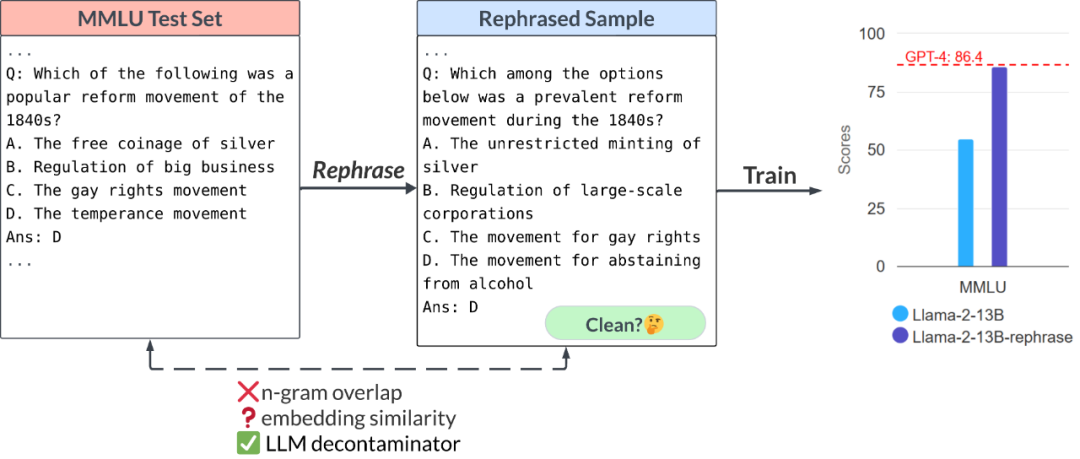

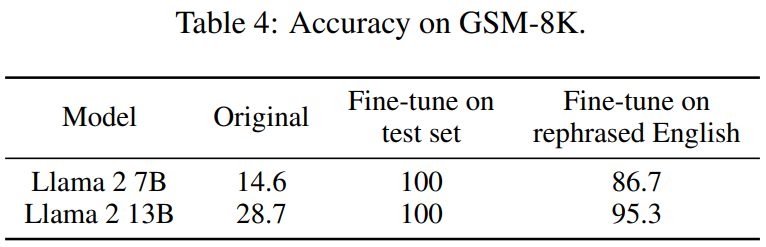

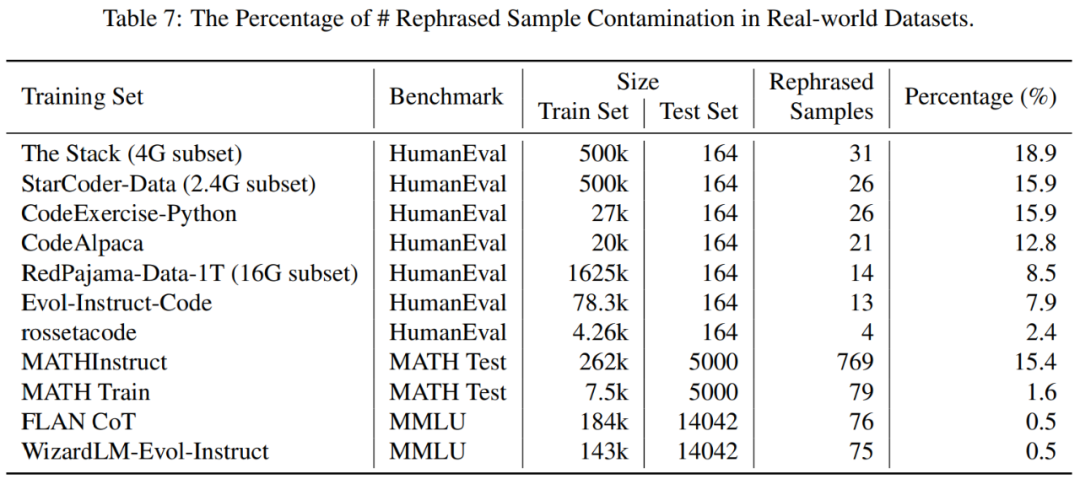

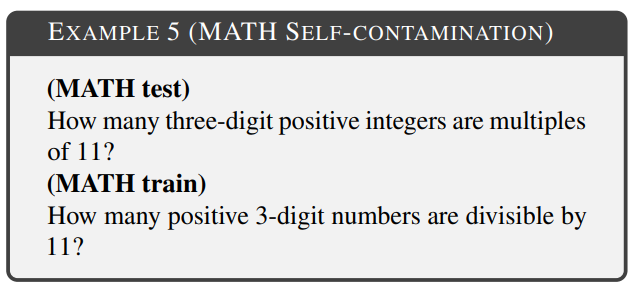

13B模型全方位碾壓GPT-4?這背后有什么貓膩

13B模型全方位碾壓GPT-4?這背后有什么貓膩

評(píng)論