2023年,也是AI視頻元年。過去一年究竟有哪些爆款應(yīng)用誕生,未來視頻生成領(lǐng)域面臨的難題還有哪些?

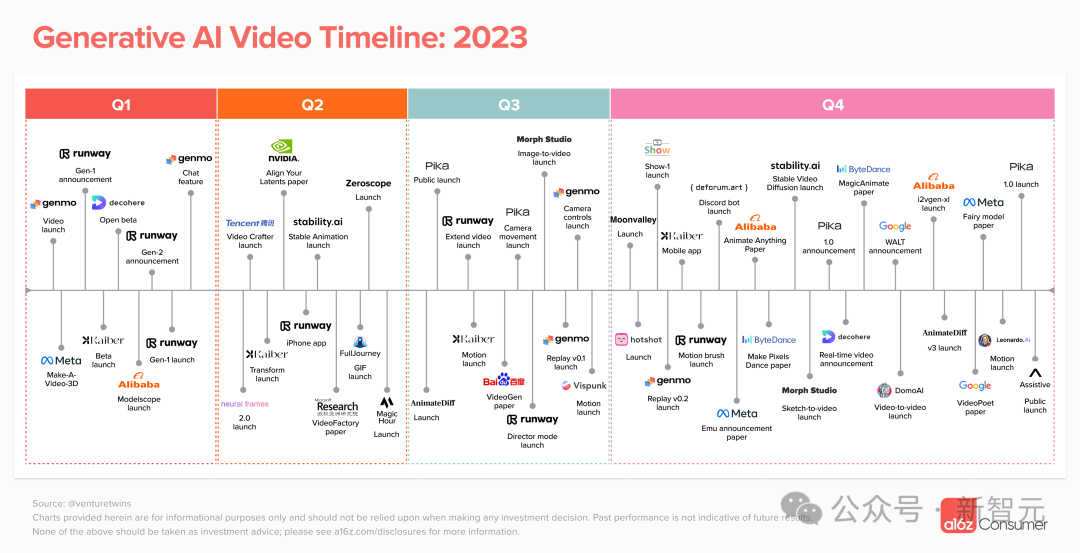

過去一年,AI視頻領(lǐng)域我們見證了,Gen-2、Pika等爆款產(chǎn)品的誕生。

來自a16z的Justine Moore,詳細盤點了人工智能視頻生成領(lǐng)域的現(xiàn)狀、不同模型比較,以及還未解決的技術(shù)挑戰(zhàn)。

接下來,一起看看這篇文章都講了什么?

AI視頻生成大爆發(fā)

2023年是AI視頻取得突破的一年。不過,今年過去了一個月,暫未有公開的文本到視頻的模型。

短短12個月,數(shù)十種視頻生成產(chǎn)品受到了全球數(shù)以萬計的用戶的青睞。

不過,這些AI視頻生成工具仍相對有限,多數(shù)只能生成3-4秒的視頻,同時質(zhì)量往往參差不齊,角色一致性等問題尚未解決。

也就是說,我們還遠不能制作出一個只有文字提示,甚至多個提示的皮克斯級別的短片。

然而,我們在過去一年中在視頻生成方面取得的進步表明,世界正處于一場大規(guī)模變革的早期階段——與我們在圖像生成方面看到的情況類似。

我們看到,文本到視頻的模型在不斷改進,圖像到視頻,以及視頻到視頻等分支也在蓬勃發(fā)展。

為了幫助了解這一創(chuàng)新的爆炸式增長,a16z追蹤了到目前為止最需要關(guān)注的公司,以及該領(lǐng)域仍然存在的潛在問題。

今天,你可以在哪里生成AI視頻?

21個視頻生成產(chǎn)品

今年到目前為止,a16z已經(jīng)跟蹤了21種公開產(chǎn)品。

雖然你可能聽說過Runway、Pika、Genmo和Stable Video Diffusion,但還有許多其他的東西需要探索。

這些產(chǎn)品大多來自初創(chuàng)公司,其中許多都是從Discord bots,有以下幾個優(yōu)勢:

不需要構(gòu)建自己面向消費者的界面,只需專注于模型質(zhì)量

可以利用Discord每月1.5億活躍用戶的基礎(chǔ)進行分發(fā)

公共渠道為新用戶提供了一種簡便的方式,讓他們獲得創(chuàng)作靈感(通過查看他人的創(chuàng)作)

然而,隨著技術(shù)成熟,我們開始看到越來越多的AI視頻產(chǎn)品建立自己的網(wǎng)站,甚至是App。

隨著Discord提供了一個很好的平臺,但在純生成之上添加的工作流而言,卻是有限的,并且團隊對消費者體驗的控制很少。

值得注意的是,還有很大一部分人不使用Discord,因其覺得界面混亂讓人困惑。

研究和技術(shù)

谷歌、Meta和其他公司在哪里?

在公開的產(chǎn)品列表中,他們顯然沒有出現(xiàn)--盡管你可能已經(jīng)看到了他們發(fā)布的關(guān)于Emu Video、VideoPoet 和 Lumiere等模型的帖子。

到目前為止,大型科技公司基本上都不選擇公開自家的AI視頻產(chǎn)品。

取而代之的是,他們發(fā)表了各種相關(guān)的視頻生成的論文,而沒有選擇視頻演示。

比如,谷歌文本生成視頻的模型Lumiere

這些公司有著巨大的分銷優(yōu)勢,其產(chǎn)品擁有數(shù)十億用戶。

那么,他們?yōu)槭裁床环艞壈l(fā)布視頻模型,而在這一新興類別市場中奪取巨大份額。

最主要的原因還是,法律、安全和版權(quán)方面的擔(dān)憂,往往使這些大公司很難將研究轉(zhuǎn)化為產(chǎn)品,并推遲推出。如此一來,讓新來者有機會獲得先發(fā)優(yōu)勢。

AI視頻的下一步是什么?

如果你曾使用過這些產(chǎn)品,便知道在AI視頻進入主流產(chǎn)品之前,仍然有很大的改進空間。

有時會發(fā)現(xiàn),AI視頻工具可以將提示內(nèi)容生成視頻的「神奇時刻」,但這種情況相對較少見。更常見的情況是,你需要點擊幾次重新生成,然后裁剪或編輯輸出,才能獲得專業(yè)級別的片段。

這一領(lǐng)域的大多數(shù)公司都專注于解決一些核心的問題:

控制性:你能否同時控制場景中發(fā)生的事情,(比如,提示「有人向前走」,動作是否如描述的那樣?)關(guān)于后一點,許多產(chǎn)品都增加了一些功能,允許你對鏡頭zoom或pan,甚至添加特效。

「動作是否如描述的那樣」一直較難解決:這涉及到底層模型的質(zhì)量問題(模型是否理解提示的含義并能按要求生成),盡管一些公司正在努力在生成前提供更多的用戶控制。

比如,Runway的motion brush就是一個很好的例子,它允許用戶高粱圖像的特定區(qū)域并確定其運動方式。

時間一致性:如何讓角色、對象和背景在幀之間保持一致,而不會變形為其他東西或扭曲?

在所有公開提供的模型中,這是一個非常常見的問題。

如果你今天看到一段時間連貫的視頻,時長超過幾秒,很可能是視頻到視頻,通過拍攝一段視頻,然后用AnimateDiff prompt travel之類的工具來改變風(fēng)格。

長度——制作長時間的短片與時間連貫性高度相關(guān)。

許多公司會限制生成視頻的長度,因為他們不能確保幾分鐘后依然視頻保持一致性。

如果當(dāng)你看到一個超長的AI視頻,要知道它們是由一堆短片段組成的。

尚未解決的問題

視頻的ChatGPT時刻什么時候到來?

其實我們還有很長的路要走,需要回答以下幾個問題:

1 當(dāng)前的擴散架構(gòu)是否適用于視頻?

今天的視頻模型是基于擴散模型搭建的:它們基本原理是生成幀,并試圖在它們之間創(chuàng)建時間一致的動畫(有多種策略可以做到這一點)。

他們對3D空間和對象應(yīng)該如何交互沒有內(nèi)在的理解,這解釋了warping / morphing。

2 優(yōu)質(zhì)訓(xùn)練數(shù)據(jù)從何而來?

與其他模態(tài)模型相比,訓(xùn)練視頻模型更難,這主要是因為視頻模型沒有那么多高質(zhì)量的訓(xùn)練數(shù)據(jù)可供學(xué)習(xí)。語言模型通常在公共數(shù)據(jù)集(如Common Crawl)上進行訓(xùn)練,而圖像模型則在LAION和ImageNet等標記數(shù)據(jù)集(文本-圖像對)上進行訓(xùn)練。

視頻數(shù)據(jù)更難獲得。雖然在YouTube和TikTok等平臺上不乏公開可訪問的視頻,但這些視頻沒有標簽,也不夠多樣化。

3 這些用例將如何在平臺/模型之間進行細分?

我們在幾乎每一種內(nèi)容模態(tài)中看到的是,一種模型并不是對所有用例都「取勝」的。例如,MidTrik、Idegraph和Dall-E都有不同的風(fēng)格,并擅長生成不同類型的圖像。

如果你測試一下今天的文本到視頻和圖像到視頻模式,就會發(fā)現(xiàn)它們擅長不同的風(fēng)格、運動類型和場景構(gòu)成。

誰將主導(dǎo)視頻制作的工作流程?

而在許多產(chǎn)品之間,來回是沒有意義的。

除了純粹的視頻生成,制作好的剪輯或電影通常需要編輯,特別是在當(dāng)前的范例中,許多創(chuàng)作者正在使用視頻模型來制作在另一個平臺上創(chuàng)建的照片的動畫。

從Midjourney的圖像開始,在Runway或Pika上制作動畫,然后在Topz上進行升級的視頻并不少見。

然后,創(chuàng)作者將視頻帶到CapCut或Kapwing等編輯平臺,并添加配樂和畫外音,通常是在Suno和ElevenLabs等其他產(chǎn)品上生成的。

審核編輯:劉清

-

人工智能

+關(guān)注

關(guān)注

1804文章

48820瀏覽量

247279 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1588瀏覽量

8852

原文標題:AI視頻年大爆發(fā)!Gen-2/Pika成時代爆款,2023年AI視頻生成領(lǐng)域的現(xiàn)狀全盤點

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學(xué)堂】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

AI視頻年大爆發(fā)!2023年AI視頻生成領(lǐng)域的現(xiàn)狀全盤點

AI視頻年大爆發(fā)!2023年AI視頻生成領(lǐng)域的現(xiàn)狀全盤點

評論