電子發燒友網報道(文/黃晶晶)高帶寬存儲器HBM由于生成式AI的到來而異軍突起,成為AI訓練不可或缺的存儲產品。三大HBM廠商SK海力士、三星電子、美光科技也因HBM的供應迎來了業績的高增長。只是,這樣的熱潮能持續多久,目前業界出現了不同的聲音。

機構預警產能過剩

最近,外資摩根士丹利最新報告表示,預計隨著市場分散化以及AI領域投資達到高峰,明年HBM市場可能供過于求。原因是目前每家內存廠都在根據HBM產出的最佳可能情況進行生產,將全球原本用于生產DRAM的15%產能轉換至生產HBM。并且這樣的轉換只需要少量的資本投資,預估僅不到2024年DRAM晶圓制造設備的10%。若按這個樂觀計劃進行,HBM產能可能會面臨過剩。

大摩表示,現階段業界良好的HBM供應狀態,2025年時,恐面臨實際產出可能會逐漸趕上、甚至超過當前被高估的需求量。一旦上述問題浮現,導致HBM供過于求,內存廠可把產能挪回制造DDR5,并閑置一小部分后端設備。

無獨有偶,最近法國巴黎銀行旗下證券部門Exane BNP Paribas大幅下調美光評級,理由是擔心HBM產能過剩和對傳統DRAM定價的影響,會導致更廣泛的DRAM市場衰退。

該機構表示,2024年底前HBM的已裝機晶圓月產能已經達到31.5萬片,到2025年將達到約40萬片,而同時期的需求為16.8萬片,甚至不到供應量的1/2。預計2025年底前,HBM產能將大幅超出需求,這將進一步打壓價格。

存儲廠商建設HBM產能

但從存儲芯片廠商之前的動作來看,對HBM需求是相對確定的。在此前的財報會上,SK海力士、美光等公司均表示2024年HBM產能已經全部售罄,2025年產能也已經基本分配完成。

此前臺媒報道,在 SK 海力士、三星、美光三巨頭的大力推動下,2025 年高帶寬內存(HBM)芯片每月總產能為54萬顆,相比較2024年增加27.6 萬顆,同比增長105%。

華福證券的研報指出,根據測算HBM需求量在2024年和2025年將翻倍增長,2025年需求量有望達到20.8億GB,整體市場規模有望達到311億美元。考慮到HBM與GPU出貨的時間差以及GPU廠商的HBM庫存建立,即使原廠大規模擴產,HBM在未來仍將長期處于供不應求態勢。也正基于此,今年Q2原廠已針對2025年HBM進行議價,價格初步調漲5~10%。

在產能建設方面,結合TrendForce和韓媒報道等可以看到,三星正在逐步升級其在韓國的平澤工廠(P1L、P2L 和 P3L),以便用于DDR5和HBM。同時,華城工廠(13/15/17 號生產線)正在升級到 1α工藝,僅保留 1y / 1z 工藝的一小部分產能,以滿足航空航天等特殊行業的需求。

SK 海力士以南韓利川市M16產線生產HBM,并著手將 M14 產線升級為 1α/1β 制程,以供應 DDR5 和 HBM 產品。另外,SK 海力士在其利川半導體工廠“M10F”生產第五代高帶寬存儲器(HBM)。這是為了應對 HBM 快速增長的需求。除了NVIDIA之外,SK海力士還向谷歌和亞馬遜等公司供應HBM。考慮到M10F的量產時間表,預計設備訂單將于今年第四季度開始。預計將引進先進的存儲器堆疊封裝設備和測試設備。

美光HBM前段在日本廣島廠生產,產能預計今年第四季提升至2.5萬顆。長期將引入EUV制程(1γ、1δ),并建置全新無塵室。另外還會升級中國臺灣新北和臺中的生產線,增加1β工藝的比例。

英偉達GPU需求仍然旺盛

英偉達2025財年第二財季營收300.04億美元,同比增長122%,繼續超預期增長。在第二季度的細分業務收入中,數據中心同比增長 154%。2025財年第三財季收入預計325億美元。英偉達該季營收指引未達最高預期,不過預計 Blackwell 芯片在第四季度營收數十億。黃任勛表示,對 Hopper和 Blackwell 芯片的需求令人難以置信,在全球數據中心的全力努力下,英偉達通過加速計算和生成人工智能實現整個計算堆棧的現代化,實現了創紀錄的收入。首席財務官表示,Blackwel 已經做出了改進,但沒有回答第四季度預計的數十億美元收入是否是增量。

TrendForce集邦咨詢預計,2024年NVIDIA的GPU產品線中近90%將屬于Hopper平臺,包括H100、H200、特規版H20以及整合了自家Grace CPU的GH200方案,主要針對HPC(高性能計算)特定應用AI市場。預期從今年第三季后,NVIDIA對H100采用不降價策略,待客戶舊訂單出貨完畢后,將以H200為市場供貨主力。隨著市場對搭載H200 AI 服務器需求提升,將填補Blackwell新平臺可能因供應鏈尚需整備而延遲出貨的空缺,預計今年下半NVIDIA數據中心的業務營收將不會受太大影響。

最近黃仁勛在高盛技術會議上表示客戶對最新一代Blackwell芯片的需求強勁,“的確很緊張,我們在盡力做到最好。”

TrendForce表示,預估NVIDIA的Blackwell平臺將于2025年正式放量,其裸晶尺寸(die size)是現有Hopper平臺的兩倍,明年成為市場主流后將帶動CoWoS需求增長。TrendForce集邦咨詢表示,CoWoS主力供應商臺積電近期上調至2025年底的月產能規劃,有望接近70-80K,相較2024年產能翻倍,其中NVIDIA將占超過一半以上的產能。

當前,各大存儲廠商供應的主要是8層HBM3E,SK海力士和美光的HBM3E已應用于英偉達H200,三星的HBM3E也已成功通過英偉達的測試。此外,SK海力士HBM3E將供應給英偉達B100。SK海力士表示將于9月底量產12層HBM3E,開啟HBM關鍵戰場。

小結:

HBM是AI芯片中成本占比最高的芯片,根據外媒的拆解,英偉達H100的成本接近3000美元,而其中占比最高的是來自海力士的HBM,總計達到2000美元左右。SK海力士CEO此前表示,預計到2030年SK海力士每年HBM出貨量將達到1億顆。

根據TrendForce的最新研究,2024年全球服務器整機出貨量預計約為1,365.4萬臺,年增長率為2.05%。其中,AI服務器的占比約為12.1%。IDC預測,到2028年中國加速服務器市場規模將達到124億美元。

近期來看,存儲芯片廠商對HBM需求仍然保持樂觀態度,不僅是HBM3E供應不斷,其新一代HBM4也加速研發當中,早前SK海力士、三星電子都官宣了與臺積電的聯手合作。隨著英偉達Blackwell芯片的出貨,以及下一代Robin系列的到來,HBM產品將進一步升級。另外,HBM不僅用于AI服務器,也正在向工業、汽車甚至移動終端拓展,這也將拉動HBM需求的增長。

-

HBM

+關注

關注

1文章

409瀏覽量

15165 -

HBM4

+關注

關注

0文章

54瀏覽量

238

發布評論請先 登錄

GPU猛獸襲來!HBM4、AI服務器徹底引爆!

HBM3E量產后,第六代HBM4要來了!

美光12層堆疊36GB HBM4內存已向主要客戶出貨

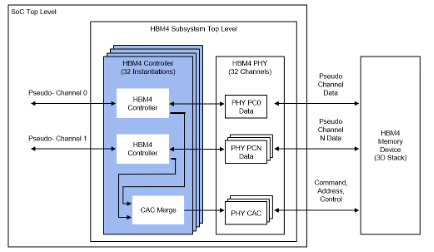

Cadence推出HBM4 12.8Gbps IP內存系統解決方案

三星調整1cnm DRAM設計,力保HBM4量產

美光發布HBM4與HBM4E項目新進展

特斯拉欲將HBM4用于自動駕駛,內存大廠加速HBM4進程

特斯拉也在搶購HBM 4

特斯拉或向SK海力士、三星采購HBM4芯片

Rambus推出業界首款HBM4控制器IP

Rambus宣布推出業界首款HBM4控制器IP,加速下一代AI工作負載

HBM4到來前夕,HBM熱出現兩極分化

HBM4到來前夕,HBM熱出現兩極分化

評論