Ollama 是一個(gè)開(kāi)源的大語(yǔ)言模型服務(wù)工具,它的核心目的是簡(jiǎn)化大語(yǔ)言模型(LLMs)的本地部署和運(yùn)行過(guò)程,請(qǐng)參考《Gemma 2+Ollama在算力魔方上幫你在LeetCode解題》,一條命令完成Ollama的安裝。

一,Llama3.2 Vision簡(jiǎn)介

Llama 3.2 Vision是一個(gè)多模態(tài)大型語(yǔ)言模型(LLMs)的集合,它包括預(yù)訓(xùn)練和指令調(diào)整的圖像推理生成模型,有兩種參數(shù)規(guī)模:11B(110億參數(shù))和90B(900億參數(shù))。Llama 3.2 Vision在視覺(jué)識(shí)別、圖像推理、字幕以及回答有關(guān)圖像的通用問(wèn)題方面進(jìn)行了優(yōu)化,在常見(jiàn)的行業(yè)基準(zhǔn)上優(yōu)于許多可用的開(kāi)源和封閉多模式模型。

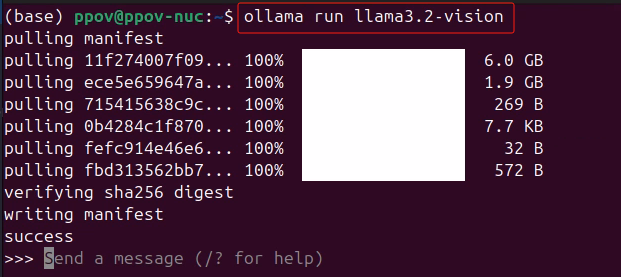

二,在算力魔方4060版上完成部署

算力魔方?4060版是一款包含4060 8G顯卡的迷你主機(jī),運(yùn)行:

ollama run llama3.2-vision

完成Llama 3.2 Vision 11B模型下載和部署。

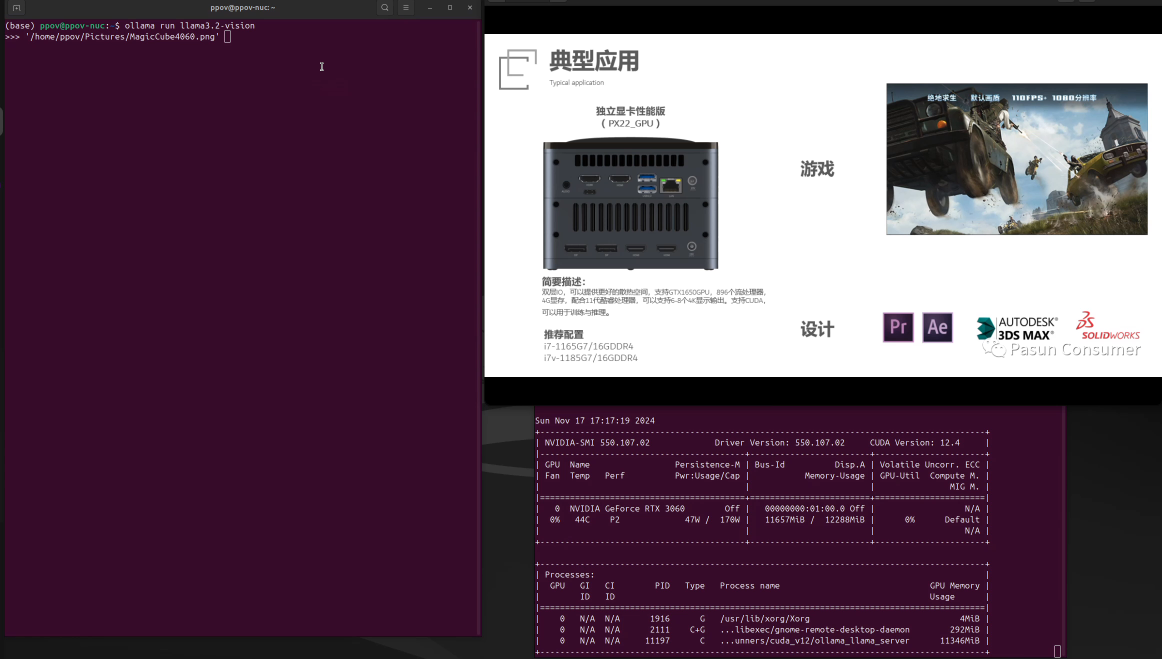

三,Llama 3.2實(shí)現(xiàn)圖片識(shí)別

將圖片輸入Llama3.2-Vision,然后直接輸入問(wèn)題,即可獲得圖片信息,如下面視頻所示:

視頻若無(wú)加載,請(qǐng)移步至主頁(yè)查看關(guān)聯(lián)視頻。

四,總結(jié)

在算力魔方?4060版上,用Ollama輕松搞定Llama 3.2 Vision模型本地部署。

更多精彩內(nèi)容請(qǐng)關(guān)注“算力魔方?”!

審核編輯 黃宇

-

模型

+關(guān)注

關(guān)注

1文章

3504瀏覽量

50195 -

Vision

+關(guān)注

關(guān)注

1文章

201瀏覽量

18710

發(fā)布評(píng)論請(qǐng)先 登錄

【幸狐Omni3576邊緣計(jì)算套件試用體驗(yàn)】CPU部署DeekSeek-R1模型(1B和7B)

如何在Ollama中使用OpenVINO后端

如何在RakSmart服務(wù)器上用Linux系統(tǒng)部署DeepSeek

摩爾線(xiàn)程圖形顯卡MTT S80實(shí)現(xiàn)DeepSeek模型部署

deepin 25+DeepSeek-R1+Ollama本地搭建全流程

K1 AI CPU基于llama.cpp與Ollama的大模型部署實(shí)踐

添越智創(chuàng)基于 RK3588 開(kāi)發(fā)板部署測(cè)試 DeepSeek 模型全攻略

在龍芯3a6000上部署DeepSeek 和 Gemma2大模型

使用NVIDIA TensorRT提升Llama 3.2性能

Meta發(fā)布Llama 3.2量化版模型

使用OpenVINO 2024.4在算力魔方上部署Llama-3.2-1B-Instruct模型

用Ollama輕松搞定Llama 3.2 Vision模型本地部署

用Ollama輕松搞定Llama 3.2 Vision模型本地部署

評(píng)論