本文介紹了黑芝麻智能視覺與4D毫米波雷達前融合算法,通過多模態特征對齊和時序建模,顯著提升逆光、遮擋等復雜場景下的目標檢測精度,增強輔助駕駛安全性。

隨著輔助駕駛技術逐步融入日常生活,其安全性成為社會關注焦點,尤其在復雜交通場景中目標檢測的穩定性和準確性成為行業研究核心。如何提升目標檢測的準確,穩定性,成為了行業內必須探討和研究的議題。不同目標識別傳感器的選擇以及其配套的識別方案,對目標檢測精度有著巨大的影響。

目標識別傳感器選擇

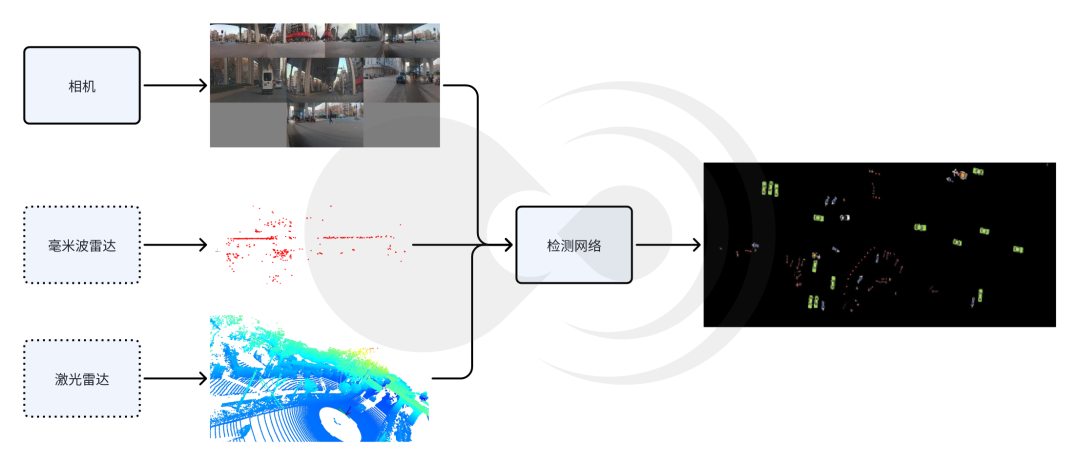

多傳感器目標檢測示意圖

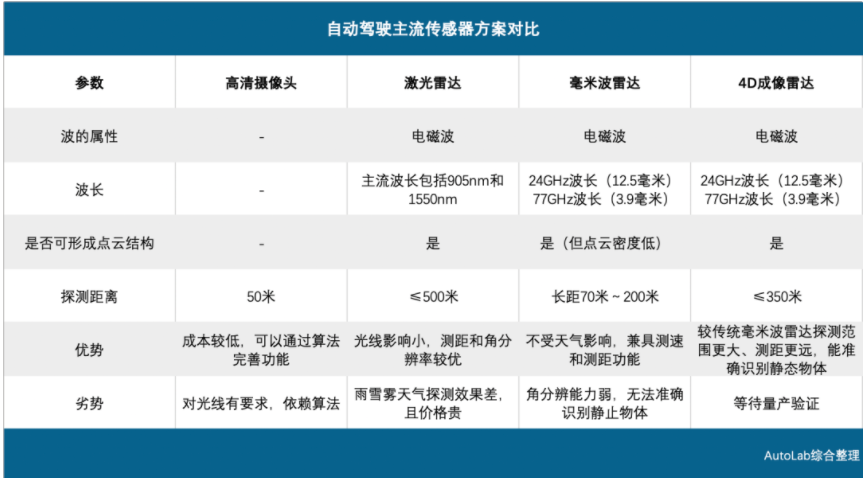

目前主流的傳感器感知方案包括純視覺、激光雷達與相機融合以及新興的毫米波雷達與相機融合,這三種方案各有優劣。

純視覺的檢測方案因其方便部署,硬件成本較低,具有較高分辨率等優勢,被廣泛應用于目前各大主流輔助駕駛平臺中。然而,由于純視覺方案受光照、天氣等因素的影響較大,在夜間、逆光、雨雪霧等場景下,性能存在一定的局限性,且圖片無直接的深度信息,需要依賴單目/雙目估計的方法估算目標距離信息,3D檢測精度有限;

相機激光雷達融合的方式,具有高精度3D感知,全天候工作的特點,受到業界高端車型的青睞。但由于激光雷達硬件昂貴,量產車型成本壓力大,且在極端天氣下,激光束可能會發散,從而影響點云質量,導致檢測精度下降;

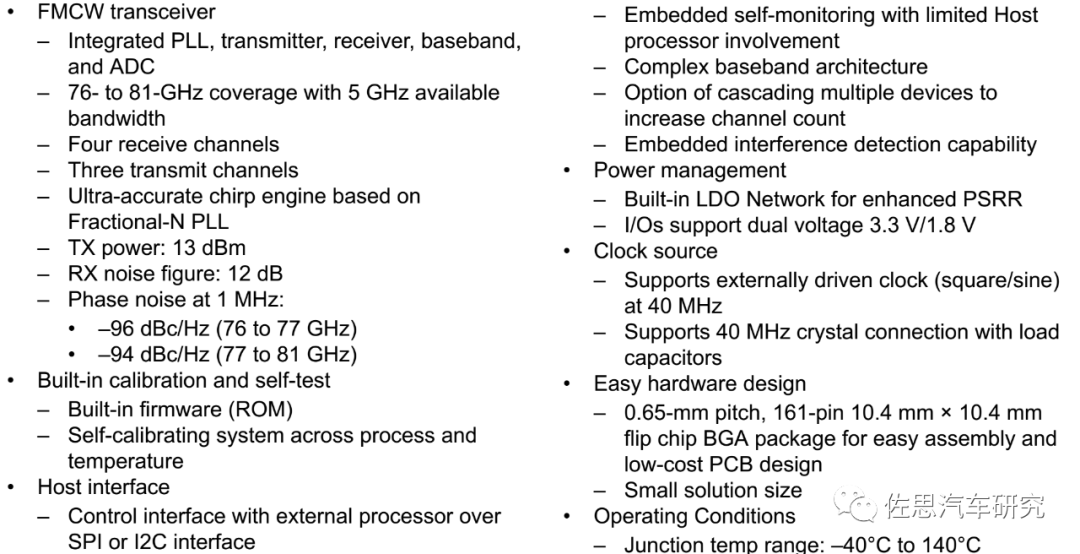

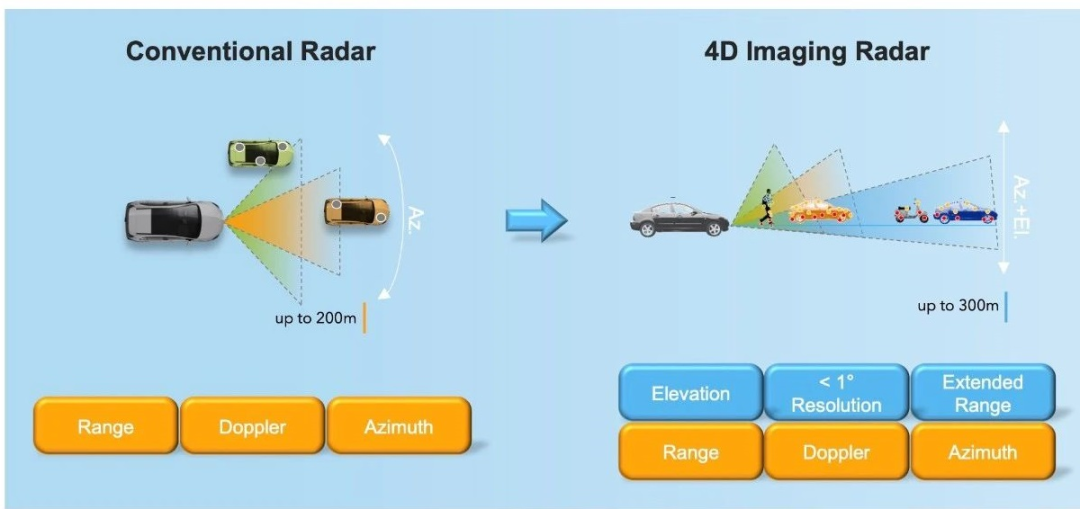

相機毫米波雷達融合的方案,毫米波穿透性強,在雨霧、沙塵等惡劣天氣下仍可穩定工作,具有全天候工作精度較高的優秀表現。此外,毫米波雷達硬件成本適中,其成本僅為激光雷達的1/3以下,且產業鏈成熟,適合規模化量產。

基于以上特點,毫米波雷達相機融合的方案成為了行業新趨勢。基于AI的融合算法,如前融合點云投影、后融合目標級關聯等逐步成熟。

行業毫米波雷達相機融合方案

輔助駕駛行業內,4D毫米波雷達相機融合方案正在加速落地,各頭部車企都有相應的布局和應用:

OEM廠商A:采用多模態融合架構,結合攝像頭、4D成像雷達和激光雷達。通過前融合和中融合的方式,融合多模態信息。前融合于原始數據層進行融合,通過時空同步算法對齊雷達點云與圖像像素信息,提升三維重建精度;中融合于特征級進行融合,使用ResNet-FPN網絡提取圖像“占用體積”特征,并將該特征與之前的特征相融合,產生4D占用網絡,最后使用反卷積獲得體積及時序等反饋,從而實現動態以及靜態的障礙物感知,增強目標屬性的預測。多傳感器互補,具有高冗余性,且因為有雷達高度信息的加持,可以覆蓋長尾場景,如施工路段等,但多傳感器融合需要高算力支持,成本較高;

OEM廠商B:整合攝像頭、激光雷達、毫米波雷達、超聲波雷達等傳感器的數據,構建360°的環境感知能力。采用主流的BEV+Transformer技術方案,BEV負責將收集到的信息進行前融合,Transformer負責對信息進行處理。除此之外,疊加激光融合的GOD網絡,擺脫大量人工規則的約束,可以穩定識別小狗、減速帶和車庫閘門等,對于路旁異常出現的水管水柱也能進行避讓;

傳統Tier1廠商A:使用毫米波雷達相機融合的方案,聚焦模塊化設計,采用JPDA(聯合概率數據關聯)算法,將雷達目標與視覺檢測框通過IoU(交并比)和速度一致性匹配,提升目標跟蹤穩定性;通過eCalib工具實現雷達與相機的時空同步,誤差控制在+-5cm內,但該類的傳統規則融合算法迭代慢,泛化性差,較難支持高等級輔助駕駛需求。

黑芝麻智能融合團隊,采用了4D毫米波雷達和相機融合的方案,結合深度學習模型,提升了雨霧雪、黑夜、逆光等極端天氣和場景下目標檢測的準確性和穩定性,改善了異形車、遮擋目標等物體檢測的識別率,優化了上下坡、匝道等三維空間存在變化的場景中目標測距測速的精確性,顯著提升了輔助駕駛的安全性與可行性。

黑芝麻智能4D毫米波雷達相機融合方案

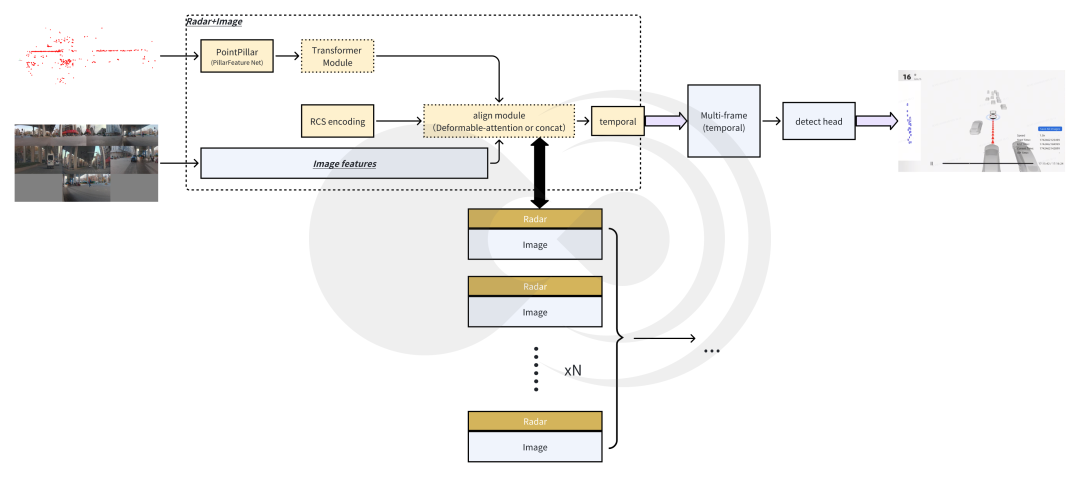

黑芝麻智能4D毫米波雷達相機融合方案,在BEV純視覺目標檢測方案基礎上,添加4D毫米波雷達特征提取分支。4D毫米波雷達點云在經過特征提取分支后,與圖像分支提取的圖像特征對齊并融合,組成時序信息,再經過目標head,輸出目標相關的信息,其總體框架如下圖所示:

黑芝麻智能4D毫米波雷達相機融合框架示意圖

4D毫米波雷達特征提取模塊

模塊使用稀疏點云作為輸入,包含3D位置信息,RCS信息,速度信息等。經過PointPillars骨干網絡提取點云的局部特征,再經過基于Transformer的骨干網絡捕獲全局信息。PointPillars可以壓縮冗余信息,提取局部特征;RCS編碼增強目標檢測的性能;Transformer強化關鍵特征,顯著提升稀疏點云的利用率。

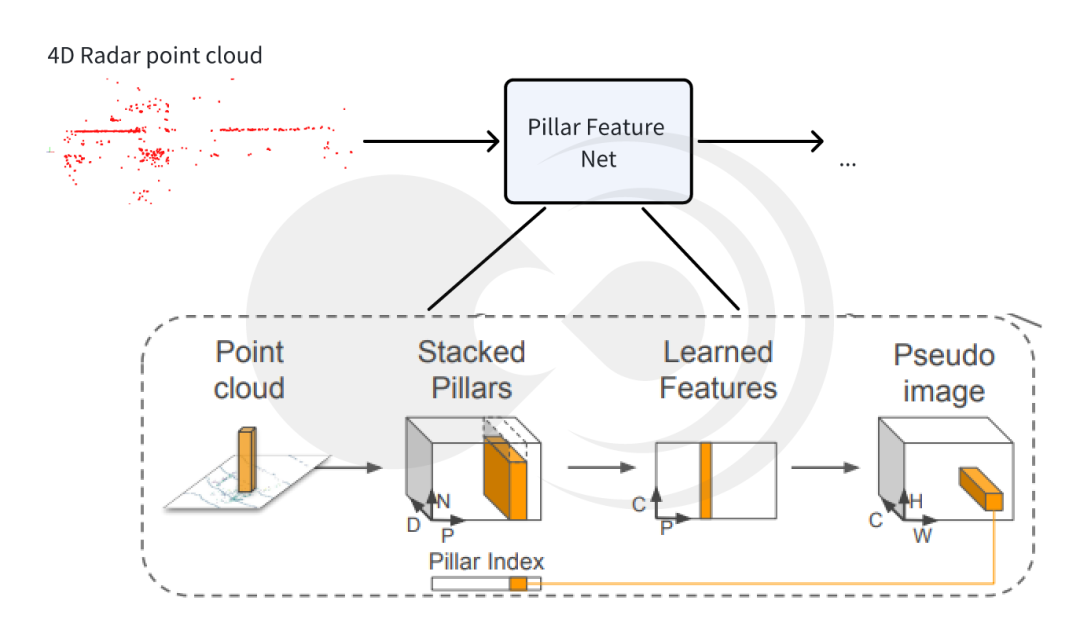

PointPillars提取點云局部特征

Pillar Feature Net提取點云特征示意圖

采用Pillar編碼的方式結構化編碼毫米波雷達,將無序的雷達點云劃分為規則的“柱狀”(Pillar)單元,每個柱體內的點云通過簡化特征(坐標、反射強度等)編碼為固定維度的特征向量。通過局部特征聚合抑制噪聲,保留有效目標信息,有效解決毫米波雷達點云稀疏且包含噪聲的問題。針對多目標檢測,柱狀劃分可以有效地捕捉分散的雷達點云(如行人、車輛),提升對小型或遠距離目標的檢測能力。

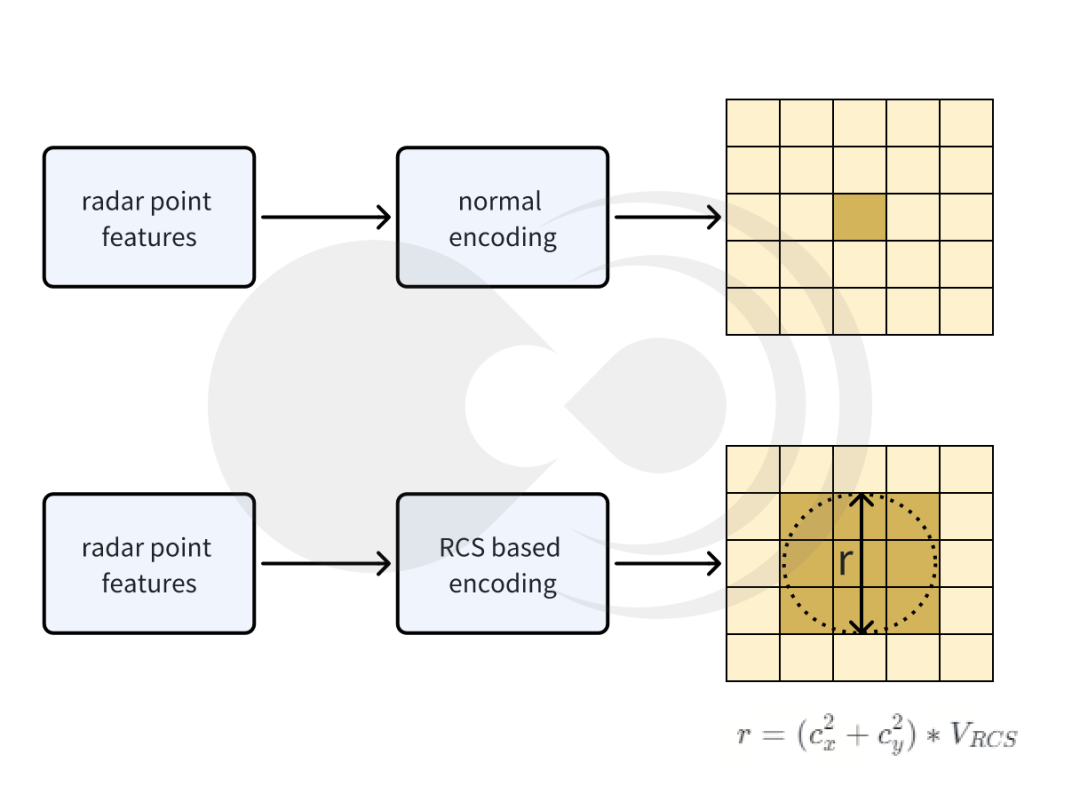

RCS編碼提升檢測性能

RSC編碼示意圖

采用基于RCS感知的BEV編碼器,利用雷達截面(RCS)能夠粗略衡量目標尺寸的特性,有效解決因雷達生成的BEV特征是稀疏的而帶來的檢測性能損失問題,即利用RCS作為目標尺寸,將一個雷達點的特征分散到BEV空間中的多個像素而不是一個像素。

Transformer捕獲全局信息

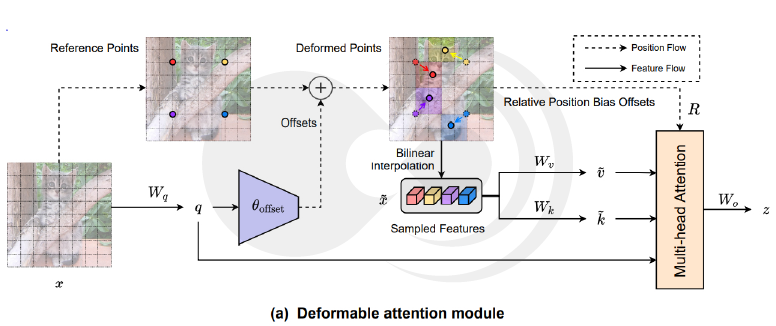

Deformable attention module

(圖片來源:《Vision Transformer with Deformable Attention》)

Transformer的子注意力機制可以跨柱體建立關聯,捕捉場景中目標之間的空間關系(如車輛與行人的相對位置),彌補傳統卷積網絡局部感受野的局限。并且采用動態權重分配的策略,根據目標重要性動態調整特征權重,例如在擁堵場景中強化相鄰車輛的特征,抑制背景干擾。

多模態特征對齊時序模塊

多模態特征間的對齊問題,一直是影響目標檢測優劣的關鍵因素。

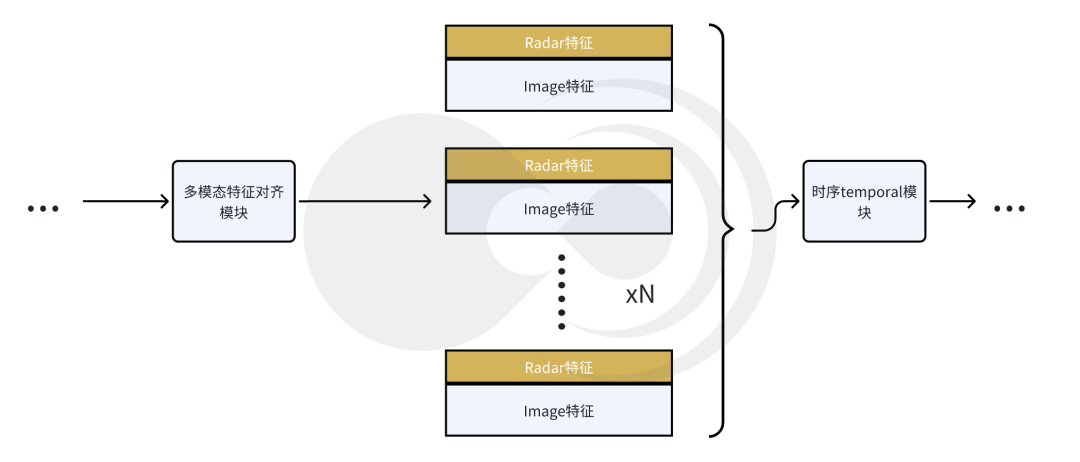

多模態特征對齊時序模塊示意圖

兼顧算力要求的多模態特征融合對齊

模塊通過接收圖像特征提取骨干網絡的圖像特征以及毫米波雷達特征提取骨干網絡的雷達特征后,通過多模態特征對齊模塊,將二者融合為一體。通過特征拼接,操作計算量極低,能夠顯著降低硬件的算力要求。并且不對原始特征進行壓縮或者變化,保留了特征的原始信息,避免信息丟失,適合需要高保真度的場景。如果需要較強的時序建模能力,且算力資源較為豐富,亦可采用多模態deformable attention的方式來實現對齊。

temporal模塊

按照時序添加temporal模塊,疊加多幀目標的feature map,能夠有效的獲取目標的時序信息,大大提升了目標時序特征的準確性和穩定性,如位置、速度等。因采用多幀特征相結合的方式,能夠有效提升遮擋目標的檢測準確度。

測試指標和結果展示

測試指標說明

模型的測試指標主要通過以下幾個方面進行對比:

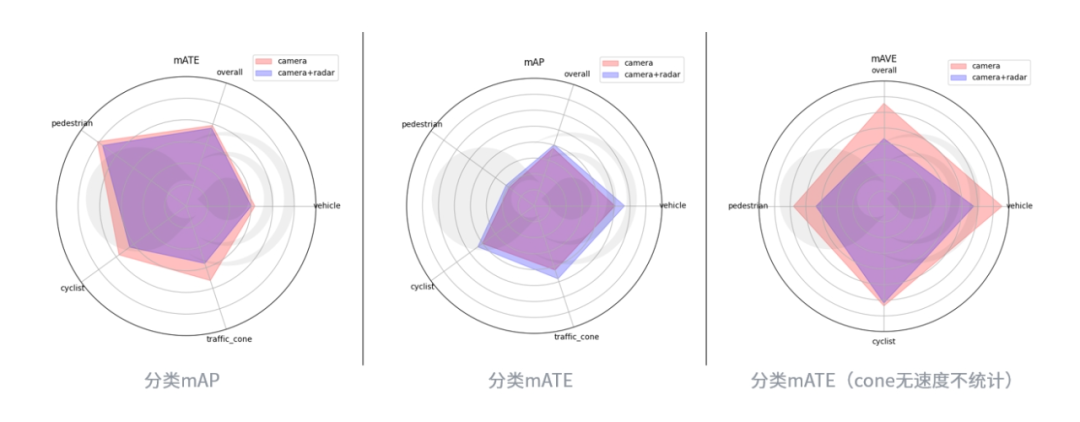

mAP:mean Average Precision,評估目標檢測模型的準確性。它計算每個類別的平均精度(AP),然后對所有類別的AP進行平均,常用于物體檢測任務,如COCO數據集評估;

mATE:mean Absolute Trajectory Error,評估物體軌跡預測精度的指標。它計算預測軌跡與真實軌跡之間的絕對誤差的平均值,常用于運動預測和計算機視覺中的跟蹤任務;

mAVE:mean Average Velocity Error,評估物體速度預測的指標。它計算預測速度與真實速度之間的誤差的平均值,常用于動態場景的分析和預測。

結果

分類測試指標

經過測試,相較于純視覺模型,4D毫米波雷達相機融合模型,在縱向100米(自車前方),橫向+-32米范圍內,mAP提升5%,mATE提升2.5%,mAVE提升明顯33.85%。

典型場景展示

在許多極端場景下,目標檢測的精度,在融合4D毫米波雷達特征后,得到了顯著提升。

逆光漏檢

逆光場景下,由于車輛和背景對比度降低,純視覺方案難以穩定檢測出目標。在融合毫米波雷達的信息后,逆光場景檢測率提升12%。

在下述例子中,前方車輛均呈現黑色紋理消失,前前大貨車純視覺方案漏檢,若前前車切出,可能因前前車目標位置速度收斂慢,導致自車急剎車,4D-radar利用其回波不受光照影響都特性,順利補回前方目標。

(0′03″處前前貨車丟失補回)

純視覺模型

4D毫米波雷達相機融合模型

遮擋漏檢

在被遮擋的情況下,純視覺方案難以檢測到明確的目標特征,因此可能會導致漏檢。在添加毫米波雷達的特征后,能夠有效提升遮擋目標的檢測率,相比于純視覺方案,提升7%。

在下述例子中,左側前方目標由于遮擋導致無法順利檢出,若左側前方目標向右cut-in自車可能無法及時響應減速。毫米波利用穿透特性,有效實時檢測間隔目標,給自車響應預留充足時間。

(0′20″左前方遮擋丟失目標補回)

純視覺模型

4D毫米波雷達相機融合模型

匝道場景

匝道場景下,由于目標和自車可能處于非同平面,純視覺系統依賴單目或雙目相機平面投影模型對目標的位置信息進行估算,易受透視畸變的影響,導致測距測速精度下降。在結合毫米波雷達的3D信息后,在非同平面專項場景下(上下坡場景),目標測距測速準確率提升9%以上。

在下述例子中,下匝道場景4D毫米波雷達相機融合方案將遠處貨車補回,并輸出更加穩定的位置、速度信息。

(0′26″前前貨車丟失補回分裂消失)

純視覺模型

4D毫米波雷達相機融合模型

4D毫米波雷達具有全天候,成本適中,產業鏈較成熟等特點,目前正在成為行業內多模態融合目標檢測任務中的重要傳感器。實驗結果表明,4D毫米波雷達相機融合方案,相較于純視覺目標檢測方案,有效提升了目標檢測的精度,改善了純視覺模型測距測速的性能,特別是極端場景下模型的表現,如光線局限場景、遮擋場景以及非同平面場景等,提升輔助駕駛的駕駛安全性。

-

傳感器

+關注

關注

2564文章

52749瀏覽量

765023 -

雷達

+關注

關注

50文章

3098瀏覽量

119714 -

感知算法

+關注

關注

0文章

20瀏覽量

7788 -

毫米波

+關注

關注

21文章

1970瀏覽量

65829 -

黑芝麻智能

+關注

關注

1文章

197瀏覽量

3821

原文標題:開芯課堂丨視覺與4D毫米波前融合感知算法設計

文章出處:【微信號:BlackSesameTech,微信公眾號:黑芝麻智能】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

黑芝麻智能視覺與4D毫米波雷達前融合算法介紹

黑芝麻智能視覺與4D毫米波雷達前融合算法介紹

評論