作者:嚴廣宇

沐曦PDE部門

1引言:什么是具身智能?

你有沒有想過,AI 不再只是待在屏幕里回答問題、寫代碼,而是真真正正地走進現實世界,像人一樣感知、決策、行動?

想象在一個智能倉庫,機器人自主規劃路徑,把包裹從貨架上取下來打包發貨。再想象一下家里的掃地機器人,未來可能不只是掃地,而是能幫你收拾房間、洗碗、開窗通風。這一系列動作的背后就是具身智能(Embodied AI),它的核心就是:讓 AI 擁有身體,擁有“行動的智能”,具備理解環境、感知人類指令、完成一連串操作的能力。

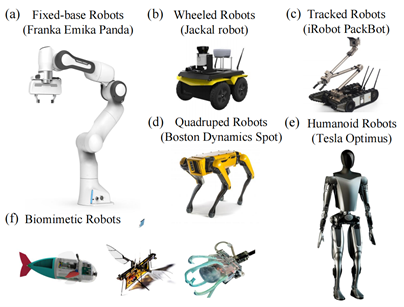

具體而言,具身智能是人工智能、機器人學、認知科學的交叉領域, 主要研究如何使機器人具備類似人類的感知、規劃、決策和行為能力[1]。不同于傳統的純計算智能(如語言模型或圖像識別),具身智能強調“身體”與環境的感知與互動,使用物理實體來感知和建模環境, 根據任務目標和實體能力進行規劃和決策, 最后使用實體的運動能力來完成任務[2],賦予了AI在現實場景中執行任務的能力。

具身智能的應用場景極其廣泛,在以下領域中都有它的身影:

工業自動化:機械臂完成精準抓取、裝配、焊接等任務,提高生產效率。

家庭服務:服務機器人實現清掃、送物、協助老人等功能,改善生活質量。

醫療輔助:手術機器人、康復機器人幫助醫生完成復雜操作或患者康復訓練。

探索與救援:自主機器人進入危險區域執行探測、救援任務。

教育與娛樂:教育機器人輔助教學,陪伴機器人提供情感交互。

從“腦力型AI”(如ChatGPT、Copilot)走向“動手型AI”(如智能機械臂、家庭機器人),這是人工智能發展的必經之路。畢竟,真正聰明的 AI,不該只是“懂”,更應該能“做”。未來,隨著硬件成本降低、算法進步和數據積累,具身智能將成為智能時代的核心驅動力。

圖 1 具身智能可應用于多種形態的機器人

來源:https://arxiv.org/pdf/2407.06886.pdf

2具身智能研發的挑戰

盡管具身智能前景廣闊,但具身智能的研發仍面臨諸多挑戰,讓機器人高效學習新技能的道路并不平坦。現實中的具身智能遠比想象中更復雜,特別是在控制機械臂這樣的典型任務上,哪怕是“開個門”,對研發人員來說都是“災難三連”:

1搭建場景:在仿真環境中搭建物理場景,定義門的物理屬性、初始狀態

2設計動作:精心設計如何移動機械臂,如何抓門、門往哪開

3寫訓練代碼:編寫獎勵函數,調節超參數,通過強化學習方法進行大量訓練調優

上面每一個環節都高度依賴人工干預,開發周期長,效率低。更麻煩的是:每訓練一個新技能,就像從頭造一輛車。比如你希望機器人學會“關窗”或“遞杯子”,就得重寫仿真環境、重新配置動作參數,甚至連訓練邏輯都得重做。總結下來,具身智能的研發過程有三座大山橫在前面:

高人力成本:每個新技能的開發都需要專業團隊投入數周甚至數月時間,涉及仿真設計、動作規劃、算法調試等多個領域。

低通用性:為特定任務設計的環境、動作和獎勵函數難以復用到其他任務。

擴展性差:當任務復雜度增加(如從單一抓取到多物體協作),開發難度呈指數級上升,難以快速迭代。

所以現實中很多具身智能研究,只能聚焦于幾個固定任務,很難做到快速拓展。

3使用大語言模型,打造“智能技能生成器”

近年來大語言模型(Large Language Model,LLM)以其強大的語言理解、知識推理和代碼生成能力,在多個領域展現出革命性潛力[3]。面對上一節中提到的挑戰,我們思考:能不能把“自然語言+通用智能”的強大能力,用在具身智能開發上?是否有可能利用AI自身的智能,自動化技能開發流程,從而大幅降低成本、提升效率?

為此,我們參考了多個使用LLM的優秀開源方案[4],并將其與具身智能的開發流程相結合。最終我們推出了:沐曦具身智能仿真生成系統,實現從任務描述到技能學習的端到端自動化。

具體而言,我們使用具備強大語言理解與通用知識推理能力的 LLM,結合具身智能中機械臂任務的特性,設計了一系列高質量的提示詞 Prompt 模板,讓它能夠自主生成新技能任務,理解任務需求,將自然語言任務描述轉化為可執行的仿真任務,生成任務所需的全部內容,實現了機械臂技能開發流程的高度自動化。

簡單來說,它有點像一個“具身任務魔法師”——你告訴它要完成什么任務,它就能自動生成整套執行方案,從場景到動作,從獎勵函數到仿真環境,全都一步到位,徹底改變了具身智能技能開發的范式。

本系統能夠自動完成以下任務:

| 任務 | 描述 |

| 生成技能任務描述 | 根據目標物體,生成多個機械臂與之相關的任務描述 |

| 生成仿真環境配置 | 生成目標物體在MuJoCo環境中的位置與屬性 |

| 生成任務操作步驟 | 根據任務技能與目標物體,將任務分解為機械臂可執行的動作序列 |

| 生成元動作序列 | 將復雜動作拆解為機械臂的基本動作單元 |

| 生成獎勵函數代碼 | 生成強化學習所需的獎勵函數邏輯代碼 |

| 生成物體初始狀態 | 生成物體的初始狀態(如關節角度) |

上面整個過程中不再需要你手動寫 MuJoCo仿真平臺所需的場景XML配置、設置各種配置參數、調整代碼邏輯。你只需要告訴LLM場景中有哪些可操作的物體,系統就能自動生成多個機械臂操作不同物體的任務,輸出每個任務完整的訓練配置,然后調用 MuJoCo 引擎啟動仿真,機械臂就開始一一學習這些技能,是不是有點“AI 的魔法感”?

為了便于演示,本系統以廚房場景來展示整個的自動化執行流程,其場景如下圖2所示。

圖 2 廚房虛擬場景樣例圖

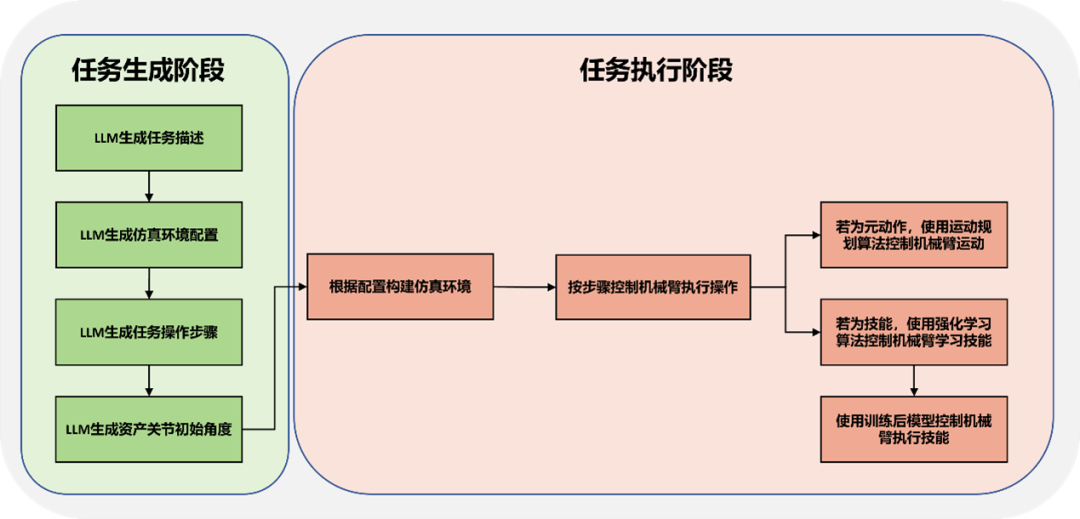

本系統整個流程可以總結為兩個階段:任務生成階段和任務執行階段,具體內容如圖3所示。

圖 3 沐曦具身智能仿真生成系統框架

3.1任務生成階段

在任務生成階段,本系統會通過精心設計的提示詞,多次調用大語言模型,逐步生成新技能任務描述、任務對應的仿真環境配置、機械臂執行任務的操作步驟、仿真環境中物體初始配置參數等信息。每個步驟的具體作用如下:

技能任務描述生成

LLM根據場景中多個不同物體的屬性信息,生成多個機械臂操作物體的任務信息描述。任務描述中包含:任務名、任務詳細描述、機械臂操作的物體名稱、機械臂與物體交互的關節名等。針對廚房場景,其生成的部分樣例如下:

Task Name: Open Microwave Door Description: The robotic arm willopenthe microwave door. Additional Objects: None Bodies: - microdoorroot: from the semantics,thisisthe door of the microwave. The robot needs to approachthisdoorinorder toopenit. Joints: - microdoorroot_joint: from the articulation tree,thisisthe hinge joint that connects microdoorroot. Therefore, the robot needs to actuatethisjointforopening the door.

仿真環境配置生成

LLM根據生成的任務描述信息、不同物體的屬性信息,生成物體在仿真環境中的多項配置信息,包括:物體名稱、物體的空間位置、是否可移動等。LLM以YAML格式返回生成的配置信息。針對打開微波爐門任務,其生成樣例如下:

- center: (0.6, 0.4, 1.6) movable:false name: microwave type: xml - center: (0.82, 0.16, 2.3) movable:false name: slidecabinet type: xml - center: (0.6, 0.4, 2.141) movable:true name: mug type: xml - task_description: The robotic arm will open the microwave door task_name: Open Microwave Door

任務操作步驟生成

LLM根據生成的任務描述信息、不同物體的屬性信息、機械臂具備的元動作函數列表、可從仿真環境中獲取狀態信息的函數列表,生成機械臂完成該任務所需執行的一系列操作步驟。對于每個步驟,LLM需要判斷該操作的類型,包括:{元動作、強化學習動作}。若為元動作,則生成機械臂執行的元動作序列,若為強化學習動作,則生成使用強化學習算法訓練學習該技能所需獎勵函數Python邏輯代碼。針對打開滑動柜門任務,其生成的工作步驟樣例如下:

substep1: move to the slidecabinet door substep2: grasp the slidecabinet door substep3: open the slidecabinet door substep4: release the slidecabinet door

物體初始狀態生成

LLM根據生成的任務描述信息、不同物體的屬性信息,生成該物體在仿真環境初始化時,各關節角度的默認值。如:開滑動柜門任務中,門的關節應初始化為關閉狀態(0表示關閉,1表示開啟),其生成樣例如下:

jointvalues slidedoor_joint:0

3.2任務執行階段

在任務生成階段完成多項生成任務后,本系統即可根據LLM生成環境配置信息、操作步驟信息、關節角度值,調用MuJoCo仿真引擎構建虛擬環境,按生成步驟控制機械臂運動,執行任務并完成強化學習訓練。其中,包括執行元動作,或調用強化學習算法進行訓練與推理。最終系統將整個任務的操作過程通過仿真引擎渲染保存為視頻,如下圖4所示。

圖4 機械臂技能學習操作演示

4和傳統開發比,新方案優勢是什么?

與傳統手動開發相比,新方案具有以下多個突破性優勢。這意味著,即便你不是機器人專家,也能用大語言模型為機械臂設計新任務;對于專業團隊而言,也可以極大提升開發效率,加快原型驗證,釋放更多創意空間。

| 對比維度 | 傳統流程 | 自動化系統 |

| 開發周期 | 數周起步 | 數小時即可構建原型 |

| 人力需求 | 多名工程師協作 | 單人即可完成 |

| 擴展任務 | 手動重復工作 | 可快速迭代新任務 |

| 復用性 | 低 | 高度模塊化、結構統一 |

| 技術門檻 | 專業背景要求高 | 語言驅動、門檻低 |

新方案具備以下技術亮點:

提示工程:我們設計了一套針對具身任務的高質量提示詞模板,確保LLM生成內容的準確性和一致性。例如,提示詞會引導LLM明確物體屬性(如“關微波爐門任務,門應該處于開啟狀態”)和機械臂動作邏輯(如“先靠近門把手,再閉合夾爪”)。

模塊化生成:系統將任務分解為環境、動作、獎勵等模塊,分別生成并整合,既保證了生成內容的結構化,又便于調試和復用。

與MuJoCo深度集成:系統生成的配置能直接兼容MuJoCo仿真引擎,支持高效的物理仿真和實時渲染。

端到端訓練:通過生成的獎勵函數和動作序列,系統支持強化學習的全流程自動化,機器人可在仿真中快速收斂到最優策略。

最重要的一點,本系統完美適配沐曦C系列GPU產品,可在曦云C500 GPU上高效進行LLM大模型推理、以及多種強化學習算法的訓練&推理。

5為什么開源?

我們希望更多人一起

創造具身智能!

雖然本系是以廚房場景機械臂操作物體為例,但參照本系統中方法,可以便捷拓展到輪式機器人、四足機器人等人形機器人,支持更復雜的多任務學習場景。例如,未來可實現“機器人自主整理房間”或“協作完成生產線裝配”等高級任務。

我們相信,具身智能的未來,是“人人可用、人人可創”的智能。

為了推動具身智能領域的進步,我們已經正式開源完整的沐曦具身智能仿真生成系統方案,所有代碼可用,且示例齊全,歡迎所有開發者、研究者、愛好者嘗試、改進、拓展。

開源地址

GitHub:https://github.com/MetaX-MACA/Embodied_AI_Simulation

Gitee:https://gitee.com/metax-maca/Embodied_AI_Simulation

6結語

過去十年,AI 靠著“認字、聽話、寫代碼”帶來了巨大變革;而下一個十年,AI 將走出屏幕,走入工廠、家庭、醫院和每一個現實場景。具身智能就是連接這兩者的橋梁,它既有 AI 的大腦,也擁有對世界的“動手能力”。我們希望這套系統,能讓更多人參與到具身智能的探索中來。不再困在復雜的開發流程里,不再被高門檻擋在門外!

-

機器人

+關注

關注

213文章

29587瀏覽量

212071 -

AI

+關注

關注

88文章

34691瀏覽量

276644 -

人工智能

+關注

關注

1805文章

48873瀏覽量

247698 -

具身智能

+關注

關注

0文章

127瀏覽量

424

原文標題:【智算芯聞】具身智能的新范式:利用AI智能體加速機器人學習技能

文章出處:【微信號:沐曦MetaX,微信公眾號:沐曦MetaX】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

沐曦具身智能仿真生成系統方案

沐曦具身智能仿真生成系統方案

評論