圖畫總是只能表現(xiàn)事物瞬間的形象,而動(dòng)畫則需要逐幀手繪,費(fèi)時(shí)費(fèi)力,人工智能是否能夠幫助我們解決這一困難?近日,來(lái)自加拿大約克大學(xué)、Ryerson 大學(xué)的研究者們提出了使用「雙流卷積神經(jīng)網(wǎng)絡(luò)」的動(dòng)畫生成方法,其參考了人類感知?jiǎng)討B(tài)紋理畫面的雙路徑模式。該動(dòng)畫生成模型可以參考相關(guān)視頻,讓一張靜態(tài)圖片變成效果逼真的動(dòng)畫。目前,該研究的論文已被 CVPR 2018 大會(huì)接收,相關(guān)代碼也已公開。

動(dòng)畫生成效果展示

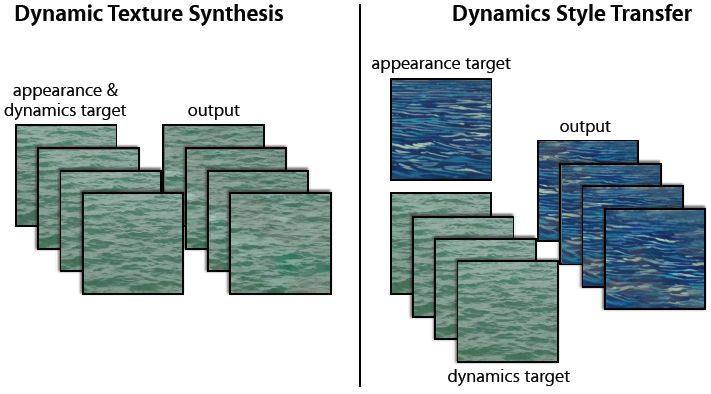

很多常見的時(shí)序視覺模式使用組成元素的外觀和動(dòng)態(tài)(即時(shí)序模式變化)的集合進(jìn)行描述。此類模式包括火、搖曳的樹木和波浪起伏的水。長(zhǎng)期以來(lái),理解和特征化這些時(shí)序模式是人類感知、計(jì)算機(jī)視覺和計(jì)算機(jī)制圖領(lǐng)域感興趣的問題。之前的研究給這些模式起了很多名字,如渦流運(yùn)動(dòng)(turbulent-flow motion)[17]、時(shí)序紋理(temporal texture)[30]、時(shí)變紋理(time-varying texture)[3]、動(dòng)態(tài)紋理 [8]、紋理運(yùn)動(dòng)(textured motion)[45] 和時(shí)空紋理(spacetime texture)[7]。本論文作者使用「動(dòng)態(tài)紋理」(dynamic texture)。該研究提出從外觀和時(shí)序動(dòng)態(tài)的角度對(duì)動(dòng)態(tài)紋理進(jìn)行因子分析。然后使用因子分解結(jié)果完成基于示例紋理輸入的動(dòng)態(tài)紋理合成,從而生成新型動(dòng)態(tài)紋理實(shí)例。它還產(chǎn)生了一種新型風(fēng)格遷移形式,目標(biāo)外觀和動(dòng)態(tài)可來(lái)自不同來(lái)源,如圖 1 所示。

圖 1:動(dòng)態(tài)紋理合成。(左)給出一個(gè)輸入動(dòng)態(tài)紋理作為目標(biāo),本文提出的雙流模型能夠合成一個(gè)新的動(dòng)態(tài)紋理,保留目標(biāo)的外觀和動(dòng)態(tài)特征。(右)雙流模型使合成結(jié)合一個(gè)目標(biāo)的紋理外觀和另一個(gè)目標(biāo)的動(dòng)態(tài),從而產(chǎn)生二者的合成品。

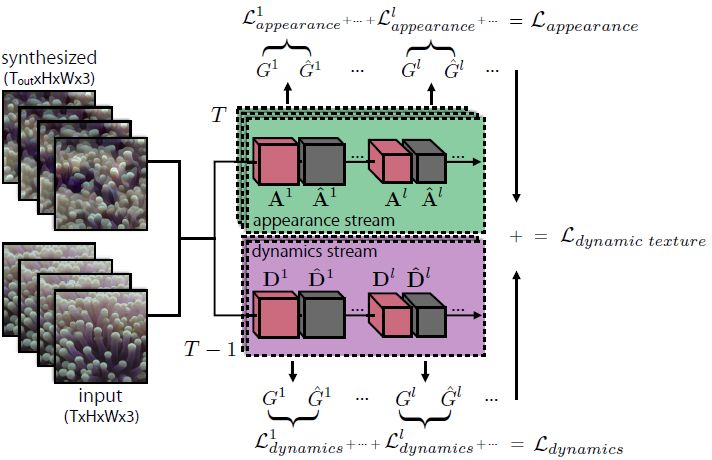

本研究提出的模型由兩個(gè)卷積網(wǎng)絡(luò)(ConvNet)構(gòu)成——外觀流和動(dòng)態(tài)流,二者分別經(jīng)過預(yù)訓(xùn)練,用于目標(biāo)識(shí)別和光流預(yù)測(cè)。與空間紋理研究 [13, 19, 33] 類似,本文根據(jù)每一個(gè)流的濾波器輸出的時(shí)空數(shù)據(jù)集,總結(jié)輸入動(dòng)態(tài)紋理。外觀流建模輸入紋理每一幀的外觀,動(dòng)態(tài)流建模時(shí)序動(dòng)態(tài)。合成過程包括優(yōu)化隨機(jī)初始化的噪聲模式,以使每個(gè)流的時(shí)空數(shù)據(jù)與輸入紋理的時(shí)空數(shù)據(jù)相匹配。該架構(gòu)受到人類感知和神經(jīng)科學(xué)的啟發(fā)。具體來(lái)說,心理物理學(xué)研究 [6] 顯示人類能夠感知?jiǎng)討B(tài)紋理的結(jié)構(gòu),即使是在沒有外觀提示的情況下,這表明兩個(gè)流是獨(dú)立的。類似地,雙流假設(shè) [16] 從兩個(gè)路徑建模人類視覺皮層:腹側(cè)流(負(fù)責(zé)目標(biāo)識(shí)別)和背側(cè)流(負(fù)責(zé)運(yùn)動(dòng)處理)。

本文提出的對(duì)動(dòng)態(tài)紋理的雙流分析也被應(yīng)用于紋理合成。研究者考慮了大量動(dòng)態(tài)紋理,并展示了其方法能夠生成新型高質(zhì)量樣本,匹配輸入樣本的逐幀外觀和時(shí)序變化。此外,外觀和動(dòng)態(tài)的因子分解還產(chǎn)生了一種新型的風(fēng)格遷移形式,一個(gè)紋理的動(dòng)態(tài)可以與另一個(gè)紋理的外觀結(jié)合起來(lái)。我們甚至可以使用單個(gè)圖像作為外觀目標(biāo)來(lái)完成該操作,使靜態(tài)圖像變成動(dòng)畫。最后,研究者通過大量用戶調(diào)研驗(yàn)證了其生成紋理的逼真程度。

技術(shù)方法

本文提出的雙流方法包括外觀流(表示每一幀的靜態(tài)(紋理)外觀)和動(dòng)態(tài)流(表示幀與幀之間的時(shí)序變化)。每個(gè)流包括一個(gè)卷積神經(jīng)網(wǎng)絡(luò),其激活數(shù)據(jù)被用于特征花動(dòng)態(tài)紋理。合成動(dòng)態(tài)紋理是一個(gè)目標(biāo)為匹配激活數(shù)據(jù)的優(yōu)化問題。本文提出的動(dòng)態(tài)紋理合成方法見圖 2。

圖 2:雙流動(dòng)態(tài)紋理生成。Gram 矩陣集表示紋理的外觀和動(dòng)態(tài)。匹配這些數(shù)據(jù)才能實(shí)現(xiàn)新紋理的生成和紋理之間的風(fēng)格遷移。

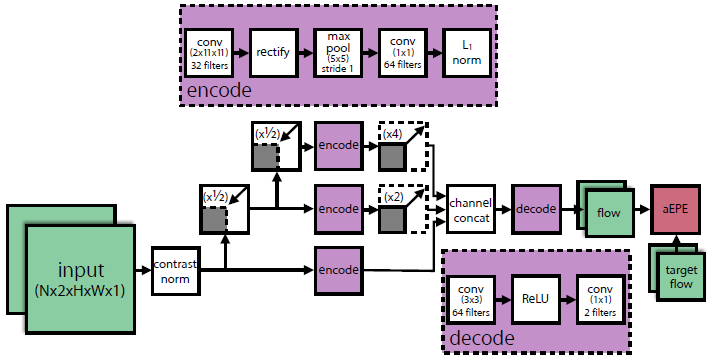

圖 3:動(dòng)態(tài)流卷積神經(jīng)網(wǎng)絡(luò)。該 ConvNet 基于面向時(shí)空的能量模型 [7,39],同時(shí)經(jīng)過光流預(yù)測(cè)的訓(xùn)練。圖中顯示了三個(gè)擴(kuò)展(scale),實(shí)踐中研究者使用了五個(gè)擴(kuò)展。

實(shí)驗(yàn)結(jié)果

(動(dòng)態(tài))紋理合成的目標(biāo)是讓計(jì)算機(jī)生成人類觀察者無(wú)法區(qū)分是否為真實(shí)圖像的樣本。該研究同時(shí)也展示了各種合成結(jié)果,以及大量用戶調(diào)研,以定量評(píng)估新模型生成圖像的逼真程度。由于生成圖像隨時(shí)間變化的特性,本研究的結(jié)果多為視頻展示。研究人員表示,該雙流架構(gòu)是由 TensorFlow 實(shí)現(xiàn)的,并使用 NVIDIA Titan X(Pascal)GPU 生成結(jié)果,圖像合成的時(shí)間介于 1-3 小時(shí)之間,每次生成 12 幀,圖像分辨率為 256×256。

摘要:本論文提出了一個(gè)用于動(dòng)態(tài)紋理合成的雙流模型。我們的模型基于兩個(gè)預(yù)訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)(ConvNet),分別針對(duì)兩個(gè)獨(dú)立任務(wù):目標(biāo)識(shí)別、光流預(yù)測(cè)。給定一個(gè)輸入動(dòng)態(tài)紋理,來(lái)自目標(biāo)識(shí)別卷積神經(jīng)網(wǎng)絡(luò)的濾波器響應(yīng)數(shù)據(jù)壓縮輸入紋理每一幀的外觀,而來(lái)自光流卷積神經(jīng)網(wǎng)絡(luò)的數(shù)據(jù)會(huì)對(duì)輸入紋理的動(dòng)態(tài)進(jìn)行建模。為了生成全新的紋理,隨機(jī)初始化輸入序列經(jīng)過優(yōu)化后,用于匹配輸入紋理的數(shù)據(jù)與每個(gè)流的特征數(shù)據(jù)。受到近期關(guān)于圖像風(fēng)格遷移的啟發(fā),同時(shí)受益于本文提出的雙流模型,我們還嘗試合成一種紋理的外觀與另一種紋理的動(dòng)態(tài),以生成全新的動(dòng)態(tài)紋理。實(shí)驗(yàn)表明,我們提出的方法可以生成全新的、高質(zhì)量樣本,可匹配輸入紋理的逐幀外觀及其隨時(shí)間的變化。最后,我們通過深入的用戶研究,對(duì)新的紋理合成方法進(jìn)行量化評(píng)估。

-

人工智能

+關(guān)注

關(guān)注

1805文章

48863瀏覽量

247632 -

計(jì)算機(jī)視覺

+關(guān)注

關(guān)注

9文章

1708瀏覽量

46637

原文標(biāo)題:用AI讓靜圖變動(dòng)圖:CVPR熱文提出動(dòng)態(tài)紋理合成新方法

文章出處:【微信號(hào):gh_ecbcc3b6eabf,微信公眾號(hào):人工智能和機(jī)器人研究院】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

分享一種中斷輸入和動(dòng)態(tài)顯示的新方法

虛擬環(huán)境中軟體的包圍盒更新方法分析

基于區(qū)域紋理合成的圖像修補(bǔ)算法

虛擬環(huán)境中軟體的包圍盒更新方法分析

基于Wang Tiles的幾何紋理合成

一種基于曲面紋理合成的改進(jìn)方法

一種求解動(dòng)態(tài)及不確定性優(yōu)化問題的新方法

并聯(lián)APF直流側(cè)電壓選擇新方法

VLSI系統(tǒng)設(shè)計(jì)的最新方法

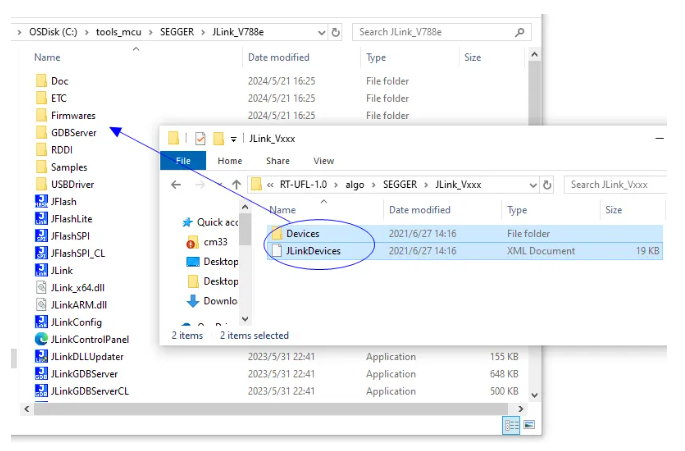

實(shí)踐JLink 7.62手動(dòng)增加新MCU型號(hào)支持新方法

動(dòng)態(tài)紋理合成新方法,由“靜”至“動(dòng)”

動(dòng)態(tài)紋理合成新方法,由“靜”至“動(dòng)”

評(píng)論