作者:算力魔方創始人/英特爾創新大使劉力

一,引言

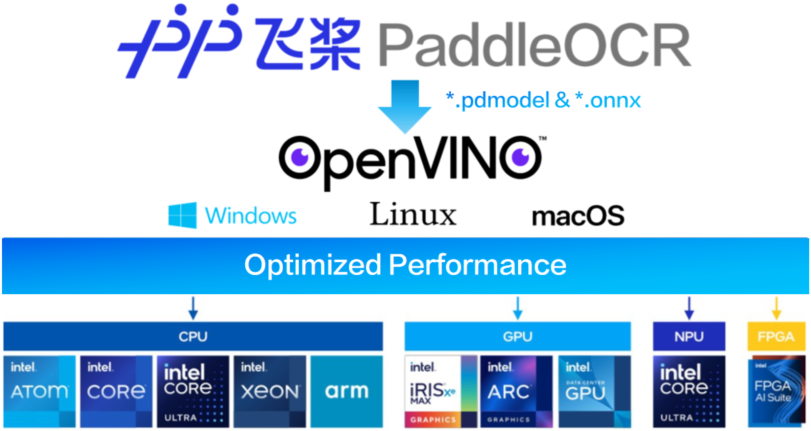

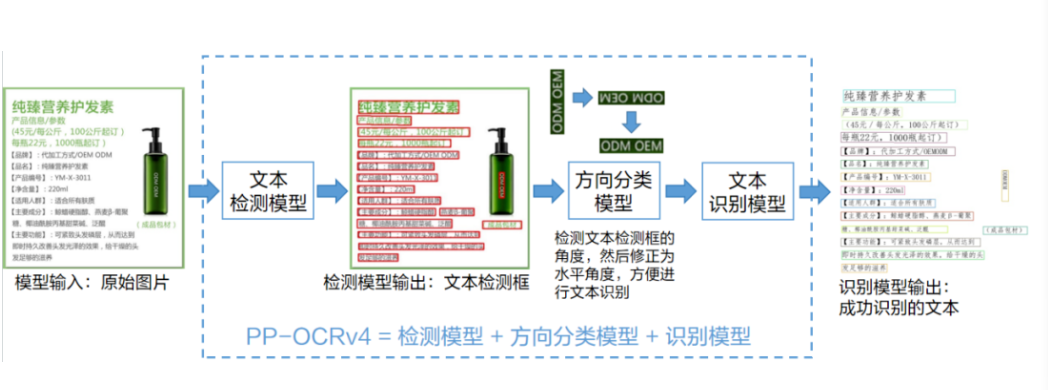

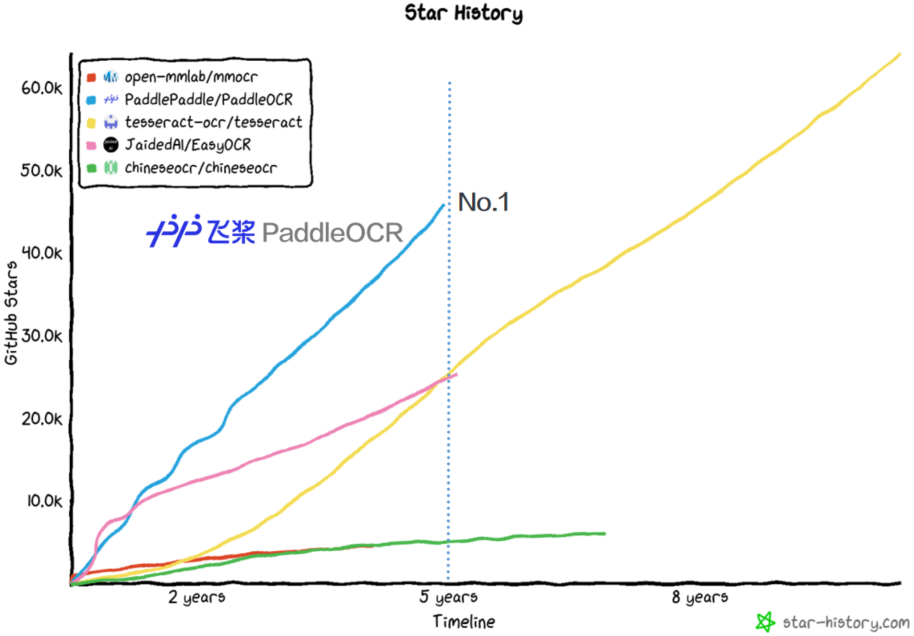

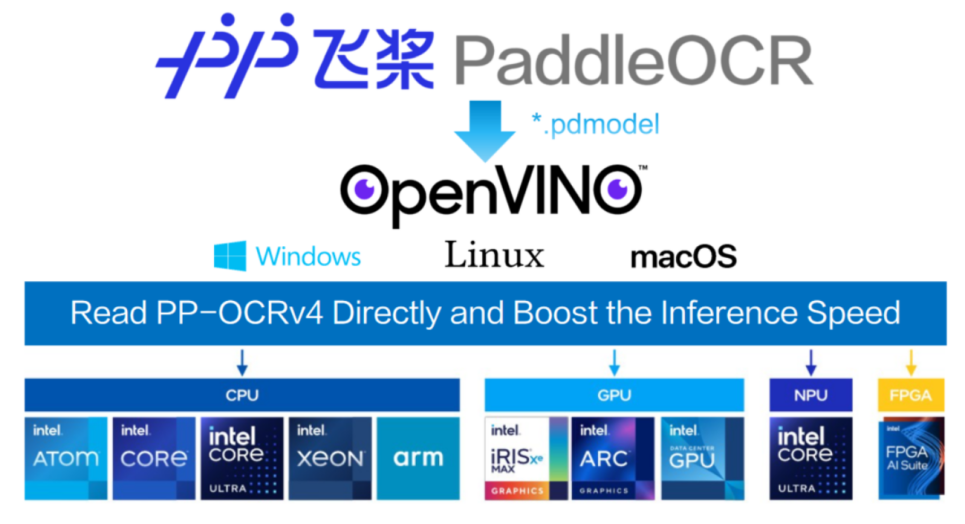

隨著人工智能技術的快速發展,光學字符識別(OCR)技術已從傳統的模式識別方法演進到基于深度學習的端到端解決方案。百度飛槳(PaddlePaddle)團隊最新推出的PP-OCRv5模型在精度和效率上實現了顯著突破,結合Intel OpenVINO工具套件的硬件加速能力,能夠為各類文檔處理場景提供更強大的支持。

二,算力魔方簡介

算力魔方是一款可以DIY的迷你主機,采用了抽屜式設計,后續組裝、升級、維護只需要拔插模塊。通過選擇不同算力的計算模塊,再搭配不同的 IO 模塊可以組成豐富的配置,適應不同場景。

性能不夠時,可以升級計算模塊提升算力;IO 接口不匹配時,可以更換 IO 模塊調整功能,而無需重構整個系統。

本文以下所有步驟將在帶有Intel i5-1165G7處理器的算力魔方上完成驗證。

三,實施步驟

1,準備工作

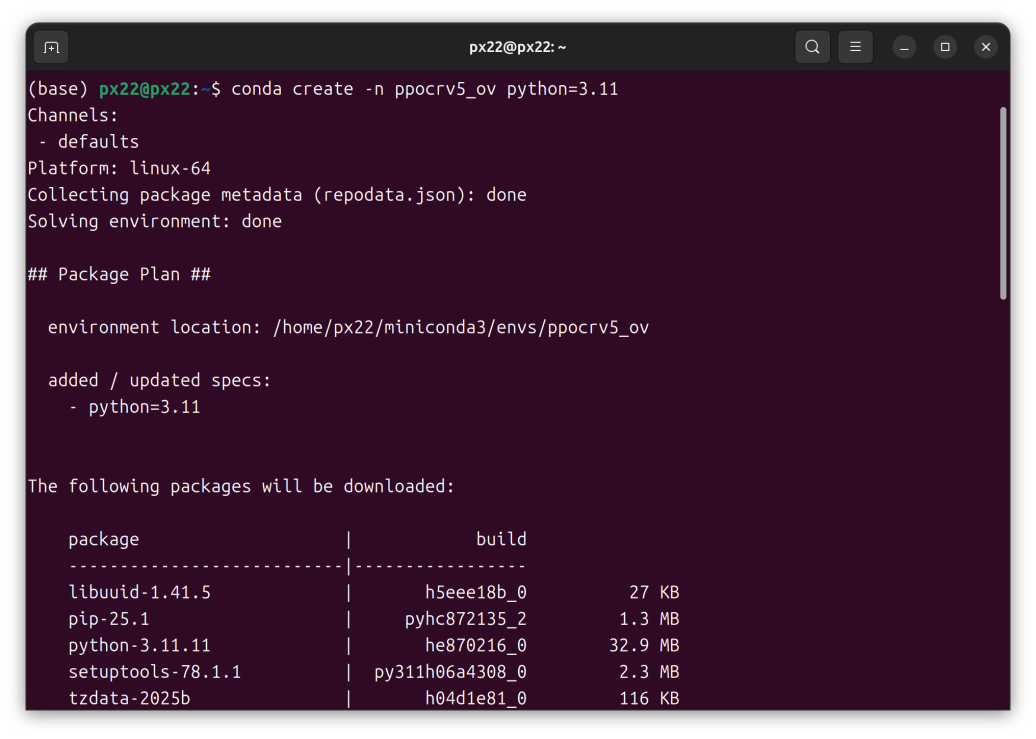

安裝Miniconda并創建虛擬環境:

conda create -n PP-OCRv5_OpenVINO python=3.11 #創建虛擬環境

conda activate PP-OCRv5_OpenVINO #激活虛擬環境

python -m pip install --upgrade pip #升級pip到最新版本

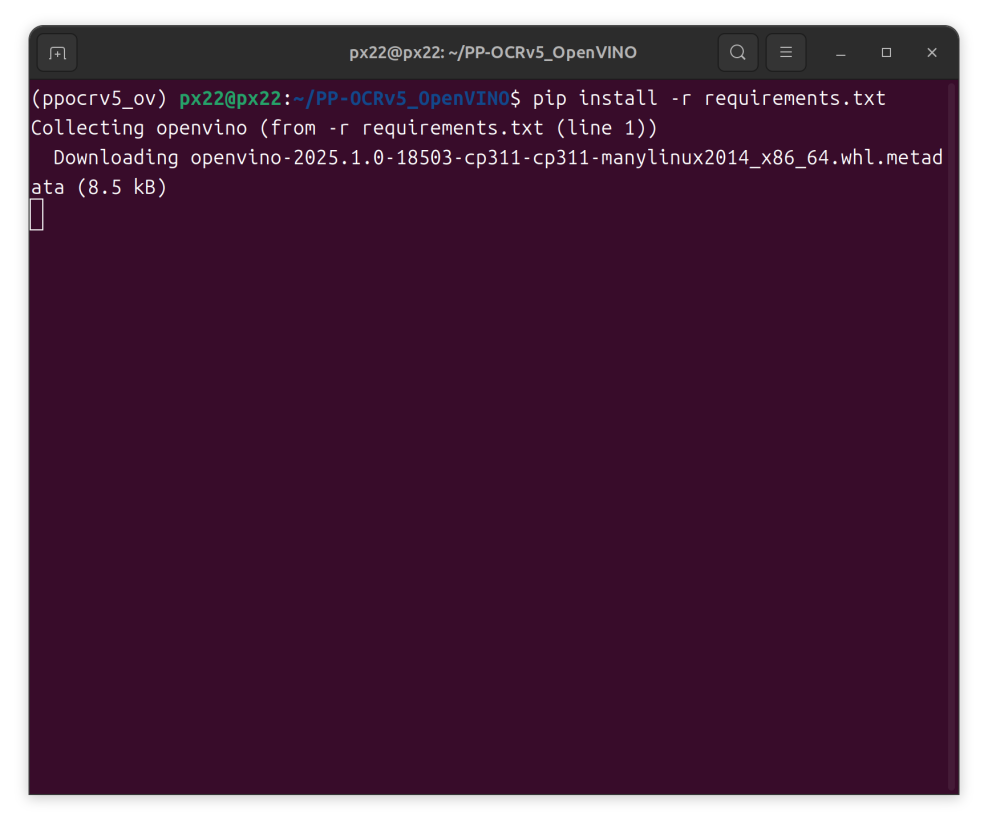

pip install -r requirements.txt # 安裝所需的軟件包

2,模型部署

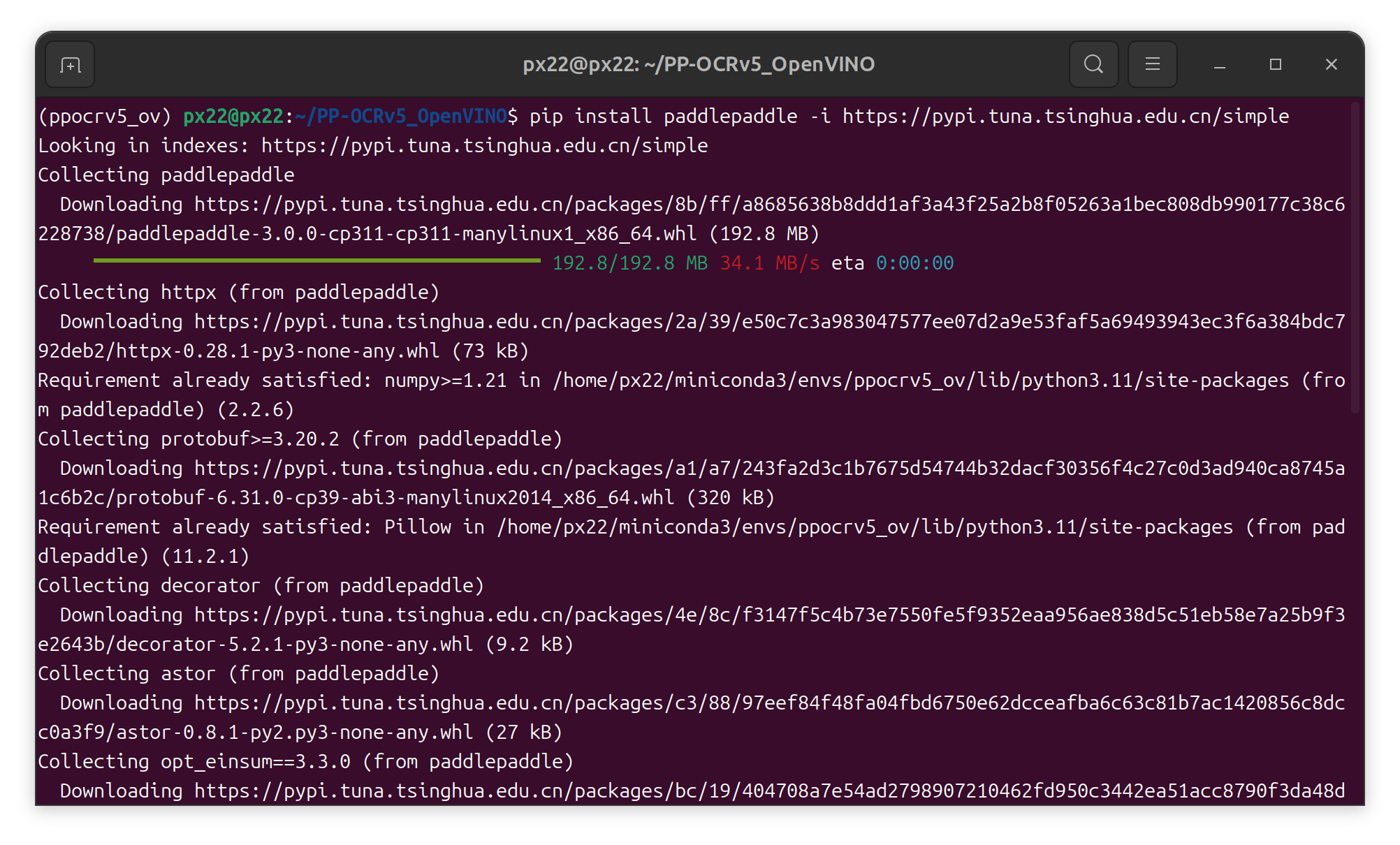

下載并安裝PaddlePaddle 和 PaddleOCRpip install paddlepaddle #安裝

paddlepaddlepip install paddleocr #安裝

paddleocrpip install onnx==1.16.0 #安裝

onnxpaddleocr install_hpi_deps cpu #調用并運行組件

3,下載PP-OCRv5_server 預訓練模型

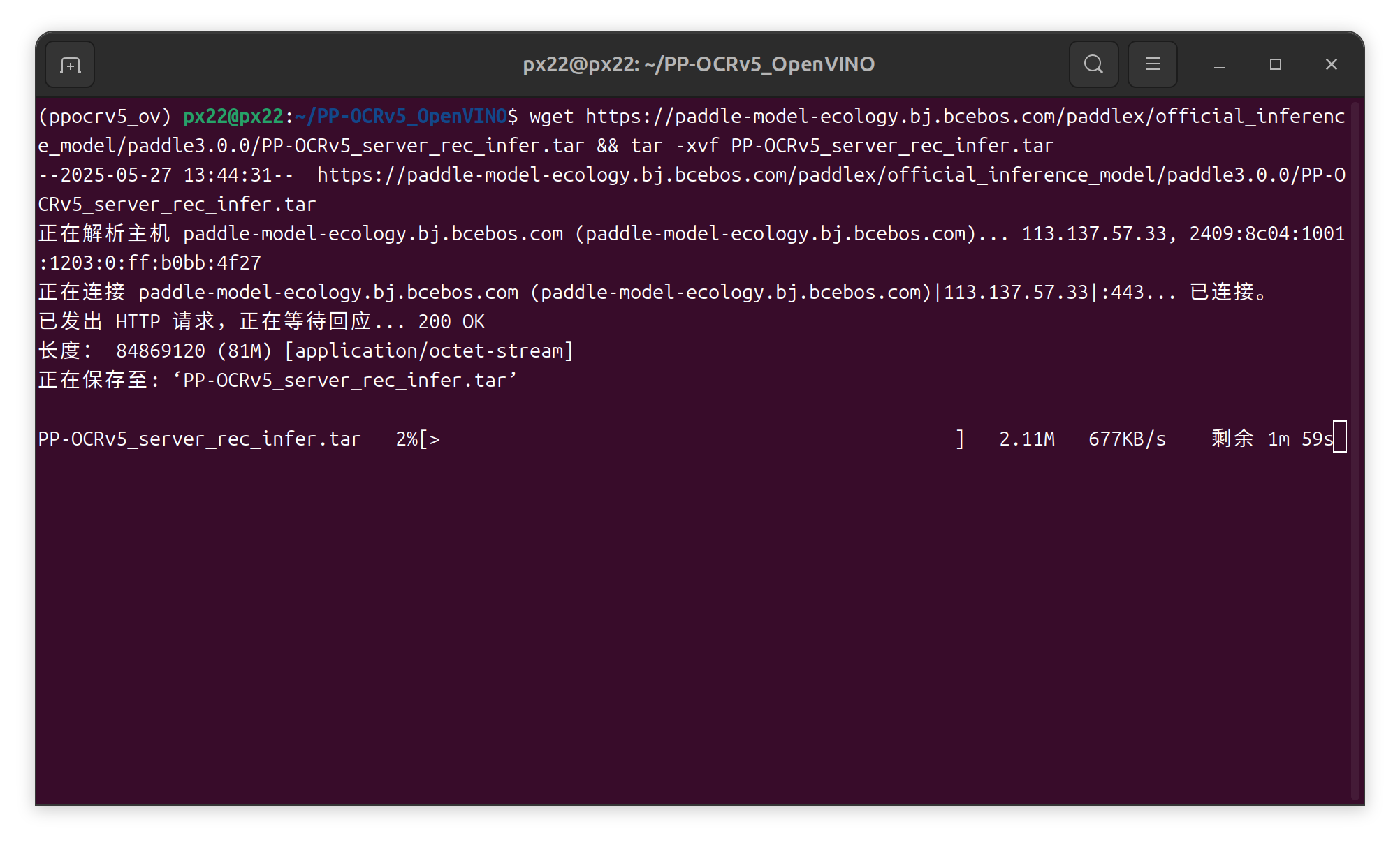

wget https://paddle-model-ecology.bj.bcebos.com/paddlex/official_inference_model/paddle3.0.0/PP-OCRv5_server_det_infer.tar && tar -xvf PP-OCRv5_server_det_infer.tar # 下載并解壓 PP-OCRv5_server_det 預訓練模型

Wget https://paddle-model-ecology.bj.bcebos.com/paddlex/official_inference_model/paddle3.0.0/PP-OCRv5_server_rec_infer.tar && tar -xvf PP-OCRv5_server_rec_infer.tar # 下載并壓縮 PP-OCRv5_server_rec 預訓練模型

wget https://paddle-model-ecology.bj.bcebos.com/paddlex/official_inference_model/paddle3.0.0/PP-LCNet_x1_0_doc_ori_infer.tar && tar -xvf PP-LCNet_x1_0_doc_ori_infer.tar # 下載并壓縮 PP-OCRv5_server_cls 預訓練模型

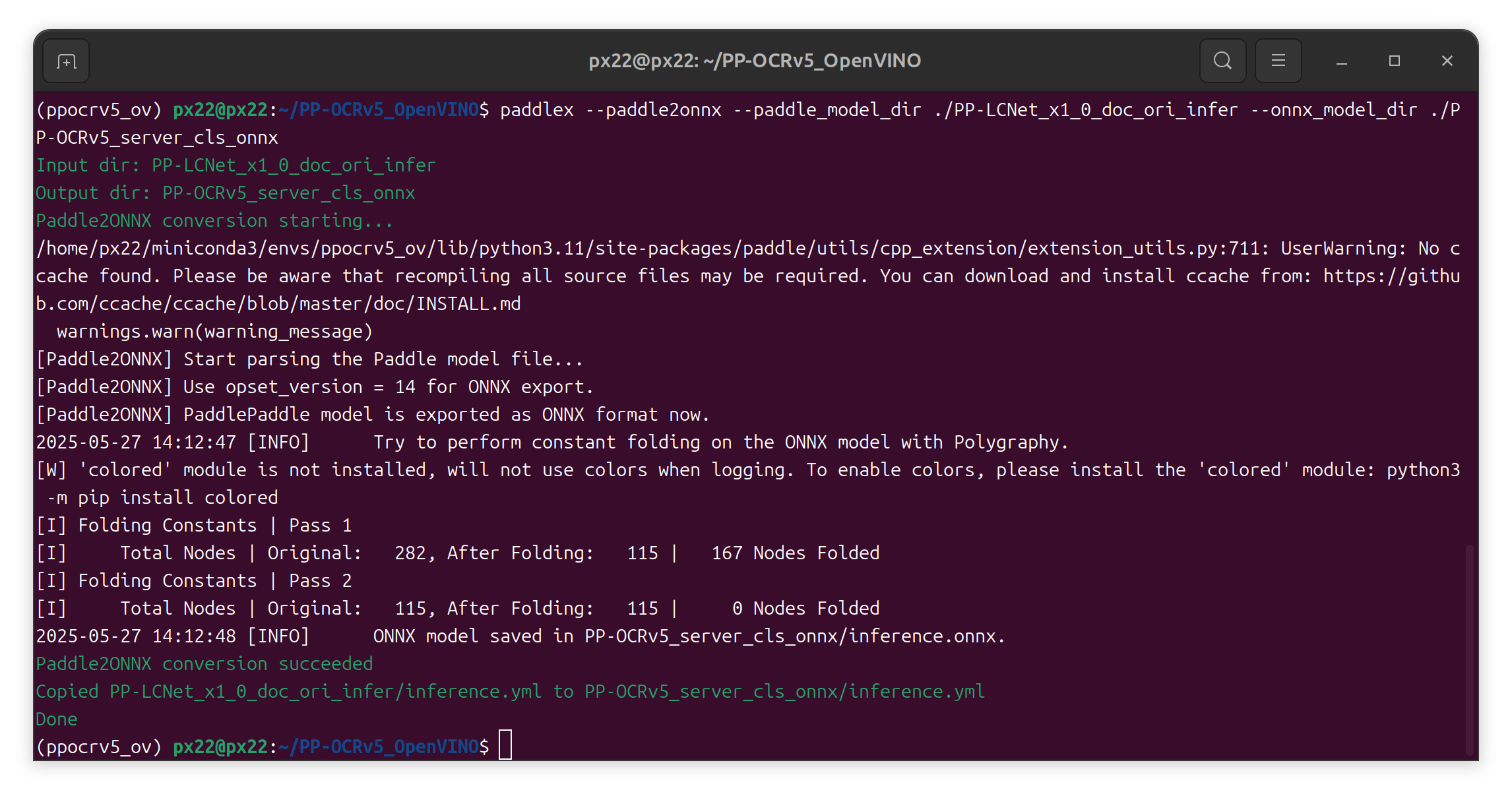

4,將PP-OCRv5_server 模型導出至 ONNX

paddlex --paddle2onnx --paddle_model_dir ./PP-OCRv5_server_det_infer --onnx_model_dir ./PP-OCRv5_server_det_onnx# 將 PP-OCRv5_server_det 導出到 ONNX

paddlex --paddle2onnx --paddle_model_dir ./PP-OCRv5_server_rec_infer --onnx_model_dir ./PP-OCRv5_server_rec_onnx# 將 PP-OCRv5_server_rec 導出到 ONNX

paddlex --paddle2onnx --paddle_model_dir ./PP-LCNet_x1_0_doc_ori_infer --onnx_model_dir ./PP-OCRv5_server_cls_onnx# 將 PP-OCRv5_server_cls 導出到 ONNX

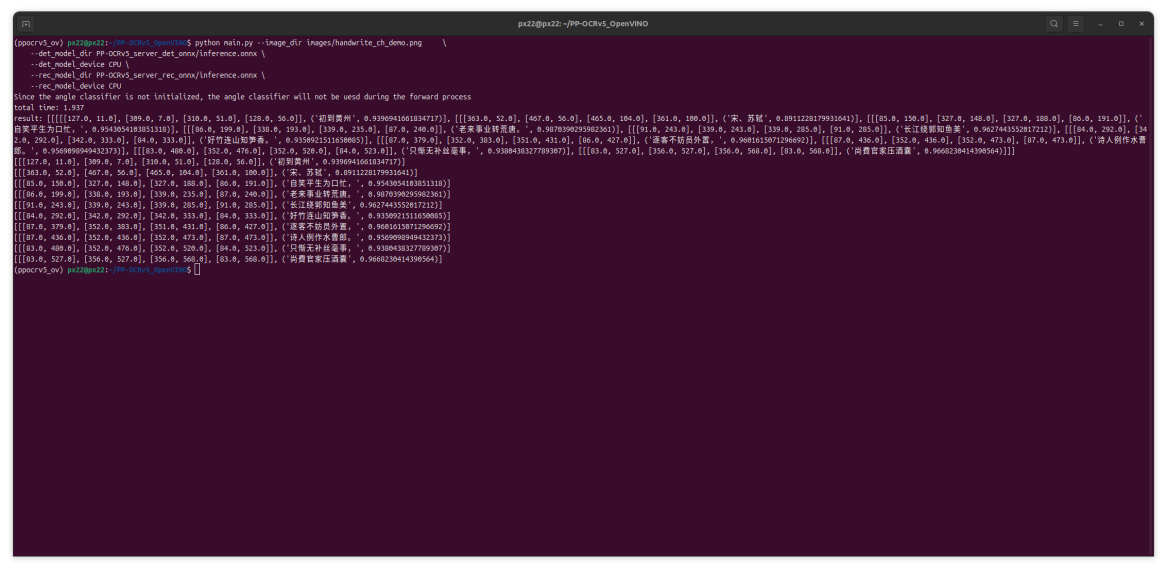

5,運行腳本

要快速開始使用 PP-OCRv5_OpenVINO 項目,請執行以下步驟:

python main.py --image_dir images/handwrite_en_demo.png #運行python代碼調用推理

--det_model_dir PP-OCRv5_server_det_onnx/inference.onnx

--det_model_device CPU

--rec_model_dir PP-OCRv5_server_rec_onnx/inference.onnx

--rec_model_device CPU

后續程序會將識別到的文本結果直接打印到控制臺

視頻鏈接:基于算力魔方與PP-OCRv5的OpenVINO智能文檔識別方案 (qq.com)

四, 結論

本文詳細介紹了基于PP-OCRv5和OpenVINO的智能文檔信息提取解決方案的部署流程。新版本的PP-OCRv5在精度和速度上都有顯著提升,結合OpenVINO的硬件加速能力,能夠實現高效的文檔處理。該方案特別適合需要處理大量文檔的企業場景,如金融票據識別、合同審核、檔案數字化等應用。

如果你有更好的文章,歡迎投稿!

稿件接收郵箱:nami.liu@pasuntech.com

更多精彩內容請關注“算力魔方?”!

審核編輯 黃宇

-

人工智能

+關注

關注

1805文章

48833瀏覽量

247330 -

OpenVINO

+關注

關注

0文章

114瀏覽量

428 -

DeepSeek

+關注

關注

1文章

785瀏覽量

1471

發布評論請先 登錄

PP-OCRv3優化策略詳細解讀

基于C#和OpenVINO?在英特爾獨立顯卡上部署PP-TinyPose模型

使用OpenVINO C# API輕松部署飛槳PP-OCRv4模型

如何在C#中部署飛槳PP-OCRv4模型

使用OpenVINO優化并部署飛槳PP-OCRv4模型

魔方復原

使用OpenVINO?在算力魔方上加速stable diffusion模型

使用OpenVINO 2024.4在算力魔方上部署Llama-3.2-1B-Instruct模型

機器人“大腦+小腦”范式:算力魔方賦能智能自主導航

C#中使用OpenVINO?:輕松集成AI模型!

基于算力魔方與PP-OCRv5的OpenVINO智能文檔識別方案

基于算力魔方與PP-OCRv5的OpenVINO智能文檔識別方案

評論