電子發(fā)燒友網(wǎng)綜合報道 2025年6月30日,華為正式宣布開源盤古70億參數(shù)的稠密模型、盤古Pro MoE 720億參數(shù)的混合專家模型及基于昇騰的模型推理技術(shù),此舉標志著華為在AI技術(shù)生態(tài)建設(shè)領(lǐng)域邁出關(guān)鍵一步,為全球開發(fā)者、企業(yè)及研究人員提供了強大的技術(shù)支撐。

華為此次開源行動涵蓋三大核心板塊:盤古Pro MoE 72B模型權(quán)重與基礎(chǔ)推理代碼已率先上線開源平臺;基于昇騰的超大規(guī)模MoE模型推理代碼同步開放;盤古7B稠密模型相關(guān)代碼將于近期完成上線。開發(fā)者可通過華為開源社區(qū)(https://gitcode.com/ascend-tribe)獲取完整技術(shù)資源,參與模型優(yōu)化與生態(tài)共建。

作為70億參數(shù)的緊湊型模型,盤古7B在保持高效推理能力的同時,顯著降低部署門檻。其設(shè)計聚焦行業(yè)場景的快速適配,特別適合資源受限環(huán)境下的邊緣計算應(yīng)用,為中小企業(yè)提供高性價比的AI解決方案。

該模型采用創(chuàng)新性的分組混合專家架構(gòu)(MoGE),通過動態(tài)激活機制實現(xiàn)160億參數(shù)的高效利用。在SuperCLUE評測中,其以720億總參數(shù)量達到59分,與千億級模型持平,展現(xiàn)出“小參數(shù)量、大能力”的技術(shù)優(yōu)勢。基于昇騰AI計算平臺的優(yōu)化,單卡推理吞吐量達2300 Tokens/s,較傳統(tǒng)架構(gòu)提升4倍,支持384個專家并行推理的超級節(jié)點架構(gòu),更將算力利用率(MFU)提升50%以上。

華為通過開源構(gòu)建開放創(chuàng)新生態(tài),吸引全球開發(fā)者參與模型優(yōu)化。目前,盤古大模型已形成覆蓋數(shù)據(jù)管理、訓練、部署的全生命周期工具鏈,支持企業(yè)定制化開發(fā)。這種“基礎(chǔ)開源+商業(yè)增值”模式,既降低技術(shù)使用門檻,又通過商業(yè)發(fā)行版形成可持續(xù)的盈利路徑。

在金融、制造、醫(yī)療等領(lǐng)域,盤古模型的動態(tài)負載均衡技術(shù)使云端推理成本降低30%,支撐高并發(fā)實時作業(yè)場景。基于MoGE架構(gòu)的輕量化引擎,可適配昇騰系列芯片,使百億級模型在邊緣設(shè)備高效運行,為工業(yè)互聯(lián)網(wǎng)、智能座艙等場景開辟新應(yīng)用空間。

作為首個由亞洲企業(yè)主導的AI大模型開源項目,華為的實踐正在改變國際技術(shù)競爭格局。通過Apache-2.0協(xié)議運營,盤古模型已吸引科大訊飛、中國科學院等1300家機構(gòu)采用,推動中國AI技術(shù)從跟跑向并跑乃至領(lǐng)跑轉(zhuǎn)變。

此次開源行動,是華為“把復雜留給自己,把簡單留給客戶”技術(shù)理念的生動實踐。當72B模型的專家網(wǎng)絡(luò)在昇騰超節(jié)點上高效運轉(zhuǎn),當7B模型的輕量化部署突破行業(yè)邊界,中國AI產(chǎn)業(yè)正以開源為支點,撬動全球技術(shù)創(chuàng)新的新范式。

-

華為

+關(guān)注

關(guān)注

216文章

35186瀏覽量

255664 -

盤古大模型

+關(guān)注

關(guān)注

1文章

112瀏覽量

724

發(fā)布評論請先 登錄

華為開發(fā)者大會2025(HDC 2025)亮點:華為云發(fā)布盤古大模型5.5 宣布新一代昇騰AI云服務(wù)上線

在阿里云PAI上快速部署NVIDIA Cosmos Reason-1模型

NVIDIA RTX 5880 Ada與Qwen3系列模型實測報告

【幸狐Omni3576邊緣計算套件試用體驗】CPU部署DeekSeek-R1模型(1B和7B)

利用英特爾OpenVINO在本地運行Qwen2.5-VL系列模型

阿里云發(fā)布開源多模態(tài)推理模型QVQ-72B-Preview

獵戶星空發(fā)布Orion-MoE 8×7B大模型及AI數(shù)據(jù)寶AirDS

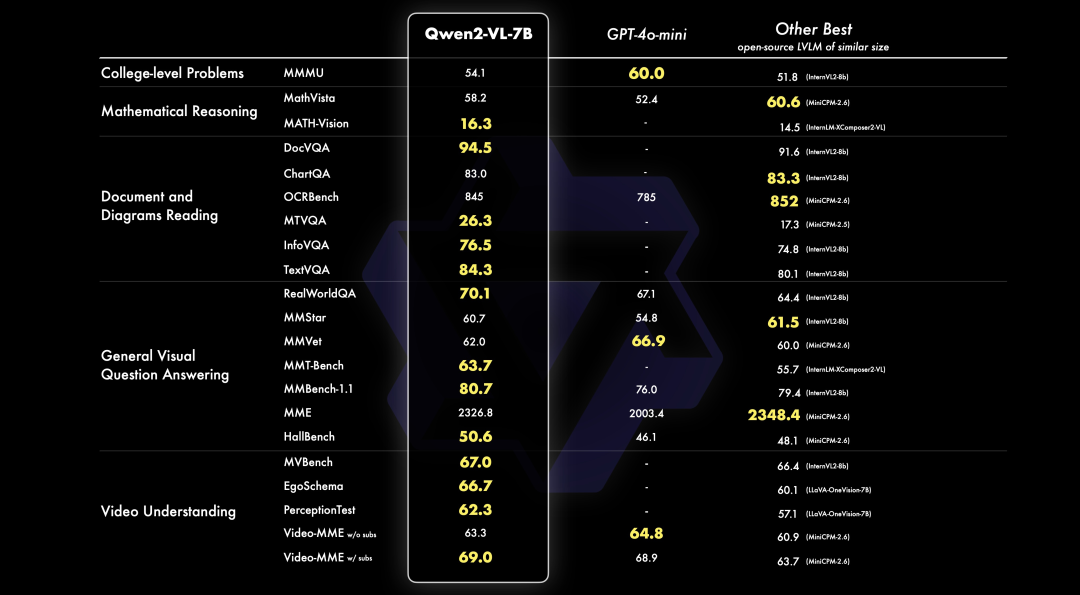

PerfXCloud重磅升級 阿里開源最強視覺語言模型Qwen2-VL-7B強勢上線!

華為宣布開源盤古7B稠密和72B混合專家模型

華為宣布開源盤古7B稠密和72B混合專家模型

評論