引言

在當今數據爆炸的時代,企業對存儲系統的需求日益增長,傳統的集中式存儲已經無法滿足大規模數據處理的要求。分布式存儲系統應運而生,而Ceph作為開源分布式存儲系統的佼佼者,以其高可用性、高擴展性和統一存儲架構贏得了眾多企業的青睞。

Ceph概述

Ceph是一個開源的分布式存儲系統,由Sage Weil在加州大學圣克魯斯分校開發,現已成為Linux基金會項目。它提供了對象存儲、塊存儲和文件存儲三種存儲接口,能夠在commodity硬件上運行,具有無單點故障、自動數據修復和智能數據分布等特性。

核心特性

高可用性:通過數據復制和分布式架構,確保系統在硬件故障時仍能正常工作。

高擴展性:支持從幾個節點擴展到數千個節點的PB級存儲集群。

統一存儲:單一集群同時提供對象、塊和文件存儲服務。

自管理:具備自動故障檢測、數據修復和負載均衡能力。

架構組件

Monitor(MON)

Monitor是Ceph集群的大腦,負責維護集群狀態信息,包括Monitor Map、OSD Map、PG Map等。通常部署奇數個Monitor實例(3或5個)以避免腦裂問題。Monitor通過Paxos算法保證集群狀態的一致性。

Object Storage Daemon(OSD)

OSD是Ceph的核心存儲組件,每個OSD管理一個存儲設備(通常是硬盤)。OSD負責存儲數據、處理數據復制、恢復和重新平衡,以及向Monitor報告狀態信息。一個典型的Ceph集群包含數十到數千個OSD。

Metadata Server(MDS)

MDS專門為CephFS文件系統服務,負責管理文件系統的元數據。對于對象存儲和塊存儲,MDS不是必需的。MDS支持動態擴展和故障轉移,確保元數據服務的高可用性。

Manager(MGR)

Manager是Ceph Luminous版本引入的新組件,負責收集集群指標、提供管理接口和擴展功能。MGR支持插件架構,可以集成各種監控和管理工具。

核心算法

CRUSH算法

CRUSH(Controlled Replication Under Scalable Hashing)是Ceph的核心數據分布算法。它通過確定性的哈希函數將數據映射到存儲位置,無需維護中心化的映射表。CRUSH算法考慮了硬件層次結構,能夠根據故障域進行智能的數據分布。

Placement Group(PG)

PG是Ceph中的邏輯概念,作為對象和OSD之間的中間層。每個PG包含多個對象,并被復制到多個OSD上。PG的數量需要根據OSD數量合理配置,通常建議每個OSD管理50-100個PG。

存儲接口

RADOS塊設備(RBD)

RBD提供塊存儲服務,支持快照、克隆和精簡配置等企業級功能。RBD可以直接掛載到虛擬機或物理主機,廣泛應用于云計算環境。

# 創建RBD鏡像 rbd create --size 1024 mypool/myimage # 映射RBD設備 rbd map mypool/myimage # 格式化并掛載 mkfs.ext4 /dev/rbd0 mount /dev/rbd0 /mnt/ceph-disk

CephFS文件系統

CephFS是一個POSIX兼容的分布式文件系統,支持多客戶端并發訪問。它通過MDS管理元數據,提供目錄層次結構和文件權限管理。

# 掛載CephFS mount -t ceph mon1/ /mnt/cephfs -o name=admin,secret=AQD... # 或使用內核客戶端 ceph-fuse /mnt/cephfs

RADOS網關(RGW)

RGW提供RESTful對象存儲接口,兼容Amazon S3和OpenStack Swift API。它支持多租戶、用戶管理和訪問控制,適用于云存儲和備份場景。

部署最佳實踐

硬件選擇

網絡:建議使用10Gb以太網,公共網絡和集群網絡分離。

存儲:SSD用于OSD日志和元數據,HDD用于數據存儲。

CPU和內存:OSD節點建議每個OSD分配1-2GB內存,Monitor節點需要更多內存。

集群規劃

節點數量:最少3個節點,推薦5個或以上節點以提高可用性。

副本數量:生產環境建議設置3副本,可根據可用性需求調整。

PG數量:合理配置PG數量,避免過多或過少影響性能。

安裝部署

使用ceph-deploy工具可以簡化部署過程:

# 安裝ceph-deploy pip install ceph-deploy # 初始化集群 ceph-deploy new node1 node2 node3 # 安裝ceph軟件包 ceph-deploy install node1 node2 node3 # 部署Monitor ceph-deploy mon create-initial # 部署OSD ceph-deploy osd create node1 --data /dev/sdb ceph-deploy osd create node2 --data /dev/sdb ceph-deploy osd create node3 --data /dev/sdb

運維管理

監控指標

集群健康狀態:通過ceph health命令監控集群整體狀態。

存儲使用率:監控各個存儲池的使用情況,及時擴容。

性能指標:關注IOPS、延遲和帶寬等關鍵性能指標。

OSD狀態:監控OSD的up/down和in/out狀態。

故障處理

OSD故障:自動檢測并將故障OSD標記為down,數據會自動重新平衡。

Monitor故障:通過多個Monitor實例保證服務連續性。

網絡分區:通過合理的網絡規劃和Monitor配置避免腦裂。

性能優化

調整復制數量:根據業務需求平衡可用性和性能。

配置參數優化:調整OSD、Monitor和客戶端相關參數。

硬件升級:使用更快的網絡和存儲設備提升整體性能。

使用場景

云計算平臺

Ceph廣泛應用于OpenStack、CloudStack等云計算平臺,為虛擬機提供塊存儲服務。通過與云管理平臺集成,實現存儲資源的動態分配和管理。

大數據分析

Ceph可以作為Hadoop、Spark等大數據處理框架的存儲后端,提供高吞吐量的數據訪問能力。CephFS特別適合需要POSIX語義的大數據應用。

備份和歸檔

利用Ceph的對象存儲能力,構建企業級備份和歸檔解決方案。RGW的S3兼容接口使得與現有備份軟件集成變得簡單。

總結

Ceph作為成熟的開源分布式存儲系統,在企業級應用中表現出色。它的統一存儲架構、高可用性和可擴展性使其成為現代數據中心的理想選擇。隨著云計算和大數據技術的發展,Ceph將繼續在存儲領域發揮重要作用。

對于運維工程師而言,深入理解Ceph的架構原理和運維要點,能夠幫助構建更加穩定、高效的存儲系統。在實際部署中,需要根據具體業務需求進行合理規劃和優化,確保系統的最佳性能和可靠性。

-

開源

+關注

關注

3文章

3678瀏覽量

43811 -

分布式存儲

+關注

關注

4文章

181瀏覽量

19869 -

Ceph

+關注

關注

1文章

25瀏覽量

9553

原文標題:運維必備:Ceph分布式存儲從原理到實踐的完整技術棧

文章出處:【微信號:magedu-Linux,微信公眾號:馬哥Linux運維】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Ceph是什么?Ceph的統一存儲方案簡析

存儲分布式系統中如何從CAP轉到PACELC

關于騰訊的開源分布式存儲系統DCache

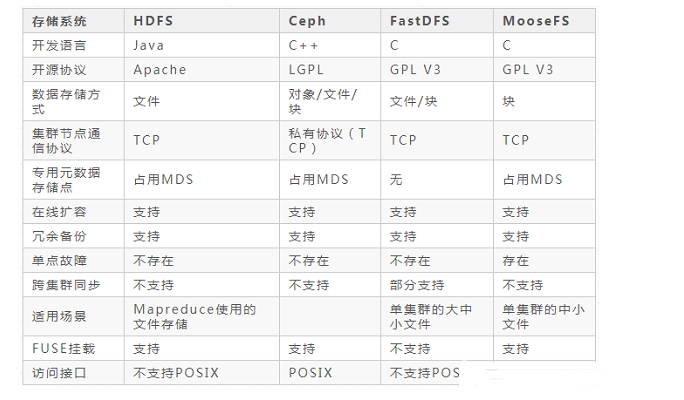

盤點分布式存儲系統的主流框架

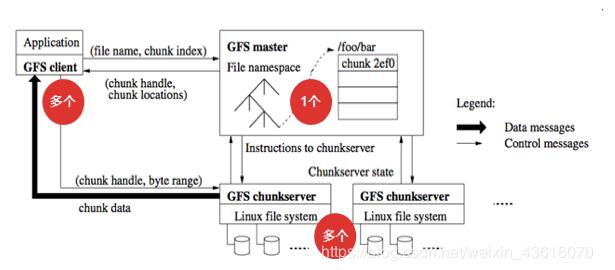

分布式文件存儲系統GFS的基礎知識

常見的分布式存儲系統有哪些類型

常見的分布式文件存儲系統的優缺點

云存儲中的Ceph分布式文件系統及節點選擇

Ceph分布式存儲系統解析

Ceph分布式存儲系統解析

評論