繼OpenAI之后,DeepMind也在多智能體強化學習方面秀肌肉:首次在第一人稱射擊游戲的多人模式中完勝人類,而且沒有使用大量訓練局數,輕松超過了人類水平。

就在OpenAI宣布在5v5 DOTA 2中戰勝人類玩家后沒多久,今天,DeepMind也分享了他們在多智能體學習(multi-agent learning)方面的進展。

CEO Hassabis在Twitter上分享:“我們最新的工作展示了智能體在復雜的第一人稱多人游戲中達到人類水平,還能與人類玩家合作!”

Hassbis說的這個游戲,就是《雷神之錘III競技場》,這也是很多現代第一人稱射擊游戲的鼻祖,玩家或獨立或組隊在地圖中廝殺,死亡后數秒在地圖某處重生。當某一方達到勝利條件(在DeepMind的實驗里就是搶奪更多的旗幟),或者游戲持續一定時間后即宣告回合結束。勝利條件取決于選擇的游戲模式。

雖然Hassbis在Twitter里說他們的AI“達到了人類水平”,實際上,從實驗結果看,他們的AI已經超越了人類:在與由40個人類玩家組成的隊伍對戰時,純AI的隊伍完勝純人類的隊伍(平均多搶到16面旗),并且有95%的幾率戰勝AI與人混合組成的隊伍。

這個AI名叫“為了贏”(For the Win,FTW),只玩了將近45萬場游戲,理解了如何有效地與人和其他的機器合作與競爭。

研究人員對AI的唯一限定是,在5分鐘時間里盡可能取得多的旗幟。對戰的游戲地圖是隨機生成的,每場都會變,室內與室外的地形也不相同。組隊的時候,AI可能與人組隊,也可能與其他AI組隊。對戰的模式分為慢速和高速兩種。

在訓練過程中,AI發展出了自己的獎勵機制,學會了基地防守、尾隨隊友,或者守在敵人營地外偷襲等策略。

DeepMind在他們今天發表的博客文章中寫道,從多智能體的角度說,玩《雷神之錘III》這種多人視頻游戲,需要與隊友合作,與敵方競爭,還要對遭遇到的任何對戰風格/策略保持魯棒性。

分析發現,游戲中,AI在“tagging”(碰觸對方,將其送回地圖上的初始地點)上比人類更加高效,80%的情況下能夠成功(人類為48%)。

而且有趣的是,對參與對戰的人類玩家進行調查后發現,大家普遍認為AI是更好的team player,更善于合作。

第一人稱射擊游戲多人模式重大突破

啟元世界首席算法官、前Netflix資深算法專家王湘君告訴新智元:

之前第一人稱射擊(FPS)游戲的研究更多是單人模式,這次DeepMind在FPS多人模式做出了重大突破,在沒有使用大量訓練局數的情況下就超過了人類水平。和之前OpenAI Five相比,DeepMind的Capture the Flag (CTF) 模型直接從pixel學習,沒有作feature engineering和為每個agent單獨訓練模型,得益于以下創新:

去年DeepMind Max Jaderberg 提出的Population-based training 的應用極大提高了訓練效率,并且提供了多樣化的exploration,幫助模型在不同地形隊友環境中的適應性,實驗結果顯示比self-play的結果更好更高效。

For The Win agent 的分層reward機制來解決credit assignment問題。

用fast and slow RNN 和內存機制達到類似Hierarchical RL的作用。

不過,FPS在策略學習上面的難度還是比Dota,星際這種RTS游戲小很多,CTF模型在長期策略游戲上效果還有待觀察。

在和人類對戰模式之外,CTF模型同時在人機協作上有很好的效果。值得一提的是,啟元世界在今年4月份北大ACM總決賽期間發布的基于星際爭霸2的人機協作挑戰賽,其智能體也率先具備了與人和AI組隊協作的能力。人機協作在未來的人工智能研究領域將成為非常重要的一環。

掌握策略,理解戰術和團隊合作

在多人視頻游戲中掌握策略、戰術理解和團隊合作是人工智能研究的關鍵挑戰。現在,由于強化學習取得的新進展,我們的智能體已經在《雷神之錘III競技場》(Quake III Arena)游戲中達到了人類級別的表現,這是一個經典的3D第一人稱多人游戲,也是一個復雜的多智能體環境。這些智能體展現出同時與人工智能體和人類玩家合作的能力。

我們居住的星球上有數十億人,每個人都有自己的個人目標和行動,但我們仍然能夠通過團隊、組織和社會團結起來,展現出顯著的集體智慧。這是我們稱之為多智能體學習(multi-agentlearning)的設置:許多個體的智能體必須能夠獨立行動,同時還要學會與其他智能體交互和合作。這是一個極其困難的問題——因為有了共適應智能體,世界在不斷地變化。

為了研究這個問題,我們選擇了3D第一人稱多人視頻游戲。這些游戲是最流行的電子游戲類型,由于它們身臨其境的游戲設計,以及它們在策略、戰術、手眼協調和團隊合作方面的挑戰,吸引了數以百萬計的玩家。我們的智能體面臨的挑戰是直接從原始像素中學習以產生操作。這種復雜性使得第一人稱多人游戲成為人工智能社區一個非常活躍而且得到許多成果的研究領域。

我們的這項工作關注的游戲是《雷神之錘III競技場》(我們對其進行了一些美術上的修改,但所有游戲機制保持不變)。《雷神之錘III競技場》是為許多現代第一人稱視頻游戲奠定了基礎,并吸引了長期以來競爭激烈的電子競技場面。我們訓練智能體作為個體學習和行動,但必須能夠與其他智能體或人類組成團隊作戰。

CTF(Capture The Flag)的游戲規則很簡單,但是動態很復雜。在Quake3里分成藍紅兩隊在給定的地圖中競賽。競賽的目的是將對方的旗子帶回來,并且碰觸未被移動過的我方旗子,我隊就得一分,稱作一個capture。為了獲得戰術上的優勢,他們可以會碰觸地方的隊員(tagging),把他們送回自己的地盤。在五分鐘內capture到最多旗子的隊伍獲勝。

從多智能體的角度看,CTF要求隊員既要成功地與隊友合作,又要與對方敵手競爭,同時在可能遇到的任何比賽風格中保持穩健性。

FTW智能體:等級分遠超基線方法和人類玩家

為了使事情更有趣,我們設計了CTF的一種變體,令地圖的布局在每一場競賽中發生改變。這樣,我們的智能體被迫要采用一般性策略,而不是記住地圖的布局。此外,為了讓游戲更加公平,智能體要以類似于人類的方式體驗CTF的世界:它們觀察一系列的像素圖像,并通過模擬游戲控制器發出動作。

CTF是在程序生成的環境中執行的,因此,智能體必須要適應不可見的地圖。

智能體必須從頭開始學習如何在不可見(unseen)的環境中觀察、行動、合作和競爭,所有這些都來自每場比賽的一個強化信號:他們的團隊是否獲勝。這是一個具有挑戰性的學習問題,它的解決方法基于強化學習的三個一般思路:

我們不是訓練一個智能體,而是訓練一群智能體,它們通過組隊玩游戲來學習,提供了多樣化的隊友和敵手。

群體中的每個智能體都學習自己的內部獎勵信號,這些信號使得智能體能夠產生自己的內部目標,例如奪取一面旗子。雙重優化過程可以直接為了獲勝優化智能體的內部獎勵,并使用內部獎勵的強化學習來學習智能體的策略。

智能體在兩個時間尺度上運行,快速和慢速,這提高了它們使用內存和產生一致動作序列的能力。

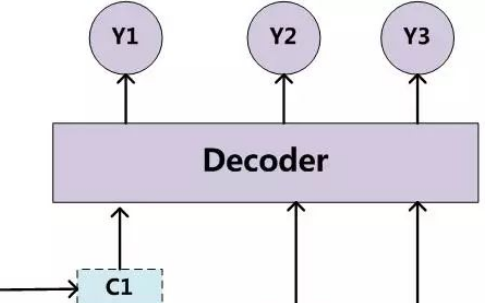

圖: For The Win (FTW)智能體架構的示意圖。該智能體將快速和慢速兩個時間尺度的循環神經網絡(RNN)相結合,包括一個共享記憶模塊,并學習從游戲點到內部獎勵的轉換。

由此產生的智能體,我們稱之為For The Win(FTW)智能體,它學會了以非常高的標準玩CTF。最重要的是,學會的智能體策略對地圖的大小、隊友的數量以及團隊中的其他參與者都具有穩健性。

下面演示了FTW智能體互相競爭的室外程序環境游戲,以及人類和智能體競爭的室內程序環境的游戲。

圖:交互式CTF游戲瀏覽器,分別有室內和室外的程序生成環境。室外地圖游戲是FTW智能體相互之間的競賽,而室內地圖上的游戲則是人類與FTW智能體之間的競賽(見圖標)。

我們舉辦了一場比賽,包括40名人類玩家。在比賽中,人類和智能體都是隨機配對的——可以作為敵手或者作為隊友。

一場早期的測試比賽,由人類與訓練好的智能體一起玩CTF。

FTW智能體學會的比強大的基線方法更強,并超過人類玩家的勝率。事實上,在一項對參與者的調查中,它們被認為比人類參與者更具有合作精神。

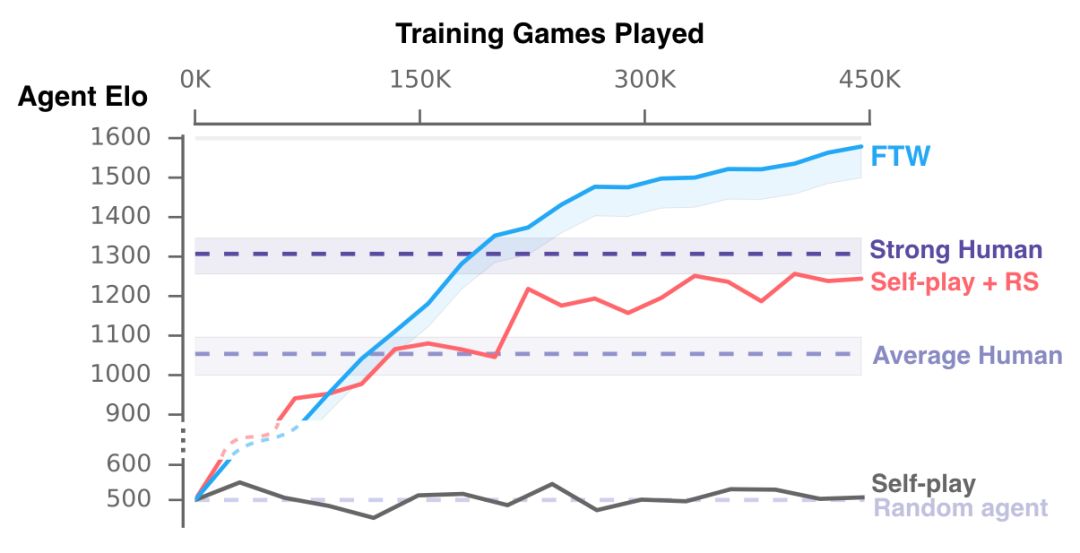

訓練期間我們的智能體的表現。我們新的FTW智能體相比人類玩家和Self-play + RS和Self-play的基線方法獲得了更高的Elo等級分——獲勝的概率也更高。

除了性能評估之外,理解這些智能體的行為和內部表示的復雜性是很重要的。

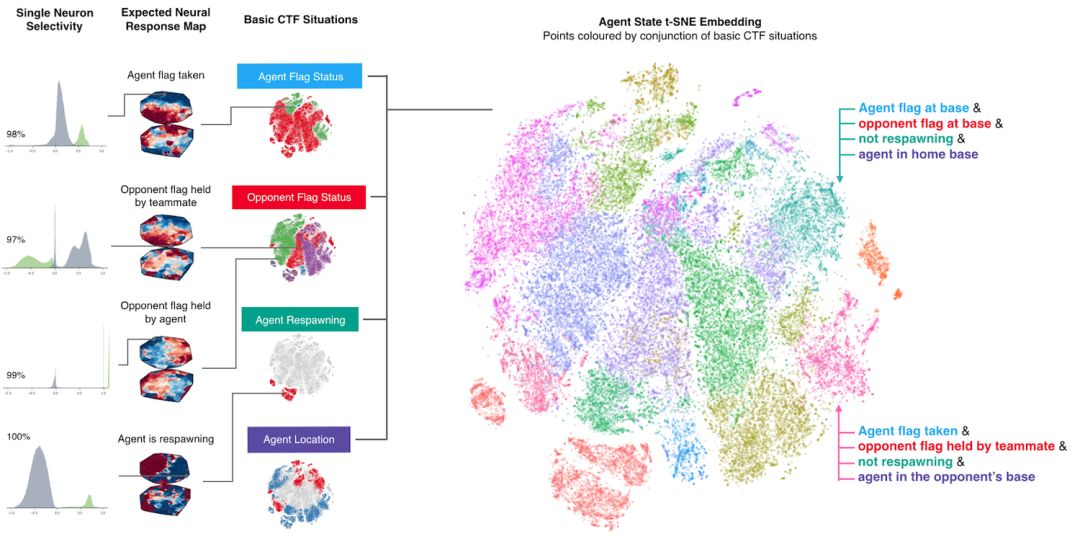

為了理解智能體如何表示游戲狀態,我們研究了在平面上繪制的智能體的神經網絡的激活模式。下圖中的點表示游戲過程中的情況,近處的點表示類似的激活模式。這些點是根據高級CTF游戲狀態進行著色的,在這些狀態中智能體要問自己:智能體在哪個房間?旗子的狀態是怎樣的?可以看到哪些隊友和敵手?我們觀察到相同顏色的集群,表明智能體以類似的方式表示類似的高級游戲狀態。

智能體如何表示游戲世界。不同的情形在概念上對應于同一游戲情境,并由智能體相似地表示出來。訓練好的智能體甚至展示了一些人工神經元,這些神經元直接為特定情況編碼。

智能體從未被告知游戲的規則,但是它可以學習基本的游戲概念,并能有效地建立CTF直覺。事實上,我們可以找到一些特定的神經元,它們可以直接編碼一些最重要的游戲狀態,比如當智能體的旗子被奪走時激活的神經元,或者當它的隊友奪到對方的旗子時激活的神經元。我們在論文中進一步分析了智能體對記憶和視覺注意力的使用。

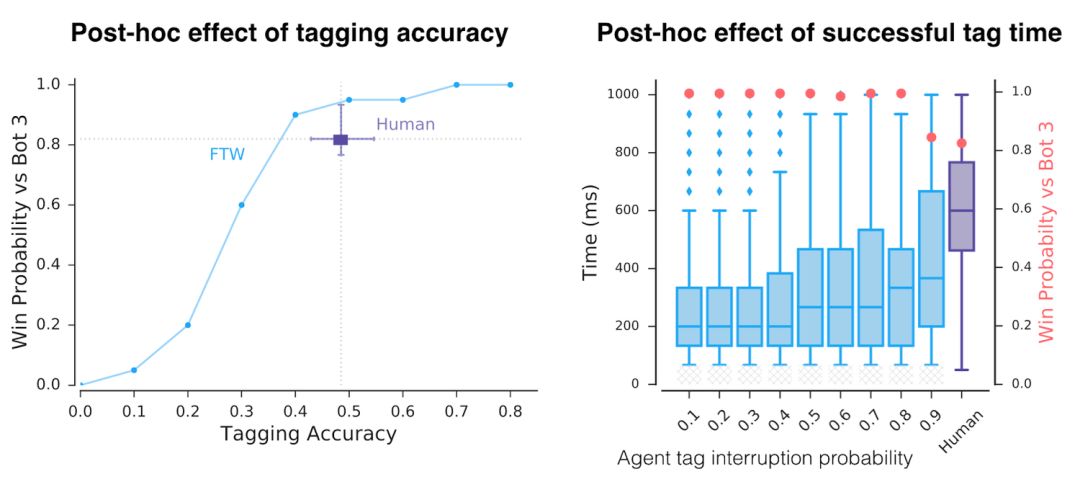

除了這種豐富的表示,智能體還會如何行動呢?首先,我們注意到這些智能體的反應時間非常快,tagging也非常準確,這可以解釋為它們的性能。但是,通過人為地降低tagging的準確度和反應時間,我們發現這只是它們成功的因素之一。

訓練后人為地降低了智能體的tagging精度和tagging反應時間。即使在具有于人類相當的準確度和反應時間下,智能體的性能仍高于人類。

通過無監督學習,我們建立了智能體和人類的原型行為( prototypical behaviours),發現智能體實際上學習了類似人類的行為,例如跟隨隊友并在對手的基地扎營。

訓練好的智能體表現出來的自動發現行為的3個例子。

這些行為出現在訓練過程中,通過強化學習和群體層面的進化,一些行為——比如跟隨隊友——隨著智能體學會以更加互補的方式合作而減少。

左上方顯示的是30個智能體在訓練和發展過程中的Elo等級分。右上角顯示了這些進化事件的遺傳樹( genetic tree)。下方的圖表顯示了整個智能體訓練過程中知識的發展,一些內部獎勵,以及行為概率。

總結和展望

最近,研究界在復雜游戲領域做出了非常令人印象深刻的工作,例如星際爭霸2和Dota 2。我們的這篇論文聚焦于《雷神之錘III競技場》的奪旗模式,它的研究貢獻是具有普遍性的。我們很希望看到其他研究人員在不同的復雜環境中重建我們的技術。未來,我們還希望進一步改進目前的強化學習和群體訓練方法。總的來說,我們認為這項工作強調了多智能體訓練對促進人工智能發展的潛力:利用多智能體訓練的自然設置,并促進強大的、甚至能與人類合作的智能體的開發。

-

人工智能

+關注

關注

1796文章

47734瀏覽量

240400 -

智能體

+關注

關注

1文章

167瀏覽量

10618 -

DeepMind

+關注

關注

0文章

131瀏覽量

10949

原文標題:【DOTA之后新里程碑】DeepMind強化學習重大突破:AI在多人射擊游戲完勝人類!

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

未來的AI 深挖谷歌 DeepMind 和它背后的技術

介紹多智能體系統的解決方案以及應用

華為公司在3G專利方面的進展

機器學習簡單運用方面的基礎知識

意法半導體展示其在功率GaN方面的研發進展

谷歌在量子計算機學習任務方面取得新進展

谷歌、DeepMind重磅推出PlaNet 強化學習新突破

DeepMind 綜述深度強化學習 智能體和人類相似度竟然如此高

DeepMind阿爾法被打臉,華為論文指出多項問題

內存計算IMC用于人工智能加速方面的研究進展

語言模型做先驗,統一強化學習智能體,DeepMind選擇走這條通用AI之路

DeepMind分享了他們在多智能體學習方面的進展

DeepMind分享了他們在多智能體學習方面的進展

評論