之前在DOTA2團隊?wèi)?zhàn)中戰(zhàn)勝人類玩家的OpenAI Five,現(xiàn)在被用于訓(xùn)練機器手,取得了前所未有的靈活度。這只機器手完全在虛擬環(huán)境中自我學(xué)習(xí)和訓(xùn)練,然后成功遷移到現(xiàn)實世界解決實際問題。OpenAI使用6144個CPU和8個GPU來訓(xùn)練,50小時內(nèi)收集了大約100年的經(jīng)驗。

還記得OpenAI那個在DOTA2有限制5v5團戰(zhàn)中戰(zhàn)勝人類玩家的OpenAI Five嗎?

這次,OpenAI的研究人員將同樣的算法和同樣的代碼用在了訓(xùn)練機器手上,所得到的機器手能以前所未有的靈活度操縱立方體、圓柱體等物體。

Dactyl自主學(xué)習(xí)的靈巧操作行為

這個系統(tǒng)名為Dactyl,與其他機器人系統(tǒng)不同的地方在于,它完全在模擬環(huán)境中進行訓(xùn)練,并將其虛擬世界中得到的知識轉(zhuǎn)化為現(xiàn)實,并且適應(yīng)現(xiàn)實世界的物理學(xué)。所有的行為都是自主發(fā)現(xiàn)的。

研究人員表示,他們的結(jié)果表明,完全可以在純模擬環(huán)境中訓(xùn)練智能體,無需對現(xiàn)實世界進行精確的物理建模(一項極端復(fù)雜且浩大的工程),就能讓智能體解決實際的任務(wù)。

雖然 Dactyl 機器手跟人手相比仍有一定距離,但這項工作表明,機器學(xué)習(xí)有可能解鎖機器新的能力——將來,AI完全可以在虛擬世界中自己教自己新的技能,大大加快學(xué)習(xí)速度,然后轉(zhuǎn)移至物理世界。

OpenAI還在這次研究中發(fā)現(xiàn)了一些令他們感到意外的結(jié)果:

首先,觸覺感應(yīng)對于操縱現(xiàn)實世界物體并不是必要的。Dactyl 機器手操縱只接收五個指尖的位置以及立方體的位置和方向。有限的傳感器可以獲得更好的性能,因為這些傳感器可以在模擬器中有效建模,由很多傳感器組成的傳感器組建模起來非常復(fù)雜。

其次,為一個對象開發(fā)的隨機化(Randomizations)也能推廣到具有類似屬性的其他對象身上。在玩轉(zhuǎn)立方體后,OpenAI的研究人員打印了一個八角棱鏡,結(jié)果 Dactyl 機器手僅使用他們?yōu)榱⒎襟w設(shè)計的隨機化就實現(xiàn)了高的性能。不過,操縱球體還略有難度,可能是因為他們沒有隨機化模擬滾動行為的參數(shù)。

此外,對于現(xiàn)實世界的機器人來說,要讓運作性能高,好的系統(tǒng)工程與好的算法同等重要。

減少反應(yīng)時間并沒有改善性能。傳統(tǒng)觀點認為,減少動作之間的時間應(yīng)該可以提高性能,因為狀態(tài)之間的變化更小,因此更容易預(yù)測。但實驗中,研究人員將機器手動作之間的時間減少到 40ms,訓(xùn)練時間反而變長,而且沒有顯著改善其在現(xiàn)實世界中的性能。他們得出的結(jié)論是,這種經(jīng)驗法則可能適用于線性模型,但可能不太適用于神經(jīng)網(wǎng)絡(luò)模型。

最后,使用真實數(shù)據(jù)來訓(xùn)練結(jié)果不一定更好。與模擬數(shù)據(jù)相比,真實數(shù)據(jù)有很明顯的缺點,比如跟蹤標(biāo)記的位置信息有延遲和測量誤差。更糟糕的是,實際配置的更改很容易讓實際數(shù)據(jù)變得無效,而且收集足夠多、足夠有用的數(shù)據(jù)十分困難。最終 Dactyl 機器手的視覺模型,是在沒有任何實際數(shù)據(jù)的情況下完成的。

機器手靈活控制物體有四大難點,一直未取得重大突破

Dactyl是一個使用Shadow Dexterous Hand操縱目標(biāo)的系統(tǒng)。我們將一個木塊或棱鏡這樣的物體放在Dactyl的手掌中,讓Dactyl將其重新定位至不同的方向;比如旋轉(zhuǎn)木塊,讓其新的一面朝上。網(wǎng)絡(luò)僅負責(zé)觀察指尖的坐標(biāo)以及來自三個普通RGB相機的圖像。

雖然第一個擬人化的機器手早在幾十年前就出現(xiàn)了,但如何利用這些手有效地操縱物體,一直是機器人控制領(lǐng)域內(nèi)的長期挑戰(zhàn)。與運動之類的其他問題不同,人們在利用傳統(tǒng)機器人方法實施靈巧的操作方面的進展一直很緩慢,并且當(dāng)前的技術(shù)在操縱現(xiàn)實世界中的物體上仍然存在局限性。

要對機器手中的物體實施重新定向,需要解決以下問題:

在現(xiàn)實世界中奏效。強化學(xué)習(xí)在模擬和視頻游戲中取得了許多成功,但在現(xiàn)實世界中取得的成果卻相對有限。我們在真實的機器人身上對Dactyl進行了測試。

高維控制。Shadow Dexterous Hand的自由度為24,而一般的機器人手臂的自由度為7。

噪音和觀察部分目標(biāo)。 Dactyl是在真實世界中工作,因此必須處理噪聲和延遲的傳感器數(shù)據(jù)。當(dāng)指尖的傳感器被其他手指或物體遮擋時,Dactyl必須能夠處理不完整信息。像摩擦和滑動等物理體系中的許多組成部分,是無法直接通過觀察得到的,必須由推理得出。

操縱多個對象。 Dactyl在設(shè)計上的高靈活性,足以重新定向多個目標(biāo)。也就是說,我們的方法不能使用僅適用于特定形狀目標(biāo)的策略。

無需任何人工輸入:領(lǐng)域隨機化,再現(xiàn)模擬奇跡!

Dactyl完全是在模擬環(huán)境中學(xué)習(xí)如何解決目標(biāo)重定向任務(wù)(object reorientation task)的,無需任何的人工輸入。在此訓(xùn)練階段之后,學(xué)習(xí)策略會在沒有任何微調(diào)的情況下對真實機器人起一定作用。

在操縱機器人的學(xué)習(xí)方法方面,通常會面臨一個兩難的選擇。模擬的機器人可以輕松提供充足的數(shù)據(jù)來訓(xùn)練復(fù)雜的策略,但是大多數(shù)操作問題都無法準確地建模,從而無法使這些策略轉(zhuǎn)移到真實機器人身上。即使是對兩個物體接觸時發(fā)生的情況進行建模(這是操作中最基本的問題)也是一個活躍的研究領(lǐng)域,并且目前沒有廣泛統(tǒng)一且接受的解決方案。直接在物理機器人上展開訓(xùn)練可以讓策略從現(xiàn)實世界物理層面進行學(xué)習(xí),但現(xiàn)今的算法需要多年的經(jīng)驗才能解決類似對象重定向這樣的問題。

而領(lǐng)域隨機化(domain randomization)是在模擬中進行學(xué)習(xí)的,旨在提供各種經(jīng)驗而不是將現(xiàn)實進行最大化。這種思路提供了最好的兩種方法:在模擬中學(xué)習(xí),可以通過擴展來快速收集更多的經(jīng)驗;不強調(diào)現(xiàn)實主義,可以解決模擬器只能近似模擬的問題。

利用MuJoCo物理引擎構(gòu)建機器人系統(tǒng)的模擬版本。這個模擬僅僅是真實機器人的粗略近似:

對摩擦、阻尼和滾動阻力等物理屬性進行測量是既麻煩又困難的。隨著機器人的磨損,這些屬性也會隨時間而改變。

MuJoCo是一個剛體模擬器,這意味著它不能模擬手指上或肌腱的拉伸時的可變形橡膠。

機器人只能通過反復(fù)接觸來操縱物體。 然而,眾所周知,接觸力難以在模擬中準確地再現(xiàn)。

通過校準其參數(shù)來匹配機器人的行為,可以使模擬更加逼真,但在目前的模擬器中,許多這樣的效果是無法精確建模的。

相反,該方法是在模擬環(huán)境的分布上對策略進行訓(xùn)練,其中物理和視覺屬性是隨機選擇的。隨機值是表示物理系統(tǒng)不確定性的一種自然方法,它還可以防止對單個模擬環(huán)境的過度擬合。如果策略可以在所有模擬環(huán)境中完成任務(wù),則更有可能在現(xiàn)實世界中完成該任務(wù)。

6144個CPU和8個GPU,50小時內(nèi)收集大約100年的經(jīng)驗

學(xué)習(xí)控制

通過構(gòu)建支持遷移的模擬,我們減輕了在現(xiàn)實世界中控制機器人來完成模擬任務(wù)的困難,這是一個非常適合強化學(xué)習(xí)的問題。雖然用一只模擬的手來操縱物體這個任務(wù)已經(jīng)有些困難,但是要在所有隨機物理參數(shù)組合中學(xué)習(xí)進行這樣的操作實際上要更加困難。

為了在不同環(huán)境中進行推廣(generalize),策略可以在具有不同動態(tài)的環(huán)境中執(zhí)行不同的操作。由于大多數(shù)動力學(xué)參數(shù)不能從單個觀測中推斷出來,所以我們使用LSTM(一種具有記憶的神經(jīng)網(wǎng)絡(luò))使網(wǎng)絡(luò)能夠了解環(huán)境的動態(tài)。LSTM在模擬中實現(xiàn)的旋轉(zhuǎn)大約兩倍于不具有記憶的策略的旋轉(zhuǎn)。

Dactyl使用Rapid學(xué)習(xí),這是一個強化學(xué)習(xí)訓(xùn)練系統(tǒng),之前解決了Dota2的OpenAI Five使用的也是它。我們使用了與OpenAI Five不同的模型架構(gòu)、環(huán)境和超參數(shù),但是使用的算法和訓(xùn)練代碼是完全相同的。Rapid使用6144個CPU內(nèi)核和8個GPU來訓(xùn)練我們的策略,在50小時內(nèi)收集了大約100年的經(jīng)驗。

為了進行開發(fā)和測試,我們使用嵌入式運動跟蹤傳感器來驗證我們的控制策略,以分別了解控制策略和視覺網(wǎng)絡(luò)的性能。

學(xué)習(xí)觀察

Dactyl的設(shè)計目的是能夠操縱任意物體,而不僅僅是為了支持跟蹤進行過特殊修改的物體。因此,Dactyl使用常規(guī)的RGB相機圖像來估計物體的位置和方向。

我們使用卷積神經(jīng)網(wǎng)絡(luò)訓(xùn)練一個姿態(tài)估計器(pose estimator)。神經(jīng)網(wǎng)絡(luò)從機器手周圍的三個攝像機中獲取視頻流,并輸出目標(biāo)的預(yù)估位置和方向。我們使用多臺攝像機來解決模糊和遮擋問題。我們再次使用Unity游戲開發(fā)平臺,僅在模擬中使用域隨機化來訓(xùn)練這個網(wǎng)絡(luò),該平臺可以模擬比Mujoco更廣泛的視覺現(xiàn)象。

控制網(wǎng)絡(luò)(control network)根據(jù)對象的姿態(tài)重新定位,視覺網(wǎng)絡(luò)(vision network)將圖像從攝像機映射到對象的姿態(tài),通過結(jié)合這兩個獨立的網(wǎng)絡(luò),Dactyl可以通過觀察來操縱對象。

用于學(xué)習(xí)估計立方塊的姿勢的訓(xùn)練示例

所有行為都由機器自主發(fā)現(xiàn),采用與人不同的策略

在部署系統(tǒng)時,我們注意到Dactyl使用了一組多樣的靈巧操作策略來解決任務(wù)。這些策略也是人類經(jīng)常使用的。但是,我們并沒有明確地將這些策略教給系統(tǒng);所有的行為都是自主發(fā)現(xiàn)的。

Dactyl自主學(xué)習(xí)的靈巧操作行為

Dactyl根據(jù)GRASP分類法了解類型。從左上到右下分別是:指尖捏、掌心捏、三指握、四指握、強力抓握、五指精準抓握。

我們觀察到,對于精準抓握,比如指尖捏,Dactyl會使用拇指和小指。人類則傾向于使用拇指和食指或拇指和中指。然而,由于由額外的自由度,機器手的小指更加靈活,這也許可以解釋為什么Dactyl更喜歡用小指。這意味著Dactyl可以調(diào)整人類的策略,以更好地適應(yīng)自身的局限性和能力。

改變實驗方式時的表現(xiàn)

我們測試了Dactyl在掉落物體、超時或成功翻轉(zhuǎn)目標(biāo)50次前的成功翻轉(zhuǎn)次數(shù)。 我們在純模擬訓(xùn)練的結(jié)果表明,該策略能夠成功操縱現(xiàn)實世界中的目標(biāo)。

我們在實驗室中使用Shadow Dexterous Hand、PhaseSpace動作跟蹤相機和Basler RGB相機進行實驗。

對于操作立方體的任務(wù)而言,使用隨機化訓(xùn)練的策略可能比未隨機化訓(xùn)練的策略實現(xiàn)更多的翻轉(zhuǎn)次數(shù),具體結(jié)果如下表所示。 此外,使用由視覺估計姿態(tài)的控制網(wǎng)絡(luò)的表現(xiàn),幾乎與直接從運動跟蹤傳感器中讀取數(shù)據(jù)的網(wǎng)絡(luò)一樣好。

| 隨機化情況 | 目標(biāo)跟蹤方式 | 最大成功翻轉(zhuǎn)次數(shù) | 成功次數(shù)中位數(shù) |

| 全部隨機化 | 視覺跟蹤 | 46 | 11.5 |

| 全部隨機化 | 運動跟蹤 | 50 | 13 |

| 未隨機化 | 運動跟蹤 | 6 | 0 |

學(xué)習(xí)過程

為了讓我們的策略在面向不同的物理動態(tài)目標(biāo)時變得更加強大,OpenAI研究人員將絕大部分的訓(xùn)練時間花費在這件事上。在沒有隨機化的情況下,要在模擬實驗中學(xué)會翻轉(zhuǎn)立方體需要大約3年時間。在完全隨機化模擬實驗中,實現(xiàn)類似的目標(biāo)性能則需要大約100年。

-

傳感器

+關(guān)注

關(guān)注

2565文章

52971瀏覽量

767128 -

智能體

+關(guān)注

關(guān)注

1文章

302瀏覽量

11077 -

機器手

+關(guān)注

關(guān)注

0文章

12瀏覽量

2748

原文標(biāo)題:【2天=100年】OpenAI用打Dota2的算法造了一只會轉(zhuǎn)方塊的機器手

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

重新定義精密制造!富唯智能高精度裝配人形機器人引領(lǐng)智造革命

2025款東風(fēng)奕派eπ007重磅上市

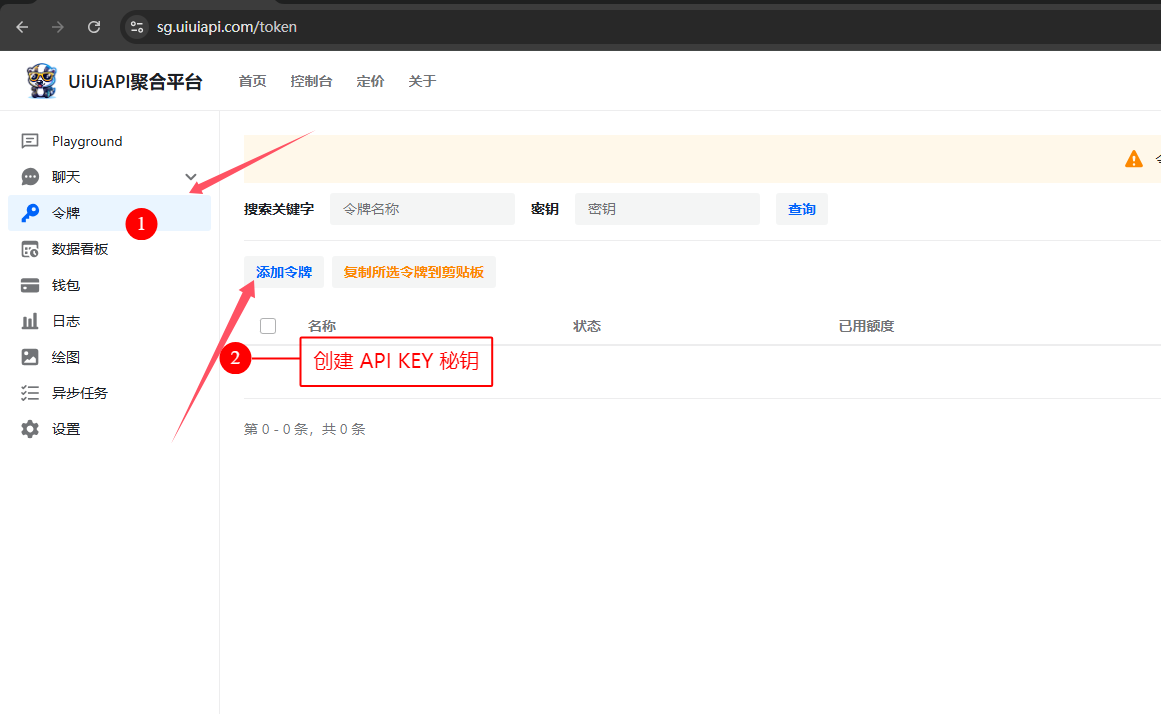

如何獲取 OpenAI API Key?API 獲取與代碼調(diào)用示例 (詳解教程)

大華星漢大模型2.0重塑產(chǎn)業(yè)格局

軟通動力昇騰AI一體機助力中鐵魯班AI升級

從片上系統(tǒng)(SoC)到立方體集成電路(CIC)

新型寬帶UV頻率梳提供前所未有的光譜分辨率

OpenAI打造的機器手能以前所未有的靈活度操縱立方體、圓柱體等物體

OpenAI打造的機器手能以前所未有的靈活度操縱立方體、圓柱體等物體

評論