關(guān)于人工智能(AI)的報導(dǎo)一直不絕于耳。過去幾年來,幾乎每個月(有時甚至是每周)都會有一款現(xiàn)有或新創(chuàng)公司的全新AI處理器推出市場。然而,懸而未決的問題是:為什么有這么多的AI處理器?每一款A(yù)I晶片的設(shè)計是為了解決哪些問題?更重要的是,當(dāng)今的AI版圖中還缺少哪些部份?

Tirias Research首席分析師Kevin Krewell直截了當(dāng)?shù)卣f,「AI帶來了一種新典范,并改變了整個電腦系統(tǒng)。」現(xiàn)有企業(yè)和新創(chuàng)公司都在爭奪仍處于混亂中的「AI就緒」(AI-ready )運(yùn)算領(lǐng)域。以色列Hailo是一家為「邊緣裝置深度學(xué)習(xí)」打造專用晶片的新創(chuàng)公司,今年6月宣布完成1,250萬美元的A輪融資。Hailo的目標(biāo)在于「為任何產(chǎn)品帶來智慧」(to bring intelligence to any product)。因此,Hailo執(zhí)行長Orr Danon最近呼吁「徹底重新設(shè)計電腦架構(gòu)的支柱——存儲器、控制和運(yùn)算以及其間的關(guān)系。」

這是一個值得稱道的目標(biāo)。然而,Hailo既不打算透露其架構(gòu)細(xì)節(jié)——Danon僅表示「可能就在今年底」,其首款A(yù)I處理器最快也要到2019年上半年后才會正式推出。

Danon認(rèn)為,目前還沒有一家自動駕駛車(AV)供應(yīng)商能在無數(shù)的新一代AI處理器中找到適用于其AV的晶片。汽車領(lǐng)域正是Hailo看好其新款A(yù)I處理器得以發(fā)揮的直接目標(biāo)市場。Danon指出,當(dāng)今的測試AV實(shí)際上都在公共道路上行駛,車后行李箱中還配置了一個資料中心。他說,為了填補(bǔ)這些測試車和自動駕駛車(必須為大量部署而打造)之間的巨大鴻溝,一線(tier one)和汽車OEM需要一種全新的AI處理器,協(xié)助其更有效率地執(zhí)行相同的深度學(xué)習(xí)任務(wù)。

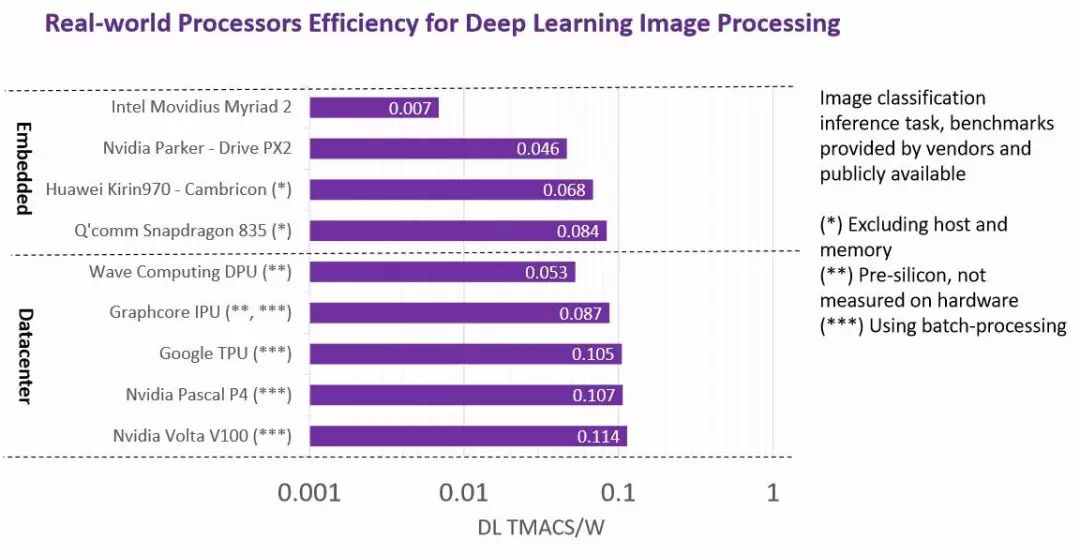

Hailo為此整理了目前每一款A(yù)I處理器的每瓦(W)深度學(xué)習(xí)TMACS。該公司與《EE Times》的讀者分享的重點(diǎn)在于深入探討:AV產(chǎn)業(yè)在多大程度上仍無法獲得推動高度自動駕駛車所需的高效能AI處理器。

業(yè)界分析師和其他AI新創(chuàng)公司高層也針對目前在AI發(fā)展道路上的重大障礙發(fā)表看法。

現(xiàn)代CPU架構(gòu)并不適用于AI

大多數(shù)業(yè)界觀察家一致認(rèn)為,目前基于馮·諾依曼(von Neumann)架構(gòu)的CPU處理器無法有效因應(yīng)當(dāng)今的AI處理任務(wù)。The Linley Group首席分析師Linley Gwennap指出,「Von Neumann不適用于AI。」他解釋說,每一次的運(yùn)算都必須擷取并解碼指令,以及收集并儲存資料于暫存器檔案中。「為了提高每瓦運(yùn)算效能,你必須執(zhí)行更多的運(yùn)算和更少的擷取任務(wù)。」

Krewell同意這一看法。他說:「Von Neumann架構(gòu)極其適于控制和循序計算:'If-Then-Else'操作。相形之下,神經(jīng)網(wǎng)路就像圖形一樣,是高度平行的,而且依賴于存儲器頻寬的處理。試圖用CPU擴(kuò)展神經(jīng)網(wǎng)路是相當(dāng)昂貴的(包括功耗和成本)。」

典型的馮·諾依曼(von Neumann)電腦架構(gòu)(來源:Hailo)

Danon說:「盡管Von Neumann架構(gòu)和現(xiàn)代CPU一般都非常靈活,但在很多情況下,這種靈活性并不是必要的。」它適用于神經(jīng)網(wǎng)路和其他操作,例如,為未來的許多周期預(yù)先確定行為。在這種情況下,他指出,設(shè)計系統(tǒng)的更有效方法是「避免以讀取指令來指導(dǎo)每個周期的系統(tǒng)行為。保持每個周期改變元素行為的靈活度非常重要。」

在Danon看來,「神經(jīng)網(wǎng)路將這一概念推向了極致。『結(jié)構(gòu)』——決定運(yùn)算元素之間連接性——確定整個會話的行為(又稱『運(yùn)算圖形』)。」簡言之,AI社群需要的不是基于Von Neumann架構(gòu)的處理器,而是「善于描述神經(jīng)網(wǎng)路結(jié)構(gòu)的特定處理器」。

重新關(guān)注資料流架構(gòu)

由于CPU和GPU的深度學(xué)習(xí)性能無法滿足需求,引發(fā)業(yè)界積極尋找基于資料流(dataflow)架構(gòu)的新解決方案。但為什么是資料流?

根據(jù)Gwenapp的說法,業(yè)界希望進(jìn)行更多的運(yùn)算和更少的擷取,首先嘗試開發(fā)寬的單指令/多資料(SIMD)架構(gòu)。「但是你只能將暫存器檔案做得很寬。」業(yè)界很快地發(fā)現(xiàn),該解決方案是「直接自動地將資料從運(yùn)算單元移動到運(yùn)算單元」。他說,「這是一種稱為資料流的通用方法,可以大幅降低von Neumann的開銷。」

不久前才收購MIPS的Wave Computing,是一家利用資料流技術(shù)的AI新創(chuàng)公司。根據(jù)該公司執(zhí)行長Derek Meyer表示,Wave Computing設(shè)計了一款新的處理單元,「可以原生支援Google TensorFlow和微軟(Microsoft)的CNTK」。

Danon坦承Hailo的新款A(yù)I處理器也屬于架構(gòu)的「資料流系列」。他解釋說,資料流「通常更適合深度學(xué)習(xí)」,因為「用于計算的大多數(shù)參數(shù)都不需要移動。相反地,它們用于描述資料流動時的圖形。」

資料流解決方案:典型的平行運(yùn)算架構(gòu)(來源:Hailo)

Krewell指出,資料流的概念并不是什么新鮮事兒,也已經(jīng)成功地在通用電腦硬體實(shí)現(xiàn)商用化了。

但是,隨著AI改變運(yùn)算領(lǐng)域,資料流正在尋找機(jī)器學(xué)習(xí)的「新機(jī)遇」。Krewell補(bǔ)充說:「透過使用資料流和脈動陣列架構(gòu),您可以將神經(jīng)網(wǎng)路處理設(shè)計為從一分層到另一分層,而無需太多控制邏輯。」

這種新轉(zhuǎn)折可說是Wave Computing的天賜良機(jī)。該新創(chuàng)公司自2010年以來一直在利用其于資料流技術(shù)方面的專業(yè)知識以及建立專利組合,積極地專注于機(jī)器和深度學(xué)習(xí)。

存儲器頻寬面臨瓶頸

AI——特別是卷積神經(jīng)網(wǎng)路(CNN),似乎非常適合資料流設(shè)計。但是,Gwenapp強(qiáng)調(diào),這并不表示所有的資料流設(shè)計都對AI有利,「系統(tǒng)中還存在著其他瓶頸,如存儲器頻寬。」

業(yè)界開始看到這樣的暗示:存儲器導(dǎo)向的裝置是客制深度學(xué)習(xí)硬體的未來。例如,新創(chuàng)公司Mythic瞄準(zhǔn)了將神經(jīng)網(wǎng)路映射到NOR存儲器陣列。該公司將「存儲器處理器」(processor-in-memory;PIM)架構(gòu)用于AI,使其晶片得以在快閃存儲器中儲存并處理神經(jīng)網(wǎng)路權(quán)重,而其結(jié)果(最終和中間)則儲存在SRAM中。因為這樣的記憶體陣列無需將資料移入和移出外部存儲器,所以,Mythic承諾將在其晶片中實(shí)現(xiàn)性能/功耗的巨大進(jìn)展。

存儲器處理器(PIM)(來源:Mythic)

Mythic的設(shè)計概念當(dāng)然具有吸引力,特別是當(dāng)大多數(shù)晶片設(shè)計者試圖提高存儲器頻寬時,一般都采用可能造成破壞的方法。然而,Danon抱持謹(jǐn)慎看法,他表示還不確定Mythic的存儲器處理器晶片能否正常運(yùn)作,但很可能「將技術(shù)推得太遠(yuǎn)了」。

Danon說,目前更實(shí)際和更現(xiàn)實(shí)的方法是「共同定位存儲器和運(yùn)算」。「我們需要讓運(yùn)算結(jié)構(gòu)能以高利用率存取所需的存儲器,從而產(chǎn)生非常高的頻寬。」他補(bǔ)充說,這對于實(shí)現(xiàn)運(yùn)算元素的高利用率至關(guān)重要。

Krewell則解釋,「一些挑戰(zhàn)是在訓(xùn)練期間保持權(quán)重。這就是像GraphCore在晶片上打造大型存儲器的原因。」他并補(bǔ)充說:「這也就是為什么GPU和英特爾(Intel)的Nervana使用高頻寬存儲器(HBM)、Wave Computing使用美光(Micron) Hypercube存儲器的原因。」

除了TPU,如何調(diào)整軟體和硬體?

Danon表示,Google經(jīng)由其Tensor處理器,「展示了一種樣板」,用于從頭開始設(shè)計高效率的架構(gòu),并針對推論任務(wù)進(jìn)行了最佳化。這是個大好消息。然而,壞消息是,如果客戶想要使用除了TensorFlow之外的深度學(xué)習(xí)架構(gòu)呢?

在這種情況下,他們就需要翻譯。雖然許多新興工具,包括ONNX,都用于翻譯幾個AI架構(gòu),但Danon解釋說,在此過程中,即使內(nèi)容不會在翻譯中完全遺失,計算也可能變得「非常低效」。他指出,產(chǎn)生這種困境的原因在于,以簡潔方式描述問題的神經(jīng)網(wǎng)路「結(jié)構(gòu)」必須轉(zhuǎn)換為von Neumann架構(gòu)的通用處理器所使用的一系列規(guī)則操作。

Danon指出,當(dāng)今的AI處理器在軟體和硬體之間缺乏一致性。他說,在理想情況下,軟體和硬體二者都使用基于結(jié)構(gòu)的描述方法。Hailo計劃將本機(jī)描述為「神經(jīng)網(wǎng)路分層」,從而使其處理器有別于其他處理器。

Danon解釋說,Hailo的目標(biāo)「有點(diǎn)類似于組合語言本身能夠在基于規(guī)則的系統(tǒng)中描述規(guī)則一樣——條件敘述和分支的形式。」

實(shí)現(xiàn)更高每瓦性能的競賽

深度學(xué)習(xí)性能效率是AI處理器競爭對手之間經(jīng)常引爆的一場大辯論。在輝達(dá)(Nvidia)和英特爾/Mobileye之間,兩家競爭對手的高層還公開爭辯其于Xavier SoC和EyeQ5的主張。

針對深度學(xué)習(xí)影像進(jìn)行處理的實(shí)際處理器效率比較(來源:Hailo)

Hailo根據(jù)每家供應(yīng)商發(fā)布的資料,編制了一份AI處理器比較表——從Nvidia的Volta V100、Pascal P4和Google TPU,到GraphCore IPU和Wave Computing DPU,詳細(xì)列出每家供應(yīng)商的深度學(xué)習(xí)tera級每秒乘積累加(TMAC)運(yùn)算和功耗資料。Hailo的目標(biāo)是為每個AI處理器計算深度學(xué)習(xí)的每瓦TMACS。Hailo并觀察到當(dāng)前的AI處理器可達(dá)到每瓦低于0.1TMACS的效能,而在使用批次處理方法時可能略高于此。

神經(jīng)網(wǎng)路(來源:Hailo)

Danon以處理高解析(HD)視訊為例指出,如果車輛以每秒30格(30f/s)的速度接收全高解析(FHD)視訊,并使用ResNet50網(wǎng)路進(jìn)行深度學(xué)習(xí)。處理FHD視訊串流通常需要每個感測器約5TMACS。根據(jù)自動駕駛的等級,一般汽車預(yù)計將配備4到12個攝影機(jī)感測器。

這意味著部署在自動駕駛車的任何現(xiàn)有AI處理器已經(jīng)讓每個感測器消耗約幾十瓦功耗,或每輛汽車幾百瓦了。Danon認(rèn)為這已經(jīng)超出太多了。或者,他懷疑,如果OEM無力應(yīng)付這么多的電力浪費(fèi),他們別無選擇,最終將只能在性能上大幅妥協(xié)。

理論上,「相較于傳統(tǒng)的von Neumann處理器,精心設(shè)計的CNN加速器應(yīng)該能達(dá)到更高數(shù)十倍的每瓦性能」。但是,Gwenapp說:「即便采用這種方法也不足以滿足4/5級自動駕駛車的挑戰(zhàn)性要求。」

換句話說,盡管市場上充斥過多的AI處理器,但沒有一款能夠達(dá)到讓全自動駕駛車實(shí)現(xiàn)商用化可行的性能標(biāo)準(zhǔn)。

但Gwennap仍抱持樂觀看法。「幸運(yùn)的是,我們還處于AI競賽的早期階段。預(yù)計在未來十年內(nèi)將能在硬體和軟體方面看到大幅的進(jìn)展。」

-

處理器

+關(guān)注

關(guān)注

68文章

19885瀏覽量

235057 -

cpu

+關(guān)注

關(guān)注

68文章

11076瀏覽量

216998 -

人工智能

+關(guān)注

關(guān)注

1806文章

49007瀏覽量

249274

原文標(biāo)題:自駕車AI芯片到位了嗎?

文章出處:【微信號:Imgtec,微信公眾號:Imagination Tech】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

用于無線 LAN 的 2.4 GHz 高效前端和適用于藍(lán)牙?應(yīng)用的端口 skyworksinc

適用于 WLAN 和藍(lán)牙?應(yīng)用的 2.4 GHz 高效前端 skyworksinc

2.4 GHz、256 QAM 前端模塊,用于 WLAN/ 和端口,適用于藍(lán)牙?應(yīng)用 skyworksinc

用于 WLAN/ 的 2.4 GHz、256 QAM 前端模塊和適用于藍(lán)牙?應(yīng)用的端口 skyworksinc

NVIDIA擴(kuò)展適用于AI工廠數(shù)字孿生的Omniverse Blueprint

適用于數(shù)據(jù)中心和AI時代的800G網(wǎng)絡(luò)

如何制作適用于Visionfive 2的Debian + UEFI固件系統(tǒng)?

進(jìn)迭時空 K1 系列 8 核 64 位 RISC - V AI CPU 芯片介紹

DP83816EX在硬體上是否可以用在PCIe to MAC?

NVIDIA推出適用于網(wǎng)絡(luò)安全的NIM Blueprint

適用于MySQL的dbForge架構(gòu)比較

適用于工業(yè)應(yīng)用的使用MDIO的以太網(wǎng)PHY配置

選擇適用于汽車應(yīng)用的基準(zhǔn)電壓

適用于AR眼鏡的TI DLP? Pico?技術(shù)

自動駕駛?cè)笾髁餍酒?b class='flag-5'>架構(gòu)分析

現(xiàn)代CPU架構(gòu)并不適用于AI,如何調(diào)整軟體和硬體?

現(xiàn)代CPU架構(gòu)并不適用于AI,如何調(diào)整軟體和硬體?

評論