最近,麻省理工學(xué)院的計(jì)算機(jī)科學(xué)家們提出了一種系統(tǒng),基于對(duì)圖片的語音描述,可以學(xué)習(xí)在圖片中辨認(rèn)目標(biāo)物體,給定一張圖片和音頻解釋,模型可以實(shí)時(shí)辨認(rèn)出音頻描述的相關(guān)區(qū)域。

與現(xiàn)有的語音識(shí)別技術(shù)不同,該模型不需要對(duì)其訓(xùn)練的樣本進(jìn)行手動(dòng)標(biāo)注,而是模型直接從錄音中學(xué)習(xí)單詞,并從原始圖片中學(xué)習(xí)目標(biāo)物體,將它們相互連接。

目前,模型僅僅可以辨認(rèn)幾百個(gè)不同的單詞和目標(biāo)物體類別,但是研究者希望,未來他們的這種語音和目標(biāo)辨認(rèn)相結(jié)合的技術(shù)可以節(jié)約大量手工勞動(dòng),為語音辨認(rèn)和圖像識(shí)別打開新的世界。

像Siri之類的語音識(shí)別系統(tǒng)需要對(duì)上千小時(shí)的錄音進(jìn)行轉(zhuǎn)譯。用這些數(shù)據(jù),系統(tǒng)學(xué)會(huì)將語音信號(hào)映射到具體的單詞上。但一旦詞匯中出現(xiàn)了新術(shù)語,這種方法就不管用了,系統(tǒng)就要重新訓(xùn)練。

計(jì)算機(jī)科學(xué)和人工智能實(shí)驗(yàn)室(CSAIL)的研究者,David Harwath表示:“我們想用一種更自然的方法進(jìn)行語音識(shí)別,使用人類常用的信號(hào)和信息來訓(xùn)練。但是那樣的機(jī)器學(xué)習(xí)算法并不容易獲取。我們想到了一種類似教小孩走路并敘述自己所看到的景象的方法。”Harwath曾參與發(fā)表了一篇論文,論文中的模型在最近的計(jì)算機(jī)視覺歐洲會(huì)議上進(jìn)行了展示。

在上述論文中,研究人員用一張圖片展示了他們的模型,圖片上有一位年輕的金發(fā)小女孩,她有一雙藍(lán)色的眼睛,穿著藍(lán)色的連衣裙,背景中有一座白色燈塔,燈塔的頂部是紅色的。模型會(huì)學(xué)習(xí)圖片中的哪些像素與小女孩有關(guān),例如哪些是“女孩”、“金發(fā)”、“藍(lán)眼睛”、“藍(lán)裙子”等等。隨著音頻的播放敘述,模型會(huì)在圖片上對(duì)這些區(qū)域進(jìn)行高亮。

其中一種有前景的應(yīng)用就是在兩種不同的語言之間進(jìn)行裝換,無需雙語標(biāo)注器。全世界大約有7000種語言,只有100種左右有足夠的數(shù)據(jù)進(jìn)行語音識(shí)別。但是,是否有這樣一種情景,當(dāng)兩種說著不同語言的人描述同一幅圖畫呢?如果模型學(xué)會(huì)語言A所描述的語言信號(hào)所對(duì)應(yīng)的圖中物體,同時(shí)也學(xué)會(huì)了B所描述的同樣物體,那么它就能將這兩種信號(hào)看作是彼此的翻譯版本。

Harwath說表示,這有助于解決神話故事中的“巴別塔”問題。

音頻-視覺聯(lián)系

這項(xiàng)工作是Harwath等人早期一項(xiàng)研究的擴(kuò)展,他們當(dāng)時(shí)研究將語音與相關(guān)主題的圖片相連接。在早期研究中,他們從Mechanical Turk平臺(tái)的分類數(shù)據(jù)集中選擇不同場景的圖片,之后讓人對(duì)圖片進(jìn)行描述,就像給小孩子講故事,錄制大約10秒鐘的視頻。他們收集了20多萬份圖片和與之對(duì)應(yīng)的音頻注解,分成了上百種不同類別,例如沙灘、購物廣場、城市街道、臥室等等。

之后,他們設(shè)計(jì)了一款模型,由兩個(gè)獨(dú)立的卷積神經(jīng)網(wǎng)絡(luò)構(gòu)成。其中一個(gè)處理圖像,另一個(gè)處理光譜(音頻信號(hào)的視覺表示)。模型的最高層會(huì)計(jì)算兩個(gè)網(wǎng)絡(luò)的輸出,并將語音模式映射到圖片數(shù)據(jù)上。

例如,研究者會(huì)A注釋輸入到圖片A中,這是相對(duì)應(yīng)的。之后又會(huì)隨機(jī)選擇一個(gè)注釋B輸入到圖片A中,這就是錯(cuò)誤的配對(duì)。經(jīng)過對(duì)比上千種錯(cuò)誤的陪讀,模型學(xué)會(huì)了與圖片A相對(duì)應(yīng)的語音信號(hào),然后將這些信號(hào)和注釋中的單詞聯(lián)系起來。正如2016年一份研究中所描述的,模型學(xué)會(huì)了表示“water”這個(gè)詞的語音信號(hào),然后檢索出了所有帶水的圖片。

但是Harwath表示,這并不能證明當(dāng)某人說出特定單詞時(shí)就指的是某個(gè)像素。

matchmap

在新的論文中,研究人員對(duì)之前的模型進(jìn)行了修改,將特定詞語和特定的像素補(bǔ)丁聯(lián)系在一起。研究人員在同樣的數(shù)據(jù)集上訓(xùn)練模型,但是最終共有40萬個(gè)圖片注釋對(duì)子,他們從中隨機(jī)選取了1000對(duì)用作測試。

在訓(xùn)練時(shí),模型像上述那樣給予不同的注釋,但這次,分析圖片的卷積神經(jīng)網(wǎng)絡(luò)將圖片用網(wǎng)格分成不同的部分,每個(gè)單元都有對(duì)應(yīng)的像素補(bǔ)丁。分析音頻的卷積神經(jīng)網(wǎng)絡(luò)將聲譜也分成不同片段,也就是說一秒鐘可能會(huì)有一到兩個(gè)單詞。

在正確的圖片和注釋對(duì)子下,模型會(huì)將第一個(gè)圖片網(wǎng)格與第一段音頻對(duì)應(yīng)起來,然后將同樣的圖片網(wǎng)格與第二段音頻對(duì)應(yīng),如此下去。對(duì)每個(gè)網(wǎng)格和音頻片段,模型都會(huì)給出一個(gè)相似度分?jǐn)?shù),表示音頻信號(hào)與目標(biāo)物體的相似程度有多少。

但其中的難題是,在訓(xùn)練過程中,模型并不知道音頻和圖片對(duì)應(yīng)的標(biāo)準(zhǔn)是什么。所以這篇論文最大的貢獻(xiàn)就是,它通過教網(wǎng)絡(luò)哪些圖片和注釋是同屬一類,而哪些不是,就能自動(dòng)推斷這些跨形態(tài)連接。

論文作者將語音和圖片像素之間的聯(lián)系稱作“matchmap”。訓(xùn)練了數(shù)千對(duì)圖片和注釋對(duì)子之后,網(wǎng)絡(luò)會(huì)在matchmap中主線縮小與詞語相對(duì)的目標(biāo)物體。

論文的寫作者Florian Metze說:“很高興看到這種神經(jīng)方法連接起圖片元素和音頻片段,并且不用文本作為中間工具。這并非是模仿熱淚學(xué)習(xí),而是完全基于彼此之間的連接。這也許能幫助我們理解,通過音頻和視頻線索如何形成視覺表示。機(jī)器翻譯是一種應(yīng)用,但它也能用于對(duì)瀕危語言的記錄上。我們也可以想象如何將這種技術(shù)應(yīng)用到廢除劉的語音中,或者殘障人士身上。”

-

語音識(shí)別

+關(guān)注

關(guān)注

39文章

1774瀏覽量

114007 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8496瀏覽量

134207 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25312

原文標(biāo)題:MIT設(shè)計(jì)跨模態(tài)系統(tǒng),讓模型“聽音識(shí)圖”

文章出處:【微信號(hào):jqr_AI,微信公眾號(hào):論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

怎樣在labview的圖片里插入與plc的通信接口,類似圖片中的組態(tài)軟件這種,在線等,急!

基于圖片特征的并行化海量圖片快速去重技術(shù)

基于深度學(xué)習(xí)的圖片中商品參數(shù)識(shí)別方法

深度學(xué)習(xí)為圖片壓縮算法,可以節(jié)省55%帶寬

哪個(gè)軟件可以打開HEIC圖片

谷歌新聞:谷歌解雇48名員工 新推機(jī)器學(xué)習(xí)標(biāo)注圖片功能

可解析圖片顏色及設(shè)置多彩陰影控件PaletteImageView

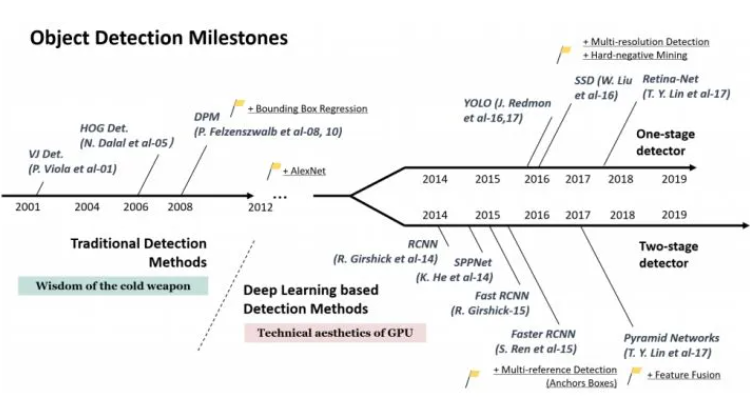

目標(biāo)檢測算法有哪些 目標(biāo)檢測算法原理圖

基于對(duì)圖片的語音描述,可以學(xué)習(xí)在圖片中辨認(rèn)目標(biāo)物體

基于對(duì)圖片的語音描述,可以學(xué)習(xí)在圖片中辨認(rèn)目標(biāo)物體

評(píng)論