當剛入門深度對抗網絡(GAN),我們可能會遇到的第一個問題是:應該從哪篇論文開始讀起呢?如果有著這樣的疑問,那就看看這篇GAN論文閱讀路線圖吧。

針對深度對抗網絡(GAN)的初學者,來自中東科技大學的學者?dil Sülo給出了GAN論文閱讀路線圖,以幫助人們更好更快地通過大量閱讀入門GAN。

路線圖按照下面四個準則構建而成:

從提綱到細節

從經典到前沿

從通用領域到特定領域

專注于最先進的技術

Generative Adversarial Networks – Paper Reading Road Map

今年夏天,我在我的實習工作中重點研究了Generative Adversarial Networks(GAN)。 起初,我對這個模型知之甚少,所以實習的最初幾周進行了大量的紙質閱讀。 為了幫助其他想要了解更多關于GAN技術的人,我想按照我閱讀的順序分享一些我讀過的文章。

在閱讀這些論文之前,如果您不熟悉這些論文,我建議您學習一些深度學習的基礎知識。 我也相信其中一些論文背后的數學可能非常困難,所以如果你覺得不舒服,你可以跳過這些部分。

這是我的論文閱讀路線圖,我給出了一些我自己關于論文的評論:

1. NIPS 2016 Tutorial: Generative Adversarial Networks

這是Ian Goodfellow的一個教程,介紹了GANS的重要性、它們的工作原理、與它們相關的研究前沿以及將GANS與其他方法結合起來最前沿的視覺模型。本教程首先介紹GANS的應用實例。然后,Ian Goodfellow對GANS和其他模型,如變分編碼器進行了比較。Goodfellow后來解釋了生成器和判別器是如何工作的,并且還描述了它們之間的關系。接下來,Goodfellow給出了改進GANS性能的一些技巧和竅門,以及與GANS相關的一些研究前沿。他還提及了GANS面臨的問題,比如模式崩塌。最后,Goodfellow提出了一些實際操作和解決方法。

Paper link: https://arxiv.org/abs/1701.00160

2. Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks

這篇論文描述了一種使卷積GAN訓練更加穩定的新型結構——深度卷積生成網絡(DCGAN)。研究人員給出了這種結構的一些指導方針,例如為更深的結構移除全連接的隱藏層,為生成器和鑒別器使用 batch normalisation,在生成器中為除輸出層之外的所有層使用ReLU,以及在鑒別器中的所有層使用LeakyReLU。

Paper link: https://arxiv.org/abs/1511.06434

本文提出了一種Wasserstein GAN(WGAN)來優化GANs的訓練過程。借助于WGAN,作者避免了模式崩塌等問題,并提供了可以調試和超參數搜索的學習方式,使用weight clipping來進行了一個Lipschitz約束,但是將在下一篇文章中看到另一種技術,將改進這部分。

Paper link: https://arxiv.org/abs/1701.07875

4. Improved Training of Wasserstein GANs

這篇論文發現,有時WGAN可能會出現不滿意的結果,如產生不好的例子,不能收斂等。這是由于上面提到的weight clipping的使用。在這個工作中,研究人員提出了一種替代weight clipping命名梯度懲罰的方法,把這種結構稱為WGAN-GP,并表明這種技術的使用極大地提高了WGAN的性能。

Paper link:https://arxiv.org/abs/1704.00028

5. On the Regularization of Wasserstein GANs

為了提升GAN訓練的穩定性,這篇論文提出了一種新的懲罰項來加強Lipschitz約束。他們把這種結構稱為WGAN-LP,并且在他們的實驗中,他們把它與上面提到的WGAN-GP進行比較。

Paper link: https://arxiv.org/abs/1709.08894

下面的論文提出了新的技術和結構,可以作為最前沿的tricks 來使生成式對抗網絡的訓練變得穩定。

6. Is Generator Conditioning Causally Related to GAN Performance?

本文提出了一種重要的技術Jacobian Clamping。通過該技術的幫助,研究者提供了GAN生成器的conditioning 和由這些GAN生成器表示的模型的“質量”之間存在因果關系的證據。

Paper link: https://arxiv.org/abs/1802.08768

7. Neural Photo Editing with Introspective Adversarial Networks

在這篇論文中,作者提出了感知圖像編輯器(Neural Photo Editor),它是一個圖像編輯界面,可以用生成神經網絡的能力來對圖像進行比較大的語義層面的合理修改。為了解決達到準確重建而不損失特征性質,作者提出了內省對抗式網絡(Introspective Adversarial Network),該網絡將GAN和VAE創新地結合在一起。通過使用基于權重分享的擴張卷積(weight-shareddilated convolutions)計算塊,該模型可以有效的獲得遠程依賴(long-rangedependencies),并且通過正交正則化(Orthogonal Regularization)這樣一個新的權重正則化方法,提升了泛化表現。作者在CeleA,SVHN和CIFAR-100數據庫上驗證了模型的有效性,并且產生了具有高視覺保真度的樣例和重構圖片。

Paper link: https://arxiv.org/abs/1609.07093

8. GANs Trained by a Two Time-Scale Update Rule Converge to a Local Nash Equilibrium

在這篇論文中, 作者引入兩種基于時間尺度的跟新規則,它們被證明可以收斂到穩定的局部納什均衡。

Paper link: https://arxiv.org/abs/1706.08500

9. Spectral Normalization for Generative Adversarial Networks

這篇文章提出一種稱為spectral normalization的新的權重歸一化技術,以穩定GAN鑒別器的訓練。

在高維空間中,鑒別器做出的密度比例估計往往不準確,而且在訓練中非常不穩定,生成器網絡也難以學到目標分布的多模態結構。更糟糕的是,當生成的和目標數據分布區域不相交的時候,就存在著一個能完美區分生成的數據和目標數據的鑒別器。一旦遇到了這樣的狀況、訓練出了這樣的鑒別器,生成器的訓練就基本停滯了,因為這樣產生的鑒別器的關于輸入的導數就成了0。這種情況讓作者們思考如何引入一些新的限制,避免訓練出這樣的鑒別器。在這篇論文中,作者們提出了一種新的權重正則化方法,稱作“spectral normalization”(光譜標準化),它可以穩定鑒別器網絡的訓練過程。這種正則化方法的性質很讓人喜歡:(1)只需要調節Lipschitz常數一個超參數,而且想到達到令人滿意的模型表現也不需要反復調試僅有的這一個參數;(2)方法的實現非常簡單,額外的計算開銷也很小。

Paper link: https://arxiv.org/abs/1802.05957

10. Generalization and Equilibrium in Generative Adversarial Nets (GANs)

泛化能力是衡量生成模型好壞的一個重要標準,本文指出 JS 散度、Wasserstein 距離都不能很好地衡量模型的泛化能力,為此,文中提出了一種基于 discriminator 的 neural network divergence/distance,用于衡量模型的泛化能力。此外作者還證明了 WGAN 的純策略納什均衡解的存在性,并提出MIX+GAN(混合策略 GAN)的訓練模式,該模式在實際訓練中更穩定,并且證明了混合策略納什均衡解的存在性。

Paper link: https://arxiv.org/abs/1703.00573

-

GaN

+關注

關注

19文章

2188瀏覽量

76413 -

深度學習

+關注

關注

73文章

5557瀏覽量

122624

原文標題:【新手必備】GAN生成對抗網絡論文閱讀路線圖(附論文下載鏈接)

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

全球唯一?IBM更新量子計算路線圖:2029年交付!

在混合電源設計上,Si、SiC、GaN如何各司其職?

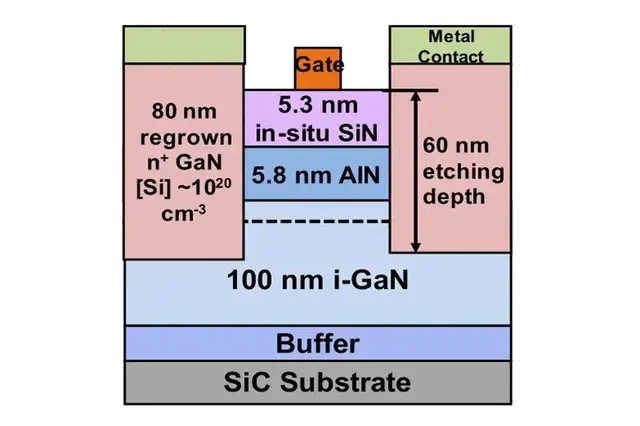

增強AlN/GaN HEMT

GaN LLC電源EMC優化技巧

功率GaN的新趨勢:GaN BDS

關于RISC-V學習路線圖推薦

未來10年智能傳感器怎么發展?美國發布最新MEMS路線圖

GAN論文閱讀路線圖,更快地通過大量閱讀入門GAN

GAN論文閱讀路線圖,更快地通過大量閱讀入門GAN

評論