近日,在 NeurIPS 2018 大會上,F(xiàn)acebook 官方宣布 PyTorch 1.0 正式版發(fā)布了。如何用Pytorch1.0搞深度學(xué)習(xí)?對很多小白學(xué)生是個問題。瑞士非盈利研究機構(gòu) Idiap Research Institute的研究員FRAN?OIS FLEURET開設(shè)了一門深度學(xué)習(xí)課程(2019年秋季),詳細結(jié)合深度學(xué)習(xí)與最新Pytorch1.0來為你細致講解,是學(xué)習(xí)Pytorch1.0深度學(xué)習(xí)不可多得的材料。

課程網(wǎng)址:

https://fleuret.org/ee559/

Francois Fleuret于2000年獲得巴黎第六大學(xué)數(shù)學(xué)博士學(xué)位,2006年獲得巴黎第十三大學(xué)數(shù)學(xué)博士學(xué)位。他是瑞士Idiap研究所計算機視覺和學(xué)習(xí)小組的負責人。在此之前,他曾在美國芝加哥大學(xué)、法國信息與自動化研究所(INRIA)和瑞士洛桑聯(lián)邦理工學(xué)院(EPFL)任職。他是IEEE模式分析和機器智能交易的副主編,也是幾個歐洲資助機構(gòu)的專家。

深度學(xué)習(xí)課程概述

本課程的目標是提供深度機器學(xué)習(xí)的完整講解。如何設(shè)計一個神經(jīng)網(wǎng)絡(luò),如何訓(xùn)練它,以及有哪些現(xiàn)有技術(shù)專門處理非常大的網(wǎng)絡(luò)結(jié)構(gòu)。本課程旨在教授應(yīng)用問題的深度學(xué)習(xí)方法所需的技能。

課程計劃內(nèi)容:

1. 什么是深度學(xué)習(xí),張量介紹。

2. 基本機器學(xué)習(xí),經(jīng)驗風險最小化,簡單嵌入。

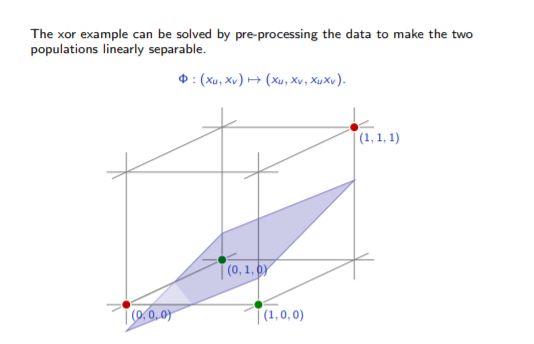

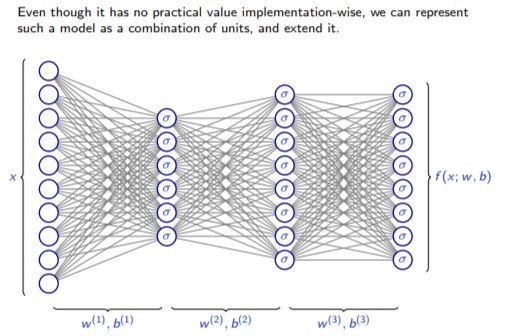

3. 線性可分性,多層感知器,反向傳播。

4. 通用網(wǎng)絡(luò),autograd,批處理,卷積網(wǎng)絡(luò)。

5. 初始化、優(yōu)化和正則化。Dropout,激活歸一化,跳過連接。

6. 計算機視覺的深層模型。

7. 深入模型分析。

9. 循環(huán)模型和自然語言處理。

10. pytorch張量,深度學(xué)習(xí)模塊,和內(nèi)部構(gòu)件。

深度學(xué)習(xí)課程導(dǎo)讀

緒論

1.1 從神經(jīng)網(wǎng)絡(luò)到深度學(xué)習(xí),21頁slides

1.2 當前成功應(yīng)用的實例 22頁slides

1.3 正在發(fā)生什么? (13頁slides)

1.4 張量基礎(chǔ)和線性回歸 12 頁slides

1.5 高維張量. 15頁slides

1.6 張量內(nèi)部 5頁slides

2. 機器學(xué)習(xí)基礎(chǔ)

2.1 損失函數(shù)與風險. 15頁slides

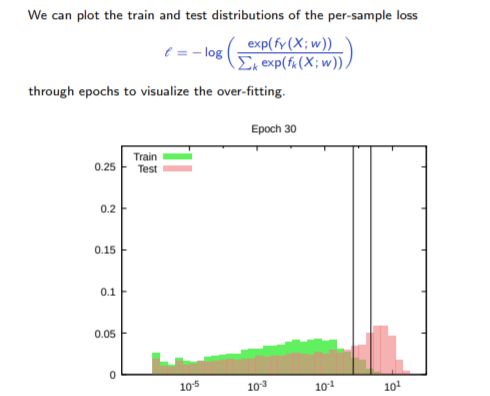

2.2 過擬合與欠擬合. 24頁slides

2.3 方差-偏差困境 10頁slides

2.4 合適評價方法 6頁slides

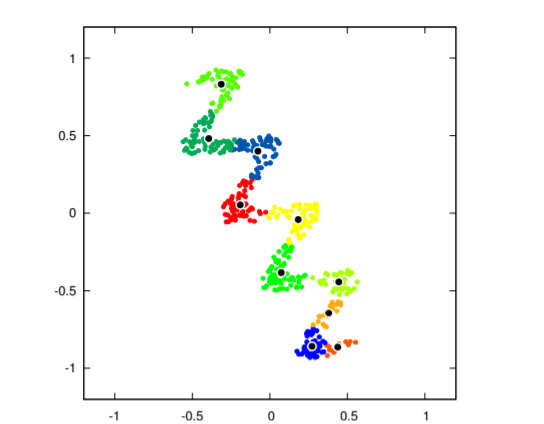

2.5 基本聚類與嵌入方法19頁slides

3. 多層感知器和反向傳播

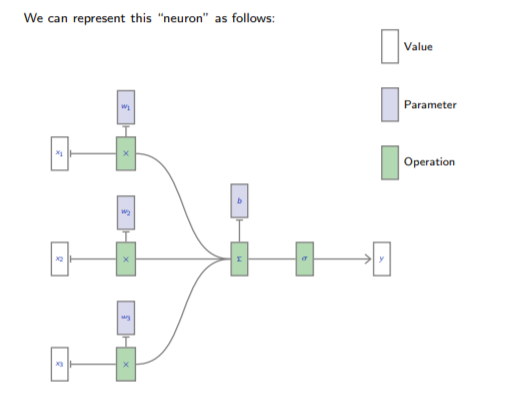

3.1 感知器。(幻燈片,講義- 16張)

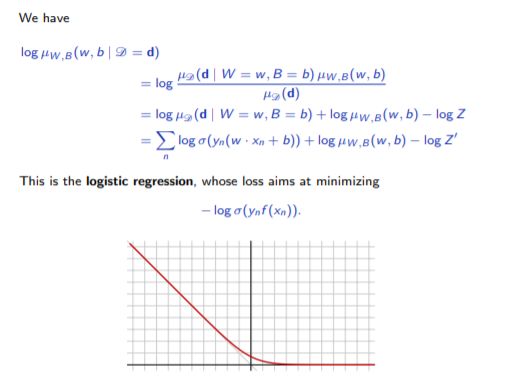

3.2 線性分類器的概率視圖。(幻燈片,講義- 8張)

3.3 線性可分性與特征設(shè)計。(幻燈片,講義- 10張)

3.4 多層感知器。(幻燈片,講義- 10張)

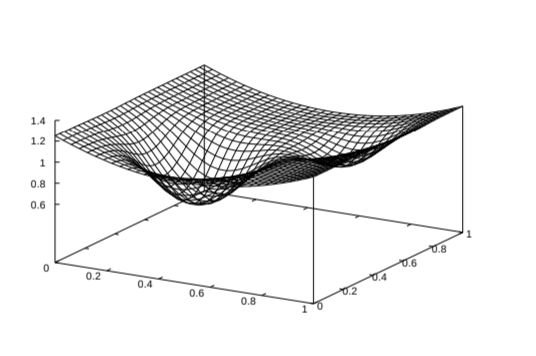

3.5 梯度下降法。(幻燈片,講義- 13張)

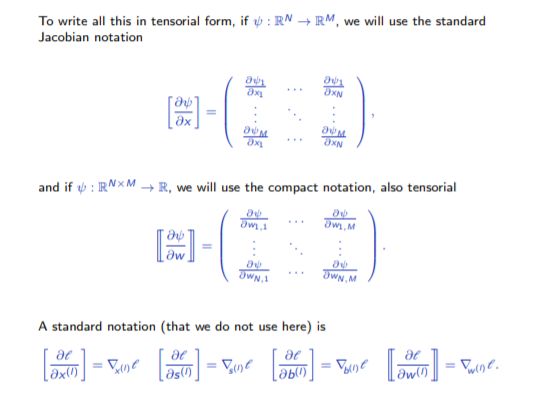

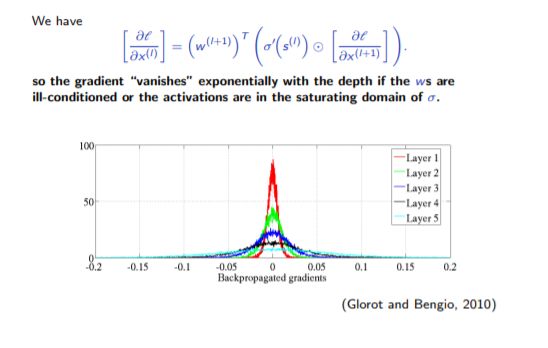

3.6 反向傳播。(幻燈片,講義- 11張)

4. 操作符、autograd和卷積層的圖操作

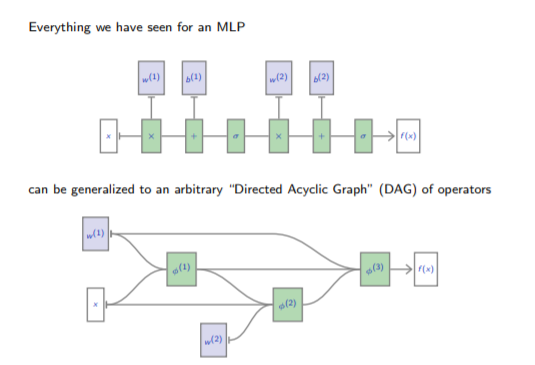

4.1 DAG網(wǎng)絡(luò)。(幻燈片,講義- 11張)

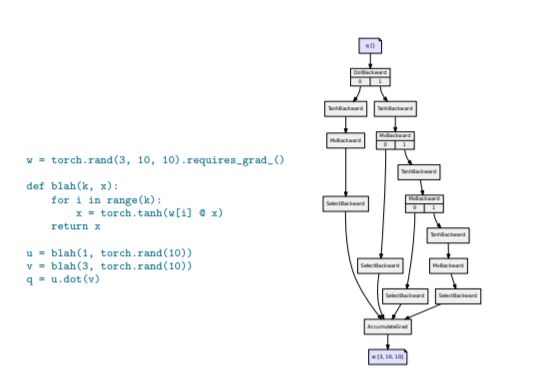

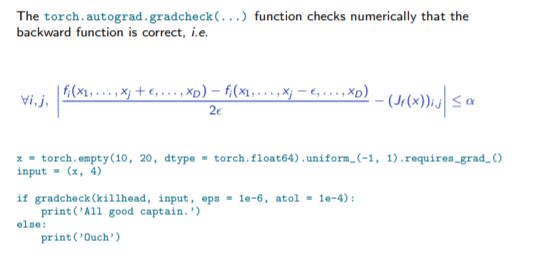

4.2 Autograd。(幻燈片,講義- 19張)

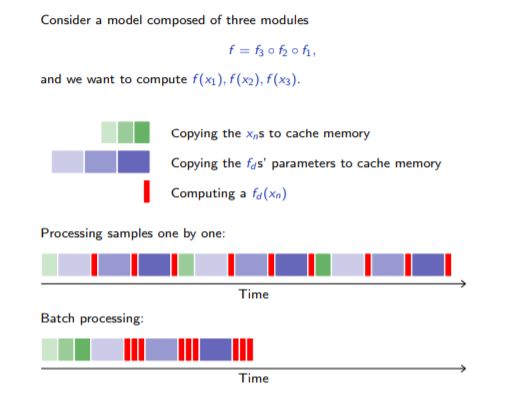

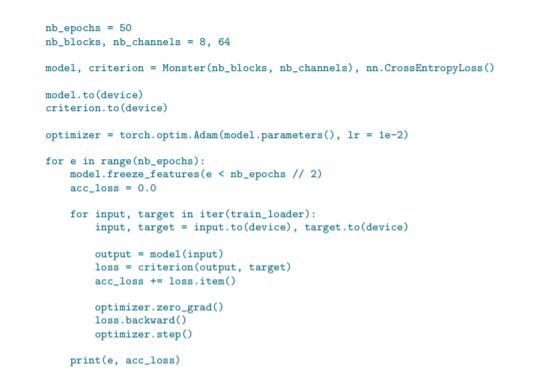

4.3 PyTorch模塊和批處理。(幻燈片,講義- 14張)

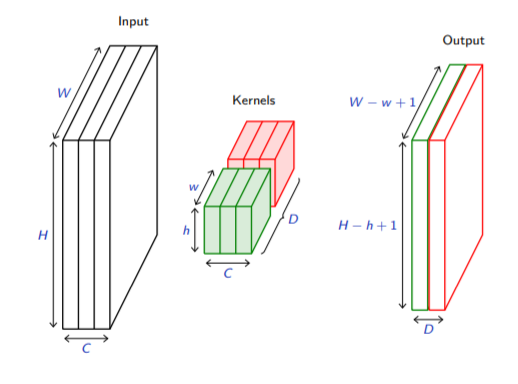

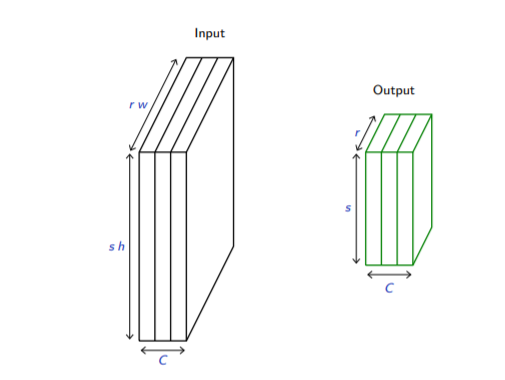

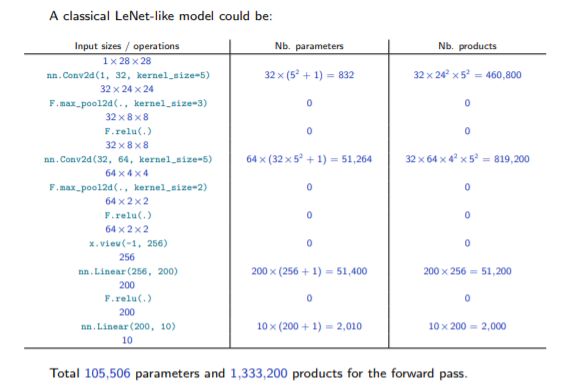

4.4 卷積。(幻燈片,講義- 23張)

4.5 池化(幻燈片,講義- 7張)

4.6 編寫一個PyTorch模塊。(幻燈片,講義- 10張)

5.1 交叉熵損失。(幻燈片,講義- 9張)

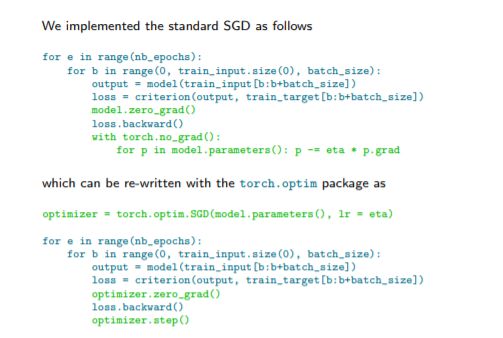

5.3 PyTorch優(yōu)化。(幻燈片,講義- 8張)

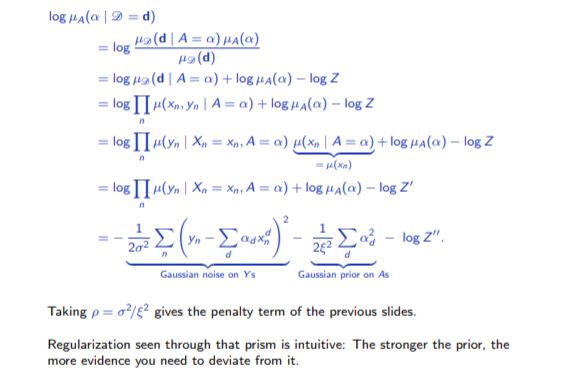

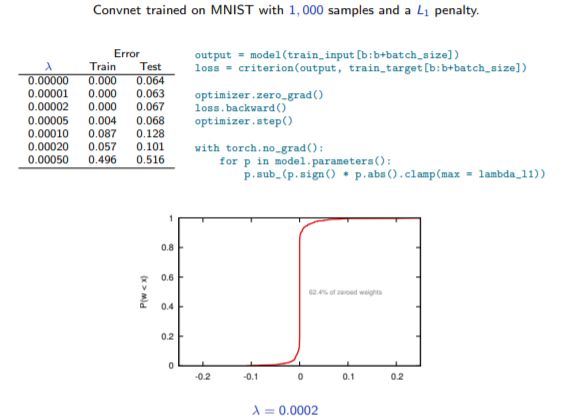

5.3 L1和L2 懲罰項。(幻燈片,講義- 10張)

5.4 參數(shù)初始化。(幻燈片,講義- 22張)

5.5 網(wǎng)絡(luò)架構(gòu)選擇和訓(xùn)練協(xié)議。(幻燈片,講義- 9張)

5.6 寫一個autograd函數(shù)。(幻燈片,講義- 7張)

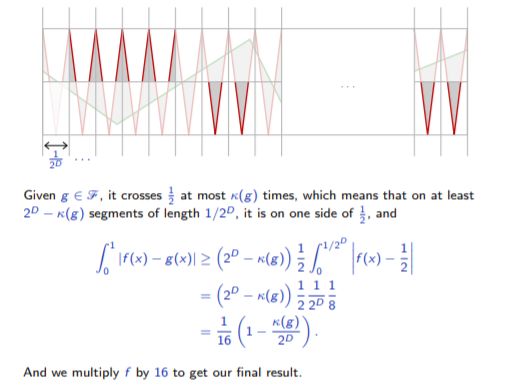

6.1 深度的好處。(幻燈片,講義- 9張)

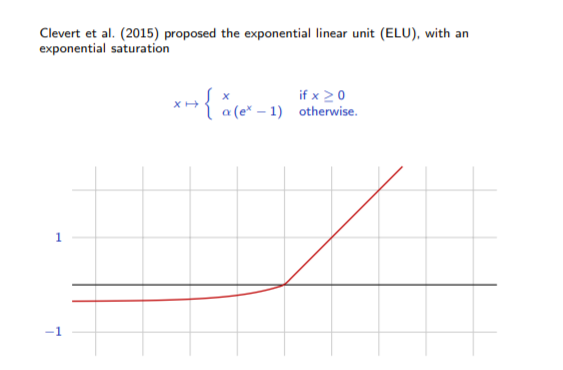

6.2 修正器。(幻燈片,講義- 7張)

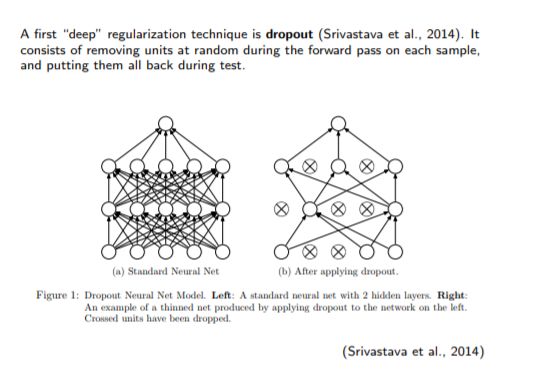

6.3 Dropout (幻燈片,講義- 12張)

7.1計算機視覺任務(wù)。(幻燈片,講義- 15張)

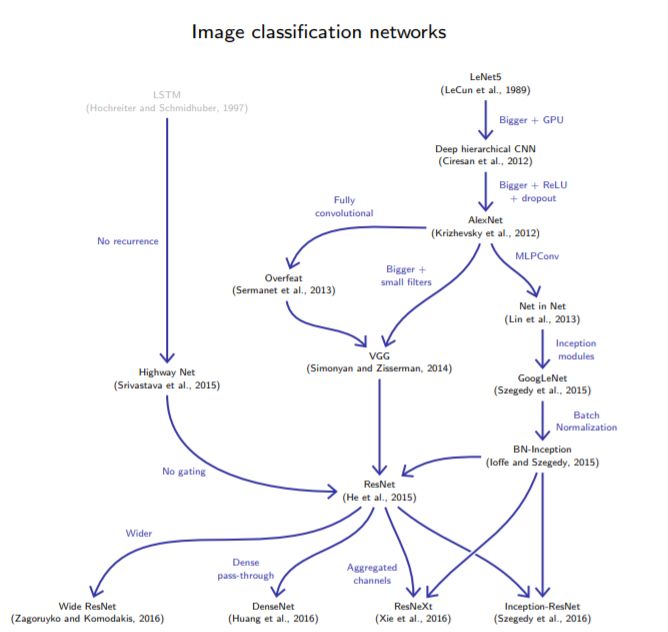

7.2 用于圖像分類的網(wǎng)絡(luò)。(幻燈片,講義- 36張)

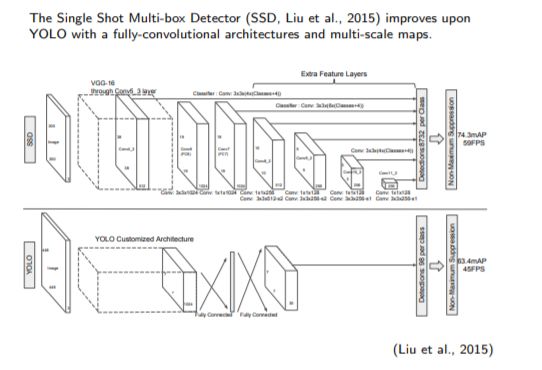

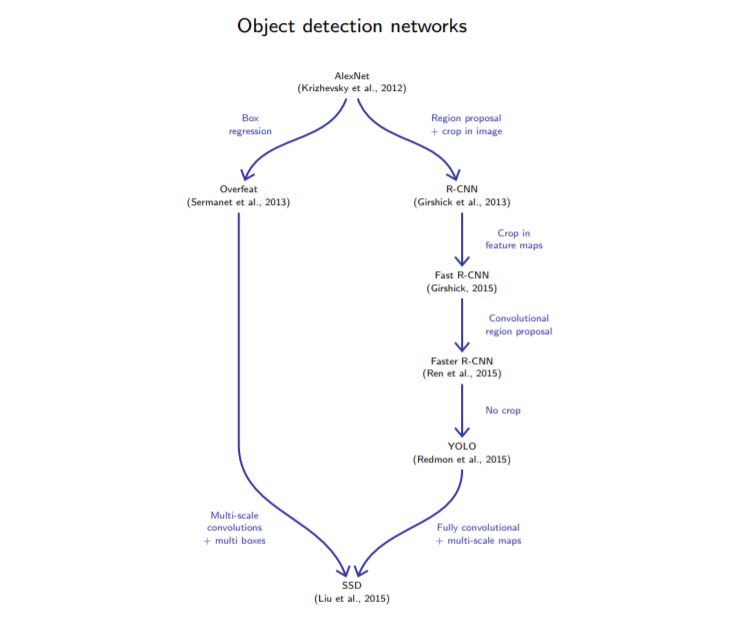

7.3用于目標檢測的網(wǎng)絡(luò)。(幻燈片,講義- 15張)

7.4 用于語義分割的網(wǎng)絡(luò)。(幻燈片,講義- 8張)

7.5 DataLoader和神經(jīng)。(幻燈片,講義- 13張)

8. 關(guān)鍵技巧方法處理

8.1 看參數(shù)。(幻燈片,講義- 11張)

8.2 激活。(幻燈片,講義- 21張)

8.3 可視化輸入中的處理。(幻燈片,講義- 26張)

8.4 優(yōu)化輸入。(幻燈片,講義- 25張)

9. 自編碼器和生成模型。

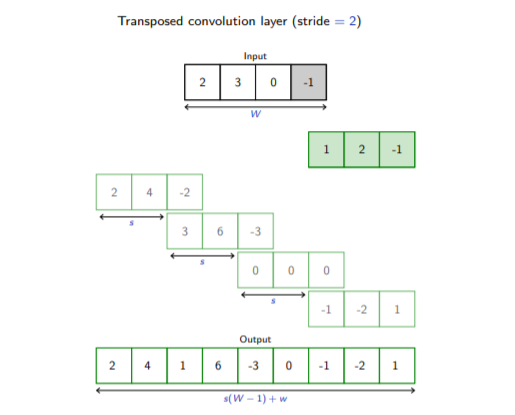

9.1 轉(zhuǎn)置運算。(幻燈片,講義- 14張)

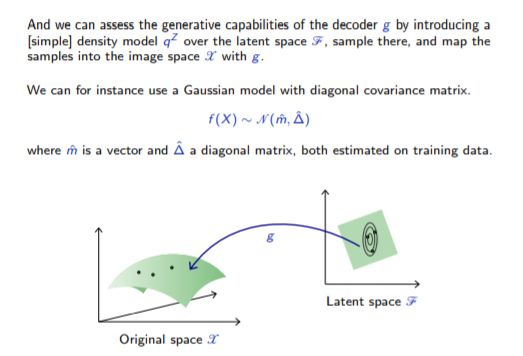

9.2 Autoencoders。(幻燈片,講義- 20張)

9.3 去噪和變分自編碼器。(幻燈片,講義- 24張)

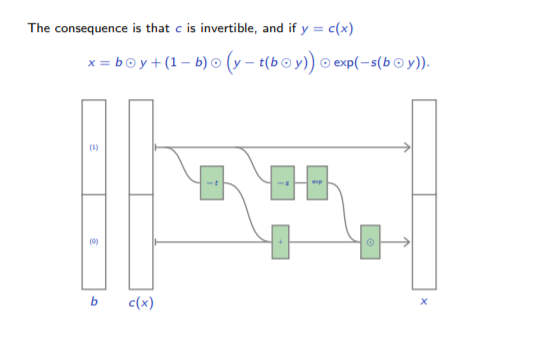

9.4Non-volume保存網(wǎng)絡(luò)。(幻燈片,講義- 24張)

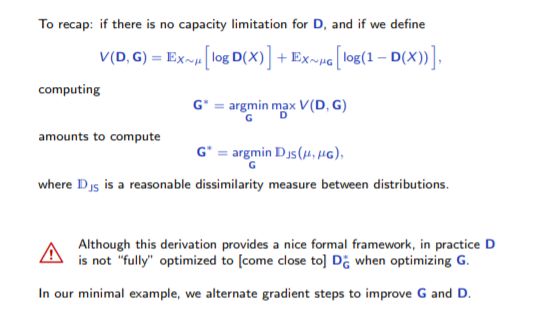

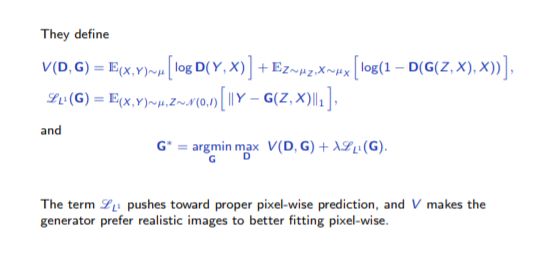

10. 生成對抗模型。

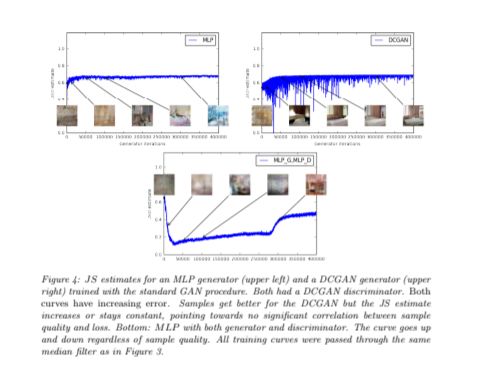

10.1 生成對抗的網(wǎng)絡(luò)。(幻燈片,講義- 29張)

10.2 Wasserstein GAN。(幻燈片,講義- 16張)

10.3 條件GAN和圖像轉(zhuǎn)換。(幻燈片,講義- 27張)

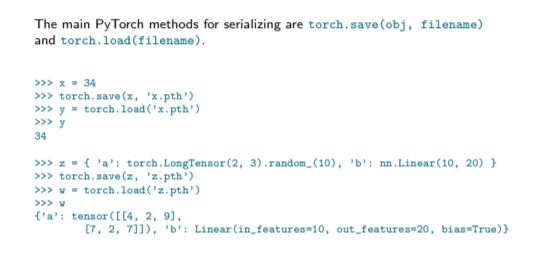

10.4 模型持久性和檢查點。(幻燈片,講義- 9張)

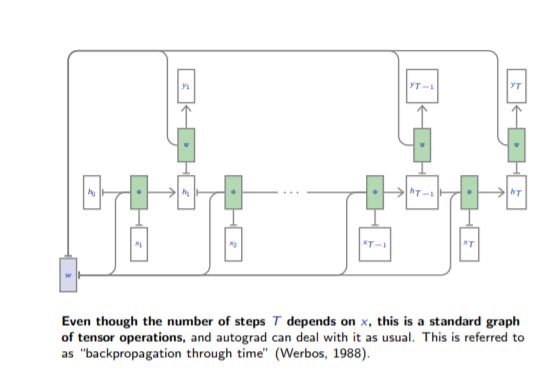

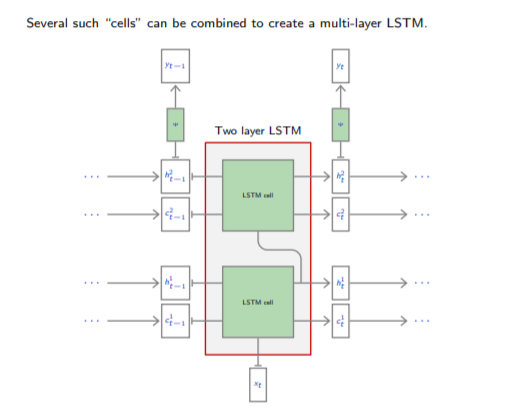

11循環(huán)模型與NLP

11.1 循環(huán)神經(jīng)網(wǎng)絡(luò)(slides,handout– 23 slides)

11.2 LSTM 和 GRU. (slides,handout– 17 slides)

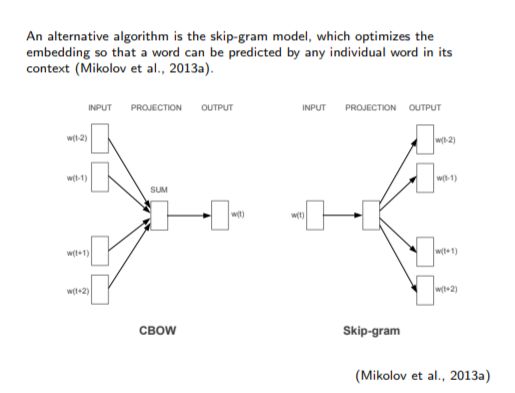

11.3 Word embeddings 與translation. (slides,handout– 31 slides)

更多閱讀:

5. 初始化和優(yōu)化。

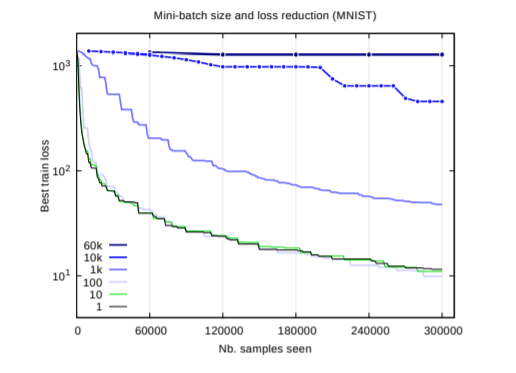

5.2 隨機梯度下降法。(幻燈片,講義- 17張)

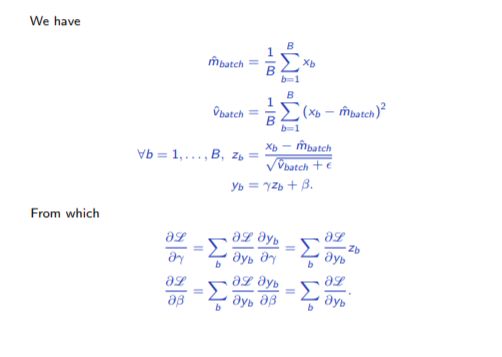

6. 搞更深

6.4 批處理歸一化。(幻燈片,講義- 15張)

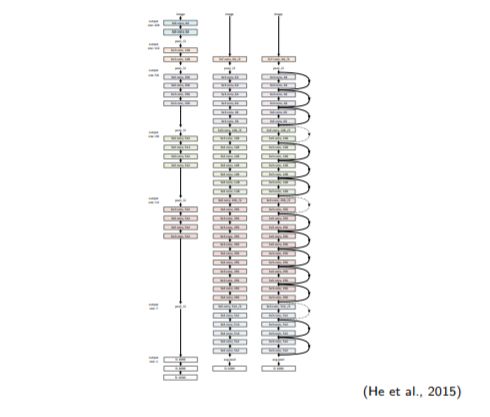

6.5 殘差網(wǎng)絡(luò)。(幻燈片,講義- 21張)

6.6 使用gpu。(幻燈片,講義- 17張)

-

計算機視覺

+關(guān)注

關(guān)注

9文章

1706瀏覽量

46617 -

機器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8497瀏覽量

134220 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5557瀏覽量

122576 -

pytorch

+關(guān)注

關(guān)注

2文章

809瀏覽量

13809

原文標題:Pytoch1.0深度學(xué)習(xí)如何玩?送你含900頁ppt和代碼實例

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

[基于GD32F350RB的音頻識別器] 4.使用Caffe2構(gòu)建訓(xùn)練平臺

通過Cortex來非常方便的部署PyTorch模型

Facebook致力AI 開源PyTorch1.0 AI框架

深度學(xué)習(xí)是什么?了解深度學(xué)習(xí)難嗎?讓你快速了解深度學(xué)習(xí)的視頻講解

Facebook宣布發(fā)布深度學(xué)習(xí)框架 PyTorch 1.0開發(fā)者預(yù)覽版

PyTorch官網(wǎng)教程PyTorch深度學(xué)習(xí):60分鐘快速入門中文翻譯版

為什么學(xué)習(xí)深度學(xué)習(xí)需要使用PyTorch和TensorFlow框架

基于PyTorch的深度學(xué)習(xí)入門教程之PyTorch的安裝和配置

基于PyTorch的深度學(xué)習(xí)入門教程之PyTorch簡單知識

PyTorch教程12.1之優(yōu)化和深度學(xué)習(xí)

結(jié)合深度學(xué)習(xí)與最新Pytorch1.0來為你細致講解

結(jié)合深度學(xué)習(xí)與最新Pytorch1.0來為你細致講解

評論