本文介紹了近期在機器學(xué)習(xí)/人工智能領(lǐng)域一些非常有創(chuàng)意的突破,每一個都腦洞大開,不管是否是相關(guān)從業(yè)人員都值得一讀。并附上一些論文、視頻鏈接和簡要總結(jié)。

與其他領(lǐng)域相比,機器學(xué)習(xí)/人工智能現(xiàn)在發(fā)展的非常快,經(jīng)常有一些有趣的突破。讓你不由自主的發(fā)出“wow”甚至“人間值得”的感嘆!(兩分鐘論文作者的口頭禪)

兩分鐘論文

https://www.youtube.com/channel/UCbfYPyITQ-7l4upoX8nvctg

免責聲明:我并沒有對“振奮人心”或“突破”進行嚴格的定義;這只是一個非正式的清單。我會用可能不那么嚴格的術(shù)語來讓這篇文章更通俗易懂。

從看似不可用的信息中得出驚人的準確估計

透過墻對人體姿態(tài)做估計

麻省理工學(xué)院研究人員的網(wǎng)站/視頻(2018年)

我們可以根據(jù)某人對WiFi信號的擾亂,準確地估計此人在墻壁另一側(cè)是如何站著/坐著/走路的。

從視頻中測量材料的物理特性

麻省理工學(xué)院研究人員的文章/視頻(2015年)

http://news.mit.edu/2015/visual-microphone-identifies-structural-defects-0521

研究人員在2014年首次展示了根據(jù)振動情況從薯片包裝袋的視頻(沒有聲音)中重現(xiàn)人類的語音。該成果沒有涉及機器學(xué)習(xí)。2015年,他們使用機器學(xué)習(xí),并展示了通過視頻來估計材料的剛度、彈性、單位面積的重量等(在某些情況下,僅僅空氣正常循環(huán)引起的振動就足夠了)。

從鍵盤旁邊的智能手機估計鍵盤敲擊

論文,2015

https://www.sigmobile.org/mobicom/2015/papers/p142-liuA.pdf

研究人員發(fā)現(xiàn),從一臺放在鍵盤旁邊的智能手機中錄制的音頻,可以以94%的準確率估計鍵盤敲擊。與以前在鍵盤周圍放置許多麥克風(fēng)的情況下使用有監(jiān)督的深度學(xué)習(xí)方法不同,這篇論文實際上使用了相對簡單的機器學(xué)習(xí)技術(shù)(k-均值聚類)和無監(jiān)督學(xué)習(xí)。

生成模型

逼真的面部生成、樣式混合和移植

Nvidia研究人員的論文/視頻(2018年)

論文

https://arxiv.org/abs/1812.04948

視頻

https://www.youtube.com/watch?v=kSLJriaOumA

研究人員將一種新的結(jié)構(gòu)與大量的GPU結(jié)合起來,創(chuàng)造出極其逼真的人造人臉,這些人臉是其他人臉之間的移植,或者是一個人臉到另一個人臉的“樣式”應(yīng)用。這項工作建立在過去關(guān)于生成對抗網(wǎng)絡(luò)(GANs)的工作之上。GANs是在2014年發(fā)明的,從那時起對它的研究就出現(xiàn)了爆炸式增長。GANs最基本的解釋是兩個相互對抗的神經(jīng)網(wǎng)絡(luò)(例如,一個是將圖像分類為“真實”或“假冒”的神經(jīng)網(wǎng)絡(luò),另一個是以試圖“欺騙”第一個神經(jīng)網(wǎng)絡(luò)將假冒圖像錯誤分類為真實的方式生成圖像的神經(jīng)網(wǎng)絡(luò)……因此,第二個神經(jīng)網(wǎng)絡(luò)是第一個的“對手”)。

總的來說,關(guān)于對抗性機器學(xué)習(xí)有很多很酷的研究,已經(jīng)存在了十多年。對網(wǎng)絡(luò)安全等也有許多令人毛骨悚然的影響,但我再講就跑題了。

很酷的研究

https://github.com/yenchenlin/awesome-adversarial-machine-learning

教機器繪圖

Google Brain的博客帖子(2017年)

https://ai.googleblog.com/2017/04/teaching-machines-to-draw.html

兩幅圖之間的插值

我在Google Brain的好朋友David Ha用一個生成循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)來繪制基于矢量的圖形(除了自動以外,我認為這就是Adobe Illustrator)。

David Ha

https://twitter.com/hardmaru

把炫酷的舞步遷移給不會跳舞的人

加州大學(xué)伯克利分校研究人員的網(wǎng)站/視頻(2018年)

網(wǎng)站

https://carolineec.github.io/everybody_dance_now/

視頻

https://www.youtube.com/watch?v=PCBTZh41Ris

想想“舞蹈版的Auto-Tune”。通過姿勢估計和生成對抗訓(xùn)練,研究人員能夠制作任何真人(“目標”人物)跳舞的假冒視頻,視頻中的人舞技精湛。所需輸入僅為:

一段舞蹈高手的跳舞短視頻

幾分鐘目標人物跳舞的視頻(通常很糟,因為大多數(shù)人都不擅長跳舞)

我還看到了Nvidia的首席執(zhí)行官黃延森(Jensen Huang)展示了一段自己像邁克爾杰克遜一樣跳舞的視頻(用這種技術(shù))。很高興我之前參加了GPU技術(shù)大會,哈哈。

強化學(xué)習(xí)

世界模型-人工智能在自己的夢里學(xué)習(xí)

Google Brain網(wǎng)站(2018年)

https://worldmodels.github.io/

人類并不真正了解或思考我們生活的世界里的所有細節(jié)。我們的行為基于我們頭腦中世界的抽象。例如,如果我騎在自行車上,我不會想到自行車的齒輪/螺母/螺栓;我只是大致了解車輪、座椅和把手的位置以及如何與它們交互。為什么不對人工智能使用類似的方法呢?

這種“世界模型”方法(同樣,由David Ha等人創(chuàng)建)允許“agent”(例如,在賽車游戲中控制汽車的人工智能)創(chuàng)建一個世界/周圍環(huán)境的生成模型,這是對實際環(huán)境的簡化/抽象。所以,你可以把這個世界模型看作是一個存在人工智能頭腦中的夢。然后人工智能可以通過強化學(xué)習(xí)在這個“夢”中得到更好的表現(xiàn)。因此,這種方法實際上是將生成性機器學(xué)習(xí)與強化學(xué)習(xí)相結(jié)合。通過這種方式,研究人員能夠在特定的電子游戲任務(wù)上實現(xiàn)目前最先進的水平。

[2019/2/15更新]在上述“世界模型”方法的基礎(chǔ)上,谷歌剛剛發(fā)布了PlaNet:Deep Planning Network for Reinformation Learning,與以前的方法相比,數(shù)據(jù)效率提高了5000%。

PlaNet:Deep Planning Network for Reinformation Learning

https://ai.googleblog.com/2019/02/introducing-planet-deep-planning.html

AlphaStar——擊敗頂級職業(yè)玩家的星際爭霸II AI

DeepMind(Google)的博客文章,e-sports-ish視頻,2019年

博客文章

https://deepmind.com/blog/alphastar-mastering-real-time-strategy-game-starcraft-ii/

e-sports-ish視頻

https://www.youtube.com/watch?v=cUTMhmVh1qs

我們在李世石和DeepMind AlphaGo之間的歷史性圍棋比賽之后已經(jīng)走了很長的路,這場比賽震撼了全世界,它僅僅發(fā)生在3年前的2016年(看看NetFlix紀錄片,讓一些人哭泣)。更令人驚訝的是,盡管沒有使用任何來自人類比賽的訓(xùn)練數(shù)據(jù),2017年的AlphaZero在圍棋方面比AlphaGo更好(也比國際象棋、日本象棋等領(lǐng)域的其他算法更好)。但2019年的AlphaStar更驚人。

李世石和DeepMind AlphaGo之間的歷史性圍棋比賽

https://en.wikipedia.org/wiki/AlphaGo_versus_Lee_Sedol

NetFlix紀錄片

https://www.netflix.com/sg/title/80190844

自1998年以來,作為一名星際迷,我很了解星際的精髓“……需要平衡短期和長期目標,適應(yīng)意外情況……這是一個巨大的挑戰(zhàn)。”這是一個真正困難和復(fù)雜的游戲,需要多層次的理解才能玩得好。自2009年以來,對星際游戲算法的研究一直在進行。

AlphaStar基本上使用了監(jiān)督學(xué)習(xí)(來自人類比賽)和強化學(xué)習(xí)(與自身對抗)的組合來實現(xiàn)其結(jié)果。

人類訓(xùn)練機器人

通過一次人工演示將任務(wù)傳授給機器

Nvidia研究人員的文章/視頻(2018年)

文章

https://news.developer.nvidia.com/new-ai-technique-helps-robots-work-alongside-humans/

視頻

https://www.youtube.com/watch?time_continue=1&v=B7ZT5oSnRys

我可以想到三種典型的方法來教機器人做一些事情,但都需要大量的時間/勞力:

針對每種情況手動編程機器人的關(guān)節(jié)旋轉(zhuǎn)等

讓機器人多次嘗試這個任務(wù)(強化學(xué)習(xí))

多次向機器人演示任務(wù)

通常對深度學(xué)習(xí)的一個主要批評是,產(chǎn)生數(shù)以百萬計的示例(數(shù)據(jù))是非常昂貴的。但是,有越來越多的方法不依賴如此昂貴的數(shù)據(jù)。

研究人員根據(jù)一個單一的人類演示視頻(一個實際的人類用手移動方塊),找到了一種機器人手臂成功執(zhí)行任務(wù)的方法(例如“拿起方塊并將其堆疊起來,使它們按順序排列:紅色、藍色、橙色”),即使視頻是從不同角度拍攝的。該算法實際上生成了一個它計劃執(zhí)行的任務(wù)的可讀描述,這對于故障排除非常有用。該算法依賴于具有姿態(tài)估計,合成訓(xùn)練數(shù)據(jù)生成和模擬到現(xiàn)實傳遞的對象檢測。

無監(jiān)督機器翻譯

Facebook人工智能研究博客(2018年)

https://code.fb.com/ai-research/unsupervised-machine-translation-a-novel-approach-to-provide-fast-accurate-translations-for-more-languages/

通常,你需要一個龐大的翻譯文檔訓(xùn)練數(shù)據(jù)集(例如聯(lián)合國議項的專業(yè)翻譯),以便很好地進行機器翻譯(即監(jiān)督學(xué)習(xí))。然后,許多主題和語言之間沒有高質(zhì)量、豐富的訓(xùn)練數(shù)據(jù)。在這篇論文中,研究人員發(fā)現(xiàn),可以使用無監(jiān)督學(xué)習(xí)(即不使用翻譯數(shù)據(jù),只使用每種語言中不相關(guān)的語料庫),達到最先進的監(jiān)督學(xué)習(xí)方法的翻譯質(zhì)量。Wow。

基本思想是,在任何語言中,某些單詞/概念往往會出現(xiàn)在很近的位置(例如“毛茸茸的”和“貓咪”)。他們把這描述為“不同語言中的詞嵌入具有相似的鄰域結(jié)構(gòu)。”好吧,我明白這個想法,但是使用這種方法,他們可以在沒有翻譯數(shù)據(jù)集的情況下達到如此高的翻譯質(zhì)量,仍然讓人吃驚。

結(jié)語

如果你之前沒有對機器學(xué)習(xí)/人工智能的發(fā)展感興趣的話,我希望這篇文章能幫到你。也許一年后我會再寫一篇類似的文章。

-

機器人

+關(guān)注

關(guān)注

213文章

29681瀏覽量

212559 -

模型

+關(guān)注

關(guān)注

1文章

3513瀏覽量

50332 -

機器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8500瀏覽量

134482

原文標題:腦洞大開!機器學(xué)習(xí)與AI突破(附鏈接)

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

最新人工智能硬件培訓(xùn)AI 基礎(chǔ)入門學(xué)習(xí)課程參考2025版(大模型篇)

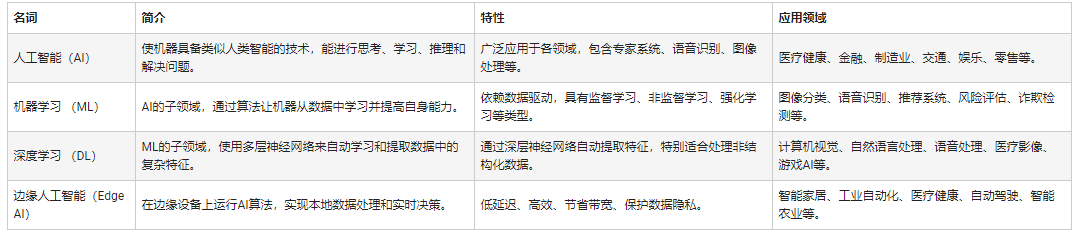

人工智能和機器學(xué)習(xí)以及Edge AI的概念與應(yīng)用

【「具身智能機器人系統(tǒng)」閱讀體驗】2.具身智能機器人大模型

【「具身智能機器人系統(tǒng)」閱讀體驗】+數(shù)據(jù)在具身人工智能中的價值

人工智能工程師高頻面試題匯總——機器學(xué)習(xí)篇

嵌入式和人工智能究竟是什么關(guān)系?

人工智能、機器學(xué)習(xí)和深度學(xué)習(xí)存在什么區(qū)別

機器學(xué)習(xí)/人工智能領(lǐng)域一些非常有創(chuàng)意的突破

機器學(xué)習(xí)/人工智能領(lǐng)域一些非常有創(chuàng)意的突破

評論