根據(jù)行業(yè)的參考標(biāo)準(zhǔn),AI將是下一件大事,或?qū)⒃谙乱患笫轮邪l(fā)揮重要作用。這也就解釋了過去18個(gè)月里人工智能領(lǐng)域活動的瘋狂。大公司支付數(shù)十億美元收購創(chuàng)業(yè)公司,甚至投入更多的資金用于研發(fā)。此外,各國政府正在向大學(xué)和研究機(jī)構(gòu)投入數(shù)十億美元。全球競賽正在進(jìn)行,目的是創(chuàng)建的最佳的架構(gòu)和系統(tǒng)來處理AI工作所必需的海量數(shù)據(jù)。

市場預(yù)測也相應(yīng)上升。 根據(jù)Tractica研究所的數(shù)據(jù),到2025年,AI年收入預(yù)計(jì)將達(dá)到368億美元。Tractica表示,迄今為止已經(jīng)確定了AI的27種不同的細(xì)分行業(yè)以及191個(gè)使用案例。

但隨著我們深入挖掘,很快就可以明顯地看到,并不存在一個(gè)的最好的方式來解決AI問題。甚至對于AI是什么,或需要分析的數(shù)據(jù)類型,我們尚沒有一致的定義。

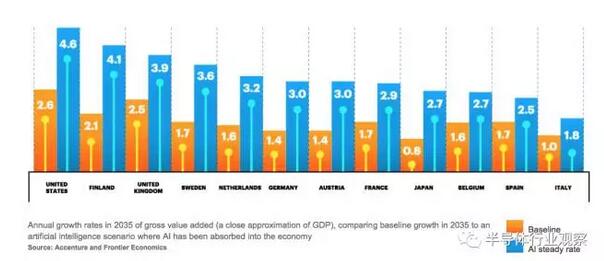

圖1 AI收入增長預(yù)測。來源:Tractica

OneSpin Solutions總裁兼首席執(zhí)行官Raik Brinkmann說,“在人工智能芯片中,你有三個(gè)問題需要解決。首先,你需要處理大量的數(shù)據(jù)。其次,構(gòu)建用于并行處理的互連。第三是功率,這是你移動數(shù)據(jù)量的直接結(jié)果。所以你亟須從馮諾依曼架構(gòu)轉(zhuǎn)變到數(shù)據(jù)流架構(gòu)。但它究竟是什么樣子?”

目前的答案很少,這就是為什么AI市場的第一顆芯片包括現(xiàn)成的CPU,GPU,FPGA和DSP的各種組合。雖然新設(shè)計(jì)正在由諸如英特爾、谷歌、英偉達(dá)、高通,以及IBM等公司開發(fā),但目前還不清楚哪家的方法會勝出。似乎至少需要一個(gè)CPU來控制這些系統(tǒng),但是當(dāng)流數(shù)據(jù)并行化時(shí),就會需要各種類型的協(xié)處理器。

AI的許多數(shù)據(jù)處理涉及矩陣乘法和加法。大量并行工作的GPU提供了一種廉價(jià)的方法,但缺點(diǎn)是更高的功率。具有內(nèi)置DSP模塊和本地存儲器的FPGA更節(jié)能,但它們通常更昂貴。這也是軟件和硬件真正需要共同開發(fā)的領(lǐng)域,但許多軟件遠(yuǎn)遠(yuǎn)落后于硬件。

Mentor Graphics董事長兼首席執(zhí)行官Wally Rhines表示:“目前,研究和教育機(jī)構(gòu)有大量的活動。有一場新的處理器開發(fā)競賽。也有標(biāo)準(zhǔn)的GPU用于深度學(xué)習(xí),同時(shí)還有很多人在從事CPU的工作。目標(biāo)是使神經(jīng)網(wǎng)絡(luò)的行為更像人腦,這將刺激一次全新的設(shè)計(jì)浪潮。”

當(dāng)視覺處理開始涉及到AI時(shí),便受到了極大的關(guān)注,主要是因?yàn)?a href="http://m.xsypw.cn/tags/特斯拉/" target="_blank">特斯拉在預(yù)計(jì)推出自動駕駛汽車的15年前就已經(jīng)提出了自動駕駛概念。這為視覺處理技術(shù),以及為處理由圖像傳感器、雷達(dá)和激光雷達(dá)收集的數(shù)據(jù)所需的芯片和整體系統(tǒng)架構(gòu)開辟了巨大的市場。但許多經(jīng)濟(jì)學(xué)家和咨詢公司正尋求超越這個(gè)市場,探討AI將如何影響整體生產(chǎn)力。Accenture最近的報(bào)道預(yù)測,AI將使一些國家的GDP翻番(見下圖2)。雖然這將導(dǎo)致就業(yè)機(jī)會大幅減少,但整體收入的提高不容忽視。

Synopsys董事長兼聯(lián)合首席執(zhí)行官Aart de Geus指出了電子學(xué)的三個(gè)浪潮——計(jì)算和網(wǎng)絡(luò)、移動、數(shù)字智能。在后一種類型中,焦點(diǎn)從技術(shù)本身轉(zhuǎn)移到它可以為人們做什么。

“You’ll see processors with neural networking IP for facial recognition and vision processing in automobiles,” said de Geus. “Machine learning is the other side of this. There is a massive push for more capabilities, and the state of the art is doing this faster. This will drive development to 7nm and 5nm and beyond.”

de Geus說:“你將看到具有面部識別和汽車視覺處理的神經(jīng)網(wǎng)絡(luò)IP。機(jī)器學(xué)習(xí)是其另一面。它對于更多的能力會產(chǎn)生一種巨大的推動,目前的技術(shù)水平可以快速完成這些。這將推動芯片發(fā)展到7nm、5nm,甚至更高的水平。”

目前的方法

自動駕駛中的視覺處理在AI當(dāng)前研究中占主導(dǎo)地位,但該技術(shù)在無人機(jī)和機(jī)器人中的作用也越來越大。

Achronix公司總裁兼首席執(zhí)行官Robert Blake說:“對于圖像處理的AI應(yīng)用,計(jì)算復(fù)雜度很高。對于無線技術(shù),數(shù)學(xué)很好理解。對于圖像處理,數(shù)學(xué)就像西部拓荒,工作負(fù)載復(fù)雜多變。大概花費(fèi)5~10年時(shí)間才能解決市場問題,但是它對于可編程邏輯肯定會有很大的作用,因?yàn)槲覀冃枰軌蛞愿叨炔⑿械姆绞酵瓿傻淖兙葦?shù)學(xué)。”

FPGA非常適合矩陣乘法。最重要的是,它的可編程性增加了一些必要的靈活性和面向未來的設(shè)計(jì),因?yàn)樵谶@一點(diǎn)上,不清楚所謂的智能將存在于一個(gè)設(shè)計(jì)的哪部分。用于做決策的數(shù)據(jù)一些將在本地處理,一些將在數(shù)據(jù)中心中處理。但在每個(gè)實(shí)現(xiàn)中,其百分比可能會改變。

這對AI芯片和軟件設(shè)計(jì)有很大的影響。雖然AI的大局并沒有太大的變化(大部分所謂的AI更接近于機(jī)器學(xué)習(xí),而非真正的AI),但是對于如何構(gòu)建這些系統(tǒng)的理解卻發(fā)生了重大的變化。

圖3:谷歌TPU開發(fā)板 來源:谷歌

Arteris營銷副總裁Kurt Shuler說:“對于自動駕駛汽車,人們正在做的就是把現(xiàn)有的東西放在一起。為了使一個(gè)真正高效的嵌入式系統(tǒng)能夠?qū)W習(xí),它需要一個(gè)高效的硬件系統(tǒng)。我們采用了幾種不同的方法。如果你關(guān)注視覺處理,你要做的是試圖弄清楚器件看到的是什么,以及你如何推斷。這包括來自視覺傳感器、激光雷達(dá)和雷達(dá)的數(shù)據(jù),然后應(yīng)用專門的算法。這里的很多事情都是試圖模仿大腦中的事情,方法是利用深度卷積神經(jīng)網(wǎng)絡(luò)。”

它與真正的AI的不同之處是,現(xiàn)有技術(shù)水平能夠檢測和避開物體,而真正的AI能夠擁有推理能力,例如如何通過一群人正在橫穿的街道,或判斷玩皮球的小孩子是否會跑到街道上。對于前者,判斷是基于各種傳感器的輸入,而傳感器的輸入是基于海量數(shù)據(jù)處理和預(yù)編程的行為。對于后者,機(jī)器能夠作出價(jià)值判斷,例如判斷轉(zhuǎn)彎避開孩子可能會造成的很多結(jié)果,并做出最佳選擇。

Shuler說:“傳感器融合是20世紀(jì)90年代出現(xiàn)的一種理念。你要把它變成機(jī)器可以處理的通用的數(shù)據(jù)格式。如果你在軍隊(duì)里,你擔(dān)心有人向你開槍。對于自動駕駛汽車而言,這就像面前有人推嬰兒車。所有這些系統(tǒng)都需要非常高的帶寬,并且都必須在其中內(nèi)置安全措施。最重要的是,你必須保護(hù)數(shù)據(jù),因?yàn)榘踩诔蔀樵絹碓酱蟮膯栴}。因此,你需要的是計(jì)算效率和編程效率。”

這是今天的許多設(shè)計(jì)中所缺少的,因?yàn)樘嗟拈_發(fā)是由現(xiàn)成的零件搭建的。

Cadence高級架構(gòu)師以及深度學(xué)習(xí)小組總監(jiān)Samer Hijazi說:“如果你優(yōu)化網(wǎng)絡(luò)、優(yōu)化問題、最小化位數(shù),并使用為卷積神經(jīng)網(wǎng)絡(luò)定制的硬件,那么你可以實(shí)現(xiàn)功率降低2~3倍的改進(jìn)。效率來自軟件算法和硬件IP。”

谷歌正嘗試改變這個(gè)公式。谷歌開發(fā)了Tensor處理單元(TPU),這是專門為機(jī)器學(xué)習(xí)而創(chuàng)建的ASIC。為了加快AI的發(fā)展,谷歌在2015年開源了TensorFlow軟件。

其他公司擁有自己的平臺。但這些都不是最終產(chǎn)品。這是進(jìn)化的過程,沒有人能確定未來十年AI將如何發(fā)展。部分是因?yàn)?a href="http://m.xsypw.cn/soft/data/42-102/" target="_blank">AI技術(shù)的使用案例正在逐漸被發(fā)現(xiàn)。在某個(gè)領(lǐng)域里有效的AI技術(shù)(如視覺處理)不一定適用于另一個(gè)領(lǐng)域(例如確定某種氣味是危險(xiǎn)的還是安全的,抑或是二者的組合)。

NetSpeed Systems營銷和業(yè)務(wù)開發(fā)副總裁Anush Mohandass說:“我們在黑暗中摸索,我們知道如何做機(jī)器學(xué)習(xí)和人工智能,但卻不知道它們真正的工作方式。目前的方法是使用大量擁有不同計(jì)算能力和不同種類的計(jì)算引擎——用于神經(jīng)網(wǎng)絡(luò)應(yīng)用的CPU、DSP,你需要確定它是有效的。但這只是第一代AI。重點(diǎn)是計(jì)算能力和異構(gòu)性。”

然而,隨著問題的解決變得更有針對性,這有望改變。就像早期版本的物聯(lián)網(wǎng)器件一樣,沒有人知道各類市場如何演變,因此系統(tǒng)公司投入了一切,并使用現(xiàn)有的芯片技術(shù)將產(chǎn)品推向市場。在智能手表的案例中,結(jié)果是電池充電后只能續(xù)航幾個(gè)小時(shí)。隨著針對這些特定應(yīng)用的新芯片的開發(fā),功耗和性能會實(shí)現(xiàn)平衡,方法是更有針對性的功能、本地處理與云處理之間更智能的分布、以及對于設(shè)計(jì)中的瓶頸的更深入的理解這三者的結(jié)合。

ARM模型技術(shù)總監(jiān)Bill Neifert說:“我們的挑戰(zhàn)是找到未知的瓶頸和限制。但根據(jù)于工作負(fù)載,處理器與軟件的交互方式不同,軟件本質(zhì)上是并行應(yīng)用程序。因此,如果你正在考慮工作負(fù)載,如金融建模或天氣圖,它們強(qiáng)調(diào)基礎(chǔ)系統(tǒng)的方式是不同的。你只能通過深入探索來理解。”

Neifert指出,軟件方面需要解決的問題需要從更高層次的抽象來看,因?yàn)檫@使得它們更容易約束和修復(fù)。這是拼圖的一個(gè)關(guān)鍵部分。隨著AI進(jìn)軍更多市場,所有這些技術(shù)都需要發(fā)展,以達(dá)到一般技術(shù)行業(yè),特別是半導(dǎo)體行業(yè)的同等效率。

Mohandass說:“現(xiàn)在我們發(fā)現(xiàn),如果他們只處理好一種類型的計(jì)算,那么架構(gòu)就會很困難。但異構(gòu)性的缺點(diǎn)是,將整體分而治之的方法變得土崩瓦解。因此,該解決方案通常涉及到超量供應(yīng)或供應(yīng)不足。”

新方法

隨著AI的應(yīng)用案例超越了自動駕駛汽車領(lǐng)域,其應(yīng)用將會擴(kuò)展。

這就是為什么英特爾去年八月收購了Nervana。Nervana開發(fā)了2.5D深度學(xué)習(xí)芯片,該芯片利用高性能處理器內(nèi)核,將數(shù)據(jù)通過中介層移動到高帶寬內(nèi)存。 Nervana聲稱的目標(biāo)是,與基于GPU的解決方案相比,該芯片訓(xùn)練深度學(xué)習(xí)模型的時(shí)間將縮短100倍。

eSilicon營銷副總裁Mike Gianfagna說:“這些看起來很像高性能計(jì)算芯片,本質(zhì)上是使用硅中介層的2.5D芯片。你將需要大量的吞吐量和超高帶寬內(nèi)存。我們已經(jīng)看到一些公司在關(guān)注它,但尚不足幾十家。它還為時(shí)尚早,實(shí)現(xiàn)機(jī)器學(xué)習(xí)和自適應(yīng)算法,以及如何將這些與傳感器和信息流整合,是非常復(fù)雜的。例如自動駕駛汽車,它從多個(gè)不同的來源串流數(shù)據(jù)并添加自適應(yīng)算法,以避免碰撞。”

Gianfagna表示,實(shí)現(xiàn)這些器件有兩個(gè)挑戰(zhàn)。其一是可靠性和認(rèn)證。其二是安全。

對于AI,可靠性需要在系統(tǒng)級考慮,其中包括硬件和軟件。ARM在12月收購Allinea提供了一個(gè)參照。另一個(gè)參照來自斯坦福大學(xué),研究人員試圖量化來自軟件的裁剪計(jì)算的影響。他們發(fā)現(xiàn),大規(guī)模切割或修剪不會對最終產(chǎn)品產(chǎn)生顯著影響。加州大學(xué)伯克利分校已經(jīng)開發(fā)了一個(gè)類似的方法,基于的計(jì)算接近100%的準(zhǔn)確率。

正在研究節(jié)能深度學(xué)習(xí)的斯坦福大學(xué)博士研究生韓松說“與精粒修剪相比,粗粒修剪不會降低精度。”他表示,斯坦福開發(fā)的稀疏矩陣要求計(jì)算減少10倍,內(nèi)存占用減少8倍,比DRAM的能耗減少120倍。它應(yīng)用于斯坦福所謂的高效語音識別引擎,壓縮導(dǎo)致了推理過程的加快。(Cadence最近的嵌入式神經(jīng)網(wǎng)絡(luò)峰會上提出了這些發(fā)現(xiàn)。)

量子計(jì)算為AI系統(tǒng)增加了另一個(gè)選擇。 Leti首席執(zhí)行官M(fèi)arie Semeria表示,量子計(jì)算是她的團(tuán)隊(duì)未來的方向之一,特別是AI應(yīng)用。IBM Research的科學(xué)與解決方案團(tuán)隊(duì)副總裁Dario Gil解釋說,使用經(jīng)典計(jì)算,如果四張卡片三藍(lán)一紅,那么有四分之一的機(jī)會猜中那張紅色的卡片。使用量子計(jì)算機(jī)和量子比特的疊加和糾纏,通過扭轉(zhuǎn)糾纏,系統(tǒng)每次都會給出正確答案。

結(jié)論

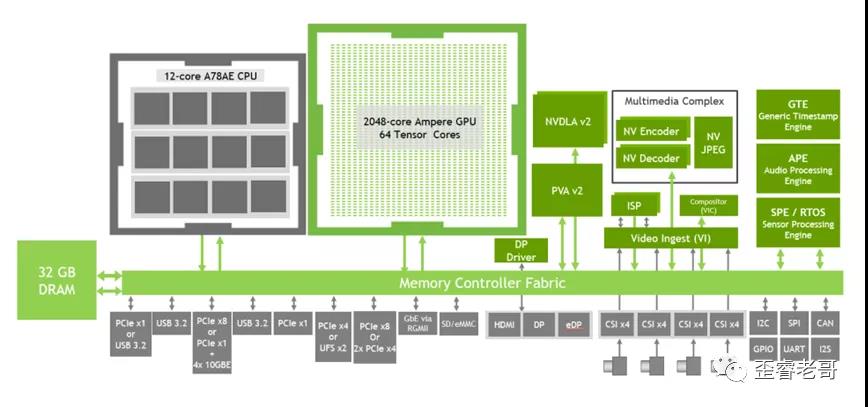

AI不是一件事,因此沒有單一的系統(tǒng)在任何地方都能完美地工作。但AI系統(tǒng)有一些通用要求,如下圖所示。

AI在許多市場都有應(yīng)用,所有這些都需要廣泛的改進(jìn)、昂貴的工具,以及支持它們的生態(tài)系統(tǒng)。經(jīng)過多年來依靠萎縮器件來提高功率、性能和成本,如今整個(gè)市場部門都在重新思考如何進(jìn)入新市場。這對于架構(gòu)師來說是一個(gè)巨大的勝利,這為設(shè)計(jì)團(tuán)隊(duì)增加了巨大的創(chuàng)造性選擇,也將刺激從工具和IP供應(yīng)商一直到包裝和流程開發(fā)的巨大發(fā)展。這就像為技術(shù)行業(yè)按下了重啟按鈕,可以證明,這對于未來整個(gè)生態(tài)系統(tǒng)的業(yè)務(wù)都是有益的。

電子發(fā)燒友App

電子發(fā)燒友App

評論