在神經(jīng)網(wǎng)絡(luò)建模中,經(jīng)常會出現(xiàn)關(guān)于神經(jīng)網(wǎng)絡(luò)應(yīng)該有多復(fù)雜的問題,即它應(yīng)該有多少層,或者它的濾波器矩陣應(yīng)該有多大。這個問題沒有簡單的答案。與此相關(guān),討論網(wǎng)絡(luò)過擬合和欠擬合非常重要。過擬合是模型過于復(fù)雜

2023-11-24 15:35:47 237

237

的復(fù)雜程度,通過調(diào)整內(nèi)部大量節(jié)點(diǎn)之間相互連接的關(guān)系,從而達(dá)到處理信息的目的,并具有自學(xué)習(xí)和自適應(yīng)的能力。簡單來說,就是通過大量的樣本訓(xùn)練神經(jīng)網(wǎng)絡(luò),得到結(jié)論。接著就可以輸入新的信息,看最后得出怎樣的回應(yīng)

2018-06-05 10:11:50

神經(jīng)網(wǎng)絡(luò)Matlab程序

2009-09-15 12:52:24

神經(jīng)網(wǎng)絡(luò)基本介紹

2018-01-04 13:41:23

第1章 概述 1.1 人工神經(jīng)網(wǎng)絡(luò)研究與發(fā)展 1.2 生物神經(jīng)元 1.3 人工神經(jīng)網(wǎng)絡(luò)的構(gòu)成 第2章人工神經(jīng)網(wǎng)絡(luò)基本模型 2.1 MP模型 2.2 感知器模型 2.3 自適應(yīng)線性

2012-03-20 11:32:43

將神經(jīng)網(wǎng)絡(luò)移植到STM32最近在做的一個項目需要用到網(wǎng)絡(luò)進(jìn)行擬合,并且將擬合得到的結(jié)果用作控制,就在想能不能直接在單片機(jī)上做神經(jīng)網(wǎng)絡(luò)計算,這樣就可以實(shí)時計算,不依賴于上位機(jī)。所以要解決的主要是兩個

2022-01-11 06:20:53

神經(jīng)網(wǎng)絡(luò)簡介

2012-08-05 21:01:08

近年來,深度學(xué)習(xí)的繁榮,尤其是神經(jīng)網(wǎng)絡(luò)的發(fā)展,顛覆了傳統(tǒng)機(jī)器學(xué)習(xí)特征工程的時代,將人工智能的浪潮推到了歷史最高點(diǎn)。然而,盡管各種神經(jīng)網(wǎng)絡(luò)模型層出不窮,但往往模型性能越高,對超參數(shù)的要求也越來越嚴(yán)格

2019-09-11 11:52:14

、成本及功耗的要求。輕型嵌入式神經(jīng)網(wǎng)絡(luò)卷積式神經(jīng)網(wǎng)絡(luò) (CNN) 的應(yīng)用可分為三個階段:訓(xùn)練、轉(zhuǎn)化及 CNN 在生產(chǎn)就緒解決方案中的執(zhí)行。要想獲得一個高性價比、針對大規(guī)模車輛應(yīng)用的高效結(jié)果,必須在每階段

2017-12-21 17:11:34

基于深度學(xué)習(xí)的神經(jīng)網(wǎng)絡(luò)算法

2019-05-16 17:25:05

1、ARM Cortex-M系列芯片神經(jīng)網(wǎng)絡(luò)推理庫CMSIS-NN詳解CMSIS-NN是用于ARM Cortex-M系列的芯片的神經(jīng)網(wǎng)絡(luò)推理庫,用于低性能芯片/架構(gòu)的神經(jīng)網(wǎng)絡(luò)部署

2022-08-19 16:06:43

和嵌入式應(yīng)用開發(fā)流程。神經(jīng)網(wǎng)絡(luò)算法的開發(fā)通常在Host主機(jī)上使用GPU加速完成,其簡要的流程如下:開發(fā)人員在Host主機(jī)上進(jìn)行算法開發(fā)工作(訓(xùn)練);開發(fā)(訓(xùn)練)完成后,通過交叉編譯的方式,在主機(jī)環(huán)境下

2020-05-18 17:13:24

MATLAB神經(jīng)網(wǎng)絡(luò)

2013-07-08 15:17:13

遞歸網(wǎng)絡(luò)newelm 創(chuàng)建一Elman遞歸網(wǎng)絡(luò)2. 網(wǎng)絡(luò)應(yīng)用函數(shù)sim 仿真一個神經(jīng)網(wǎng)絡(luò)init 初始化一個神經(jīng)網(wǎng)絡(luò)adapt 神經(jīng)網(wǎng)絡(luò)的自適應(yīng)化train 訓(xùn)練一個神經(jīng)網(wǎng)絡(luò)3. 權(quán)函數(shù)dotprod

2009-09-22 16:10:08

我在MATLAB中進(jìn)行了神經(jīng)網(wǎng)絡(luò)模型訓(xùn)練,然后將訓(xùn)練好的模型的閾值和權(quán)值導(dǎo)出來,移植到STM32F407單片機(jī)上進(jìn)行計算,但是在單片機(jī)上的計算結(jié)果和在MATLAB上的不一樣,一直找不到原因。代碼在

2020-06-16 11:14:28

嵌入式MCU上跑AI模型了,買了一塊開發(fā)板來做一些嘗試,做一下記錄。我所使用的Nucleo開發(fā)板,MCU為STM32F767ZITCube.AI的主要特點(diǎn):從預(yù)先訓(xùn)練的神經(jīng)網(wǎng)絡(luò)模型生成STM32優(yōu)化的庫。...

2022-02-22 06:50:34

請問:我在用labview做BP神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)故障診斷,在NI官網(wǎng)找到了機(jī)器學(xué)習(xí)工具包(MLT),但是里面沒有關(guān)于這部分VI的幫助文檔,對于”BP神經(jīng)網(wǎng)絡(luò)分類“這個范例有很多不懂的地方,比如

2017-02-22 16:08:08

習(xí)神經(jīng)神經(jīng)網(wǎng)絡(luò),對于神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)是如何一直沒有具體實(shí)現(xiàn)一下:現(xiàn)看到一個簡單的神經(jīng)網(wǎng)絡(luò)模型用于訓(xùn)練的輸入數(shù)據(jù):對應(yīng)的輸出數(shù)據(jù):我們這里設(shè)置:1:節(jié)點(diǎn)個數(shù)設(shè)置:輸入層、隱層、輸出層的節(jié)點(diǎn)

2021-08-18 07:25:21

《 AI加速器架構(gòu)設(shè)計與實(shí)現(xiàn)》+第一章卷積神經(jīng)網(wǎng)絡(luò)觀感

? ?在本書的引言中也提到“一圖勝千言”,讀完第一章節(jié)后,對其進(jìn)行了一些歸納(如圖1),第一章對常見的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行了介紹,舉例了一些結(jié)構(gòu)

2023-09-11 20:34:01

模型、更多神經(jīng)網(wǎng)絡(luò)模型、機(jī)器學(xué)習(xí)的步驟:訓(xùn)練與預(yù)測、訓(xùn)練的兩階段:正向推演與反向傳播、以TensoRFlow + Excel表達(dá)訓(xùn)練流程以及AI普及化教育之路。 7.【AI學(xué)習(xí)】第4篇--Python

2020-11-05 17:55:48

模型、更多神經(jīng)網(wǎng)絡(luò)模型、機(jī)器學(xué)習(xí)的步驟:訓(xùn)練與預(yù)測、訓(xùn)練的兩階段:正向推演與反向傳播、以TensoRFlow + Excel表達(dá)訓(xùn)練流程以及AI普及化教育之路。 7.【AI學(xué)習(xí)】第4篇--Python

2020-11-26 11:57:36

`本篇主要介紹:人工神經(jīng)網(wǎng)絡(luò)的起源、簡單神經(jīng)網(wǎng)絡(luò)模型、更多神經(jīng)網(wǎng)絡(luò)模型、機(jī)器學(xué)習(xí)的步驟:訓(xùn)練與預(yù)測、訓(xùn)練的兩階段:正向推演與反向傳播、以TensorFlow + Excel表達(dá)訓(xùn)練流程以及AI普及化教育之路。`

2020-11-05 17:48:39

的神經(jīng)網(wǎng)絡(luò)編程,想基于此開發(fā)板,進(jìn)行神經(jīng)網(wǎng)絡(luò)的學(xué)習(xí),訓(xùn)練和測試神經(jīng)網(wǎng)絡(luò)。項目計劃:1.基于官方的文檔及資料,熟悉此開發(fā)板。2.測試官方demo,學(xué)習(xí)ARM內(nèi)核和FPGA如何協(xié)調(diào)工作。3.基于自己最近

2019-01-09 14:48:59

,得到訓(xùn)練參數(shù)2、利用開發(fā)板arm與FPGA聯(lián)合的特性,在arm端實(shí)現(xiàn)圖像預(yù)處理已經(jīng)卷積核神經(jīng)網(wǎng)絡(luò)的池化、激活函數(shù)和全連接,在FPGA端實(shí)現(xiàn)卷積運(yùn)算3、對整個系統(tǒng)進(jìn)行調(diào)試。4、在基本實(shí)現(xiàn)系統(tǒng)的基礎(chǔ)上

2018-12-19 11:37:22

能在外界信息的基礎(chǔ)上改變內(nèi)部結(jié)構(gòu),是一種自適應(yīng)系統(tǒng),通俗的講就是具備學(xué)習(xí)功能。現(xiàn)代神經(jīng)網(wǎng)絡(luò)是一種非線性統(tǒng)計性數(shù)據(jù)建模工具。簡單來說,就是給定輸入,神經(jīng)網(wǎng)絡(luò)經(jīng)過一系列計算之后,輸出最終結(jié)果。這好比人的大腦

2019-03-03 22:10:19

。由于整個代碼使用python語言編寫,只使用了芯片的ARM處理器部分。雖然訓(xùn)練樣本較小,但在執(zhí)行訓(xùn)練函數(shù)的時候,也花費(fèi)了不少時間。如果能利用FPGA部分進(jìn)行神經(jīng)網(wǎng)絡(luò)的硬件加速,應(yīng)該可縮短整個運(yùn)行時

2019-03-18 21:51:33

的數(shù)篇帖子里,我會圍繞“基于PYNQ的神經(jīng)網(wǎng)絡(luò)自動駕駛小車”項目,對整個項目的實(shí)現(xiàn)進(jìn)行詳解,相信有電子設(shè)計基礎(chǔ)的網(wǎng)友們也可以很容易進(jìn)行復(fù)現(xiàn),制作并訓(xùn)練一輛屬于自己的自動駕駛小車。 一、作品背景如今

2019-03-02 23:10:52

元,它決定了該輸入向量在地位空間中的位置。SOM神經(jīng)網(wǎng)絡(luò)訓(xùn)練的目的就是為每個輸出層神經(jīng)元找到合適的權(quán)向量,以達(dá)到保持拓?fù)浣Y(jié)構(gòu)的目的。SOM的訓(xùn)練過程其實(shí)很簡單,就是接收到一個訓(xùn)練樣本后,每個輸出層神經(jīng)

2019-07-21 04:30:00

`BP神經(jīng)網(wǎng)絡(luò)首先給出只包含一個隱層的BP神經(jīng)網(wǎng)絡(luò)模型(兩層神經(jīng)網(wǎng)絡(luò)): BP神經(jīng)網(wǎng)絡(luò)其實(shí)由兩部分組成:前饋神經(jīng)網(wǎng)絡(luò):神經(jīng)網(wǎng)絡(luò)是前饋的,其權(quán)重都不回送到輸入單元,或前一層輸出單元(數(shù)據(jù)信息是單向

2019-07-21 04:00:00

人工神經(jīng)網(wǎng)絡(luò)是根據(jù)人的認(rèn)識過程而開發(fā)出的一種算法。假如我們現(xiàn)在只有一些輸入和相應(yīng)的輸出,而對如何由輸入得到輸出的機(jī)理并不清楚,那么我們可以把輸入與輸出之間的未知過程看成是一個“網(wǎng)絡(luò)”,通過不斷地給

2008-06-19 14:40:42

人工神經(jīng)網(wǎng)絡(luò)(Artificial Neural Network,ANN)是一種類似生物神經(jīng)網(wǎng)絡(luò)的信息處理結(jié)構(gòu),它的提出是為了解決一些非線性,非平穩(wěn),復(fù)雜的實(shí)際問題。那有哪些辦法能實(shí)現(xiàn)人工神經(jīng)網(wǎng)絡(luò)呢?

2019-08-01 08:06:21

人工神經(jīng)網(wǎng)絡(luò)課件

2016-06-19 10:15:48

簡單理解LSTM神經(jīng)網(wǎng)絡(luò)

2021-01-28 07:16:57

圖卷積神經(jīng)網(wǎng)絡(luò)

2019-08-20 12:05:29

通過堆疊卷積層使得模型更深更寬,同時借助GPU使得訓(xùn)練再可接受的時間范圍內(nèi)得到結(jié)果,推動了卷積神經(jīng)網(wǎng)絡(luò)甚至是深度學(xué)習(xí)的發(fā)展。下面是AlexNet的架構(gòu):AlexNet的特點(diǎn)有:1.借助擁有1500萬標(biāo)簽

2018-05-08 15:57:47

優(yōu)化神經(jīng)網(wǎng)絡(luò)訓(xùn)練方法有哪些?

2022-09-06 09:52:36

全連接神經(jīng)網(wǎng)絡(luò)和卷積神經(jīng)網(wǎng)絡(luò)的區(qū)別

2019-06-06 14:21:42

請問用matlab編程進(jìn)行BP神經(jīng)網(wǎng)絡(luò)預(yù)測時,訓(xùn)練結(jié)果很多都是合適的,但如何確定最合適的?且如何用最合適的BP模型進(jìn)行外推預(yù)測?

2014-02-08 14:23:06

以前的神經(jīng)網(wǎng)絡(luò)幾乎都是部署在云端(服務(wù)器上),設(shè)備端采集到數(shù)據(jù)通過網(wǎng)絡(luò)發(fā)送給服務(wù)器做inference(推理),結(jié)果再通過網(wǎng)絡(luò)返回給設(shè)備端。如今越來越多的神經(jīng)網(wǎng)絡(luò)部署在嵌入式設(shè)備端上,即

2021-12-23 06:16:40

卷積神經(jīng)網(wǎng)絡(luò)為什么適合圖像處理?

2022-09-08 10:23:10

卷積神經(jīng)網(wǎng)絡(luò)(CNN)究竟是什么,鑒于神經(jīng)網(wǎng)絡(luò)在工程上經(jīng)歷了曲折的歷史,您為什么還會在意它呢? 對于這些非常中肯的問題,我們似乎可以給出相對簡明的答案。

2019-07-17 07:21:50

等[16- 18]進(jìn)行分類。特征提取和分類器的 設(shè)計是圖片分類等任務(wù)的關(guān)鍵,對分類結(jié)果的好壞 有著最為直接的影響。卷積神經(jīng)網(wǎng)絡(luò)可以自動地從 訓(xùn)練樣本中學(xué)習(xí)特征并且分類,解決了人工特征設(shè)計 的局限性

2022-08-02 10:39:39

卷積神經(jīng)網(wǎng)絡(luò)的層級結(jié)構(gòu) 卷積神經(jīng)網(wǎng)絡(luò)的常用框架

2020-12-29 06:16:44

抽象人工智能 (AI) 的世界正在迅速發(fā)展,人工智能越來越多地支持以前無法實(shí)現(xiàn)或非常難以實(shí)現(xiàn)的應(yīng)用程序。本系列文章解釋了卷積神經(jīng)網(wǎng)絡(luò) (CNN) 及其在 AI 系統(tǒng)中機(jī)器學(xué)習(xí)中的重要性。CNN 是從

2023-02-23 20:11:10

什么是卷積神經(jīng)網(wǎng)絡(luò)?ImageNet-2010網(wǎng)絡(luò)結(jié)構(gòu)是如何構(gòu)成的?有哪些基本參數(shù)?

2021-06-17 11:48:22

二十多種不同的神經(jīng)網(wǎng)絡(luò)計算,各種復(fù)雜的網(wǎng)絡(luò)結(jié)構(gòu)。它幾乎不依賴硬件平臺,同時能在各種32bit 和64bit的平臺上編譯運(yùn)行。它提供一鍵轉(zhuǎn)換腳本,可以一行代碼把剛訓(xùn)練好的Keras模型轉(zhuǎn)換成一個獨(dú)立的C

2019-05-01 19:03:01

為提升識別準(zhǔn)確率,采用改進(jìn)神經(jīng)網(wǎng)絡(luò),通過Mnist數(shù)據(jù)集進(jìn)行訓(xùn)練。整體處理過程分為兩步:圖像預(yù)處理和改進(jìn)神經(jīng)網(wǎng)絡(luò)推理。圖像預(yù)處理主要根據(jù)圖像的特征,將數(shù)據(jù)處理成規(guī)范的格式,而改進(jìn)神經(jīng)網(wǎng)絡(luò)推理主要用于輸出結(jié)果。 整個過程分為兩個步驟:圖像預(yù)處理和神經(jīng)網(wǎng)絡(luò)推理。需要提前安裝Tengine框架,

2021-12-23 08:07:33

最近在學(xué)習(xí)電機(jī)的智能控制,上周學(xué)習(xí)了基于單神經(jīng)元的PID控制,這周研究基于BP神經(jīng)網(wǎng)絡(luò)的PID控制。神經(jīng)網(wǎng)絡(luò)具有任意非線性表達(dá)能力,可以通過對系統(tǒng)性能的學(xué)習(xí)來實(shí)現(xiàn)具有最佳組合的PID控制。利用BP

2021-09-07 07:43:47

得出得神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)誤差曲線和數(shù)字識別結(jié)果如圖1 所示。 本文將0 ~ 9 共10 類數(shù)據(jù)中的每類取20 個做測試樣本,共200 個測試樣本對系統(tǒng)進(jìn)行性能測試。測試結(jié)果如表1 所列。由表1 中的數(shù)據(jù)

2018-11-13 16:04:45

基于BP神經(jīng)網(wǎng)絡(luò)的辨識

2018-01-04 13:37:27

FPGA實(shí)現(xiàn)神經(jīng)網(wǎng)絡(luò)關(guān)鍵問題分析基于FPGA的ANN實(shí)現(xiàn)方法基于FPGA的神經(jīng)網(wǎng)絡(luò)的性能評估及局限性

2021-04-30 06:58:13

基于RBF神經(jīng)網(wǎng)絡(luò)的辨識

2018-01-04 13:38:52

基于光學(xué)芯片的神經(jīng)網(wǎng)絡(luò)訓(xùn)練解析,不看肯定后悔

2021-06-21 06:33:55

作者:Nagesh Gupta 創(chuàng)始人兼 CEOAuviz Systems Nagesh@auvizsystems.com憑借出色的性能和功耗指標(biāo),賽靈思 FPGA 成為設(shè)計人員構(gòu)建卷積神經(jīng)網(wǎng)絡(luò)

2019-06-19 07:24:41

如何用stm32cube.ai簡化人工神經(jīng)網(wǎng)絡(luò)映射?如何使用stm32cube.ai部署神經(jīng)網(wǎng)絡(luò)?

2021-10-11 08:05:42

原文鏈接:http://tecdat.cn/?p=5725 神經(jīng)網(wǎng)絡(luò)是一種基于現(xiàn)有數(shù)據(jù)創(chuàng)建預(yù)測的計算系統(tǒng)。如何構(gòu)建神經(jīng)網(wǎng)絡(luò)?神經(jīng)網(wǎng)絡(luò)包括:輸入層:根據(jù)現(xiàn)有數(shù)據(jù)獲取輸入的層隱藏層:使用反向傳播優(yōu)化輸入變量權(quán)重的層,以提高模型的預(yù)測能力輸出層:基于輸入和隱藏層的數(shù)據(jù)輸出預(yù)測

2021-07-12 08:02:11

訓(xùn)練一個神經(jīng)網(wǎng)絡(luò)并移植到Lattice FPGA上,通常需要開發(fā)人員既要懂軟件又要懂?dāng)?shù)字電路設(shè)計,是個不容易的事。好在FPGA廠商為我們提供了許多工具和IP,我們可以在這些工具和IP的基礎(chǔ)上做

2020-11-26 07:46:03

神經(jīng)網(wǎng)絡(luò)(Neural Networks)是人工神經(jīng)網(wǎng)絡(luò)(Ar-tificial Neural Networks)的簡稱,是當(dāng)前的研究熱點(diǎn)之一。人腦在接受視覺感官傳來的大量圖像信息后,能迅速做出反應(yīng)

2019-08-08 06:11:30

引入了圖采樣,以進(jìn)一步加速神經(jīng)網(wǎng)絡(luò)的訓(xùn)練并減少通信開銷。基于上述通信縮減策略,本文提出了時序圖神經(jīng)網(wǎng)絡(luò)系統(tǒng)T-GCN。實(shí)驗結(jié)果表明,T-GCN實(shí)現(xiàn)了最高7.9倍的整體性能提升。在圖采樣性能上,本文提出的線段二分搜索采樣算法能夠?qū)崿F(xiàn)最高38.8倍的采樣性能提升。原作者:追求卓越的Baihai IDP

2022-09-28 10:37:20

的成分做為電路故障特征,再輸入給量子神經(jīng)網(wǎng)絡(luò)。不僅解決了一個可測試點(diǎn)問題,并提高了辨識故障類別的能力,而且在網(wǎng)絡(luò)訓(xùn)練之前,利用主元分析降低了網(wǎng)絡(luò)輸入維數(shù)。通過實(shí)驗可以看出,這種方法不僅能實(shí)現(xiàn)模擬電路單軟軟故障診斷,也能實(shí)現(xiàn)多軟軟故障診斷,實(shí)驗統(tǒng)計結(jié)果表明:故障診斷率為100%。

2019-07-05 08:06:02

人工神經(jīng)網(wǎng)絡(luò)在AI中具有舉足輕重的地位,除了找到最好的神經(jīng)網(wǎng)絡(luò)模型和訓(xùn)練數(shù)據(jù)集之外,人工神經(jīng)網(wǎng)絡(luò)的另一個挑戰(zhàn)是如何在嵌入式設(shè)備上實(shí)現(xiàn)它,同時優(yōu)化性能和功率效率。 使用云計算并不總是一個選項,尤其是當(dāng)

2021-11-09 08:06:27

當(dāng)訓(xùn)練好的神經(jīng)網(wǎng)絡(luò)用于應(yīng)用的時候,權(quán)值是不是不能變了????就是已經(jīng)訓(xùn)練好的神經(jīng)網(wǎng)絡(luò)是不是相當(dāng)于得到一個公式了,權(quán)值不能變了

2016-10-24 21:55:22

有提供編寫神經(jīng)網(wǎng)絡(luò)預(yù)測程序服務(wù)的嗎?

2011-12-10 13:50:46

求助地震波神經(jīng)網(wǎng)絡(luò)程序,共同交流!!

2013-05-11 08:14:19

小女子做基于labview的蒸發(fā)過程中液位的控制,想使用神經(jīng)網(wǎng)絡(luò)pid控制,請問這個控制方法可以嗎?有誰會神經(jīng)網(wǎng)絡(luò)pid控制么。。。叩謝

2016-09-23 13:43:16

求助大神 小的現(xiàn)在有個難題: 一組車重實(shí)時數(shù)據(jù) 對應(yīng)一個車重的最終數(shù)值(一個一維數(shù)組輸入對應(yīng)輸出一個數(shù)值) 這其中可能經(jīng)過均值、方差、去掉N個最大值、、、等等的計算 我的目的就是弄清楚這個中間計算過程 最近實(shí)在想不出什么好辦法就打算試試神經(jīng)網(wǎng)絡(luò) 請教大神用什么神經(jīng)網(wǎng)絡(luò)好求神經(jīng)網(wǎng)絡(luò)程序

2016-07-14 13:35:44

1、加速神經(jīng)網(wǎng)絡(luò)的必備開源項目 到底純FPGA適不適合這種大型神經(jīng)網(wǎng)絡(luò)的設(shè)計?這個問題其實(shí)我們不適合回答,但是FPGA廠商是的實(shí)際操作是很有權(quán)威性的,現(xiàn)在不論是Intel還是Xilinx都沒有在

2022-10-24 16:10:50

嵌入式設(shè)備自帶專用屬性,不適合作為隨機(jī)性很強(qiáng)的人工智能深度學(xué)習(xí)訓(xùn)練平臺。想象用S3C2440訓(xùn)練神經(jīng)網(wǎng)絡(luò)算法都會頭皮發(fā)麻,PC上的I7、GPU上都很吃力,大部分都要依靠服務(wù)器來訓(xùn)練。但是一旦算法訓(xùn)練

2021-08-17 08:51:57

請問用matlab編程進(jìn)行BP神經(jīng)網(wǎng)絡(luò)預(yù)測時,訓(xùn)練結(jié)果很多都是合適的,但如何確定最合適的?且如何用最合適的BP模型進(jìn)行外推預(yù)測?

2014-02-08 14:19:12

最簡單的神經(jīng)網(wǎng)絡(luò)

2019-09-11 11:57:36

一定的早熟收斂問題,引入一種自適應(yīng)動態(tài)改變慣性因子的PSO算法,使算法具有較強(qiáng)的全局搜索能力.將此算法訓(xùn)練的模糊神經(jīng)網(wǎng)絡(luò)應(yīng)用于語音識別中,結(jié)果表明,與BP算法相比,粒子群優(yōu)化的模糊神經(jīng)網(wǎng)絡(luò)具有較高

2010-05-06 09:05:35

CV之YOLOv3:深度學(xué)習(xí)之計算機(jī)視覺神經(jīng)網(wǎng)絡(luò)Yolov3-5clessses訓(xùn)練自己的數(shù)據(jù)集全程記錄(第二次)——Jason niu

2018-12-24 11:52:25

我在matlab中訓(xùn)練好了一個神經(jīng)網(wǎng)絡(luò)模型,想在labview中調(diào)用,請問應(yīng)該怎么做呢?或者labview有自己的神經(jīng)網(wǎng)絡(luò)工具包嗎?

2018-07-05 17:32:32

原文鏈接:【嵌入式AI部署&基礎(chǔ)網(wǎng)絡(luò)篇】輕量化神經(jīng)網(wǎng)絡(luò)精述--MobileNet V1-3、ShuffleNet V1-2、NasNet深度神經(jīng)網(wǎng)絡(luò)模型被廣泛應(yīng)用在圖像分類、物體檢測等機(jī)器

2021-12-14 07:35:25

時空記憶。增加了幾個非局部模塊后,我們的“非局部神經(jīng)網(wǎng)絡(luò)”結(jié)構(gòu)能比二維和三維卷積網(wǎng)絡(luò)在視頻分類中取得更準(zhǔn)確的結(jié)果。另外,非局部神經(jīng)網(wǎng)絡(luò)在計算上也比三維卷積神經(jīng)網(wǎng)絡(luò)更加經(jīng)濟(jì)。我們在 Kinetics

2018-11-12 14:52:50

基于小波神經(jīng)網(wǎng)絡(luò)的信息系綜合評價系統(tǒng)的訓(xùn)練算法

為了對基于小波神經(jīng)網(wǎng)絡(luò)的信息系統(tǒng)綜合評價系統(tǒng)進(jìn)行訓(xùn)練,必須確定網(wǎng)絡(luò)參數(shù)Wk ,bk

2009-02-27 09:36:12 665

665

基于自適應(yīng)果蠅算法的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)訓(xùn)練_霍慧慧

2017-01-03 17:41:58 0

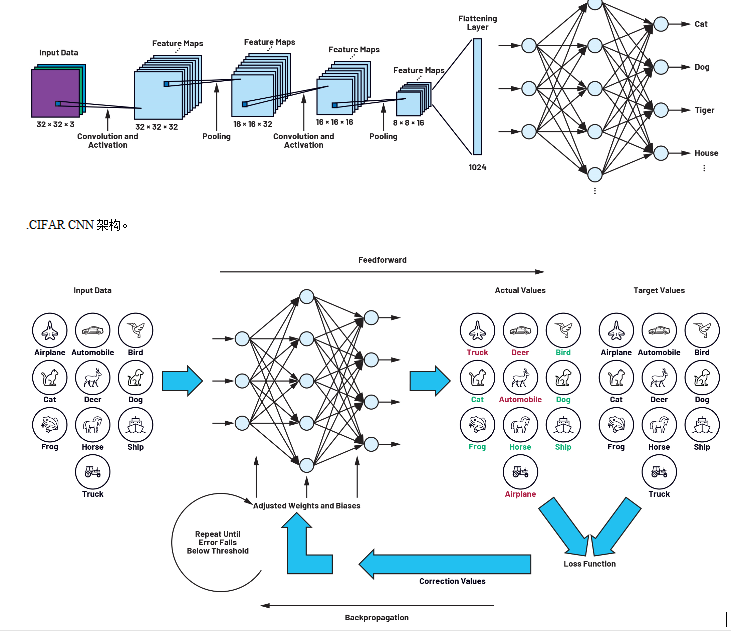

0 要訓(xùn)練神經(jīng)網(wǎng)絡(luò),我們需要“訓(xùn)練數(shù)據(jù)集”。訓(xùn)練數(shù)據(jù)集是由對應(yīng)目標(biāo)z(期望輸出)的輸入信號(x_1和 x_2)組成。神經(jīng)網(wǎng)絡(luò)的訓(xùn)練是一個迭代過程。在每個迭代中,使用來自訓(xùn)練數(shù)據(jù)集的新數(shù)據(jù)修改網(wǎng)絡(luò)節(jié)點(diǎn)的加權(quán)系數(shù)。整個迭代由前向計算和反向傳播兩個過程組成。

2017-10-18 18:20:30 8226

8226

神經(jīng)網(wǎng)絡(luò)模型的每一類學(xué)習(xí)過程通常被歸納為一種訓(xùn)練算法。訓(xùn)練的算法有很多,它們的特點(diǎn)和性能各不相同。問題的抽象人們把神經(jīng)網(wǎng)絡(luò)的學(xué)習(xí)過程轉(zhuǎn)化為求損失函數(shù)f的最小值問題。一般來說,損失函數(shù)包括誤差項和正則

2017-11-16 15:30:54 12889

12889 任務(wù)中通過種群進(jìn)化,選取適應(yīng)度最高的權(quán)陣作為Map任務(wù)下一輪訓(xùn)練的初始權(quán)陣,直至該權(quán)陣對所有輸入數(shù)據(jù)分片收斂。實(shí)驗結(jié)果表明,與現(xiàn)有方法相比,該方法可有效避免MapReduce訓(xùn)練BP神經(jīng)網(wǎng)絡(luò)時容易陷入局部收斂的問題,并大大減少訓(xùn)練時間。

2017-11-23 15:07:40 12

12 算法進(jìn)行訓(xùn)練。值得指出的是,BP算法不僅可用于多層前饋神經(jīng)網(wǎng)絡(luò),還可以用于其他類型的神經(jīng)網(wǎng)絡(luò),例如訓(xùn)練遞歸神經(jīng)網(wǎng)絡(luò)。但我們通常說 “BP 網(wǎng)絡(luò)” 時,一般是指用 BP 算法訓(xùn)練的多層前饋神經(jīng)網(wǎng)絡(luò)。

2018-06-19 15:17:15 42819

42819

這張圖就是我們的核心了,也是整個神經(jīng)網(wǎng)絡(luò)的架構(gòu),只要能理解這個,那就OK了!首先我們來觀察整個結(jié)構(gòu),發(fā)現(xiàn)在神經(jīng)網(wǎng)絡(luò)中是存在多個層的,有輸入層,隱層1,隱層2,輸出層。那么我們想要得到一個合適的結(jié)果,就必須通過這么多層得到最終的結(jié)果,

2020-04-17 14:51:11 2982

2982 神經(jīng)網(wǎng)絡(luò)是一個具有相連節(jié)點(diǎn)層的計算模型,其分層結(jié)構(gòu)與大腦中的神經(jīng)元網(wǎng)絡(luò)結(jié)構(gòu)相似。神經(jīng)網(wǎng)絡(luò)可通過數(shù)據(jù)進(jìn)行學(xué)習(xí),因此,可訓(xùn)練其識別模式、對數(shù)據(jù)分類和預(yù)測未來事件。

2023-07-26 18:28:41 1623

1623

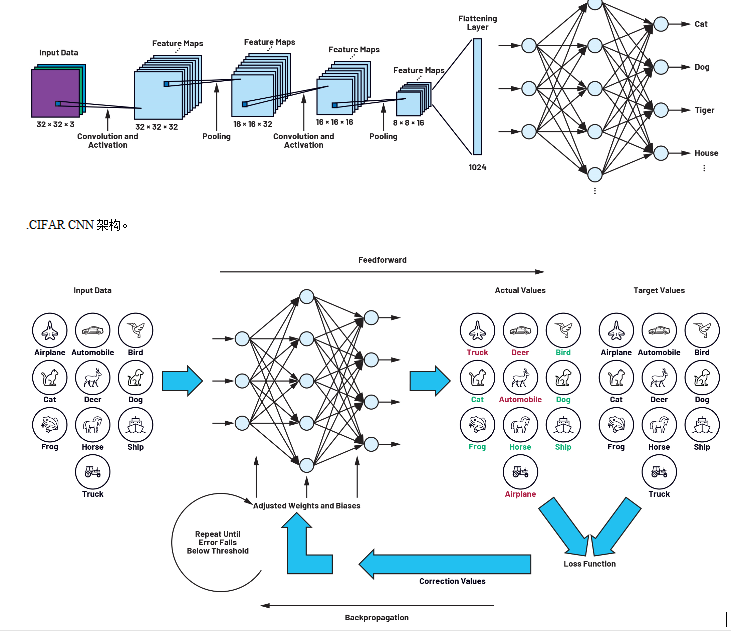

卷積神經(jīng)網(wǎng)絡(luò)模型訓(xùn)練步驟? 卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network, CNN)是一種常用的深度學(xué)習(xí)算法,廣泛應(yīng)用于圖像識別、語音識別、自然語言處理等諸多領(lǐng)域。CNN

2023-08-21 16:42:00 885

885 科學(xué)神經(jīng)網(wǎng)絡(luò)模型使用隨機(jī)梯度下降進(jìn)行訓(xùn)練,模型權(quán)重使用反向傳播算法進(jìn)行更新。通過訓(xùn)練神經(jīng)網(wǎng)絡(luò)模型解決的優(yōu)化問題非常具有挑戰(zhàn)性,盡管這些算法在實(shí)踐中表現(xiàn)出色,但不能保證它們會及時收斂到一個良好的模型

2023-12-30 08:27:54 319

319

電子發(fā)燒友App

電子發(fā)燒友App

評論