穿衣搭配不僅反映個(gè)人的審美同時(shí)也與出席的場(chǎng)合、文化傳統(tǒng)息息相關(guān)。在一個(gè)時(shí)尚場(chǎng)景中,通常會(huì)包含三個(gè)要素:場(chǎng)合、個(gè)體和衣著。這些時(shí)尚信息和知識(shí)對(duì)于衣著推薦搭配等應(yīng)用十分重要。而當(dāng)今高度發(fā)展的社交媒體為時(shí)尚知識(shí)提供了豐富的資源,從朋友圈到微博從推特到Ins,人們?cè)诓煌瑘?chǎng)合的穿搭圖像、文字和多媒體信息構(gòu)成了龐大的信息資源。

來自新加坡國(guó)立大學(xué)的研究人員們利用深度學(xué)習(xí)集成多種方法來從社交媒體中抽取時(shí)尚三要素,以實(shí)現(xiàn)時(shí)尚知識(shí)的自動(dòng)化抽取和學(xué)習(xí),同時(shí)還構(gòu)建了以用戶為中心時(shí)尚知識(shí)抽取數(shù)據(jù)集FashionKE。

時(shí)尚時(shí)尚最時(shí)尚

隨著生活水平的不斷提高,人們的時(shí)尚需求不斷增加,對(duì)于不同場(chǎng)合的衣著搭配也有著更為精細(xì)化的需求。面對(duì)這個(gè)萬(wàn)億級(jí)的時(shí)尚市場(chǎng),如何將機(jī)器學(xué)習(xí)與深度學(xué)習(xí)更有效的應(yīng)用于時(shí)尚知識(shí)的學(xué)習(xí)、穿搭推薦甚至是知識(shí)級(jí)別的構(gòu)建是科技巨頭和研究人員們的研究熱點(diǎn)。

目前對(duì)于時(shí)尚知識(shí)級(jí)別的研究工作還比較有限,如何有效的穿衣搭配涉及到場(chǎng)景、主體和衣著三個(gè)關(guān)鍵因素。在日常生活有很多固定的經(jīng)驗(yàn)和模式幫助人們進(jìn)行有效的穿搭,但研究人員希望將這些模式總結(jié)成更為凝練的知識(shí)以指導(dǎo)不同的人在對(duì)應(yīng)的場(chǎng)合進(jìn)行最適宜的穿搭。在這一過程中,需要面對(duì)的第一個(gè)問題就是,從哪里去獲取這些知識(shí)呢?如何獲取這些知識(shí)呢?新加坡國(guó)立大學(xué)的研究人員給出了自己的答案。

他們將目光放到了各大社交媒體平臺(tái),從中進(jìn)行以用戶為中心的自動(dòng)化時(shí)尚知識(shí)抽取,來幫助實(shí)現(xiàn)這一目標(biāo)。為什么呢?社交媒體的龐大用戶規(guī)模保證了多模態(tài)數(shù)據(jù)的豐富和質(zhì)量,不僅包含了世界各地、各個(gè)場(chǎng)景中用戶的照片,同時(shí)也包含了包括性別在內(nèi)的個(gè)人屬性,而且還緊跟時(shí)尚潮流更新迅速。但有些利用這些數(shù)據(jù)還面臨著一系列挑戰(zhàn)。

首先時(shí)尚知識(shí)的抽取很大程度上決定于時(shí)尚概念和屬性抽取器的表現(xiàn),包括對(duì)于場(chǎng)景、衣著和飾品的識(shí)別檢測(cè)。雖然現(xiàn)在在學(xué)術(shù)界有很多研究成果,但大多集中于簡(jiǎn)單干凈的背景上,而現(xiàn)實(shí)中面對(duì)的卻是豐富多樣的自然場(chǎng)景,使得屬性檢測(cè)變得十分困難。第一個(gè)需要解決的挑戰(zhàn)就是需要實(shí)現(xiàn)自然場(chǎng)景和背景的時(shí)尚概念和屬性檢測(cè)。

其次社交媒體雖然豐富,但基本上缺乏時(shí)尚概念的標(biāo)注,但這對(duì)時(shí)尚知識(shí)的構(gòu)建十分重要。時(shí)尚知識(shí)自動(dòng)獲取的質(zhì)量極大地依賴于語(yǔ)義級(jí)的時(shí)尚概念學(xué)習(xí)。手工標(biāo)記如此龐大的數(shù)據(jù)是不現(xiàn)實(shí)的,而現(xiàn)存的電子商務(wù)數(shù)據(jù)主要集中于衣著屬性,缺乏人物和場(chǎng)景屬性的標(biāo)注。 如何解決這兩個(gè)問題成為了實(shí)現(xiàn)知識(shí)抽取的關(guān)鍵。

時(shí)尚知識(shí)自動(dòng)化抽取

為了解決這兩個(gè)問題,研究人員提出了一種基于弱標(biāo)記數(shù)據(jù)的時(shí)尚概念聯(lián)合檢測(cè)方法。這種基于上下文的時(shí)尚概念學(xué)習(xí)模塊可以有效捕捉不同時(shí)尚概念間的聯(lián)系和相關(guān)性,通過場(chǎng)景、衣著分類和屬性來輔助時(shí)尚知識(shí)抽取。其中弱標(biāo)記數(shù)據(jù)則有效應(yīng)對(duì)了缺乏標(biāo)記數(shù)據(jù)的困擾,在標(biāo)記遷移矩陣幫助下,通過機(jī)器標(biāo)記數(shù)據(jù)和干凈數(shù)據(jù)的結(jié)合可有效控制學(xué)習(xí)過程中的噪聲。

這一研究的目標(biāo)在于從社交媒體中抽取用戶為中心的時(shí)尚知識(shí)數(shù)據(jù),得到場(chǎng)景對(duì)應(yīng)穿著的結(jié)構(gòu)化數(shù)據(jù)為下游任務(wù)提供應(yīng)用基礎(chǔ)。

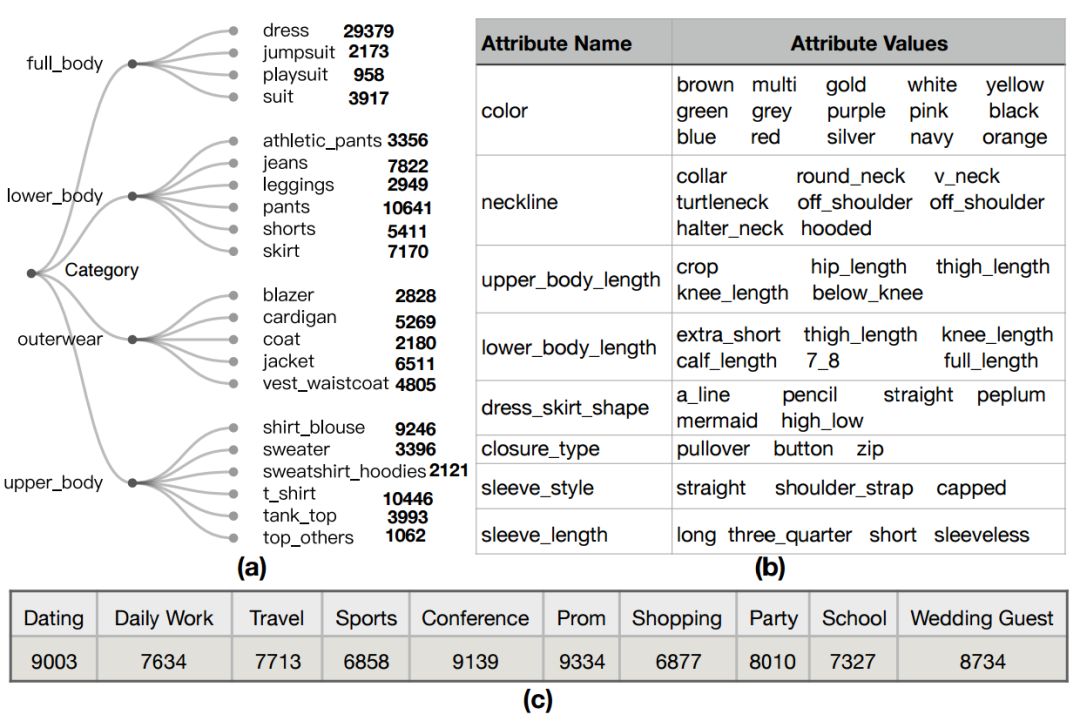

研究人員將時(shí)尚知識(shí)定義為個(gè)體、衣著和場(chǎng)合三元組合K={P,C,O},其中個(gè)體包括了人的屬性:性別、年齡、身材;服裝則包括了衣著的屬性和分類,用于定義特定類型的服飾,例如:一條深藍(lán)色的露肩長(zhǎng)裙;場(chǎng)景則包含了各種主體出席的場(chǎng)合、包括舞會(huì)、約會(huì)、會(huì)議、聚會(huì)等等及其相關(guān)的時(shí)間地點(diǎn)元數(shù)據(jù)。

研究人員的任務(wù)就是要從某個(gè)po出的社交媒體信息{V(圖像),T(文字),M(元數(shù)據(jù))}中抽取出上面的信息構(gòu)成時(shí)尚知識(shí){P,C.Q}。這一任務(wù)自然包含了三個(gè)子任務(wù):人體屬性檢測(cè)、衣著分類和屬性檢測(cè)、場(chǎng)景檢測(cè)。

人體檢測(cè)框架目前很成熟,所以研究人員致力于后兩個(gè)子任務(wù)的開發(fā),從社交媒體數(shù)據(jù)中聯(lián)合檢測(cè)出主體所處的場(chǎng)景和服裝分類屬性。

為了有效檢測(cè)場(chǎng)景及其主體的衣著分類屬性,研究人員設(shè)計(jì)了一套統(tǒng)一的框架來獲取其屬性及相關(guān)性。這套基于上下文時(shí)尚概念的學(xué)習(xí)模型包含了兩個(gè)雙邊回歸神經(jīng)網(wǎng)絡(luò)來捕捉場(chǎng)景、衣著間的聯(lián)系。

對(duì)于某篇包含圖像V和文字T社交媒體來說,這一模型首先將衣著檢測(cè)模型檢測(cè)圖像中一系列的服飾區(qū)域。隨后針對(duì)圖像預(yù)測(cè)出對(duì)應(yīng)的場(chǎng)景標(biāo)簽,針對(duì)每個(gè)服裝區(qū)域預(yù)測(cè)出對(duì)應(yīng)的服裝類別和屬性標(biāo)簽。為了有效的預(yù)測(cè)出這三者之間的相關(guān)性,研究人員利用基于上下文的方式來從中得到不同屬性間的關(guān)系以便抽取知識(shí)。為了有效抽取知識(shí),需要對(duì)服裝分類、場(chǎng)景和服裝屬性的表示進(jìn)行學(xué)習(xí)。

分類表達(dá)。模型的第一步是學(xué)習(xí)服裝區(qū)域的上下文表示用于分類預(yù)測(cè)和整幅圖像的場(chǎng)景預(yù)測(cè)。研究人員首先利用與訓(xùn)練的CNN來抽取全圖和每個(gè)服裝區(qū)域的特征表示,隨后利用雙邊LSTM來編碼所有服裝區(qū)域間的相關(guān)性,并最終得到服裝區(qū)域的分類表達(dá)。

場(chǎng)景表達(dá)。為了更好的表達(dá)整幅圖像,研究人員將第一步中整幅圖像的CNN特征、上一步Bi-LSTM的最后隱含狀態(tài)及TextCNN抽取文字描述特征結(jié)合為新的特征,來實(shí)現(xiàn)場(chǎng)景表達(dá)學(xué)習(xí);

屬性表達(dá)。最后,由于每種服裝有包括顏色、長(zhǎng)短、外形等多個(gè)不同特征,所以需要屬性預(yù)測(cè)模塊來預(yù)測(cè)屬性。研究人員利用多分支的結(jié)構(gòu)來對(duì)不同種類的服飾進(jìn)行屬性預(yù)測(cè),每個(gè)分支輸出層的神經(jīng)元數(shù)量代表了對(duì)應(yīng)的屬性數(shù)目。

隨后為了捕捉不同服飾屬性和服飾分類間的依賴關(guān)系,研究人員使用了第二個(gè)雙邊LSTM來編碼屬性和分類間的依賴關(guān)系,并最終通過全連接轉(zhuǎn)換為屬性表達(dá)。最終通過標(biāo)準(zhǔn)的分類器將得到場(chǎng)景、服裝分類和屬性的預(yù)測(cè)分?jǐn)?shù)。

為了對(duì)這一模型進(jìn)行訓(xùn)練,研究人員構(gòu)建自己的數(shù)據(jù)集FashionKE,其中包含了80629張圖像,可以容易辨認(rèn)出時(shí)尚知識(shí)的三要素。同時(shí)對(duì)每張圖片進(jìn)行了場(chǎng)景標(biāo)注(十種主要場(chǎng)景);而針對(duì)服裝屬性和分類標(biāo)注,由于社交媒體數(shù)據(jù)過于龐大,對(duì)于每一個(gè)圖像和文字?jǐn)?shù)據(jù)進(jìn)行多種屬性的手工標(biāo)注是不現(xiàn)實(shí)的。只有30%的數(shù)據(jù)進(jìn)行了人工核對(duì),其他數(shù)據(jù)都利用時(shí)尚標(biāo)簽工具進(jìn)行機(jī)器標(biāo)注。

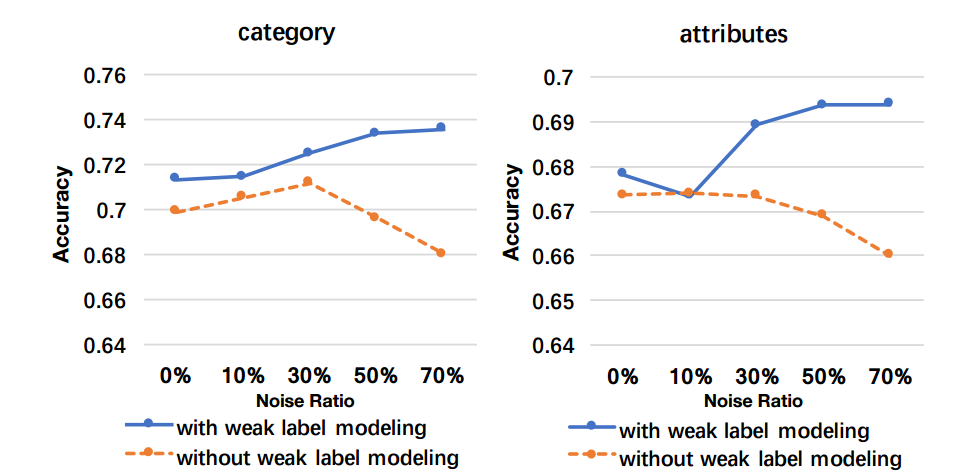

機(jī)器標(biāo)注的數(shù)據(jù)很廉價(jià),但是卻包含很多的噪聲,使得模型的訓(xùn)練容易出現(xiàn)過擬合。為了充分利用機(jī)器標(biāo)注的數(shù)據(jù)和少量人類標(biāo)記數(shù)據(jù),研究人員引入了弱標(biāo)記建模的方法來處理機(jī)器標(biāo)記數(shù)據(jù)中的噪聲。其基本思想是在模型中添加一個(gè)標(biāo)簽校正層,在預(yù)測(cè)層后利用估計(jì)出的標(biāo)簽轉(zhuǎn)換矩陣來實(shí)現(xiàn),使得預(yù)測(cè)與弱標(biāo)記的數(shù)據(jù)分布相匹配。這一轉(zhuǎn)換矩陣將通過與主干任務(wù)協(xié)同訓(xùn)練的線性層來得到。

實(shí)驗(yàn)和結(jié)果

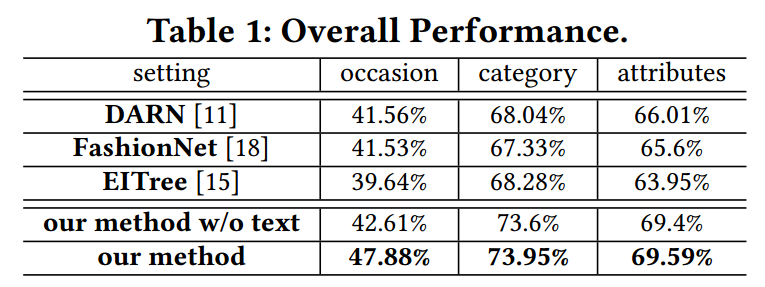

研究人員在實(shí)驗(yàn)中發(fā)現(xiàn)新提出的框架和策略有效的實(shí)現(xiàn)了時(shí)尚概念的預(yù)測(cè)。通過與DARN、FashionNet和EITree的比較本文的方法在多個(gè)指標(biāo)上都超過了先前的方法。

一方面,由于本方法充分使用了機(jī)器標(biāo)注的模型并通過弱標(biāo)記建模模塊抑制了標(biāo)注噪聲的影響,從而得到了額外的增益。這一模型將場(chǎng)景、服裝分類和屬性間的依賴性和相關(guān)性進(jìn)行了考量,為時(shí)尚概念的識(shí)別提供了額外辨別能力。這些依賴性和相關(guān)性表明時(shí)尚知識(shí)的存在以及對(duì)于相關(guān)應(yīng)用的積極作用。

另一方面,這一方法還通過文字信息進(jìn)一步提升了性能,特別是在場(chǎng)景分類中很多社交媒體的問題信息包含了豐富的場(chǎng)景信息,有助于時(shí)尚信息的抽取。

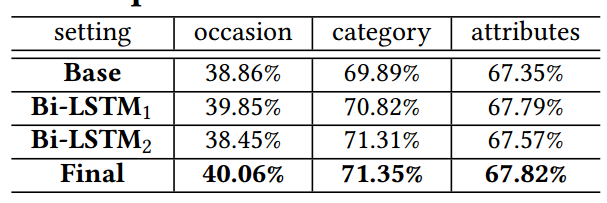

此外通過消融性分析,研究人員發(fā)現(xiàn)第一個(gè)Bi-LSTM通過學(xué)習(xí)出不同服裝區(qū)域間的相關(guān)性來提升了分類性能,并通過將隱含層的加入來替身了場(chǎng)景預(yù)測(cè)性能;第二個(gè)Bi-LSTM則通過不同屬性表達(dá)和分類表達(dá)間的依賴性建模來提升性能;同時(shí)兩個(gè)LSTM間的協(xié)同作用也將顯著加強(qiáng)模型知識(shí)抽取能力。

最后通過不同比例的噪聲數(shù)據(jù)對(duì)模型訓(xùn)練也顯示出弱標(biāo)記建模對(duì)于知識(shí)抽取能力的提升。

最后研究人員們還展示了基于這一模型在不同領(lǐng)域的應(yīng)用。

從時(shí)尚概念抽取時(shí)尚知識(shí),圖中展示了一部分結(jié)構(gòu)化的時(shí)尚知識(shí)

不同場(chǎng)景下人們的穿著服飾分析,包括國(guó)家、場(chǎng)合和季節(jié)都有著明顯的區(qū)分。

時(shí)尚知識(shí)分析,包含了不同季節(jié)和不同地區(qū)不同場(chǎng)合的穿著。

下圖還顯示了不同場(chǎng)合中最流行的服飾,包括了其中縱軸是男性女性對(duì)應(yīng)的十種場(chǎng)景、橫軸是對(duì)應(yīng)的流行穿著。可以看到會(huì)議中男性傾向于穿著夾克外套、舞會(huì)中女性則喜愛各種連衣裙。

同時(shí)研究人員們還分析了不同屬性和分類間的相關(guān)性,圖中的節(jié)點(diǎn)大小代表了服飾的數(shù)量,邊的寬度代表了相關(guān)性的強(qiáng)弱。可以看到牛仔褲和襯衫T恤都是大家的最愛搭配。而不同屬性間的相關(guān)性中可以看到長(zhǎng)款衣服還是主流,長(zhǎng)袖長(zhǎng)褲是主流搭配。

在未來研究人員們還將探索包括時(shí)尚穿搭推薦的不同領(lǐng)域的應(yīng)用,并對(duì)更加細(xì)粒度的知識(shí)進(jìn)行抽取,同時(shí)加入不同的視覺概念來實(shí)現(xiàn)包括交叉模態(tài)檢索和人體檢索等更多的檢索任務(wù)。

-

模塊

+關(guān)注

關(guān)注

7文章

2787瀏覽量

50226 -

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4813瀏覽量

103419 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5560瀏覽量

122745

原文標(biāo)題:對(duì)面的女孩看過來,深度學(xué)習(xí)從社交媒體中為你發(fā)掘最美穿搭

文章出處:【微信號(hào):thejiangmen,微信公眾號(hào):將門創(chuàng)投】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

嵌入式AI技術(shù)之深度學(xué)習(xí):數(shù)據(jù)樣本預(yù)處理過程中使用合適的特征變換對(duì)深度學(xué)習(xí)的意義

軍事應(yīng)用中深度學(xué)習(xí)的挑戰(zhàn)與機(jī)遇

AI自動(dòng)化生產(chǎn):深度學(xué)習(xí)在質(zhì)量控制中的應(yīng)用

深度學(xué)習(xí)從社交媒體中為你發(fā)掘最美穿搭

深度學(xué)習(xí)從社交媒體中為你發(fā)掘最美穿搭

評(píng)論