近日,Google 宣布推出量子機器學習開源庫 TensorFlow Quantum。

這一開源庫集成了 Google 之前開源的量子計算框架 Cirq 和機器學習框架 TensorFlow。Cirq 提供了一個軟件模擬器來運行量子算法,不要求開發(fā)者必須有一臺真實的量子計算機。而 TensorFlow 是一個封裝了底層深度學習模型的軟件庫。簡言之,不管是 Cirq 還是 TensorFlow,都是為了降低新技術(shù)門檻而生。借助這些開源工具,開發(fā)者可以更快更省地打造量子計算或機器學習應(yīng)用。

Google 現(xiàn)在把兩者結(jié)合了起來,能讓開發(fā)者利用經(jīng)典或者量子數(shù)據(jù),快速打造一個混合的量子-經(jīng)典模型原型,以期推動量子計算和機器學習社區(qū)發(fā)現(xiàn)更能發(fā)揮量子優(yōu)勢的新算法。

雖然量子計算和機器學習都是技術(shù)熱詞,但分屬完全不同的領(lǐng)域。兩者為什么能結(jié)合在一起?量子計算能給機器學習帶來什么?一切要從經(jīng)典數(shù)據(jù)和量子數(shù)據(jù)的區(qū)別說起。

跳出 0 和 1 的局限

所謂經(jīng)典數(shù)據(jù)和經(jīng)典模型,都是相對于量子而言。現(xiàn)在流行的計算機被稱為經(jīng)典計算機,信息量的基本單位是比特,在二進制中取值不是 0 就是 1。

而遵循量子力學規(guī)律打造的計算機被稱為量子計算機,信息量的基本單位是量子比特,在取值前處于不確定狀態(tài),即疊加態(tài)。也就是說,量子比特可以同時處于 “0” 和 “1” 的狀態(tài)。

有人做過一個比喻:經(jīng)典比特是 “開關(guān)”,只有開和關(guān)兩個狀態(tài)(0 和 1),而量子比特是 “旋鈕”,就像收音機上調(diào)頻的旋鈕那樣,有無窮多個狀態(tài)。經(jīng)典計算機通過操縱經(jīng)典比特進行運算,而量子計算機是操縱量子比特,本質(zhì)上就是去旋轉(zhuǎn)它們。

量子疊加這種特性決定了在同樣比特數(shù)量的情況下,量子比特能存儲比經(jīng)典比特更多的信息。

比如,把 1 個“0”和 1 個“1”放在一起,會有 4 個組合狀態(tài):00、01、10、11。2 個經(jīng)典比特只能是其中 1 種狀態(tài),而 2 個量子比特可以同時包含這 4 個狀態(tài),并且每個狀態(tài)都有一定的權(quán)重。

只有當人們?nèi)プx取量子比特時,同時包含 4 個狀態(tài)的量子比特才會變化為其中一個狀態(tài)。正是由于這種疊加的特性,量子計算機具備了強大的并行計算能力。

▲(“薛定諤的貓” 就是解釋量子疊加的一個思想實驗)

除了疊加,量子還有個特性是“糾纏”。糾纏性可以讓多個量子比特共享狀態(tài),創(chuàng)造出 “超級疊加” 的量子并行計算,計算能力隨比特數(shù)增加呈指數(shù)級增長。

理論上,擁有 300 個量子比特的量子計算機,瞬間所能執(zhí)行的并行計算次數(shù)比宇宙中的原子總數(shù)還多。

對于量子計算的并行性,微軟 CEO Satya Nadella 在 2017 年微軟 Ignite 大會上,用找迷宮出口來比喻解釋:

為了找到迷宮的出口,經(jīng)典計算機先開啟一條搜索路徑,遇到障礙物后會沿原路返回。之后再次探尋新路,直到遇障返回或找到了正確出口。雖然最終能找到一個結(jié)果,但這種方法相當耗時。

對比之下,量子計算機解鎖了神奇的并行性。它們同時探尋玉米迷宮中的每一條路。因此,量子計算機可能指數(shù)級減少解決問題的步驟。

中國科學院院士潘建偉也曾說:“如果傳統(tǒng)計算機的速度是‘自行車’,那么量子計算機的速度就是‘飛機’。”

這種遠遠超過經(jīng)典計算機的計算性能,正是機器學習所需要的。眾所周知,當下這次以機器學習方法為代表的人工智能浪潮,是算力、算法和數(shù)據(jù)相結(jié)合的結(jié)果。

如果機器學習任務(wù)無法快速計算完成,那么經(jīng)濟價值就無法得到體現(xiàn)。當前,企業(yè)和學界普遍采用 GPU 和 FPGA 等適合并行計算的通用芯片來實現(xiàn)加速,但這些方法依然是基于經(jīng)典計算機。

速度遠遠超越經(jīng)典計算機的量子計算機,自然而然和機器學習聯(lián)系起來。

量子機器學習是如何實現(xiàn)的

早在 1995 年,美國路易斯安那州立大學 Kak 教授首先提出了“量子神經(jīng)計算”的概念。而后,量子聚類、量子深度學習和量子向量機等算法相繼被提出。2015 年,潘建偉教授團隊在小型光量子計算機上,首次實現(xiàn)了量子機器學習算法 。

事實上,已有的量子機器學習算法主要可細分為 3 類。第一類,機器學習的整體計算依然采用經(jīng)典計算機,但把比較復(fù)雜的計算轉(zhuǎn)換成量子版本,用量子計算機來運行。

▲(圖片來自《量子機器學習算法綜述》

第二類是“尋找量子系統(tǒng)的力學效應(yīng)、動力學特性與傳統(tǒng)機器學習處理步驟的相似點,將物理過程應(yīng)用于傳統(tǒng)機器學習問題的求解,產(chǎn)生出新的機器學習算法”。第三類,則是借助機器學習力去研究量子系統(tǒng)。

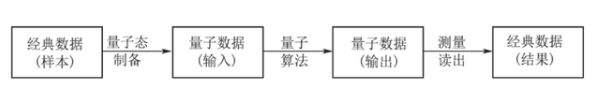

目前,對量子機器學習的研究大多集中在第一類。在具體的執(zhí)行層面上,要用量子計算機來運行經(jīng)典機器學習復(fù)雜計算的部分,首先要把經(jīng)典數(shù)據(jù)轉(zhuǎn)換成量子數(shù)據(jù)。

然后把量子數(shù)據(jù)輸入量子計算機,用量子算法計算完成后輸出。由于輸出的計算結(jié)果依然是量子疊加態(tài)的,所以最后還需要進行測量,把經(jīng)典數(shù)據(jù)提取出來。

雖然量子計算的特性和機器學習非常契合,但整體而言量子機器學習還處于初級階段。并且,不是所有的經(jīng)典機器學習算法都可以用量子計算加速。

量子機器學習算法實用化的硬件條件也還沒有成熟。據(jù)科技日報報道,在通用量子計算機建造成功之前,量子機器學習算法很難在實際應(yīng)用中展現(xiàn)出其數(shù)據(jù)處理方面的強大能力。

這次開源 TensorFlow Quantum 的 Google,也是一直在打造自己的量子計算機。2019 年 10 月 23 日,Google 在 Nature 上刊登了關(guān)于 “實現(xiàn)量子優(yōu)越性” 的論文 ,他們制造出了 53 個量子比特數(shù)的量子計算機,計算能力超經(jīng)典超級計算機。同樣的計算量,量子計算機用 200 秒就完成了,而目前最強的經(jīng)典超級計算機,要花費 10000 年才能完成。

“量子優(yōu)越性” 是指量子計算機可以完成經(jīng)典計算機無法做到的事情。這個概念最早由加州理工學院理論物理教授 John Preskill 在 2012 年提出。

▲(Google CEO 桑德爾·皮蔡和量子計算機)

Google 用 53 個量子比特實現(xiàn)了“量子優(yōu)越性”是一個里程碑式的事件,但離通用量子計算機的要求(通常認為需要 100 萬個量子比特)還是很遙遠。盡管如此,依然有越來越多學術(shù)機構(gòu)和公司投入到了量子機器學習領(lǐng)域。并且,在一些具體的場景(如圖像分類),量子機器學習也已經(jīng)被證明了其可行性。

-

Google

+關(guān)注

關(guān)注

5文章

1789瀏覽量

58983 -

機器學習

+關(guān)注

關(guān)注

66文章

8501瀏覽量

134567 -

量子計算

+關(guān)注

關(guān)注

4文章

1147瀏覽量

35710

發(fā)布評論請先 登錄

玻色量子重磅發(fā)布量子奇點計劃

北理工實現(xiàn)量子全息顯微技術(shù)突破

機器學習模型市場前景如何

傳統(tǒng)機器學習方法和應(yīng)用指導(dǎo)

如何選擇云原生機器學習平臺

量子通信與量子計算的關(guān)系

如何在低功耗MCU上實現(xiàn)人工智能和機器學習

什么是機器學習?通過機器學習方法能解決哪些問題?

NPU與機器學習算法的關(guān)系

本源量子等向北京“金融量子云實驗平臺”提供自主量子算力

《學習時報》刊發(fā)本源量子抗量子攻擊實踐專家署名文章

基于機器學習的IWR6843AOP跌倒和姿態(tài)檢測實現(xiàn)

量子機器學習是如何實現(xiàn)的

量子機器學習是如何實現(xiàn)的

評論