多模態融合是感知自動駕駛系統的一項基本任務,最近引起了許多研究人員的興趣。然而,由于原始數據噪聲大、信息利用率低以及多模態傳感器的無對準,達到相當好的性能并非易事。本文對現有的基于多模態自動駕駛感知任務方法進行了文獻綜述。分析超過50篇論文,包括攝像頭和激光雷達,試圖解決目標檢測和語義分割任務。與傳統的融合模型分類方法不同,作者從融合階段的角度,通過更合理的分類法將融合模型分為兩大類,四小類。此外,研究了當前的融合方法,就潛在的研究機會展開討論。

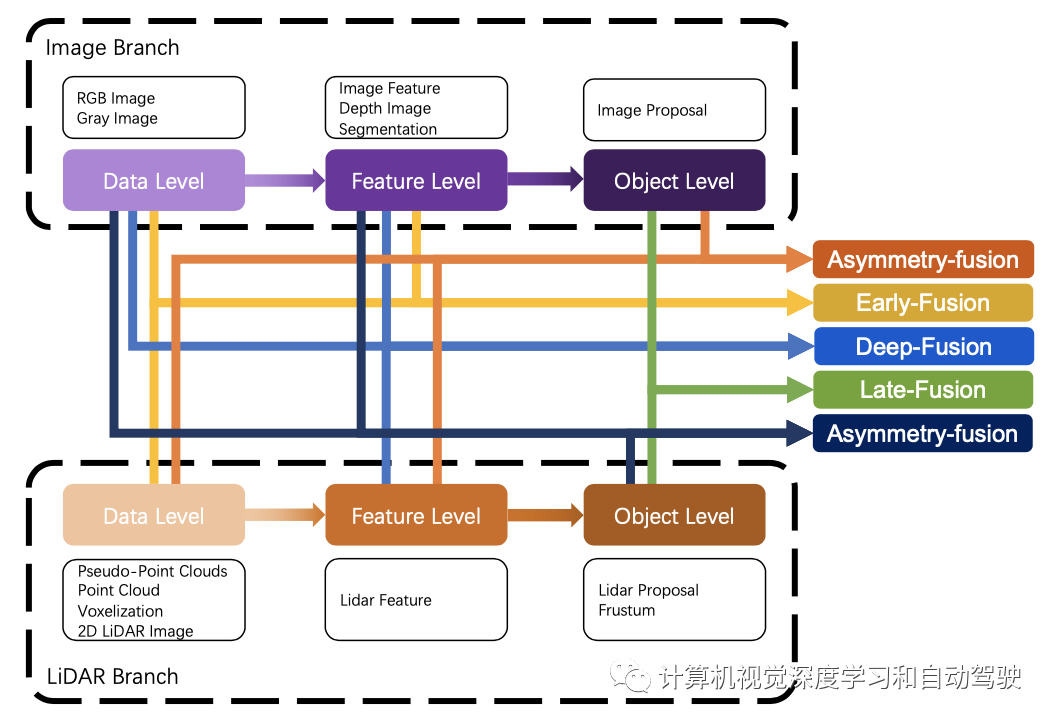

最近,用于自動駕駛感知任務的多模態融合方法發展迅速,其從跨模態特征表示和更可靠的模態傳感器,到更復雜、更穩健的多模態融合深度學習模型和技術。然而,只有少數文獻綜述集中在多模態融合方法本身的方法論上,大多數文獻都遵循傳統規則,將其分為前融合、深度(特征)融合和后融合三大類,重點關注深度學習模型中融合特征的階段,無論是數據級、特征級還是提議級。首先,這種分類法沒有明確定義每個級別的特征表示。其次,它表明,激光雷達和攝像頭這兩個分支在處理過程中始終是對稱的,模糊了激光雷達分支中融合提議級特征和攝像頭分支中融合數據級特征的情況。綜上所述,傳統的分類法可能是直觀的,但對于總結最近出現的越來越多的多模態融合方法來說卻很落后,這使得研究人員無法從系統的角度對其進行研究和分析。

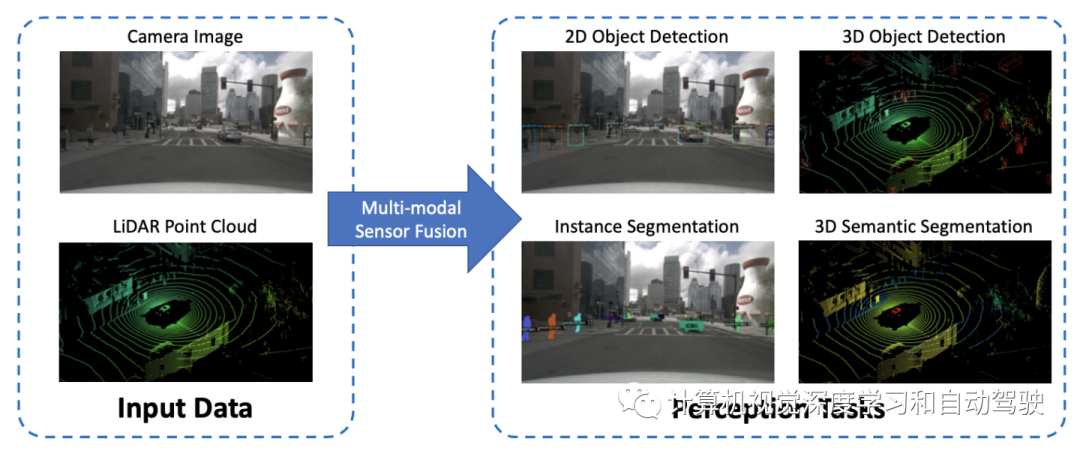

如圖是自動駕駛感知任務的示意圖:

深度學習模型僅限于輸入的表示。為了實現該模型,需要在數據輸入模型之前,通過一個復雜的特征提取器對原始數據進行預處理。

至于圖像分支,大多數現有方法保持與下游模塊輸入的原始數據相同的格式。然而,激光雷達分支高度依賴于數據格式,這種格式強調不同的特性,并對下游模型設計產生巨大影響。因此,這里將其總結為基于點、基于體素和基于二維映射的點云數據格式,以適應異構深度學習模型。

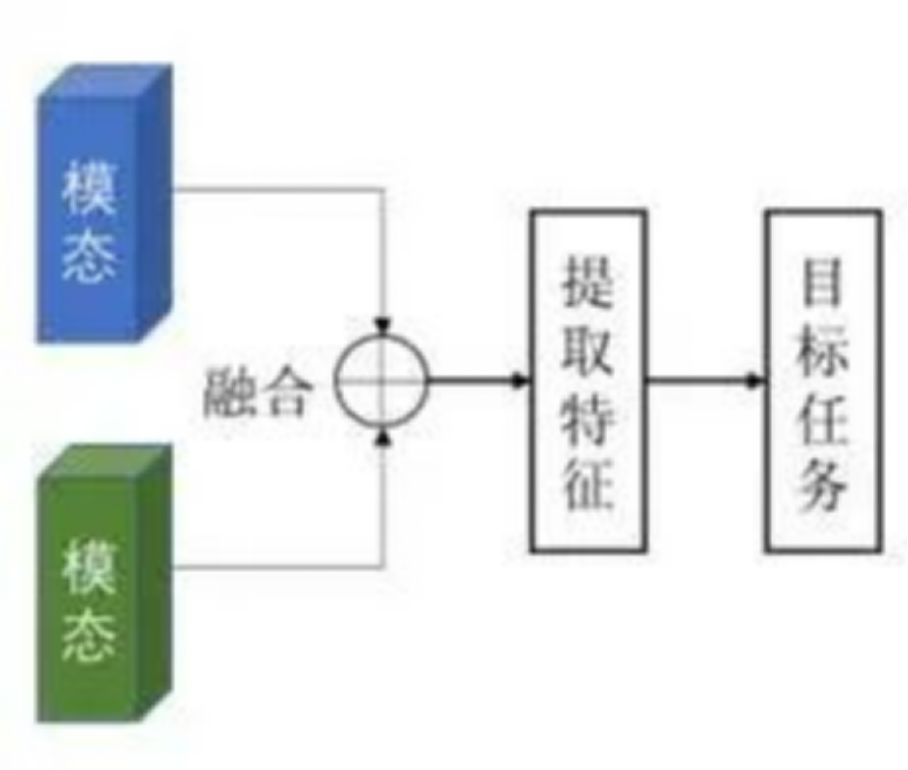

數據級融合或前融合方法,通過空間對齊直接融合不同模式的原始傳感器數據。特征級融合或深度融合方法通過級聯或元素相乘在特征空間中混合跨模態數據。目標級融合方法將各模態模型的預測結果結合起來,做出最終決策。

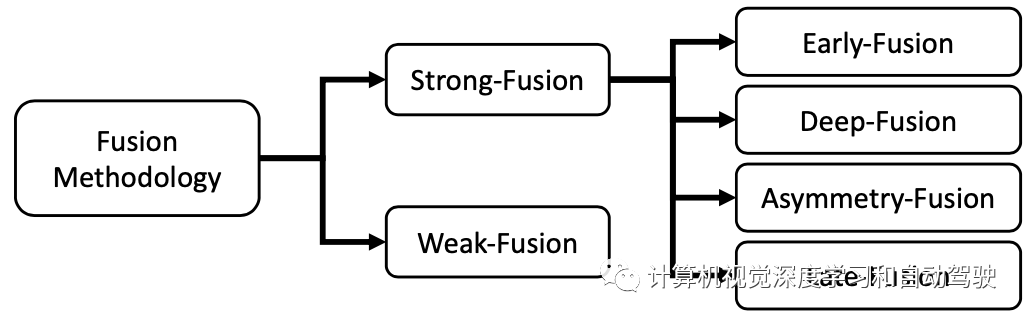

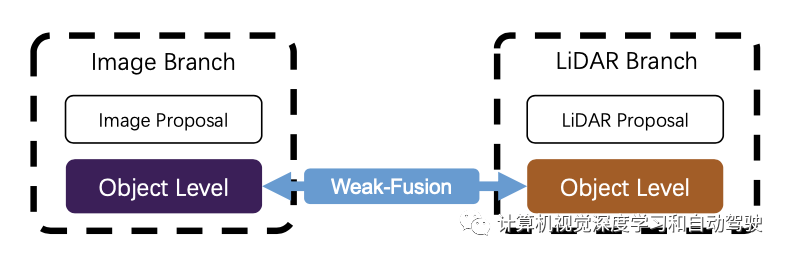

一種新的分類法,將所有融合方法分為強融合和弱融合,如圖展示了二者之間的關系:

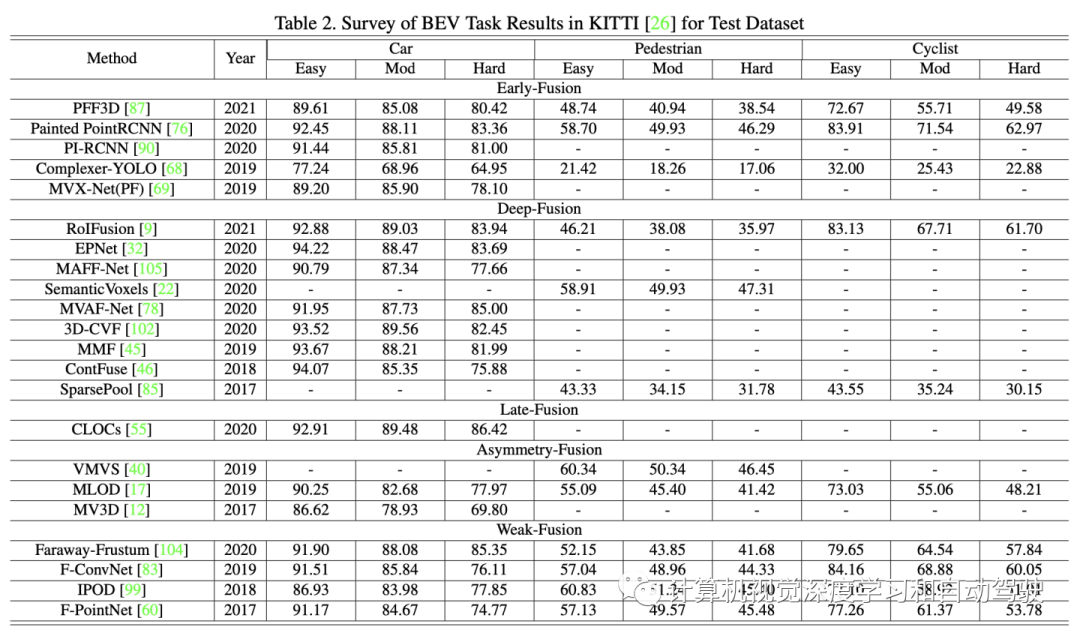

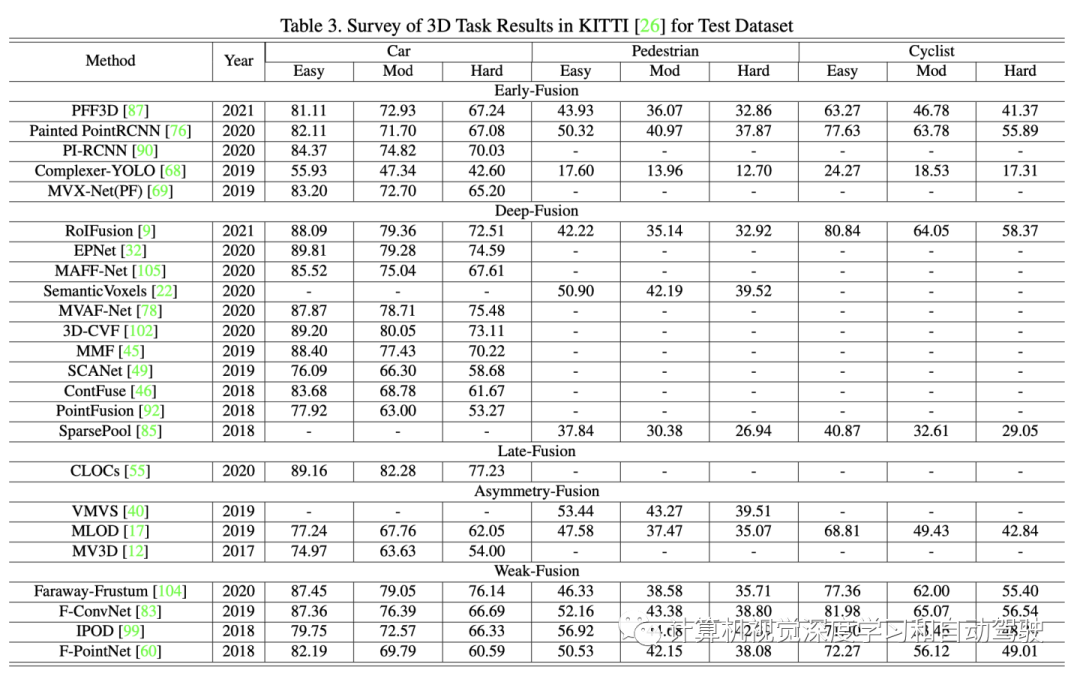

為性能比較,KITTI benchmark的3D檢測和鳥瞰目標檢測。如下兩個表分別給出BEV和3D的KITTI測試數據集上多模態融合方法的實驗結果。

根據激光雷達和攝像頭數據表示的不同組合階段,將強融合再分為前融合、深度融合、后融合和非對稱融合四類。作為研究最多的融合方法,強融合近年來取得了許多杰出的成就。

如圖所示:強融合的每個小類都高度依賴于激光雷達點云,而不是攝像頭數據。

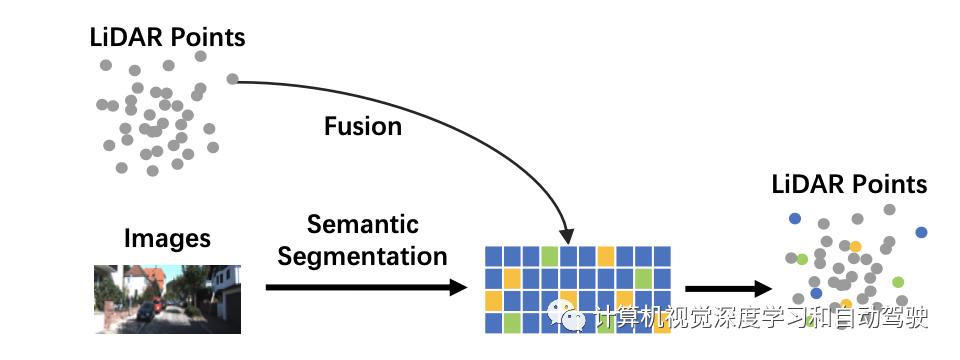

前融合。數據級融合是一種通過原始數據級的空間對齊和投影直接融合每個模態數據的方法,與之不同的是,前融合在數據級是融合激光雷達數據,在數據級或特征級則融合攝像頭數據。一個例子如圖所示:

在激光雷達分支,點云可以是有反射圖、體素化張量、前視圖/距離視圖/鳥瞰視圖以及偽點云等形式。盡管所有這些數據都具有不同的內在特征,與激光雷達主干網高相關,但除了偽點云之外,大多數據通過基于規則的處理生成。此外,與特征空間嵌入相比,該階段的數據仍然具有可解釋性,因此所有這些激光雷達數據表示都直觀可視。

對于圖像分支,嚴格的數據級定義應該只包含RGB或灰度等數據,缺乏通用性和合理性。與前融合的傳統定義相比,攝像頭數據放松為數據級和特征級數據。特別是,這里將有利于三維目標檢測的圖像語義分割任務結果作為特征級表示,因為這些“目標級”特征與整個任務的最終目標級提議不同。

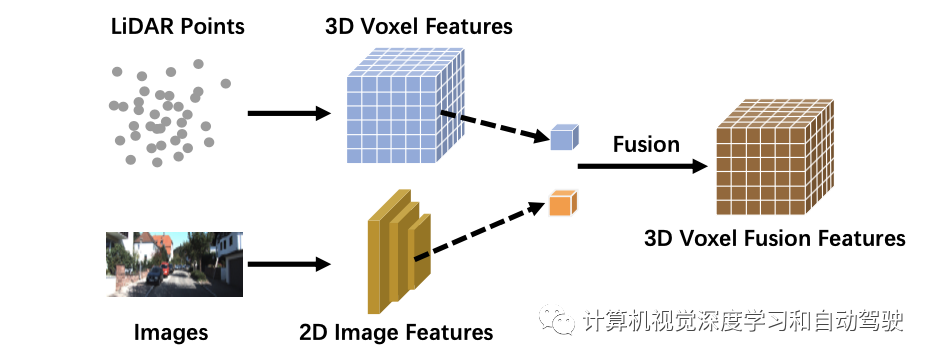

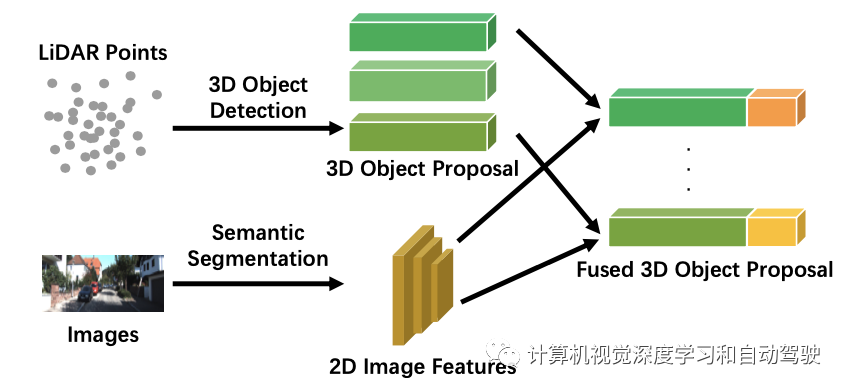

深度融合。深度融合方法在激光雷達分支的特征級對跨模態數據融合,但在圖像分支的數據級和特征級做融合。例如,一些方法使用特征提取器分別獲取激光雷達點云和攝像頭圖像的嵌入表示,并通過一系列下游模塊將特征融合到兩種模式中。然而,與其他強融合方法不同,深度融合有時以級聯方式融合特征,這兩種方法都利用原始和高級語義信息。深度融合的一個例子如圖所示:

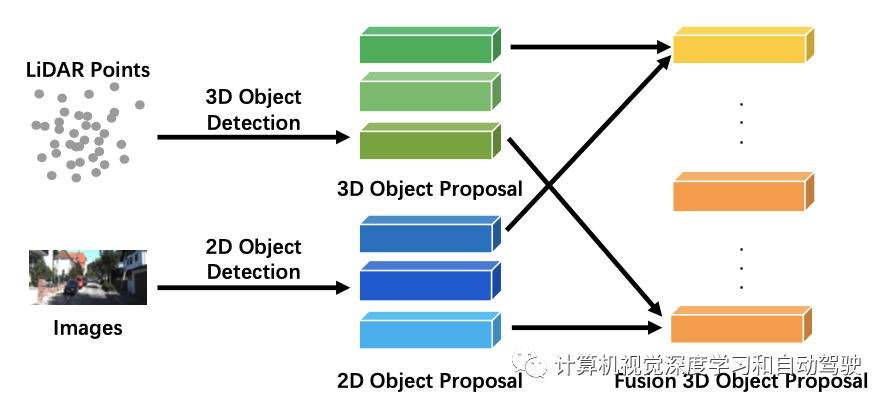

后融合。后融合,也稱為目標級融合,指的是融合每個模態中流水線結果的方法。例如,一些后融合方法利用激光雷達點云分支和攝像頭圖像分支的輸出,并基于兩種模式的結果進行最終預測。請注意,兩個分支提議的數據格式應與最終結果相同,但在質量、數量和精度上有所不同。后融合是一種多模態信息優化最終提議的集成方法(ensemble method)。如圖是后融合的一個例子:

非對稱融合。除了早融合、深度融合和后融合外,一些方法以不同的權限處理跨模態分支,因此融合一個分支的目標級信息和其他分支的數據級或特征級信息,定義為非對稱融合。強融合的其他方法將兩個分支視為似乎相等的狀態,非對稱融合至少有一個分支占主導地位,而其他分支提供輔助信息來執行最終任務。如圖是非對稱融合的一個例子:可能具有提議的相同提取特征,但非對稱融合只有來自一個分支的一個提議,而后融合有來自所有分支的提議。

與強融合不同,弱融合方法不會以多種方式直接從分支融合數據/特征/目標,而是以其他方式操作數據。基于弱融合的方法通常使用基于規則的方法來利用一種模態數據作為監督信號,以指導另一模態的交互。如圖展示了弱融合模式的基本框架:

有可能圖像分支中CNN的2D提議導致原始激光雷達點云出現截錐體(frustum)。然而,與圖像特征組合非對稱融合不同,弱融合直接將選擇的原始激光雷達點云輸入到激光雷達主干網,以輸出最終提議。

有些工作不能簡單地定義為上述任何類型的融合,在整個模型框架中采用多種融合方法,例如深度融合和后融合的結合,也有將前融合和深度融合結合在一起。這些方法從模型設計看存在冗余,這不是融合模塊的主流。

待解決的問題有一些分析。

當前的融合模型面臨著錯對齊和信息丟失的問題。此外,平融合(flat fusion)操作也阻止了感知任務性能的進一步提高。總結一下:

錯對齊和信息丟失:傳統的前融合和深度融合方法利用外部標定矩陣將所有激光雷達點直接投影到相應的像素,反之亦然。然而,由于傳感器噪聲,這種逐像素對齊不夠精確。因此,可以采取周圍的信息作為補充,會產生更好的性能。此外,在輸入和特征空間的轉換過程中,還存在其他一些信息損失。通常,降維操作的投影不可避免地會導致大量信息丟失,例如,將3-D激光雷達點云映射到2-DBEV圖像。將兩個模態數據映射到另一個專門為融合設計的高維表示,可以有效地利用原始數據,減少信息損失。

更合理的融合操作:級聯和元素相乘這些簡單的操作可能無法融合分布差異較大的數據,難以彌合兩個模態之間的語義鴻溝。一些工作試圖用更復雜的級聯結構來融合數據并提高性能。

前視圖單幀圖像是自動駕駛感知任務的典型場景。然而,大多數框架利用有限的信息,沒有詳細設計輔助任務來進一步理解駕駛場景。總結一下:

采用更多的潛在信息:現有方法缺乏對多維度和來源信息的有效利用。其中大多數都集中在前視圖的單幀多模態數據上。其他有意義的信息還有語義、空間和場景上下文信息。一些模型試圖用圖像語義分割任務結果作為附加特征,而其他模型可能利用神經網絡主干中間層的特征。在自動駕駛場景中,許多明確語義信息的下游任務可能會極大地提高目標檢測任務的性能。例如車道檢測、語義分割。因此,未來的研究可以通過各種下游任務(如檢測車道、交通燈和標志)共同構建一個完整的城市場景的認知框架,幫助感知任務的表現。此外,當前的感知任務主要依賴于忽略時間信息的單一框架。最近基于激光雷達的方法結合了一個幀序列來提高性能。時間序列信息包含序列化的監控信號,與單幀方法相比,它可以提供更穩健的結果。

表征學習的自監督:相互監督的信號自然地存在于從同一個真實世界場景但不同角度采樣的跨模態數據中。然而,由于缺乏對數據的深入理解,目前無法挖掘出各模態之間的協同關系。未來的研究可以集中在如何利用多模態數據進行自監督學習,包括預訓練、微調或對比學習。通過實施這些最先進的機制,融合模型將加深對數據的理解并取得更好的結果。

域偏差和數據分辨率與真實場景和傳感器高相關。這些缺陷阻礙了自動駕駛深度學習模型的大規模訓練和實施。

域偏差:在自主駕駛感知場景中,由不同傳感器提取的原始數據伴隨著域相關特征。不同的攝像頭系統有其光學特性,而激光雷達可能因機械激光雷達和固態激光雷達而不同。更重要的是,數據本身可能是有域偏差的,例如天氣、季節或地理位置。因此,檢測模型無法順利適應新的場景。由于泛化失敗,這些缺陷妨礙大規模數據集的收集和原始訓練數據可重用性。

分辨率沖突:來自不同模式的傳感器通常具有不同的分辨率。例如,激光雷達的空域密度明顯低于圖像的空域密度。無論采用何種投影方法,由于無法找到對應關系,一些信息被消除。這可能導致模型被一個特定模態的數據所主導,無論是特征向量的分辨率不同還是原始信息的不平衡。

審核編輯 :李倩

-

傳感器

+關注

關注

2553文章

51419瀏覽量

756726 -

激光雷達

+關注

關注

968文章

4029瀏覽量

190436 -

自動駕駛

+關注

關注

785文章

13934瀏覽量

167034

原文標題:一文讀懂自動駕駛多模態傳感器融合

文章出處:【微信號:Zidonjiashi,微信公眾號:Zidonjiashi】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

自動駕駛多傳感器數據融合方法

自動駕駛系列報告大放送了涉及傳感器,芯片,執行控制等

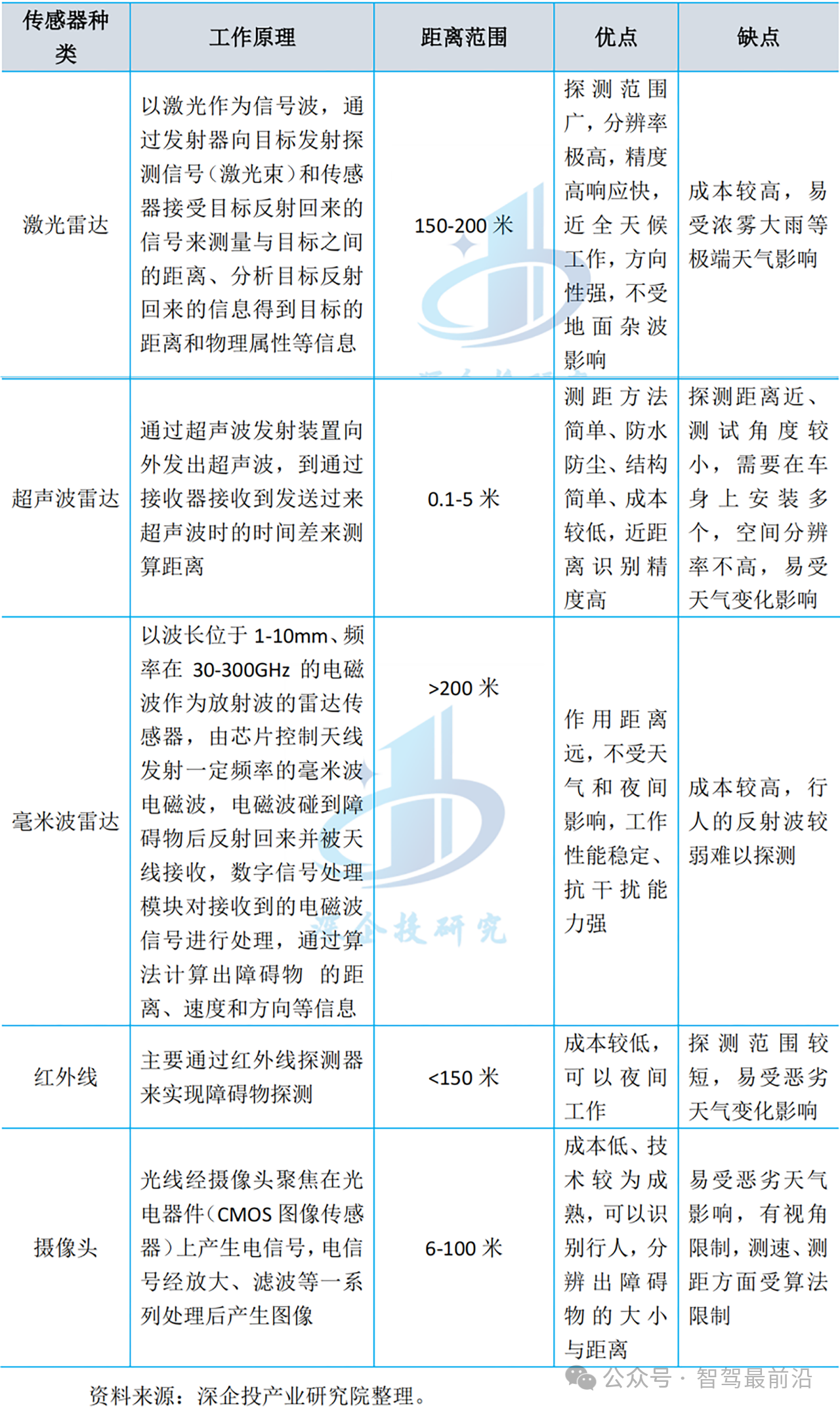

自動駕駛汽車中傳感器的分析

這些自動駕駛傳感器,你了解多少?

傳感器成自動駕駛“硬實力” 有哪些

自動駕駛深度多模態目標檢測和語義分割:數據集、方法和挑戰

自動駕駛多模態傳感器融合

自動駕駛多模態傳感器融合

評論