有關 batch size 的設置范圍,其實不必那么拘謹。

我們知道,batch size 決定了深度學習訓練過程中,完成每個 epoch 所需的時間和每次迭代(iteration)之間梯度的平滑程度。batch size 越大,訓練速度則越快,內存占用更大,但收斂變慢。

又有一些理論說,GPU 對 2 的冪次的 batch 可以發揮更好性能,因此設置成 16、32、64、128 … 時,往往要比設置為其他倍數時表現更優。

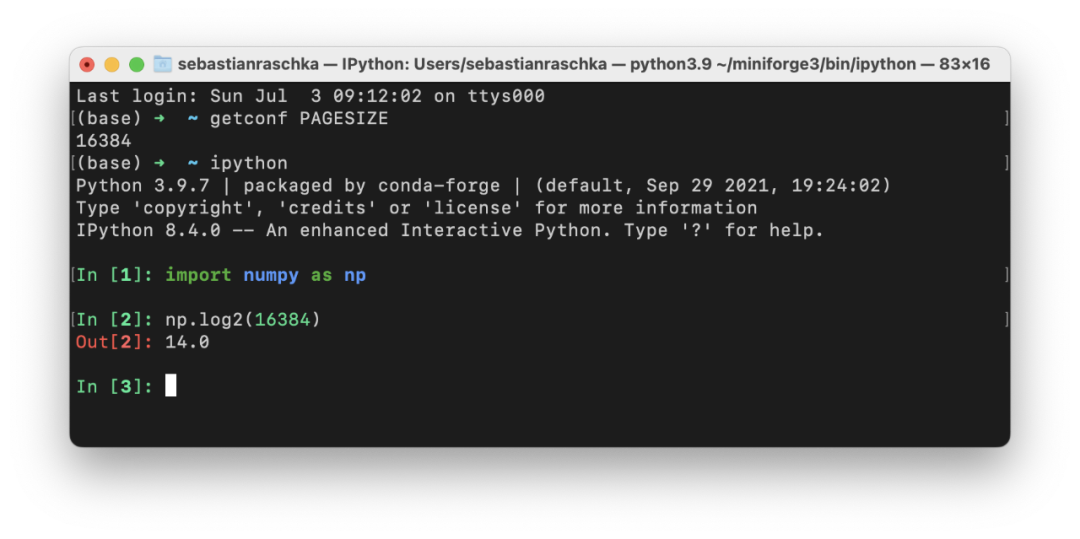

后者是否是一種玄學?似乎很少有人驗證過。最近,威斯康星大學麥迪遜分校助理教授,著名機器學習博主 Sebastian Raschka 對此進行了一番認真的討論。

Sebastian Raschka

關于神經網絡訓練,我認為我們都犯了這樣的錯誤:我們選擇批量大小為 2 的冪,即 64、128、256、512、1024 等等。(這里,batch size 是指當我們通過基于隨機梯度下降的優化算法訓練具有反向傳播的神經網絡時,每個 minibatch 中的訓練示例數。)

據稱,我們這樣做是出于習慣,因為這是一個標準慣例。這是因為我們曾經被告知,將批量大小選擇為 2 的冪有助于從計算角度提高訓練效率。

這有一些有效的理論依據,但它在實踐中是如何實現的呢?在過去的幾天里,我們對此進行了一些討論,在這里我想寫下一些要點,以便將來參考。我希望你也會發現這很有幫助!

理論背景

在看實際基準測試結果之前,讓我們簡要回顧一下將批大小選擇為 2 的冪的主要思想。以下兩個小節將簡要強調兩個主要論點:內存對齊和浮點效率。

內存對齊

選擇批大小為 2 的冪的主要論據之一是 CPU 和 GPU 內存架構是以 2 的冪進行組織的。或者更準確地說,存在內存頁的概念,它本質上是一個連續的內存塊。如果你使用的是 macOS 或 Linux,就可以通過在終端中執行 getconf PAGESIZE 來檢查頁面大小,它應該會返回一個 2 的冪的數字。

這個想法是將一個或多個批次整齊地放在一個頁面上,以幫助 GPU 并行處理。或者換句話說,我們選擇批大小為 2 以獲得更好的內存對齊。這與在視頻游戲開發和圖形設計中使用 OpenGL 和 DirectX 時選擇二次冪紋理類似。

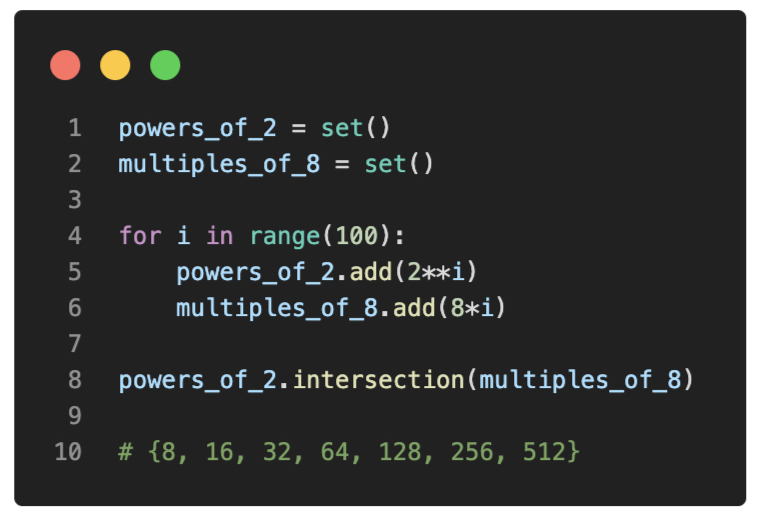

矩陣乘法和 Tensor Core

再詳細一點,英偉達有一個矩陣乘法背景用戶指南,解釋了矩陣尺寸和圖形處理單元 GPU 計算效率之間的關系。因此,本文建議不要將矩陣維度選擇為 2 的冪,而是將矩陣維度選擇為 8 的倍數,以便在具有 Tensor Core 的 GPU 上進行混合精度訓練。不過,當然這兩者之間存在重疊:

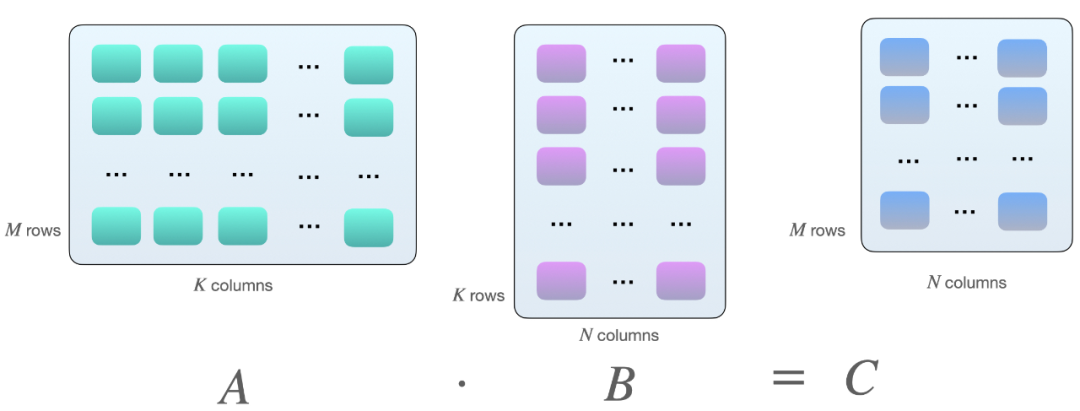

為什么會是 8 的倍數?這與矩陣乘法有關。假設我們在矩陣 A 和 B 之間有以下矩陣乘法:

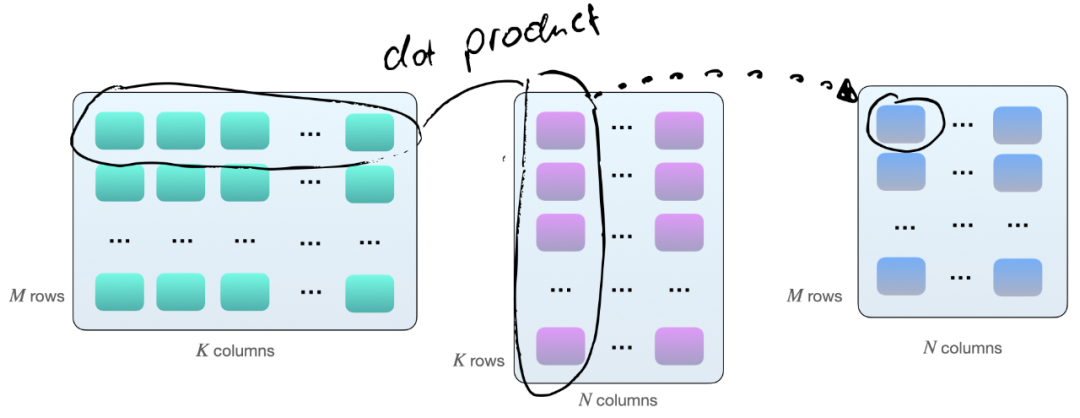

將兩個矩陣 A 和 B 相乘的一種方法,是計算矩陣 A 的行向量和矩陣 B 的列向量之間的點積。如下所示,這些是 k 元素向量對的點積:

每個點積由一個「加」和一個「乘」操作組成,我們有 M×N 個這樣的點積。因此,共有 2×M×N×K 次浮點運算(FLOPS)。不過需要知道的是:現在矩陣在 GPU 上的乘法并不完全如此,GPU 上的矩陣乘法涉及平鋪。

如果我們使用帶有 Tensor Cores 的 GPU,例如英偉達 V100,當矩陣維度 (M、N 和 K)與 16 字節的倍數對齊(根據 Nvidia 的本指南)后,在 FP16 混合精度訓練的情況下,8 的倍數對于效率來說是最佳的。

通常,維度 K 和 N 由神經網絡架構決定(盡管如果我們自己設計還會有一些回旋余地),但批大小(此處為 M)通常是我們可以完全控制的。

因此,假設批大小為 8 的倍數在理論上對于具有 Tensor Core 和 FP16 混合精度訓練的 GPU 來說是最有效的,讓我們研究一下在實踐中可見的差異有多大。

簡單的 Benchmark

為了解不同的批大小如何影響實踐中的訓練,我運行了一個簡單的基準測試,在 CIFAR-10 上訓練 MobileNetV3 模型 10 個 epoch—— 圖像大小調整為 224×224 以達到適當的 GPU 利用率。在這里,我使用 16 位原生自動混合精度訓練在英偉達 V100 卡上運行訓練,它更有效地使用了 GPU 的張量核心。

如果想自己運行它,代碼可在此 GitHub 存儲庫中找到:https://github.com/rasbt/b3-basic-batchsize-benchmark

小 Batch Size 基準

我們從批大小為 128 的小基準開始。「訓練時間」對應于在 CIFAR-10 上訓練 MobileNetV3 的 10 個 epoch。推理時間意味著在測試集中的 10k 圖像上評估模型。

查看上表,讓我們將批大小 128 作為參考點。似乎將批量大小減少一 (127) 或將批量大小增加一 (129) 確實會導致訓練性能減慢。但這里的差異看來很小,我認為可以忽略不計。

將批大小減少 28 (100) 會導致性能明顯下降。這可能是因為模型現在需要處理比以前更多的批次(50,000 / 100 = 500 對比 50,000 / 100 = 390)。可能出于類似的原因,當我們將批大小增加 28 (156) 時就可以觀察到更快的訓練時間。

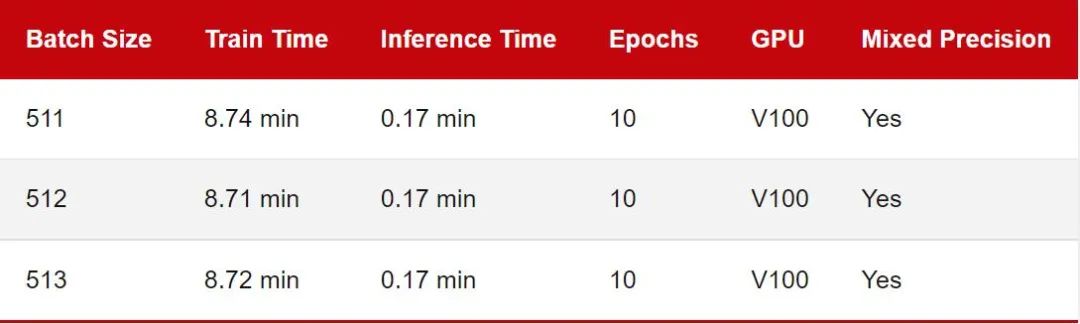

最大 Batch Size 基準

鑒于 MobileNetV3 架構和輸入圖像大小,上一節中的批尺寸相對較小,因此 GPU 利用率約為 70%。為了研究 GPU 滿負荷時的訓練時間差異,我將批量大小增加到 512,以使 GPU 顯示出接近 100% 的計算利用率:

由于 GPU 內存限制,批大小不可能超過 515。

同樣,正如我們之前看到的,作為 2 的冪(或 8 的倍數)的批大小確實會產生很小但幾乎不明顯的差異。

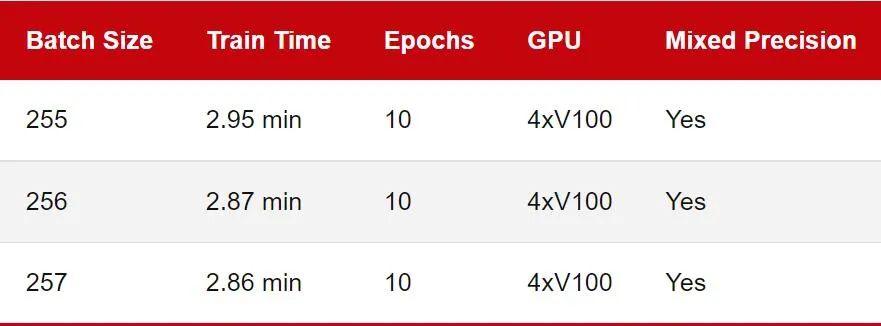

多 GPU 訓練

之前的基準測試評估了單塊 GPU 上的訓練性能。不過如今在多 GPU 上訓練深度神經網絡更為常見。所以讓我們看看下面的多 GPU 訓練的數字比較:

請注意,推理速度被省略了,因為在實踐中我們通常仍會使用單個 GPU 進行推理。此外,由于 GPU 的內存限制,我無法運行批處理大小為 512 的基準測試,因此在這里降低到 256。

正如我們所看到的,這一次 2 的冪和 8 的倍數批量大小 (256) 并不比 257 快。在這里,我使用 DistributedDataParallel (DDP) 作為默認的多 GPU 訓練策略。你也可以使用不同的多 GPU 訓練策略重復實驗。GitHub 上的代碼支持 —strategy ddp_sharded (fairscale)、ddp_spawn、deepspeed 等。

基準測試注意事項

這里需要強調的是上述所有基準測試都有注意事項。例如我只運行每個配置一次。理想情況下,我們希望多次重復這些運行并報告平均值和標準偏差。(但這可能不會影響我們的結論,即性能沒有實質性差異)

此外,雖然我在同一臺機器上運行了所有基準測試,但我以連續的順序運行它們,運行之間沒有很長的等待時間。因此這可能意味著基本 GPU 溫度在運行之間可能有所不同,并且可能會對計時產生輕微影響。

我運行基準測試來模仿真實世界的用例,即在 PyTorch 中訓練具有相對常見設置的現成架構。然而,正如 Piotr Bialecki 正確指出的那樣,通過設置 torch.backends.cudnn.benchmark = True 可以稍微提高訓練速度。

其他資源和討論

正如 Ross Wightman 所提到的,他也不認為選擇批量大小作為 2 的冪會產生明顯的差異。但選擇 8 的倍數對于某些矩陣維度可能很重要。此外 Wightman 指出,在使用 TPU 時批量大小至關重要。(不幸的是,我無法輕松訪問 TPU,也沒有任何基準比較)

如果你對其他 GPU 基準測試感興趣,請在此處查看 Thomas Bierhance 的優秀文章:https://wandb.ai/datenzauberai/Batch-Size-Testing/reports/Do-Batch-Sizes-Actually-Need-to-be-Powers-of-2---VmlldzoyMDkwNDQx

特別是你想要比較:

顯卡是否有 Tensor Core;

顯卡是否支持混合精度訓練;

在像 DeiT 這樣的無卷積視覺轉換器。

Rémi Coulom-Kayufu 的一個有趣的實驗表明,2 次方的批大小實際上很糟糕。看來對于卷積神經網絡,可以通過以下方式計算出較好的批大小:

Batch Size=int ((n×(1《《14)×SM)/(H×W×C))。

其中,n 是整數,SM 是 GPU 內核的數量(例如,V100 為 80,RTX 2080 Ti 為 68)。

結論

根據本文中共享的基準測試結果,我不認為選擇批大小作為 2 的冪或 8 的倍數在實踐中會產生明顯的差異。

然而,在任何給定的項目中,無論是研究基準還是機器學習的實際應用上,都已經有很多旋鈕需要調整。因此,將批大小選擇為 2 的冪(即 64、128、256、512、1024 等)有助于使事情變得更加簡單和易于管理。此外,如果你對發表學術研究論文感興趣,將批大小選擇為 2 的冪將使結果看起來不像是刻意挑選好結果。

雖然堅持批大小為 2 的冪有助于限制超參數搜索空間,但重要的是要強調批大小仍然是一個超參數。一些人認為較小的批尺寸有助于泛化性能,而另一些人則建議盡可能增加批大小。

個人而言,我發現最佳批大小在很大程度上取決于神經網絡架構和損失函數。例如,在最近一個使用相同 ResNet 架構的研究項目中,我發現最佳批大小可以在 16 到 256 之間,具體取決于損失函數。

因此,我建議始終考慮調整批大小作為超參數優化搜索的一部分。但是,如果因為內存限制而不能使用 512 的批大小,則不必降到 256。有限考慮 500 的批大小是完全可行的。

原文標題:一番實驗后,有關Batch Size的玄學被打破了

文章出處:【微信公眾號:OpenCV學堂】歡迎添加關注!文章轉載請注明出處。

-

神經網絡

+關注

關注

42文章

4812瀏覽量

103221 -

存儲

+關注

關注

13文章

4519瀏覽量

87268 -

gpu

+關注

關注

28文章

4925瀏覽量

130941

原文標題:一番實驗后,有關Batch Size的玄學被打破了

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學堂】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

有關batch size的設置范圍

有關batch size的設置范圍

評論