摘要

本文提出了一種名為 R3LIVE++ 的 LiDAR 慣性視覺(jué)融合框架,以實(shí)現(xiàn)穩(wěn)健且準(zhǔn)確的狀態(tài)估計(jì),同時(shí)實(shí)時(shí)重建輻射圖。R3LIVE++ 由實(shí)時(shí)運(yùn)行的 LiDAR 慣性里程計(jì) (LIO) 和視覺(jué)慣性里程計(jì) (VIO) 組成。LIO 子系統(tǒng)利用來(lái)自 LiDAR 的測(cè)量來(lái)重建幾何結(jié)構(gòu),而 VIO 子系統(tǒng)同時(shí)從輸入圖像中恢復(fù)幾何結(jié)構(gòu)的輻射信息。

R3LIVE++基于R3LIVE,通過(guò)結(jié)合相機(jī)光度校準(zhǔn)和相機(jī)曝光時(shí)間的在線估計(jì),進(jìn)一步提高了定位和建圖的準(zhǔn)確性。論文在公開和私有數(shù)據(jù)集上展開了充分的實(shí)驗(yàn),并同其他SOTA的SLAM 系統(tǒng)進(jìn)行比較。定量和定性的結(jié)果表明,R3LIVE++ 在準(zhǔn)確性和魯棒性方面都有很大的優(yōu)勢(shì)。

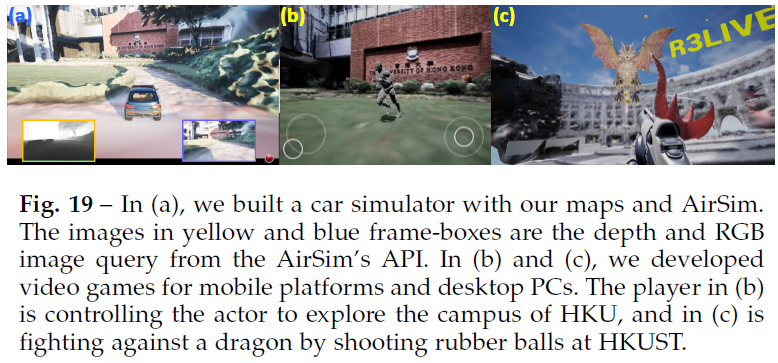

此外,為了展示R3LIVE++ 的可擴(kuò)展性,論文基于R3LIVE++得到的重建地圖開發(fā)了若干應(yīng)用程序,例如高動(dòng)態(tài)范圍 (HDR) 成像、虛擬環(huán)境探索和 3D 視頻游戲。 在SLAM中融合LiDAR和相機(jī)測(cè)量,可以克服各個(gè)傳感器在定位中的退化問(wèn)題,并生成滿足各種地圖應(yīng)用需求的精確、紋理化和高分辨率3D地圖。基于此,論文提出的R3LIVE++有以下特點(diǎn):

R3LIVE++是一個(gè)激光雷達(dá)慣性視覺(jué)融合框架,緊密耦合了兩個(gè)子系統(tǒng):LIO和VIO子系統(tǒng)。這兩個(gè)子系統(tǒng)聯(lián)合增量地實(shí)時(shí)構(gòu)建周圍環(huán)境的3D輻射圖。特別是,LIO通過(guò)將LiDAR中的新點(diǎn)云配準(zhǔn)到地圖中來(lái)重建幾何結(jié)構(gòu),而VIO則通過(guò)將圖像中的像素顏色渲染到地圖中的點(diǎn)來(lái)恢復(fù)輻射信息;

R3LIVE++提出一個(gè)新穎的VIO設(shè)計(jì),通過(guò)最小化輻射圖中的點(diǎn)與當(dāng)前圖像中稀疏像素集合間的輻射度差異來(lái)跟蹤相機(jī)姿態(tài)(并估計(jì)其他系統(tǒng)狀態(tài))。frame-to-map的對(duì)齊有效地降低了里程計(jì)的漂移,而單個(gè)像素稀疏集合上的直接光度誤差有效地限制了計(jì)算負(fù)載。此外,基于光度誤差,VIO能夠在線估計(jì)相機(jī)曝光時(shí)間,從而能夠恢復(fù)環(huán)境的真實(shí)輻射信息;

在定位精度、魯棒性和輻射圖重建精度方面,論文的方法在真實(shí)世界的實(shí)驗(yàn)中得到了廣泛驗(yàn)證。來(lái)自開放數(shù)據(jù)集(NCLT數(shù)據(jù)集)的25個(gè)序列的基準(zhǔn)測(cè)試結(jié)果表明,相比之下,R3LIVE++在所有其他最先進(jìn)的SLAM系統(tǒng)(如LVI-SAM、LIO-SAM、FAST-LIO2等)中實(shí)現(xiàn)了新SOTA。

此外,論文在私有數(shù)據(jù)集的評(píng)估表明,R3LIVE++對(duì)于激光雷達(dá)或相機(jī)測(cè)量退化的極端挑戰(zhàn)場(chǎng)景(例如,當(dāng)設(shè)備面對(duì)無(wú)紋理的墻時(shí))具有更好的魯棒性。最后,與其他同類產(chǎn)品相比,R3LIVE++可以更準(zhǔn)確地估計(jì)相機(jī)的曝光時(shí)間,并重建環(huán)境的真實(shí)輻射信息,與圖像中的測(cè)量像素相比,誤差要小得多;

據(jù)論文稱,這是第一個(gè)輻射圖重建框架,它可以在配備標(biāo)準(zhǔn)CPU的PC上實(shí)現(xiàn)實(shí)時(shí)性能,而無(wú)需任何硬件或GPU加速。基于進(jìn)一步開發(fā)的一套網(wǎng)格重建和紋理處理離線應(yīng)用程序,該系統(tǒng)在各種現(xiàn)實(shí)應(yīng)用中顯示出巨大潛力,例如3D HDR成像、物理模擬和視頻游戲。

方法

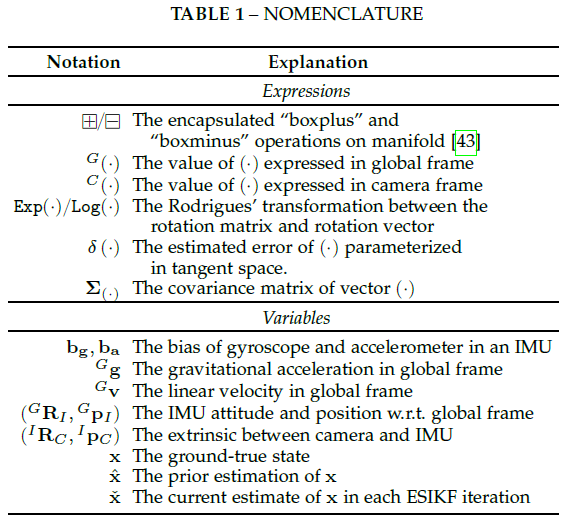

論文使用的符號(hào)含義如下表所示:

系統(tǒng)概覽

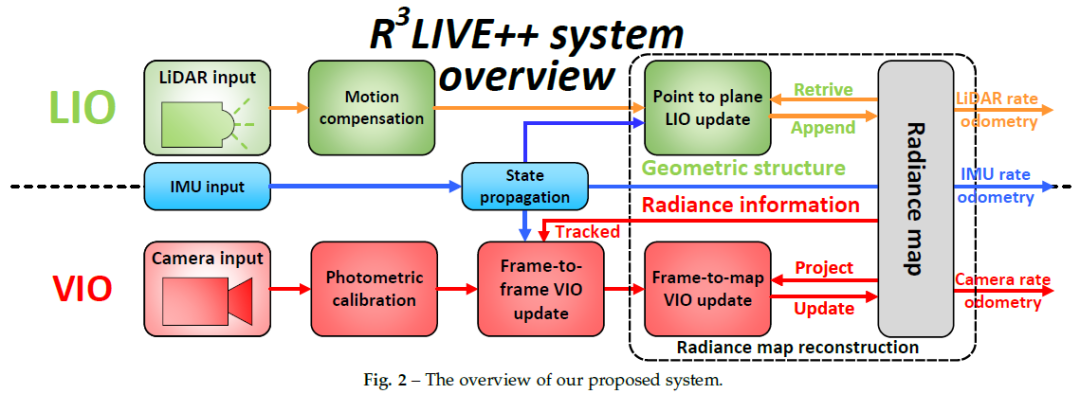

為了同時(shí)估計(jì)傳感器姿態(tài)并重建環(huán)境輻射圖,論文設(shè)計(jì)了一個(gè)緊密耦合的LiDAR慣性視覺(jué)傳感器融合框架,如圖2所示。該框架包含兩個(gè)子系統(tǒng):LIO和VIO子系統(tǒng)。LIO子系統(tǒng)通過(guò)記錄每個(gè)輸入LiDAR的點(diǎn)云測(cè)量值,構(gòu)建輻射圖的幾何結(jié)構(gòu)。

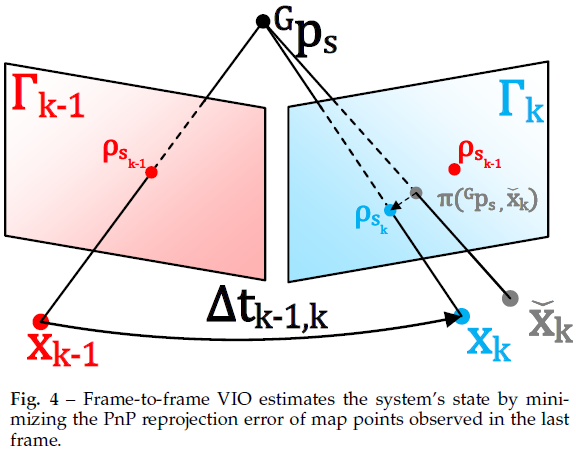

VIO子系統(tǒng)分兩步恢復(fù)地圖的輻射信息:幀到幀VIO更新通過(guò)最小化幀到幀PnP重投影誤差來(lái)估計(jì)系統(tǒng)狀態(tài),而幀到地圖VIO更新則最小化地圖點(diǎn)云和當(dāng)前圖像之間的輻射誤差。這兩個(gè)子系統(tǒng)在流形誤差狀態(tài)迭代卡爾曼濾波器框架(ESIKF)[43]內(nèi)緊密耦合,其中激光雷達(dá)和攝像機(jī)視覺(jué)測(cè)量在各自的數(shù)據(jù)接收時(shí)間融合到相同的系統(tǒng)狀態(tài)。

點(diǎn)

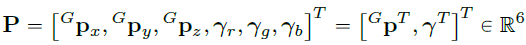

本文的輻射圖由全局框架中的地圖點(diǎn)組成,每個(gè)點(diǎn)P的結(jié)構(gòu)如下所示:

體素

為了有效地查詢輻射圖中的點(diǎn),論文將地圖點(diǎn)設(shè)置為固定大小(0.1m×0.1m×0.1m)的體素。如果一個(gè)體素近期附加了點(diǎn)(例如最近1秒),則將該體素標(biāo)記為激活。否則,此體素將標(biāo)記為停用。

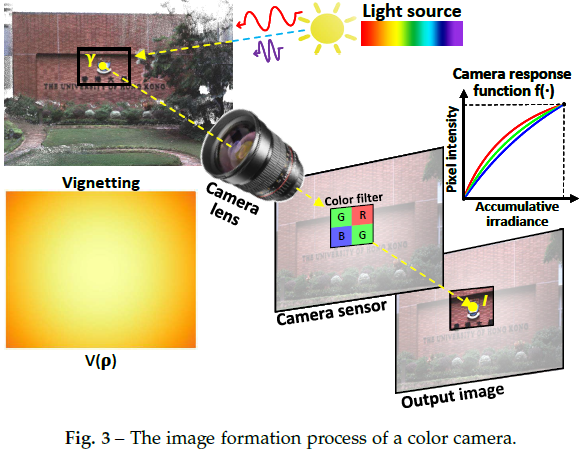

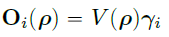

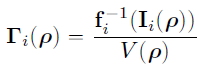

彩色相機(jī)光度模型

相機(jī)以圖像的形式觀察現(xiàn)實(shí)世界的輻射,圖像由像素強(qiáng)度的2D數(shù)組組成。在本文中基于[44]對(duì)相機(jī)的圖像形成過(guò)程進(jìn)行建模,并將灰色相機(jī)模型進(jìn)一步擴(kuò)展到彩色相機(jī)。如圖3所示,對(duì)于現(xiàn)實(shí)世界中的點(diǎn)P,它反射來(lái)自光源(例如太陽(yáng))的入射光。反射光通過(guò)相機(jī)鏡頭,最終到達(dá)CMOS傳感器,傳感器記錄反射光的強(qiáng)度,并在輸出圖像中創(chuàng)建像素通道。記錄的強(qiáng)度由輻射度決定,輻射度是點(diǎn)P反射功率的測(cè)量值。

為了建模上述成像過(guò)程,使用表示點(diǎn)P的輻射度。由于彩色相機(jī)的CMOS傳感器中有三個(gè)通道:紅色、綠色和藍(lán)色,因此輻射度有三個(gè)分量:、、 。對(duì)于每個(gè)通道,穿過(guò)相機(jī)鏡頭的光線有如下能量:

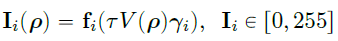

拍攝圖像時(shí),捕獲的輻射度隨時(shí)間(即曝光時(shí)間)進(jìn)行積分。然后,通過(guò)相機(jī)響應(yīng)函數(shù)將累積輻射度轉(zhuǎn)換為像素強(qiáng)度輸出:

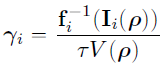

由于真實(shí)的相機(jī)傳感器具有有限的動(dòng)態(tài)范圍,并且輻射的物理尺度無(wú)法恢復(fù),因此可以將像素強(qiáng)度歸一化到0-1之間。 不同通道通常具有不同的非線性響應(yīng)函數(shù),它們可以根據(jù)[45]中的方法與vignetting factor一起離線校準(zhǔn)。本文的曝光時(shí)間是在線估計(jì)的。根據(jù)校準(zhǔn)和估計(jì)結(jié)果,點(diǎn)P相對(duì)于觀測(cè)像素值的輻射度可計(jì)算為:

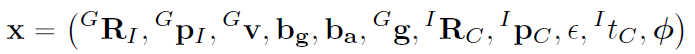

狀態(tài)

最終狀態(tài)x定義如下:

激光雷達(dá)慣性里程計(jì)(LIO)

論文的LIO子系統(tǒng)通過(guò)將新的LiDAR點(diǎn)云配準(zhǔn)到全局地圖來(lái)重建環(huán)境的幾何結(jié)構(gòu)。即使用generalized-iterative closet point(GICP)方法[46],通過(guò)最小化掃描中每個(gè)點(diǎn)云到地圖中相應(yīng)點(diǎn)擬合的平面的距離,迭代估計(jì)LiDAR姿態(tài)(和其他系統(tǒng)狀態(tài))。然后使用估計(jì)的狀態(tài)估計(jì)值將新點(diǎn)附加到地圖。

LiDAR point-to-plane residual

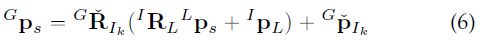

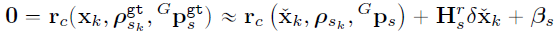

如圖2所示,論文的LIO子系統(tǒng)構(gòu)建了全局地圖的幾何結(jié)構(gòu)。對(duì)于第k個(gè)輸入LiDAR掃描,首先使用在[22]中引入的IMU反向傳播來(lái)補(bǔ)償幀內(nèi)運(yùn)動(dòng)。假設(shè)是運(yùn)動(dòng)補(bǔ)償后m個(gè)LiDAR點(diǎn)的集合,計(jì)算的每個(gè)原始點(diǎn)(或下采樣子集)的殘差,其中s是點(diǎn)的索引,上標(biāo)L表示點(diǎn)在LiDAR參考幀中的表示。 基于當(dāng)前迭代的估計(jì),將從LiDAR幀轉(zhuǎn)換到全局幀:

為了將點(diǎn)云配準(zhǔn)到全局地圖,論文搜索地圖中最近的五個(gè)點(diǎn)。為了加速最近鄰搜索,地圖點(diǎn)被組織成incremental k-d tree(參見(jiàn)[23])。使用找到的最近鄰點(diǎn)擬合一個(gè)具有法向和質(zhì)心的平面,然后使用激光雷達(dá)測(cè)量殘差:

LIO ESIKF update

理想情況下,上式中的殘差應(yīng)為零。然而,由于中的估計(jì)誤差和LiDAR測(cè)量噪聲,該殘差通常不是零,可以用于細(xì)化狀態(tài)估計(jì)。具體來(lái)說(shuō),假設(shè)是點(diǎn)的測(cè)量噪聲,則真值和測(cè)量值的關(guān)系如下所示:

該真實(shí)點(diǎn)位置和真實(shí)狀態(tài)可以推導(dǎo)出下式:

上式構(gòu)成的觀測(cè)分布,它與IMU傳播的先驗(yàn)分布相結(jié)合得到:

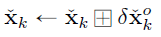

求解上式得到的Maximum A-Posteriori(MAP)估計(jì)值,然后更新到中,如下所示:

迭代直至收斂(即更新小于給定閾值)。然后將收斂狀態(tài)估計(jì)值用作IMU傳播的起點(diǎn),直到接收到下一個(gè)LiDAR掃描或相機(jī)圖像。此外,收斂估計(jì)值用于將當(dāng)前LiDAR掃描中的點(diǎn)添加到全局地圖中,如下所示。對(duì)于第s個(gè)點(diǎn),其在全局幀中的位置首先通過(guò)(6)獲得。如果在地圖中有距離為1cm的附近點(diǎn),將被丟棄,以保持1cm的空間分辨率。否則,將在地圖中創(chuàng)建一個(gè)新的點(diǎn)結(jié)構(gòu):

視覺(jué)慣性里程計(jì)(VIO)

當(dāng)LIO子系統(tǒng)重建環(huán)境的幾何結(jié)構(gòu)時(shí),VIO子系統(tǒng)從輸入的彩色圖像中恢復(fù)輻射信息。更具體地說(shuō),VIO子系統(tǒng)從全局地圖向當(dāng)前圖像投影一定數(shù)量的點(diǎn)(即跟蹤點(diǎn)),然后通過(guò)最小化這些點(diǎn)的輻射誤差來(lái)迭代估計(jì)相機(jī)姿態(tài)(和其他系統(tǒng)狀態(tài))。為了提高計(jì)算效率,只使用一組稀疏的跟蹤地圖點(diǎn)。

論文提出的框架不同于以前基于光度的方法[33]、[47],這些方法通過(guò)考慮所有相鄰像素(即patch)的光度誤差來(lái)構(gòu)成點(diǎn)的殘差。這些基于patch的方法具有更強(qiáng)的魯棒性和更快的收斂速度,然而對(duì)平移或旋轉(zhuǎn)都不是不變的,即需要在兩個(gè)patch對(duì)齊時(shí)估計(jì)相對(duì)變換。

此外,這些方法假設(shè)patch中所有像素的深度與中心點(diǎn)相同,所以殘差的計(jì)算并不精確。另一方面,論文的VIO在逐像素上操作,利用單個(gè)地圖點(diǎn)的輻射來(lái)計(jì)算殘差。在VIO中同時(shí)更新的輻射度是世界上某個(gè)點(diǎn)的固有屬性,對(duì)攝影機(jī)平移和旋轉(zhuǎn)都是不變的。

為了確保穩(wěn)健和快速收斂,論文設(shè)計(jì)了圖2所示的兩步流水線,其中在第一步(即 frame-to-frame VIO)中,利用frame-to-frame光流跟蹤最后一幀中觀察到的地圖點(diǎn),并通過(guò)最小化跟蹤點(diǎn)的PnP重投影誤差來(lái)獲得系統(tǒng)狀態(tài)的粗略估計(jì)。然后,在第二步(即frame-to-map VIO)中,通過(guò)最小化地圖點(diǎn)的亮度和當(dāng)前圖像中其投影位置的像素強(qiáng)度之間的差異,進(jìn)一步細(xì)化狀態(tài)估計(jì)。

通過(guò)收斂狀態(tài)估計(jì)和原始輸入圖像,論文最終根據(jù)當(dāng)前圖像測(cè)量更新地圖點(diǎn)的輻射度。

光度矯正

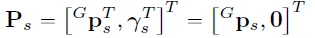

對(duì)于輸入圖像,首先校正圖像non-linear CRF 和vignetting factor ,其已經(jīng)預(yù)先校準(zhǔn),以獲得測(cè)光校正圖像,其像素位置的第i通道為:

測(cè)光校正圖像 之后在VIO管道中使用,包括frame-to-frame VIO、frame-to-map VIO和輻射恢復(fù)。

Frame-to-frame VIO

Perspective-n-Point reprojection error

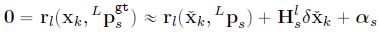

假設(shè)跟蹤了m個(gè)在最后一幀圖像中的地圖點(diǎn)及其在圖像中的投影位置。論文使用Lucas Kanade光流來(lái)定位這些點(diǎn)在當(dāng)前圖像中的位置。然后迭代地最小化點(diǎn)P的重投影誤差,以獲得狀態(tài)的粗略估計(jì)(見(jiàn)圖4)。

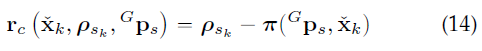

投影誤差表示如下:

Frame-to-frame VIO Update

與LIO更新類似,中的狀態(tài)估計(jì)誤差和相機(jī)測(cè)量噪聲將導(dǎo)致(14)中的某個(gè)殘差,從中可以如下更新?tīng)顟B(tài)估計(jì)。首先(14)中的測(cè)量噪聲由兩個(gè)來(lái)源組成:一個(gè)是的像素跟蹤誤差,另一個(gè)是地圖點(diǎn)定位誤差:

類似的,校正此類噪聲并使用真實(shí)的系統(tǒng)狀態(tài)應(yīng)導(dǎo)致零殘差:

上式構(gòu)成了的觀測(cè)分布,將其與與IMU傳播相結(jié)合,以獲得狀態(tài)的MAP估計(jì)值,方法與LIO更新相同。然后收斂的狀態(tài)估計(jì)值用于細(xì)化frame-to-map VIO。

Frame-to-map VIO

Frame-to-map radiance error

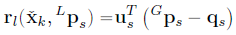

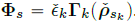

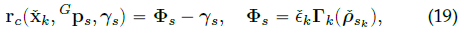

frame-to-frame VIO更新可以提供良好的狀態(tài)估計(jì),通過(guò)最小化跟蹤的地圖點(diǎn)P的輻射誤差,frame-to-map VIO更新會(huì)進(jìn)一步細(xì)化。利用當(dāng)前迭代的狀態(tài)估計(jì)(包含估計(jì)的相機(jī)姿態(tài)、內(nèi)外參和曝光時(shí)間),進(jìn)一步將跟蹤的地圖點(diǎn)投影到圖像平面,以獲得其像素位置。然后,由表示的觀測(cè)輻射度可以由下式獲得:

最后,frame-to-map輻射誤差由下式獲得:

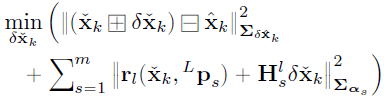

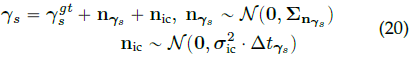

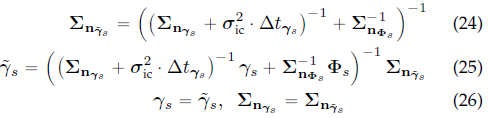

Frame-to-map VIO update

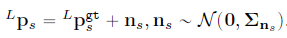

上式中的測(cè)量噪聲來(lái)自輻射分量和:

結(jié)合(19)、(20)和(21)進(jìn)一步得到了真實(shí)零殘差的一階泰勒展開式:

與之前類似,(22)構(gòu)成了狀態(tài)的觀測(cè)分布,該分布與IMU傳播相結(jié)合,以獲得該狀態(tài)的MAP估計(jì)值。

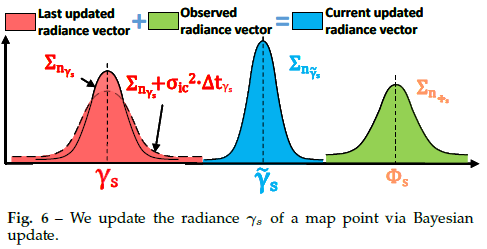

Recovery of radiance information

在frame-to-map VIO更新后,便得到了當(dāng)前圖像的精確姿態(tài)。然后進(jìn)行貝葉斯更新以確定所有地圖點(diǎn)的最佳輻射度,從而使每個(gè)點(diǎn)與其對(duì)應(yīng)圖像之間的平均輻射度誤差最小。 進(jìn)一步檢索所有激活體素中的點(diǎn)。假設(shè)檢索到的點(diǎn)集為Q。對(duì)于落在當(dāng)前圖像FoV中的第s個(gè)點(diǎn),首先通過(guò)(19)獲取觀測(cè)到的輻射向量,通過(guò)(21)獲得其協(xié)方差。然后,如果是LIO子系統(tǒng)附加的一個(gè)新點(diǎn)且,則我們?cè)O(shè)置:

否則,通過(guò)貝葉斯更新(見(jiàn)圖6),將保存在地圖中的輻射矢量與新觀測(cè)到的輻射矢量進(jìn)行融合:

Update of the tracking points

在恢復(fù)輻射信息后,論文更新跟蹤點(diǎn)集P以供下一幀圖像使用。首先,如果(14)中的投影誤差或(19)中的輻射誤差過(guò)大,就從當(dāng)前P中刪除點(diǎn),并刪除不屬于當(dāng)前圖像FoV的點(diǎn)。其次,論文將Q中的每個(gè)點(diǎn)投影到當(dāng)前圖像中,如果在50像素的鄰域中沒(méi)有其他跟蹤點(diǎn),則將其添加到P中。

實(shí)驗(yàn)

論文進(jìn)行了大量實(shí)驗(yàn),從三個(gè)方面驗(yàn)證了提出的系統(tǒng)相對(duì)于其他同類系統(tǒng)的優(yōu)勢(shì):

1)為了驗(yàn)證定位的準(zhǔn)確性,在公開數(shù)據(jù)集(NCLT數(shù)據(jù)集)上定量比較了R3LIVE++與其他SOTA的SLAM系統(tǒng);

2) 為了驗(yàn)證框架的魯棒性,在攝像機(jī)和激光雷達(dá)傳感器退化的各種具有挑戰(zhàn)性的場(chǎng)景下進(jìn)行測(cè)試;

3) 為了評(píng)估R3LIVE++在重建輻射圖時(shí)的精度,論文將其與現(xiàn)有基線進(jìn)行比較,以估算相機(jī)曝光時(shí)間并計(jì)算每個(gè)圖像的平均光度誤差。在實(shí)驗(yàn)中,使用了兩個(gè)數(shù)據(jù)集進(jìn)行評(píng)估:NCLT數(shù)據(jù)集和私有的R3LIVE數(shù)據(jù)集。

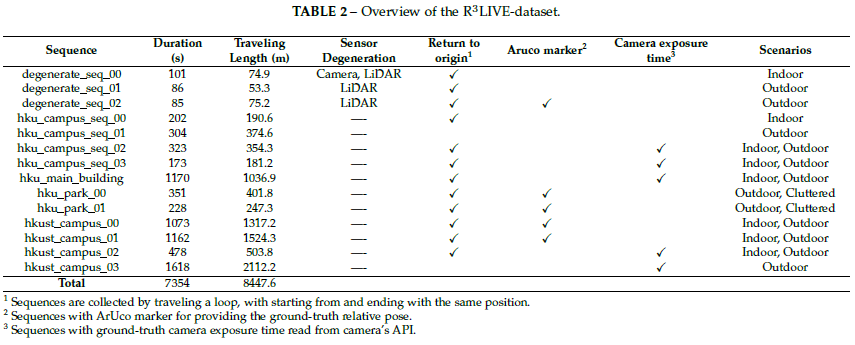

R3LIVE數(shù)據(jù)集收集于香港大學(xué)(HKU)和香港科技大學(xué)(HKUST)的校園內(nèi)。如表2所示,數(shù)據(jù)集包含13個(gè)序列,通過(guò)探索室內(nèi)和室外環(huán)境,在一天中不同時(shí)間(即上午、中午和晚上)的不同場(chǎng)景(如人行道、公園、森林等)中收集這些序列。這使得數(shù)據(jù)集能夠捕獲具有不同照明條件下的結(jié)構(gòu)化城市建筑和雜亂現(xiàn)場(chǎng)環(huán)境。

數(shù)據(jù)集還包括三個(gè)退化序列,其中激光雷達(dá)或相機(jī)(或兩者)偶爾面對(duì)設(shè)備,使其退化為單個(gè)視覺(jué)或無(wú)紋理平面(例如,墻、地面)。總行程8.4km,持續(xù)時(shí)間達(dá)到2.4h。

定位準(zhǔn)確性評(píng)估

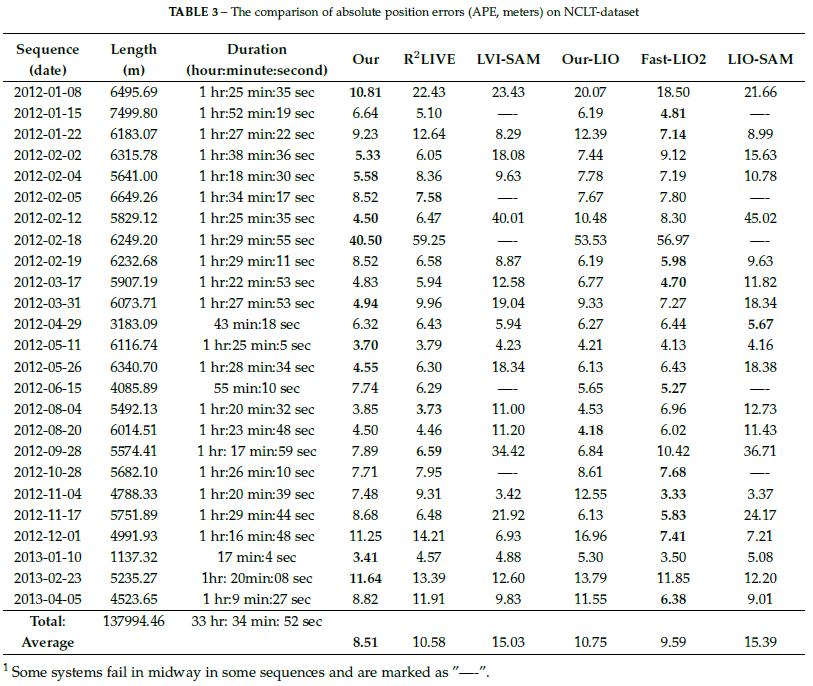

論文將R3LIVE++與其他SLAM系統(tǒng)進(jìn)行對(duì)比,包括LIO-SAM[19]、LVI-SAM[40]、FAST-LIO2[23]和R2LIVE[41]。 對(duì)比結(jié)果如下表所示:

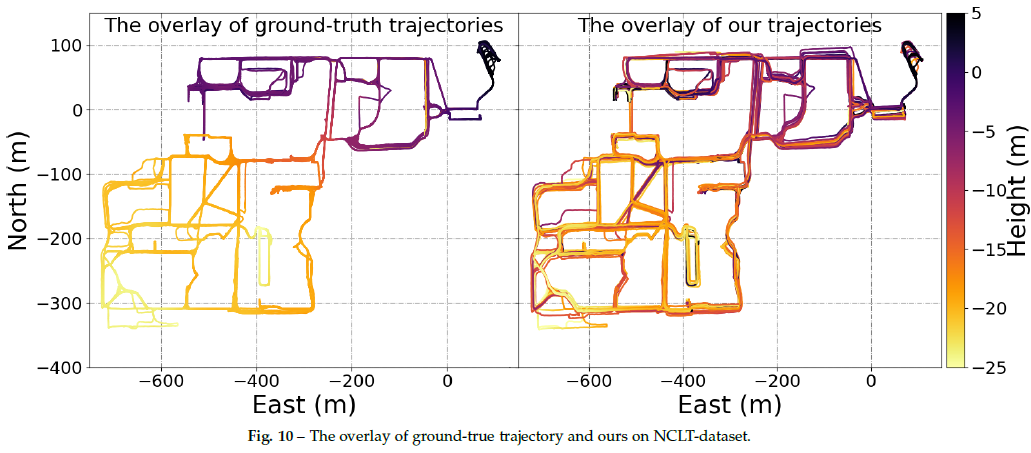

在圖10中,論文對(duì)比疊加了所有25條地面真實(shí)軌跡(左圖)和R3LIVE的結(jié)果(右圖)。可以看出,R3LIVE++系統(tǒng)估計(jì)的疊加軌跡與GT吻合得很好,并且每個(gè)軌跡仍然可以清楚地區(qū)分,沒(méi)有明顯的誤差。請(qǐng)注意,這25條軌跡是在同一校園區(qū)域內(nèi)一天中的不同時(shí)間和一年中的不同季節(jié)采集的,但R3LIVE++仍然可以生成一致且可靠的軌跡估計(jì),證明了系統(tǒng)的魯棒性。

魯棒性評(píng)估

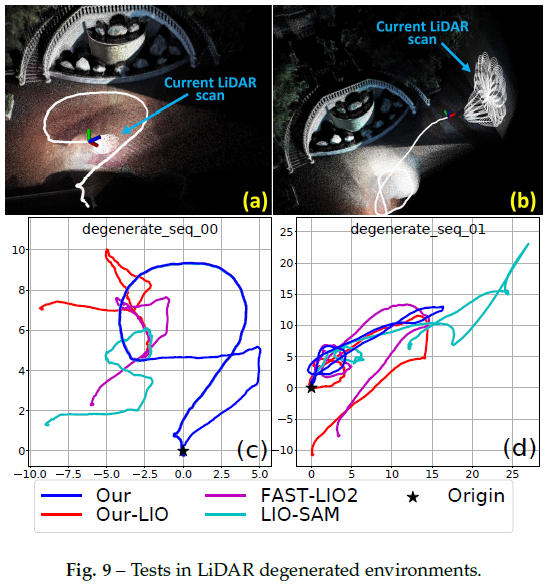

LiDAR退化場(chǎng)景下的魯棒性評(píng)估:可以看出,由于面對(duì)單個(gè)平面時(shí)激光雷達(dá)退化,所有三個(gè)LIO系統(tǒng)都失敗了,沒(méi)有返回起點(diǎn)。相比之下,通過(guò)利用視覺(jué)圖像中的線索,R3LIVE++在這兩個(gè)序列中都能很好地工作,并成功地回到起點(diǎn)。

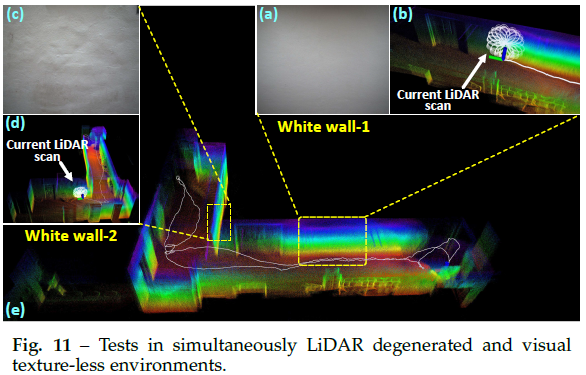

LiDAR退化和視覺(jué)紋理較少環(huán)境下的魯棒性評(píng)估:在這個(gè)實(shí)驗(yàn)中,R3LIVE++挑戰(zhàn)了SLAM中最困難的場(chǎng)景之一,激光雷達(dá)和相機(jī)都會(huì)退化。傳感器裝置穿過(guò)一個(gè)狹窄的“T”形通道(見(jiàn)圖11)

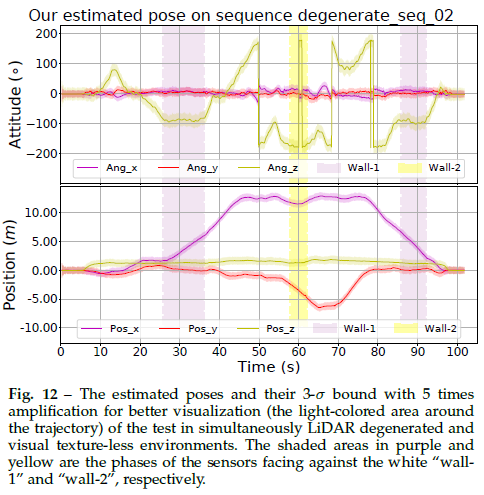

利用原始像素顏色信息,并將其與LiDAR點(diǎn)云測(cè)量緊密融合,R3LIVE++可以在這種極其困難的場(chǎng)景中“生存”。圖12是姿態(tài)估計(jì)的結(jié)果,穿過(guò)“墻-1”和“墻-2”的階段分別用紫色和黃色陰影表示。估計(jì)協(xié)方差也如圖12所示,它在整個(gè)估計(jì)軌跡上有界,表明R3LIVE++的估計(jì)質(zhì)量在整個(gè)過(guò)程中是穩(wěn)定的。

輻射圖重建評(píng)估

由于無(wú)法測(cè)量環(huán)境的真實(shí)輻射圖,論文使用兩個(gè)指標(biāo)來(lái)評(píng)估精度:一個(gè)是相機(jī)曝光時(shí)間的估計(jì)質(zhì)量,另一個(gè)是重建的輻射圖與測(cè)量圖像之間的平均光度誤差。

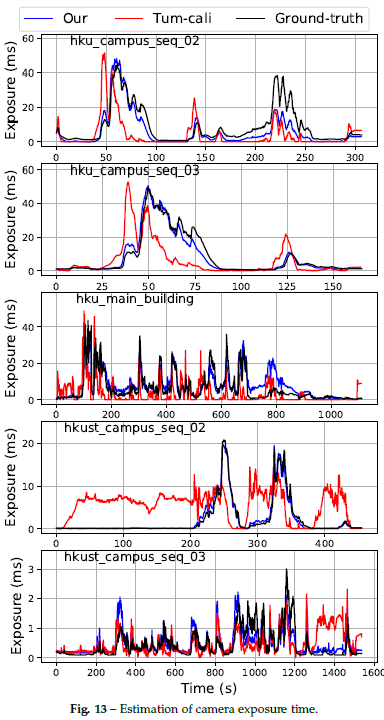

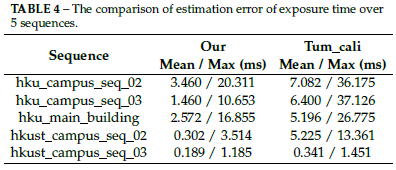

曝光時(shí)間估計(jì):在這個(gè)實(shí)驗(yàn)中,論文通過(guò)將估計(jì)的相機(jī)曝光時(shí)間與從相機(jī)API讀取的GT進(jìn)行比較來(lái)評(píng)估其準(zhǔn)確性。結(jié)果如圖13和表4所示。

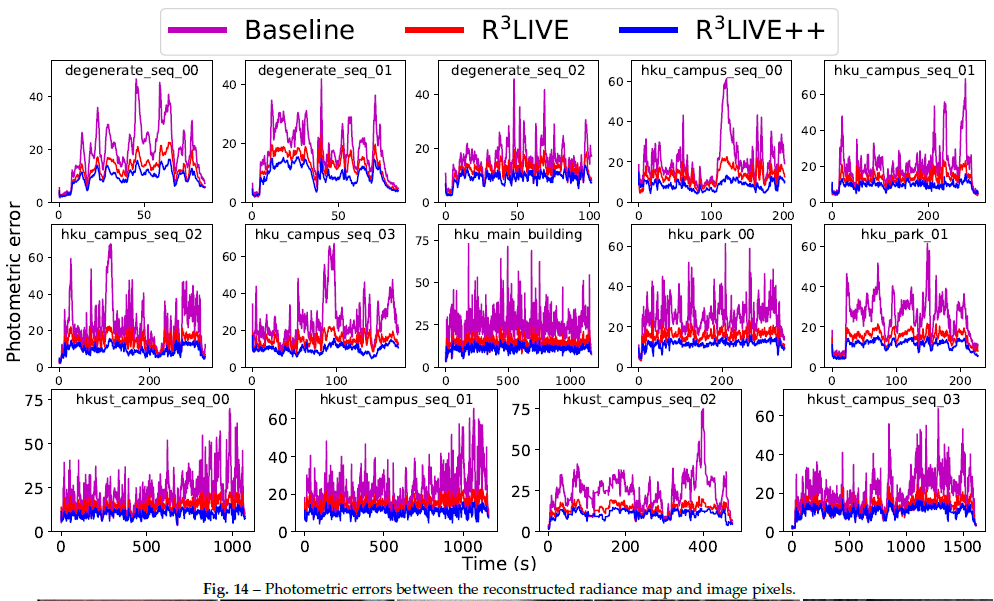

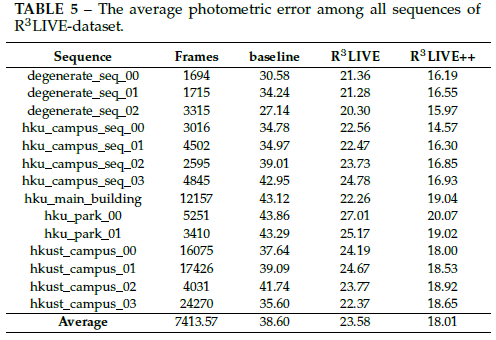

輻射圖評(píng)估:為了評(píng)估輻射重建誤差,在地圖重建后使用估計(jì)的相機(jī)姿態(tài)和校準(zhǔn)的光度參數(shù),將地圖中所有具有輻射信息的點(diǎn)重新投影到每個(gè)圖像幀。然后計(jì)算地圖點(diǎn)顏色和圖像在投影像素位置的RGB值之間的光度誤差。計(jì)算每個(gè)圖像幀的平均光度誤差,以評(píng)估重建的輻射圖精度。實(shí)驗(yàn)結(jié)果如圖14和表5所示:

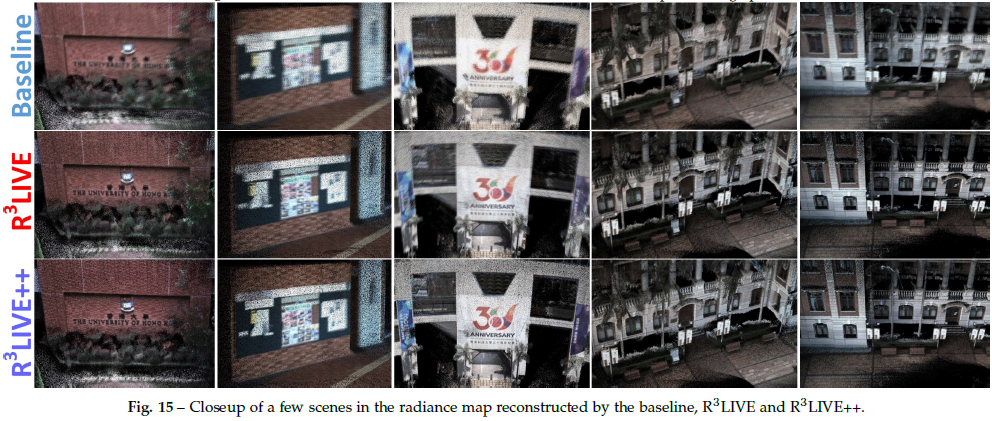

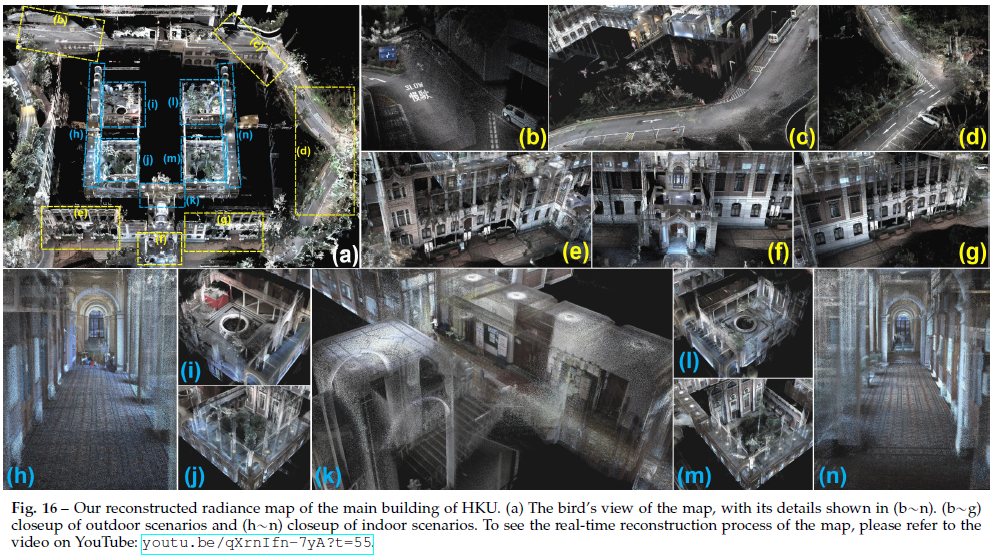

可以看出,R3LIVE++在所有序列中始終實(shí)現(xiàn)了最低的光度誤差,其次是R3LIVE。圖15顯示了重建輻射圖的一些特寫鏡頭,從中可以清楚地分辨物體上的單詞。此外,圖16展示了R3LIVE數(shù)據(jù)集中“香港大學(xué)主樓”序列的重建輻射圖,室內(nèi)和室外細(xì)節(jié)(例如道路上的標(biāo)記)都非常清晰,表明R3LIVE++具有較高的精度。

運(yùn)行時(shí)間分析

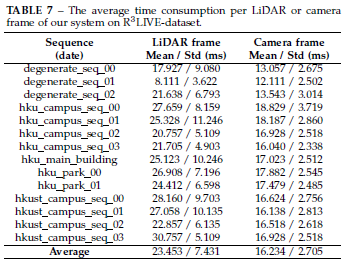

本節(jié)分析SLAM系統(tǒng)在純CPU PC(配備Intel i7-9700K CPU和64GB RAM)上的平均耗時(shí)。論文計(jì)算了兩個(gè)數(shù)據(jù)集所有序列的平均耗時(shí),結(jié)果如表6和表7所示。在NCLT數(shù)據(jù)集上,每次LiDAR掃描需要34.3 ms,相機(jī)需要16.6 ms的處理時(shí)間。

R3LIVE++的應(yīng)用

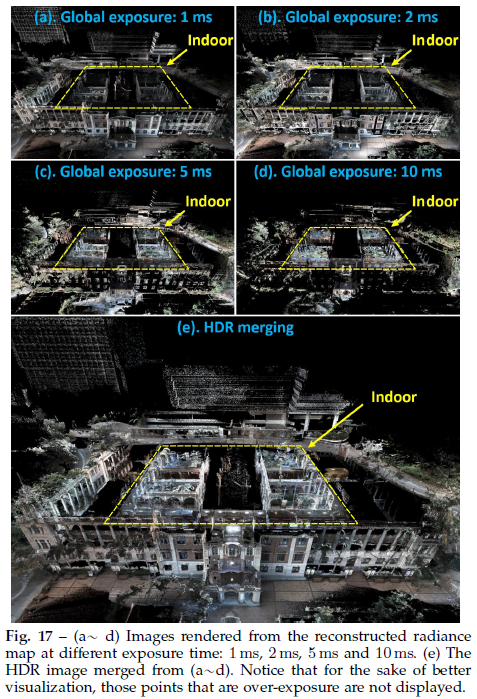

High dynamic range (HDR) imaging

在重建輻射圖后,可以進(jìn)一步渲染圖像,可視化結(jié)果如圖17所示:

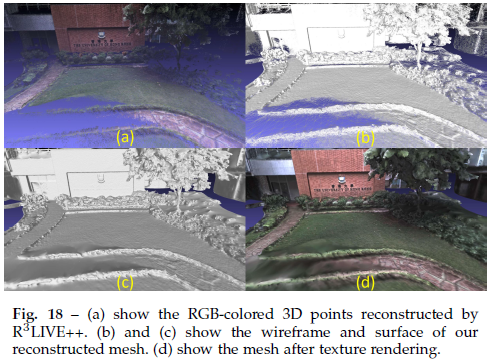

Mesh reconstruction and texturing

當(dāng)R3LIVE++實(shí)時(shí)重建彩色3D地圖時(shí),論文還開發(fā)了軟件程序來(lái)離線對(duì)重建的地圖進(jìn)行網(wǎng)格劃分和紋理處理(見(jiàn)圖18)。

Toward various of 3D applications

通過(guò)開發(fā)的軟件,論文將將重建的3D地圖導(dǎo)出到Unreal Engine[60],以支持一系列3D應(yīng)用程序。如圖19所示的汽車模擬器、視頻游戲等

結(jié)論和未來(lái)工作

結(jié)論

論文提出了一種新的激光雷達(dá)慣性視覺(jué)融合框架R3LIVE++,以實(shí)現(xiàn)魯棒和精確的狀態(tài)估計(jì),同時(shí)動(dòng)態(tài)重建輻射圖。該框架由兩個(gè)子系統(tǒng)(即LIO和VIO)組成,這兩個(gè)子系統(tǒng)共同增量地實(shí)時(shí)構(gòu)建環(huán)境的3D輻射圖。通過(guò)將三種不同類型傳感器的測(cè)量值緊密融合,R3LIVE++可以實(shí)現(xiàn)更高的定位精度,同時(shí)對(duì)傳感器退化的場(chǎng)景具有足夠的魯棒性。

論文通過(guò)真實(shí)世界的實(shí)驗(yàn),在定位精度、魯棒性和輻射圖重建精度方面驗(yàn)證了R3LIVE++的有效性。在NCLT數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,R3LIVE++超越了以往SOTA的SLAM系統(tǒng)。對(duì)私有數(shù)據(jù)集(R3LIVE數(shù)據(jù)集)的評(píng)估表明,R3LIVE++對(duì)LiDAR或相機(jī)測(cè)量退化的極端挑戰(zhàn)性場(chǎng)景具有魯棒性。最后與其他算法相比,R3LIVE++可以更準(zhǔn)確地估計(jì)相機(jī)的曝光時(shí)間,并重建環(huán)境的真實(shí)輻射信息,與圖像中的測(cè)量值相比,誤差要小得多。

為了證明R3LIVE++的可擴(kuò)展性,論文基于重建的輻射圖開發(fā)了幾個(gè)應(yīng)用程序,例如高動(dòng)態(tài)范圍(HDR)成像、虛擬環(huán)境探索和3D視頻游戲。

未來(lái)工作

在R3LIVE++中,輻射圖是用包含輻射信息的3D點(diǎn)云重建的,因此無(wú)法從輻射圖中渲染高分辨率圖像,因?yàn)檩椛鋱D的點(diǎn)云密度有限(論文設(shè)置為1cm)。雖然可以進(jìn)一步增加點(diǎn)云密度,但也會(huì)進(jìn)一步增加耗時(shí)。此外點(diǎn)云密度還受到激光雷達(dá)傳感器測(cè)量的原始點(diǎn)云密度的限制。我們注意到圖像通常具有更高的分辨率,未來(lái)可以探索如何在融合框架中充分利用此類高分辨率圖像。

審核編輯:劉清

-

HDR

+關(guān)注

關(guān)注

4文章

288瀏覽量

32613 -

SLAM

+關(guān)注

關(guān)注

24文章

440瀏覽量

32470 -

激光雷達(dá)

+關(guān)注

關(guān)注

971文章

4230瀏覽量

192686

原文標(biāo)題:港大重磅SLAM新作!R3LIVE++:一個(gè)實(shí)時(shí)魯棒的緊耦合激光雷達(dá)-慣性-視覺(jué)融合框架

文章出處:【微信號(hào):3D視覺(jué)工坊,微信公眾號(hào):3D視覺(jué)工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

RGB+EVS視覺(jué)融合相機(jī):事件相機(jī)的革命性突破?

霍尼韋爾推出新一代慣性導(dǎo)航系統(tǒng) HGuide-N380

【「# ROS 2智能機(jī)器人開發(fā)實(shí)踐」閱讀體驗(yàn)】視覺(jué)實(shí)現(xiàn)的基礎(chǔ)算法的應(yīng)用

一種新型激光雷達(dá)慣性視覺(jué)里程計(jì)系統(tǒng)介紹

一種實(shí)時(shí)多線程VSLAM框架vS-Graphs介紹

視美泰EVS事件融合相機(jī)新品“靈光一號(hào)”正式發(fā)布,開啟視覺(jué)新紀(jì)元

慣性傳感器的分類和應(yīng)用

一種基于MASt3R的實(shí)時(shí)稠密SLAM系統(tǒng)

一種面向飛行試驗(yàn)的數(shù)據(jù)融合框架

基于視覺(jué)語(yǔ)言模型的導(dǎo)航框架VLMnav

基于旋轉(zhuǎn)平移解耦框架的視覺(jué)慣性初始化方法

一種全新開源SfM框架MASt3R

一種完全分布式的點(diǎn)線協(xié)同視覺(jué)慣性導(dǎo)航系統(tǒng)

LIDAR激光雷達(dá)逆向建模能用到revit當(dāng)中嗎

計(jì)算機(jī)視覺(jué)中的圖像融合

一種R3LIVE++的LiDAR慣性視覺(jué)融合框架

一種R3LIVE++的LiDAR慣性視覺(jué)融合框架

評(píng)論