1. 簡介

Prompt通過將輸入文本填入預(yù)設(shè)prompt模板的方式,將下游NLP任務(wù)形式與語言模型預(yù)訓(xùn)練任務(wù)統(tǒng)一起來,來更好地利用預(yù)訓(xùn)練階段學(xué)習(xí)到的知識(shí),使模型更容易適應(yīng)于下游任務(wù),在一系列NLP任務(wù)上取得了很好的效果[1]。Soft prompt方法使用可學(xué)習(xí)的參數(shù)來替代prompt模板中固定的token,盡管在少標(biāo)注文本分類任務(wù)上性能優(yōu)異[2],但是其表現(xiàn)隨模型初始化參數(shù)不同會(huì)出現(xiàn)很大的波動(dòng)[1, 3]。人工選擇soft prompt模型參數(shù)需要對語言模型內(nèi)部工作機(jī)理的深入理解和大量試錯(cuò),并且在遇到不同少標(biāo)注任務(wù)時(shí)難以復(fù)用。

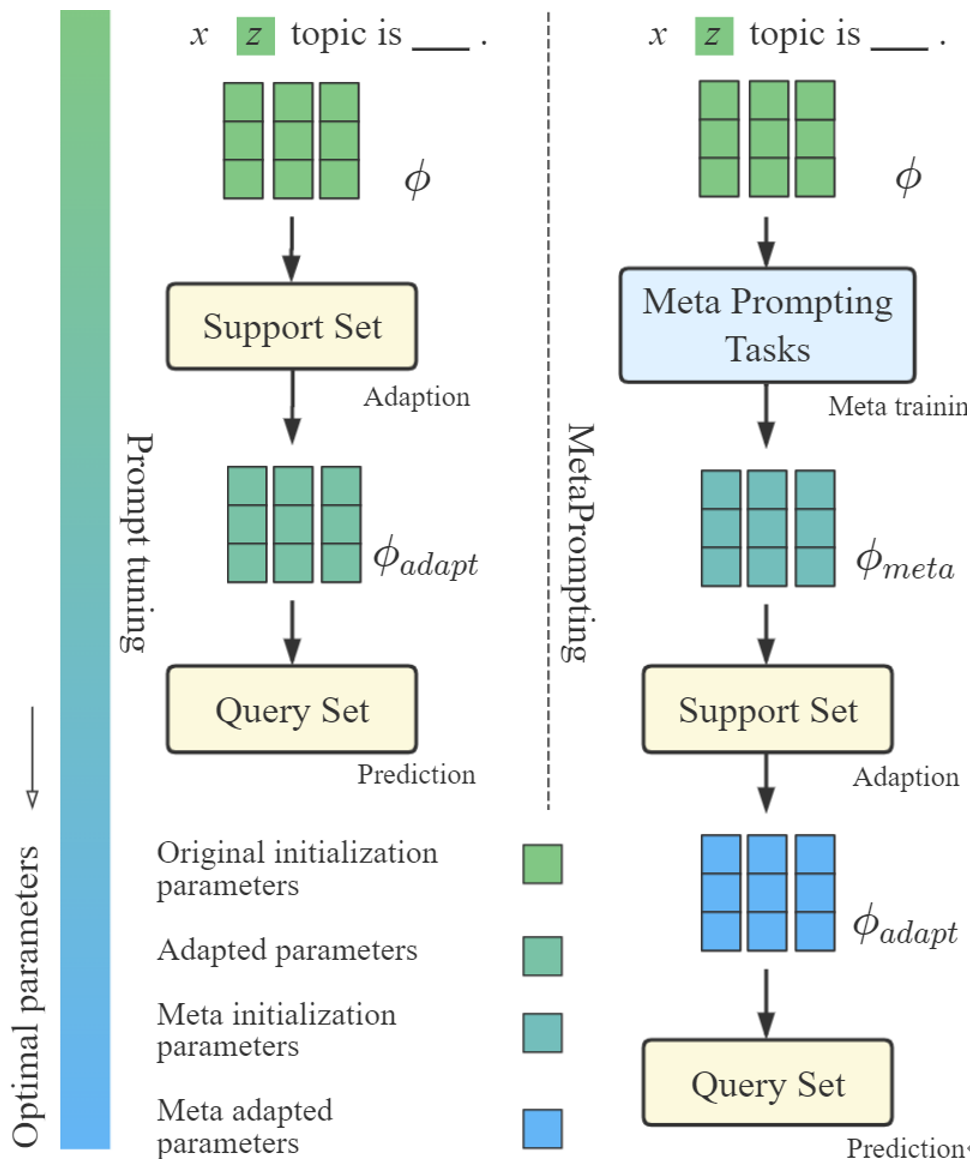

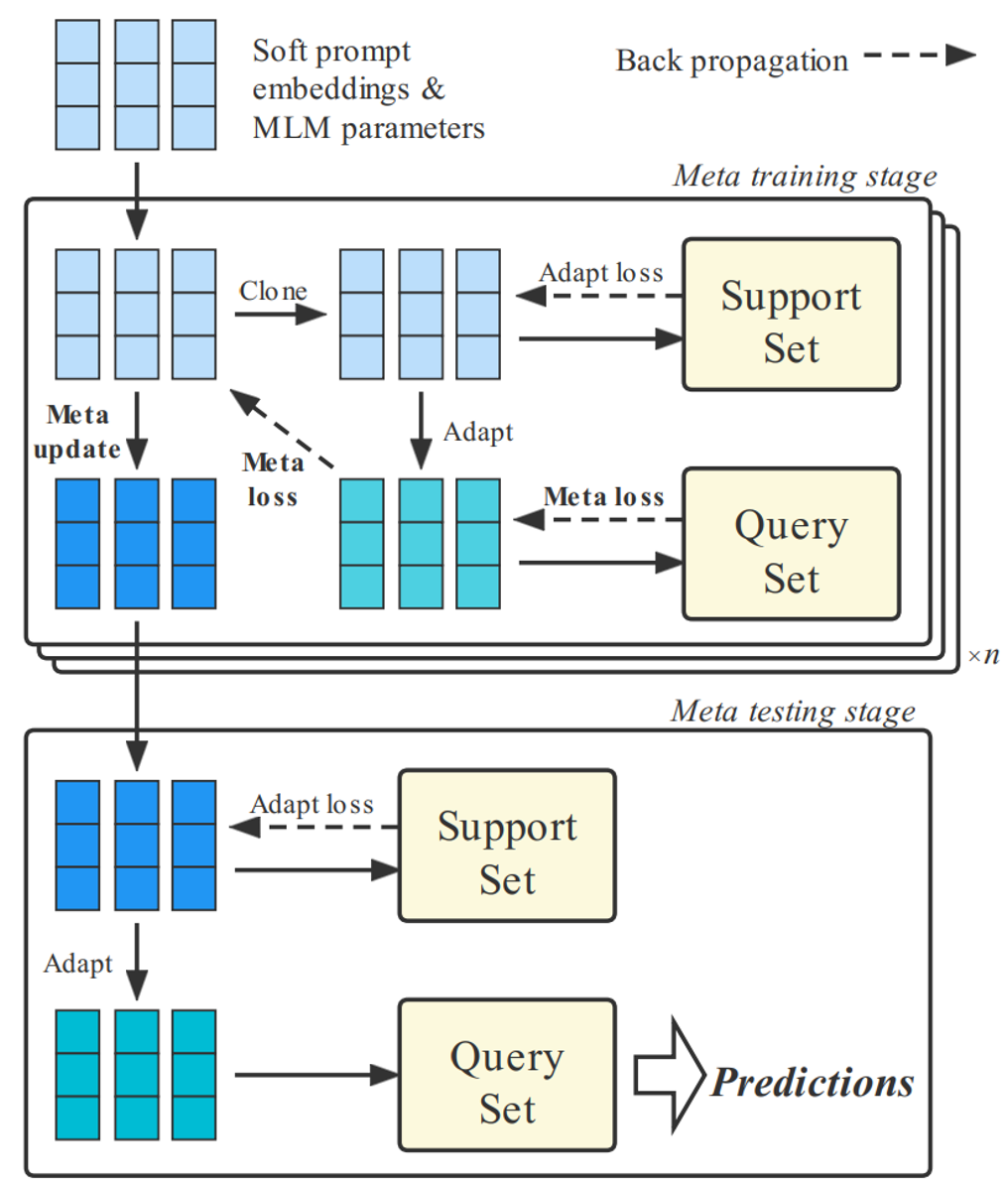

圖1 MetaPrompting幫助模型找到一個(gè)更優(yōu)參數(shù)初始化點(diǎn),以更快、更好地適應(yīng)于新的少標(biāo)注任務(wù)

為了解決上述問題,本文將目光從任務(wù)專用的soft prompt模型設(shè)計(jì)轉(zhuǎn)移到任務(wù)通用的模型參數(shù)初始化點(diǎn)搜索,以幫助模型快速適應(yīng)到不同的少標(biāo)注任務(wù)上。本文采用近年提出的基于優(yōu)化的元學(xué)習(xí)方法,例如MAML[4]、Reptile[5]等,來搜索更優(yōu)的soft prompt模型參數(shù)初始化點(diǎn),以解決模型對初始化點(diǎn)過于敏感的問題。

本文在四個(gè)常用的少標(biāo)注文本分類數(shù)據(jù)集上進(jìn)行了充分的實(shí)驗(yàn),結(jié)果表明MetaPrompting相比其他基于元學(xué)習(xí)和prompt方法的強(qiáng)基線模型取得了更好的效果,達(dá)到了新的SOTA。

2. 方法

2.1 Soft prompt方法

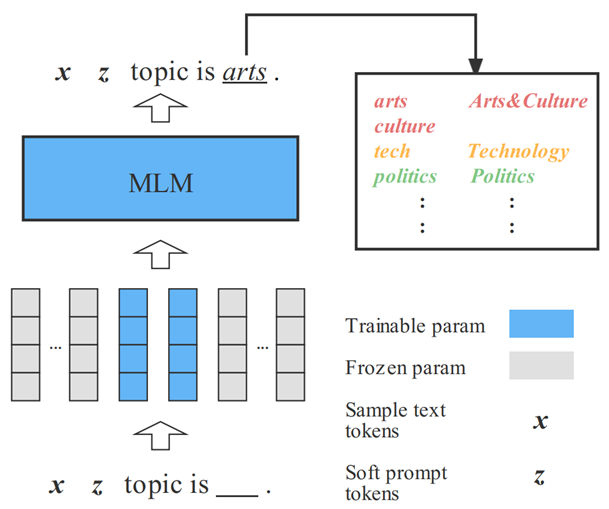

Prompt方法通過將下游任務(wù)轉(zhuǎn)化成語言模型預(yù)訓(xùn)練目標(biāo)的形式,幫助模型更好地在下游任務(wù)上發(fā)揮性能。如圖2所示,對于一個(gè)新聞文本分類任務(wù),可以通過將輸入文本填入prompt模板的方式,將該文本分類任務(wù)轉(zhuǎn)化為MLM任務(wù)形式。之后將模型在[MASK]位置填入各個(gè)詞語的概率映射到不同標(biāo)簽上,即可完成文本分類任務(wù)的處理。

Soft prompt模型中,部分prompt tokens以可訓(xùn)練embedding的形式給出,并可以和預(yù)訓(xùn)練模型的參數(shù)一起進(jìn)行優(yōu)化,在保留離散token中語義信息的同時(shí),給予模型更多的靈活性。

圖2 Soft prompt方法

2.2 將基于優(yōu)化的元學(xué)習(xí)方法應(yīng)用于soft prompt模型

少標(biāo)注任務(wù)構(gòu)建

本文使用元階段(episode)風(fēng)格的少標(biāo)注學(xué)習(xí)范式。具體而言,每一個(gè)少標(biāo)注任務(wù)包含支持集和查詢集兩個(gè)部分,支持集中每個(gè)類別所對應(yīng)標(biāo)注樣本數(shù)量極少,本文通過將模型在支持集上進(jìn)行適配,在查詢集上進(jìn)行測試的方法,衡量模型的少標(biāo)注學(xué)習(xí)性能。本文將不同標(biāo)簽對應(yīng)的樣本分別劃分成用于訓(xùn)練、驗(yàn)證和測試的少標(biāo)注任務(wù),以衡量模型從源領(lǐng)域?qū)W習(xí)通用元知識(shí)來處理目標(biāo)領(lǐng)域少標(biāo)注任務(wù)的能力。

基于元學(xué)習(xí)的soft prompt模型優(yōu)化過程

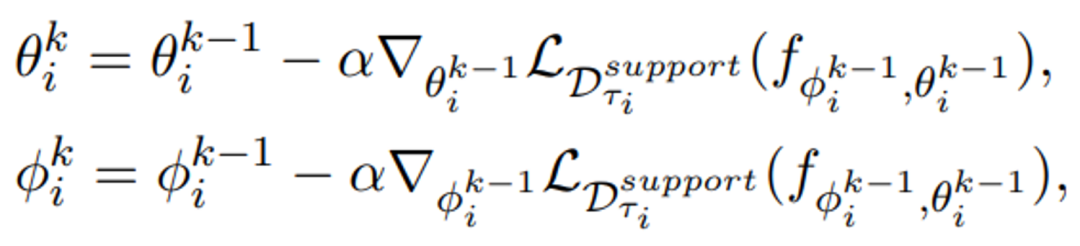

MetaPrompting的整體優(yōu)化過程如圖3所示。元訓(xùn)練階段,模型在少標(biāo)注任務(wù)的支持集上進(jìn)行試探性參數(shù)更新,并在查詢集上進(jìn)行梯度回傳。元測試階段,模型在未見過的少標(biāo)注任務(wù)上進(jìn)行適配和預(yù)測。令和分別表示預(yù)訓(xùn)練模型和soft prompt的參數(shù),在元訓(xùn)練階段,模型在一個(gè)少標(biāo)注任務(wù)支持集上進(jìn)行適配的過程如下式所示:

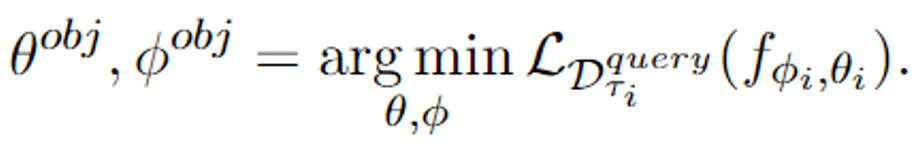

其中α是適配過程的學(xué)習(xí)率,表示模型進(jìn)行適配學(xué)習(xí)的步數(shù)。令模型在少標(biāo)注任務(wù)上適配學(xué)習(xí)之后的參數(shù)為和,可將模型在該少標(biāo)注任務(wù)上的優(yōu)化目標(biāo)描述為:

該優(yōu)化目標(biāo)模擬了模型在少標(biāo)注場景下進(jìn)行試探性參數(shù)更新,并根據(jù)試探性更新之后的情況優(yōu)化模型參數(shù)的策略。這種策略更多關(guān)注了模型在一步或多步更新之后的情況,因而可以幫助模型找到一個(gè)能快速適應(yīng)于新的少標(biāo)注任務(wù)的參數(shù)初始化點(diǎn)。

圖3 MetaPrompting模型參數(shù)更新過程

實(shí)驗(yàn)中,本文還使用了MAML++[6]中的多步梯度回傳技巧,來使得優(yōu)化過程更加穩(wěn)定,達(dá)到更好的效果。

3. 實(shí)驗(yàn)

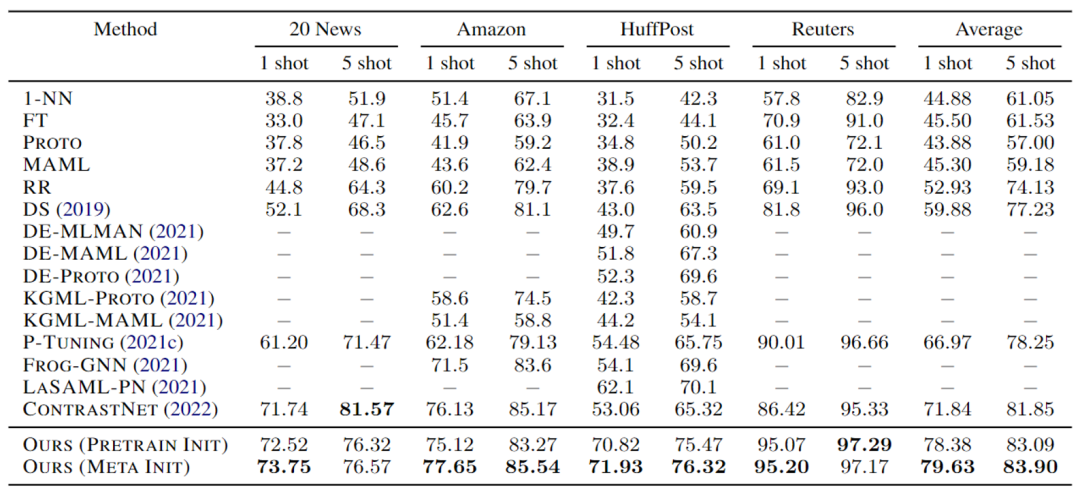

本文分別采用5way 1shot和5way 5shot的少標(biāo)注學(xué)習(xí)設(shè)定來測試模型性能。實(shí)驗(yàn)選擇了HuffPost、Amazon、Reuters和20newsgroup四個(gè)廣泛使用的文本分類數(shù)據(jù)集,結(jié)果以分類準(zhǔn)確率%給出。

實(shí)驗(yàn)結(jié)果如表1所示,表中20newsgroup數(shù)據(jù)集性能由于數(shù)據(jù)構(gòu)造問題與原文略有出入,現(xiàn)為勘誤后結(jié)果,勘誤不影響實(shí)驗(yàn)結(jié)論。由實(shí)驗(yàn)結(jié)果可見,MetaPrompting性能優(yōu)于當(dāng)前的SOTA模型ContrastNet[7]和其他基于元學(xué)習(xí)和提示學(xué)習(xí)的方法,取得了明顯的性能提升。相比于不使用元學(xué)習(xí)優(yōu)化目標(biāo)的Ours (Pretrain Init),引入元學(xué)習(xí)搜索模型參數(shù)初始化點(diǎn)的Ours (Meta Init)也得到了更好的性能,說明了元學(xué)習(xí)方法在soft prompt模型參數(shù)優(yōu)化中的有效性。

表1 MetaPrompting主實(shí)驗(yàn)結(jié)果

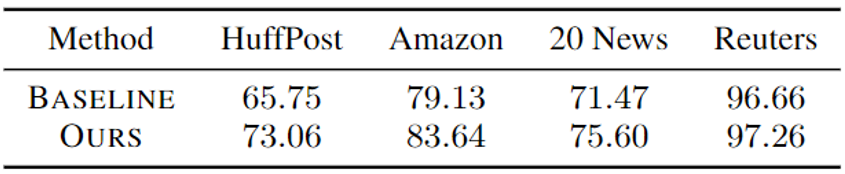

主實(shí)驗(yàn)中,為了與其他基線模型進(jìn)行公平的對比,將soft prompt參數(shù)和預(yù)訓(xùn)練模型參數(shù)一起進(jìn)行了優(yōu)化。為了更好地說明MetaPrompting針對soft prompt參數(shù)初始化的作用,本文還參數(shù)進(jìn)行了固定預(yù)訓(xùn)練模型的實(shí)驗(yàn)。實(shí)驗(yàn)結(jié)果如表2所示,相比于參數(shù)隨機(jī)初始化的soft prompt模型,MetaPrompting取得了明顯的性能提升。

表2 MetaPrompting在固定預(yù)訓(xùn)練模型參數(shù)時(shí)的性能

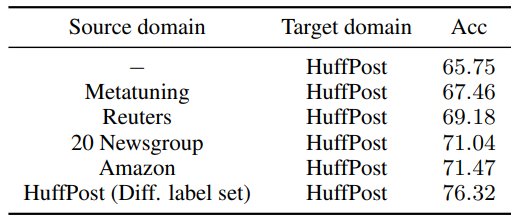

現(xiàn)實(shí)應(yīng)用場景中,往往難以得到內(nèi)容、形式十分相近的源領(lǐng)域數(shù)據(jù)。因此本文還對MetaPrompting在分布外數(shù)據(jù)上的性能進(jìn)行了測試。實(shí)驗(yàn)結(jié)果如表3所示,即使源領(lǐng)域的數(shù)據(jù)內(nèi)容、形式上有較大的差異,MetaPrompting仍然可以學(xué)習(xí)到任務(wù)通用的元知識(shí),來輔助在目標(biāo)領(lǐng)域少標(biāo)注任務(wù)上的學(xué)習(xí)。

表3 MetaPrompting在不同內(nèi)容、形式的源領(lǐng)域數(shù)據(jù)上進(jìn)行元學(xué)習(xí)的性能

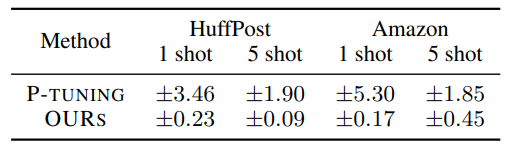

本文還對MetaPrompting對于不同prompt模板的魯棒性進(jìn)行了測試。如表4所示,相比于隨機(jī)初始化的soft prompt模型,MetaPrompting尋找到的參數(shù)初始化點(diǎn)在不同prompt模板下性能方差更小,魯棒性更強(qiáng)。

表4 MetaPrompting在不同prompt模板下性能的方差

4. 總結(jié)

本文提出了MetaPrompting,將基于優(yōu)化的元學(xué)習(xí)方法推廣到soft prompt模型中,來處理少標(biāo)注文本任務(wù)。MetaPrompting利用源領(lǐng)域數(shù)據(jù)進(jìn)行元學(xué)習(xí),搜索能夠更快、更好地適應(yīng)于新的少標(biāo)注人物的模型參數(shù)初始化點(diǎn)。在4個(gè)少標(biāo)注文本分類數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,MetaPrompting相比于樸素的soft prompt模型以及其他基于元學(xué)習(xí)的基線模型取得了更好的效果,達(dá)到了新的SOTA性能。

審核編輯 :李倩

-

模型

+關(guān)注

關(guān)注

1文章

3517瀏覽量

50383 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1224瀏覽量

25434 -

nlp

+關(guān)注

關(guān)注

1文章

490瀏覽量

22613

原文標(biāo)題:參考文獻(xiàn)

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

第一章 W55MH32 高性能以太網(wǎng)單片機(jī)的學(xué)習(xí)方法概述

使用MATLAB進(jìn)行無監(jiān)督學(xué)習(xí)

18個(gè)常用的強(qiáng)化學(xué)習(xí)算法整理:從基礎(chǔ)方法到高級(jí)模型的理論技術(shù)與代碼實(shí)現(xiàn)

一種無刷直流電機(jī)霍耳信號(hào)與定子繞組關(guān)系自學(xué)習(xí)方法

VirtualLab Fusion應(yīng)用:非近軸衍射分束器的設(shè)計(jì)與優(yōu)化

DeepSeek與Kimi揭示o1秘密,思維鏈學(xué)習(xí)方法顯成效

如何優(yōu)化BP神經(jīng)網(wǎng)絡(luò)的學(xué)習(xí)率

焊接技術(shù)流程優(yōu)化方法

傳統(tǒng)機(jī)器學(xué)習(xí)方法和應(yīng)用指導(dǎo)

什么是機(jī)器學(xué)習(xí)?通過機(jī)器學(xué)習(xí)方法能解決哪些問題?

基于優(yōu)化的元學(xué)習(xí)方法

基于優(yōu)化的元學(xué)習(xí)方法

評論