這個工作來自于浙江大學(xué)和DAMO academy。在點(diǎn)云配準(zhǔn)領(lǐng)域,盡管已經(jīng)有很多方法被提出來,但是無論是傳統(tǒng)方法,還是近年來蓬勃發(fā)展的基于深度學(xué)習(xí)的三維點(diǎn)云配置方法,其實(shí)在真正應(yīng)用到真實(shí)的LiDAR掃描點(diǎn)云幀時都會出現(xiàn)一些問題。造成這種困窘的一個主要的原因在于LiDAR掃描到的點(diǎn)云分布極不均勻。

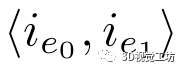

具體而言,相較于RGBD相機(jī),LiDAR的有效掃描深度要大很多。隨著深度的增大,其激光發(fā)射出去的扇面將會變得稀疏。因此,即使是掃描同一目標(biāo)或場景的點(diǎn)云幀之間,其尺度并不一致。導(dǎo)致想要研究的關(guān)鍵點(diǎn)周圍的鄰域點(diǎn)分布也存在較大不同,難以通過這些3D點(diǎn)的特征描述關(guān)聯(lián)起點(diǎn)云幀。

這個問題一直以來都十分棘手。這個工作獨(dú)辟蹊徑,提出對于這種點(diǎn)云數(shù)據(jù),不再通過3D點(diǎn)來構(gòu)建關(guān)聯(lián)以實(shí)現(xiàn)點(diǎn)云配準(zhǔn),而是研究點(diǎn)云數(shù)據(jù)中的高層次的幾何原語。這種做法直觀來說是有道理的,因?yàn)檫@些高層次的幾何原語通常會有較大的支撐點(diǎn)集,換句話說,其對于點(diǎn)云掃描和采樣具有較大的魯棒性,通常不會因?yàn)槟硞€點(diǎn)沒有被記錄而影響相應(yīng)幾何原語的提取。

同時,幾何原語通常具有更具體的特征和幾何結(jié)構(gòu),例如一條直線、一個平面等,其更容易構(gòu)建不同幀間的關(guān)聯(lián),避免誤匹配。但是,這種研究思路通常難度較大,原因在于缺乏足夠的有標(biāo)簽的數(shù)據(jù)集。在這種情況下,這個工作顯得極其重要,它不僅僅提供了一個數(shù)據(jù)集自動標(biāo)注模型,同樣也是少數(shù)真正開始探索幾何原語用于點(diǎn)云配準(zhǔn)任務(wù)的先河性的工作。

摘要:交通桿和建筑物邊緣是城市道路上經(jīng)常可以觀察到的物體,為各種計(jì)算機(jī)視覺任務(wù)傳達(dá)了可靠的提示。為了重復(fù)提取它們作為特征并在離散的LiDAR幀之間進(jìn)行關(guān)聯(lián)以進(jìn)行配準(zhǔn),我們提出了第一個基于學(xué)習(xí)的LiDAR點(diǎn)云3D線特征分割和描述模型。

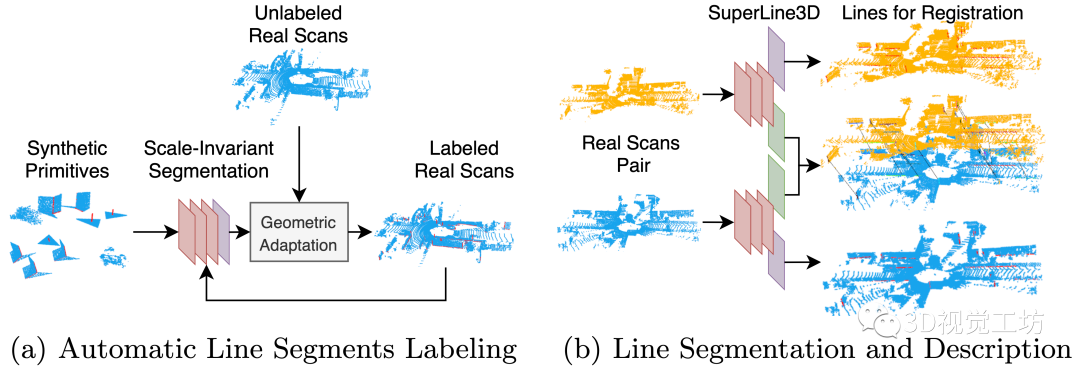

為了在沒有耗時和繁瑣的數(shù)據(jù)標(biāo)記過程的情況下訓(xùn)練我們的模型,我們首先為目標(biāo)線的基本外觀生成合成原語,并構(gòu)建一個迭代線自動標(biāo)注過程以逐漸調(diào)整真實(shí)LiDAR掃描的線標(biāo)簽。我們的分割模型可以在任意尺度擾動下提取線,并且我們使用共享的EdgeConv編碼器層來聯(lián)合訓(xùn)練兩個分割和描述符提取頭。

基于該模型,我們可以在沒有初始變換提示的情況下構(gòu)建一個用于點(diǎn)云配準(zhǔn)的高可用性全局配準(zhǔn)模塊。實(shí)驗(yàn)表明,我們的基于線的配準(zhǔn)方法與最先進(jìn)的基于點(diǎn)的方法相比具有很強(qiáng)的競爭力。

主要貢獻(xiàn):

1.據(jù)我們所知,我們提出了第一個基于學(xué)習(xí)的激光雷達(dá)掃描線分割和描述網(wǎng)絡(luò),為全局配準(zhǔn)提出了一個適用的特征類別。

2.我們提出了一種用于點(diǎn)云線標(biāo)注方法,該方法可以將從合成數(shù)據(jù)中學(xué)習(xí)的模型遷移到真實(shí)的LiDAR掃描點(diǎn)云以進(jìn)行自動標(biāo)注。

3.我們探索了點(diǎn)云特征的尺度不變性,并通過消除Sim(3)變換中的尺度因子,為改善點(diǎn)云上基于學(xué)習(xí)的任務(wù)在尺度擾動下的泛化提供了可行的思路

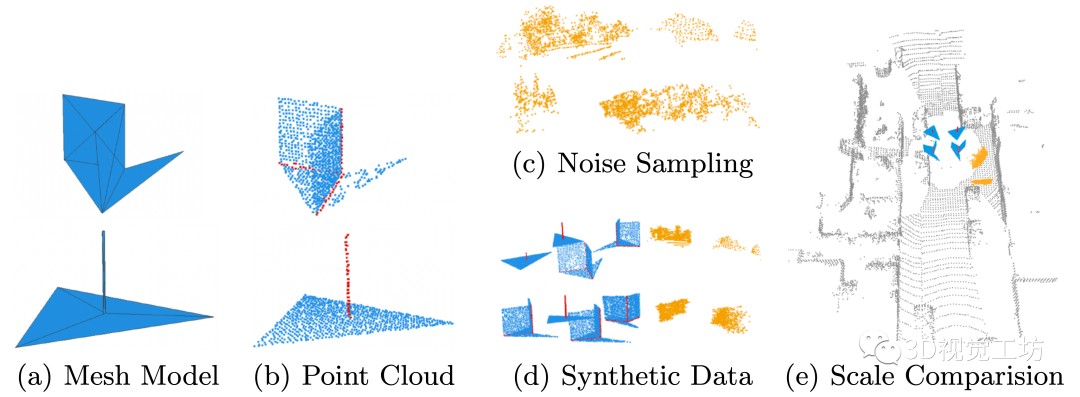

Fig1:整體網(wǎng)絡(luò)框架。a):我們在合成數(shù)據(jù)上訓(xùn)練尺度不變的分割,并在多次幾何自適應(yīng)迭代后得到精確的線標(biāo)簽。b):我們同時在標(biāo)注的LiDAR掃描點(diǎn)云上訓(xùn)練分割和描述符提取網(wǎng)絡(luò),其中紅色、紫色和綠色層分別代表編碼器、分割網(wǎng)絡(luò)頭和描述符提取網(wǎng)絡(luò)頭。

方法介紹: 考慮到缺乏可用的LiDAR掃描點(diǎn)云的有標(biāo)簽線數(shù)據(jù)集,我們遵循SuperPoint的自監(jiān)督思想來訓(xùn)練我們的線分割模型,首先構(gòu)建一個簡單的合成數(shù)據(jù)來初始化一個基礎(chǔ)模型,然后使用幾何自適應(yīng)的自動標(biāo)記真實(shí)LiDAR掃描點(diǎn)云進(jìn)行迭代來調(diào)整模型。之后我們收集不同LiDAR掃描點(diǎn)云幀之間的線對應(yīng)關(guān)系,并以端到端的方法聯(lián)合訓(xùn)練線分割和描述符提取網(wǎng)絡(luò)。

一、線分割模型

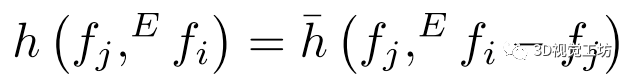

1)合成數(shù)據(jù)生成.

兩種類型的可靠線段可以檢測:

1)平面之間的交線,以及2)交通桿。因此,我們選擇使用圖2(a)所示的以下兩個網(wǎng)格原語分別模擬它們的局部外觀。這兩個網(wǎng)格模型首先被均勻采樣成4000個點(diǎn),如圖 2(b) 所示,每個點(diǎn)添加5%的相對3自由度位置擾動。然后,為了模擬附近可能的背景點(diǎn),我們隨機(jī)裁剪了40 個基本原語,每個原語包含1000個來自真實(shí)掃描點(diǎn)云的點(diǎn),并將它們放在一起組成最終的合成數(shù)據(jù)。我們總共生成了5000個合成點(diǎn)云,每個點(diǎn)云有5000個點(diǎn)。

?2)尺度不變線分割.

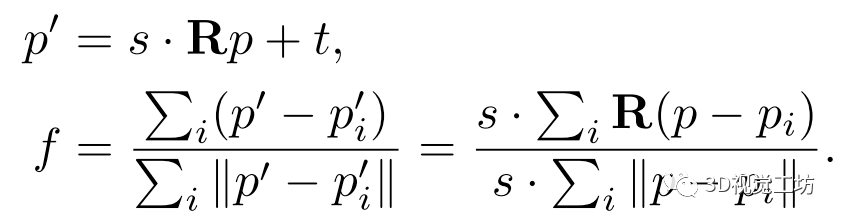

我們將線檢測視為點(diǎn)云分割問題,主要挑戰(zhàn)是原語尺度縮放問題:在真實(shí)的LiDAR點(diǎn)云幀中,點(diǎn)的密度隨著掃描距離的增加而降低,而當(dāng)目標(biāo)特征遠(yuǎn)離傳感器時,體素網(wǎng)格下采樣不能完全歸一化密度。此外,我們的合成數(shù)據(jù)生成也沒有考慮線的尺度(如圖 2(e)放在一起時所示)。如果不處理這個問題,當(dāng)訓(xùn)練和測試數(shù)據(jù)在不同的尺度上時,模型將不會產(chǎn)生合理的預(yù)測。 我們的網(wǎng)絡(luò)通過消除Sim(3)變換的尺度因子s和使用相對距離來解決這個問題,如:

在上式中,我們搜索點(diǎn)p的k=20個最近點(diǎn) ,并計(jì)算尺度不變的局部特征f(p與其近鄰點(diǎn)之間的曼哈頓距離與歐幾里得距離之比)。這種特征定義的損失在于f不能反映原點(diǎn)在歐幾里德空間中的位置,因此此變換存在信息損失。 3)模型結(jié)構(gòu). 我們選擇DGCNN作為我們的主干,因?yàn)樗苯訉c(diǎn)及其最近的近鄰點(diǎn)進(jìn)行編碼而無需復(fù)雜的操作。下式展示了其被稱為EdgeConv的局部特征編碼函數(shù),其中

,并計(jì)算尺度不變的局部特征f(p與其近鄰點(diǎn)之間的曼哈頓距離與歐幾里得距離之比)。這種特征定義的損失在于f不能反映原點(diǎn)在歐幾里德空間中的位置,因此此變換存在信息損失。 3)模型結(jié)構(gòu). 我們選擇DGCNN作為我們的主干,因?yàn)樗苯訉c(diǎn)及其最近的近鄰點(diǎn)進(jìn)行編碼而無需復(fù)雜的操作。下式展示了其被稱為EdgeConv的局部特征編碼函數(shù),其中 是第j個特征,

是第j個特征, 是特征空間 S中

是特征空間 S中  的鄰居, h是學(xué)習(xí)的模型。

的鄰居, h是學(xué)習(xí)的模型。  在第一個EdgeConv層中,x表示歐氏空間中的點(diǎn)坐標(biāo)。在我們的實(shí)現(xiàn)中,我們收集每個點(diǎn)的k=20個最近鄰點(diǎn)并計(jì)算尺度不變特征f。然后我們把第一個EdgeConv層變成:

在第一個EdgeConv層中,x表示歐氏空間中的點(diǎn)坐標(biāo)。在我們的實(shí)現(xiàn)中,我們收集每個點(diǎn)的k=20個最近鄰點(diǎn)并計(jì)算尺度不變特征f。然后我們把第一個EdgeConv層變成:  它用尺度不變的特征f代替了歐氏空間中的坐標(biāo),但

它用尺度不變的特征f代替了歐氏空間中的坐標(biāo),但 仍然是歐氏空間中第i個鄰居點(diǎn)

仍然是歐氏空間中第i個鄰居點(diǎn) 的特征,而不是

的特征,而不是 在特征空間中的鄰居。由于在生成尺度不變特征時,原始?xì)W氏空間中的部分信息已經(jīng)丟失,保留原始?xì)W氏空間中的鄰域關(guān)系可以減少進(jìn)一步的信息丟失。

在特征空間中的鄰居。由于在生成尺度不變特征時,原始?xì)W氏空間中的部分信息已經(jīng)丟失,保留原始?xì)W氏空間中的鄰域關(guān)系可以減少進(jìn)一步的信息丟失。

Fig2:合成數(shù)據(jù)生成步驟。我們通過對原始網(wǎng)格模型進(jìn)行采樣并將真實(shí)掃描散點(diǎn)作為噪聲來增強(qiáng)生成合成數(shù)據(jù)。

4)自動線標(biāo)注.

當(dāng)前沒有可用的 LiDAR點(diǎn)云有標(biāo)簽線數(shù)據(jù)集,并且難以對點(diǎn)云進(jìn)行手動標(biāo)記。因此,我們構(gòu)建了一個自動線標(biāo)注框架(圖 3)。受SuperPoint啟發(fā),我們對LiDAR掃描點(diǎn)云執(zhí)行幾何自適應(yīng)。首先,我們僅在合成數(shù)據(jù)上訓(xùn)練一個尺度不變的分割模型,并將XOY中20m和偏航 360°的均勻分布的2D變換應(yīng)用于LiDAR掃描點(diǎn)云。

然后,我們使用經(jīng)過訓(xùn)練的模型來預(yù)測擾動數(shù)據(jù)上的標(biāo)簽,聚合來自所有擾動幀的結(jié)果,并將超過80%預(yù)測屬于線的點(diǎn)作為候選點(diǎn)。為了將點(diǎn)聚類成線,我們使用區(qū)域增長算法。點(diǎn)之間的連通性通過0.5m搜索半徑的KD-Tree定義。我們使用標(biāo)注點(diǎn)作為種子,生長到附近的標(biāo)注點(diǎn),并擬合線。

一旦提取了此類線,我們將繼續(xù)在獲得的有標(biāo)簽LiDAR掃描點(diǎn)云上調(diào)整分割模型。我們重復(fù)幾何自適應(yīng)3次以在KITTI里程計(jì)序列上生成12989個自動標(biāo)注的 LiDAR幀。

Fig3:自動標(biāo)注框架。我們使用幾何自適應(yīng)和線擬合來減少網(wǎng)絡(luò)預(yù)測噪聲,并通過迭代訓(xùn)練提高真實(shí)LiDAR掃描點(diǎn)云的模型精度。

二、聯(lián)系訓(xùn)練線分割和描述符提取網(wǎng)絡(luò)

1)線描述符的定義.

不同于只需要線段兩個端點(diǎn)的幾何定義,每條線的描述符應(yīng)通過其所有所屬點(diǎn)傳達(dá)局部外觀,因?yàn)橛^察到的端點(diǎn)可能由于可能的遮擋而在幀之間變化。因此,我們將描述符定義為其所有所屬點(diǎn)的平均值。

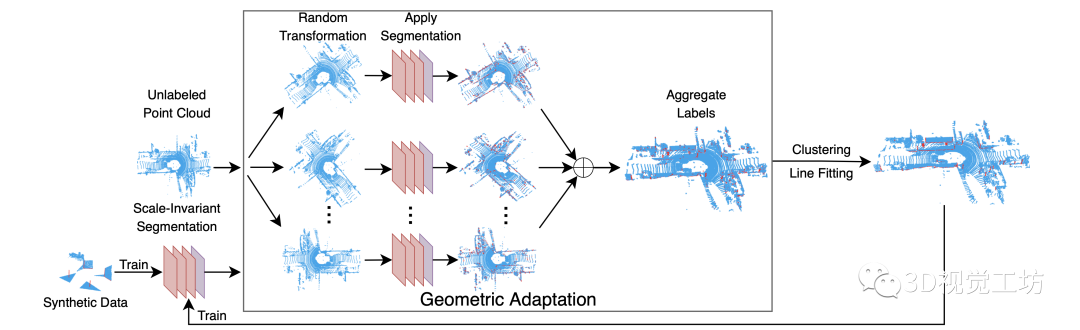

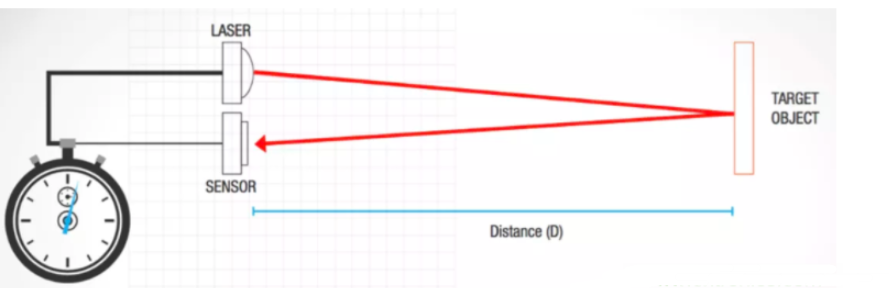

Fig4: 網(wǎng)絡(luò)架構(gòu)。該網(wǎng)絡(luò)使用EdgeConv模塊來提取特征。分割網(wǎng)絡(luò)頭和描述符提取頭分別用于預(yù)測每個點(diǎn)的標(biāo)簽和描述符。

2)網(wǎng)絡(luò)結(jié)構(gòu).

我們的網(wǎng)絡(luò)結(jié)構(gòu)(圖4)由堆疊的三個EdgeConv層組成,用于特征編碼,兩個解碼器分別用于線分割和描述。每個EdgeConv層輸出一個 張量,在max-pooling層之后用于3層的分割和描述。我們使用ReLU進(jìn)行激活。分割網(wǎng)絡(luò)頭將特征向量卷積后變成一個

張量,在max-pooling層之后用于3層的分割和描述。我們使用ReLU進(jìn)行激活。分割網(wǎng)絡(luò)頭將特征向量卷積后變成一個 大小的張量(N為輸入點(diǎn)數(shù)),然后通過softmax層得到每個點(diǎn)的布爾坐標(biāo),預(yù)測是否屬于一條線。描述符提取網(wǎng)絡(luò)頭輸出一個大小為

大小的張量(N為輸入點(diǎn)數(shù)),然后通過softmax層得到每個點(diǎn)的布爾坐標(biāo),預(yù)測是否屬于一條線。描述符提取網(wǎng)絡(luò)頭輸出一個大小為 的張量,然后進(jìn)行L2歸一化得到一個d維的描述符。 3)損失函數(shù).我們的分割損失

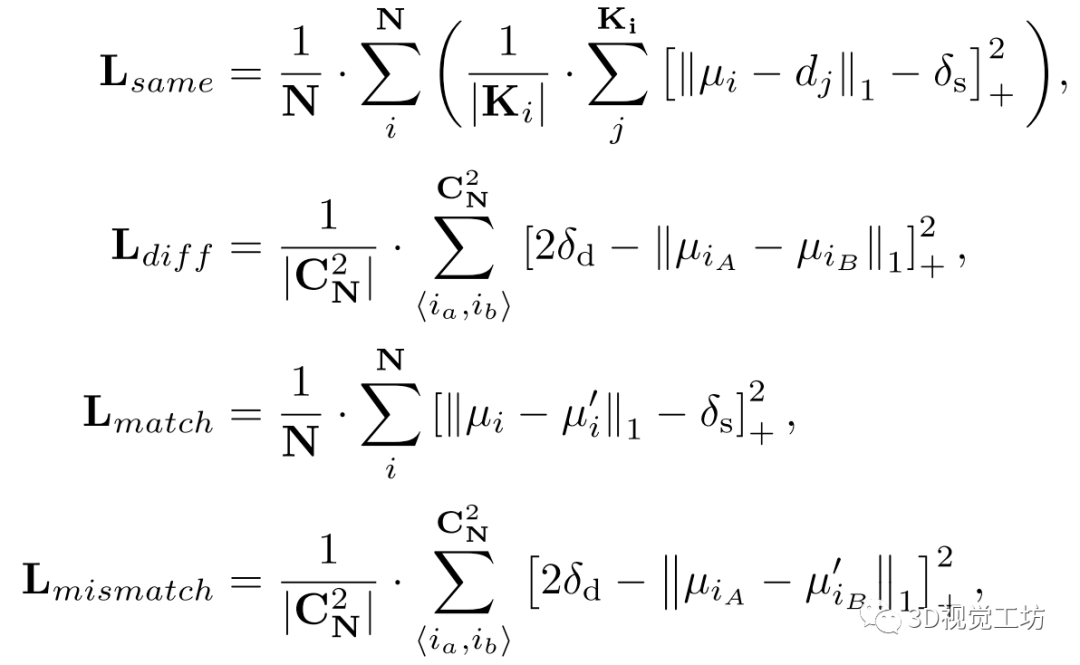

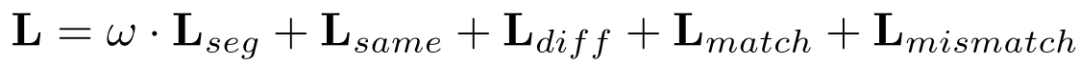

的張量,然后進(jìn)行L2歸一化得到一個d維的描述符。 3)損失函數(shù).我們的分割損失 是一個標(biāo)準(zhǔn)的交叉熵?fù)p失,對于描述符損失,我們首先使用線段標(biāo)簽得到每條線段的均值描述符u,然后使用

是一個標(biāo)準(zhǔn)的交叉熵?fù)p失,對于描述符損失,我們首先使用線段標(biāo)簽得到每條線段的均值描述符u,然后使用 將點(diǎn)描述符拉向u。

將點(diǎn)描述符拉向u。 的提出是為了讓不同行的描述符相互排斥。此外,對于點(diǎn)云對,我們計(jì)算匹配損失

的提出是為了讓不同行的描述符相互排斥。此外,對于點(diǎn)云對,我們計(jì)算匹配損失 和非匹配線之間的損失

和非匹配線之間的損失 。每一個損失項(xiàng)都可以寫成如下形式:

。每一個損失項(xiàng)都可以寫成如下形式:

其中N是檢測到的線數(shù), 代表兩條線的所有對。i和j是兩個迭代器,分別用于直線和直線上的點(diǎn)。

代表兩條線的所有對。i和j是兩個迭代器,分別用于直線和直線上的點(diǎn)。 是一條線的平均描述符,

是一條線的平均描述符, 是其相關(guān)點(diǎn)j的描述符。

是其相關(guān)點(diǎn)j的描述符。 和

和 是另一個關(guān)聯(lián)點(diǎn)云的平均描述符,

是另一個關(guān)聯(lián)點(diǎn)云的平均描述符, 和

和 分別為正負(fù)邊緣。

分別為正負(fù)邊緣。 , 且表示L1距離。最后,我們使用

, 且表示L1距離。最后,我們使用 來平衡最終的損失:

來平衡最終的損失:

3)基于線的配準(zhǔn).

我們的網(wǎng)絡(luò)為每個點(diǎn)輸出標(biāo)簽和描述符。我們首先提取線,然后我們執(zhí)行描述符匹配以獲得行對應(yīng)。匹配描述符的閾值設(shè)置為0.1。用于將源云 注冊到目標(biāo)點(diǎn)云的變換通過最小化所有線匹配代價(jià)

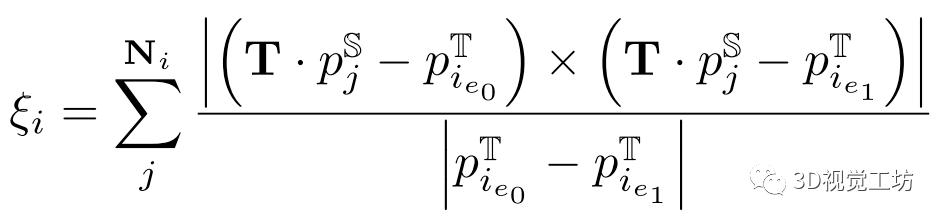

注冊到目標(biāo)點(diǎn)云的變換通過最小化所有線匹配代價(jià) 中的點(diǎn)到線距離進(jìn)行優(yōu)化:

中的點(diǎn)到線距離進(jìn)行優(yōu)化:  其中

其中 是源點(diǎn)云中的線上的點(diǎn),

是源點(diǎn)云中的線上的點(diǎn), 和

和 是線i的匹配線

是線i的匹配線 的端點(diǎn)。

的端點(diǎn)。

審核編輯:劉清

-

編碼器

+關(guān)注

關(guān)注

45文章

3822瀏覽量

138381 -

激光雷達(dá)

+關(guān)注

關(guān)注

971文章

4244瀏覽量

193112 -

RGBD數(shù)據(jù)

+關(guān)注

關(guān)注

0文章

3瀏覽量

1090

原文標(biāo)題:SuperLine3D:從3D點(diǎn)到3D線

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

LiDAR如何構(gòu)建3D點(diǎn)云?如何利用LiDAR提供深度信息

基于3D點(diǎn)云的多任務(wù)模型在板端實(shí)現(xiàn)高效部署

基于深度學(xué)習(xí)的方法在處理3D點(diǎn)云進(jìn)行缺陷分類應(yīng)用

浩辰3D軟件中如何創(chuàng)建槽特征?3D模型設(shè)計(jì)教程!

3D軟件中如何應(yīng)用文本特征?3D文本特征應(yīng)用技巧

點(diǎn)云問題的介紹及3D點(diǎn)云技術(shù)在VR中的應(yīng)用

3D模型的加權(quán)特征點(diǎn)調(diào)和表達(dá)

如何在LiDAR點(diǎn)云上進(jìn)行3D對象檢測

何為3D點(diǎn)云語義分割

如何直接建立2D圖像中的像素和3D點(diǎn)云中的點(diǎn)之間的對應(yīng)關(guān)系

基于深度學(xué)習(xí)的3D分割綜述(RGB-D/點(diǎn)云/體素/多目)

NeuralLift-360:將野外的2D照片提升為3D物體

基于深度學(xué)習(xí)的點(diǎn)云分割的方法介紹

基于深度學(xué)習(xí)的3D點(diǎn)云實(shí)例分割方法

一個基于學(xué)習(xí)的LiDAR點(diǎn)云3D線特征分割和描述模型

一個基于學(xué)習(xí)的LiDAR點(diǎn)云3D線特征分割和描述模型

評論