近年來(lái),基于大數(shù)據(jù)預(yù)訓(xùn)練的多模態(tài)基礎(chǔ)模型 (Foundation Model) 在自然語(yǔ)言理解和視覺(jué)感知方面展現(xiàn)出了前所未有的進(jìn)展,在各領(lǐng)域中受到了廣泛關(guān)注。在醫(yī)療領(lǐng)域中,由于其任務(wù)對(duì)領(lǐng)域?qū)I(yè)知識(shí)的高度依賴和其本身細(xì)粒度的特征,通用基礎(chǔ)模型在醫(yī)療領(lǐng)域的應(yīng)用十分有限。因此,如何將醫(yī)療知識(shí)注入模型,提高基礎(chǔ)模型在具體診療任務(wù)上的準(zhǔn)確度與可靠性,是當(dāng)前醫(yī)學(xué)人工智能研究領(lǐng)域的熱點(diǎn)。 在此背景之下,上海交通大學(xué)與上海人工智能實(shí)驗(yàn)室聯(lián)合團(tuán)隊(duì)探索了基于醫(yī)學(xué)知識(shí)增強(qiáng)的基礎(chǔ)模型預(yù)訓(xùn)練方法,發(fā)布了首個(gè)胸部 X-ray 的基礎(chǔ)模型,即 KAD(Knowledge-enhanced Auto Diagnosis Model)。該模型通過(guò)在大規(guī)模醫(yī)學(xué)影像與放射報(bào)告數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,通過(guò)文本編碼器對(duì)高質(zhì)量醫(yī)療知識(shí)圖譜進(jìn)行隱空間嵌入,利用視覺(jué) - 語(yǔ)言模型聯(lián)合訓(xùn)練實(shí)現(xiàn)了知識(shí)增強(qiáng)的表征學(xué)習(xí)。在不需要任何額外標(biāo)注情況下,KAD 模型即可直接應(yīng)用于任意胸片相關(guān)疾病的診斷,為開(kāi)發(fā)人工智能輔助診斷的基礎(chǔ)模型提供了一條切實(shí)可行的技術(shù)路線。

KAD 具有零樣本(zero-shot)診斷能力,無(wú)需下游任務(wù)微調(diào),展現(xiàn)出與專業(yè)醫(yī)生相當(dāng)?shù)木龋?/p>

KAD 具有開(kāi)放疾病診斷(open-set diagosis)能力,可應(yīng)用于胸片相關(guān)的任意疾病診斷;

KAD 具有疾病定位能力,為模型預(yù)測(cè)提供可解釋性。

研究論文《Knowledge-enhanced Visual-Language Pre-training on Chest Radiology Images》已被知名國(guó)際期刊《自然 - 通訊》(Nature Communications)接收。論文作者為張小嫚、吳超逸、張婭教授,謝偉迪教授(通訊),王延峰教授(通訊)。

論文鏈接:https://arxiv.org/pdf/2302.14042.pdf

代碼模型鏈接:https://github.com/xiaoman-zhang/KAD

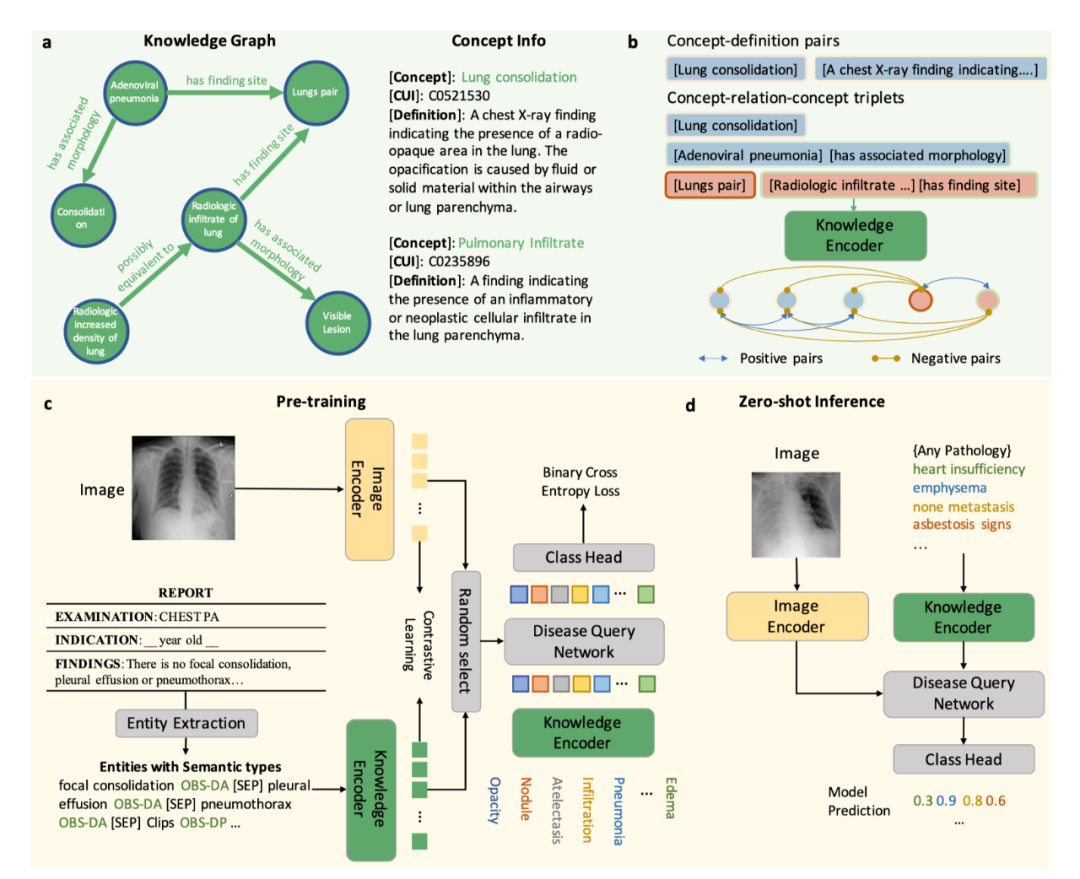

模型介紹 KAD 模型的核心是利用醫(yī)學(xué)先驗(yàn)知識(shí)引導(dǎo)基礎(chǔ)模型預(yù)訓(xùn)練,第一階段,該研究利用醫(yī)學(xué)知識(shí)圖譜訓(xùn)練一個(gè)文本知識(shí)編碼器,對(duì)醫(yī)學(xué)知識(shí)庫(kù)在隱空間進(jìn)行建模;第二階段,該研究提出放射報(bào)告中提取醫(yī)學(xué)實(shí)體和實(shí)體間關(guān)系,借助已訓(xùn)練的知識(shí)編碼器來(lái)指導(dǎo)圖像與文本對(duì)的視覺(jué)表征學(xué)習(xí),最終實(shí)現(xiàn)了知識(shí)增強(qiáng)的模型預(yù)訓(xùn)練。具體流程如圖 1 所示。

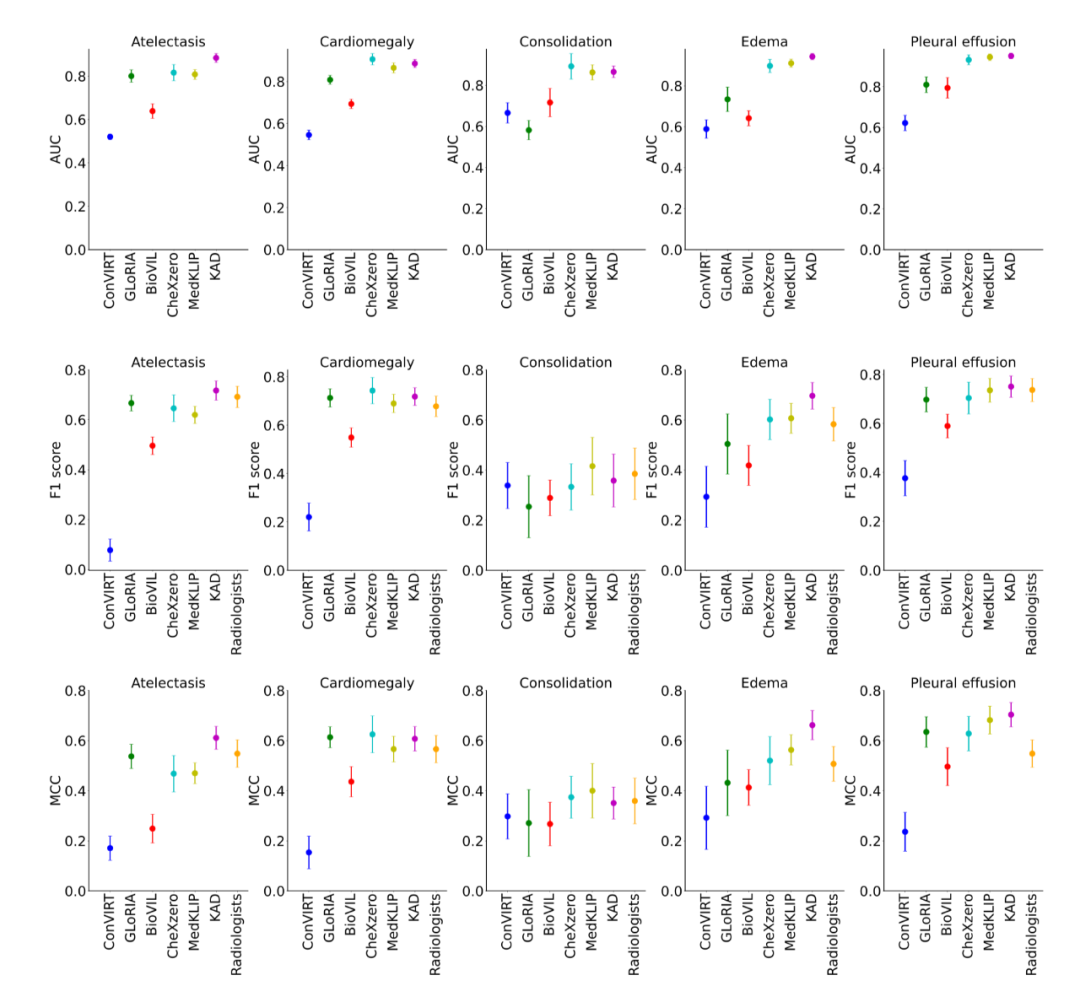

圖 1:KAD 的模型架構(gòu) 知識(shí)編碼器 知識(shí)編碼器的核心是在特征空間隱式地建立醫(yī)學(xué)實(shí)體之間的關(guān)系。具體來(lái)說(shuō),該研究將統(tǒng)一醫(yī)學(xué)語(yǔ)言系統(tǒng) (Unified Medical Language System,UMLS) 作為醫(yī)學(xué)知識(shí)庫(kù),如圖 1a 所示;通過(guò)對(duì)比學(xué)習(xí)訓(xùn)練文本編碼器,將醫(yī)學(xué)知識(shí)注入模型,如圖 1b 所示。 知識(shí)引導(dǎo)的視覺(jué)表征學(xué)習(xí) 知識(shí)編碼器訓(xùn)練完成后,模型在文本特征空間已經(jīng)建立了醫(yī)學(xué)實(shí)體之間的關(guān)系,即可用于引導(dǎo)視覺(jué)表征學(xué)習(xí)。具體來(lái)說(shuō),如圖 1c 所示,基于胸片 - 報(bào)告對(duì)的數(shù)據(jù),首先進(jìn)行實(shí)體提取,得到常見(jiàn)疾病的集合及其標(biāo)簽,該研究嘗試了三種方法:基于 UMLS 啟發(fā)式規(guī)則的實(shí)體提取、基于報(bào)告結(jié)構(gòu)化工具 RadGraph 的實(shí)體提取以及基于 ChatGPT 的實(shí)體提取;在模型層面,該研究提出了基于 Transformer 架構(gòu)的疾病查詢網(wǎng)絡(luò)(Disease Query Networks),以疾病名稱作為查詢 (query) 輸入,關(guān)注 (attend) 視覺(jué)特征以獲得模型預(yù)測(cè)結(jié)果;在模型訓(xùn)練過(guò)程中,該研究聯(lián)合優(yōu)化圖像 - 文本對(duì)比學(xué)習(xí)和疾病查詢網(wǎng)絡(luò)預(yù)測(cè)的多標(biāo)簽分類損失。 經(jīng)過(guò)上述兩階段的訓(xùn)練,在模型使用階段,如圖 1d 所示,給定一張圖像以及查詢的疾病名稱,分別輸入圖像編碼器和知識(shí)編碼器,經(jīng)過(guò)疾病查詢網(wǎng)絡(luò),即可得到查詢疾病的預(yù)測(cè)。同時(shí)可以通過(guò)疾病查詢網(wǎng)絡(luò)得到注意力圖對(duì)病灶進(jìn)行定位,增強(qiáng)模型的可解釋性。 實(shí)驗(yàn)結(jié)果 研究團(tuán)隊(duì)將僅在 MIMIC-CXR [1] 上使用圖像和報(bào)告預(yù)訓(xùn)練的 KAD 模型,在多個(gè)具有不同數(shù)據(jù)分布的公開(kāi)數(shù)據(jù)集上進(jìn)行了系統(tǒng)性評(píng)測(cè),包括 CheXpert [2], PadChest [3], NIH ChestX-ray [4] 和 CheXDet10 [5]。MIMIC-CXR 數(shù)據(jù)收集于貝斯以色列女執(zhí)事醫(yī)療中心(Beth Israel Deaconess Medical Center,BIDMC)是,CheXpert 數(shù)據(jù)收集于美國(guó)斯坦福醫(yī)院(Stanford Hospital),PadChest 數(shù)據(jù)收集于西班牙圣胡醫(yī)院(San Juan Hospital),NIH ChestX-ray 和 CheXDet10 數(shù)據(jù)來(lái)自于美國(guó)國(guó)立衛(wèi)生研究院(National Institutes of Health)臨床 PACS 數(shù)據(jù)庫(kù)。 (1) KAD 零樣本診斷能力與專業(yè)放射科醫(yī)生精度相當(dāng) 如圖 2 所示,該研究將預(yù)訓(xùn)練的 KAD 模型在 CheXpert 數(shù)據(jù)上進(jìn)行評(píng)測(cè),在其中的五類疾病診斷任務(wù)與放射科醫(yī)生進(jìn)行了比較,圖中 Radiologists 表示三名放射科醫(yī)生的平均結(jié)果。KAD 在五類疾病診斷任務(wù)上的平均 MCC 超過(guò)了 Radiologists,且在其中三類疾病的診斷結(jié)果顯著優(yōu)于放射科醫(yī)生,肺不張 atelectasis (KAD 0.613 (95% CI 0.567, 0.659) vs. Radiologists 0.548);肺水腫 edema (KAD 0.666 (95% CI 0.608, 0.724) vs. Radiologists 0.507);胸腔積液 pleural effusion (KAD 0.702 (95% CI 0.653, 0.751) vs. Radiologists 0.548)。該結(jié)果證實(shí)了基于知識(shí)增強(qiáng)的模型預(yù)訓(xùn)練的有效性。

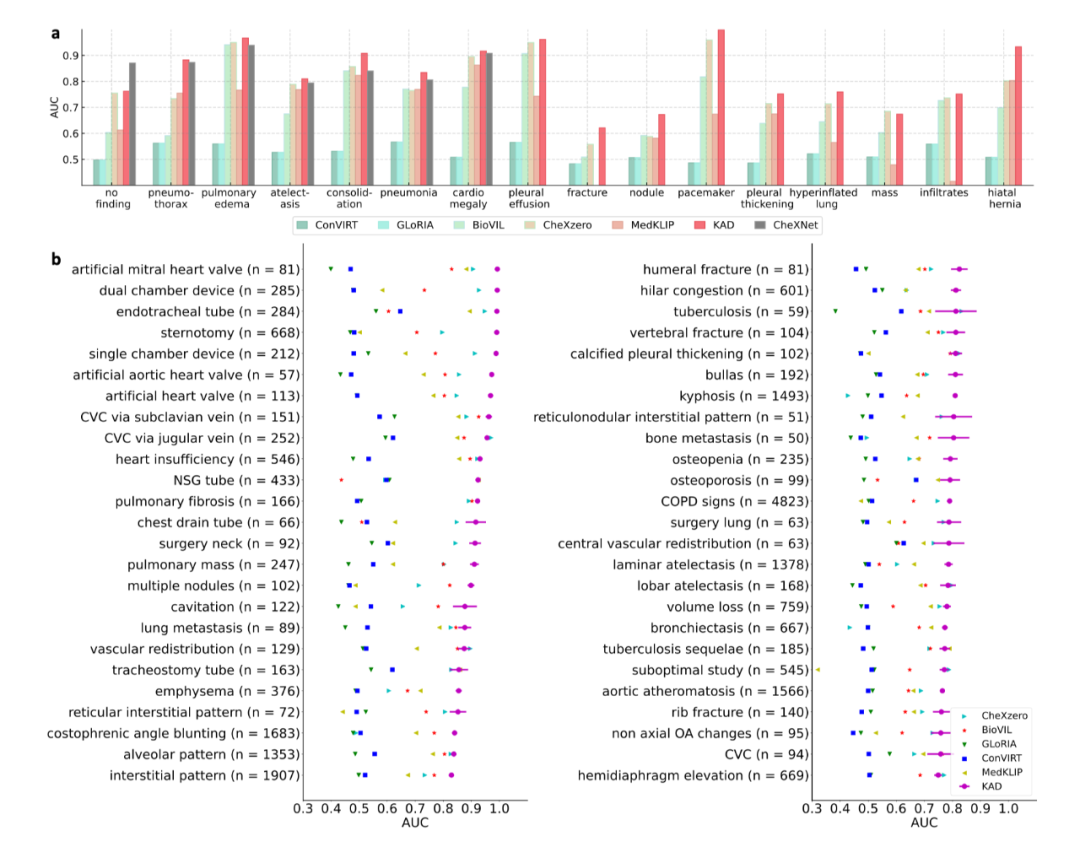

圖 2:KAD 在 CheXpert 數(shù)據(jù)集上與基線模型以及放射科醫(yī)生的比較 (2) KAD 零樣本診斷能力與全監(jiān)督模型相當(dāng),支持開(kāi)放集疾病診斷 如圖 3a 所示,在 PadChest 上的零樣本診斷性能大幅度超越此前所有多模態(tài)預(yù)訓(xùn)練模型(例如 Microsoft 發(fā)布的 BioVIL [6],Stanford 發(fā)布的 CheXzero [7]),與全監(jiān)督模型 (CheXNet [8]) 相當(dāng)。此外,全監(jiān)督的模型的應(yīng)用范圍受限于封閉的訓(xùn)練類別集合,而 KAD 可以支持任意的疾病輸入,在 PadChest 的 177 個(gè)未見(jiàn)類別的測(cè)試中,有 31 類 AUC 達(dá)到 0.900 以上,111 類 AUC 達(dá)到 0.700 以上,如圖 3b 所示。

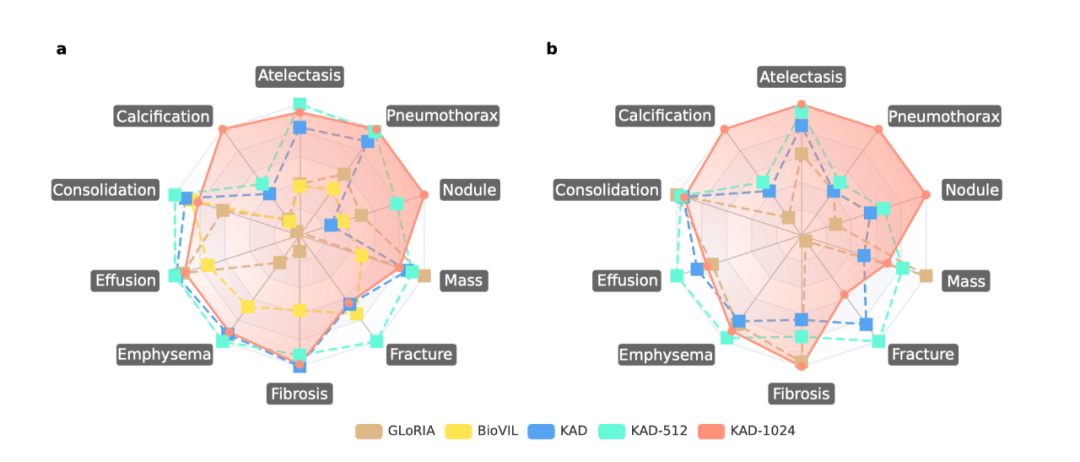

圖 3:KAD 在 PadChest 數(shù)據(jù)集上與基線模型的比較 (3) KAD 具有疾病定位能力,為模型預(yù)測(cè)提供可解釋性 除了自動(dòng)診斷能力,可解釋性在人工智能輔助醫(yī)療的作用同樣關(guān)鍵,能夠有效幫助臨床醫(yī)生理解人工智能算法的判斷依據(jù)。在 ChestXDet10 數(shù)據(jù)集上對(duì) KAD 的定位能力進(jìn)行了定量分析與定性分析。如圖 4 所示,KAD 的定位能力顯著優(yōu)于基線模型。圖 5 中,紅色方框?yàn)榉派淇漆t(yī)生提供的標(biāo)注,高亮區(qū)域?yàn)槟P偷臒崃D,從中可以看出模型所關(guān)注的區(qū)域往往能與醫(yī)生標(biāo)注區(qū)域?qū)?yīng)上,隨著輸入圖像的分辨率增加,模型的定位能力也顯著增強(qiáng)。 需要強(qiáng)調(diào) 這是模型設(shè)計(jì)的優(yōu)勢(shì),是在無(wú)需人工病灶區(qū)域標(biāo)注情況下獲得的副產(chǎn)品。

圖 4: KAD 在 ChestXDet10 數(shù)據(jù)集上與基線模型的比較

圖 5:KAD 的定位結(jié)果可視化 總結(jié) 醫(yī)療領(lǐng)域的專業(yè)性,導(dǎo)致通用基礎(chǔ)模型在真實(shí)臨床診療場(chǎng)景下的應(yīng)用十分受限。KAD 模型的提出為基于知識(shí)增強(qiáng)的基礎(chǔ)模型預(yù)訓(xùn)練提供了切實(shí)可行的解決方案。KAD 的訓(xùn)練框架只需要影像 - 報(bào)告數(shù)據(jù),不依賴于人工注釋,在下游胸部 X-ray 診斷任務(wù)上,無(wú)需任何監(jiān)督微調(diào),即達(dá)到與專業(yè)放射科醫(yī)生相當(dāng)?shù)木龋恢С珠_(kāi)放集疾病診斷任務(wù),同時(shí)以注意力圖形式提供對(duì)病灶的位置定位,增強(qiáng)模型的可解釋性。值得注意的是,該研究提出的基于知識(shí)增強(qiáng)的表征學(xué)習(xí)方法不局限于胸部 X-ray,期待其能夠進(jìn)一步遷移到醫(yī)療中不同的器官、模態(tài)上,促進(jìn)醫(yī)療基礎(chǔ)模型在臨床的應(yīng)用和落地。

-

編碼器

+關(guān)注

關(guān)注

45文章

3780瀏覽量

137316 -

模型

+關(guān)注

關(guān)注

1文章

3499瀏覽量

50077 -

大數(shù)據(jù)

+關(guān)注

關(guān)注

64文章

8952瀏覽量

139605

原文標(biāo)題:Nature子刊!上海交大&上海AI Lab提出胸部X-ray疾病診斷基礎(chǔ)模型

文章出處:【微信號(hào):CVer,微信公眾號(hào):CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

一文詳解知識(shí)增強(qiáng)的語(yǔ)言預(yù)訓(xùn)練模型

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的預(yù)訓(xùn)練

優(yōu)化神經(jīng)網(wǎng)絡(luò)訓(xùn)練方法有哪些?

微軟在ICML 2019上提出了一個(gè)全新的通用預(yù)訓(xùn)練方法MASS

新的預(yù)訓(xùn)練方法——MASS!MASS預(yù)訓(xùn)練幾大優(yōu)勢(shì)!

檢索增強(qiáng)型語(yǔ)言表征模型預(yù)訓(xùn)練

一種側(cè)重于學(xué)習(xí)情感特征的預(yù)訓(xùn)練方法

如何向大規(guī)模預(yù)訓(xùn)練語(yǔ)言模型中融入知識(shí)?

利用視覺(jué)語(yǔ)言模型對(duì)檢測(cè)器進(jìn)行預(yù)訓(xùn)練

介紹幾篇EMNLP'22的語(yǔ)言模型訓(xùn)練方法優(yōu)化工作

基礎(chǔ)模型自監(jiān)督預(yù)訓(xùn)練的數(shù)據(jù)之謎:大量數(shù)據(jù)究竟是福還是禍?

基于生成模型的預(yù)訓(xùn)練方法

混合專家模型 (MoE)核心組件和訓(xùn)練方法介紹

基于醫(yī)學(xué)知識(shí)增強(qiáng)的基礎(chǔ)模型預(yù)訓(xùn)練方法

基于醫(yī)學(xué)知識(shí)增強(qiáng)的基礎(chǔ)模型預(yù)訓(xùn)練方法

評(píng)論