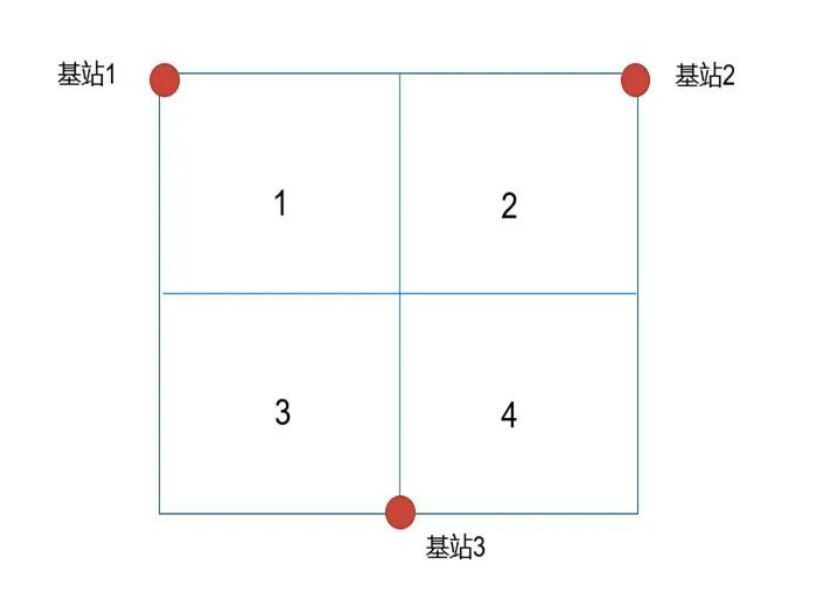

基于三個UWB錨點基站,采集近5萬條數據,分別采用BPNN和LSTM兩種神經網絡訓練和預測模型,實現目標區域的判斷;

實驗共使用了11741條數據,按照8 : 2的比例劃分為訓練集與測試集

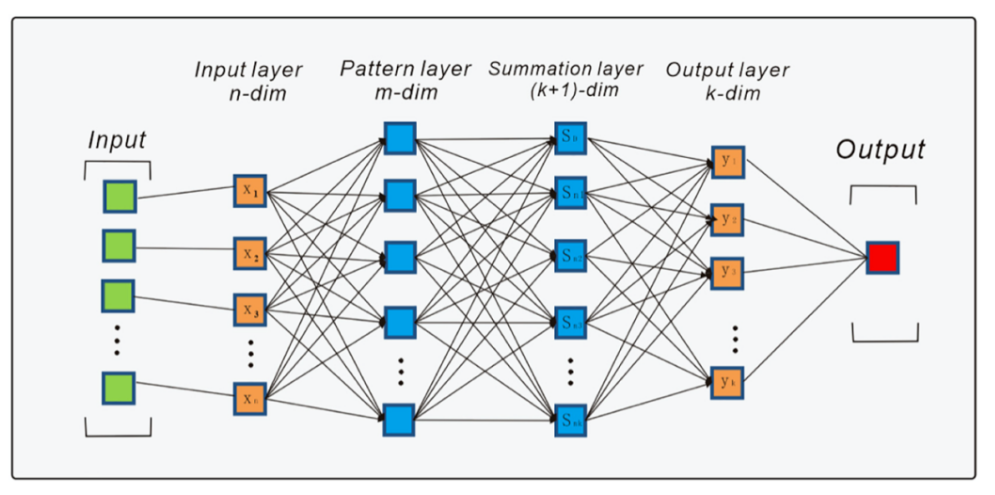

模型采用的是3層BPNN,隱含層為3,維度變化依次為3->32->16->4

損失函數使用的是交叉熵,優化器選擇的是Adam,學習率為0.0001

訓練輪數為100,為了提高訓練效率和泛化能力,將32個數據作為一批,按批進行訓練,在100輪訓練之后,訓練損失逐漸收斂于0.005;

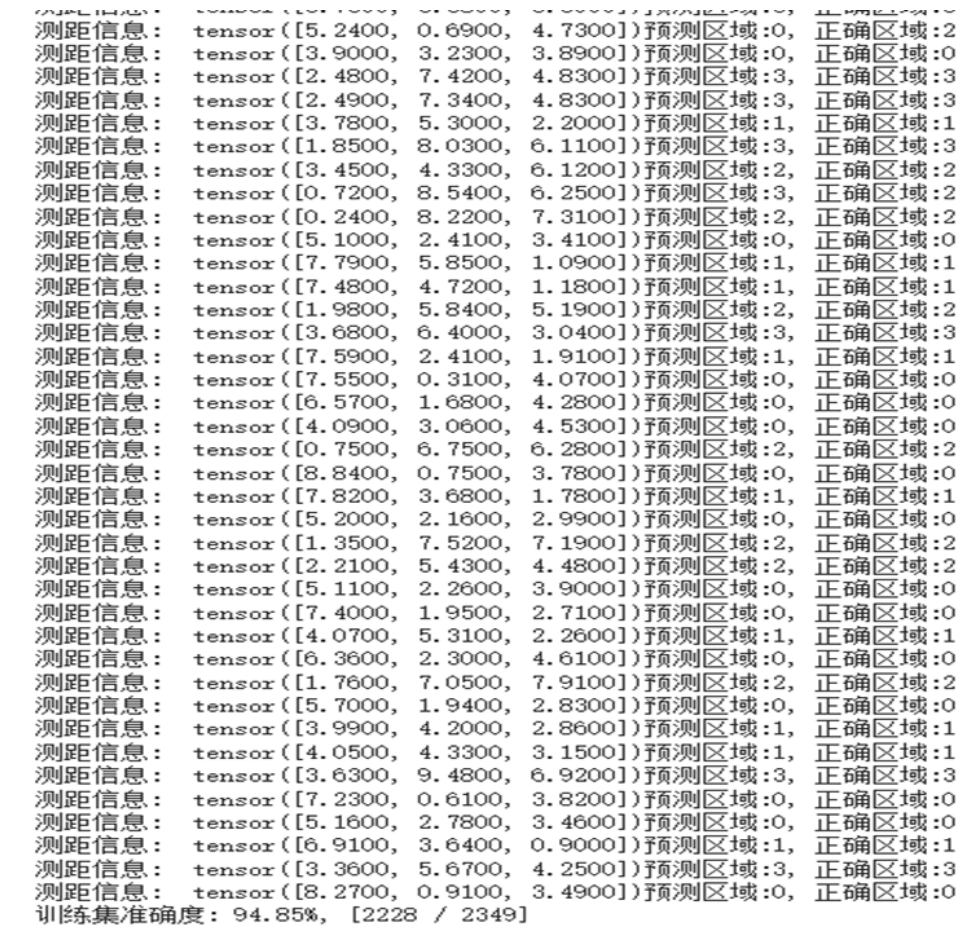

在測試集中的2349個數據中的測試準確率為94.85%

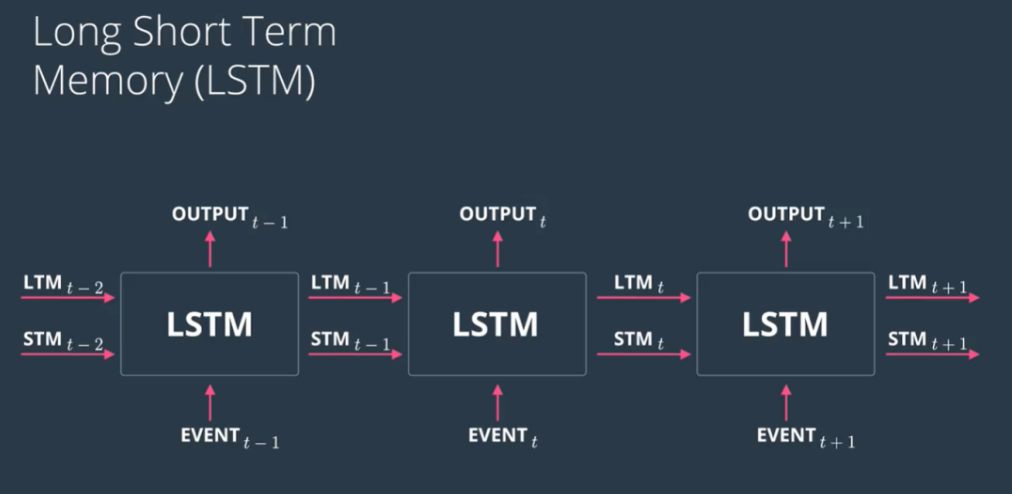

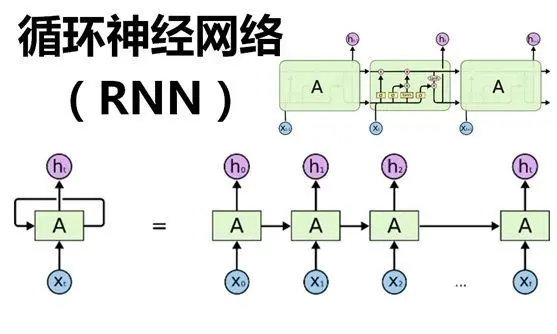

LSTM模型

數據歸一化與劃分,使用numpy的最大值函數獲取每個特征列的最大值,并將數據進行預處理,使用最大值歸一化并將數據按照8:2的比例進行模型的訓練與預測。

模型的構建:使用了Keras來創建模型。模型結構包括一個LSTM層,它有32個神經元,激活函數為Relu。Dropout層設置為20%的丟棄比率。全連接層輸出4個神經元,使用softmax激活函數進行多類分類。對模型進行編譯,使用Adam優化器和分類交叉熵損失函數。之后將模型進行擬合,指定批量大小(batch_size)為20,訓練次數(epochs)為100。

經過100輪訓練之后,模型的訓練準確率達到了95.52%,損失函數為0.1134.測試數據約3000條的測試準確率為95.99%。

后續會進一步基于兩種神經網絡學習模型,通過減少錨點以及增加時間序列和信號能量以及信號到達角輸入變量,觀察預測模型的準確率;

審核編輯:湯梓紅

-

算法

+關注

關注

23文章

4701瀏覽量

94843 -

UWB

+關注

關注

32文章

1164瀏覽量

62373 -

模型

+關注

關注

1文章

3499瀏覽量

50062 -

深度學習

+關注

關注

73文章

5555瀏覽量

122528

發布評論請先 登錄

基于UWB信號的深度學習算法

基于UWB信號的深度學習算法

評論