來(lái)源:易百納技術(shù)社區(qū)

隨著人工智能技術(shù)的不斷進(jìn)步,深度學(xué)習(xí)成為計(jì)算機(jī)視覺(jué)領(lǐng)域的重要技術(shù)。微表情識(shí)別作為人類(lèi)情感分析的一種重要手段,受到了越來(lái)越多的關(guān)注。本文將介紹基于深度學(xué)習(xí)的微表情識(shí)別技術(shù),并提供一個(gè)示例代碼來(lái)演示其實(shí)現(xiàn)過(guò)程。

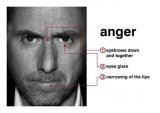

微表情是人類(lèi)情感的微小表達(dá),通常持續(xù)時(shí)間很短(不到1/25秒),難以察覺(jué)。然而,微表情蘊(yùn)含了豐富的情感信息,對(duì)于理解他人的情感狀態(tài)以及非言語(yǔ)交流具有重要意義。

基于深度學(xué)習(xí)的微表情識(shí)別技術(shù):

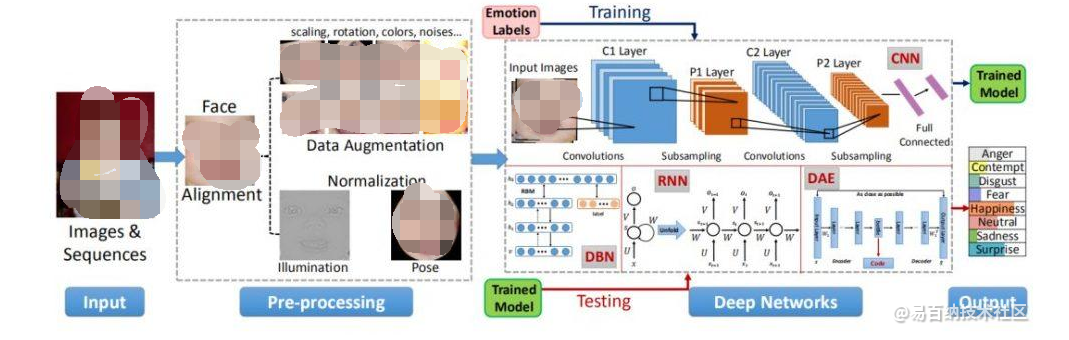

深度學(xué)習(xí)技術(shù)在圖像識(shí)別領(lǐng)域取得了巨大成功,也被應(yīng)用于微表情識(shí)別。以下是一個(gè)基于深度學(xué)習(xí)的微表情識(shí)別技術(shù)框架:

數(shù)據(jù)收集與預(yù)處理:

構(gòu)建一個(gè)高質(zhì)量的微表情識(shí)別模型需要大量的帶有標(biāo)簽的數(shù)據(jù)集。可以通過(guò)收集視頻數(shù)據(jù)并手動(dòng)標(biāo)注微表情的起始和終止幀來(lái)創(chuàng)建一個(gè)數(shù)據(jù)集。預(yù)處理步驟通常包括圖像幀的灰度化、歸一化和裁剪,以減少計(jì)算量并提高模型的魯棒性。

特征提取:

深度學(xué)習(xí)的一個(gè)主要優(yōu)勢(shì)在于其能夠自動(dòng)學(xué)習(xí)特征表示。在微表情識(shí)別中,可以使用卷積神經(jīng)網(wǎng)絡(luò)(CNN)來(lái)提取特征。將預(yù)處理后的圖像幀輸入CNN,通過(guò)多個(gè)卷積層和池化層學(xué)習(xí)圖像的特征表示。

微表情識(shí)別模型:

在特征提取后,可以將其輸入到一個(gè)分類(lèi)器中,例如支持向量機(jī)(SVM)或循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN),來(lái)對(duì)微表情進(jìn)行分類(lèi)。SVM適用于靜態(tài)圖像的分類(lèi),而RNN則可以處理時(shí)間序列數(shù)據(jù),更適合微表情的分類(lèi)任務(wù)。

基于深度學(xué)習(xí)的微表情識(shí)別

下面是一個(gè)簡(jiǎn)單的示例代碼,演示了如何使用Python和Keras庫(kù)來(lái)實(shí)現(xiàn)一個(gè)基于CNN的微表情識(shí)別模型。請(qǐng)確保已經(jīng)安裝了所需的庫(kù)。

# 導(dǎo)入所需的庫(kù) import numpy as np import keras from keras.models import Sequential from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense # 構(gòu)建CNN模型 model = Sequential() model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 1))) model.add(MaxPooling2D((2, 2))) model.add(Conv2D(64, (3, 3), activation='relu')) model.add(MaxPooling2D((2, 2))) model.add(Flatten()) model.add(Dense(128, activation='relu')) model.add(Dense(2, activation='softmax')) # 這里假設(shè)微表情有兩類(lèi):正面和負(fù)面 # 編譯模型 model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy']) # 加載數(shù)據(jù)集并預(yù)處理 # 這里需要準(zhǔn)備一個(gè)包含標(biāo)簽的圖像數(shù)據(jù)集,圖像大小為64x64,灰度圖像 # X_train和y_train分別代表訓(xùn)練集圖像和標(biāo)簽 X_train = ... y_train = ... # 訓(xùn)練模型 model.fit(X_train, y_train, epochs=10, batch_size=32) # 在測(cè)試集上評(píng)估模型 # 這里需要準(zhǔn)備一個(gè)包含標(biāo)簽的測(cè)試集,圖像大小為64x64,灰度圖像 # X_test和y_test分別代表測(cè)試集圖像和標(biāo)簽 X_test = ... y_test = ... loss, accuracy = model.evaluate(X_test, y_test) print("測(cè)試集上的準(zhǔn)確率:", accuracy)

雖然基于深度學(xué)習(xí)的微表情識(shí)別技術(shù)取得了顯著進(jìn)展,但仍然存在一些技術(shù)挑戰(zhàn)需要解決。

數(shù)據(jù)集規(guī)模與質(zhì)量:

深度學(xué)習(xí)模型通常需要大規(guī)模的數(shù)據(jù)集來(lái)訓(xùn)練,以獲得較好的性能。對(duì)于微表情識(shí)別來(lái)說(shuō),獲取高質(zhì)量、大規(guī)模且標(biāo)記準(zhǔn)確的數(shù)據(jù)集是一項(xiàng)挑戰(zhàn)。解決這個(gè)問(wèn)題的方法可能包括增強(qiáng)數(shù)據(jù)集、引入合成數(shù)據(jù)或利用遷移學(xué)習(xí)等技術(shù)。

多樣性和泛化能力:

微表情通常是非常細(xì)微的情感表達(dá),不同個(gè)體之間可能存在較大的差異。模型需要具備較強(qiáng)的泛化能力,能夠適應(yīng)不同人群和情境的微表情。為了提高泛化性能,可以采用一些正則化技術(shù),如批標(biāo)準(zhǔn)化、dropout等。

時(shí)間序列建模:

微表情是一種時(shí)間序列數(shù)據(jù),需要將圖像序列作為輸入,同時(shí)考慮時(shí)間信息。傳統(tǒng)的CNN模型并不擅長(zhǎng)處理時(shí)間序列數(shù)據(jù)。因此,可以嘗試使用循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)、長(zhǎng)短期記憶網(wǎng)絡(luò)(LSTM)或注意力機(jī)制等模型來(lái)更好地捕捉微表情的時(shí)序特征。

實(shí)時(shí)性:

在一些實(shí)際應(yīng)用場(chǎng)景中,實(shí)時(shí)性是一個(gè)關(guān)鍵要求。例如,在視頻會(huì)議中對(duì)微表情進(jìn)行實(shí)時(shí)識(shí)別,需要模型具備較快的推理速度。為了提高模型的實(shí)時(shí)性,可以采用輕量化的網(wǎng)絡(luò)結(jié)構(gòu)、模型壓縮或硬件加速等方法。

未來(lái)發(fā)展方向: 隨著人工智能技術(shù)的不斷發(fā)展,基于深度學(xué)習(xí)的微表情識(shí)別技術(shù)有望在以下方向取得進(jìn)一步的發(fā)展:

多模態(tài)融合:將音頻、姿態(tài)、心率等其他感知信息與圖像信息進(jìn)行融合,可以更全面地理解和識(shí)別微表情,提高情感識(shí)別的準(zhǔn)確性和魯棒性。

自監(jiān)督學(xué)習(xí):利用無(wú)需標(biāo)注的數(shù)據(jù)進(jìn)行自監(jiān)督學(xué)習(xí),從大量未標(biāo)注的數(shù)據(jù)中學(xué)習(xí)表征,進(jìn)一步提升模型性能。

弱監(jiān)督學(xué)習(xí):在數(shù)據(jù)標(biāo)注成本較高的情況下,通過(guò)弱監(jiān)督學(xué)習(xí)技術(shù),利用少量標(biāo)注數(shù)據(jù)和大量未標(biāo)注數(shù)據(jù)進(jìn)行訓(xùn)練,實(shí)現(xiàn)性能的提升。

跨數(shù)據(jù)集泛化:構(gòu)建能夠在不同數(shù)據(jù)集上泛化的微表情識(shí)別模型,使得模型具備更廣泛的應(yīng)用能力。

隱私保護(hù):在應(yīng)用微表情識(shí)別技術(shù)時(shí),需要考慮個(gè)人隱私的保護(hù)。研究隱私保護(hù)技術(shù),確保在使用微表情識(shí)別技術(shù)時(shí)不侵犯?jìng)€(gè)體隱私。

微表情識(shí)別模型的時(shí)間序列建模

使用Keras中的LSTM層來(lái)進(jìn)行微表情的時(shí)間序列建模。假設(shè)我們已經(jīng)準(zhǔn)備好了帶有時(shí)間序列標(biāo)簽的數(shù)據(jù)集,其中每個(gè)樣本是一個(gè)包含連續(xù)微表情圖像的序列。

# 導(dǎo)入所需的庫(kù)

import numpy as np

import keras

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, LSTM, Dense

# 構(gòu)建LSTM模型

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 1)))

model.add(MaxPooling2D((2, 2)))

model.add(Conv2D(64, (3, 3), activation='relu'))

model.add(MaxPooling2D((2, 2)))

model.add(TimeDistributed(Flatten())) # 對(duì)每一幀應(yīng)用Flatten

model.add(LSTM(64, return_sequences=True)) # LSTM層處理時(shí)間序列

model.add(LSTM(32))

model.add(Dense(2, activation='softmax')) # 假設(shè)有兩類(lèi)微表情:正面和負(fù)面

# 編譯模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 加載數(shù)據(jù)集并預(yù)處理

# 這里需要準(zhǔn)備一個(gè)包含時(shí)間序列標(biāo)簽的圖像數(shù)據(jù)集,圖像大小為64x64,灰度圖像

# X_train和y_train分別代表訓(xùn)練集圖像和標(biāo)簽

# X_train的形狀為 (樣本數(shù), 時(shí)間步數(shù), 圖像高度, 圖像寬度, 通道數(shù))

X_train = ...

y_train = ...

# 訓(xùn)練模型

model.fit(X_train, y_train, epochs=10, batch_size=32)

# 在測(cè)試集上評(píng)估模型

# 這里需要準(zhǔn)備一個(gè)包含時(shí)間序列標(biāo)簽的測(cè)試集,圖像大小為64x64,灰度圖像

# X_test和y_test分別代表測(cè)試集圖像和標(biāo)簽

X_test = ...

y_test = ...

loss, accuracy = model.evaluate(X_test, y_test)

print("測(cè)試集上的準(zhǔn)確率:", accuracy)

在上面的代碼中,我們使用了Keras的TimeDistributed層來(lái)對(duì)每一幀圖像應(yīng)用Flatten操作,以使圖像的特征在時(shí)間序列上進(jìn)行扁平化。然后,我們使用兩個(gè)LSTM層來(lái)處理時(shí)間序列數(shù)據(jù),從而更好地捕捉微表情的時(shí)序信息。

結(jié)論

基于深度學(xué)習(xí)的微表情識(shí)別技術(shù)為我們理解和分析人類(lèi)情感提供了新的視角。通過(guò)深度學(xué)習(xí)技術(shù)的不斷進(jìn)步和創(chuàng)新,相信微表情識(shí)別技術(shù)將在社交交互、心理學(xué)研究、情感智能等領(lǐng)域發(fā)揮重要作用,為人工智能領(lǐng)域帶來(lái)更多有意義的應(yīng)用和突破。同時(shí),我們也應(yīng)該密切關(guān)注技術(shù)所帶來(lái)的社會(huì)和倫理問(wèn)題,確保技術(shù)的發(fā)展與應(yīng)用符合倫理和法律準(zhǔn)則。

審核編輯 黃宇

-

人工智能

+關(guān)注

關(guān)注

1796文章

47722瀏覽量

240368 -

表情識(shí)別

+關(guān)注

關(guān)注

0文章

33瀏覽量

7439 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5516瀏覽量

121573

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

【技術(shù)雜談】用AI讀懂人心?情感科學(xué)專家:靠表情識(shí)別情緒不靠譜

基于粗集的表情識(shí)別在電力學(xué)習(xí)中的應(yīng)用

多文化場(chǎng)景下的多模態(tài)情感識(shí)別

深度學(xué)習(xí)下的AI微表情研究

微表情識(shí)別-深度學(xué)習(xí)探索情感

微表情識(shí)別-深度學(xué)習(xí)探索情感

評(píng)論