深度學習框架區分訓練還是推理嗎

深度學習框架是一個非常重要的技術,它們能夠加速深度學習的開發與部署過程。在深度學習中,我們通常需要進行兩個關鍵的任務,即訓練和推理。訓練是指使用訓練數據訓練神經網絡模型,以便將來能夠進行準確的預測。推理是指在訓練完成后,使用已經訓練好的模型進行新的預測。然而,深度學習框架是否區分訓練和推理呢?

大多數深度學習框架是區分訓練和推理的。這是因為,在訓練和推理過程中,使用的是不同的算法和數據流程。具體而言,在訓練過程中,我們需要計算神經網絡模型中的梯度,并將其用于反向傳播算法,以更新模型參數。這種計算通常需要大量的計算資源和時間。另外,在訓練過程中,我們通常會使用大量的訓練數據進行模型訓練,這些訓練數據需要在每一次迭代時傳遞給模型。這些數據也需要消耗大量的內存和處理能力。相反,在推理過程中,我們僅需要將輸入數據傳遞給模型,進行預測即可。這種預測通常會快速執行,因為它通常不需要進行梯度計算和反向傳播。

因此,大多數深度學習框架會在設計時考慮到這一點,可以提供訓練和推理的不同接口,并且會自動選擇適當的算法和數據處理流程。例如,在Python中,TensorFlow、PyTorch和Keras等深度學習框架都提供了不同的API來支持訓練和推理。在這些框架中,我們可以使用相同的模型來進行訓練和推理,但需要使用不同的API。通常,訓練API會提供訓練數據、模型以及訓練參數,而推理API僅需提供輸入數據和經過訓練的模型即可。

此外,許多深度學習框架還提供了優化和加速訓練和推理的選項。例如,TensorFlow和PyTorch都支持GPU加速訓練和推理,這可以顯著加速深度學習應用程序的執行時間。另外,許多深度學習框架還支持分布式訓練和推理,因此可以在多個計算節點上同時運行算法。這些優化和加速選項可以幫助我們更高效地利用計算資源,并加速深度學習應用程序的執行時間。

總結:

在本文中,我們探討了深度學習框架是否區分訓練和推理。我們發現,在訓練和推理過程中,使用的是不同的算法和數據流程,因此大多數深度學習框架都會提供不同的接口,以支持訓練和推理。此外,這些框架還提供了優化和加速訓練和推理的選項,這可以加速深度學習應用程序的執行時間。

-

神經網絡

+關注

關注

42文章

4810瀏覽量

102916 -

深度學習

+關注

關注

73文章

5555瀏覽量

122533

發布評論請先 登錄

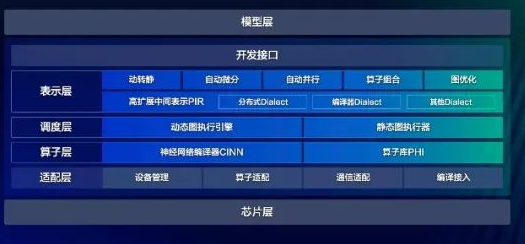

壁仞科技支持DeepSeek-V3滿血版訓練推理

昆侖芯率先完成Deepseek訓練推理全版本適配

深度學習框架區分訓練還是推理嗎

深度學習框架區分訓練還是推理嗎

評論