一、引言

深度學(xué)習(xí)模型訓(xùn)練是一個(gè)復(fù)雜且關(guān)鍵的過(guò)程,它涉及大量的數(shù)據(jù)、計(jì)算資源和精心設(shè)計(jì)的算法。訓(xùn)練一個(gè)深度學(xué)習(xí)模型,本質(zhì)上是通過(guò)優(yōu)化算法調(diào)整模型參數(shù),使模型能夠更好地?cái)M合數(shù)據(jù),提高預(yù)測(cè)或分類的準(zhǔn)確性。本文將詳細(xì)介紹深度學(xué)習(xí)模型訓(xùn)練的全過(guò)程,包括數(shù)據(jù)預(yù)處理、模型構(gòu)建、損失函數(shù)定義、優(yōu)化算法選擇、訓(xùn)練過(guò)程以及模型的評(píng)估與調(diào)優(yōu)。

二、數(shù)據(jù)預(yù)處理

數(shù)據(jù)預(yù)處理是深度學(xué)習(xí)模型訓(xùn)練的第一步,也是至關(guān)重要的一步。數(shù)據(jù)預(yù)處理的主要目的是將原始數(shù)據(jù)轉(zhuǎn)換為模型可以處理的格式,并消除數(shù)據(jù)中的噪聲和冗余信息,提高模型的訓(xùn)練效果。數(shù)據(jù)預(yù)處理的主要步驟包括:

數(shù)據(jù)清洗:檢查數(shù)據(jù)中的缺失值、異常值和重復(fù)值,并進(jìn)行相應(yīng)的處理。例如,缺失值可以通過(guò)填充平均值、中位數(shù)或眾數(shù)來(lái)處理,異常值可以通過(guò)刪除或替換為合適的值來(lái)處理,重復(fù)值可以通過(guò)刪除或合并來(lái)處理。

數(shù)據(jù)標(biāo)準(zhǔn)化:對(duì)數(shù)據(jù)進(jìn)行標(biāo)準(zhǔn)化處理,即將數(shù)據(jù)轉(zhuǎn)換為均值為0、標(biāo)準(zhǔn)差為1的分布。標(biāo)準(zhǔn)化可以消除不同特征之間的量綱差異,使模型更容易學(xué)習(xí)到特征之間的關(guān)系。

特征縮放:對(duì)特征進(jìn)行縮放處理,以調(diào)整特征的取值范圍。常見(jiàn)的特征縮放方法包括最小-最大縮放和標(biāo)準(zhǔn)化縮放。特征縮放可以加速模型的訓(xùn)練過(guò)程,提高模型的性能。

特征選擇:選擇與目標(biāo)變量相關(guān)性較高的特征進(jìn)行訓(xùn)練,以提高模型的預(yù)測(cè)準(zhǔn)確性。常見(jiàn)的特征選擇方法包括相關(guān)系數(shù)、信息增益等。

三、模型構(gòu)建

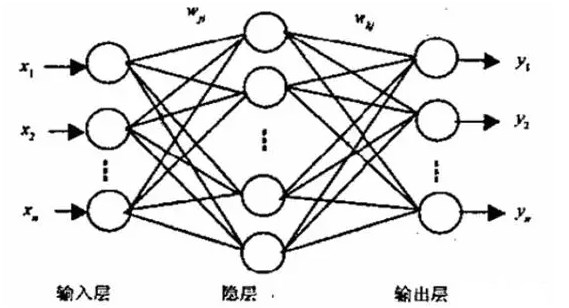

模型構(gòu)建是深度學(xué)習(xí)模型訓(xùn)練的核心步驟。在模型構(gòu)建階段,需要選擇合適的深度學(xué)習(xí)模型和設(shè)計(jì)相應(yīng)的架構(gòu)。常見(jiàn)的深度學(xué)習(xí)模型包括卷積神經(jīng)網(wǎng)絡(luò)(CNN)、循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)、生成對(duì)抗網(wǎng)絡(luò)(GAN)等。在模型架構(gòu)設(shè)計(jì)中,需要考慮模型的深度、寬度、激活函數(shù)、正則化等因素。同時(shí),還需要根據(jù)具體任務(wù)的需求選擇合適的損失函數(shù)和優(yōu)化算法。

四、損失函數(shù)定義

損失函數(shù)是衡量模型預(yù)測(cè)結(jié)果與真實(shí)標(biāo)簽之間差異的函數(shù)。在深度學(xué)習(xí)中,常見(jiàn)的損失函數(shù)包括均方誤差(MSE)、交叉熵(Cross Entropy)等。損失函數(shù)的選擇對(duì)模型的訓(xùn)練效果有重要影響。選擇合適的損失函數(shù)可以使模型更好地?cái)M合數(shù)據(jù),提高預(yù)測(cè)準(zhǔn)確性。

五、優(yōu)化算法選擇

優(yōu)化算法是用于更新模型參數(shù)以最小化損失函數(shù)的算法。在深度學(xué)習(xí)中,常用的優(yōu)化算法包括隨機(jī)梯度下降(SGD)、動(dòng)量(Momentum)、Adam等。不同的優(yōu)化算法具有不同的特點(diǎn)和適用場(chǎng)景。選擇合適的優(yōu)化算法可以加速模型的訓(xùn)練過(guò)程,提高模型的性能。

六、訓(xùn)練過(guò)程

訓(xùn)練過(guò)程是深度學(xué)習(xí)模型訓(xùn)練的核心環(huán)節(jié)。在訓(xùn)練過(guò)程中,需要不斷迭代地更新模型參數(shù)以最小化損失函數(shù)。訓(xùn)練過(guò)程主要包括以下幾個(gè)步驟:

前向傳播:將輸入數(shù)據(jù)通過(guò)模型進(jìn)行前向傳播計(jì)算得到預(yù)測(cè)結(jié)果。

計(jì)算損失:使用損失函數(shù)計(jì)算預(yù)測(cè)結(jié)果與真實(shí)標(biāo)簽之間的差異得到損失值。

反向傳播:根據(jù)損失值計(jì)算梯度信息并通過(guò)反向傳播算法將梯度信息回傳到模型中的各個(gè)參數(shù)上。

更新參數(shù):使用優(yōu)化算法根據(jù)梯度信息更新模型的參數(shù)。

迭代訓(xùn)練:重復(fù)上述步驟進(jìn)行迭代訓(xùn)練直到達(dá)到預(yù)設(shè)的迭代次數(shù)或損失值收斂。

在訓(xùn)練過(guò)程中,還需要注意一些細(xì)節(jié)問(wèn)題,如學(xué)習(xí)率的選擇、批量大小的設(shè)置、正則化方法的使用等。這些細(xì)節(jié)問(wèn)題對(duì)模型的訓(xùn)練效果也有重要影響。

七、模型的評(píng)估與調(diào)優(yōu)

在模型訓(xùn)練完成后,需要對(duì)模型進(jìn)行評(píng)估和調(diào)優(yōu)以提高模型的性能。常見(jiàn)的評(píng)估指標(biāo)包括準(zhǔn)確率、召回率、F1值等。通過(guò)對(duì)模型進(jìn)行評(píng)估可以了解模型在不同數(shù)據(jù)集上的表現(xiàn)情況,并根據(jù)評(píng)估結(jié)果對(duì)模型進(jìn)行調(diào)優(yōu)。常見(jiàn)的調(diào)優(yōu)方法包括調(diào)整學(xué)習(xí)率、增加或減少隱藏層數(shù)量、更換優(yōu)化算法等。

八、總結(jié)與展望

本文詳細(xì)介紹了深度模型訓(xùn)練的全過(guò)程包括數(shù)據(jù)預(yù)處理、模型構(gòu)建、損失函數(shù)定義、優(yōu)化算法選擇、訓(xùn)練過(guò)程以及模型的評(píng)估與調(diào)優(yōu)。深度學(xué)習(xí)模型訓(xùn)練是一個(gè)復(fù)雜且關(guān)鍵的過(guò)程需要仔細(xì)設(shè)計(jì)每一步驟以確保模型的性能。隨著技術(shù)的不斷發(fā)展和進(jìn)步相信深度學(xué)習(xí)模型訓(xùn)練將變得更加高效和智能為各個(gè)領(lǐng)域帶來(lái)更多的應(yīng)用和發(fā)展機(jī)會(huì)。

-

算法

+關(guān)注

關(guān)注

23文章

4709瀏覽量

95339 -

模型

+關(guān)注

關(guān)注

1文章

3517瀏覽量

50401 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5561瀏覽量

122783

發(fā)布評(píng)論請(qǐng)先 登錄

如何才能高效地進(jìn)行深度學(xué)習(xí)模型訓(xùn)練?

Pytorch模型訓(xùn)練實(shí)用PDF教程【中文】

深度學(xué)習(xí)中過(guò)擬合/欠擬合的問(wèn)題及解決方案

labview調(diào)用深度學(xué)習(xí)tensorflow模型非常簡(jiǎn)單,附上源碼和模型

深度學(xué)習(xí)模型是如何創(chuàng)建的?

帶Dropout的訓(xùn)練過(guò)程

基于預(yù)訓(xùn)練模型和長(zhǎng)短期記憶網(wǎng)絡(luò)的深度學(xué)習(xí)模型

基于分割后門訓(xùn)練過(guò)程的后門防御方法

深度學(xué)習(xí)框架區(qū)分訓(xùn)練還是推理嗎

深度學(xué)習(xí)如何訓(xùn)練出好的模型

深度學(xué)習(xí)的模型優(yōu)化與調(diào)試方法

CNN模型的基本原理、結(jié)構(gòu)、訓(xùn)練過(guò)程及應(yīng)用領(lǐng)域

深度學(xué)習(xí)的典型模型和訓(xùn)練過(guò)程

解讀PyTorch模型訓(xùn)練過(guò)程

BP神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)和訓(xùn)練過(guò)程

深度學(xué)習(xí)模型訓(xùn)練過(guò)程詳解

深度學(xué)習(xí)模型訓(xùn)練過(guò)程詳解

評(píng)論