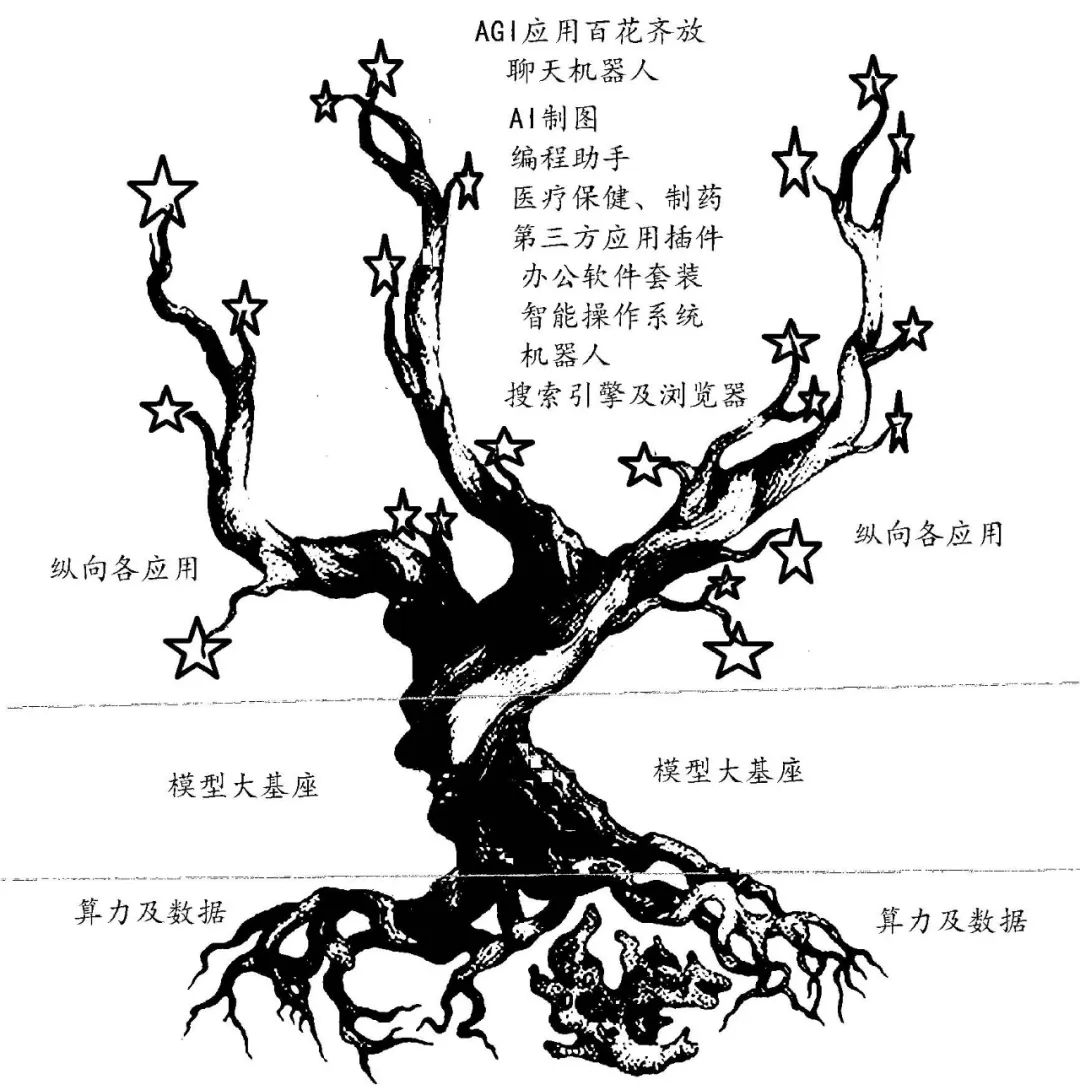

通用人工智能的生態樹如圖1所示,它龐大的樹根(算力)從大地中吸取營養(數據),形成茁壯的樹干(基座大模型),上面結滿了大蘋果(縱向應用包括聊天機器人、智能操作系統、瀏覽器、第三方應用插件、辦公套裝軟件、AI圖像、軟件開發、醫療、制藥、機器人等)。修剪刀剪去病枝爛果,修正樹勢,保證果實茁壯成長。

科技發展都是為了應用。在AGI生態樹中,縱向應用是結出的成千上萬的大蘋果。這些應用幾乎無所不至,國內外對此均有巨大的市場需求。技術、資金等進入的門檻不是太高,而且收效快,眾多大中小企業、創業者都可參與,B端、C端均可分享。

樹壯才能碩果累累。基座大模型的算法當前都不成問題,采用LLM(大語言模型)已成共識,國內外基本所有的大模型都來源于2017年谷歌開源的Transformer模型。國外的大模型有微軟和OpenAI的GPT 4、谷歌的PaLM 2、亞馬遜的Titan大模型、Intel的Aurora genAI模型、Meta公司的LLaMA 模型,而國內則是百度“文心一言”等的百模爭雄。近日,智源研究院發布了“悟道3.0”系列大模型及算法,這是目前我國市場上為數不多的可商用開源大語言模型之一。雖然“悟道3.0”的模型參數沒有公布,但2021年6月發布的“悟道2.0”模型參數規模達到1.75萬億,是當時我國首個萬億級模型。而且,“悟道3.0”中的天演團隊將“天演”接入我國新一代百億億次超級計算機——天河新一代超級計算機。通過“天演-天河”的成功運行,實現鼠腦V1視皮層精細網絡等模型仿真,計算能耗均可降低約10倍以上,計算速度實現10倍以上提升,達到全球范圍內最極致的精細神經元網絡仿真性能。

圖1 AGI強人工智能生態樹

數據是肥料,來源于人類的自然積累,位于人腦(經驗)、書本(文字)、音像作品中。ChatGPT 的訓練使用了來自于2021年9月前互聯網公開的文本數據(維基百科、書籍、期刊、Reddit社交新聞站點等),共45TB、近1萬億個單詞。但國內AGI中公益數據不多,數據的版權分散在各個機構、互聯網廠商的手中,若能建立中文數據集的產業聯盟,打破版權壁壘,將人工智能訓練數據統一規劃,則必是好事一樁。

互聯網上的文本數據有限,且有很多虛假、違反法律/道德和意識形態以及侵犯隱私的信息。下一代大模型的參數可能達到萬億級別以上,為了避免數據短缺問題成為訓練的瓶頸,人們推出了“合成數據”。合成數據(syntheticdata)是通過計算機技術人工生成的數據,雖然不是由真實事件產生的數據,但能夠在數學上或統計學上反映原始數據的屬性,因此可以作為原始數據的替代品來訓練、測試并驗證大模型。合成數據具有更高的效率(較短的時間內大量生成)、更低的成本、更高的質量(通過深度學習算法合成原始數據中沒有的罕見樣本,規避用戶隱私問題)。據稱,到2024年,人工智能和數據分析項目中的數據預計將有60%來自合成數據。

對人工智能的監管(法律、道德、倫理)就是對果樹的修剪。為了促進生成式人工智能技術健康發展和規范應用,國家網信辦在2023年4月11日發布了關于《生成式人工智能服務管理辦法(征求意見稿)》。2023年2月16日,中美等60多國簽署聲明“軍事領域負責任使用人工智能”。5月22日,OpenAI的創始人奧特曼、總裁和首席科學家聯合撰文稱:“我們最終可能需要類似于IAEA(國際原子能機構)的東西來進行超級智能方面的努力;任何超過一定能力(計算等資源)門檻的努力都需要接受國際權威機構的檢查,要求進行審計,測試是否符合安全標準,對部署程度和安全級別進行限制等。”

龐大的根系是果樹生長結果的根本。算力作為根系,一直都是掣肘人工智能發展的基石。

在人工智能(AI)研究過程中,有兩種流派:一種流派是嚴格的邏輯推理,另一種流派是研究模擬生物學的人類及大腦。后者在20世紀80年代推出了神經網絡學說,把人腦看成是一臺碳基計算機,用我們的硅基計算機來模擬生物的進化。隨著神經網絡模型不斷變大,神經元不斷增多,不知在突破某個值后是否會發生突變,變得更為智能。有專家按照現代神經網絡的架構分析人類神經網絡參數最少為100萬億(100~1000萬億),僅同時激活10%,其算力最少需0.79 EFLOPS,功耗僅幾十瓦。計算機所需要的數據空間大概為400~4 000 TB。

神經網絡學派推出了循環卷積等各種算法,但在20世紀沒有真正奏效的重要原因是當時計算機運行速度不夠快、數據集不夠大。隨著“神經元”的膨脹,大模型(LLM)計算復雜度以指數級增加,當時計算機有限的內存和處理速度不足以解決任何實際的AI問題,而每次算力的突破都帶來人工智能的爆發。IBM 研制的深藍(算力為11.38 GFLOPS )、谷歌的AlphaGo(算力是深藍的30萬倍)帶動了深度學習的大發展,而這次NVIDIA的A100、H100及CUDA則助推了GPT生成式大模型的問世。

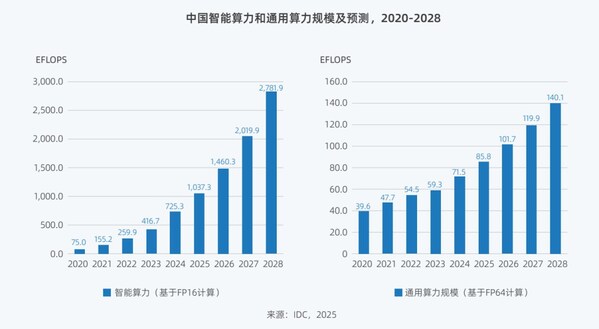

人類通常不斷有各種科學幻想和預言(期待的成果),而一些優秀的科學家為實現這些幻想和預言研究出各種理論(牛頓的力學及萬有引力、霍金的黑洞及宇宙起源、愛因斯坦的相對論等)。理論往往都超前于當時的科技水平,超前于算法,算法則要求有算力做支撐。有分析認為,當前的AGI算力和能耗都遠比不上人腦的碳基計算機!當下,千億級、萬億級參數的生成式大模型比人腦百萬億級參數還差很多,但能耗卻高得可怕。2023年4月,OpenAI就因需求量過大而停止了ChatGPT Plus的銷售。據數據預測,到2030年全球超算算力將達到0.2 ZFLOPS,平均年增速超過34%,未來10年人工智能算力需求將會增長500倍以上。為此,除NVIDIA外,幾乎所有的芯片大廠都在布局AI算力芯片。

AMD近期就推出一款新一代超級AI芯片———將CPU 和GPU 融合在一起的MI300X。該芯片是針對LLM 的優化版,擁有192 GB的HBM 內存,與NVIDIAH100相比,有2.4倍的HBM 密度和1.6倍的HBM 帶寬優勢,這可以在芯片上容納更大的模型,以獲得更高的吞吐量。單個MI300X可以運行一個參數多達800億的模型,這是全球首次在單個GPU 上運行這么大參數量的模型。這表明在無人駕駛L5等應用項目中需要強大邊緣計算算力的地方,MI300X將大放異彩。

1 提高算力的路徑

(1) 提高制程及Chiplet

根據摩爾定律,集成電路上可以容納的晶體管數目大約每經過18個月便會增加一倍,因此微處理器的性能每隔18個月提高一倍,價格下降一半。而光刻“制程”的進步是每18個月單位面積硅片上可容納的晶體管數目翻倍的主要原因。經歷了二十多年的正增長后,新世紀摩爾生長曲線在變緩,尤其是近年來芯片“制程”的提升越來越難,從16 nm 到7 nm 節點,芯片制造成本也在大幅提升,出現“摩爾定律失效”的議論。在將芯片制程繼續從7 nm降至5nm、3 nm、2 nm 的同時,芯片業也在從各方面應對AGI算力提升和功耗降低面臨的挑戰。

Chiplet是一種芯片設計和集成的方法,它將一個大型AI芯片分解為多核異構、多個獨立的功能模塊片段(稱為IP核或Chiplet)。每個Chiplet指已經過驗證的、可以重復使用的具有某種確切功能的集成電路設計模塊,如圖形處理器(GPU)IP、神經網絡處理器(NPU)IP、視頻處理器(VPU)IP、數字信號處理器(DSP)IP等。Chiplet設計可以使芯片設計更加模塊化,具有更強的靈活性。不同的芯片片段可以獨立設計和優化,然后通過集成技術組合成一個完整的芯片。這種模塊化的設計使芯片開發更加容易,而且每個芯片片段可以在獨立的制造工藝下生產,而不是整個芯片都使用同一種復雜的制造工藝,這樣可以降低制造成本,提高芯片的產量和良品率。

當前計算機均為馮·諾依曼架構,計算單元和存儲單元分離,存儲帶寬制約了計算系統的有效帶寬,造成時延長、功耗高等問題。采用多維集成芯片將多個芯片堆疊在一起,使存儲與計算完全融合,以新的高效運算架構進行二維和三維矩陣計算,具有更大算力(1000 TFLOPS以上)、更高能效(超過10~100 TFLOPS/W)、降本增效三大優勢,有效克服了馮·諾依曼架構瓶頸,實現計算能效的數量級提升。

AMD近期推出的MI300X就采用了3D堆疊技術和Chiplet設計,配備了9個基于5 nm 制程的芯片組,置于4個基于6nm 制程的芯片組之上。

(2) CPU到GPU、TPU、NPU和多核異構

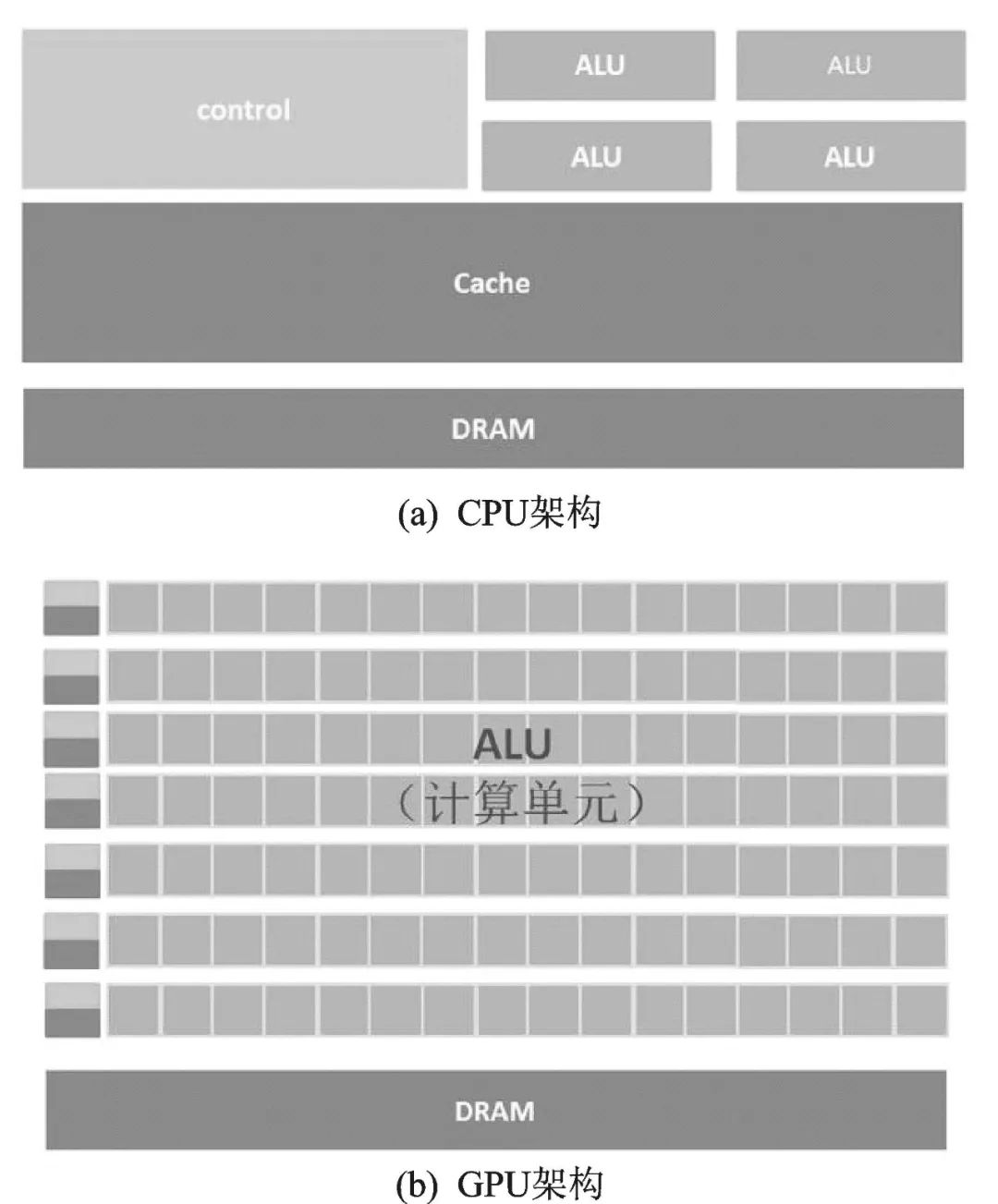

最初的處理器是CPU,采用馮·諾依曼架構,存儲程序,順序執行。在圖2(a)CPU 架構圖中,負責計算的ALU 區占的面積太小,而Cache和Control單元占據了大量空間。為提升算力,出現了多線程的流水線作業,繼而出現新結構的各類處理器。

GPU(圖形處理器)。在圖像處理中,每個像素點都需要處理,而且處理的過程和方式十分相似,都需要相同的精度、不高的運算,為此推出了GPU(Graphics Processing Unit)。GPU 架構示意圖如圖2(b)所示,它有數量眾多的計算單元和超長的流水線,特別適合處理大量的類型統一的數據。它將求解的問題分解成若干子任務,各子任務并行計算。雖然GPU 為了圖像處理而生,但它在結構上并沒有專門為圖像服務的部件,只是對CPU的結構進行了優化與調整,所以GPU不僅可以在圖像處理領域大顯身手,還被用來進行科學計算、密碼破解、數值分析、海量AGI數據處理。

圖2 CPU及GPU的架構圖

TPU(Tensor Processing Unit)即張量處理器。張量是機器學習中常見的多維數組結構,谷歌就專門為此開發了一款TPU 芯片。TPU 專注于高效地執行大規模張量計算,具有高帶寬和低延遲的內存訪問以及快速的張量操作指令,用于進行機器學習和人工智能任務中的張量計算,提供高效、快速且能耗低的計算性能。據稱,TPU有高性能和能耗效率,與同期的CPU 和GPU 相比,可以提供15~30倍的性能提升,以及30~80倍的效率(性能/瓦特)提升。2021年谷歌發布的第四代TPUv4,每個芯片擁有2.5 PFLOPS的算力。

NPU(Neural Network Processing Unit)是用電路模仿人類的神經元,深度學習的基本操作是神經網絡中神經元和突觸的處理,其中存儲和處理是一體化的。NPU通常不單獨存在,而是存在于多核異構的處理器中。典型代表有國內的寒武紀芯片和IBM 的TrueNorth。Dian-NaoYu指令直接面對大規模神經元和突觸的處理,一條指令即可完成一組神經元的處理,并對神經元和突觸數據在芯片上的傳輸提供了一系列專門的支持。

(3) 人工智能專用計算機

芯片能力直接影響算力訓練效果和速度,當前最好的AI芯片是NVIDIA的A100和H100,其最高浮點算力分別實現19.5 TFLOPS和67 TFLOPS,但AGI所需算力和單個處理器所有的算力差距太大,當前的AGI大模型的計算都需要成千上萬個GPU 堆疊起來應用。業內公認,做好AI大模型的算力門檻是1萬枚A100芯片,GPT3.5大模型需要2萬塊A100來處理訓練數據。近期,谷歌推出了擁有26 000片H100的超級AGI計算機A3。

這樣大量GPU 堆起來使用就需要采用專門針對深度學習和神經網絡的互聯硬件、架構和軟件工具包,從而實現更高的計算速度和更低的功耗。通過優化和協調來協同作用,再去組合模擬優化的路徑。NVIDIA在2006年發布了一個名為CUDA(ComputeUnified Device Architecture)的軟件工具包。他們搭建的CUDA 開發者平臺以良好的易用性和通用性讓GPU 可以用于通用超級計算,使用CUDA和不使用CUDA,兩者在計算速度上往往有數倍到數十倍的差距。26000塊H100D的A3超極計算機單獨疊起用的算力是26 000×67 TFLOPS=1.724 EFLOPS,而采用CUDA后可提供高達26 FLOPS的算力。Meta的超級計算機RSC(Research Super Cluster) 花費了數十億美元,配備了由 16000 個 NVIDIA A100 GPU 組裝成的2 000個 NVIDIA DGX A100 系統(8個A100+CUDA),集聯起來,在其巔峰時期算力可以達到近 5 EFLOPS,所以A100、H100、CUDA 三者確定了NVIDIA成為當前全球AGI算力霸主的地位。

在谷歌的數據中心中,大規模的TPU 芯片則是通過光開關互連網絡連接在一起的。光開關是一種高帶寬、低延遲的互連技術,它使用光纖作為傳輸介質,實現快速的數據傳輸和通信。通過光開關,TPU 芯片之間可以進行高速、并行的通信,以實現大規模的并行計算。這種互連方式能夠提供低延遲和高帶寬的通信性能,確保在分布式計算環境中各個TPU 芯片能夠有效地協同工作,共同完成復雜的機器學習任務。谷歌的光開關互連網絡架構為其算力集群提供了高效的通信基礎設施,使得TPU能夠實現高性能、大規模的機器學習計算。這種光開關連接的設計能夠支持谷歌處理海量數據和進行復雜計算,提供出色的計算能力和可擴展性。

(4) 下一代計算機

當前,硅基計算機的摩爾定律似乎快走到盡頭,于是人們寄希望于“類人腦生物計算機”的非硅基計算機。未來的計算機可能會采用一種或多種可能的技術和架構技術提高算力計算性能和效率。

① 量子計算機:量子計算機利用量子力學原理來執行計算。這種計算機可以大大提高處理大量數據和解決復雜問題的速度(例如加密和化學模擬)。近期量子計算機好消息不斷:在國際超算大會(ISC)上,NVIDIA公布了一個搭載384 顆Grace CPU 超級芯片的超級計算機Isambard 3。這臺超級計算機FP64峰值性能達到約2.7petaFLOPS,功耗低于270 kW。當前全球大量的量子計算研究都在NVIDIA GPU 上運行。歐洲量子計算設施于利希超算中心(JSC)計劃與NVIDIA 共同建立一座量子計算實驗室。在NVIDIA 量子計算平臺的基礎上開發一臺量子超級計算機,作為于利希量子計算用戶基礎設施(JUNIQ)的一部分,運行高性能、低延遲的量子-經典計算工作負載。近期,IBM 科學家在《自然》雜志上發表了論文《容錯前的量子計算實用性證據》。容錯量子計算指的是有量子糾錯保護的量子計算。IBM 科學家宣布,已經設計出一種方法來管理量子計算的不可靠性,從而得出可靠、有用的答案。英特爾公布了名為Tunnel Falls的硅自旋量子芯片,它擁有12個硅自旋量子比特,是英特爾迄今為止研發的最先進的硅自旋量子比特芯片。

② 光子計算機:光子計算機使用光子而不是傳統的電子來執行計算,這種計算機可以實現更高的速度和更低的功耗,并且更容易進行并行計算。

③ DNA計算機:DNA計算機使用DNA分子來執行計算,這種計算機可以處理大量數據,并且具有很好的并行性。

2 合作共贏

算力是AGI的決定性的基礎建設,是AGI金字塔的底座,需要人力和資金的巨大投入。ChatGPT全面放開導致用戶激增、算力不足。除大量購入GPU 外,近期又和甲骨文(Oracle)討論了一項協議,如果任何一家公司為使用大規模AI的云客戶所提供的計算能力不足,那么雙方就將相互租用對方服務器。

而日本經產省2022年11月牽頭組建了“技術研究組合最先端半導體技術中心(LSTC)”,隨后,豐田汽車、索尼、NTT、NEC、軟銀等8家大型公司成立合資企業Rapidus公司,計劃最早2025年在日量產2 nm芯片,希望2025到2030年的幾年中為其他企業提供代工服務。

國內重心放在了大模型上,近3年大模型發布數量為世界之首(達79個),已超過美國,但實際上國內AGI的短板在于算力,國內AGI都受制于算力,僅面向B端用戶或內測,其使用效果、影響力、評價有目共賭。正如百度CEO李彥宏所說:“文心一言跟ChatGPT 的差距大約是兩個月,這兩個月的差距我們要用多長時間才能趕上,也許很快,也許永遠也趕不上。”

面對芯片封控,算力是買不來的,也不是幾年時間可以一蹴而就的,也不是短期能解決的。在面對封鎖的重大問題上(如兩彈一星、北斗、航天等),國家都采用舉國體制,趕上了世界先進水平。AGI重要性不遜于核能,其核心算力牽涉到國民經濟的各個方面,需要在國家層面上,組織大廠合作共贏。當前國內百模競爭只會分散人力、財力,從而拉大差距。

-

半導體技術

+關注

關注

3文章

241瀏覽量

61195 -

人工智能

+關注

關注

1804文章

48783瀏覽量

246888 -

語言模型

+關注

關注

0文章

560瀏覽量

10692

原文標題:人工智能的生態樹及算力研究

文章出處:【微信號:麥克泰技術,微信公眾號:麥克泰技術】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

大算力芯片的生態突圍與算力革命

Deepseek引發算力變革 《2025中國人工智能計算力發展評估報告》發布

人工智能的生態樹及算力研究

人工智能的生態樹及算力研究

評論