加利福尼亞州圣克拉拉——Nvidia通過一個(gè)名為TensorRT LLM的新開源軟件庫,將其H100、A100和L4 GPU的大型語言模型(LLM)推理性能提高了一倍。

正如對相同硬件一輪又一輪改進(jìn)的基準(zhǔn)測試結(jié)果所證明的那樣,在從專用人工智能芯片中擠出盡可能好的性能時(shí),軟件往往與硬件一樣重要。

“我們所做的很大一部分是硬件和軟件的結(jié)合,如今英偉達(dá)的軟件工程師比硬件工程師多,”英偉達(dá)超大規(guī)模和HPC計(jì)算業(yè)務(wù)副總裁兼總經(jīng)理Ian Buck告訴《EE時(shí)報(bào)》。“這是回到最初的CUDA的決定的一部分,也是交付不僅是一個(gè)帶有指令集的芯片,而且是一個(gè)完整的堆棧以滿足開發(fā)者需求的動(dòng)機(jī)。

他說:“這提供了一個(gè)在各個(gè)層面進(jìn)行創(chuàng)新的機(jī)會(huì):改變硬件架構(gòu)、改變指令集、改變編譯器、改變驅(qū)動(dòng)程序、改變工具、庫等等,這樣我們就可以推動(dòng)整個(gè)平臺(tái)向前發(fā)展。”。“在過去20年的加速計(jì)算中,這種情況已經(jīng)多次出現(xiàn),人工智能推理也是如此。”

TensorRT-LLM是Nvidia原始深度學(xué)習(xí)軟件庫的演變,對LLM推理進(jìn)行了優(yōu)化。它旨在支持 H100,但也可以應(yīng)用于 A100 和 L4 部署。

“[在TensorRT-LLM中,我們]確保我們?yōu)榇笮驼Z言模型提供最佳的張量核心優(yōu)化,”Buck說。“這允許人們采用任何大型語言模型并通過TensorRT-LLM傳遞,以獲得Hopper的變壓器引擎的好處,該引擎使Hopper的FP8計(jì)算能力成為可能。而且在生產(chǎn)工作流程中不會(huì)有任何準(zhǔn)確性損失。

Nvidia 的 Hopper 架構(gòu)引入了變壓器引擎,這是一個(gè)軟件庫,可智能地管理訓(xùn)練和推理工作負(fù)載的精度,以實(shí)現(xiàn)最佳性能。Buck說,變壓器引擎需要對所涉及的數(shù)學(xué),統(tǒng)計(jì)數(shù)據(jù)和數(shù)據(jù)有深入的了解,并在Nvidia的編譯器上進(jìn)行大量工作。它有助于在模型投入生產(chǎn)后保持模型的預(yù)測準(zhǔn)確性,這可能是一個(gè)挑戰(zhàn)。

“你可以很容易地將32位或16位計(jì)算塞進(jìn)FPGA中,但你可能會(huì)得到錯(cuò)誤的答案,因?yàn)樗鼪]有你想要的生產(chǎn)級(jí)精度,”巴克說。“深思熟慮和謹(jǐn)慎地做到這一點(diǎn),保持規(guī)模和偏差,在某些情況下將計(jì)算保持在只有8位的范圍內(nèi) - 為模型的某些部分保留FP16 - 這是Nvidia已經(jīng)努力了一段時(shí)間的事情。

TensorRT-LLM還包括一個(gè)稱為動(dòng)態(tài)批處理的新功能。

Buck解釋說,LLM工作負(fù)載,甚至是同一模型的推理工作負(fù)載,都是多種多樣的。LLM從情緒分析等更簡單的用例開始,但今天的LLM可能正在回答問題,閱讀長文本并總結(jié)它們,或者為電子郵件,文章,演示文稿等生成長文本或短文本。為LLM推理服務(wù)的數(shù)據(jù)中心也可以為許多不同的用戶提供許多不同的服務(wù)。

與現(xiàn)有的AI工作負(fù)載相比,現(xiàn)有的AI工作負(fù)載在大小上更有可能相似,因此易于批處理,Buck表示,針對同一模型的LLM查詢在大小方面可能會(huì)相差幾個(gè)數(shù)量級(jí),從需要幾毫秒才能完成的查詢到需要幾秒鐘的查詢。模型也可以堆疊,使事情變得更加復(fù)雜。

“我們的標(biāo)準(zhǔn)批處理方法總是等待最長的查詢完成,”他說。“圖像查詢大致花費(fèi)相同的時(shí)間——從效率的角度來看,這不是問題,而且查詢可以填充,所以沒什么大不了的。

借助新的動(dòng)態(tài)批處理功能,查詢完成后,查詢可以停用,軟件可以插入另一個(gè)查詢,而較長的查詢?nèi)栽谶M(jìn)行中。這有助于提高具有不同查詢長度的 LLM 的 GPU 利用率。

“坦率地說,結(jié)果甚至讓我感到驚訝,”巴克說。“它使Hopper的性能翻了一番。Hopper 是一個(gè)非常強(qiáng)大的 GPU,它可以在同一個(gè) GPU 中并行處理大量查詢,但如果沒有動(dòng)態(tài)批處理,如果你給它多樣化的查詢,它會(huì)等待最長的查詢,而不會(huì)被充分利用。

TensorRT-LLM是開源的,以及Nvidia的所有LLM工作,包括許多LLM模型,如GPT,Bloom和Falcon,這些模型已經(jīng)通過內(nèi)核融合,更快的注意力,多頭注意力等技術(shù)進(jìn)行了優(yōu)化。所有這些操作的內(nèi)核都作為TensorRT-LLM的一部分開源。

“這使得對性能感興趣的研究人員有一個(gè)起點(diǎn),使其更快,”巴克說。“我們的客戶和用戶很欣賞,如果他們有一個(gè)想要部署的特定想法,他們可以針對他們的用例進(jìn)一步優(yōu)化一些東西。

創(chuàng)新來自學(xué)術(shù)界,也來自Meta、Microsoft和谷歌等公司。雖然 Nvidia 與他們合作優(yōu)化推理,雖然優(yōu)化可能會(huì)成為學(xué)術(shù)論文,但“世界沒有一個(gè)好地方去獲得這些優(yōu)化,而且 Nvidia 工程師所做的工作沒有得到一個(gè)可以幫助世界其他地方的地方分享,“巴克說。

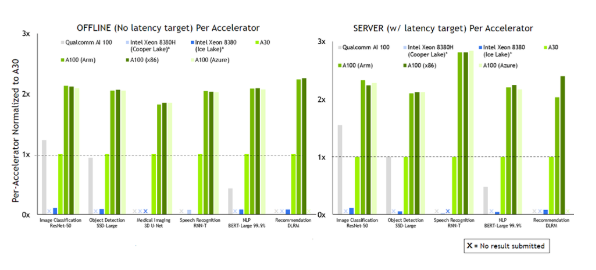

Buck補(bǔ)充說,TensorRT-LLM的性能提升在下一輪MLPerf推理分?jǐn)?shù)中應(yīng)該是顯而易見的,該分?jǐn)?shù)將于明年春天到期。

審核編輯:彭菁

-

NVIDIA

+關(guān)注

關(guān)注

14文章

5324瀏覽量

106629 -

開源

+關(guān)注

關(guān)注

3文章

3754瀏覽量

43965 -

語言模型

+關(guān)注

關(guān)注

0文章

563瀏覽量

10833 -

LLM

+關(guān)注

關(guān)注

1文章

328瀏覽量

887

發(fā)布評論請先 登錄

NVIDIA擴(kuò)大AI推理性能領(lǐng)先優(yōu)勢,首次在Arm服務(wù)器上取得佳績

Arm KleidiAI助力提升PyTorch上LLM推理性能

如何在魔搭社區(qū)使用TensorRT-LLM加速優(yōu)化Qwen3系列模型推理部署

NVIDIA打破AI推理性能記錄

NVIDIA 在首個(gè)AI推理基準(zhǔn)測試中大放異彩

求助,為什么將不同的權(quán)重應(yīng)用于模型會(huì)影響推理性能?

如何提高YOLOv4模型的推理性能?

NVIDIA發(fā)布最新Orin芯片提升邊緣AI標(biāo)桿

現(xiàn)已公開發(fā)布!歡迎使用 NVIDIA TensorRT-LLM 優(yōu)化大語言模型推理

用上這個(gè)工具包,大模型推理性能加速達(dá)40倍

自然語言處理應(yīng)用LLM推理優(yōu)化綜述

魔搭社區(qū)借助NVIDIA TensorRT-LLM提升LLM推理效率

開箱即用,AISBench測試展示英特爾至強(qiáng)處理器的卓越推理性能

Nvidia 通過開源庫提升 LLM 推理性能

Nvidia 通過開源庫提升 LLM 推理性能

評論